Fernsehtechnik - Vom Studiosignal zum DVB-Sendesignal

Die Fernsehtechnik umfasst den Weg vom Studiosignal bis hin zum DVB-Sendesignal. Dieser Artikel bietet einen Überblick über die Entwicklung und Anwendung verschiedener Techniken in diesem Bereich. Beginnend mit der Geschichte der Fernsehtechnik wird das Prinzip der Bildübertragung untersucht. Es werden Themen wie die trägerfrequente Übertragung von analogem Bild- und Tonsignal, die Datenreduktion beim digitalen Videosignal und Audiosignal sowie die Video- und Audio-Codierung nach dem MPEG-Standard behandelt. Zudem werden Aspekte wie die Übertragung des MPEG-2-Transportstroms, die digitale Trägermodulation und die Übertragung des DVB-Signals im Satelliten-, Kabel- und terrestrischen Funkkanal beleuchtet.

Inhaltsverzeichnis:

„Schon digital - oder noch analog” werden heute Fernsehprogramme übertragen. Die vorangehende 3. Auflage des Buches „Fernsehtechnik” war eigentlich im wesentlichen auf die zukünftige Technik der digitalen Fernsehsignalverteilung orientiert. Manche Leser aber waren enttäuscht, dass dabei die Übertragungsverfahren für das analoge PAL-Signal nur kurz oder überhaupt nicht mehr behandelt wurden.

Der Abschnitt über das analoge Video-Quellensignal wurde deshalb, wie in vorangehenden Auflagen, durch Erläuterungen über den PAL-Coder und -Decoder sowie über das PALplus-System ergänzt. Im Weiteren wird die trägerfrequente Übertragung des analogen Bild- und Tonsignals im terrestrischen Funk- und Kabelkanal sowie im Satellitenkanal beschrieben. Derzeit ist davon auszugehen, dass die endgültige Abschaltung der noch analogen terrestrischen Fernsehsender in Deutschland spätestens im Jahr 2010 erfolgen wird. In den Kabelnetzen und über einige Satelliten-Transponder werden darüber hinaus sicher noch analoge Fernsehprogramme übertragen. Damit sei es gerechtfertigt, dass in dieser Auflage nochmals die analoge Fernsehsignalverteilung erscheint.

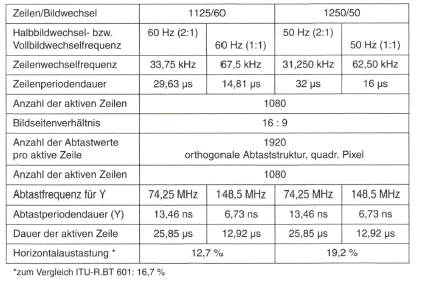

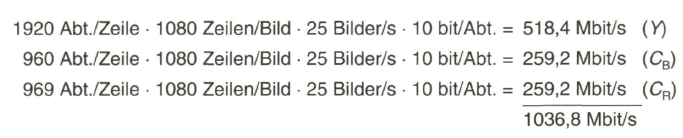

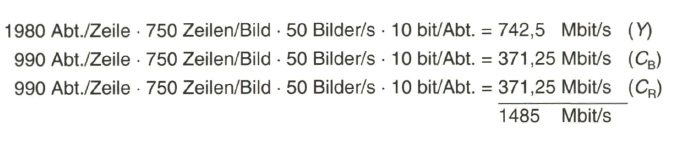

Die bevorstehenden technologischen Neuerungen bei der Fernsehprogrammverteilung werden mit der Einführung von hochauflösendem Fernsehen, HDTV, verbunden sein. Treibende Kraft ist dabei das immer breitere Angebot an großflächigen Flachbildschirmen mit LCD- oder Plasma-Display-Technik. Obwohl in Europa noch keine endgültigen Standards festgelegt sind, so kann doch, basierend auf „De facto”-Standards, von dem 1920 x 1080-HD-Format (1080 aktive Zeilen) mit Zeilensprung-Abtastung, aber wahrscheinlich auch von einem 1280 x 720-Format (720 aktive Zeilen) mit progressiver Abtastung ausgegangen werden. Dem hochauflösenden Fernsehen wurde deshalb beim digitalen Studiosignal mehr Bedeutung zugeordnet.

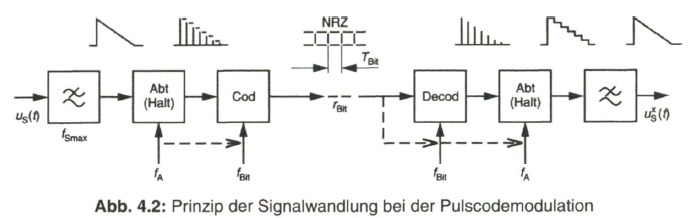

Die rasche Entwicklung der Digitaltechnik in Verbindung mit immer schnelleren Schaltkreisen blieb nicht ohne Einfluss auf die Fernsehtechnik. Sowohl im Studiobereich, bei der Bearbeitung von Programmsignalen, als auch bei der Signalverarbeitung im Fernsehempfänger kamen im Laufe der letzten Jahrzehnte zunächst inselweise, sukzessive aber immer mehr digitale Schaltungen und Systeme zum Einsatz. Diese erforderten in einem analogen Umfeld als Interface stets eine Analog-Digital- bzw. Digital-Analog-Wandlung.

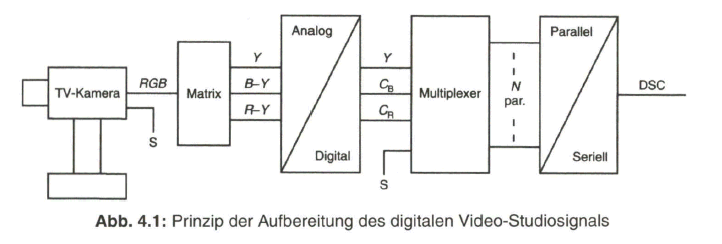

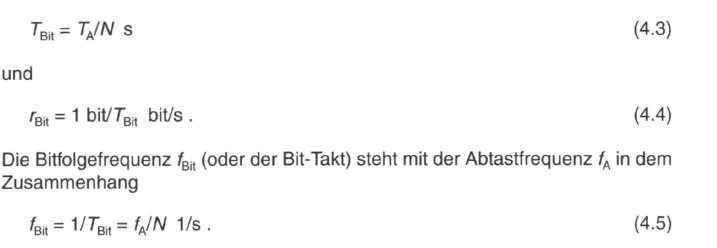

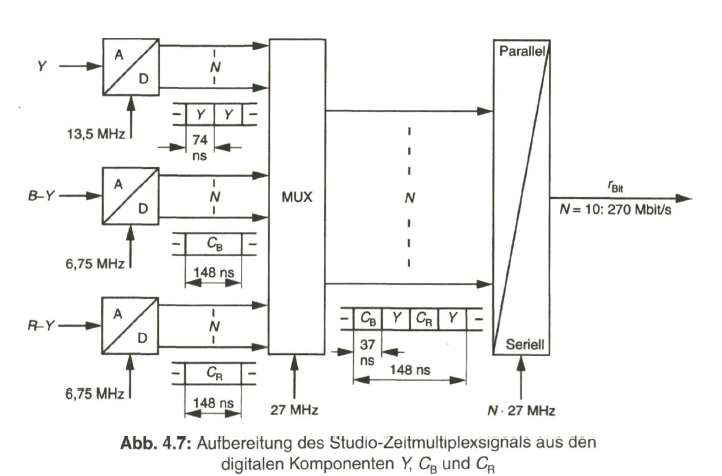

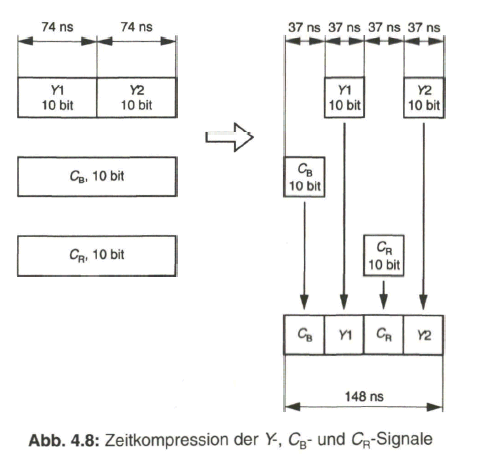

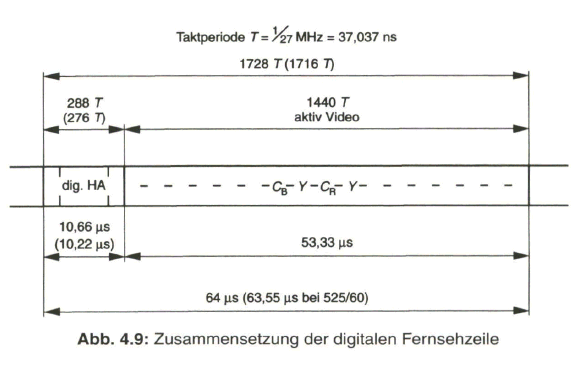

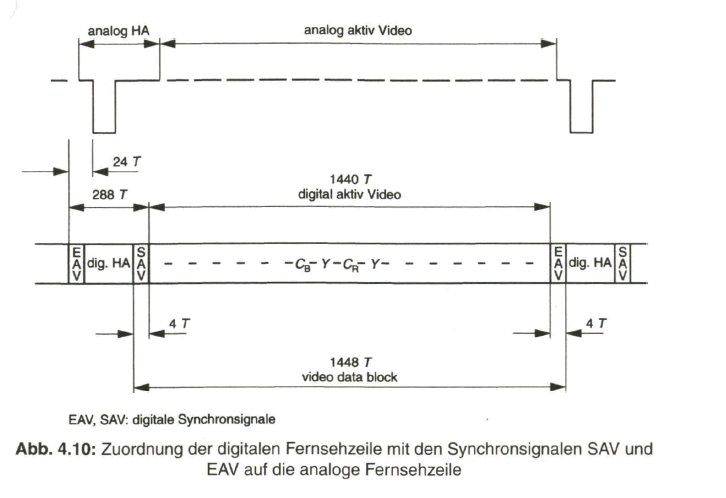

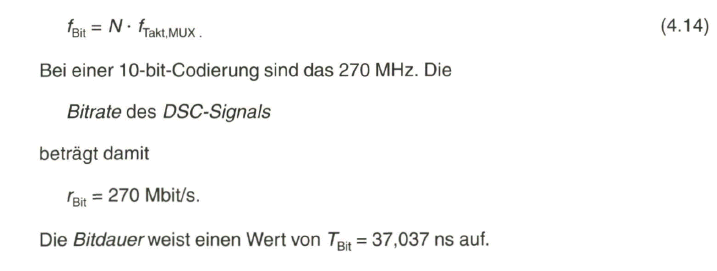

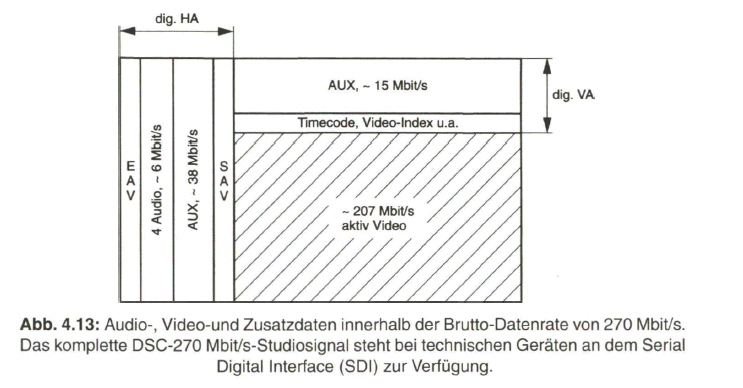

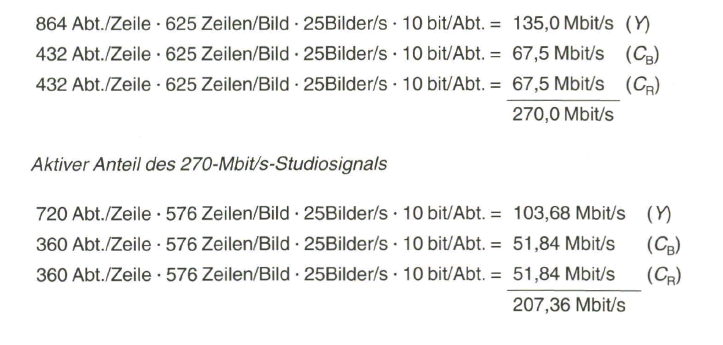

Es war deshalb naheliegend, dass ein digitaler Standard für das Video-Studiosig- nal erarbeitet wurde, der im Jahr 1981 durch das CCIR (Commite Consultatif International des Radiocommunications) als Empfehlung 601 verabschiedet worden ist. Die hohen Anforderungen im Studio bedingten bald einen Übergang von der ursprünglich festgelegten 8-bit-Codierung auf eine 10-bit-Codierung, womit sich nun eine Datenrate von 270 Mbit/s für das aus den Komponenten zusammengesetzte digitale Multiplexsignal nach CCIR-Empfehlung 656 ergab.

Für den Programmaustausch und auf den Zubringer-Leitungen waren dazu breitbandige Übertragungssysteme notwendig, jedoch mit einer Datenrate, die von der bei den üblichen SDH- und ATM-Plierarchien abweicht. Es wurden Datenreduktionsverfahren für das Bild- und Tonsignal entwickelt, die ohne wahrnehmbaren oder wesentlichen Qualitätsverlust zu einer Datenrate führen, mit der es wiederum möglich ist, installierte SDH- oder ATM-Breitbandsysteme auf den Contributions-Strecken zu benutzen.

Mit einer weiteren Reduktion der Datenrate, die zunächst nur für Multimediazwecke gedacht und gemäß den Vorschlägen der Moving Pictures Expert Group in dem so genannten MPEG-1-Standard niedergeschrieben war, und mit der nachfolgenden Anpassung auf die Parameter und Vorgaben des Rundfunk-Fernsehsignals im MPEG-2-Standard eröffnete sich die Möglichkeit, digitale Video- und Audiosignale auch über herkömmliche Fernsehkanäle zu verteilen. Damit wurde das Startsignal für das „digitale Fernsehen“ bis zum Teilnehmer hin gegeben.

Als Verfasser schätze ich mich glücklich, dass ich mit der Entwicklung der Fernsehtechnik aufwachsen durfte. Durch meine langjährige Tätigkeit in der Lehre an der Hochschule und mit Industrieseminaren sowie engen Kontakten zu Entwicklungsstellen bei Industrie und beim Institut für Rundfunktechnik hat sich ein umfangreiches Wissen angesammelt. Dieses soll nun in der 3. Auflage der „Fernsehtechnik“ mit dem Untertitel „Vom Studiosignal zum DVB-Sendesig- nal“ niedergeschrieben und dem interessierten Leser nahe gebracht werden.

Der an Technikgeschichte interessierte Leser findet in einer kurzen Zusammenfassung die Entwicklung der Fernsehtechnik von den Anfängen bis zur nahezu zwangsläufigen Einführung des digitalen Fernsehens in den vergangenen Jahren. Die noch nicht oder nicht mehr mit den Grundlagen des analogen Fernsehens vertraut sind, werden in einem einführenden Abschnitt die wesentlichen Abläufe und Parameter des analogen Video-Quellensignals erläutert.

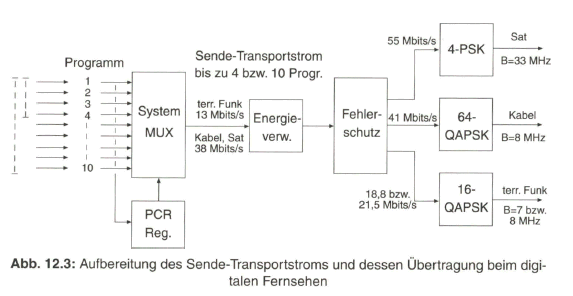

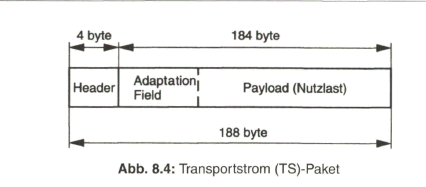

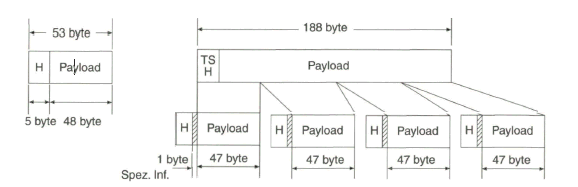

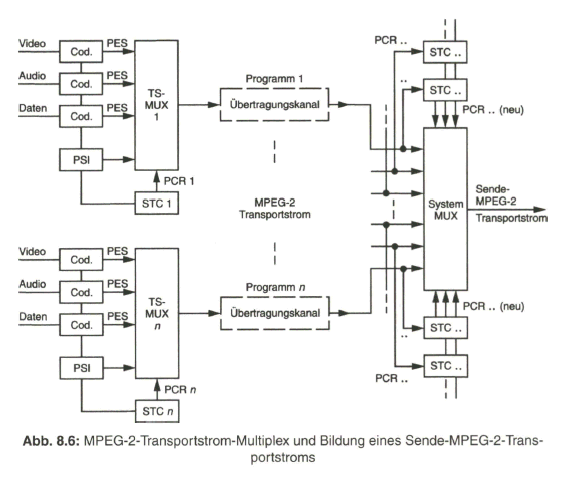

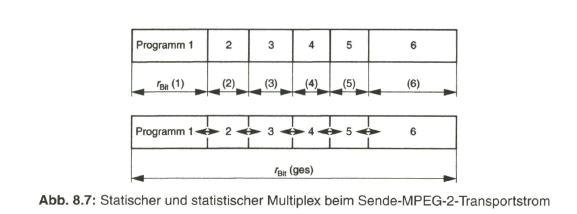

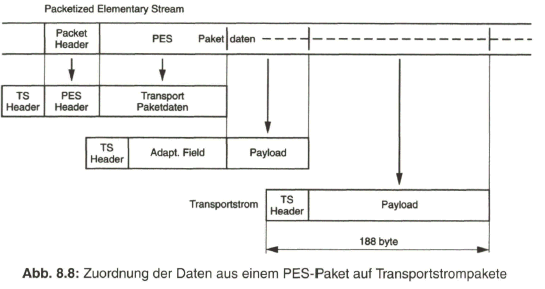

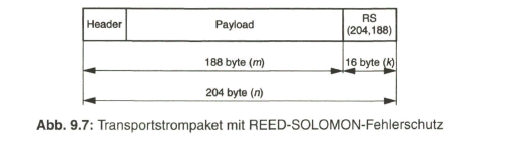

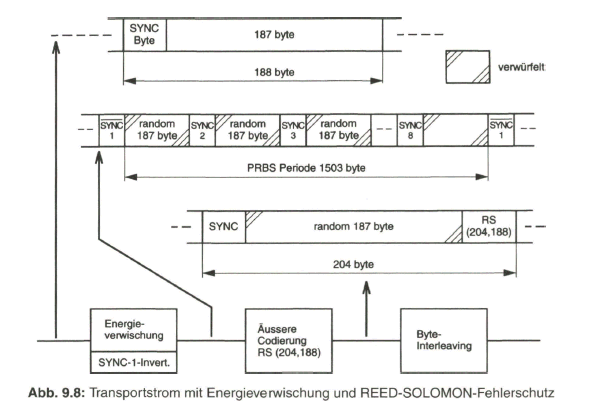

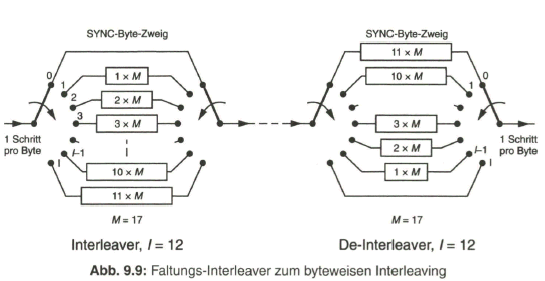

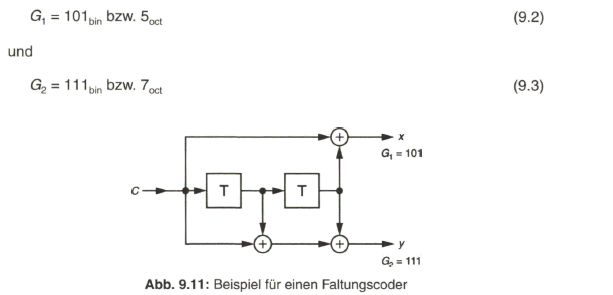

Der Schwerpunkt dieses Buches liegt aber beim „digitalen Fernsehen“. Nach der Aufbereitung des digitalen Studiosignals mit der schon eingangs angesprochenen Datenrate von 270 Mbit/s werden Verfahren zur wirksamen Datenreduktion beim Videosignal behandelt, die auf einer Redundanz- und Irrelevanzreduktion beim Quellensignal basieren. Dazu wird es erforderlich, das zeilengebundene Video- Quellensignal neu zu unterteilen, wobei bereits auf die von MPEG-2 vorgegebene Hierarchie im Datenstrom Bezug genommen wird. Die vom MPEG-2-Video- und auch -Audio-Coder gelieferten Daten werden in Paketen gebündelt und in die Syntax des MPEG-2-Systems eingebracht. Durch Multiplexen von Datenpaketen mit Video- und Audioanteilen entsteht der MPEG-2-Transportstrom. Dieser wird nach Einbringen von Fehlerschutzdaten dem Übertragungskanal zugeführt.

Nach einer Beschreibung der wichtigsten digitalen Modulationsverfahren wird im letzten Abschnitt auf die Übertragung des digitalen Fernsehsignals nach den DVB-Spezifikationen im Satellitenkanal (DVB-S), im Kabelverteilkanal (DVB-C) und im terrestrischen Funkkanal (DVB-T) eingegangen

1. Geschichte der Fernsehtechnik

„Fernsehen“ als ein Medium zur Verbreitung von Information und Unterhaltung an einen weiten Teilnehmerkreis gibt es weltweit seit etwa 50 Jahren. Die ersten Anfänge reichen in Deutschland sogar bis 1936 zurück, als anlässlich der Olympischen Sommerspiele in Berlin bereits Sportübertragungen im öffentlichen Fernsehen mit einer Auflösung des Bildes in 441 Zeilen stattfanden.

Deutschland, 1936: 441 Zeilen, 50 Halbbilder pro Sekunde

Kriegsbedingt stagnierte die Entwicklung in Europa, aber in den USA wurde schon 1940 von der CBS ein Farbfernsehsystem vorgestellt, bei dem die Farbzerlegung und Wiedergabe noch unter Zuhilfenahme von rotierenden Farbfilterscheiben für die mechanisch-optische Umschaltung der drei Farbkomponenten erfolgte. In Europa wurde 1950 von einem Expertengremium unter der Leitung des Schweizer Fernsehexperten WALTER GERBER eine Fernsehnorm mit 625 Zeilen und 50 Halbbildern pro Sekunde erarbeitet und 1952 vom CCIR (Comite Consultant International des Radiocommunications) als Standard offiziell angenommen.

Europa, 1952: 625 Zeilen, 50 Halbbilder pro Sekunde

Über einige Zeit konkurrierten damit noch der englische 405-Zeilen und der französische 819-Zeilen-Standard. All diesen Fernseh Standards, wie auch bereits beim ursprünglichen 441-Zeilen-Standard, ist das Zeilensprungverfahren gemeinsam. Die Rundfunkanstalten in der Bundesrepublik Deutschland starteten im Jahr 1952 mit der regulären Ausstrahlung von Schwarzweiß-Fernsehprogrammen nach der 625-Zeilen-Norm [1],

Nachdem in den USA Farbbildröhren verfügbar waren und das Farbfernsehsystem NTSC (National Television System Committee) zur Einführung kam, wurden auch in Deutschland Versuche mit der Übertragung von Farbfernsehsignalen unternommen, wobei neben dem NTSC-Verfahren auch das von WALTER BRUCH entwickelte PAL-Verfahren als ein verbessertes, weil gegen Phasenfehler unempfindliches, NTSC-ähnliches System, und das von HENRI DE FRANCE vorgestellte SECAM-Verfahren getestet wurden. Objektive Vergleiche wiesen aber dem PAL-Verfahren die besten Eigenschaften zu.

So kam es in der Bundesrepublik Deutschland am 25. August 1967 zur offiziellen Einführung des Farbfernsehens mit dem PAL-Verfahren. Viele Länder der Erde, mit 625-Zeilen-Standard, entschieden sich im Folgenden für die Einführung des PAL-Farbfernsehsystems.

Deutschland (und weltweit), 1967: PAL-Farbfernsehsystem

Geringe Abweichungen einzelner Parameter oder auch unterschiedliche HF- Kanalbandbreiten (7 bzw. 8 MHz) beim 625-Zeilen-Standard sowie das in Nordamerika und Japan eingeführte NTSC-System mit 525-Zeilen-Standard und das SECAM-System wurden in den CCIR-Standard 624 aufgenommen.

Im Laufe der Zeit offenbarten sich dem kritischen Beobachter des nach dem PAL-Verfahren übertragenen Farbfernsehbildes auch hier wieder gewisse Schwächen des Systems, insbesondere durch Übersprecheffekte, bedingt durch das Frequenzmultiplex-Prinzip mit den verkämmten Spektren von Luminanz und Chrominanzsignal. Eine Abhilfe konnte durch so genannte Mehrzeilen-Laufzeit-Decoder beim PAL-Empfänger geschaffen werden, die aber wiederum andere Mängel mit sich brachten. Eine andere Möglichkeit bot sich in dem Übergang auf das Zeit-multiplex-Prinzip. Mit diesem ist eine Zeitkompression der zu übertragenden Signale, sinnvoller Weise nur mit digitaler Technik realisierbar, verbunden.

Anfang der 1980er-Jahre kam es zur Entwicklung eines analogen Zeitmultiplex systems mit dem Namen MAC (Multiplexed Analogue Components), das aber bereits bei der Aufbereitung des Studioausgangssignals und bei der empfängerseitigen Verarbeitung mit digitaler Schaltungstechnik verknüpft war. Gefordert wurde eine volle Kompatibilität in den verfügbaren HF-Übertragungskanälen, was weitgehend erfüllt werden konnte. Darüber hinaus konnte kompatibel auf das 16:9-Breitbildformat umgeschaltet werden und ein abwärtskompatibler HDTV-Fernseh-Standard HD-MAC war, zumindest bedingt, möglich.

Europa, 1983: beabsichtigte und in Probephase bereits realisierte Einführung des MAC-Verfahrens

Die Investitionen auf der Studioseite und insbesondere beim Fernsehteilnehmer, mit der Notwendigkeit von zunächst einem Zusatzgerät oder später einem auf das neue Verfahren ausgelegten Fernsehempfänger, waren jedoch zu hoch, so dass das MAC-bzw. HD-MAC-Verfahren vom Fernsehteilnehmer nicht angenommen wurde und damit, trotz deutsch-französischer Regierungsvereinbarung, nicht zur tatsächlichen Einführung kam.

Indirekt profitiert hat von dieser Entwicklung eine verbesserte Variante des PAL-Verfahrens mit Unterdrückung der Cross-Störungen und damit voller Ausnutzbarkeit der 5-MHz-Videobandbreite, das mit PAL kompatible Color-Plus-Verfahren. In Verbindung mit der kompatiblen 16:9-Breitbildübertragung ist dieses im PALplus- System integriert. Das PAL-plus-System kommt in Deutschland bei den öffentlich rechtlichen Rundfunkanstalten weitestgehend zum Einsatz und wird neben dem Standard-PAL-System bis zum Auslaufen der PAL-Ära eingeführt bleiben.

Deutschland, 1991: Einführung des PAL-plus-Systems

Im Studiobereich vollzog sich bereits ab Mitte der 1980er-Jahre eine allmähliche Umstellung auf die digitale Komponententechnik. Voraussetzung war die Definition eines digitalen Studio-Standards, der im Jahr 1981 vom CCIR mit der Rec. 601 und Rec. 656 festgelegt wurde und nun weltweite Gültigkeit durch Anpassung an das 525-Zeilen-System mit 60 Hz und an das 625-Zeilen-System mit 50 Hz erlangte. Das frühere CCIR (Comite Consultatif International des Radio communications) ist seit Dezember 1992 durch Neuorganisation in die Internationale Fernmeldeunion ITU (International Telecommunication Union), Section Radio (ITU-R) übergegangen.

Weltweit, 1981: Digitaler Studio-Standard

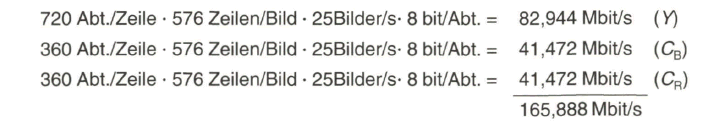

Ursprünglich war 8-bit-Codierung mit einer Brutto-Datenrate von 216 Mbit/s vorgesehen. Aus den Erfahrungen im Studiobereich ergab sich die Notwendigkeit, auf eine 10-bit-Codierung mit der Brutto-Datenrate von 270 Mbit/s überzugehen. Sowohl schon bei der „Contribution“ auf den Verbindungs- und Zubringerleitungen zwischen den TV-Studios und den Senderstandorten als auch bei der „Distribution“ zum Fernsehteilnehmer hin, war eine Reduktion der zu übertragenden Datenrate erforderlich, natürlich mit der Vorgabe, dass damit keine wahrnehmbare Qualitätsverminderung verbunden ist.

Auch zur Speicherung von digitalen Fernsehsignalen im Studio bis hin zum Consumer-Bereich war eine Datenreduktion notwendig. Angestrebt wurde nun wieder ein weltweiter Standard für datenreduzierte Video- und Audiosignale. Dazu wurde eine Expertengruppe beauftragt, die bereits vorangehend eine Empfehlung für die Codierung bei der Festbildübertragung erarbeitet hat, bekannt unter dem Namen JPEG (Joint Pictures Expert Group). Die Ausweitung auf Bewegtbilder und Begleitton führte zu dem Ergebnis des MPEG-1-Standards (Moving Pictures Expert Group) für Multimedia-Anwendungen und Speicherung auf einer Compact Disc (CD) mit einer Datenrate von maximal 1,5 Mbit/s.

Weltweit, 1993: MPEG-1 -Standard für Multimedia

Basierend auf reduzierter Rasterauflösung mit 352 x 288 Pixel für Luminanz und einer geringeren Farbauflösung, mit progressiver Abtastung und einer Bildwiederholfrequenz bis 30 Hz war dieser Standard jedoch nicht für eine Anwendung beim Fernsehen geeignet, obwohl mit modifizierten Versionen 1994 die ersten Satellitenübertragungen mit dem DSS-Standard in den USA abgewickelt wurden.

Weltweit, 1994: MPEG-2-Standard für Rundfunk-Fernsehen

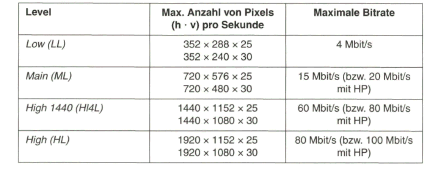

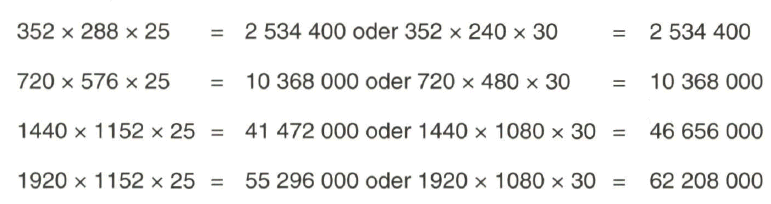

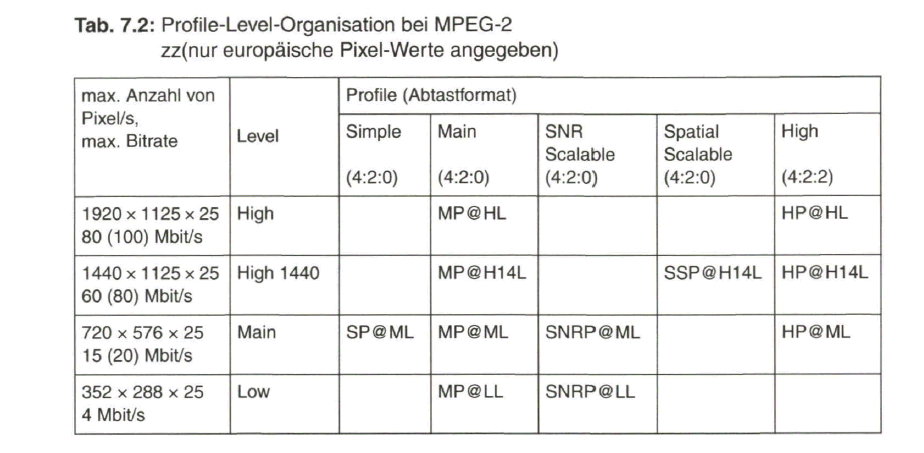

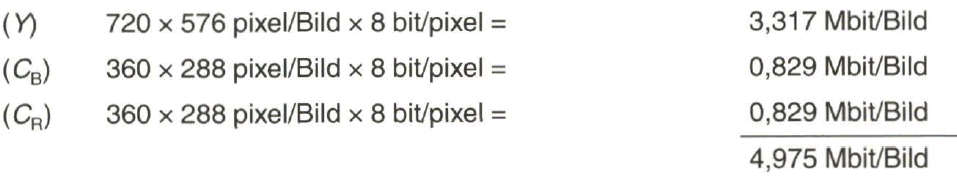

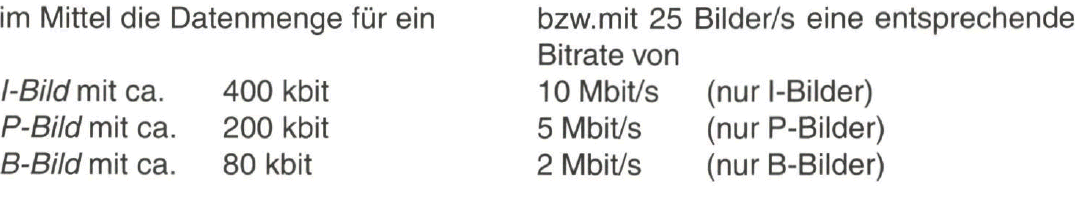

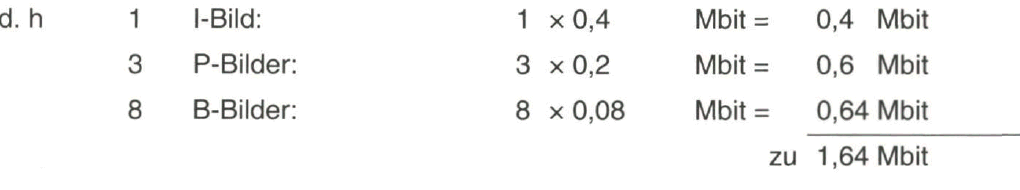

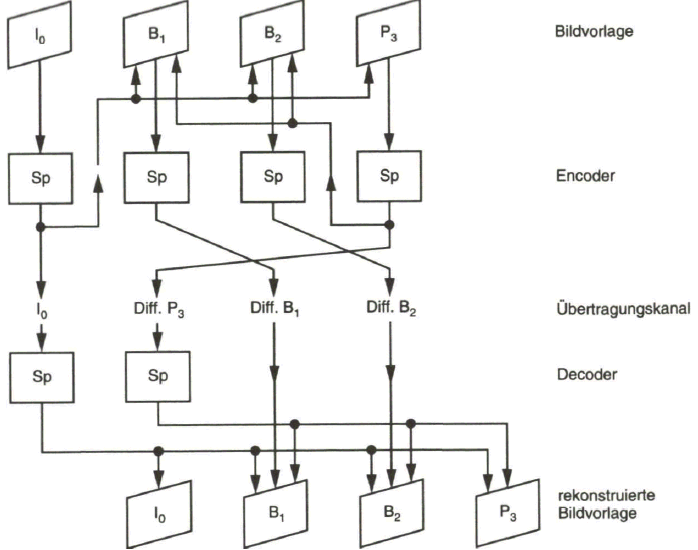

Erst mit dem MPEG-2-Standard kam der Durchbruch zum digitalen Rundfunk- Fernsehen. Volle Bildauflösung übernommen vom digitalen Studio-Standard mit 720 x 576 Pixel für Luminanz und 360 x 576 Pixel für Chrominanz sowie die Möglichkeit, neben der progressiven Abtastung auch mit dem Zeilensprungverfahren zu arbeiten, wurden als Vorgaben erfüllt. Abhängig von der Zeilenzahl und Chrominanzauflösung, bei MPEG-2 nun ausgedrückt durch die „Levels“ und „Profiles“, wurden Obergrenzen für die Datenrate des komprimierten Videosignals zwischen 4 Mbit/s für reduzierte Auflösung, über 20 Mbit/s für Standard-TV bis zu 100 Mbit/s bei hochauflösendem Fernsehen HDTV, festgelegt. Mit effektiven Datenkompressionsverfahren wird praktisch nur etwa ein Viertel dieser Werte oder weniger benötigt. Damit waren die Voraussetzungen geschaffen, um digitale Fernsehsignale mit geeigneten Modulationsverfahren über die gegebenen TV-Verteilkanäle dem Fernsehteilnehmer zuzuführen.

Ein gewisser Wettlauf entstand zwischen den USA, wo man sich schon früher als in Europa für die Entwicklung eines digitalen Fernsehsystems sogar mit der Vorgabe von HDTV entschieden hatte, und der Entwicklung in Europa, wo nach Expertengesprächen innerhalb der European Launching Group im September 1993 das europäische DVB-Projekt gestartet wurde. Die vom Technical Module des DVB-Projektes als erstes verabschiedete Systemspezifikation für den Satellitenkanal wurde im November 1994 vom europäischen Normungsinstitut ETSI zum European Telecommunication Standard ETS 300 421 (DVB-S) erklärt. Es folgte die Spezifikation für DVB-Kabelübertragung (DVB-C) und später für Digitales Terrestrisches Fernsehen (DVB-T) mit Ausstrahlung in Gleichwellennetzen.

Europa, 1995: DVB-Standard für Satelliten-, Kabel- und terrestrischen Funkkanal

In Europa startete 1996 das digitale Fernsehen über Satellitenkanäle. Neu ist, dass nun über einen Transponderkanal gleichzeitig bis zu zehn Standard-TV-Programme übertragen werden, im Gegensatz zu nur einem durch Frequenzmodulation übertragenen Programmsignal bei analogem Fernsehen. Ein solches „Bouquet“ aus mehreren Programmen kann im Allgemeinen auch über einen Kabel-TV-Kanal dem Fernsehteilnehmer zugeführt werden. Das Digitale Terrestrische Fernsehen wurde in Europa bereits 1998 in England flächendeckend eingeführt. In Deutschland erfolgte nach einer Testphase in Berlin-Potsdam in den Jahren 2002 und 2003 mit simultaner Ausstrahlung ab der zweiten Jahreshälfte 2003 die abrupte Umstellung von analogem auf digitales terrestrisches Fernsehen unter dem Slogan

„DVB-T: Das ÜberallFernsehen“

inselweise in Ballungsräumen, mit Start in Berlin und Potsdam und bis Ende 2005 über das Bundesgebiet verstreut, mit weit reichenden Abdeckungen des Versorgungsgebiets.

Laut Beschluss der deutschen Bundesregierung vom 24. August 1998 soll bis zum Jahr 2010 in Deutschland der Hör- und Fernseh-Rundfunk von der analogen auf digitale Technik umgestellt werden. Analoge TV-Übertragungen über terrestrische Sendernetze werden dann eingestellt. Zur Jahresmitte 2000 waren in Deutschland nur etwa 5 % der Haushalte zum Empfang von digitalem Fernsehen, über Satellit oder Kabel, eingerichtet [3]. Zwischenzeitlich dürfte dieser Wert aber durch die weitgehende Einführung des digitalen terrestrischen Fernsehens in den Ballungsgebieten bei über 20 % liegen.

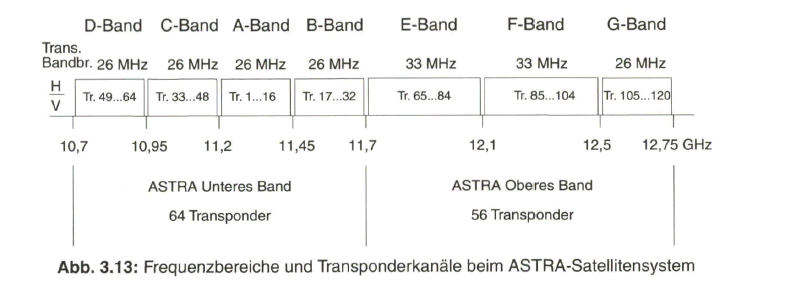

Die weitere Entwicklung wird geprägt sein durch das hochauflösende Fernsehen HDTV. Während in den USA und Japan sowie in Australien bereits seit einigen Jahren in verschiedenen Kanälen HDTV-Programme ausgestrahlt werden, verläuft die HDTV-Einführung in Europa noch etwas zurückhaltend, was mit dem geringen Interesse seitens der Fernsehzuschauer verbunden ist. Durch das immer breitere Angebot an Flachbild-Displays mit Bildschirmdiagonalen bis zu 120 cm und mehr zeichnet sich jedoch die Notwendigkeit einer höheren Zeilenauflösung, mindestens 720 oder 1080 aktive Zeilen, und ein Übergang auf progressive Bildabtastung ab. Die dadurch bedingten höheren Quellen-Datenraten sollen durch verbesserte Codierungsverfahren (MPEG-4 mit H.264-Codierung) und durch effektivere Übertragungsverfahren (DVB-S 2 im Satellitenkanal) beherrscht werden.

HDTV-Programm-Angebot über ASTRA-Satelliten-Transponder

Seit Mitte des Jahres 2006 gibt es über Satellitenkanäle die Möglichkeit HDTV-Programme frei oder in bestimmten Themengruppen (Film, Sport o.a.) über Extragebühren von einigen Anbietern zu empfangen. Premiere HD Film und HD Sport werden künftig auch im Kabelnetz von Kabel Deutschland (KDG) verteilt. Ein nächster Schritt in der Verbreitung von Fernsehprogrammen geht zum Mobilen Empfang von Fernsehen über „Handheld Terminals“.

Es handelt sich dabei um batteriebetriebene Geräte mit kleinem Bildschirm oder entsprechend eingerichtete Mobilfunkgeräte. Damit verbunden sind auch die Übertragungsstandards, die einerseits an die rundfunkmäßige Verteilung der Programme gekoppelt sind und mit dem System DVB-H über das terrestrische digitale Fernsehen oder mit dem System DMB über Digital Audio Broadcasting (DAB) beim digitalen Hörfunk oder andererseits die UMTS-Mobilfunknetze benutzen. Davon abhängig ist auch das Programmangebot, das aus dem herkömmlichen Fernsehangebot entnommen sein kann oder spezielle, eigens aufbereitete Informationen beinhaltet.

2. Prinzip der Bildübertragung

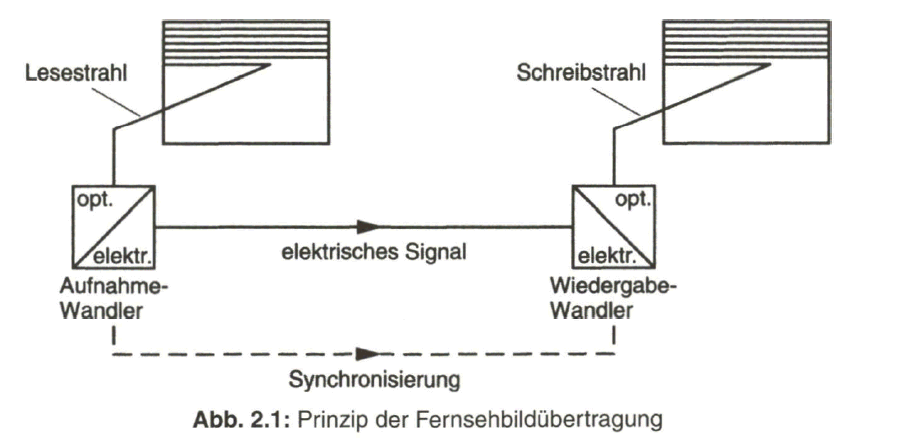

„Fernsehen“ als ein Übertragungsverfahren der elektrischen Nachrichtentechnik beruht auf der Umwandlung der Helligkeits- und Farbverteilung einer Bildvorlage in ein entsprechendes elektrisches Signal, das leitungsgebunden oder auf dem Funkweg dem Empfangssystem zugeführt und dort wieder in ein äquivalentes optisches Bild umgewandelt wird. Sowohl von der Historie als auch von der Technik her baut das Fernsehen auf der Übertragung und Wiedergabe von Schwarzweißbildern, also der Helligkeitsverteilung der Bildvorlage, auf.

Über ein optisch-elektrisches Wandlersystem wird dazu von den einzelnen Bildelementen, den Bildpunkten oder Pixeln, nacheinander in bestimmter Reihenfolge ein elektrisches Signal erzeugt. Aus der zweidimensionalen, geometrischen Zuordnung der Bildpunkte leitet sich so durch den Vorgang der Bildabtastung ein zeitabhängiges elektrisches Signal ab, dessen Momentanwert der Helligkeit des gerade abgetasteten Bildpunktes proportional ist. Empfangsseitig wird, nach entsprechender Aufbereitung, das elektrische Signal einem elektrisch-optischen Wandler, der Fernsehbildröhre, zugeführt und als ein Abbild der Helligkeitsverteilung der Bildvorlage wiedergegeben (Bild 2.1).

In der prinzipiellen Darstellung nach Bild 2.1 wird der Einfachheit halber noch von einem „Lesestrahl“ und von einem „Schreibstrahl“ gesprochen. Tatsächlich werden schon lange für die Bildaufnahme vakuumlose Halbleiter-Zeilen- (bei der Filmabtastung) oder -Flächen-Sensoren (bei Fernsehkameras) verwendet. Die Zuordnung des „Lesestrahls“ erfolgt nun über die sequentielle Abtastung der Bildpunkte, deren Helligkeitsverteilung als Ladungsbild in eine CCD-Speicheranord- nung übertragen wird. Die Ladungsverteilung wiederum wird zeilenweise ausgelesen. Die Bildwiedergabe geschieht noch weitgehend mit Fernsehbildröhren mit einem Elektronenstrahl im Hochvakuum. Aber zunehmend mehr an Bedeutung gewinnen Flachbild-LCD- oder -Plasma-Displays, bei denen die Bildwiedergabe zeilenweise über adressierbare Bildpunkte erfolgt.

2.1.1 Bildabtastung

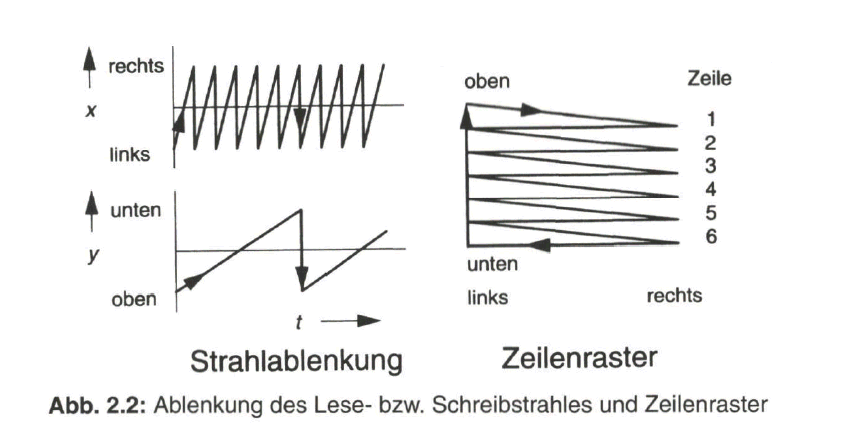

Die Abtastung der Bildvorlage durch den Lesestrahl läuft zeilenweise ab, wobei der Lesestrahl gleichzeitig horizontal von links nach rechts und vertikal von oben nach unten abgelenkt wird. Der Vorgang lässt sich mit der Bewegung des Gesichtsfeldes beim Lesen eines Textes von links nach rechts längs der Textzeilen und mit dem raschem Zurückspringen auf den Beginn der nächstfolgenden Zeile vergleichen. Vom Ende der letzten Zeile am unteren Bildrand wird der Abtaststrahl zum Ausgangspunkt am linken oberen Bildrand zurückgeführt und das Zeilenraster wiederholt durchlaufen. Die Ablenkung des Lese- bzw. Schreibstrahles in der horizontalen und vertikalen Richtung und die sich damit ergebende Rasterstruktur zeigt Bild 2.2.

Tatsächlich werden als optisch-elektrische Aufnahmewandler heute nur noch Halbleiter-Sensoren mit CCD-Technik (CCD: Charge Coupled Device) verwendet, bei denen die Abtastung in den Zeilen diskret in den einzelnen Bildpunkten erfolgt. Auch beim elektrisch-optischen Wiedergabewandler findet man bereits Flachbildschirme mit punktweiser Bildrekonstruktion. In beiden Fällen werden die Bildpunkte von adressierbaren Steuersignalen angesprochen. Damit sich der Lesestrahl und der Schreibstrahl gleichzeitig in richtiger Zuordnung über die Bildfläche bewegen bzw. damit bei der bildpunktweisen Aufnahme und Wiedergabe jeweils gleiche Bildpunkte zugeordnet werden, müssen geeignete Synchronisierzeichen übertragen werden.

2.1.2 Zeilenzahl

Die Qualität der Bildübertragung wird durch die Auflösung des Bildes, d. h. durch die Anzahl der Zeilen und Bildpunkte in der Zeile, bestimmt. Die Auflösung und damit die Bildschärfe ist umso besser, je höher die Anzahl der Bildpunkte pro Zeile (horizontale Auflösung) und je höher die Zeilenzahl (vertikale Auflösung) ist. Mit zunehmender Anzahl von Bildpunkten und Zeilen wachsen aber auch die Anforderungen an die Bandbreite des Übertragungssystems, so dass es gilt, einen vernünftigen Kompromiss zu finden.

Eine Mindestzahl von Zeilen ist notwendig, damit die Rasterstruktur des wiedergegebenen Bildes nicht störend in Erscheinung tritt. Diese kann jedoch nur im Zusammenhang mit den Abmessungen des Fernsehbildes und dem Betrachtungsabstand sowie dem Auflösungsvermögen des menschlichen Auges gefunden werden. Nach einer Näherungsformel erhält man für die mindestens notwendige Anzahl Zaktiv der auf dem Bildschirm sichtbaren Zeilen

wobei der Betrachtungsabstand und die Höhe des sichtbaren Bildes sind. Mit einem vernünftigen Wert von E/H = 5 ergibt sich eine mindestens notwendige Anzahl von aktiv = 500 sichtbaren Zeilen. Diesen Wert findet man annähernd auch in den eingeführten Standard-Fernsehsystemen.

Europäisches 625-Zeilen-System: 575 (analog) bzw. 576 (digital) aktive, d.h. sichtbare Zeilen

Amerikanisches 525-Zeilen-System: 485 (analog) bzw. 480 (digital) aktive, d.h. sichtbare Zeilen

2.1.3 Bild-Seitenverhältnis

Das Verhältnis von Bildbreite ßzur Bildhöhe H wurde vom ursprünglichen Kino- Bildformat mit

B/H = 4 : 3

übernommen. Beim Kinofilm gibt es aber mittlerweile fast 20 verschiedene Breitbildformate. Für das „kinoähnliche“ Fernsehbild, ursprünglich nur auf das hochauflösende Fernsehen HDTV bezogen, wurde in Europa ein Breitbildformat von

B/H =16 : 9

festgelegt, was einem Verhältnis von (4 : 3)- 4/3 bzw. 5,33 : 3 entspricht. Dieses „Breitbildformat“ wurde mittlerweile auch bei Standard-TV (SDTV), z.B. bei dem PALplus-System, eingeführt. Das Bild-Seitenverhältnis ist praktisch durch das Format der Bildwiedergaberöhre bestimmt. Bei Breitbildröhren kann durch eine geringere Horizontalablenkung auch ein 4 : 3-Bild wiedergegeben werden.

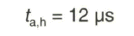

2.1.4 Bildwechselfrequenz

Die Übertragung einer Bewegtbildvorlage erfolgt ähnlich wie beim Kinofilm über eine Folge von einzelnen Teilbildern. Bei der Festlegung der Bildwechselfrequenz sind die physiologischen Eigenschaften des menschlichen Sehorgans zu berücksichtigen. Zunächst muss davon ausgegangen werden, dass zur Wiedergabe eines kontinuierlichen, schnellen Bewegungsvorgangs eine bestimmte Mindest- Teilbildfrequenz erforderlich ist, damit keine störenden Diskontinuitäten im Bild entstehen. Ein Wert von 16 Teilbildern pro Sekunde stellt hier die untere Grenze dar. Beim Kinofilm arbeitet man mit 24 Teilbildern pro Sekunde. Dieser Wert könnte auch beim Fernsehen übernommen werden, doch es wurde hier mit Rücksicht auf eine mögliche Verkopplung mit der Netzfrequenz (u. a. auch wegen der Beleuchtungstechnik mit Gasentladungslampen) eine Bildwechselfrequenz von

beziehungsweise von

![]()

gewählt. In den USA wurde der Wert bei der Einführung des Farbfernsehens geringfügig geändert von 30 Hz auf 29,97 Hz.

Eine Bildwechselfrequenz von 25 Hz oder 30 Hz reicht jedoch für eine flimmerfreie Bildwiedergabe nicht aus. Die subjektiv empfundene Flimmerstörung eines in der Helligkeit periodisch schwankenden Bildfeldes hängt von verschiedenen Faktoren ab. Dazu zählen die Frequenz der Helligkeitsschwankung und das Verhältnis Hell- zu Dunkelzeit. Die Flimmergrenzfrequenz, oberhalb der unter normalen Bedingungen kein Flimmern mehr wahrgenommen wird, liegt etwa zwischen 50 Hz und 60 Hz.

Dieses Problem lag auch schon bei der Einführung des Kinofilms vor und wurde durch eine Verdoppelung der Teilbildfrequenz gelöst. Über eine so genannte Flimmerblende wird die Projektion jedes Teilbildes einmal unterbrochen, wodurch der Eindruck der doppelten Bildwechselfrequenz entsteht. Bei der Einführung des Fernsehens konnte man noch nicht auf die heute mögliche Speicherung von Fernsehteilbildern zurückgreifen. Es musste eine andere Möglichkeit zur Erhöhung der Teilbildfrequenz gefunden werden.

2.1.5 Zeilensprungverfahren

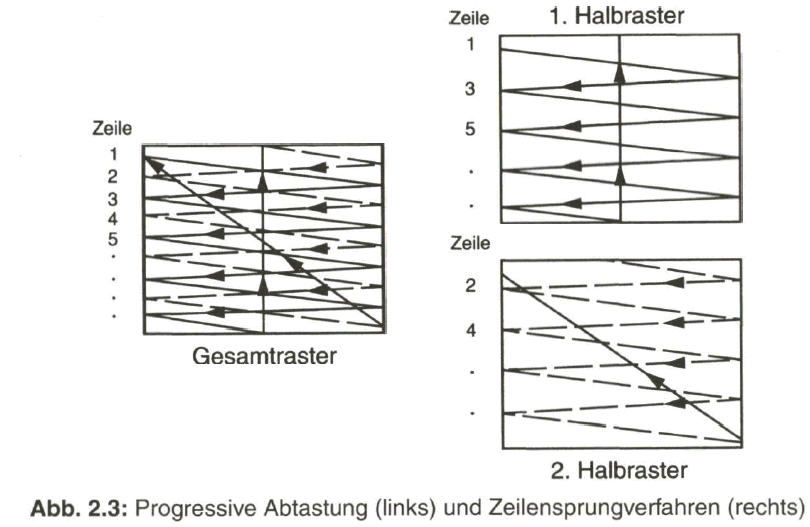

Die Bildwechselfrequenz auf den doppelten Wert zu erhöhen wäre zwar eine Möglichkeit, um das Flimmern (weitestgehend) zu vermeiden. Es hätte aber gleichzeitig eine Erhöhung der notwendigen Übertragungsbandbreite um den Faktor zwei zur Folge. Schon sehr früh angestellte Versuche ergaben jedoch, dass die Bildwechselfrequenz auf kleine Bildbereiche bezogen relativ niedrig sein kann, wenn nur das Zeilenraster genügend oft geschrieben wird.

Gegenüber der so genannten progressiven Abtastung, wo gemäß der bisherigen Annahme die Zeilen aufeinanderfolgend abgetastet und geschrieben werden (Bild 2.3, links), erfolgt beim Zeilensprungverfahren (auch Zwischenzeilenverfahren genannt, engl, interlaced scanning) eine Aufteilung des gesamten Rasters in zwei Halbraster mit jeweils halber Zeilenzahl, die ineinander verschachtelt sind und die zeitlich nacheinander übertragen und geschrieben werden (Bild 2.3, rechts). In der Darstellung nach Bild 2.3 wird vereinfacht davon ausgegangen, dass das horizontale Zurücksetzen auf den Anfang der nächsten zu übertragenden Zeile sowie das vertikale Zurücksetzen auf den Anfang des nächsten zu übertragenden Vollbildes oder Halbbildes in vernachlässigbar kurzer Zeit geschieht.

Der Wechsel vom ersten zum zweiten Halbraster erfolgt bei ungerader Zeilenzahl, zum Beispiel mit Z= 625, am Ende des ersten Halbrasters nach Durchlaufen einer halben Zeile, womit das zweite Halbraster mit der verbleibenden halben Zeile beginnt. Damit erübrigt sich ein besonderes Hilfssignal zum periodischen Versatz der beiden Halbraster und es ist stets die Voraussetzung geschaffen, dass die Zeilen des zweiten Halbrasters mittig in den Zwischenräumen des ersten Halbrasters liegen und somit ein gleichmäßig verteiltes Gesamtraster entsteht.

An Stelle von

25 Vollbildern pro Sekunde, engl. frames,

mit je 625 Zeilen bei dem europäischen Fernsehsystem und der

Bildwechselfrequenz fw = 25 Hz,

werden also

50 Halbbilder pro Sekunde, engl. fields,

mit je 312 1/2 Zeilen übertragen. Es ergibt sich somit eine

Halbbildwechselfrequenz,

auch als Rasterwechselfrequenz oder Vertikalfrequenz bezeichnet, mit

![]()

Die Periodendauer des Halbbildwechsels beziehungsweise die Periodendauer der Vertikalablenkung, engl. field duration beträgt

![]()

Ein heute neu zu definierendes Fernsehsystem würde, wie auch beim Computer- Monitor, mit progressiver Abtastung arbeiten. Mit Rücksicht auf die eingeführten und installierten Geräte und Systeme kann jedoch keine abrupte Umstellung von Zeilensprung-Abtastung auf progressive Abtastung erfolgen. Wie später angeführt wird, bietet aber das digitale Fernsehen die Möglichkeit, auch auf progressive Abtastung überzugehen, was z.B. bei den digitalen Standards in den USA schon ausgenützt wird.

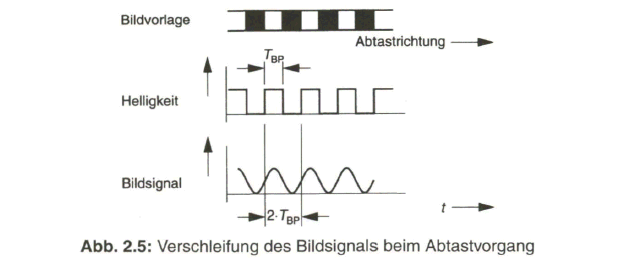

2.1.6 Zeilenfrequenz

Die Zeilenwechselfrequenz oder Zeilenfrequenz, auch Horizontalwechselfrequenz ![]() genannt, engl. line frequency, leitet sich nach der Beziehung

genannt, engl. line frequency, leitet sich nach der Beziehung

ab. Beim europäischen 625-Zeilen-System sind dies

![]() = 312 1/2 • 50 Hz = 625 • 25 Hz = 15 625 Hz.

= 312 1/2 • 50 Hz = 625 • 25 Hz = 15 625 Hz.

Der Zeilenfrequenz von ![]() = 15 625 Hz

= 15 625 Hz

entspricht eine Zeilenperiodendauer oder Zeilendauer ![]()

die üblicherweise mit dem Buchstaben H ausgedrückt wird. Beim europäischen 625-Zeilen-Fernsehsystem entspricht somit H- 64 die üblicherweise mit dem Buchstaben H ausgedrückt wird. Beim europäischen 625-Zeilen-Fernsehsystem entspricht somit H- 64![]()

2.2 BAS-Signal

Unter dem BAS-Signal versteht man das (für Schwarzweiß-Bildübertragung) komplette Videosignal, das sich aus dem eigentlichen Bildsignal (B), dem Austastsignal (A) und dem Synchronsignal (S) zusammensetzt. Das Bildsignal enthält die bildpunktweise in den einzelnen Zeilen gewonnene Information über die Helligkeitsverteilung der zu übertragenden Bildvorlage. Im Englischen wird das BAS-Signal als Composite Video Sync Signal (CVSS) bezeichnet.

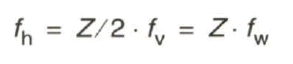

2.2.1 Bildsignal mit Gamma-Korrektur

Wie eingangs erwähnt, dient zur Bildwiedergabe beim Fernsehen auch heute noch in den allermeisten Fällen die Fernsehbildröhre, eine Hochvakuum-Elektronenstrahlröhre. Die Übertragungskennlinie der Fernsehbildröhre, also die Umsetzung einer Steuerspannung ![]() in den abgestrahlten Wiedergabe-Lichtstrom

in den abgestrahlten Wiedergabe-Lichtstrom ![]() ist nicht linear und folgt der Beziehung

ist nicht linear und folgt der Beziehung

![]()

Der Exponent ![]() hat einen Wert von etwa 2,2.

hat einen Wert von etwa 2,2.

Bei einer üblicherweise linearen Übertragungskennlinie des Aufnahmewandlers hätte dies über das gesamte Aufnahme-Wiedergabe-System eine Gradationsverzerrung zur Folge, d.h. helle Bildanteile wären gegenüber den dunklen zu stark hervorgehoben. Um dem zu begegnen, wird das Bildsignal nach dem Aufnahmewandler, bezogen auf den Aufnahme-Lichtstrom ![]() durch eine zur Bildröhren- Kennlinie inverse Übertragungsfunktion korrigiert, gemäß der Beziehung

durch eine zur Bildröhren- Kennlinie inverse Übertragungsfunktion korrigiert, gemäß der Beziehung

![]()

womit im System insgesamt wieder eine lineare Beziehung

![]()

gilt. Siehe dazu Bild 2.4.

Der Exponent ![]() üblicherweise den Wert 0,45. Die Gamma-Korrektur erfolgt nach dem Aufnahmewandler im Kameravorverstärker.

üblicherweise den Wert 0,45. Die Gamma-Korrektur erfolgt nach dem Aufnahmewandler im Kameravorverstärker.

Das gammakorrigierte Bildsignal wird, insbesondere später beim Farbfernsehen in der Zusammensetzung mit den Farbwertsignalen aus dem Rot(R)-, Grün(G)- und Blau(ß)-Kanal, durch einen hochgestellten Strich gekennzeichnet: R\ G\ B'.

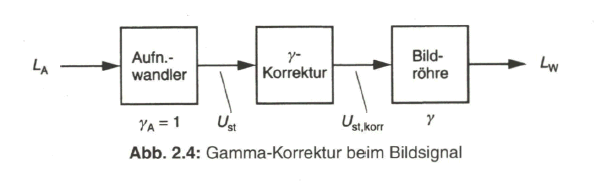

2.2.2 Bandbreite des Bildsignals

Das vom Videosignal belegte Frequenzband wird durch die Bildpunktauflösung in horizontaler Richtung und durch die Zeilenzahl bestimmt. Die Auflösung in vertikaler Richtung ist wegen der Zeilenstruktur diskontinuierlich und quantisiert. In horizontaler Richtung ergibt sich, bei angenommener Elektronenstrahlabtastung durch die kontinuierliche Bewegung des Abtaststrahles, eine Verschleifung von Hell-Dunkel-Kanten. Dies geschieht auch im Fall der bildpunktweisen „Abtastung" bei den CCD-Wandlern, weil wegen des Abtastvorganges eine Tiefpass-Filterung notwendig wird. Siehe dazu Bild 2.5.

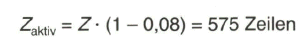

Zur Berechnung der höchsten im Bildsignal vorkommenden Frequenzkomponente, der maximalen Bildfrequenz, wird der Einfachheit halber von gleicher Auflösung des Bildes in horizontaler und vertikaler Richtung ausgegangen, das heißt die Bildpunktbreite b wird gleich dem Zeilenabstand oder der Zeilenbreite a angenommen (Bild 2.6, links).

Der Abtaststrahl muss nach Durchlaufen jeder Zeile und jedes Teilbildes wieder zurückgeführt werden. Während des Strahlrücklaufes werden sowohl der Lesestrahl im Aufnahmewandler als auch der Schreibstrahl in der Bildröhre dunkel gesteuert. Innerhalb der Periodendauer ![]() der Horizontalablenkung beziehungsweise

der Horizontalablenkung beziehungsweise ![]() der Vertikalablenkung werden Austastzeiten

der Vertikalablenkung werden Austastzeiten ![]() und

und ![]() festgelegt.

festgelegt.

Beim 625-Zeilen-System nach dem ITU-R-Standard 624, System B bzw. G, beträgt die Zeitdauer der Horizontalaustastung

entsprechend 18,75 % von der Periodendauer ![]() und die Zeitdauer der Vertikalaustastung

und die Zeitdauer der Vertikalaustastung

entsprechend 8 % von der Periodendauer ![]() plus

plus ![]()

Von der gesamten Zeilenperiodendauer ![]() steht somit zur Übertragung des Bildinhaltes einer Zeile nur die Zeit

steht somit zur Übertragung des Bildinhaltes einer Zeile nur die Zeit

![]()

und von der gesamten, der Periodendauer  zugeordneten Zeilenzahl Z nur der Anteil

zugeordneten Zeilenzahl Z nur der Anteil

für die Bildübertragung zur Verfügung (Bild 2.6, rechts).

Für das sichtbare Bild ist ein Bild-Seitenverhältnis von B/H = 4/3 festgelegt. Bei gleicher Auflösung in horizontaler und vertikaler Richtung berechnet sich hieraus eine Anzahl von

4/3 • 625 • (1 - 0,08) = 767 Bildpunkte je aktive Zeile

und mit 625 • (1 - 0,08) aktiven Zeilen ein Wert von

4/3 • 625 • (1 - 0,08) ■ 625 • (1 - 0,08) = 440 833 Bildpunkte je Bild.

Diese Anzahl von Bildpunkten wird in einer Zeit von

64 ps • (1 - 0,1875) • 625 • (1 - 0,08) = 29,9 ms übertragen.

Für die Zeit zum Durchlaufen eines Bildpunktes ergibt sich dann

Die höchste Bildpunktfrequenz, die auch als Schachbrettfrequenz bezeichnet wird, tritt auf, wenn helle und dunkle Bildpunkte aufeinander folgen (siehe Bild 2.5). Das Bildsignal weist in diesem Fall eine Periodendauer ![]() von

von

Wegen des endlichen Durchmessers des angenommenen Abtaststrahles und der damit verbundenen Verschleifung des Hell-Dunkel-Überganges genügt es, die Grundschwingung des rechteckförmigen, idealisierten Signalverlaufes zu übertragen. Dies führt zu einer höchsten vorkommenden Bildfrequenz von

![]()

Die Grenze der Auflösung in vertikaler Richtung ist durch die Zeilenstruktur gegeben. Bei voller vertikaler Auflösung und fehlender Vorfilterung würde durch den zeilenweisen Abtastvorgang ein Übersprechen im Spektrum auftreten, das zu Schwebungseffekten im wiedergegebenen Bild führen könnte. Es wird deshalb bei dem angenommenen Abtaststrahl durch eine „optische Unschärfe“ die Auflösung in vertikaler, aber gleichzeitig auch in horizontaler Richtung reduziert. Die maximale Bildfrequenz verringert sich daher etwa um den Faktor 2/3. Dieser Faktor wird als KELL-Faktor bezeichnet, unter Bezugnahme auf R. D. KELL, der sich eingehend mit dem Problem der Fernsehbildzerlegung beschäftigt hat.

Man kommt so letztendlich beim 625-Zeilen-Fernsehsystem auf eine durch den Standard festgelegte Bandbreite des Videosignals von

Mit der daraus berechneten Periodendauer ![]() einer Schwarz-Weiss- Bildpunktfolge von 0,2

einer Schwarz-Weiss- Bildpunktfolge von 0,2 ![]() im aktiven Teil der Zeile mit 52

im aktiven Teil der Zeile mit 52 ![]() erhält man eine Auflösung in 520 Bildpunkte pro Zeile. Für den 525-Zeilen-Standard ist eine Video-Bandbreite von 4,2 MHz festgelegt, was einer Auflösung in 442 Bildpunkte pro Zeile entspricht.

erhält man eine Auflösung in 520 Bildpunkte pro Zeile. Für den 525-Zeilen-Standard ist eine Video-Bandbreite von 4,2 MHz festgelegt, was einer Auflösung in 442 Bildpunkte pro Zeile entspricht.

2.2.3 Austastsignal

Während des horizontalen und vertikalen Strahlrücklaufes wird das Bildsignal in seinem zeitlichen Verlauf unterbrochen, es wird „ausgetastet“. Der Signalpegel wird auf dem Schwarzwert festgehalten. Die Austastung des Bildsignals wird durch das Austastsignal vorgenommen, das sich aus den zeilenfrequenten Horizontal-Austastimpulsen mit der Dauer ![]() = 12

= 12 ![]() und den im Rhythmus des Halbbildwechsels erscheinenden Vertikal- Austastimpulsen mit der Dauer

und den im Rhythmus des Halbbildwechsels erscheinenden Vertikal- Austastimpulsen mit der Dauer ![]() = 1,612 ms zusammensetzt. Das so modifizierte Bildsignal wird dadurch zum BA-Signal.

= 1,612 ms zusammensetzt. Das so modifizierte Bildsignal wird dadurch zum BA-Signal.

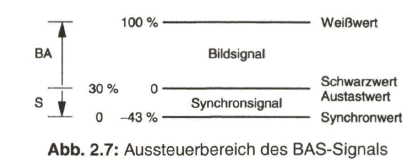

2.2.4 Synchronsignal

Das empfangsseitig auf der Fernsehbildröhre geschriebene Zeilenraster muss synchron mit dem sendeseitigen Zeilenraster ablaufen. Dazu werden neben dem Bildsignal noch Synchronimpulse erzeugt und übertragen. Sie steuern gleichermaßen die Ablenkeinrichtungen beim Aufnahme- und Wiedergabewandler. Eingebracht werden die Synchronimpulse während der horizontalen und vertikalen Austastzeiten. Pegelmäßig liegt das Synchronsignal unter dem Austastwert (Bild 2.7).

Die Impulse zur Synchronisierung der Horizontal- und Vertikalablenkung müssen eindeutig unterscheidbare Merkmale aufweisen. Innerhalb des wertmäßig zugeordneten Spannungsbereiches für die Synchronimpulse ist dies möglich durch die unterschiedliche Folgefrequenz und Impulsdauer.

Nach den Parametern der 625-Zeilen-Norm, ITU-R 624.BT, System B bzw. G, beginnt der Horizontal-Synchronimpuls 1,5 ![]() nach der Vorderflanke des Horizontal-Austastimpulses. Die Vorderflanke des 4,7

nach der Vorderflanke des Horizontal-Austastimpulses. Die Vorderflanke des 4,7 ![]() breiten Horizontal-Synchronimpulses ist bestimmend für das Einsetzen der Synchronisierung. Die innerhalb der Horizontalaustastung nachfolgende hintere Schwarzschulter dient als Schwarz- Bezugswert. Der Horizontal-Synchronimpuls wird im Bildwiedergabegerät über ein Differenzierglied (RC-Hochpass) aus dem Synchronsignalgemisch ausgesiebt. Damit bleibt das Kriterium der Synchronisation durch die Vorderflanke erhalten.

breiten Horizontal-Synchronimpulses ist bestimmend für das Einsetzen der Synchronisierung. Die innerhalb der Horizontalaustastung nachfolgende hintere Schwarzschulter dient als Schwarz- Bezugswert. Der Horizontal-Synchronimpuls wird im Bildwiedergabegerät über ein Differenzierglied (RC-Hochpass) aus dem Synchronsignalgemisch ausgesiebt. Damit bleibt das Kriterium der Synchronisation durch die Vorderflanke erhalten.

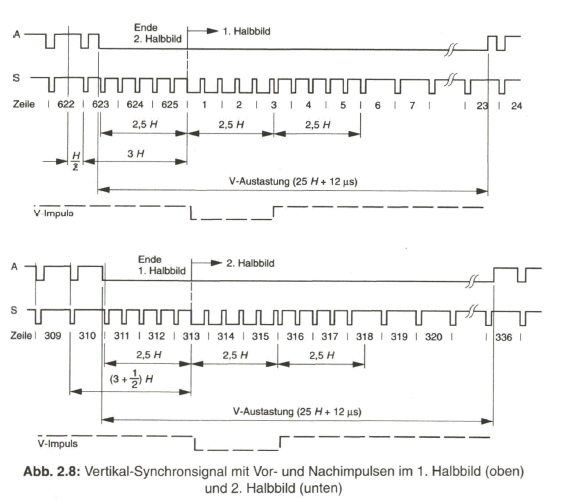

Innerhalb der Vertikal-Austastlücke wird der Vertikal-Synchronimpuls übertragen. Er ist mit einer Dauer von 160 ![]() (2,5 H) wesentlich länger als der Horizontal-Synchronimpuls. Damit während der Zeit von 2,5 mal der Zeilendauer kein Ausfall der Horizontal-Synchronisierung erfolgt, wird der Vertikal-Synchronimpuls jeweils kurz unterbrochen. Wegen des Halbzeilenversatzes der beiden Teilraster geschieht diese Unterbrechung im Abstand von H/2. In Bild 2.8, mit der Darstellung der kompletten Vertikal-Synchronimpulsfolge innerhalb der V-Austastlücke des ersten und zweiten Halbbildes, sind die für die Horizontal-Synchronisierung maßgebenden Impulsflanken markiert.

(2,5 H) wesentlich länger als der Horizontal-Synchronimpuls. Damit während der Zeit von 2,5 mal der Zeilendauer kein Ausfall der Horizontal-Synchronisierung erfolgt, wird der Vertikal-Synchronimpuls jeweils kurz unterbrochen. Wegen des Halbzeilenversatzes der beiden Teilraster geschieht diese Unterbrechung im Abstand von H/2. In Bild 2.8, mit der Darstellung der kompletten Vertikal-Synchronimpulsfolge innerhalb der V-Austastlücke des ersten und zweiten Halbbildes, sind die für die Horizontal-Synchronisierung maßgebenden Impulsflanken markiert.

Das Kriterium für die Synchronisierung der Vertikalablenkung gewinnt man durch Integration des vollständigen Synchronsignals, bei der wegen der Tiefpasswirkung des Integriergliedes (RC-Tiefpass) und der längeren Impulsdauer des Vertikal-Synchronimpulses nur dieser den entscheidenden Beitrag für die Spannung am Integrationskondensator liefert.

Die dem Vertikal-Synchronimpuls vorangehenden Horizontal-Synchronimpulse ergäben jedoch wegen des H/2-Versatzes in den beiden Halbbildern unterschiedliche Anfangsbedingungen für den Integrationsvorgang. Dies könnte zu einem falschen Einsetzen der Vertikal-Synchronisierung und damit zu einer Paarigkeit der Rasterzeilen führen. Es werden deshalb dem eigentlichen Vertikal-Synchronimpuls fünf schmale, 2,35![]() breite Ausgleichsimpulse - die Vorimpulse jeweils im Abstand von H/2 vorausgeschickt, damit in jedem Halbbild gleiche Anfangsbedingungen für die Integration herrschen. In ähnlicher Weise sorgen fünf Nachimpulse für eine gleichmäßige Rückflanke der integrierten Vertikal-Teilimpulse.

breite Ausgleichsimpulse - die Vorimpulse jeweils im Abstand von H/2 vorausgeschickt, damit in jedem Halbbild gleiche Anfangsbedingungen für die Integration herrschen. In ähnlicher Weise sorgen fünf Nachimpulse für eine gleichmäßige Rückflanke der integrierten Vertikal-Teilimpulse.

Zur Zählweise der Zeilen in Bild 2.8 ist noch Folgendes zu sagen: In der Fernsehtechnik ist es üblich, entgegen der Aufteilung in ungeradzahlige und geradzahlige Zeilen gemäß Bild 2.3, die aufeinanderfolgend ablaufenden Zeilen durchgehend zu nummerieren. Das erste Halbbild beginnt bei der Vorderflanke des Vertikal-Synchronimpulses mit Zeile 1 und es weist 312 ![]() Zeilen auf. Davon fallen die ersten 22 1/2 Zeilen in die Vertikal-Austastlücke. Das zweite Halbbild beginnt nach 312 1/2 Zeilen in der Mitte der 313. Zeile. Danach wiederholt sich die Zählweise im Rhythmus von zwei Halbbildern.

Zeilen auf. Davon fallen die ersten 22 1/2 Zeilen in die Vertikal-Austastlücke. Das zweite Halbbild beginnt nach 312 1/2 Zeilen in der Mitte der 313. Zeile. Danach wiederholt sich die Zählweise im Rhythmus von zwei Halbbildern.

Das Synchronsignal wird an der Videosignalquelle pegelgerecht dem BA-Signal zugesetzt. Man erhält so das BAS-Signal. Der Normspannungswert für das BAS- Signal beträgt in der Studio- und Fernsehmesstechnik 1 V (Spitze-Spitze-Wert), wobei auf den BA-Anteil 70 % (0,7 V) und auf den S-Anteil 30 % (0,3 V) entfallen. Als Bezugspegel kann der Austastwert gelten (nach ITU-R-Norm) mit dem Weißwert bei 100 % und dem Synchronwert bei -43 % oder der Synchronpegel, wobei dann der Austastwert bei 30 % vom Weißwert liegt (siehe dazu Bild 2.7). Der Bezugswiderstand in der Videotechnik ist 75 Ohm.

2.3 Farbbildsignal

Den bisherigen Ausführungen liegt die Übertragung der Helligkeitsinformation einer bunten Bildvorlage zu Grunde. Beim „Fernsehen“ wird jedoch schon seit langen Jahren dem Zuschauer ein „Farbbild“ übertragen.

2.3.1 Farbbildaufnahme und -Wiedergabe

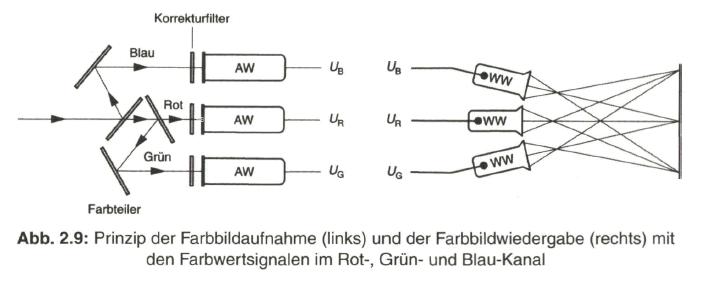

Die Farbbildaufnahme beim Fernsehen basiert auf dem Vorgang der Wahrnehmung eines Farbreizes durch das menschliche Auge, wo auf der Netzhaut neben den auf Helligkeitsunterschiede reagierenden Stäbchen noch weitere Sensoren, die Zäpfchen, auf einfallende Lichtstrahlung im Spektralbereich von Blau (etwa 400 bis 500 nm), Grün (etwa 500 bis 600 nm) und Rot (etwa 600 bis 700 nm) reagieren. Über eine Mischung der drei Teilempfindungen entsteht der Farbeindruck. Daraus ergibt sich auch das Prinzip der Farbbildaufnahme über drei optisch-elektrische Aufnahmewandler (AW). Das über ein optisches Linsensystem einfallende Licht wird in einem Farbteiler, bestehend aus halbdurchlässigen Spiegeln, Umlenkspiegeln und Korrekturfiltern, den drei Aufnahmewandlern für den Rot-, Grün- und Blau-Kanal zugeführt (Bild 2.9, links).

Das Aufnahmesystem ist farbmetrisch auf die Eigenschaften des Farbbildwiedergabesystems abgestimmt. Die Farbbildwiedergabe kann prinzipiell mit drei elektrisch-optischen Wiedergabewandlern (WW) und Projektion über ein Linsensystem auf einen gemeinsamen Bildschirm erfolgen (Bild 2.9, rechts). Diese Anordnung findet sich in Projektionssystemen wieder. Bei dem herkömmlichen Farbfernsehempfänger kommt als Wiedergabewandler noch immer die Fernsehbildröhre, teilweise auch schon der Flachbildschirm mit LCD- oder Gasentladungstechnik zum Einsatz.

2.3.2 Farbwertsignale R, G, B

Das Farbbildaufnahmesystem liefert die Farbwertsignale mit der Spannung UR, UG und UB bzw. korrekterweise mit gammakorrigierten Signalen UR \ UG und UB. Der Einfachheit halber werden die Farbwertsignale nur mit R, G und B bezeichnet.

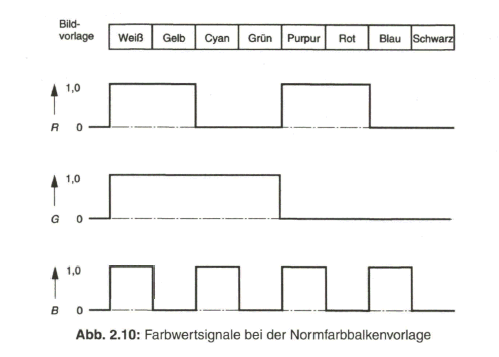

Für Abgleich- und Testzwecke verwendet man eine so genannte Farbbalkenvorlage. Diese setzt sich zusammen aus vertikalen Balken mit den Unbuntstufen Weiß und Schwarz sowie den Grund- oder Primärfarben Rot, Grün und Blau und den Mischfarben Cyan (Blau und Grün), Gelb (Grün und Rot) und Purpur (Rot und Blau). Die Reihenfolge der Farbbalken ist nach sinkender Helligkeit angeordnet. So ergeben sich bei der zeilenweisen Abtastung dieser Bildvorlage die Farbwertsignale R, G und B bezogen auf die (aktive) Zeilendauer gemäß Bild 2.10.

2.3.3 Helligkeits- oder Leuchtdichtesignal

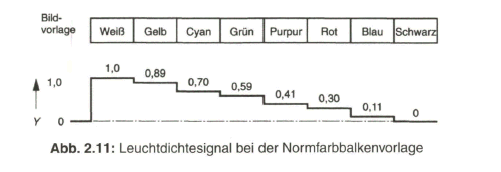

Schon aus der Kompatibilitätsforderung bei Einführung des Farbfernsehens ergab sich, dass weiterhin ein Helligkeitssignal erforderlich ist. Auch unter Bezugnahme auf die Lichtwahrnehmung des menschlichen Auges über ein Helligkeitsempfinden und ein Farbempfinden wird deshalb aus den Farbwertsignalen unter Berücksichtigung des spektral unterschiedlichen Helligkeitsempfindens ein Helligkeitssignal abgeleitet, das jetzt mit dem farbmetrisch korrekten Ausdruck als Leuchtdichtesignal Y bezeichnet wird, und sich gemäß der Beziehung

![]()

zusammensetzt.

Das Y-Signal wird über eine Matrix-Schaltung, zum Beispiel über ein Widerstandsnetzwerk, aus den R-G-B-Signalen gewonnen. Bild 2.11 zeigt den Verlauf des Y-Signals bei der Normfarbbalkenfolge.

Die Leuchtdichte wird vielfach auch mit Luminanz bezeichnet, vom englischen Begriff luminance übernommen, woraus sich ein Luminanzsignalableitet.

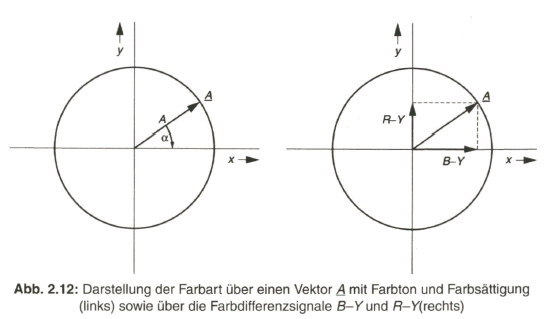

2.3.4 Farbdifferenzsignale

Ein Farbreiz, wird neben der Helligkeit oder Leuchtdichte noch durch die Farbart charakterisiert. Dieser Begriff beinhaltet eine Doppelinformation, nämlich eine Aussage über den Farbton, der über die Wellenlänge der reinen oder dominierenden Spektralkomponente in der Lichtstrahlung angegeben werden kann, und eine Aussage über die Farbsättigung, als ein Maß für die spektrale Reinheit gegenüber dem Gleichenergieweiß, in dem alle Spektralkomponenten der sichtbaren Strahlung mit gleicher Energie vertreten sind. Die Farbart wird auch als Chrominanz bezeichnet, aus dem englischen Ausdruck chrominance, mit dem Farbton, engl, hue oder colour hue und der Farbsättigung, engl. colour Saturation. Entsprechend der Doppelinformation kann die Farbart nur in zweidimensionaler Darstellung angegeben werden. Dies ist möglich in einem Polar-Koordinatensystem als Vektor A, dessen Winkel a zur positiven x-Achse die Wellenlänge und damit den Farbton ausdrückt und dessen Länge A ein Maß für die Farbsättigung angibt (siehe Bild 2.12, links).

Die Farbart kann aber auch über die Achsenabschnitte aus der Projektion des Vektors A auf die X- und Y-Achse angegeben werden. Es sind dies die Farbdifferenzsignale B-Y und R-Y (siehe Bild 2.12, rechts).

Die Farbdifferenzsignale können positiven oder negativen Wert haben. Sie werden zu Null bei Unbunt, d. h. bei Weiß und allen Grauwerten bis Schwarz. Die Übertragung des Farbbildsignals erfolgt entweder über die Farbwertsignale R, G, B, wobei jedes dieser Signale die volle Videobandbreite von z. B. 5 MHz aufweist, oder mittels Leuchtdichtesignal Y und den Farbdifferenzsignalen B-Y und R-Y. In diesem Fall weist nur das Leuchtdichtesignal die volle Videobandbreite auf. Die beiden Farbdifferenzsignale können wegen der geringeren Auflösung des menschlichen Sehorgans für Farbdetails mit einer niedrigeren Bandbreite als für das Leuchtdichtesignal (etwa ein Viertel bis ein Halb der Luminanz-Bandbreite) übertragen werden.

Die Wiedergewinnung der Farbwertsignale R, G und B auf der Empfängerseite erfolgt gemäß den Beziehungen

(R- Y)+Y= R

(B- Y) + Y= B

(G- Y)+Y=G

Das nicht übertragene (G-V)-Signal wird aus

Gl. (2.3) Y=0,30- R +0,59- G + 0,11 •B

und mit Y= 0,30 • Y+ 0,59 • Y+ 0,11 -Y

berechnet zu

(G-Y)--0,51 • (R- V)-0,19 • (B- Y).

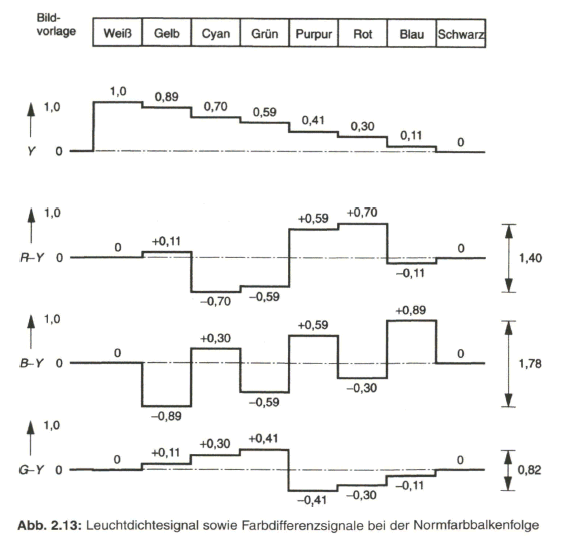

Bild 2.13 gibt die bei der Normfarbbalken-Bildvorlage zeilenperiodischen Signale für Y sowie R-Y, B-Y und G-Y wieder. Dabei ist zu ersehen, dass die Farbdifferenzsignale bipolar sind und in ihrem Spitze-Spitze-Wert den auf 1,0 normierten Wert beim Leuchtdichtesignal für den Bereich von Schwarz bis Weiß überschreiten.

2.4 FBAS-Signal

Zur Übertragung der Farbartinformation im analogen Fernsehsignal musste eine Lösung gefunden werden, die es erlaubt, zusätzlich zum BAS-Signal im gleichen Frequenzband des Videosignals ein „Farbartsignal“ ohne gegenseitige Störungen einzufügen.

2.4.1 Spektrum des Leuchtdichte- bzw. BAS-Signals

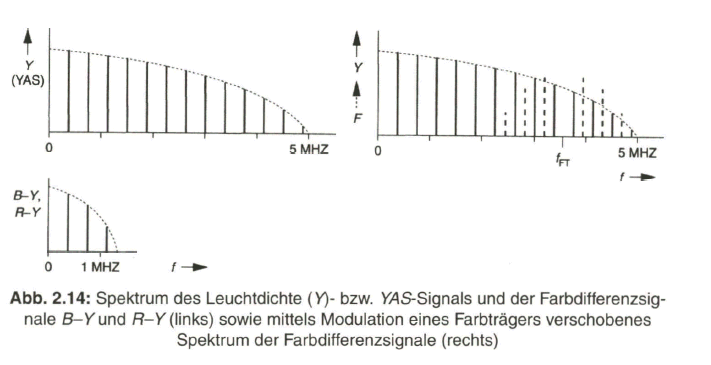

Beim ATSC-Verfahren, nach dem National Television System Committee benannt, und bei der verbesserten Variante, dem PAL-Verfahren, abgeleitet von Phase Alternation Line, nützt man im Spektrum des BAS- bzw. YAS-Signals die Lücken zwischen den einzelnen im Abstand der Horizontalfrequenz fh zueinander auftretenden Spektralkomponenten aus. Nachdem auch die Farbdifferenzsignale mit der Zeilenfrequenz verknüpft sind, treten deren Spektralkomponenten ebenso bei Vielfachen der Zeilenfrequenz auf, mit einer Begrenzung des Spektrums bei etwa einem Viertel der Bandbreite des BAS-Signals. Bild 2.14, links, zeigt dazu schematisch das Spektrum des BAS- bzw. YAS-Signals und der Farbdifferenzsignale B-Y und R-Y.

Es wird nun eine Frequenzverschiebung des Spektrums der Farbdifferenzsignale aus der Bezugsfrequenzlage von Null auf eine höhere Frequenzlage, symmetrisch um die Frequenz des Farbträgers vorgenommen, indem dieser in seiner 0°- Komponente mit dem (B-Y)-Signal und in seiner 90°-Komponente mit dem (P-Y)- Signal amplitudenmoduliert wird. Man erhält so das Farbartsignal F.

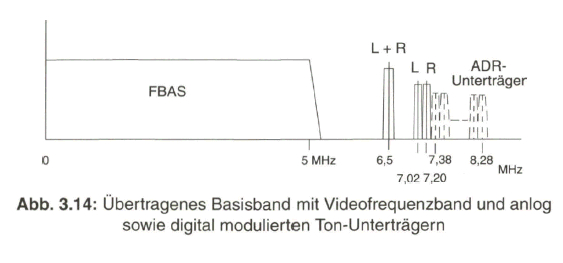

Die Frequenz ![]() des Farbträgers weist gegenüber den Spektralkomponenten des BAS-Signals einen Offset um die halbe Zeilenfrequenz auf (Halbzeilen-Offset). Sie liegt im oberen Bereich des BAS-Spektrums. Bild 2.14, rechts, gibt das verkämmte Spektrum von BAS-Signal und Farbartsignal wieder.

des Farbträgers weist gegenüber den Spektralkomponenten des BAS-Signals einen Offset um die halbe Zeilenfrequenz auf (Halbzeilen-Offset). Sie liegt im oberen Bereich des BAS-Spektrums. Bild 2.14, rechts, gibt das verkämmte Spektrum von BAS-Signal und Farbartsignal wieder.

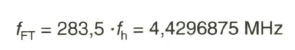

Die genaue Frequenz des Farbträgers wird bei dem NTSC-Verfahren durch den so genannten Halbzeilen-Offset bestimmt, mit dem Wert

(bezogen auf das europäische 625-Zeilen-System).

Bei dem PAL-Verfahren ist durch die zeilenweise Umpolung der 90°-Komponente der Farbträgerschwingung ein Viertelzeilen-Offset erforderlich, wobei noch ein zusätzlicher 25-Hz-Versatz dazukommt. Somit beträgt die Farbträgerfrequenz nun

![]()

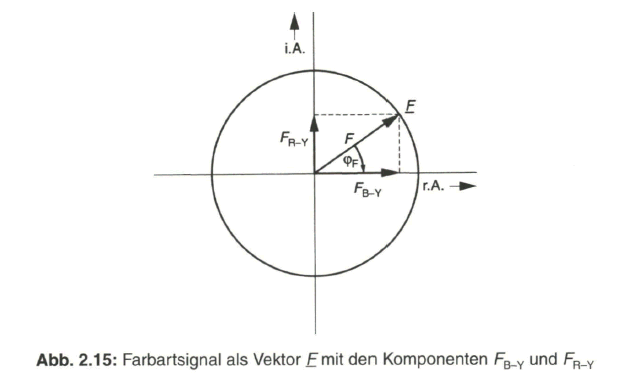

0°-Komponente vom (B-Y)-Signal und in einer 90°-Komponente vom (R-Y)-Signal modulierten Farbträgers. Man spricht in diesem Fall von Quadraturamplitudenmodulation. Technisch realisiert wird die Quadraturamplitudenmodulation über eine Amplitudenmodulation mit unterdrücktem Träger auf einer 0°-Komponente und auf einer 90°-Komponente des Farbträgers mit anschließender vektorieller Addition der Modulationsprodukte.

Die Doppelinformation Farbton und Farbsättigung wird so in die Phase und Amplitude des resultierenden Vektors F übertragen, mit den Komponenten![]() und

und ![]() (Bild2.15).

(Bild2.15).

2.4.2 Farbartsignal beim PAL-Verfahren

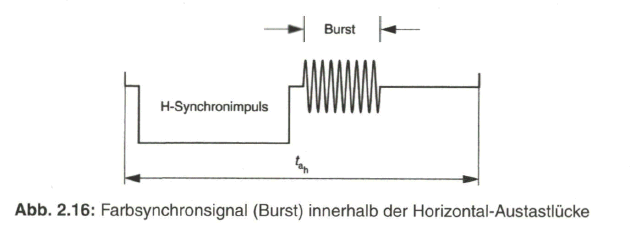

Beim Farbartsignal wird in der Phasenlage der modulierten Farbträgerschwingung gegenüber der Bezugslage 0° der Farbton übertragen. Die Bezugsphase 0° (bzw. 180°) wird während jeder Zeile durch eine Folge von etwa 10 Schwingungen des unmodulierten Farbträgers als Burst nach dem Horizontal-Synchronimpuls auf der hinteren Schwarzschulter der Empfängerseite übermittelt (Bild 2.16).

Eine Veränderung der Phase des Farbartsignals gegenüber der Burstphase auf dem Übertragungsweg führt zu einer Farbtonverfälschung. Um dem zu begegnen, wird beim PAL-Verfahren (Phase Alternation Line) eine Phasenfehlerkompensation durch eine zeilenweise Umpolung der ![]() Komponente (+90° oder -90°) bewirkt, die auf der Empfängerseite wieder rückgängig gemacht wird.

Komponente (+90° oder -90°) bewirkt, die auf der Empfängerseite wieder rückgängig gemacht wird.

Die jeweils übertragene Phasenlage der ![]() Komponente wird durch den synchron dazu mit seiner wechselnden ±90°-Komponente alternierenden Burst dem Empfänger übermittelt (Bild 2.17).

Komponente wird durch den synchron dazu mit seiner wechselnden ±90°-Komponente alternierenden Burst dem Empfänger übermittelt (Bild 2.17).

Die Phasenlage der FV- Komponente und damit auch des alternierenden Burst ist unter Bezug auf ungeradzahlige und geradzahlige Zeilen in aufeinanderfolgenden Halbbildern gemäß dem ITU-R-Standard 624 genau festgelegt. Es ergibt sich eine Wiederholung nach acht Halbbildern (8er-Sequenz). In Verbindung mit der Austastung des Bursts während eines Teils der Vertikal-Austastlücke wird damit gewährleistet, dass alle Halbbilder mit der gleichen Burstphase beginnen.

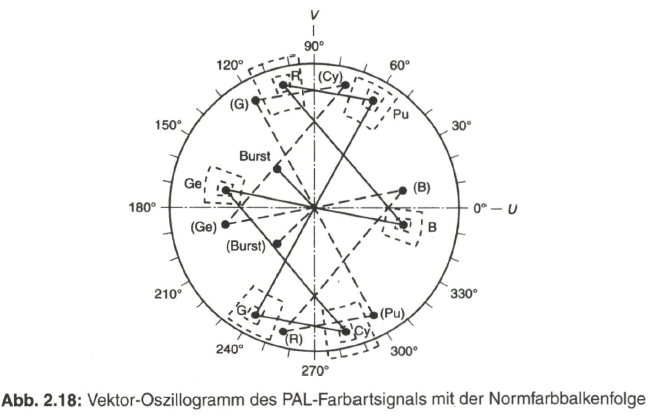

Mit dem Farbartsignal wird die Information über den Farbton, in der Phasenlage bezogen auf die Referenzphase des Burst, und über die Farbsättigung, in der Amplitude der Farbträgerschwingung, bezogen auf den Bildinhalt innerhalb des aktiven Teils einer Zeile übertragen. Am Beispiel der Normfarbbalkenvorlage (Bildvorlage siehe Bild 2.10) gibt Bild 2.18 das Vektor-Oszillogramm des PAL- Farbartsignals für zwei aufeinanderfolgende Zeilen mit der zeilenweise alternierenden ![]() bzw. FV- Komponente (auf der (R-Y)- bzw. V-Achse) und dem zeilenweise alternierenden Burst wieder. Die Endpunkte der Vektoren, die am Bildschirm der Elektronenstrahlröhre des Vektorskops als helle Punkte erscheinen, sollen dabei innerhalb eines engeren oder weiteren Toleranzbereiches liegen. Bei einer unbunten Bildvorlage werden die Farbdifferenzsignale zu Null und damit auch die Komponenten

bzw. FV- Komponente (auf der (R-Y)- bzw. V-Achse) und dem zeilenweise alternierenden Burst wieder. Die Endpunkte der Vektoren, die am Bildschirm der Elektronenstrahlröhre des Vektorskops als helle Punkte erscheinen, sollen dabei innerhalb eines engeren oder weiteren Toleranzbereiches liegen. Bei einer unbunten Bildvorlage werden die Farbdifferenzsignale zu Null und damit auch die Komponenten ![]() und

und ![]() des Farbartsignals. Im Vektor-Oszillogramm bedeutet dies, dass der Vektorendpunkt im Koordinaten-Nullpunkt liegt.

des Farbartsignals. Im Vektor-Oszillogramm bedeutet dies, dass der Vektorendpunkt im Koordinaten-Nullpunkt liegt.

Die Bedeutung der U- und V-Signale bzw. der ![]() und

und ![]() Signalkomponenten des Farbartsignals wird im Folgenden erläutert.

Signalkomponenten des Farbartsignals wird im Folgenden erläutert.

2.4.3 PAL-FBAS-Signal

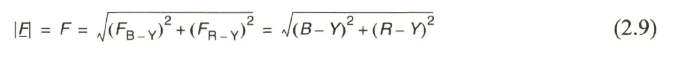

Das Farbartsignal F wird, zusammen mit dem Burst, dem BA-Signal (YA-Signal) additiv überlagert. Man erhält so das FBAS-Signal. Die resultierende Amplitude ![]() des Farbartsignals ergibt sich aus der vektoriellen Addition der

des Farbartsignals ergibt sich aus der vektoriellen Addition der ![]() und

und ![]() Komponente. Bei der Amplitudenmodulation mit Trägerunterdrückung wird der Momentanwert und damit auch der Maximalwert des modulierenden Signals in den Momentanwert bzw. die Amplitude des Farbartsignals umgesetzt. Man erhält

Komponente. Bei der Amplitudenmodulation mit Trägerunterdrückung wird der Momentanwert und damit auch der Maximalwert des modulierenden Signals in den Momentanwert bzw. die Amplitude des Farbartsignals umgesetzt. Man erhält

Unter Bezugnahme auf das Testsignal mit der Normfarbbalkenfolge würde die Addition von Leuchtdichtesignal Y und Farbartsignal F zu einer wesentlichen Überschreitung des Aussteuerbereiches vom ursprünglichen BA- bzw. Y-Signal führen. Es wird deshalb eine Reduktion der Amplitude des Farbartsignals über eine Reduzierung der Farbdifferenzsignalwerte B-Y und R-Y vorgenommen und zwar so, dass bei 100 % Farbsättigung eine Überschreitung des Aussteuerbereiches um 33 % zugelassen wird. Die reduzierten Farbdifferenzsignale werden nun mit den neuen Symbolen U und V gekennzeichnet. Es gelten die Beziehungen

und daraus

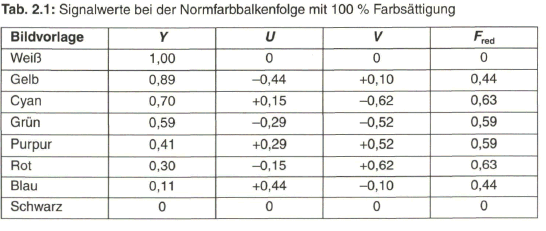

Tabelle 2.1 listet eine Zusammenstellung der normierten Signalwerte bei der Normfarbbalkenfolge mit 100 % Farbsättigung auf. Signalwerte bei der Normfarbbalkenfolge mit 100 % Farbsättigung

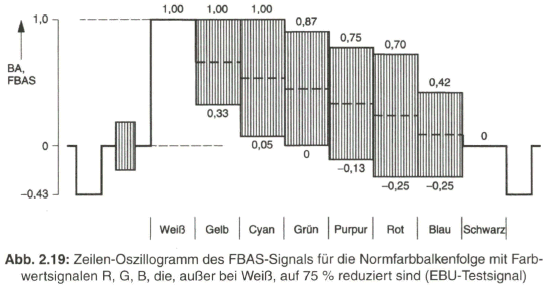

Im praktischen Betrieb werden Farbsättigungswerte gegen 100 % kaum erreicht. Es wird deshalb ein Testsignal (EBU-Testsignal, nach European Broadcasting Union) mit der Normfarbbalkenfolge und 75 % Farbsättigung definiert, das maximal an den Aussteuerungsgrenzwert von BA = 1,00, entsprechend dem Weißwert, herankommt. Die Farbsättigung von 75 % erhält man durch Reduktion der Farbwertsignale R, G und B (nicht beim Weiß-Balken) auf 75 % ihres ursprünglichen Wertes. Selbstverständlich ändern sich damit auch die Werte für das Leuchtdichtesignal Y, außer im Weiß-Balken, entsprechend. In Bild 2.19 ist das Zeilen-Oszillogramm dargestellt.

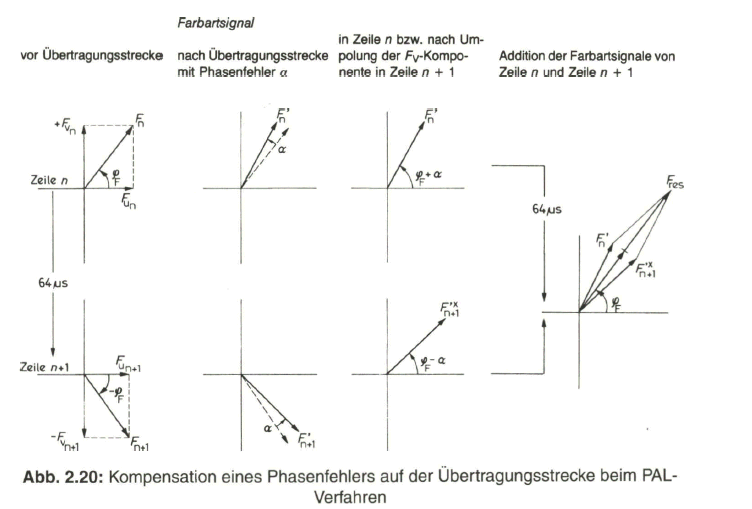

Mit dem PAL-Verfahren kann auf relativ einfache Weise eine Kompensation von Phasenfehlern im Farbartsignal gegenüber der Bezugsphase im Burst erreicht werden. Der Grundgedanke ist folgender: Eine Phasenverschiebung, die das Farbartsignal auf dem Übertragungsweg erfahren hat, kann durch eine entgegengesetzt gerichtete, gleich große Phasendrehung kompensiert werden.

Man erreicht diesen Effekt, indem die Phasenlage einer der beiden Komponenten des Farbartsignals, z. B. der FV- Komponente, zeilenweise um 180° umgepolt wird. Damit tritt der Phasenfehler auf der Empfangsseite abwechselnd in positiver und in negativer Richtung auf. Durch eine Addition der Farbartsignale von zwei aufeinanderfolgenden Zeilen kompensiert sich der Fehler. Bild 2.20 erläutert das Prinzip der Phasenfehlerkompensation beim PAL-Verfahren.

Das Farbartsignal ![]() der Zeile n, zusammengesetzt aus den Komponenten

der Zeile n, zusammengesetzt aus den Komponenten ![]() und

und ![]() , erleidet auf der Übertragungsstrecke einen Phasenfehler a in positiver Richtung gegenüber der Bezugsphase des Burst. Es gelangt empfangsseitig als Signal

, erleidet auf der Übertragungsstrecke einen Phasenfehler a in positiver Richtung gegenüber der Bezugsphase des Burst. Es gelangt empfangsseitig als Signal ![]() über ein Laufzeitglied mit der Verzögerung um die Dauer einer Zeile (64

über ein Laufzeitglied mit der Verzögerung um die Dauer einer Zeile (64![]() ) zu einer Addierstufe. Während der darauffolgend übertragenen Zeile n + 1 wird sendeseitig die fv- Komponente um 180° umgepolt. Das Farbartsignal

) zu einer Addierstufe. Während der darauffolgend übertragenen Zeile n + 1 wird sendeseitig die fv- Komponente um 180° umgepolt. Das Farbartsignal ![]() , gebildet aus den Komponenten

, gebildet aus den Komponenten ![]() und

und ![]() , wird ebenso um den Phasenfehler a in positiver Richtung verfälscht. Die sendeseitige Umpolung der Fv-Komponente muss nun empfangsseitig wieder rückgängig gemacht werden. Damit erhält man aus dem fehlerbehafteten Signal

, wird ebenso um den Phasenfehler a in positiver Richtung verfälscht. Die sendeseitige Umpolung der Fv-Komponente muss nun empfangsseitig wieder rückgängig gemacht werden. Damit erhält man aus dem fehlerbehafteten Signal ![]() nach Umpolung der Fv-Komponente das Farbartsignal

nach Umpolung der Fv-Komponente das Farbartsignal ![]() , das den Phasenfehler a der Übertragungsstrecke mit negativer Richtung aufweist.

, das den Phasenfehler a der Übertragungsstrecke mit negativer Richtung aufweist.

Unter der Voraussetzung, dass die Farbartsignale der Zeilen n und n + 1 gleich sind, erhält man aus der Addition des verzögerten Farbartsignals ![]() und des unverzögerten Farbartsignals

und des unverzögerten Farbartsignals ![]() ein resultierendes Signal

ein resultierendes Signal ![]() , in dem sich der Phasenfehler aufhebt. Der Phasenwinkel

, in dem sich der Phasenfehler aufhebt. Der Phasenwinkel ![]() des Empfangsignals

des Empfangsignals ![]() ist identisch mit dem des gesendeten Farbartsignals, womit der Farbton erhalten bleibt. Das Empfangssignal weist nach einer Reduzierung auf den halben Amplitudenwert lediglich eine geringe Entsättigung gegenüber dem Sendesignal auf.

ist identisch mit dem des gesendeten Farbartsignals, womit der Farbton erhalten bleibt. Das Empfangssignal weist nach einer Reduzierung auf den halben Amplitudenwert lediglich eine geringe Entsättigung gegenüber dem Sendesignal auf.

2.4.4 PAL-Coder und -Decoder

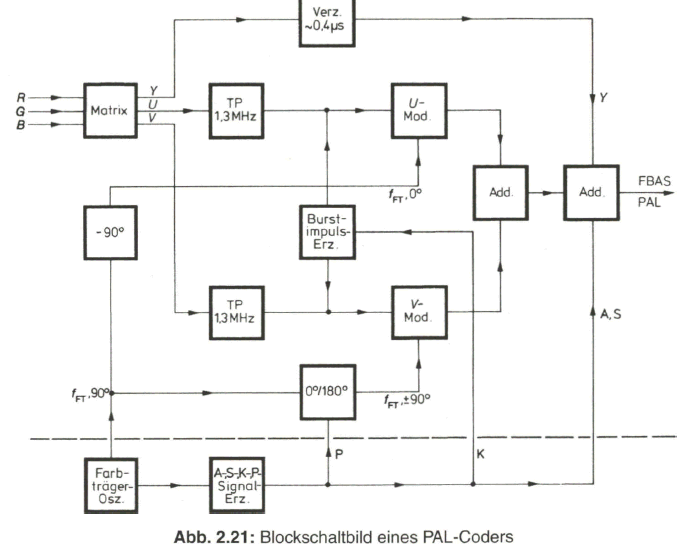

Die Aufbereitung des FBAS-Signals erfolgt im PAL-Coder. Bild 2.21 zeigt dazu das Blockschaltbild eines PAL-Coders. Es werden neben dem Y-Signal mit der vollen Bandbreite von 5 MHz die reduzierten Farbdifferenzsignale U und V mit einer Bandbreite von 1,3 MHz (max. 3 dB Abfall) übertragen. Zum Angleichen der Signallaufzeit im schmalbandigen Chrominanzkanal und im breitbandigen Luminanzkanal wird das Y-Signal um etwa 0,4 ![]() verzögert. Im U- und V- Modulator werden auch der 0°- und der +90°- bzw. -90°-Anteil des alternierenden Burst erzeugt. Die Auftastung während der Dauer des Burst erfolgt über den K-Impuls (Keying-lmpuls). Dem U-Modulator wird der Farbträger mit 0°-Phase und dem V- Modulator mit +90°- bzw. -90°-Phase zugeführt. Die zeilenweise Phasenumpolung des 90°-Trägers wird über den P-Impuls (PAL-Impuls) vorgenommen. Am Ausgang des PAL-Coders werden das Leuchtdichtesignal Y (BA) und das Farbartsignal F mit dem Austast- und dem Synchronsignal zum FSAS-Signal zusammengefasst.

verzögert. Im U- und V- Modulator werden auch der 0°- und der +90°- bzw. -90°-Anteil des alternierenden Burst erzeugt. Die Auftastung während der Dauer des Burst erfolgt über den K-Impuls (Keying-lmpuls). Dem U-Modulator wird der Farbträger mit 0°-Phase und dem V- Modulator mit +90°- bzw. -90°-Phase zugeführt. Die zeilenweise Phasenumpolung des 90°-Trägers wird über den P-Impuls (PAL-Impuls) vorgenommen. Am Ausgang des PAL-Coders werden das Leuchtdichtesignal Y (BA) und das Farbartsignal F mit dem Austast- und dem Synchronsignal zum FSAS-Signal zusammengefasst.

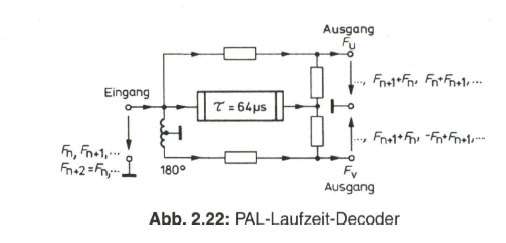

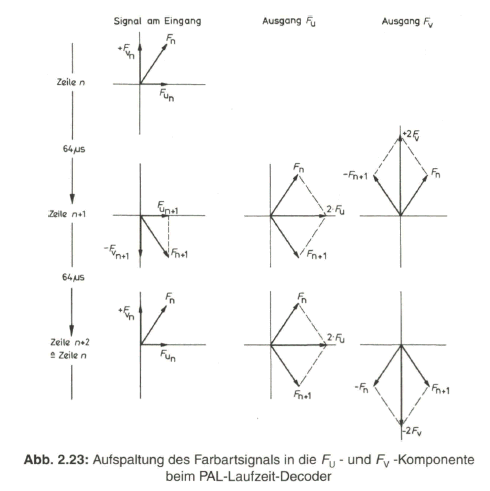

Die technische Realisierung der PAL-Fehlerkompensation auf der Empfängerseite bedarf gegenüber der Prinzipdarstellung in Bild 2.20 einer besonderen Erläuterung. Dazu ist es zweckmäßig, aus dem PAL-Decoder zunächst eine wichtige Funktionsgruppe, den Laufzeit-Decoder herauszunehmen. Im Gegensatz zu einem NTSC-Decoder wird beim PAL-Decoder das Farbartsignal nicht parallel den Synchrondemodulatoren zugeführt, sondern es findet bereits vorher eine Aufspaltung in die FU- und die FV- Komponente statt. Diese Aufgabe übernimmt der Laufzeit-Decoder (Bild 2.22).

Das ankommende Farbartsignal teilt sich am Eingang des Laufzeit-Decoders in drei Pfade auf. Es gelangt einmal über ein Laufzeitglied mit der Signalverzögerung um eine Zeilendauer ![]() (Gruppenlaufzeit 64

(Gruppenlaufzeit 64 ![]() ) und mit einer Phasenverschiebung von 0°

) und mit einer Phasenverschiebung von 0° ![]() , entsprechend einer Phasenlaufzeit von z. B. 284

, entsprechend einer Phasenlaufzeit von z. B. 284![]() 64,056

64,056 ![]() , und zum anderen auf direktem Weg mit 0° bzw. 180° Phasendrehung an die beiden Ausgänge. Dort findet jeweils die Addition von zwei Signalen statt.

, und zum anderen auf direktem Weg mit 0° bzw. 180° Phasendrehung an die beiden Ausgänge. Dort findet jeweils die Addition von zwei Signalen statt.

Am „Ausgang FU-" addieren sich das Farbartsignal der vorangehenden Zeile (FN) und das der gerade ablaufenden Zeile (![]() ). Aufeinanderfolgende Zeilen beinhalten die FV- Komponente mit um 180° wechselnder Phasenlage, so dass diese sich über zwei Zeilen hinweg aufhebt. An dem „Ausgang FU- ” kann somit ständig die FU- Komponente des Farbartsignals abgenommen werden. Dem „Ausgang FV ” wird das Eingangssignal um 180° phasenverschoben zugeführt. Durch die Addition mit dem um eine Zeilendauer verzögerten Farbartsignal ergibt sich hier eine Aufhebung der Fu- Komponente. Es erscheint an diesem Ausgang dann nur die FV- Komponente des Farbartsignals, allerdings zeilenweise in der Phasenlage um 180° wechselnd. Die Funktion des Laufzeit-Decoders geht aus dem Zeigerdiagramm in Bild 2.23 deutlich hervor.

). Aufeinanderfolgende Zeilen beinhalten die FV- Komponente mit um 180° wechselnder Phasenlage, so dass diese sich über zwei Zeilen hinweg aufhebt. An dem „Ausgang FU- ” kann somit ständig die FU- Komponente des Farbartsignals abgenommen werden. Dem „Ausgang FV ” wird das Eingangssignal um 180° phasenverschoben zugeführt. Durch die Addition mit dem um eine Zeilendauer verzögerten Farbartsignal ergibt sich hier eine Aufhebung der Fu- Komponente. Es erscheint an diesem Ausgang dann nur die FV- Komponente des Farbartsignals, allerdings zeilenweise in der Phasenlage um 180° wechselnd. Die Funktion des Laufzeit-Decoders geht aus dem Zeigerdiagramm in Bild 2.23 deutlich hervor.

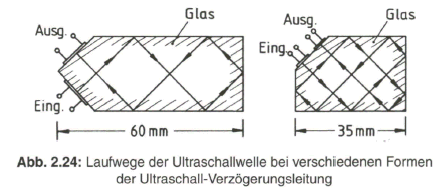

Zur Signalverzögerung im Laufzeit-Decoder verwendet man eine Ultraschall-Verzögerungsleitung. Der Begriff „Leitung” ist hier nur im übertragenen Sinne zu deuten, weil tatsächlich ein Glaskörper Verwendung findet. Das Farbartsignal wird dazu über piezo-elektrische Wandler in eine Ultraschallschwingung mit 4,43 MHz und wieder in ein elektrisches Signal umgewandelt. Die Ultraschallwelle durchläuft diesen Glaskörper. Ihre Fortpflanzungsgeschwindigkeit ist gering (2650 m/s), so dass man für die Laufzeit von 64 ![]() etwa eine Lauflänge von 17 cm benötigt.

etwa eine Lauflänge von 17 cm benötigt.

Die ersten Ultraschall-Verzögerungsleitungen waren zunächst stabförmig, bei einer Länge von etwa 17 cm. Kleinere Abmessungen erreicht man, wenn Mehrfachreflexionen an den Glas-Luft-Übergängen ausgenutzt werden. Bild 2.24 zeigt dazu verschiedene Möglichkeiten.

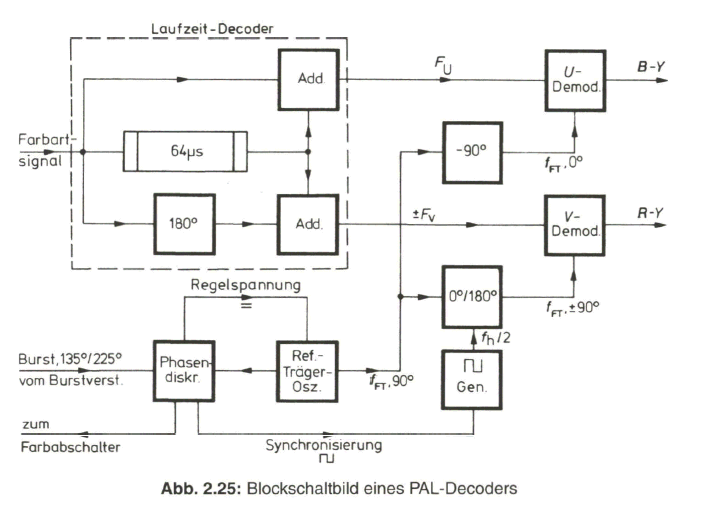

Die zeilenweise Änderung der Phasenlage der FV- Komponente könnte durch eine entsprechende periodische Umschaltung rückgängig gemacht werden. Einfacher ist jedoch die zeilenweise Umpolung der Phasenlage des Referenzträgers für den Y-Synchrondemodulator im PAL-Decoder. In der Anordnung des kompletten PAL-Decoders (Bild 2.25) übernimmt diese Aufgabe der PAL-Schalter. Die phasenrichtige Synchronisierung des PAL-Schalters erfolgt über die Auswertung des alternierenden Burst.

Die Ausgangssignale des Laufzeit-Decoders, FU und +FV werden den Synchrondemodulatoren zugeführt, wo sie mit dem Referenz-Farbträger in 0°- bzw. ±90°-Phasenlage phasenrichtig demoduliert werden. Der Referenzträgeroszillator stellt sich in dem geschlossenen Regelkreis auf eine Phasenlage von 90° bezogen auf den Mittelwert der Burstphase bei 180° ein. Dazu wird die über ein Integrationsglied geglättete Ausgangsspannung des Burst-Phasendiskriminators zur Nachstimmung des Referenzträgeroszillators herangezogen. Die nur von den Farbträgeranteilen befreite Ausgangsspannung des Phasendiskriminators dient zur phasenrichtigen Synchronisation des PAL-Multivibrators, der den PAL-Schalter zur Umpolung des Referenzträgers für den (R-Y)- bzw. V-Synchrondemodulator steuert.

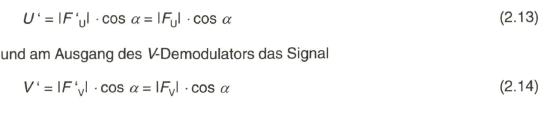

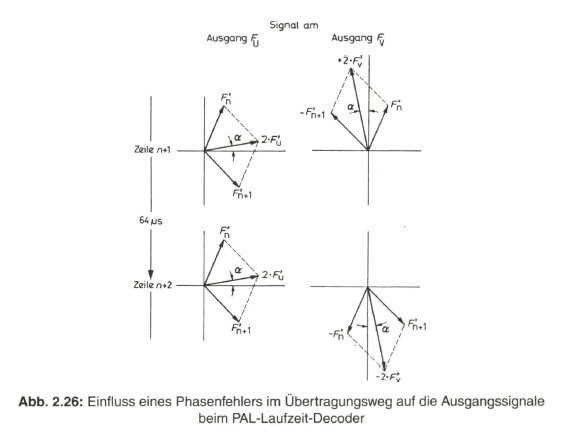

Ein Phasenfehler a, den das Farbartsignal auf dem Übertragungsweg in Bezug auf den Burst erfährt, erscheint sowohl beim FU- als auch beim +FV Signal in gleicher Richtung (Bild 2.26). Da in den Synchrondemodulatoren aber nur eine Bewertung der mit dem jeweiligen Referenzträger in Phase liegenden Komponente des zugeführten Signals stattfindet, erhält man am Ausgang des U-Demodulators das Signal

Beide zurückgewonnenen Farbdifferenzsignale, U‘ und V‘, sind durch den Phasenfehler a mit dem selben Faktor cos a behaftet, so dass das Verhältnis V´ / U ‘ gegenüber dem sendeseitigen Wert V / U gleich geblieben ist und damit auch der Farbton, der im Phasenwinkel ![]() enthalten ist, nicht verfälscht wird. Eine gewisse Entsättigung durch die geringere Amplitude der demodulierten Farbdifferenzsignale mit dem Faktor cos a macht sich erst bei größeren Werten des Phasenfehlers bemerkbar.

enthalten ist, nicht verfälscht wird. Eine gewisse Entsättigung durch die geringere Amplitude der demodulierten Farbdifferenzsignale mit dem Faktor cos a macht sich erst bei größeren Werten des Phasenfehlers bemerkbar.

2.4.5 Spektrum des PAL-FBAS-Signals

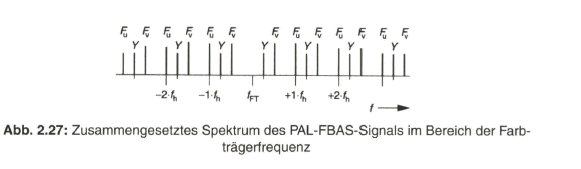

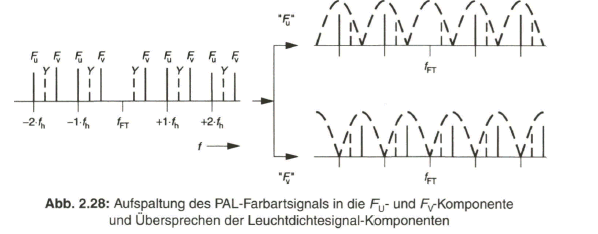

Durch additive Überlagerung des BAS-Signals mit dem Farbartsignal wird das FBAS-Signal gebildet. Die Zeitfunktion des zusammengesetzten Signals zeigt an einem Beispiel mit der Normfarbbalkenfolge Bild 2.19. Im Spektrum des FBAS- Signals treten, bedingt durch den Viertelzeilen-Offset und die zeilenweise Umpolung der FV- Komponente , die Spektralkomponenten des Y- bzw. BAS-Signals und die Spektralkomponenten des bzw. FV- Signals bei verschiedenen Frequenzen auf. Bild 2.27 gibt dies an einem Ausschnitt des Spektrums um die Farbträgerfrequenz wieder. Diese Konstellation erlaubt es, auf der Empfängerseite die Komponenten FU und FV- des Farbartsignals über ein so genanntes Kammfilter von den Komponenten des Y- bzw. BAS-Signals zu trennen. Mit dem üblicherweise technisch realisierten Kammfilter mittels des einfachen PAL-Laufzeit-Decoders gelingt diese Trennung aber nicht vollkommen. Siehe dazu Bild 2.28. Sowohl in dem FU- als auch in dem FV- Signal treten noch Spektralkomponenten des Y- Signals auf, die sich als Übersprechstörung bei Bildvorlagen mit vertikalen Feinstrukturen bemerkbar machen. Man spricht in diesem Fall von „Cross Chrominance“ bzw. „Cross Colour“.

Eine Störung im Leuchtdichtekanal durch den modulierten Farbträger wird als „Cross Luminance“ bezeichnet. Durch die Wahl der Farbträgerfrequenz am oberen Ende des BAS-Spektrums reduziert sich diese Störung schon weitgehend. Zusätzlich wird der Frequenzgang im Leuchtdichtekanal beim PAL- Farbfernsehempfänger meist schon oberhalb von 4 MHz abgesenkt.

Eine nahezu vollkommene Unterdrückung von Cross-Chrominance- und Cross- Luminance-Störungen gelingt mit dem Color-Plus-Verfahren. Es handelt sich hierbei um eine modifizierte Variante des PAL- Verfahrens mit Halbbildspeicherung auf der Encoder- und Decoderseite. Das Color-Plus-Verfahren wird beim PALplus-System eingebracht, bei dem aber als wesentliche Eigenschaft die kompatible Breitbildübertragung im Vordergrund steht.

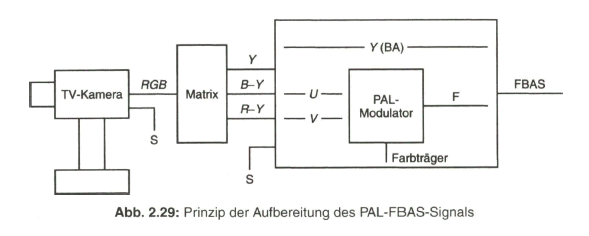

Zusammenfassend zeigt Bild 2.29 nochmals das Prinzip der Aufbereitung des herkömmlichen PAL-FBAS-Signals im Studio. Die technische Erzeugung des PAL-FBAS-Signals erfolgt heute meistens in einem Encoder, der von PAL mit 4:3 Seitenverhältnis auf PALplus mit 16:9-Seitenverhältnis und Color-Plus-Aufbereitung umgeschaltet werden kann. Dieser Encoder basiert vollkommen auf digitaler Signalverarbeitung. Bezogen auf die Prinzipdarstellung in Bild 2.29 bedeutet dies, dass die Signale aus der Matrix, Y, B - Y und R - Y, analog-digital gewandelt werden und das Ausgangssignal des Encoders wieder in ein analoges FBAS-Signal im Frequenzbereich von Null bis fünf MHz übergeführt wird. Als Eingangssignal liegt am Studio-PALplus-Encoder meist das digitale, serielle Komponentensignal (DSC, Digital Serial Components) an. Siehe dazu Näheres im Abschnitt 4, Digitales Video-Studiosignal.

2.5 PALplus-System

Nach verschiedenen Zwischenlösungen zur Qualitätsverbesserung beim PAL- Verfahren und Übergang auf das Breitbildformat wurde auf der Internationalen Funkausstellung 1991 ein neuer Fernseh-Standard unter dem Begriff PALplus der Öffentlichkeit vorgestellt. Als Vorgabe war dabei selbstverständlich die volle Kompatibilität mit dem eingeführten PAL-System zu berücksichtigen, sowohl empfängerseitig als auch weitestgehend auf der Senderseite und bei den hochfrequenten Übertragungskanälen. Die Rundfunkanstalten, insbesondere die öffentlich rechtlichen, übertragen ihre Programmbeiträge zum großen Teil im kompatiblen Breitbildformat.

2.5.1 Merkmale des PALplus-Standards

Gegenüber dem eingeführten Standard-PAL-Verfahren bringt das voll kompatible PALplus-System die Einführung des 16:9-Bildformats und die Unterdrückung der Cross-Colour und Cross-Luminance-Störungen und damit volle Ausnutzung der 5-MHz-Bandbreite für das Leuchtdichtesignal. Die zusätzlich noch vorgesehene digitale Tonsignalübertragung und eine Entzerrung von Echostörungen kamen aus verschiedenen Gründen nicht zum Einsatz. Das Breitbildformat wird auf einem herkömmlichen 4:3-Bildschirm mit den bereits von Breitbildfilmen bekannten schwarzen Streifen am oberen und unteren Bildrand wiedergegeben.

2.5.2 Kompatible Übertragung im 16:9-Bildformat

Nach dem Letterbox-Verfahren wird die 16:9-Bildvorlage so aufbereitet, dass durch Herausnahme von Zeilen aus dem aktiven Raster ein 16:9-Breitbild mit verminderter Bildhöhe auf dem 4:3-Bildschirm wiedergegeben werden kann. Das Bild erscheint damit als in die Breite gezogenes Rechteck, was zu dem Vergleich mit einem „Briefkasteneinwurf” geführt hat. Am oberen und unteren Bildrand treten dabei breite schwarze Streifen auf.

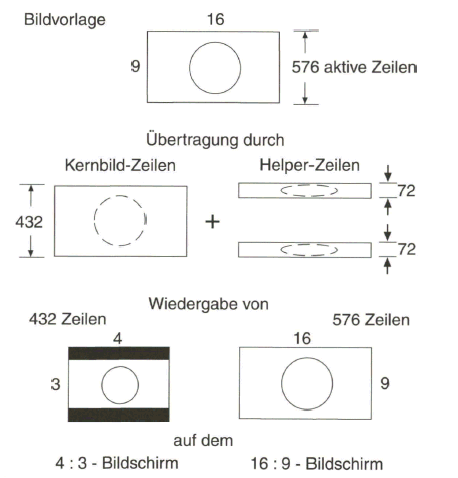

Abb. 2.30: Aufteilung des 16:9-Bildes beim Letterbox-Verfahren in Kernbild- und Helper-Zeilen

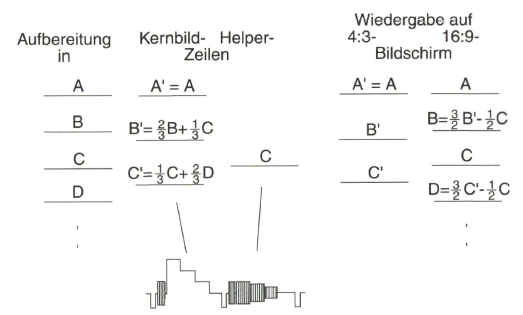

Das Prinzip des Letterbox-Verfahrens zeigt Bild 2.30. Die Reduzierung der Bildhöhe erfolgt durch Herausnahme jeder vierten Zeile aus dem aktiven 576-Zeilen- Raster. Durch die Aufbereitung des PALplus-FBAS-Signals mit kompatiblem 16:9- Bildformat und mit dem Color-Plus-Verfahren ist es notwendig, von 575 auf 576 aktive Zeilen im 625-Zeilen-Raster überzugehen, was zudem im digitalen Studiosignal schon vorliegt. Die verbleibenden 432 Zeilen werden entsprechend zusammengeschoben, womit die aktive Bildhöhe sich auf drei Viertel des ursprünglichen Wertes verringert. Dieses so genannte „Kernbild” (oder auch „Letterbox-Bild“) wird in herkömmlicher Weise durch Leuchtdichte- und Farbartsignal übertragen. Die Leuchtdichteinformation der herausgenommenen 144 Zeilen wird am oberen und unteren Bildrand in je 72 „Helper-Zeilen” so übertragen, dass sie für den Stan- dard-PAL-Empfänger unsichtbar bleibt. Der PALplus-Empfänger jedoch verarbeitet die Zusatzinformation in den „Vertikal-Helfern” und rekonstruiert zusammen mit der Information in den 432 Zeilen des Kernbildes das ursprüngliche Farbbild mit 576 sichtbaren Zeilen im 16:9-Breitbildformat.

Die reversible Zeileninterpolation wird nach vereinfachter Darstellung gemäß Bild 2.31 vorgenommen. Die 576 aktiven Zeilen werden dazu in jeweils vier Zeilen, hier mit A, B, C, D bezeichnet, zusammengefasst. Durch eine 4:3-Vertikalfilterung werden daraus drei Zeilen A', B', C' nach der in Bild 2.31 angegebenen Zusammensetzung abgeleitet, deren Information durch Leuchtdichte- und Farbartsignal übertragen wird. Die angegebene Gewichtung in den Zeilen bezieht sich auf den Signalinhalt in übereinanderliegenden Bildpunkten.

Abb. 2.31: Reversible Zeileninterpolation beim Letterbox-Verfahren in Gruppen von jeweils vier Zeilen

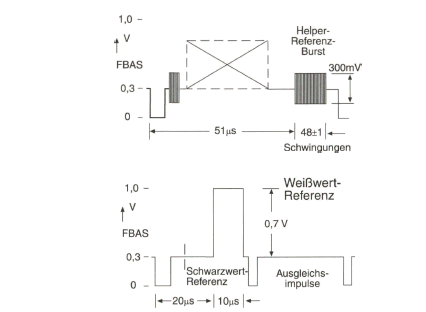

Die jeweils dritte Zeile, C, wird zusätzlich als so genannter „Vertikal-Helfer” so übertragen, dass sie für den Standard-PAL-Empfänger unsichtbar bleibt. Dazu wird das Leuchtdichtesignal dieser Zeile nach einer nichtlinearen Amplituden-Vorverzerrung einem Hilfsträger, für den die Farbträgerschwingung verwendet wird, durch Restseitenband Amplitudenmodulation aufgebracht und mit reduzierter Amplitude um den Schwarzwert herum in den jeweils 72 Zeilen am oberen und unteren Bildrand übertragen. Durch die Trägermodulation wird das resultierende Spektrum der Vertikal-Helfer-Signale von niederfrequenten Anteilen befreit, die sonst bei älteren Fernsehempfängern zu Synchronisationsstörungen führen könnten. Die Amplitude des Vertikal-Helfer-Signals wird auf 300 mV Spitze-Wert symmetrisch um den Schwarzwert, entsprechend der Burst-Amplitude, festgelegt.

2.5.3 Statusbits-Information und Referenzsignale

Die Signalverarbeitung im PALplus-Encoder und Decoder erfolgt abhängig von dem Quellensignal (von der elektronischen Kamera oder vom Filmabtaster), und sie ist auch davon abhängig, ob 4:3 oder 16:9-Bildmaterial vorliegt. Darüber hinaus ist das Einbringen von Untertiteln bei der Letterbox-Übertragung zu berücksichtigen. Hierfür ist es erforderlich, einige Informationen aus dem Studio an den Empfänger zu übertragen. Dazu dient ein Datenwort mit 14 bit, das in vier Funktionsgruppen folgende Information beinhaltet:

- Gruppe 1 Bildformat (3 bit + 1 Paritätsbit) Vollformat 4:3, Letterbox 16:9, Letterbox 14:9, Vollformat 16:9 u. a.

- Gruppe 2 Verbesserte Dienste (4 bit) Kamera-Mode oder Film-Mode, Standard-PAL oder Color-Plus, Helper-Signal ja/nein.

- Gruppe 3 Untertitel (3 bit) Untertitel im Teletext ja/nein, innerhalb oder außerhalb des aktiven Bildes.

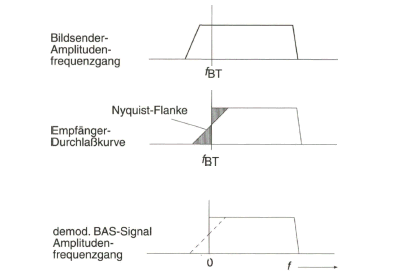

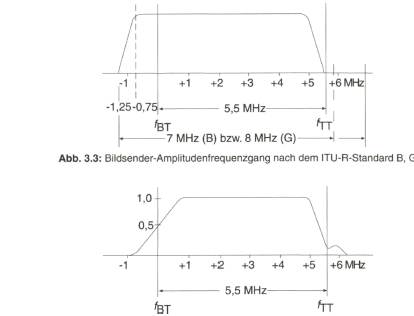

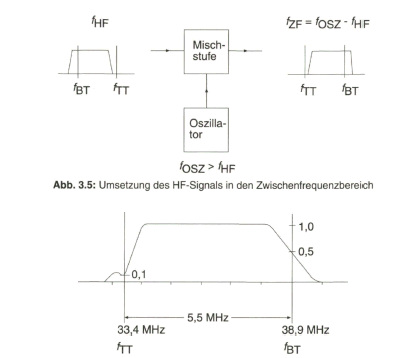

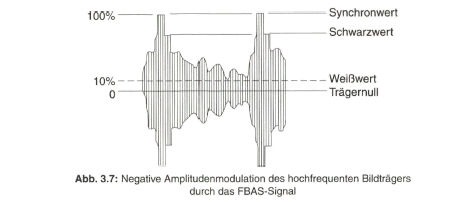

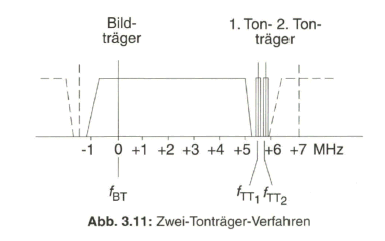

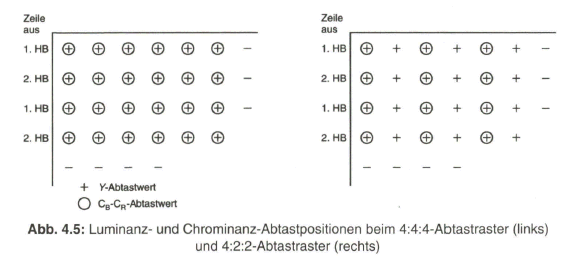

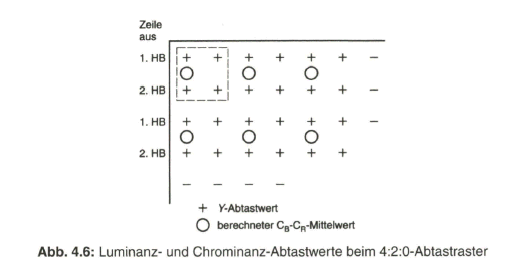

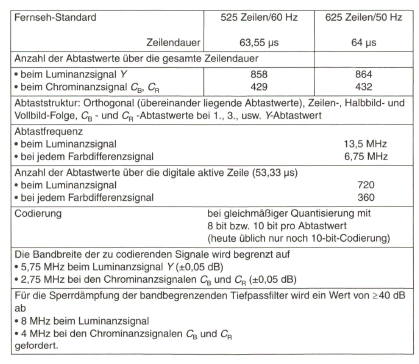

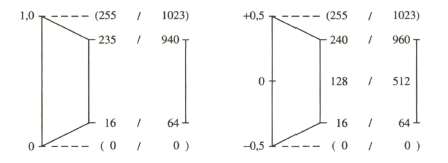

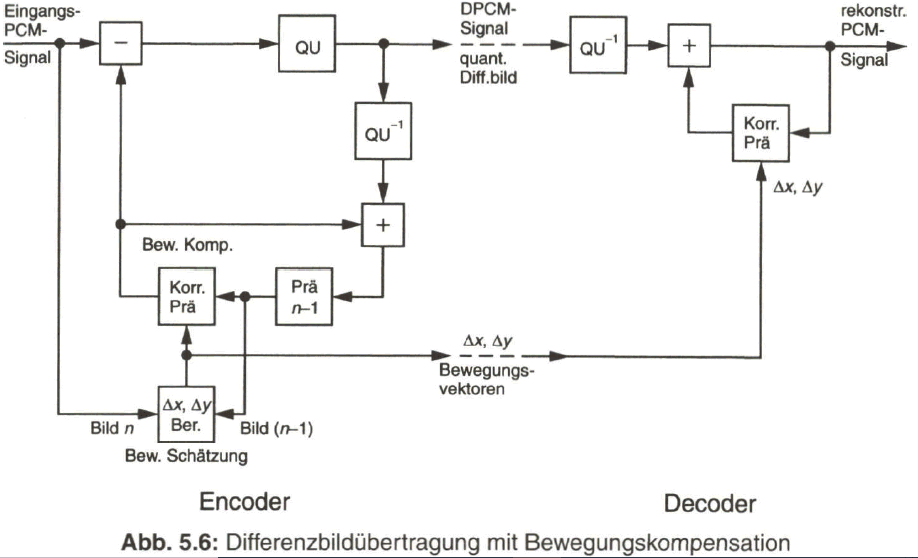

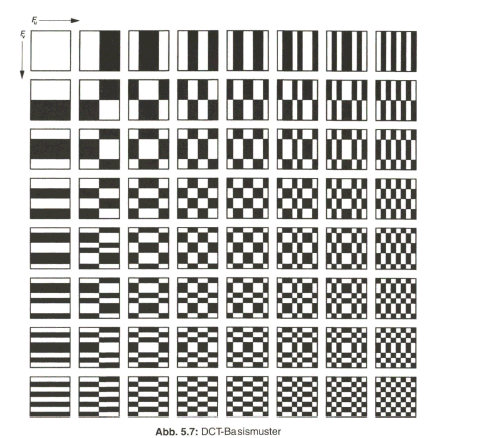

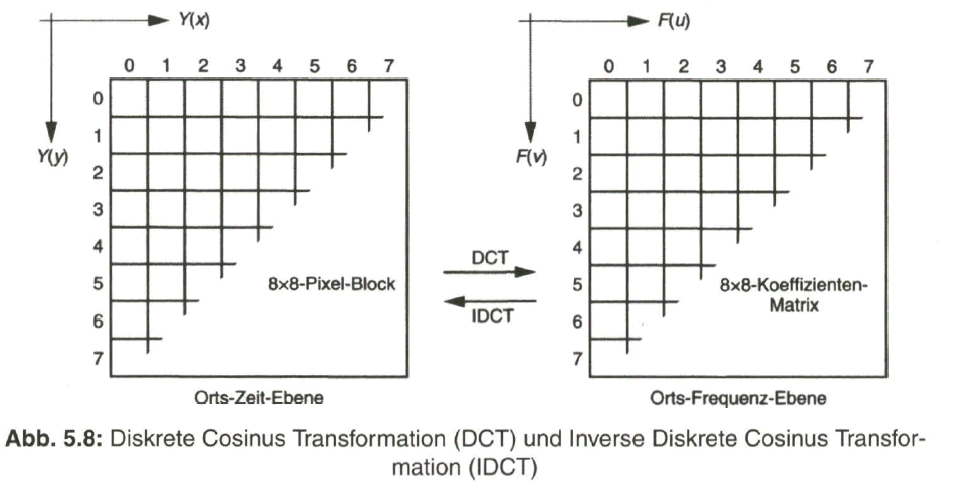

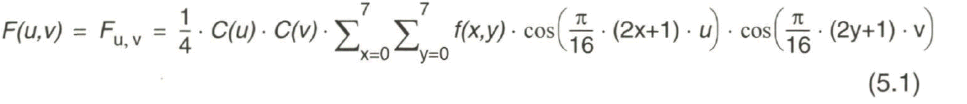

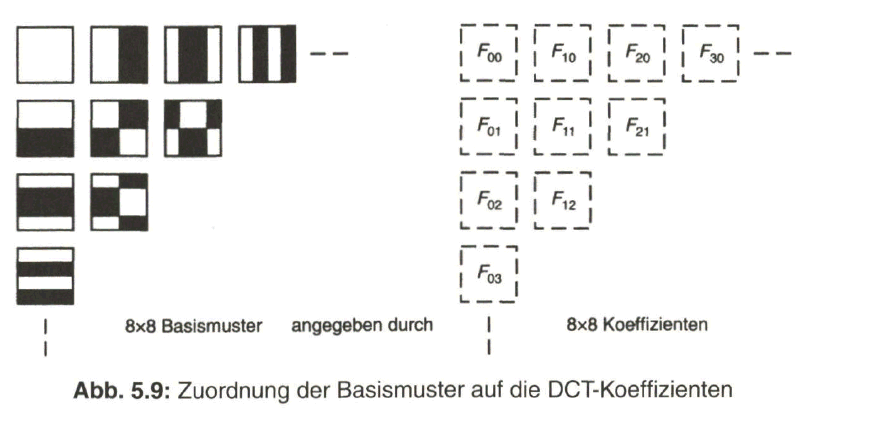

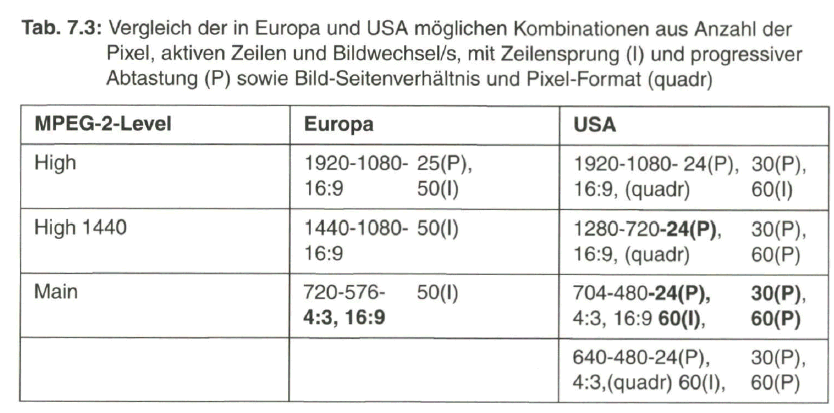

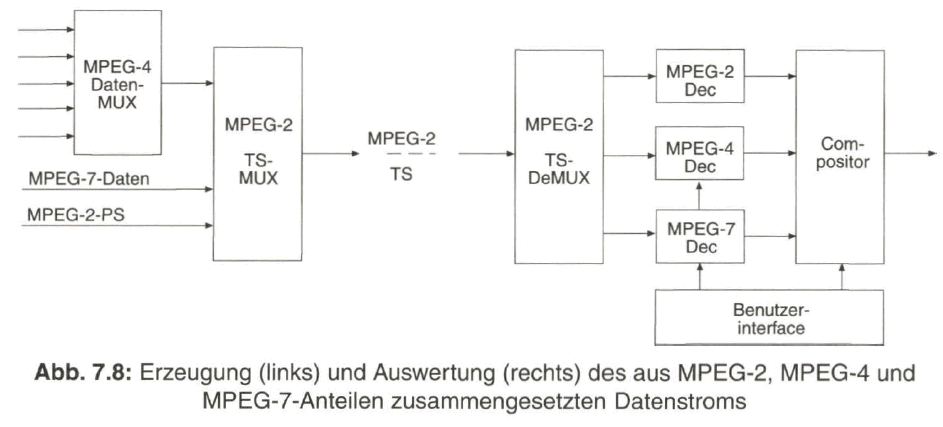

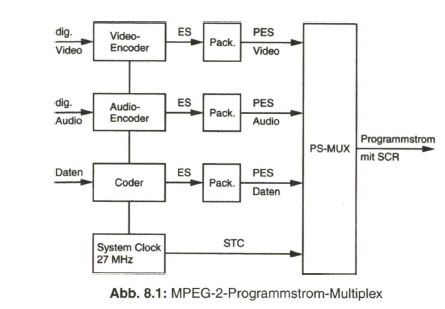

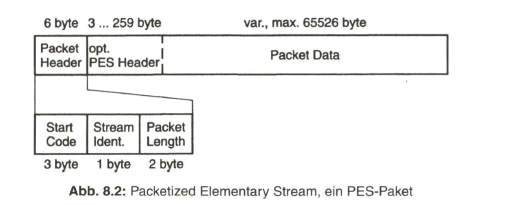

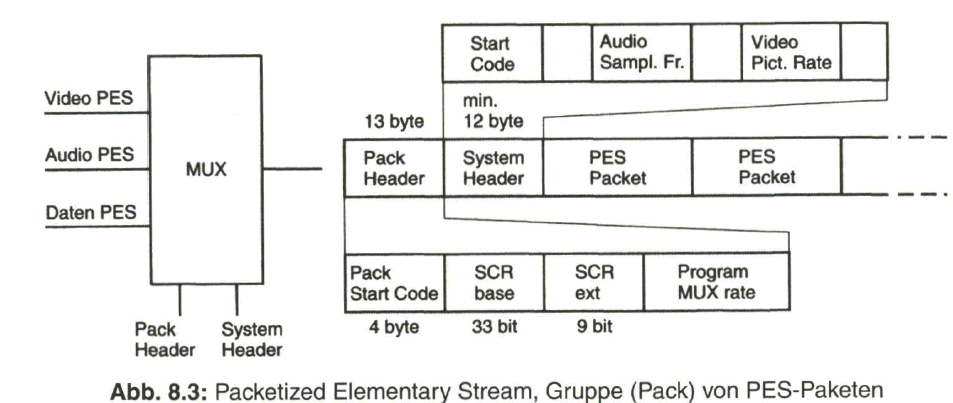

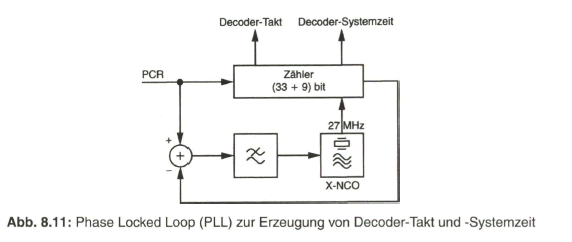

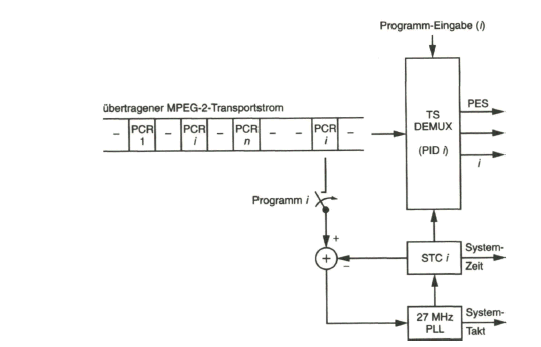

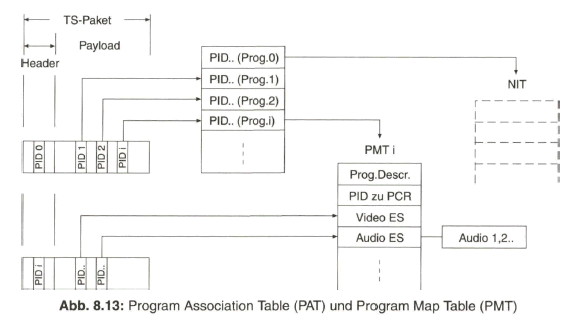

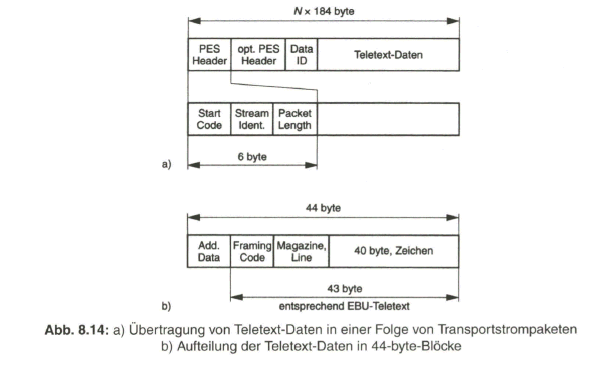

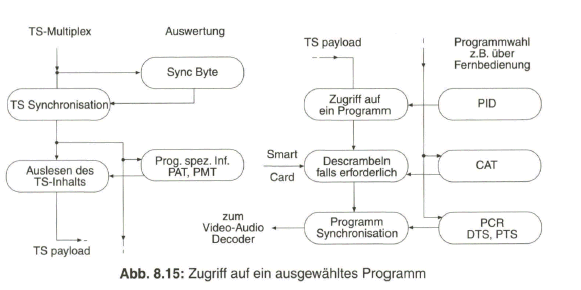

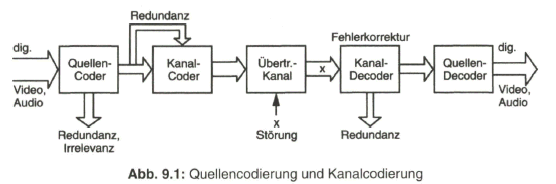

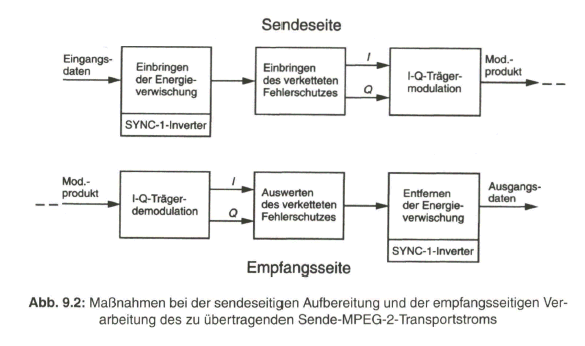

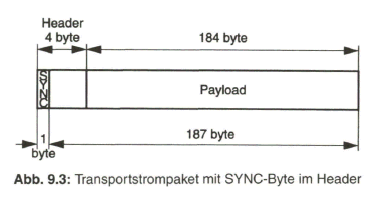

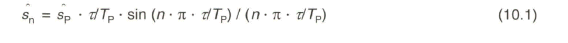

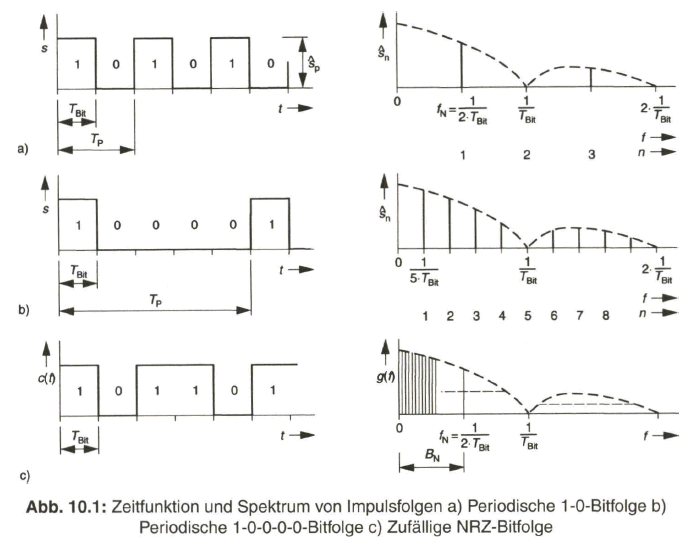

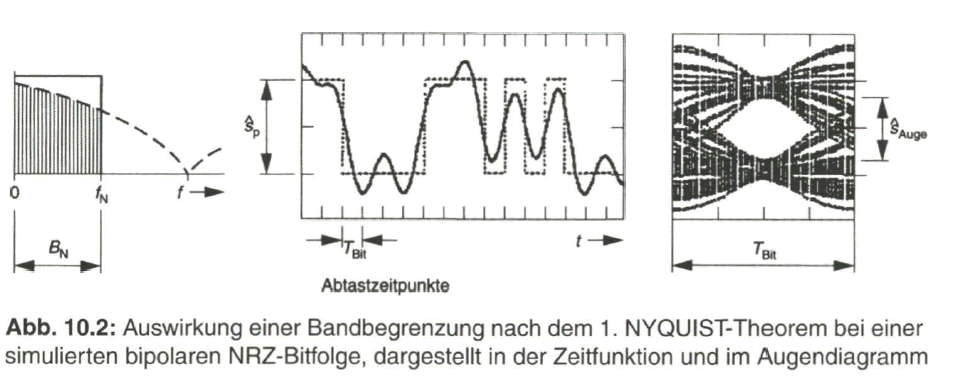

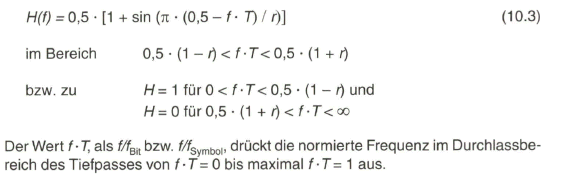

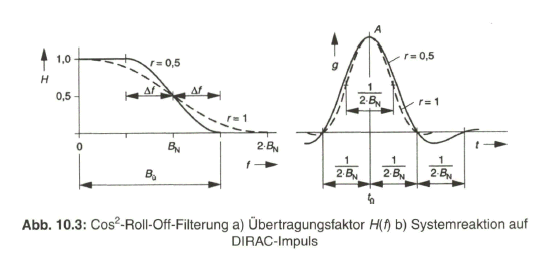

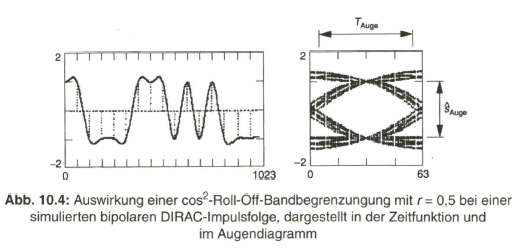

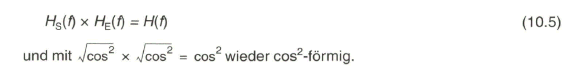

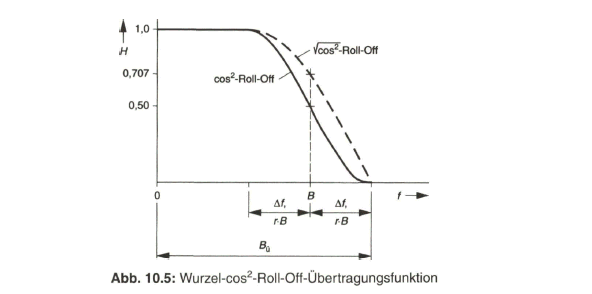

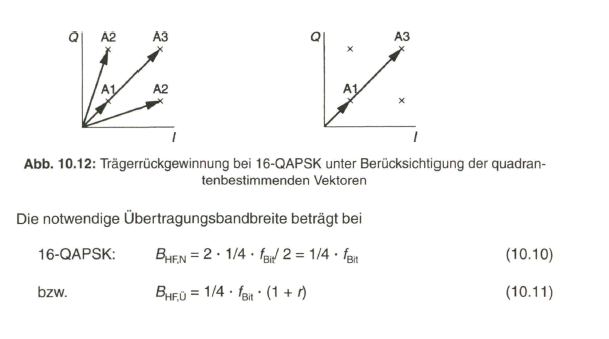

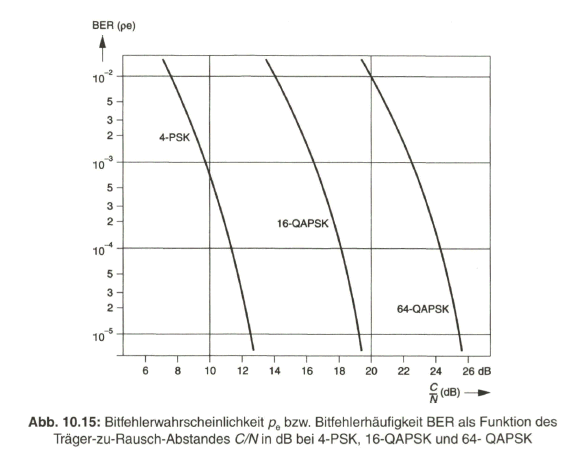

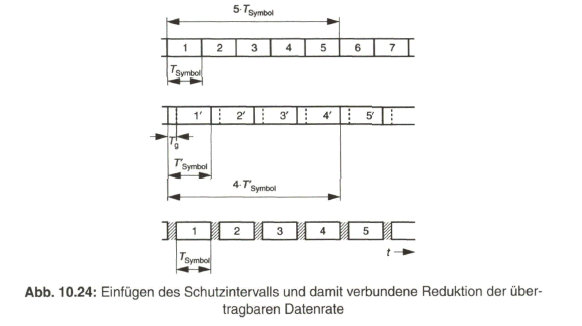

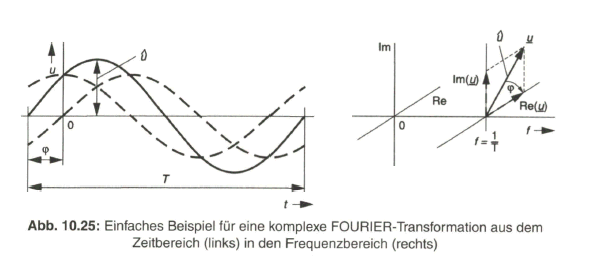

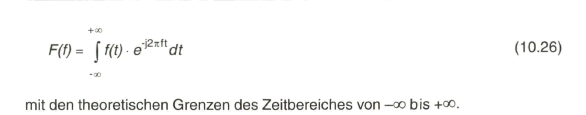

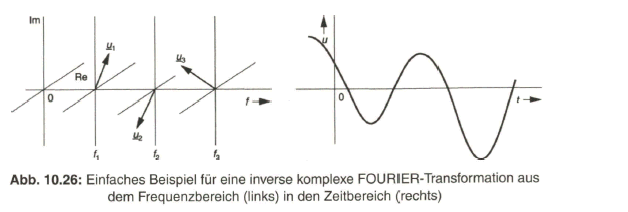

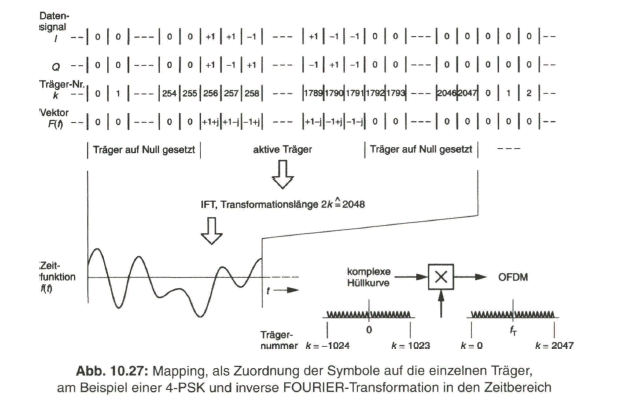

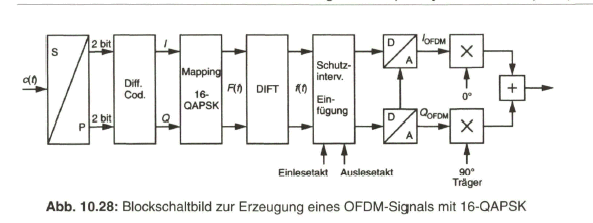

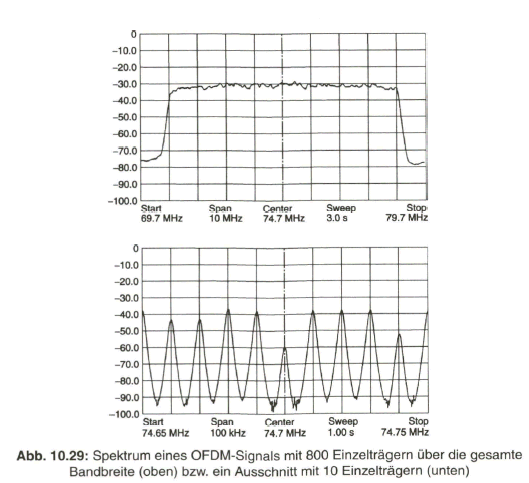

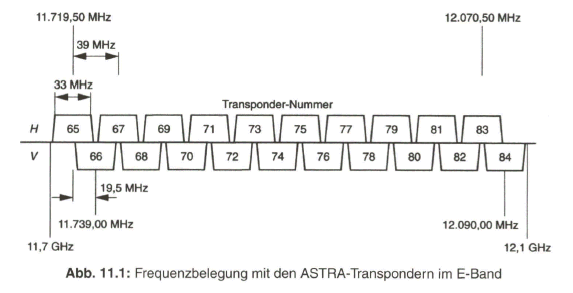

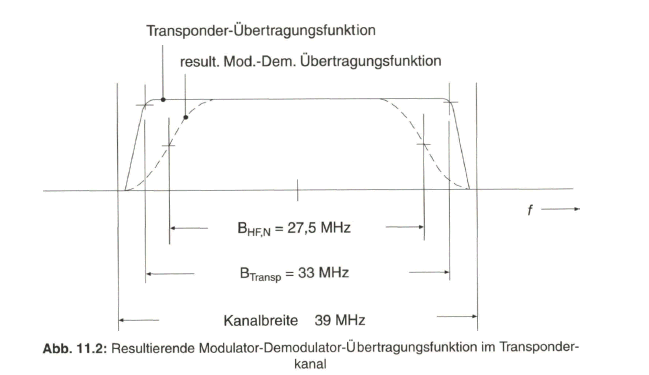

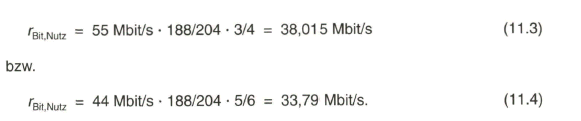

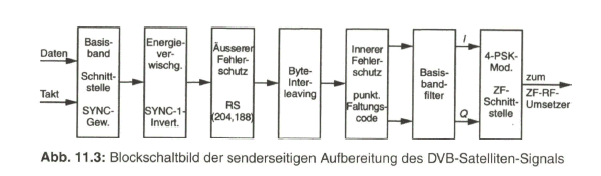

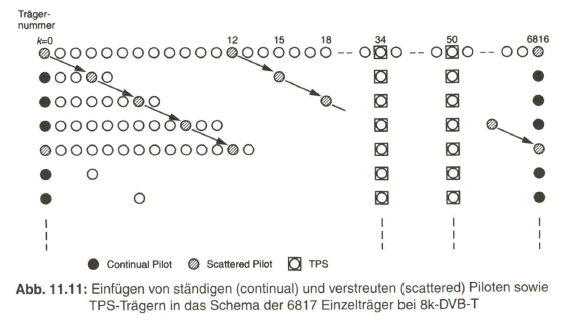

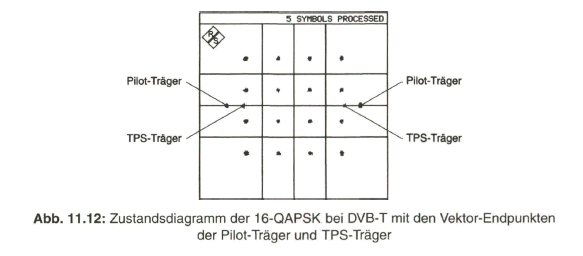

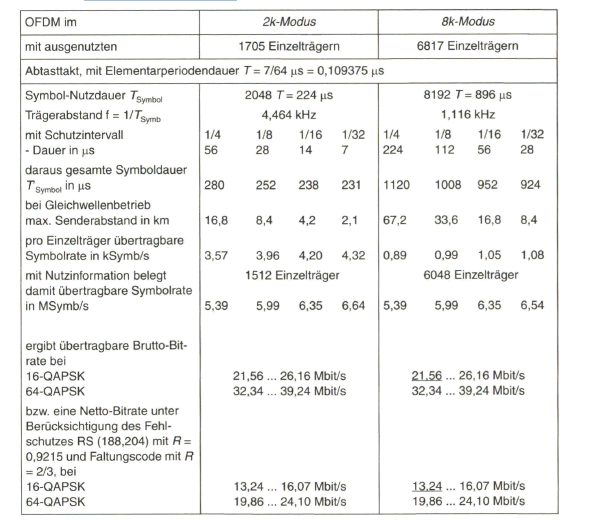

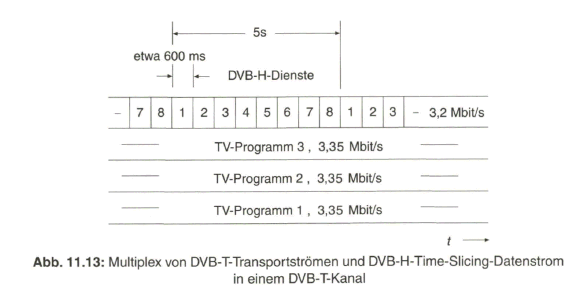

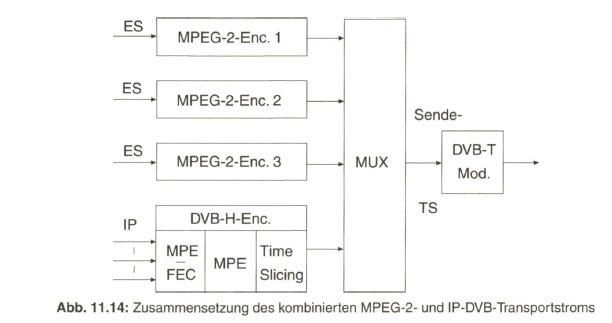

- Gruppe 4 (3 bit) ist noch nicht mit Information belegt.