Bildwiedergabesysteme

Während der Röhrenfernseher über 50 Jahre die Unterhaltungselektronik dominierte, sind spätestens seit Beginn des 21. Jahrhunderts seine flachen, großen, leichten und energieeffizienten Söhne und Enkel die Stars in den Wohnzimmern und seit einigen Jahren auch wieder auf der Internationalen Funkausstellung in Berlin. Kaum noch jemand weint den dicken und schweren TV-Geräten eine Träne nach. So mancher hatte zwar anfänglich Probleme bei der Umstellung, aber letztlich haben wir uns schon längst an die schlanken Geräte gewöhnt und wollen sie auch nicht mehr missen. Oder etwa doch? Machen Smartphone und Tablet dem Fernsehgerät Konkurrenz?

Logo der Internationalen Funkausstellung 2016

Wenn man den Umsatzzahlen Glauben schenken darf, dann schon. Allerdings ist die klassische Unterhaltungselektronik auf dem Rückzug. Dafür wird mehr Geld für IT-Geräte im Privatkundenmarkt ausgegeben. Der Digitalverband Bitkom gab in einer Pressemitteilung pünktlich zum Startschuss der IFA 2015 aktuelle Zahlen bekannt, die sich auf Prognosen der Marktforschungsunternehmen EITO und GfK beziehen. Demnach stellten die Smartphones im Jahre 2015 den Verkaufsrekord auf und spülten über 9 Milliarden Euro Umsatz in die Kassen der Hersteller. Gleich nach der unglaublichen Zahl von 25,56 Millionen verkauften Geräten liegen die Tablets auf Rang 2. Hier wurden 2015 immerhin knapp 8 Millionen Geräte verkauft, was über 2 Milliarden Euro entspricht. Dagegen sieht der Gesamtumsatz der klassischen Unterhaltungselektronik (z.B. TV-Geräte, Spielkonsolen, Blu-ray- und DVD-Player sowie Digitalkameras) mit gerade einmal 9,78 Milliarden Euro ziemlich kläglich aus.

Die Zukunft liegt also in der Vernetzung und dem mobilen Entertainment. So weit, so gut. Und die Flachbildfernseher? Werden auch sie bald vom Markt verdrängt werden oder feiern sie ein neues Comeback? Fakt ist, dass die Umsätze innerhalb des Produktsegmentes „klassische Unterhaltungselektronik“ immer noch den weitaus größten Umsatzanteil ausmachen. Mit 43 Prozent sind TV-Geräte jeglicher Art nach wie vor der Verkaufsrenner par excellence. Und die kleine Lücke in der Nachfrage könnte mit der IFA 2015 auch schon wieder überwunden sein. Denn die Internationale Funkausstellung in Berlin war von jeher die Geburtshelferin für neue Technologien. In 2015 hieß das Zauberwort 4K bzw. Ultra HD, in 2016: HDR, OLED und Quantum Dots.

Curved Display 4K LCD TV X18119 von Medion

Im Jahre 1967 drückte Willy Brandt bei der IFA auf den berühmten roten Knopf und startete damit das Farbfernsehen in Deutschland. Dreißig Jahre später wurde auf der IFA die DVD vorgestellt. Und 2015 stand die IFA wieder Pate für die Präsentation und vielleicht sogar den Durchbruch einer neuen Technologie. In den Hallen auf dem legendären Berliner Messegelände starteten im September 2015 die ersten UHD-Demokanäle (z.B. pearl.tv) via Satellit. Und wieder war es der Sender Sky, der ein Sportevent für seinen Testlauf nutzte. Dieses Mal war es das DFB-Pokalfinale, das in UHD-Qualität live übertragen wurde. Die Verbraucher hatten davon natürlich noch nicht viel. Die Geräte kommen erfahrungsgemäß erst nach der IFA auf den Markt. In 2016 tat sich hier einiges. Ultra HD ist keine Zukunftsmusik mehr – zumindest, was die Bildwiedergabe anbelangt. In den nächsten Jahren wird sich Ultra HD immer weiter etablieren, sofern Hollywood & Co. für entsprechende Filme sorgen.

Denn Ultra HD könnte im Fernsehgeschäft die Innovationsspritze sein, auf die zahlreiche Hersteller, Verkäufer und natürlich viele Verbraucher gewartet haben. Im sogenannten TecWatch-Forum stellte auf der IFA 2015 die Deutsche TV-Plattform entsprechende Programme vor und lud IFA-Besucher und vor allem Experten ein, die neue Bildqualität in Augenschein zu nehmen.

Abbildung 312: Logo Deutsche TV-Plattform zur IFA 2015

Denn der Verkauf neuer UHD-Fernseher steigt nur dann dynamisch, wenn parallel dazu das Angebot entsprechender TV-Inhalte wächst. Vorreiter hierfür ist unter anderem die Videoplattform YouTube aber auch die VoD-Anbieter, wie Amazon, Netflix und Videoload (vgl. „Streaming in Ultra HD und 8K“). Über die entsprechende Apps wurden erste ultrahochauflösende Filme bereits ausgestrahlt. Geplant sind darüber hinaus auch die zukünftige Etablierung von High Dynamic Range (HDR) sowie lineare IPTV-Programmangebote. So kündigte beispielsweise der Präsident der UHD-Alliance und CTO bei 20th Century Fox Film Corporation, Hanno Basse, an, zukünftig mehr Filme in UHD/4K inklusive HDR zu produzieren, die dann in Form von Blu-ray-Discs angeboten werden. Im Rahmen der Zertifizierung und Standardisierung kam hierzu das entsprechende Gütesiegel der UHD-Alliance in 2016 auf den Markt (vgl. hierzu das Kapitel „Ultra HD PremiumTM“ sowie „Weitere Gütesiegel für 4K/Ultra HD“ in diesem Buch).

Zur Qualitätssicherung dienen zusätzlich sogenannte „Best Product Awards“, die insbesondere bei den Verbrauchern zu mehr Vertrauen führen sollen. Gerade bei der Einführung neuer Technologien macht sich hier Unsicherheit breit – nicht zuletzt weil die Neuanschaffung entsprechender Geräte auch immer mit relativ hohen Kosten verbunden ist. Neben „Stiftung Warentest“ und zahlreichen Auszeichnungen von Onlinemagazinen bietet in der Fachwelt aber auch für jeden durchschnittlich interessierten TV-Liebhaber unter anderem der EISA-Award die Möglichkeit, sich im Dschungel des heiß umkämpften Marktes zurechtzufinden.

Die European Imaging and Sound Association (EISA) genießt nicht umsonst hohes Vertrauen und Ansehen in der Branche. Die Tests und Produktbewertungen werden ausnahmslos von hochqualifizierten Experten durchgeführt. Umso mehr kann sich die Firma Sony freuen, die in 2015 von der EISA für ihre innovativen Produktentwicklungen, herausragende Technik und ein eindrucksvolles Design gleich mehrfach ausgezeichnet wurde. So erhielt der japanische Elektronikkonzern für sage und schreibe sechs seiner Produkte den beliebten Award „bestes Produkt“. Sonys HT-XT3 wurde zu Europas bester Soundbase und der BRAVIA KD-65X9005C zum besten Design-Fernseher des Jahres 2015-2016 gekürt. In 2016 vergab die EISA die beliebten Preis in der Kategorie „HOME THEATRE DISPLAY & VIDEO“ an mehrere namhafte Hersteller, wie beispielsweise LG und Panasonic.

Abbildung 313: EISA-Award/Best Product 2016-2017: Panasonic TX-65-DX900E

Doch was ist denn nun der Unterschied zwischen SD, HD, Full HD, Ultra HD? Bei den zahlreichen Bildformaten der televisionären Neuzeit kann man leicht den Überblick verlieren. Worin unterscheiden sie sich? Welche Videoauflösungen gibt es überhaupt? Und wofür benötigt man eine so hohe Pixeldichte? Im folgenden Kapitel soll ein kleiner Überblick über die unterschiedlichen Technologien erfolgen und einzelne Beispiele stellvertretend für die Bildwiedergabesysteme der neuen Generation vorgestellt werden. Natürlich sei auch hier angemerkt, dass die vorgestellten Technologien und Produkte nur eine Momentaufnahme im sich rasant entwickelnden Markt der Unterhaltungselektronik darstellen kann – bezogen auf die Jahre 2015/2016.

Video-Features der Zukunft

Seit der Erfindung des Fernsehens hat sich sowohl die Technik als auch das Verhalten der Verbraucher gravierend geändert. Brillante Bilder, hochauflösend und superscharf sind nur einige Merkmale, die nicht mehr nur TV-Bildschirme, sondern auch Computermonitore sowie Tablet- und Smartphone-Displays der Neuzeit auszeichnen. In der Praxis wird hier nicht selten so einiges durcheinander geworfen und führt mitunter deshalb zu diversen Missverständnissen. Beispielsweise die Bildauflösung. Umgangssprachlich stellt diese das Maß für die Bildgröße dar, die durch die Gesamtzahl der Bildpunkte (Pixel) angegeben wird. Im physikalischen Sinne bezeichnet die Auflösung die Pixeldichte einer Wiedergabe beziehungsweise Bildabtastung. Neben der Farbtiefe zählt also insbesondere die Bildauflösung als Merkmal für die Qualität von Videomaterial.

Abbildung 314: Bildschirmauflösungen (www.burosch.de)

Insofern spielt die Bildgröße zwar eine tragende Rolle in der heutigen Fernsehtechnik, allerdings ist sie kein Garant für ausgezeichnete Bildqualität. Im Gegenteil! So kann beispielsweise eine sehr kleine Grafik viel hochwertiger sein und riesige Bildschirme wiederum geben ein schlechtes Bild, wenn die Auflösung nicht stimmig ist. Alles in allem zählt im Kontext der Bildauflösung und der Bildformate vor allem eines: Ein Bild kann nur so gut sein, wie seine Wiedergabe es ermöglicht. Deshalb ist vor allem die Wiedergabequalität entscheidend für perfekten und hochauflösenden Fernsehgenuss.

Da die Bildauflösung immer auch durch die Anzahl der Spalten (Breite und der Bildzeilen (Höhe) gemessen wird, ist das Bildformat in diesem Zusammenhang entscheidend. Und auch wenn mit den neuen Technologien die Probleme, die sich insbesondere aus der Verknüpfung alter (analoger) und neuer (digitaler) Systeme ergeben, bald verschwunden sein werden, soll hier dennoch kurz auf die herkömmlichen Bildformate eingegangen werden, die sich in der folgenden Abbildung wiederfinden.

|

Bildschirm-Auflösungen |

||

|

Bezeichnung |

Pixel |

Seitenverhältnis |

|

VGA |

640 x 480 |

1,33:1 = 4:3 |

|

SVGA |

800 x 600 |

1,33:1 = 4:3 |

|

WVGA |

853 x 480 |

1,77:1 = 16:9 |

|

XGA |

1.024 x 768 |

1,33:1 = 4:3 |

|

SXGA |

1.280 x 1.024 |

1,25:1 |

|

WXGA |

1.280 x 768 |

1,66:1 = 15:9 |

|

WXGA |

1280 x 800 |

16:10 |

|

WXGA |

1.366 x 768 |

1,77:1 = 16:9 |

|

SXGA+ |

1.400 x 1.050 |

1,33:1 = 4:3 |

|

UXGA |

1.600 x 1.200 |

1,33:1 = 4:3 |

|

WSXGA+ |

1680 x 1050 |

16:10 |

|

UXGA+ |

1.920 x 1.200 |

1,6:1 |

|

QXGA |

2.048 x 1.536 |

1,33:1 = 4:3 |

|

QUXGA |

3.200 x 2.400 |

1,33:1 = 4:3 |

|

QUXGA+ |

3.840 x 2.400 |

1,6:1 |

Abbildung 315: Standards für Bildschirmauflösungen

Das Format des Eingangssignals kann nicht immer akkurat wiedergegeben werden, denn das sogenannte Wiedergaberaster ist auf modernen Flachbildschirmen in der Regel fest vorgegeben. Deshalb muss man im Allgemeinen bereits beim sogenannten Skalieren mit Qualitätsverlusten rechnen. Dass man gestochen scharfe Bilder mit UHD-Technologie nicht auf einem TV-Gerät aus dem Jahre 2001 erkennen kann, leuchtet noch jedem ein. Die Auflösung reduziert sich aber auch und vor allem, wenn beispielsweise HDTV auf einem 4:3-Bildschirm geschaut wird. Grund dafür ist, dass HD ausschließlich das Bildformat 16:9 verwendet und somit bei der Wiedergabe in 4:3 bis zu 25 Prozent der horizontalen Zeilen verloren gehen. Insofern reduziert sich die nutzbare Auflösung und HDTV kommt nicht vollumfänglich zur Geltung.

Kurzum: Jede Auflösungsänderung wirkt sich negativ auf die Bildqualität aus. Da spielt nicht nur die Pixeldichte als solche, sondern vor allem das Bildformat (Höhe und Breite) eine tragende Rolle. Ausschlaggebend dabei ist nicht zwangsläufig die Bilderstellung, sondern vielmehr die Möglichkeiten der Bildwiedergabe. Deshalb ist es wichtig, die Bildauflösung lediglich an einer Stelle des Signalwegs zu verändern, und zwar bei der Bildwiedergabe. In diesem Zusammenhang spricht man auch von der nativen Auflösung, die exakt der physikalischen digitalen Auflösung eines Anzeigegerätes entspricht. Wenn beispielsweise ein Film über einen Blu-ray-Player auf dem Fernseher wiedergegeben werden soll, so ist es ratsam, die Bildeinstellungen entweder am TV-Gerät ODER am Blu-ray-Player vorzunehmen, damit im Zweifel nicht zwei Mal die Auflösung skaliert werden muss. Näheres dazu findet sich im Kapitel „Professionelle Bildeinstellungen“ am Ende dieses Buches.

Abbildung 316: SD(PAL)-Referenzbild „Dubvronik“ (www.burosch.de)

Während bei der Umstellung von SD (Standard Definition) zu HD (High Definition) noch Komplikationen in der Verarbeitung der analogen sowie digitalen Signale auftraten, wird zukünftig bei UHD/4K, HDR, 8K etc. das Umkopieren der Darstellungsformate hoffentlich der Vergangenheit angehören. Basis dafür können jedoch nur die TV-Programmanstalten selbst sein, die sich bestenfalls auf einheitliche Bildformate und Bildabtastvarianten (progressiv oder interlaced) einigen. So könnte die Standardauflösung mit nur 720 x 576 Pixel bald ins kollektive Langzeitgedächtnis wandern, wenn die Fernsehsender das SD-Signal nicht mehr ausstrahlen, sondern ausschließlich in HD senden. Denn erst im Vergleich wird deutlich, wie schlecht das Bild noch vor einigen Jahren standardisiert war (vgl. Abbildung).

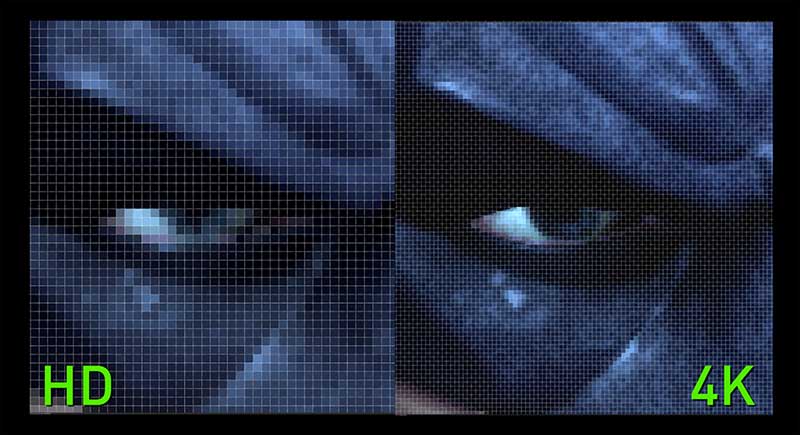

Doch selbst wenn man das bis vor kurzem noch als absoluten Durchbruch gefeierte HDTV mit dem aktuellen 4K-Standard vergleicht, erkennt man schnell die gravierenden Qualitätsunterschiede.

Abbildung 317: Auflösungsvorteil von HD gegenüber Ultra HD/4K (NVIDIA Corporation)

Ein Grund für die rasante Geschwindigkeit, mit der sich die Bildauflösungen potenzieren, ist natürlich die hohe Nachfrage nach besonders großen TV-Geräten. Es liegt in der Natur der Sache, dass eine geringe Pixeldichte auf einem riesigen Bildschirm kein scharfes Bild, sondern vielmehr eine Aneinanderreihung von „Klötzchen“ ergibt. Deshalb konnte selbst Full HD mit 1920 x 1080 Pixel lediglich eine Übergangslösung darstellen – vor allem wenn man bedenkt, dass dieses Format gegenüber Ultra HD nur über ein Viertel der Pixelanzahl pro Fläche verfügt. Gerade bei großen Displayflächen wird der Qualitätsunterschied besonders in den Bilddetails deutlich.

Und wenn man schon Ultra HD auf seinem Bildschirm zu stehen hat, dann sollte auch tatsächlich Ultra HD ausgegeben werden. Um also das Beste aus dem neuen und sicherlich nicht ganz preiswerten TV-Gerät herausholen zu können, sind auch hier Testbilder äußerst sinnvoll. Als Referenz für die optimale Bilddarstellung eignen sich beispielsweise die Testbilder „Dubrovnik“, die in SD und Full HD zur Verfügung stehen. Die feine Struktur der Dächer ist perfekt dafür geeignet, die unterschiedlichen Display-Technologien deutlich zu visualisieren (vgl. die folgenden zwei Abbildungen).

In diesem Zusammenhang sei darauf hingewiesen, dass Referenzbilder ausnahmslos um ein Vielfaches besser sein müssen als die Displays, auf denen sie angezeigt werden. Denn wie beim Urmeter oder der Atomuhr dient eine Referenz als exklusiver Bezugswert, nach dem sich alles andere richtet. Deshalb eignet sich noch längst nicht jedes Foto, das mit einer herkömmlichen Digitalkamera aufgenommen wurde, als Referenzbild. BUROSCH verwendet für die Erstellung seiner Referenzbilder höchstauflösendes Video-Equipment und gewährleistet damit Referenz-Qualität auf maximalem Niveau.

Abbildung 318: Full-HD-Referenzbild „Dubvronik“ (www.burosch.de)

Ultra HD/UHD/4K

Vielleicht fragt sich der eine oder andere Fernsehkunde, wozu eine so gigantische Auflösung überhaupt gut sein kann. Wer ehrlich ist, muss aber auch zugeben, dass genau solche Fragen den technischen Fortschritt in all seinen Facetten und Etappen begleitet haben. In den 1930er Jahren wollte niemand Fernsehgeräte im Wohnzimmer, in den 1950er Jahren waren die Verbraucher skeptisch gegenüber Color-TV. Und übermorgen kann sich kaum noch jemand vorstellen, dass es vor kurzem überhaupt analoges Fernsehen gab und die Pixeldichte unterirdisch niedrig war.

Denn Ultra HD mit 3840 x 2160 Pixel bedeutet die exakt vierfache Auflösung gegenüber Full HD und damit immer mehr darstellbare und vor allem schärfere Bilddetails trotz großer Bildschirmfläche. Denn auch die ist heute keine Seltenheit mehr. TV-Geräte mit Diagonalen von 60 Zoll (152 Zentimeter) und mehr stehen bereits in vielen deutschen Haushalten. Nicht zuletzt durch unsere Smartphones sind wir in punkto Auflösung mehr als nur verwöhnt. Da kommen die 4K-Fernseher mit ihren unglaublichen acht Millionen Bildpunkten gerade richtig. Und wer sich fragt, ob sich ein Kauf jetzt (2016) schon lohnt, wo es kaum ultraauflösendes Filmmaterial gibt: Es lohnt sich allemal, denn die 4K-Fernseher rechnen mithilfe neuer Chip-Technologien auf die stärkere Auflösung hoch, sodass die Bildqualität im Allgemeinen nur besser werden kann (vgl. hierzu Kapitel „Upscaling & Co.“ in diesem Buch).

Abbildung 319: UHD-Referenzbild „Dubvronik“ (www.burosch.de)

Beim Kauf eines solchen neuen 4K-Gerätes sollten allerdings einige Punkte beachtetet werden. Insbesondere die Anschlüsse müssen zur Verwendung passen. Wer sich zum UHD-TV beispielsweise gleich noch einen 4K-Blu-ray-Player kauft, der könnte bei 60 Hz enttäuscht werden. Nicht alle HDMI-Eingänge unterstützen alle Standards. In der Regel weiß der versierte Verkäufer Rat, allerdings bieten auch diverse Fachzeitschriften und entsprechende Online-Portale ausreichende Informationen an. Auch die Firma BUROSCH wird als Ansprechpartner gern genutzt, wenn es um qualifizierte Beratung und herausragende Bildoptimierung geht. Nicht umsonst ist das Stuttgarter Unternehmen Experte im TV-Tuning und seit Jahren Marktführer auf diesem Gebiet.

Auf unserer Webseite erhalten Interessierte viele Informationen in Bezug auf das Grundlagenwissen der Fernsehtechnik, die aktuellen technischen Features und damit Auskunft darüber, ob ein UHD-Fernseher zukunftssicher ist oder eben nicht. Denn nicht jeder UHD-TV ist qualitativ gleichwertig in Bezug auf Qualität und technische Standards. Warum sollten sonst Geräte im Jahre 2016 das Vielfache von dem Kosten, was im Grunde bereits 2014 auf dem Markt erhältlich war. Die eindeutige Aussage ist: die Pixelanzahl allein ist noch kein Qualitätskriterium, sondern die Qualität jedes einzelnen Bildpunktes. In ist, was drin ist! Und hier sind die Unterschiede zwischen Einstiegs- und Oberklassemodellen gewaltig. Ob mit zusätzlichen Farbfiltern, beschichteten Leuchtdioden oder Nanotechnologie – die technischen Dimensionen und damit Kontrast und Farbbrillanz haben sich in nur wenigen Monaten signifikant verbessert. Und auch die Anschlüsse sind nicht überall dieselben. Nicht alle UHD-TVs unterstützen das neue HDR-Format oder aber HEVC-Codecs. Die Zukunft liegt darüber hinaus in HDMI 2.0 und HDCP 2.2 sowie in Doppeltunern, drahtlosem TV-Empfang, Streaming und natürlich bester 4K-Bildqualität sowie HDR.

Abbildung 320: © Sony

Die Checkliste könnte also folgende Punkte enthalten:

-

Zur Mindestausstattung gehört ein HDMI-Eingang, der den Kopierschutz HDCP 2.2 sowie den Codec H.265 verarbeiten kann, um für zukünftige UHD/4K Blu-ray-Player gerüstet zu sein.

-

Darüber hinaus sollte das Gerät über mindestens einen HDMI-Eingang verfügen, der die UHD-Auflösung bei 10 oder aber 12 Bit/Deep Color mit einer Farbunterabtastung von YCbCr 4:2:0 bis hoch zu YCbCr 4:4:4 bei 50/60Hz unterstützt. Die 8-Bit-Variante ist allerdings auch nach wie vor wichtig, um Rückwärtskompatibilität zu gewährleisten.

-

Für zukünftigen UHD-Empfang sollte der TV über einen eingebauten Empfänger verfügen, der auch entsprechend codierte Signale (50/60Hz H.265/HEVC) empfangen und decodieren kann sowie die aktuellen Spezifikationen DVB-S2 und DVB-T2 unterstützt (Stand: 2016).

-

Für das zukünftige UHD-Film-Streaming über Netflix, Amazon & Co. muss der H.265/HEVC-Codec auch über die jeweilige App des Streaming-Anbieters unterstützt werden. Sofern dies der Fall ist, greift auch die Abwärtskompatibilität zu HDCP 2.2.

-

Auch über den USB-Anschluss sollte optional das Abspielen von UHD- sowie Full-HD-Files im H.265/HEVC codierten Standard möglich sein.

-

JPEG-Dateien beziehungsweise Fotos im Allgemeinen sollten auch in nativer UHD-Auflösung dargestellt werden, ohne dass die Ränder beschnitten werden.

-

Und letztlich ist UHD-Auflösung nicht alles. Auch eine verbesserte Farbdarstellung und die Unterstützung des neuen HDR-Formats sollten vom neuen „Familienmitglied“ im heimischen Wohnzimmer realisiert werden können, wenn es um Zukunftssicherheit und die entsprechenden technischen Möglichkeiten geht.

Grundsätzlich ist beim Kauf darauf zu achten, dass die oben genannten technischen Daten gegeben sind. Bei den 2016er Modellen der Markenhersteller sollten die Features eigentlich zur Standardausrüstung gehören, wobei HDR und auch der neue Farbraum BT.2020 hier noch in den Kinderschuhen stecken. Wichtige Informationen zu diesen neuen Features erhalten Sie in den folgenden Kapiteln. Auf der UHD-Welle schwimmen jedoch auch diverse Billighersteller mit, bei denen die Ausstattung ganz genau geprüft werden sollte. Andererseits bieten beispielsweise ältere AV-Receiver das sogenannte UHD/4K-Passthrough, was hingegen nicht ausreicht, um echte UHD-Filme in ihrer ganzen Schönheit darstellen zu können. Auch Blu-ray-Player sind erst seit Ende 2015 vollständig UHD-fähig. Weitere Informationen hierzu finden sich im Kapitel „Video-Equipment“.

BT.2020: Der lange Weg zum erweiterten Farbraum

Die Hersteller werben mit einem erweiterten Farbraum und manche Displays bieten bereits entsprechende Menü-Optionen an. Ähnlich verhält es sich mit dem neuen Feature High Dynamic Range (HDR), das im nächsten Kapitel eingehender erläutert werden soll. In diesem Zusammenhang hält sich tapfer das Gerücht, dass unter dem Begriff „Rec.2020“ ausschließlich die Erweiterung des Farbraums gemeint ist. Doch das ist so natürlich nicht richtig. Beide Standards rücken mit hoher Geschwindigkeit in den kollektiven Fokus der technikinteressierten Gemeinde, Verwirrung macht sich breit. Jedoch wird selbst im Zukunftsmarkt Medientechnik nicht alles so heißt gegessen, wie es serviert wird.

Bevor wir uns mit den technischen Details der BTU-Empfehlung BT.2020 (oder Rec.2020) befassen, schauen wir uns deshalb noch einmal etwas genauer an, was Farbräume überhaupt sind. Näheres dazu findet sich im Übrigen auch im Kapitel „Farbräume und photometrische Größen“.

Abbildung 321: BT.2020 – Der lange Weg zum erweiterten Farbraum (Bild: Panasonic)

Die Grundlage für alle Farbräume bilden die Graßmannschen Gesetze, welche die Farbvalenz als eine dreidimensionale Größe - die Grundfarbe (Spektralfarbe), die Farbintensität und die Weißintensität - definieren. Darauf aufbauend werden diese drei Grundgrößen heute im Zusammenhang mit dem HSV-Farbraum, den CIE-Primärvalenzen oder den Werten CMY und RGB verwendet. RGB ist die Abkürzung für Rot, Grün, Blau. Diese drei Farbwerte stellen die Primärvalenzen beziehungsweise Primärfarben dar, also jene drei spektral reinen Farben, die sich nicht aus den jeweils anderen herstellen (mischen) lassen. Der deutsche Naturwissenschaftler Hermann Ludwig Ferdinand von Helmholtz erkannte, dass die Farbvalenz durch Farbton, Sättigung und Helligkeit gekennzeichnet ist. So lässt sich die „Farbe“ nach ihrem Helligkeitsanteil (engl. luminance) und der Farbart unterscheiden. Diese setzt sich aus dem durch die Wellenlänge des Lichtes bestimmten Farbton (engl. hue) und der Farbsättigung (engl. saturation) zusammen, die durch den zugemischten Weißanteil entsteht. Insofern ist der Begriff „Farbe“ nicht korrekt. Es müsste vielmehr „Buntheit“ heißen, da die sogenannten Farbnuancen in erster Linie etwas mit der Helligkeit zu tun haben. Im Umkehrschluss verwendet man bei Grauwerten in der Fachsprache die Bezeichnung „unbunte Farben“.

Farben entstehen also in erster Linie durch Licht, weshalb ebenjenes auch und vor allem in der Display-Praxis eine tragende Rolle spielt. Verändert man die Intensität eines Farbtons, ergeben sich pro Farbton etwa 500 unterscheidbare Helligkeiten. Die Grundlage aller Farben sind die oben beschriebenen Primärvalenzen RGB und darüber hinaus die sogenannten Komplementärfarben, welche auch synonym als Gegenfarben bezeichnet werden, da sie sich im sogenannten Farbkreis genau gegenüberstehen. Verschiedene Farbpaare gelten als komplementär. Dazu zählen Blau ↔ Gelb, Rot ↔ Cyan und Grün ↔ Magenta. Da diese aus den Farben RGB resultieren, stellen sie die Basis dar für das CIE-System und andere technische Systeme (z.B. RGB und CMY).

Abbildung 322: Veranschaulichung der Primär- und Komplementärfarben im Farbkreis

Soweit die Theorie. Im Laufe der technischen Entwicklungen wurde zu Beginn des 20. Jahrhunderts erkannt, dass die subjektive Natur der menschlichen Farbwahrnehmung nicht unbedingt ein verlässlicher Parameter ist. Deshalb wurden bestimmte Farben als Referenzwerte festgelegt werden. Bereits im Jahre 1931 wurde eine Normfarbtafel entwickelt und von der Internationalen Beleuchtungskommission (Commission internationale de l’éclairage: CIE) in einem Farbbeschreibungssystem definiert: dem CIE 1931. Dieses stellt auch heute noch eine international vereinbarte Methode der Farbkennzeichnung dar, um die menschliche Farbwahrnehmung und die physiologisch farbige Wirkung einer wahrgenommenen Strahlung (Farbvalenz) in Relation zu setzen. Sie basiert auf der additiven Farbmischung. Deshalb wird dieses wahrnehmungsbezogene System auch als CIE-Normvalenzsystem bezeichnet, das die Gesamtheit aller vom Menschen wahrnehmbaren Farben umfasst.

Mithilfe der Dreifarbentheorie gelang somit die numerische Erfassung der vom Menschen wahrnehmbaren Farbreize. Auch wenn die Hufeisenform des CIE-Farbsegels vom Grunde her der nicht-linearen physiologischen Verarbeitung im menschlichen Auge entspricht, können mit den drei Primärfarben nur die Farbreize technisch wiedergegeben werden, die nach dem Gamut-Prinzip innerhalb des abgebildeten Dreiecks liegen. Insofern handelt es sich hierbei um ein theoretisches Dreieck mit einem mathematisch definierten Feld, in dem jeweils die Farben liegen, die von einem Bildgerät reproduziert werden können. Auch wenn sich dieses dreieckige Feld innerhalb des Gamuts im Laufe der Zeit erweiterte und damit heute einen weitaus größeren Farbraum gemäß Rec.2020 zulässt, gleicht es noch längst nicht dem Potenzial der menschlichen Wahrnehmung.

Neben dem aktuellen HDTV-Standard gemäß Rec.709 und dem zukünftigen nach BTU-Empfehlung Rec.2020 haben sich im Laufe der Zeit diverse Farbraummodelle entwickelt. So haben allein die Fernsehnormen (NTSC, PAL und SECAM) jeweils individuelle Parameter für die Farbdarstellung. Genauso wurden im Computerbereich eigene Modelle entwickelt, wie etwa sRGB, der eine aktuelle Alternative zu Rec.709 bietet. In der Digitalfotographie ist seit 1998 Adobe-RGB internationaler Standard, im Digitaldruck hat sich CMYK etabliert. Und ein weiterer Farbraum ist spätestens seit Ultra HD und dem entsprechenden Gütesiegel der UHD-Alliance in aller Munde: DCI - der Farbdynamik-Standard für Kinoformate.

Im Rahmen der Zertifizierung und den entsprechenden Angaben in Bezug auf Standards zu Ultra HD und HDR tauchte in 2016 immer wieder die Formulierung auf: „deckt den DCI-Farbraum um xy Prozent ab“. Dieser Parameter wird als Qualitätsmerkmal genutzt, doch kaum jemand weiß, was tatsächlich dahinter steckt. DCI bedeutet grundsätzlich „Digital Cinema Initiatives“. Hierbei handelt es sich um den Dachverband der amerikanischen Filmstudios, welcher den gleichnamigen Farbdynamik-Standard herausgegeben hat. Im eigentlichen Sinne bezieht sich dieser Farbraum auf Kinoformate. Jedoch ist im Zusammenhang mit der 4K-Auflösung insbesondere bei Beamern ebenjenes Cinema-Format mit einer Auflösung von 4096 × 2160 Pixeln im Heimkinobereich längst angekommen. Der entsprechend bezeichnete DCI-Farbraum ähnelt vom Umfang her in etwa dem Adobe-RGB-Farbraum und ist somit bedeutend größer als der Farbraum gemäß BT.709 aber kleiner als nach BT.2020 (vgl. Abbildung).

Abbildung 323: Vergleich Farbräume nach Rec. 709, Rec.2020 und DCI

Kommen wir nun zur Praxis. Erinnern Sie sich an das Desaster seinerzeit bei der Umstellung auf 16:9? Selbst als die Fernseher technisch dazu in der Lage waren, das Seitenverhältnis automatisch anzupassen, waren nervige Verzerrungen die Folge. Die Darsteller in älteren Filmen oder TV-Produktionen im 4:3-Format hatten plötzlich breite Gesichter oder aber ihnen fehlte der halbe Kopf. Ganz ähnlich verhält es sich bei der Darstellung der beiden Farbräume. Denn es ist nicht so einfach, aus 75,8 Prozent des Farbraums 35,9 Prozent zu zaubern – oder umgekehrt. Vor allem dann, wenn nicht bekannt ist, wie diese Farben produziert wurden. Anders als beim Upscaling/Downscaling – also der Anpassung von Full HD auf Ultra HD oder umgekehrt - gibt es in punkto Farbraum kaum geeignete Technologien, die es ermöglichen, die Farben beziehungsweise Farbstandards automatisch anpassen zu können.

Die ersten Geräte bieten bereits in den Bildeinstellungen die Auswahlmöglichkeit zwischen BT.709 und BT.2020. Nur hilft uns dieser Modus zurzeit (Stand: 2016) noch keinen Millimeter weiter. Denn auch mit dem teuersten Fernseher bleiben die massiven Probleme in der Abwärtskompatibilität sowie der Linearität der Wiedergabekette bei den verschiedenen Zuspielungen. Warum? Produziert und gesendet wird derzeit noch im Farbraum gemäß BT.709. Stellt man das Display mit BT.2020 ein, wirken die Bilder zu knallig. Und selbst wenn originales Videomaterial mit dem erweiterten Farbraum zugespielt wird, können die Geräte heute noch nicht automatisch zwischen den Farbräumen wechseln und die Bildmodi entsprechend anpassen. Insofern ist es wohl für den Übergang besser, weniger Farben einzustellen, auch wenn man mehr Farben zur Verfügung hat.

Schon mit der Einführung von HDTV und dem Farbstandard gemäß ITU-R BT.709 gab es Probleme zwischen der Filmaufnahme und der Filmwiedergabe. Während die Koordinaten für die Farborte exakt definiert sind, wurde ein verbindlicher Gammaverlauf nur für die Filmaufnahme festgelegt – nicht aber für die Wiedergabe. Doch die Basis für ein perfektes Bild ist die korrekte Umsetzung der Gammafunktion beziehungsweise Gammakorrektur (vgl. entsprechendes Kapitel in diesem Buch). Hierbei handelt es sich um das Leuchtverhältnis unterschiedlicher Grau- und Farbstufen, das dazu dient, aus einer linearen Größe (Aufnahme) eine nicht-lineare Übertragungsfunktion (Wiedergabe) zu machen, die der menschlichen Wahrnehmung entspricht. Im Allgemeinen hat sich der Gammawert von 2,2 bis 2,4 als Standardgröße etabliert, weshalb Displays zwischen 10 und 90 IRE exakt auf ein Gamma von 2,2 kalibriert werden. Bei der Verarbeitung des Eingangs- und Ausgangssignals im TV-Display kann es nun zu Fehlern kommen, die vor allem die Leuchtkraft und damit den Kontrast und natürlich auch die Farbstufen betreffen. Denn der spezifizierte Gammaverlauf von BT.709 für die Aufnahme weicht massiv von einem realen Gamma 2,2 ab. So muss ein 10-Prozent-Pegel im Eingangssignal noch längst keine 10 Prozent der maximalen Leuchtkraft bei der Wiedergabe ergeben. Bisweilen bleibt nicht mehr als 1 Prozent Lichtstärke im Ausgangssignal übrig.

Dies ändert sich nun insbesondere mit der neuen HDR-Technologie. Denn hier wurde die nicht-lineare Übertragungsfunktion (klassische Gammakurve) durch die weitaus komplexere elektrooptische Transferfunktion (EOTF) ersetzt. Allerdings definiert die ITU mit BT.2020 weiterhin eine nichtlineare Übertragungsfunktion zur Gammakorrektur bei RGB und YCbCr. Wobei RGB für beste Qualität und YCbCr für die Gewährleistung der Kompatibilität zu SDTV/HDTV eingesetzt werden kann. Darüber hinaus ist in BT.2020 ebenfalls eine linear-kodierte Version von YCbCr (YcCbcCrc) definiert, welche Anwendung findet, wenn eine möglichst originalgetreue Reproduktion der Helligkeitsinformationen gefordert wird.

Abbildung 324: BUROSCH-Testbild zur exakten Beurteilung des Gamma-Wertes (2,4)

Hinzu kommt, dass neben der Gammakorrektur gemäß BT.2020 bei der Filmproduktion beziehungsweise dem Mastering weitere Übertragungsfunktionen verwendet werden (z.B. nach BT.1886, BT.2035 oder Dolby Perceptual Quantizer: PQ). Außerdem kann im Nachhinein kaum eine eindeutige Aussage darüber getroffen werden, welcher Film wie gemastert wurde. Kurzum: Fernsehtechnik bedeutet heute nicht mehr nur schlichte Amplitudenmodulation. Die digitale Technik ist mittlerweile so komplex geworden, dass selbst beste Prozessoren ihre Schwierigkeiten bei der Signalverarbeitung haben. Genau deshalb klafft zwischen der Theorie und der Praxis noch eine riesige Lücke, die erst nach und nach gestopft werden kann – egal, was die Hersteller versprechen.

Bei der Fülle dieser Werte ist schnell erkennbar, dass insbesondere bei der Farbreproduktion Schwierigkeiten auftreten können. Auch wenn Studiomonitore (z.B. BVM-L 230 von Sony) über präzise Farbkorrekturen verfügen, die nahezu alle Farbstandards emulieren können, heißt das noch lange nicht, dass auch Consumer-Geräte dazu in der Lage sind. Die Hersteller werben mit „Wide Color Enhancer“ und versprechen bessere und sogar mehr Farben, als die Fernsehtechnik jemals vermochte und die Konkurrenz hat. Tatsächlich ist aber nicht die Anzahl der Farben, sondern deren richtige Darstellung das Geheimnis. Und genau hier liegt der Hase im Pfeffer. Selbst wenn die aktuellen TV-Geräte grundsätzlich einen erweiterten Farbraum darstellen können, entspricht dieser nicht immer dem festgelegten Farbstandard. Bei der Reproduktion des Farbraums werden somit Farben schlichtweg falsch dargestellt – also nicht so, wie bei der Aufnahme beziehungsweise Filmproduktion vorgesehen.

Und genau deshalb ist es noch viel zu früh, den HDTV-Standard gemäß BT.709 bereits zu den Akten zu legen. Rec.709 ist immer noch gültig. Im Kapitel „Farbräume und photometrische Größen“ wurde bereits ausführlich darauf hingewiesen, was genau die ITU-Empfehlung BT.2020 beinhaltet. Im Wettstreit um Detailreichtum und Farbvielfalt verwenden die TV-Hersteller den Begriff „Rec.2020“ jedoch quasi synonym für dynamisches Licht, nie dagewesene Bildtiefe und natürlich eine gigantische Farbenpracht. Schlagwörter wie „Wide Color Enhancer“ (Erweiterung des Farbraums) machen die Runde.

Abbildung 325: Werbung für Wide-Color-Enhancer-Technologie (Samsung)

Und doch heißt die aktuelle Videonorm: BT.709. Zumindest noch solange, bis die technischen Voraussetzungen tatsächlich in der Display-Praxis angekommen sind. Die Firma BUROSCH ist seit nunmehr siebzig Jahren am Markt und hat so einige Hypes und technische Revolutionen hautnah miterlebt. Einige davon haben sich durchgesetzt (Full HD), andere sind noch dabei (HDR) und wieder andere verschwinden so langsam wieder von der Bildfläche (3D). Insofern gehört es zu unserem Firmenprofil, die technischen Entwicklungen und Trends am Markt genau zu beobachten, im Labor daran teilzuhaben, darüber zu berichten und im richtigen Moment entsprechend zu handeln. Aufgrund unserer engen Zusammenarbeit mit diversen Herstellern sitzen wir quasi in der ersten Reihe, wenn es um die Geburt, die Kinderkrankheiten und die Etablierung eines neuen Video-Features geht.

Vor diesem Hintergrund können wir im Jahre 2016 mit Fug und Recht behaupten, dass wir uns derzeit im Grunde erst auf der Hälfte des Weges von BT.2020 befinden. Denn es sind gerade einmal vier Jahre vergangen seit der Veröffentlichung der BTU-Empfehlung Rec.2020, die als solche im Übrigen keinen festen Zeitplan vorsieht. Schaut man sich in der Praxis an, was in den aktuellen TV-Modellen drinsteckt, dann wird schnell klar, dass wir uns derzeit erst am Anfang der Phase 2 von UHD-1 befinden. Ultra HD erobert den Markt, 50 beziehungsweise 60 Hz sind Realität und 8-Bit-Panels wurden in 2016 durch die neue 10-Bit-Variante ersetzt. In den deutschen Wohnzimmern hingegen stehen überwiegend Fernseher mit FullHD-Auflösung, ganz zu schweigen vom TV-Signal, das mit DVB-T2 in 2017 erst die FullHD-Ära einläutet und von Ultra HD noch weit entfernt ist.

Selbstverständlich tut sich was in punkto Farbraumerweiterung. Die Fernsehtechnik erlebt in diesen Zeiten eine kleine Revolution. Mit der Recommendation ITU-R BT.2020 vom 23. August 2012 wurde der Grundstein für farbgewaltige XXL-Displays mit beeindruckender Bildqualität gelegt. Aber eben nur der Grundstein und längst nicht die Spitze des gigantischen Wolkenkratzers. Vergleicht man die Entwicklung von High Definition mit einem Hausbau, so befinden wir uns heute vielleicht im mittleren Stockwerk. Denn die BT.2020 sieht insgesamt drei Phasen der Einführung von UHD vor und hat für ebendiese verschiedene Parameter festgelegt oder vielmehr als Mindeststandard empfohlen. Mit 4K und HDR befinden wir uns im Jahre 2016 am Anfang von Phase 2. Das Ziel von Rec.2020 ist also noch längst nicht erreicht, denn das heißt: 8K.

Abbildung 326: Zeitplan für die Umsetzung von Rec.2020

Wie aus obiger Abbildung ersichtlich ist, sind für die Umsetzung der Rec.2020 drei Phasen vorgesehen. Diese beinhalten ausschließlich technische Standards und keine Werbeversprechen. Insofern sollte man sich als Technikinteressierter an ebenjene Spezifikationsrichtlinien halten. Schauen wir uns die technischen Details im Einzelnen an und vergleichen sie mit der Praxis im Jahre 2016:

Bei der Einführung von UHD-Fernsehern wurden noch 8-Bit-Displays verbaut und somit lediglich der Farbraum nach Rec.709 realisiert. Insofern sind hier die gravierenden Unterschiede in der Bilddarstellung begründet, weshalb die Pixelanzahl eben nicht allein über die Qualität entscheidet. So wurde der Farbraum gemäß der Empfehlung Rec.2020 für UHD-2 erweitert und umfasst 75,8 Prozent der Farben im Diagramm des Farbraumes CIE 1931 und damit Wellenlängen, die nach Rec.709 (35,9 Prozent) noch nicht darstellbar waren. Für die RGB-Grundfarben wurden die folgenden Wellenlängen in der BT.2020 festgesetzt: Rot (630 nm), Grün (532 nm), Blau (467 nm). Aufgrund der höheren Abstände zwischen benachbarten Farbwerten erfordert die entsprechend höhere Farbpräzision ein zusätzliches Bit pro Abtastwert.

Gemäß der ITU-R-Empfehlung BT.2020 wird bei 10 Bits pro Abtastwert eine Helligkeitswerteskala genutzt, bei der der Schwarzpunkt auf den Code 64 und der Weißpunkt auf den Code 940 festgesetzt ist. Für die Zeitreferenz dienen die Codes 0 bis 3 und 1.020 bis 1.023, während die Codes 4 bis 63 Helligkeitswerte unterhalb des Schwarzpunktes und die Codes von 941 bis 1.019 Helligkeitswerte oberhalb des Nennspitzenwertes bezeichnen. Bei 12 Bits pro Abtastwert ist der Schwarzpunkt auf dem Code 256 und der Weißpunkt auf dem Code 3.760 der Helligkeitswerteskala gemäß Rec.2020 festgelegt.

Entsprechend verändern sich die übrigen Werte: Zeitreferenz (Codes 0 bis 15 und 4.080 bis 4.095), Helligkeitswerte unterhalb des Schwarzpunktes (Codes 16 bis 255), Helligkeitswerte oberhalb des Nennspitzenwertes (Codes von 3.761 bis 4.079). Das klingt alles ziemlich kompliziert? Ist es auch. Für die praktische Anwendung haben wir deshalb im Folgenden vier Punkte aufgeschlüsselt, die im Wesentlichen den aktuellen Stand der Technik im Jahre 2016 aufzeigen und in diesem Zusammenhang die Tatsache begründen, warum es bis zur realen Praxis gemäß Rec.2020 noch etwas dauert:

Auflösung: Deutschland schafft gerade erst das analoge Kabelfernsehen ab (Sommer 2017). TV-Inhalte in Full HD sind noch längst nicht flächendeckend verfügbar. Lediglich Videoproduktionen in Ultra HD kommen langsam auf den Markt. Die Entwicklung der 4K-Blu-ray-Disk/-Player hinkt. Mit HDR und einem erweiterten Farbraum können ultrahochauflösende Videoinhalte derzeit praktisch nur per Onlinestream geschaut werden – jedoch in voller Qualität nur von dem, der über Highspeed-Internet verfügt. Bei schwachem Datentransfer (z.B. DSL) wird auf Full HD oder gar SD gedrosselt.

Abtastverfahren/Bildwiederholungsrate: Die öffentlich-rechtlichen Fernsehanstalten senden derzeit mit 720 Zeilen und 50 Vollbildern pro Sekunde (720p/50) im progressiven Vollbildverfahren. Das Interlaced-/Halbbildverfahren ist jedoch mit 1080i noch nicht vom Tisch der Programmanbieter. Die Zukunft heißt 1080p/50 und damit gerade einmal Full HD und 50 Hz. Das heißt, Ultra HD mit 100/120 Hz (High Frequency Rate: HFR) ist im Zusammenhang mit der TV-Übertragung reine Zukunftsmusik.

Quantisierung/Farbraum: Mit 8 Bit für die Übertragung beziehungsweise Verteilung von TV- und Videoinhalten ist kein HDR möglich. Abgesehen davon sind alle Geräte, die bis 2015 hergestellt wurden, in der Lage, maximal mit 8 Bit zu arbeiten. Der erweiterte Farbraum wird in den Studios generell noch nicht angewendet, aktueller Standard bleibt für 2016 und die nahe Zukunft der Farbraum nach BT.709.

Insofern ist der Weg bis zur Vollendung der ITU-Empfehlung noch lang, auch wenn „lang“ im rasanten Tempo der technischen Fortschritts im 21. Jahrhundert quasi nur noch ein Wimpernschlag bedeutet. Erste Player sind auf dem Markt und mit ihnen eine kleine Auswahl an Blu-ray-Discs. Videomaterial in Ultra HD ist tatsächlich aber nach wie vor fast ausschließlich als Stream zu haben. Allerdings ist das Datenvolumen eines erstklassigen 4K-Streams inklusive HDR & Co. trotz bester Komprimierungsverfahren riesig und kann nach heutigem Stand kaum transportiert werden (vgl. Kapitel „Streaming in Ultra HD und 8K“ in diesem Buch).

Wer sich nun fragt, warum Hersteller mit ihren aktuellen TV-Modellen den erweiterten Farbraum nun so hoch loben? Dieser stellt naturgemäß ein wesentliches Qualitätsmerkmal dar - sowohl bei der Aufnahme als auch bei der Wiedergabe. Denn nur ein umfassender Einstell-Spielraum macht eine automatische Farbkorrektur möglich, die dafür sorgt, dass die Farbreproduktion an die unterschiedlichen Farbstandards angepasst werden kann und somit neutrale Farben liefert. Also auch wenn es noch eine Weile dauern wird, bis Hollywood seine Blockbuster im erweiterte Farbraum serienmäßig produziert, kann es nicht schaden, schon heute einen Fernseher zu besitzen, der nicht nur den aktuellen HDTV-Standard BT.709 korrekt darstellt, sondern darüber hinaus den erweiterten Farbraum gemäß BT.2020 realisieren könnte.

Bleibt abschließend zu bemerken, dass sich die ITU-Empfehlung BT.2020 nicht auf die Bildeinstellungen bezieht, sondern grundsätzlich auf die Display-Technik für ultrahochauflösende Geräte. Es geht also primär um Bits, Hertz und die technischen Voraussetzungen für die Zukunft von UHD-2 (8K). In enger Zusammenarbeit mit diversen Herstellern testen wir seit 2016 Displays in der jeweiligen Produktionsphase auf den aktuellen Farbraum gemäß Rec.2020 - so beispielsweise das UltraHD-Premium-Modell TX-58DXW904 von Panasonic, welches als erstes Gerät überhaupt das Premium-Siegel der UHD-Alliance erhielt und tatsächlich den erweiterten Farbraum darstellen kann und darüber hinaus HDR-fähig ist.

HDR

High Dynamic Range (HDR) war bisher nur aus der Bildbearbeitung bekannt. Dabei handelt es sich um sogenannte Hochkontrastbilder, die große Helligkeitsunterschiede detailreich wiedergeben, weshalb in diesem Kontext auch von Bildern mit hohem Dynamikumfang gesprochen wird. Das Gegenteil bezeichnet LDR – also digitale Bilder mit geringem Dynamikumfang: Low Dynamic Range (Images). Die Standardvariante insbesondere in der herkömmlichen Videotechnik wird als SDR (Standard Dynamic Range) bezeichnet – also ähnlich wie bei der Videoauflösung SD und HD. Bisher waren HDR-fähige Ausgabegeräte dünn gesät. Aber auch das änderte sich mit der neuen TV-Generation im Jahre 2016, weshalb es nicht schaden kann, zu wissen, worum es dabei eigentlich geht.

Der Dynamikumfang bezeichnet grundsätzlich das Verhältnis von größter und kleinster Leuchtdichte und wird typischerweise von der sichtbaren Umgebung (Kamera oder Betrachter) in der Größenordnung von 10.000:1 ausgewiesen. Allerdings kann dieser Dynamikumfang auch noch wesentlich größer werden, wenn eine Lichtquelle hinzugezogen wird. Bisher wurden bei der digitalen Bildverarbeitung hierzu lediglich 256 Helligkeitsstufen (8 Bit) für jeden RGB-Farbkanal verwendet.

Abbildung 327: Vergleich mit und ohne HDR-Modus

Allerdings erhöht sich mit den neuen Technologien die Farbtiefe auf 10 Bit (Deep Color). Dazu nutzen HDR-Displays spezielle Techniken, um den Dynamikbereich auszuweiten. Eine Möglichkeit ist hier die Erhöhung der Helligkeitswerte über eine Hintergrundbeleuchtung - einer sogenannten LED-Matrix, mit der das Display nicht flächendeckend, sondern individuell heller und dunkler bestrahlt wird oder aber die Bildpunkte selbst dynamisch leuchten. Erst so kann der Kontrast erhöht beziehungsweise Weiß heller und Schwarz dunkler dargestellt werden, als es bisher möglich war. Die Steuerung von Farbton und Helligkeit erfolgt bei HDR also nicht mehr statisch, sondern in Abhängigkeit vom Bildinhalt. In der Gerätepraxis werden so Werte zwischen 0,01 und 4.000 cd/qm erzielt, was einem Dynamikumfang von 400.000:1 entspricht.

Mit HDR ist es somit möglich, die in der Natur vorkommenden Helligkeiten und Farben viel besser zu erfassen und entsprechend darzustellen. Über- oder Unterbelichtungen sind perspektivisch so gut wie ausgeschlossen. Deshalb können mit der HDR-Technologie und der entsprechenden Farbtiefe nunmehr Bilder und Videos erzeugt und wiedergegeben werden, die gestochen scharf, kontrastreich und darüber hinaus auch noch dem natürlichen Vorbild zum Verwechseln ähnlich sehen. Wer sich die Realität in die eigenen vier Wände holen möchte, muss allerdings noch relativ viel Geld ausgeben. Auch wenn die Hersteller massiv auf diese neue Technik setzen, gibt es sie bisher nur in teuren Premiumgeräten.

HDR – Das Geheimnis ist das Licht

Abbildung 328: HDR – Das Geheimnis ist das Licht (Bild: Samsung)

Ultra HD ist schon längst keine Neuigkeit mehr und etabliert sich nach und nach in unseren Wohnzimmern. Nun tauchen neue Schlagwörter auf, die Anwendern einiges Kopfzerbrechen bereiten. Nicht selten werden technische Begriffe wie 4K, HDR und der erweiterte Farbraum in einen Topf geworfen. Fakt ist jedoch, dass jedes dieser technischen Features eine Klasse für sich darstellt. Was bedeutet nun HDR, warum hinkt die Umsetzung und welche Potenziale stecken dahinter?

Modernes Fernsehen hat spätestens seit 2016 nicht mehr ausschließlich etwas mit Masse zu tun, auch wenn über acht Millionen Pixel pro Bild bei Ultra HD natürlich schon großartig sind. Jetzt werden neben der ultrahohen Auflösung ebenjene Pixel qualitativ aufgemotzt. Die einzelnen Bildinformationen können mithilfe der HDR-Technik aufgewertet werden und machen das Videomaterial somit noch brillanter und detailreicher. Insofern sollte man HDR nicht synonym für Ultra HD verwenden, denn es ist weitaus mehr. Mit HDR wird es zukünftig gigantische 1.000 Helligkeitsabstufungen geben, während bei herkömmlichen UHD/4K-Inhalten lediglich 256 Hell-Dunkel-Werte pro RGB-Farbkanal möglich sind (Stand: 2016).

Mit HDR gelingt die Darstellung des gesamten Umfangs an sichtbaren Details – sowohl im Licht als auch im Schatten. Das klingt erst einmal einfach, ist es aber ganz und gar nicht. Wenn Sie beispielsweise ein paar Sekunden in die Sonne schauen, fällt es Ihnen im Anschluss außerordentlich schwer, sich in einem dunklen Keller zu orientieren. Wenn man nun bedenkt, dass die menschliche Wahrnehmung der Technik meilenweit voraus ist, wird deutlich, dass die parallele Aufnahme sowie Darstellung von hellen und dunklen Bereichen eine mannigfaltige Herausforderung für Ingenieure und Kamera- und Display-Hersteller ist. Denn bisher konnte man entweder Details im Hellen darstellen, wobei dann im dunklen Teil des Bildes nichts zu erkennen war. Oder eben umgekehrt: bei detailreichen dunklen Szenen wurde der helle Anteil überbelichtet. Mit HDR wird es zukünftig möglich sein, sowohl dunkle als auch helle Bildanteile so zu produzieren und wiederzugeben, wie wir sie in der Natur wahrnehmen und es sich Produzenten und Regisseure wünschen. Dabei wird zwischen diffusem Weiß und sogenannten Spitzlichtern unterschieden, was eine deutlich bessere Differenzierung in der Tiefe eines Bildes zulässt. Das Ergebnis ist eine Bildwiedergabe, die wesentlich naturgetreuer ist, als es bisher möglich war.

Die vielen Informationen und Werbeversprechen der Hersteller lassen uns glauben, dass HDR bereits im Jahre 2016 quasi dazugehört und gleichzusetzen sei mit 4K oder Ultra HD. Doch letztlich stehen wir hier – ähnlich wie beim erweiterten Farbraum gemäß Rec.2020 - noch ganz am Anfang, wenngleich die technische Entwicklung schneller voranschreitet als noch im letzten Jahrtausend. Während der sogenannte Dynamikumfang – also das Verhältnis von größter und kleinster Leuchtdichte – noch vor einigen Jahren bei mickrigen 100 Nits lag und Videomaterial in ebenjenem Kontrastverhältnis von 100:1 produziert wurde, lagen die Werte bis 2014/2015 bei etwa 400 Nits. Einige UHD-TVs im Jahre 2016 schaffen hingegen die für HDR erforderliche Spitzenhelligkeit von 1.000 Candela pro Quadratmeter (cd/qm) und ein entsprechendes Kontrastverhältnis von 1.000:1 bis stellenweise sogar 10.000:1. Die HDR-Tauglichkeit der Geräte hängt also unmittelbar mit den technischen Voraussetzungen zusammen, die zum einen die erwähnte Spitzenhelligkeit als auch den Schwarzwert betreffen, der im Rahmen der Zertifizierung der UHD-Alliance bei weniger als 0,05 Nits für LED-LCD-Displays beziehungsweise unter 0,0005 Nits für OLED-Bildschirme liegt.

Andererseits ist für diesen riesigen Dynamikumfang (0,05 bis 10.000 Nits) und die entsprechend kontrastreiche Darstellung eines unabdingbar: die erhöhte Quantisierung. Das heißt, die Bildabtastung muss in einem höheren Intervall erfolgen, da weitaus mehr Werte im Signal verarbeitet werden müssen. Um diese für HDR typischen hohen Kontraste und brillante Bildqualität erreichen zu können und störende Helligkeitsschwellen beziehungsweise Helligkeitssprünge (Artefakte) unsichtbar zu halten, reicht die bisherige 8-Bit-Technik mit 256 Helligkeitsstufen nicht mehr aus.

Abbildung 329: www.technicolor.com

Gemäß des neuen Standards (SMPTE ST-2084) werden für HDR mindestens 10 Bits pro Abtastwert vorgeschrieben. Diese Bittiefe entspricht in etwa einer Milliarde Farbtöne, denn letztlich ist das Licht das Geheimnis von Detailgenauigkeit und brillanter Farbdarstellung. Insofern wird in diesem Zusammenhang von der Farbtiefe oder aber Deep Color gesprochen. Mit den neuen Display-Technologien (z.B. OLED, Quantum Dots) wurde die Grundlage geschaffen, die Farbtiefe auf 10 Bit oder gar 12 Bit zu erhöhen und den Dynamikbereich entsprechend auszuweiten. Doch damit noch nicht genug. Ein weiteres entscheidendes Kriterium bei der Umsetzung von HDR ist die Datenverarbeitung nach dem Vorbild des Internets.

Mithilfe des softwaregestützten HDR-Verfahrens wird es zukünftig auch in der Fernsehtechnik möglich sein, mit dem Filmmaterial gezielt Informationen (Metadaten) zu übertragen, die im Display die Helligkeit dynamisch steuern. Somit können automatisch Bildverbesserungen insbesondere bei extremen Hell-Dunkel-Bereichen vorgenommen werden. Einfach ausgedrückt funktioniert HDR ähnlich wie die menschliche Wahrnehmung - speziell wie die Adaption im menschlichen Auge. Ob nun in tiefschwarzer Nacht oder im Licht eines 1000-Watt-Halogenstrahlers: unsere Augen können sich grundsätzlich an schier unzählige Lichtintensitäten anpassen. Differenzen in den Lichtverhältnissen kompensiert die Pupille durch Verengung oder Erweiterung (Hell-Dunkel-Adaption/Pupillenlichtreflex) sowie mit Veränderung in der Sensitivität der Rezeptoren.

Abbildung 330: BUROSCH-Realbild "Winter" zur perfekten Kontrolle nach erfolgter Bildoptimierung mit unseren Referenz-Testbildern

Diese retinale Adaption hat die Natur dafür vorgesehen, dass wir unsere Wahrnehmung an stark unterschiedliche Umgebungshelligkeiten (Leuchtdichten) anpassen können. So schafft es unser Auge, sagenhafte 10.000.000.000.000 (1012) verschiedene Reizstärken zu differenzieren, um somit die Orientierung bei Nacht zu gewährleisten. Auch bei direkter Sonneneinstrahlung können wir beispielsweise Spuren im Schnee erkennen, was auf die einzigartige Wechselwirkung zwischen Auge und Gehirn zurückzuführen ist. Jetzt schafft auch die Technik zumindest ansatzweise, was bisher nur der Natur vorbehalten war. Mit der 4K-Auflösung waren wir schon ziemlich dicht an der Realität, mit HDR wird der Unterschied zwischen einem künstlichen Display und dem Original in der Natur noch geringer.

Was zu Beginn des digitalen TV-Zeitalters noch als technische Herausforderung galt, ist also heute zumindest in einigen Geräten möglich. Erste HDR-taugliche TV-Modelle kamen Ende 2015/Anfang 2016 auf den Markt. Wer besonderen Wert auf extrascharfe Bilder und einzigartige Kontraste legt, der sollte auf die jeweiligen Spezifikationen und Mindestanforderungen achten, die unter anderem von der UHD-Alliance mit ihrem Label „Ultra HD Premium“ festgelegt beziehungsweise zertifiziert werden. Hierzu zählt insbesondere die Spitzenhelligkeit von mindestens 1.000 Nits, welche die Grundvoraussetzung für HDR darstellt. Wer auf Nummer sicher beim Kauf gehen möchte, der sollte sich generell an dem Label der UHD Alliance orientieren, mit dem nicht nur HDR-fähige TV-Geräte, sondern auch Player und sogar Blu-ray-Disks ausgestattet sind. Beachten Sie hierzu das folgende Kapitel „Ultra HD PremiumTM“).

Probleme bei der Kompatibilität

Kaum jemand wird sich an die Umstellung vom Schwarz-Weiß- zum Farb-Fernsehen erinnern. Doch grundsätzlich gab es damals ähnliche Probleme wie heute. Der Grund war und ist die Kompatibilität der verschiedenen Systeme. Gerade im Broadcast- beziehungsweise Fernsehbetrieb sind die Herausforderungen an die Entwickler gigantisch, aber auch für HDR aus der „Konserve“ (Blu-ray-Disc) oder gar im Online-Stream sind im Jahre 2016 noch längst nicht alle Voraussetzungen geschaffen. Das liegt zum einen daran, dass es zumindest für eine absehbare Zeit sowohl SDR- als auch HDR-Angebote geben muss, weil natürlich nicht jeder ab sofort ein HDR-fähiges Gerät zu Hause stehen hat. Wir sind gerade erst dabei, uns von den letzten Röhrenfernseher zu verabschieden und das analoge TV-Signal restlos abzuschalten. Deshalb muss bei der Entwicklung einer Übertragungstechnik insbesondere die Kompatibilität berücksichtigt werden. Ähnlich wie bei der Auflösung (Full HD/Ultra HD) müssen die technischen Standards also geräteunabhängig praktikabel sein, da in den nächsten Jahren SDR und HDR parallel laufen werden.

Insofern wurden und werden verschiedene HDR-Standards entwickelt. Der wohl aktuell meist verbreitete ist HDR-10, welcher überwiegend in den 2016er TV-Modellen vorkommt und auch für 4K-Blu-ray vorgesehen ist. Jedoch verspricht das technisch ausgefeiltere Format „Dolby Vision“ bereits jetzt (Stand: 2016) eine noch bessere Qualität, deshalb wird sich diese Technik in nächster Zeit wohl weiter am Markt durchsetzen. Neben einer dritten Variante von Technicolor & Philips, die vorrangig für Streaming und Blu-ray entwickelt werden soll, tüfteln auch Sendeanstalten (z.B. BBC) an eigenen Verfahren, die sich allerdings mehr mit der Fernsehübertragung befassen. Mehr dazu in den weiteren Kapiteln. Zuvor widmen wir uns einigen technischen Problemen im Allgemeinen.

Probleme zwischen Aufnahme und Wiedergabe

Wie bereits erwähnt, stammt HDR eigentlich aus der digitalen Fotografie beziehungsweise Bildbearbeitung. Um dunkle und helle Szenen gleichzeitig so detailreich wie möglich zu gestalten, behilft man sich hier mit einem kleinen Trick. Dieselbe Szene wird mit unterschiedlichen Belichtungen mehrfach aufgenommen und im Anschluss mithilfe einer passenden Software zusammengesetzt. Damit solche Aufnahmen mit einem großen Dynamikumfang auch kompatibel sind und dementsprechend auf Geräten mit einem geringen Kontrast angezeigt werden können, kommt das sogenannte Tonemapping zum Einsatz, das im nächsten Kapitel noch im Detail erläutert werden soll.

Beim Film wird seit einiger Zeit mit einem sehr großen Szenenkontrastumfang und entsprechenden Kompressionsverfahren („Color Grading“) gearbeitet, weshalb die Dynamik zwischen Hell und Dunkel hier bereits gegeben ist. Hochwertige Kameras können heute (Stand: 2016) im Umfang von bis zu 14 Blendenstufen aufnehmen, denn sie verfügen über präzise Sensoren, die Licht in ein elektrisches Signal umwandeln. Diese Umwandlung von Photonen zu Elektronen bis hin zum Videosignal wird über eine sogenannte Opto-Electronic-Transfer-Funktion (OETF) definiert. Ursprünglich wurde diese Funktion (auch als Gammavorentzerrung bekannt) dazu benutzt, in Röhrenmonitoren die nicht-lineare Electronic-Opto-Transfer-Funktion (EOTF) zu kompensieren. Diese EOTF wurde seinerzeit in der ITU-Empfehlung BT.1886 standardisiert. Da diese Gammavorentzerrung als Potenzfunktion mit dem Exponenten 2,4 dem menschlichen Kontrastempfinden sehr ähnlich ist, wurde sie sowohl in der HDTV-Norm BT.709 (mit 8 Bit oder 10 Bit) als auch in der BT.2020 für UHDTV-Signale (mit 10 Bit oder 12 Bit) beibehalten. Der einzige Unterschied liegt hier also in der Quantisierung.

Abbildung 331: Werbung Dolby Vision

Moderne Kameras verwenden also überwiegend eine logarithmische Kurve (OETF), während Displays auf die herkömmliche Gammavorentzerrung (EOTF) zurückgreifen. Beide Standards arbeiten unabhängig voneinander und sind längst nicht in jedem Gerät gleich. Denn die verschiedenen Hersteller nutzen speziell optimierte log-Funktionen für den jeweiligen Sensor, damit die Kameras mit einem möglichst hohen Szenenkontrastumfang und möglichst geringem Datenvolumen aufnehmen. Die OETF (Aufnahme) ist also variabel und darüber hinaus nicht spezifiziert. Und genau hier liegt das Problem. Denn für eine perfekte Rekonstruktion (also die Umwandlung eines elektrischen Signals in ein optisches Signal) muss auf der Wiedergabeseite (EOTF) bekannt sein, mit welcher Wiedergabekennlinie gearbeitet werden muss. Ist dies nicht bekannt, wird es schwer bis unmöglich, den gesamten Dynamikumfang der Aufnahme bei der Wiedergabe zu erhalten.

So sind heute auch Fernsehkameras sehr wohl in der Lage, mit einem größeren Dynamikumfang aufzuzeichnen. Jedoch wurde dieses Feature bisher vernachlässigt, da es keine geeigneten Verarbeitungsmöglichkeiten in der Produktions- und Sendekette gab. TV-Signale werden live übertragen, eine nachträgliche manuelle Bearbeitung wie beim Film ist also beim Broadcast naturgemäß ausgeschlossen. Für die direkte Übertragung von HDR-Inhalten bedarf es insofern automatischer Verfahren, die eine hersteller- sowie systemunabhängige Signalverarbeitung zulassen und eine qualitativ hochwertige Wiedergabe sowohl in HDR als auch in SDR realisieren. Der simpelste Denkansatz hierfür war und ist die Weiterentwicklung des Tonemappings.

Abbildung 332: Werbung Dolby Vision

Tonemapping

Das Ziel der HDR-Entwicklung ist also nicht nur, die technischen Voraussetzungen für HDR sowohl bei der Aufnahme (Kamera) als auch bei der Wiedergabe (Display/Fernseher) zu schaffen. Die Schwierigkeit liegt in der Kompatibilität zwischen Sender und Empfänger und der Abwärtskompatibiliät der einzelnen Standards (HDR SDR). Insofern bietet sich die sogenannte Hybrid-Log-Gamma-Funktion (HLG) an, die seit 2016 für die Übertragung bereits genutzt wird (vgl. Kapitel „UHD/HDR-Demokanäle“ in diesem Buch). Die HLG-Technologie sorgt dafür, dass der Dynamikumfang abwärtskompatibel komprimiert wird, was allgemeinhin als Tonemapping bekannt ist. Natürlich kann dieses Verfahren aus der Digitalfotografie nicht eins-zu-eins in den Videobereich übernommen werden. Denn anders als bei einzelnen Bildern müssen Filmsequenzen über eine temporale Homogenität und eine Echtzeitfähigkeit verfügen und darüber hinaus gilt es, Artefakte zu vermeiden.

In der Weiterentwicklung des Tonemappings gibt es nunmehr zwei Varianten. Einerseits das globale Tonemapping, bei der auf Basis einer durchschnittlichen und maximalen Leuchtdichte jedes Pixel mit derselben Übertragungskurve gewichtet wird. Der Vorteil liegt in der niedrigen Rechenintensität, der Möglichkeit, das Ursprungssignal zurückzugewinnen (inverses Tonemapping) und der geringen Artefaktebildung.

Wenn es jedoch darum geht, einen möglichst großen Szenenkontrastumfang darzustellen, bietet das lokale Tonemapping bessere Chancen, einen höheren Kontrast zu bewahren. Denn mit einer höheren Datenkompression kann hier auch die Umgebung eines jeden Pixels berücksichtigt werden. Wenn man bedenkt, dass ein UHD/4K-Bild über 8 Millionen Pixel beinhaltet und mit der BT.2020 zukünftig bis zu 120 Bilder pro Sekunde (120 Hz) übertragen werden sollen, kann man sich die unglaubliche Rechenleistung und das entsprechende Datenvolumen zumindest ansatzweise vorstellen. Insofern stellt sich in diesem Zusammenhang die Frage nach der besten Übertragungsmethode, wie also die nötigen Informationen am besten und schnellsten vom Sender zum Empfänger gelangen und welche Codierung/Decodierung sinnvoll ist.

HDR-Übertragungsmethoden

Ähnlich wie bei 2D 3D oder auch SD HD seinerzeit und dem erweiterten Farbraum zukünftig, besteht auch bei HDR die Notwendigkeit, sowohl SDR- als auch HDR-Inhalte gleichzeitig zu übertragen sowie zu codieren. Dafür gibt es derzeit (Stand: 2016) drei verschiedene Varianten.

Einfacher Single-Layer: Hier wird die Szene über einen einzigen Datenstrom transportiert und mithilfe einer Transformationskurve (Hybrid-Log-Gamma-Kurve: HLG) so codiert, dass die Videoinhalte auf jedem handelsüblichen Display (SDR und HDR) wiedergegeben werden können. Metadaten sind hierfür nicht erforderlich, dafür ist der Dynamikumfang begrenzt.

Doppelter Single-Layer: Mit einer Punkt-zu-Punkt-Verbindung wird die Szene in zwei voneinander getrennten Datenströmen übertragen, wobei der eine Stream die SDR-Inhalte und der andere die HDR-Inhalte enthält. Je nach Display-Typ und Videomaterial kann so das jeweils passende Signal abgerufen werden.

Dual-Layer: Auch hier werden zwei unterschiedliche Streams (SDR: Basis-Layer/HDR: Enhancement-Layer) genutzt, die jedoch parallel über nur einen Datenstrom übertragen werden. Die zusätzlich mitgelieferten Metadaten sorgen dann dafür, dass beide Signale im jeweiligen Endgerät entsprechend getrennt beziehungsweise einzeln abgerufen werden können.

Abbildung 333: HDR-Übertragungsmethoden

Metadaten

Ein großer Schritt in Richtung Kompatibilität setzen Metadaten, die dem Datenstrom hinzugefügt werden. Wesentliche Grundvoraussetzung ist hier natürlich ein einheitlicher Standard, sodass diese auch auf allen gängigen Signalübertragungswegen (z.B. SDI, IPTV, OTT) Verwendung finden können. Eine besondere Herausforderung ist auch hier die Übertragung in Echtzeit, wie beim Broadcast/Fernsehen, da die Informationen synchron und verlustfrei weitergegeben werden und die Verzögerung bei der Signalverarbeitung so gering wie möglich sein müssen. Insofern wird heute von den Entwicklern für Fernsehübertragungen der einfache Single-Layer-Betrieb präferiert. Bei Nicht-Echtzeitanwendungen kann sich quasi Zeit gelassen werden und die statischen Metadaten auch noch während der Nachbearbeitung hinzugefügt beziehungsweise abgespeichert werden. Entscheidend sind hier die Informationen über die Erstellung des Videomaterials während des Mastering-Prozesses, um die Wiedergabe möglichst originalgetreu zu realisieren. Damit Aufnahme und Wiedergabe sozusagen dieselbe Sprache sprechen, wurden im SMPT-Standard ST-2086 konkrete Werte für das Mastering-Display festgelegt. Dazu gehören die X/Y-Koordinaten der drei Display-Primärvalenzen sowie des Weißpunkts und darüber hinaus die maximale/minimale Leuchtdichte. Diese werden in den Metadaten beschrieben, damit die Wiedergabe das Mastering nachvollziehen kann. Bei 4K-Blu-ray/HDR ist es möglich, weitere Informationen (Metadaten) hinzuzufügen, die sich im RGB-Kontext auf den maximalen Wert in einer Szene (Maximum Content Light Level: MaxCLL) und den durchschnittlichen Wert (Maximum Frame-Average Light Level: MaxFALL) von Szene zu Szene beziehen.

Diese dynamischen Metadaten dienen vorrangig der Kompatibilität zwischen Mastering-Display und Wiedergabebildschirmen mit geringem Dynamikumfang. Die Basisparameter hierfür sind in der SMPTE ST-2094-1 und ST-2094-2 spezifiziert und umfassen grundsätzlich vier unterschiedliche Anwendungen:

Transformation: Abhängig vom Eingangsbild wird aus dem Ausgangsmaterial ein Bild generiert und kann manuell verändert werden (Tonemapping).

Color-Grading: Hier werden bestimmte Parameter festgelegt, wie und wo (manuell oder automatisch) Helligkeits- und Farbveränderungen vorgenommen werden sollen, welche dann in den Metadaten übertragen werden.

Differenzierung: Aus dem HDR-Inhalt und den zusätzlich gelieferten Metadaten wird ein SDR-Bild gewonnen.

Spezifikation: Auf Basis der maximalen Leuchtdichte von Mastering- und Wiedergabedisplay werden mithilfe von Tonemapping-Algorithmen spezifische Parameter berechnet, um das HDR-Material bei der Wiedergabe möglichst originalgetreu darzustellen.

Abbildung 334: HDR Color Grading (www.technicolor.com)

HDR-Systeme und ihre verschiedenen Ansätze

Während perspektivisch BBC/NNK insbesondere vor dem Hintergrund der Live-Übertragung im Broadcast-Bereich die einfache Single-Layer-Methode nutzen wollen, bevorzugen Dolby, Philips und Technicolor komplexere Methoden. Hierbei stützen sich die Entwicklungsansätze bei Dolby Vision auf die Übertragung der Metadaten im Enhancement-Layer. Technische Basis hierfür ist die sogenannte Preceptual-Quantizer-Kurve (PQ) gemäß SMPTE ST-2084. Beim Mastering des EDR-Materials (Extended Dymanic Range) werden darüber hinaus Metadaten erzeugt, die weitere Informationen zur Darstellung des Bildmaterials enthalten. Natürlich gibt es das alles nicht umsonst. Die Datenrate des Enhancement-Layers steigt proportional zum Umfang der Metadaten und liegt etwa 25 Prozent über der des Basis-Layers. Dolby setzt bei seinem HDR-System „Dolby Vision“ auf die automatische Konvertierung des oben beschriebenen lokalen Verfahrens (Content Mapping Unit: CMU), bei dem aus der HDR-Version das SDR-Material generiert wird. Dazu werden aus dem HDR-Grading die entsprechenden Einstellungen abgeleitet und bei der Reproduktion die nötigen Informationen für das SDR-Grading geliefert.

Philips will für die Übertragung einen Basis-Layer zuzüglich Metadaten nutzen, aus denen die jeweilige Version (SDR/HDR) im Wiedergabegerät reproduziert werden kann. Sollte es nur eine HDR-Version im Original geben, wird das SDR-Bild mithilfe des automatischen Tonemappings inklusive manueller Bildoptimierung erzeugt. Bei Technicolor wird die HDR-Version vorverarbeitet, sodass jedes HDR-Bild quasi aus einem SDR-Bild und den dazugehören Modulations-Metadaten besteht. So kann über das SDR-Signal beispielsweise via HEVC/Main 10 codiert, übertragen und in einem SDR-Display entsprechend wiedergegeben werden. Genau wie bei Philips werden die zusätzlichen dynamischen Metadaten für die Modulation in HDR in sogenannten SEI-Paketen (Supplemental Enhancement Information) an ein entsprechendes Wiedergabegerät weitergeleitet und dort zu einem HDR-Bild reproduziert. Hier kommt ebenfalls die inverse Funktion des Vorverarbeitungsprozesses zum Einsatz. Da sich beide Systeme im Over-The-Top-Content (OTT) sehr ähnlich sind, wurde sich hier darauf geeinigt, gemeinsam ein einheitliches Verfahren zu entwickeln. Technicolor verkündete dies in einer Pressemitteilung vom 4. Januar 2016.

HD+ (Samsung)

Im August 2016 verwirrte die Meldung, dass Samsung mit seinem HDR+ das entsprechende Videomaterial optimieren möchte. Hierbei handelt es sich aber nicht um einen Standard, sondern lediglich um einen Bildmodus (HDR+), der die Helligkeitseinstellungen des jeweiligen Displays umfasst. Wird HDR+ zugeschaltet, erfolgt eine automatische Anpassung unter anderem der Backlight-Einstellung auf die höchste Stufe. Damit können dunkle Bildbereiche an Kontrast gewinnen, insbesondere wenn eine entsprechend hohe Umgebungsbeleuchtung vorhanden ist (Tageslicht). Samsung verspricht ein Online-Update für HDR+ für alle 2016er SUHD-Modelle. Fakt ist aber, dass es sich hier lediglich um eine automatische Bildanpassung handelt und nicht um die in diesem Kapitel beschriebene HDR-Technologie selbst.

HDR-10 vs. Dolby Vision

Das Ziel aller Entwicklungen ist, für möglichst viele herkömmliche und zukünftige Displays mit ganz unterschiedlichen Systemvoraussetzungen (z.B. Spitzenhelligkeit, Schwarzwert) ein optimales Ergebnis zu schaffen, das sowohl SDR als auch HDR beinhaltet. Im Gegensatz zur Auflösung, bei der es lediglich um die Anzahl der Bildpunkte geht, ist HDR weitaus komplexer. Da reicht also kein Update/Upgrade. Wer mit Dolby Vision zukünftig HDR-Inhalte genießen möchte, der muss tatsächlich neu kaufen.

Grundsätzlich unterscheiden sich die einzelnen HDR-Standards im Mastering-Prozess und der Übertragungsform der Metadaten. So liegt beim herkömmlichen HDR-10 die Farbtiefe bei 10-Bit, Dolby Vision arbeitet hingegen mit 12 Bit, also einem weitaus breiterem Helligkeitsumfang, was für höhere Bildqualität sorgt. Zudem können die Bildinhalte hier besser an das Display angepasst werden, da die Helligkeitsinformationen pro Bild übertragen werden und nicht wie bei HDR-10 pro Film. Insofern greifen die ersten TV-Hersteller (z.B. LG, Sony) nach „Dolby Vision“, mit deren Unterstützung die HDR-Umsetzung noch besser gelingen soll. Ob dieser Standard bei Blu-ray-Playern ebenfalls übernommen wird, ist derzeit (Stand: 2016) noch nicht sicher. Gemunkelt wird aber, dass noch in 2016 insbesondere LG und Philips neue UHD-Player auf den Markt bringen wollen, die Dolby Vision mit an Bord haben.

|

HDR-10 |

Dolby Vision |

|

|

Maximale Helligkeit |

1.000 nits (cd/m2) |

10.000 cd/m² |

|

Farbauflösung |

10 Bit |

12 Bit |

|

Bildanpassung |

statisch |

dynamisch |

|

Signalverarbeitung |

Single-Layer |

Dual-Layer |

Kurzum: Die Umsetzung von HDR steckt noch in den Kinderschuhen – genau wie die Systeme zur Umsetzung. So informiert im Sommer 2016 Dolby erstmalig ausführlich zum neuen HDR-Verfahren „Dolby Vision“. Bereits mehrere Fernseher diverser Marken (z.B. TCL, Vizio) unterstützen dieses HDR-System, die technischen Voraussetzungen bieten hingegen derzeit (Stand: 2016) nur einige aktuelle Modelle des Herstellers LG.

Mit der Etablierung von Dolby Vision wird eines unumgänglich sein: neue Geräte. Das liegt jedoch nicht am Marketing oder an den Herstellern, sondern tatsächlich am Aufbau der neuen HDR-fähigen Blu-ray-Disc mit Dolby Vision. Denn diese besteht aus mehreren Schichten. Zum einen aus der BL-Schicht (Basis-Layer) für die allgemeinen Bildinformationen und zum anderen aus der EL-Schicht (Enhancement Layer) für alle Zusatzinformationen/Metadaten. Die neuen Player müssen nun in der Lage sein, beide Schichten (BL + EL) parallel auszulesen. Hinzu kommt auch hier der aktuelle Codec H.265, der Ultra HD und HDR sowieso erst möglich macht. Aufgrund der hohen Datenmengen, die decodiert werden müssen, sind insbesondere bei höheren Bildfrequenzen für Dolby Vision neben der Single Chip-Signalverarbeitung sogar zwei HEVC-Decoder vorgesehen. Dolby Vision erklärt im Sommer 2016, dass hier die Unterstützung von gleich mehreren großen Chip-Produzenten zugesagt wurde, etwa von Mediatek, Realtek oder Sigma.

Für die Verbraucher ist dabei natürlich besonders interessant, inwieweit ein heute (Stand: 2016) gekaufter Blu-ray-Player zukünftig HDR-Videomaterial auf Basis von Dolby Vision wiedergeben soll, wenn dieser aber nur HDR-10 unterstützt. Die gute Nachricht ist: eine „Abwärtskompatibilität“ zu HDR-10 ist dabei nicht ausgeschlossen. Möglich ist, dass 4K-Blu-ray-Discs mit Dolby Vision auch die Metadaten von HDR-10 enthalten, damit Geräte, welche Dolby Vision nicht verarbeiten können, zumindest HDR mit HDR-10 möglich machen.

Videomaterial mit HDR

Wer nach passendem Videomaterial Ausschau hält, das tatsächlich in HDR produziert wurde, muss mit der Lupe suchen. Bei TV-Sendern ist HDR vor allem wegen der mangelnden Kompatibilität in der Signalverarbeitung noch reine Zukunftsmusik – ähnlich wie übrigens auch der erweiterte Farbraum gemäß BT.2020. Deshalb haben momentan ausschließlich die Streamingdienstleister in punkto Bildtiefe und Farbbrillanz die Nase vorn. Sowohl Amazon bietet erste Video-Titel mit einem HDR-Etikett an, aber auch Netflix hält sein Versprechen und produziert zunehmend Filme und Serien sowohl ultrahochauflösend als auch mit höherem Dynamikumfang. Laut Pressemeldung vom 19. April 2016 wird Netflix bis Jahresende UHD-Videomaterial in HDR-Qualität mit einer Länge von insgesamt 250 Stunden zur Verfügung stellen.

Wenn auch schleppend so gibt es mittlerweile doch die ersten Blu-ray-Disks in Ultra HD plus HDR. Natürlich macht das Ganze nur richtig Spaß, wenn Sie die entsprechenden HDR-tauglichen Geräte besitzen. Alles in allem sollten Sie beim BD-Kauf ebenfalls auf das Premium-Zertifikat der UHD-Alliance achten. Ähnlich wie bei 3D gibt es hier mehrere Disks in unterschiedlichen Formaten in einem Cover.

Abbildung 335: Beispiel für Blu-ray-Disc mit UHD-Siegel und HDR

Amazon und Netflix setzen auf Dolby Vision

VOD-Anbieter wie Netflix und Amazon boten bisher ausschließlich HDR in Verbindung mit dem HDR-10-Standard. Doch seit Sommer 2016 hat sich dies geändert. Im Juni desselben Jahres wurde hier die 2. Staffel von „Marco Polo“ die HDR-Variante veröffentlicht, die tatsächlich sowohl HDR-10 als auch Dolby Vision unterstützt.

Bereits 2015 startete Amazon mit seinen Originalserien (z.B. „Mozart in the Jungle“ oder „Red Oaks“) den HDR-Content, jedoch aus Mangel an Möglichkeiten nur mit dem herkömmlichen HDR-10-Standard. In 2016 setzt Amazon hingegen mit seiner 2. Staffel von „Bosch“ ausschließlich auf Dolby Vision. Eine mutige Aktion, denn perfekte HDR-Inhalte können so nur mit Geräten realisiert werden, die Dolby Vision auch tatsächlich unterstützen. Hierzulande sind das im Herbst 2016 lediglich die 4K-OLEDs oder Super-UHD-TVs von LG. HDR-10 wird hingegen von diversen Modellen unterschiedlicher Hersteller unterstützt. Aber zum passenden Equipment gehört bekanntermaßen auch immer das richtige Kabel.

HDR nur mit dem richtigen Kabel

Selbst wenn Ihnen echte HDR-Inhalte zur Verfügung stehen, die Sie nun auf Ihren HDR-tauglichen Fernseher streamen oder über Ihren HDR-tauglichen Blu-ray-Player abspielen möchten, bleibt noch die Frage der richtigen Leitung. Das Datenvolumen von 4K/Ultra HD ist schon gewaltig. Auf Basis der aktuellen Technik (z.B. HEVC/H.265) müssen im Datenstrom auch noch diverse zusätzliche Informationen (Metadaten) an das Display weitergegeben werden. Mit HDMI-Kabeln der älteren Generation kommen Sie hier deshalb nicht weiter. Achten Sie auf den aktuellen HDMI-Standard 2.0a und verwenden Sie nicht zu lange Kabel.

Kurzum: HDR steckt noch längst nicht in jedem TV. HDR ist nicht gleichzusetzen mit 4K/UHD. HDR bleibt vorerst in den meisten Wohnzimmern reine Zukunftsmusik. Hollywood wird auch in nächster Zeit nur sehr spärlich in HDR produzieren. Eine TV-Übertragung in HDR-Qualität ist noch absolute Utopie (Stand: 2016). Lassen Sie sich also nicht verwirren, Rom wurde schließlich auch nicht an einem Tag erbaut.

Ultra HD PremiumTM

Sowohl der durchschnittlich interessierte Anwender als auch die zahlreichen Technikbegeisterten können bei der Vielzahl an Features, technischen Details und diversen Abkürzungen gelegentlich den Überblick verlieren. Licht ins Dunkel bringen hier erfahrungsgemäß die in diesem Buch beschriebenen Spezifikationen und Standards. Bewährt haben sich aber auch Zertifikate, wie etwa das neue Gütesiegel der UHD-Alliance, das Verbrauchern sowohl die lästige Suche als auch den zeitraubenden Vergleich erspart. Doch auch die Film-Studios und VoD-Dienste-Anbieter sind begeistert und nicht zuletzt haben Hersteller mit dem Logo auf ihren Geräten eine ausgezeichnete Möglichkeit, sich von der Konkurrenz abzuheben.

Abbildung 336: Gütesiegel der UHD Alliance "Ultra HD Premium

Noch vor dem offiziellen Start der CES 2016 in Las Vegas präsentierte die UHD Alliance auf einer eigens hierfür veranstalteten Pressekonferenz ihr aktuelles Logo, das zukünftig Garant für die Einhaltung bestimmter Standards und Spezifikationen vor allem im Bereich der ultrahochauflösenden Gerätetechnik sein soll. Mittlerweile werben Panasonic, Sony, Samsung und weitere Hersteller mit dem Gütesiegel "Ultra HD Premium". Insofern kann es gut sein, dass ebenjenes zukünftig nicht mehr ausschließlich dem High-End-Bereich vorbehalten sein wird.

Denn fehlende Spezifikationen und Standards sind letztlich generell ein Problem, das im Übrigen nicht nur die Verbraucher angeht. Vielmehr macht sich die mangelnde Vereinheitlichung vor allem als Lücke zwischen Filmproduktion und Filmwiedergabe bemerkbar. Wenn HDR und Ultra HD eine originalgetreue Darstellung beinhalten sollen, ist der wesentlichste Punkt dabei zu wissen, wie und unter welchen Voraussetzungen ein Film gedreht wurde. Nur so ist es möglich, diesen auch quasi als Original wiederzugeben. Bisher wurden die entsprechenden Informationen auf unterschiedliche Weise kodiert und dekodiert. Allgemeines Chaos herrschte, zumal Hersteller und Produktionsfirmen weltweit nicht auf demselben Stand waren.

Vor diesem Hintergrund schlossen sich alle großen Hersteller, Entwickler und Anbieter innerhalb der Unterhaltungselektronik-Branche zusammen und sorgen zumindest für eine gewisse Vereinheitlichung. Im Rahmen der Zertifizierung werden allgemeine Standards zugrunde gelegt, die sowohl für UHD/HDR-Inhalte als auch für die entsprechende Hardware (TV-Geräte etc.) mit erweitertem Farbraum gelten. UHD-Alliance-Präsident HannoBasse sagte dazu: "Es war bislang nicht klar genug definiert, was gemeint ist, wenn von Ultra-HD, HDR oder erhöhten Farbumfang die Rede ist".

Abbildung 337: Mitglieder der UHD Alliance (Stand: 2016)

Insofern begrüßen vor allem VoD-Dienste-Anbieter (z.B. Netflix oder Amazon) sowie insbesondere auch die Vertreter aller namhaften Filmstudios eine solche Vereinheitlichung der Standards und die damit einhergehende Einführung des UHD-Logos. Denn gerade die Anbieter von entsprechendem Videomaterial benötigen weitgehend übereinstimmende technische Rahmenbedingungen, um weltweit ihre Filme anbieten zu können. Schließlich nützt es nichts, wenn Amazon eine neue Serie dreht oder Warner Bros. eine Blu-ray herausbringt, die dann nur in den USA laufen kann, weil in Europa andere Standards gelten. Deshalb könnte man behaupten, dass mit dem UHD-Gütesiegel nicht nur die Verbraucher auf der sicheren Seite sind, sondern zukünftig in den Genuss kommen, aus einem vielfältigen Angebot zu wählen.

Denn übereinstimmend erklärten sowohl 20th Century Fox, Sony Pictures und Universal Pictures als auch der Sprecher der Hollywood-Studios Warner Bros., bis Ende 2016 sechzig oder gar einhundert Filme in 4K zur Verfügung zu stellen, die dann via Online-Streaming oder aber auf UHD-Blu-ray-Disk angeboten werden. Hierbei soll es sich um neue aber auch „remasterte“ Filmklassiker handeln. Auch im 4K-Gaming-Bereich sehen die Fachleute Potenzial. Die Umsetzung bleibt abzuwarten.

Abbildung 338: Auch Blu-ray-Discs erhalten das Zertifikat „Ultra HD Premium

Auf Basis der ITU-R-Empfehlung BT.2020 legte die UHD Alliance nunmehr diverse Parameter fest, die für die Vergabe des Logos "Ultra HD Premium" erforderlich sind. Diese beziehen sich also insbesondere auf ultrahochauflösende Inhalte (3840 x 2160 Pixel), den erweiterten Farbraum sowie die Farbtiefe. Darüber hinaus spielen eine feinere Differenzierung der Helligkeitswerte sowie die entsprechend leistungsfähige Signalverarbeitung eine wesentliche Rolle, wobei alle am Markt üblichen Display-Technologien (z.B. OLED) berücksichtigt wurden.