10. Digitale Trägermodulation

Bei der „Modulation“ einer hochfrequenten Trägerschwingung mit einem Basisbandsignal besteht prinzipiell kein Unterschied zwischen dem Aufbringen eines analogen Informationssignals oder eines digitalen Datensignals. Beim analogen Signal kann im Allgemeinen von einem zeit- und wertkontinuierlichen Vorgang mit begrenztem Spektrum ausgegangen werden. Dagegen handelt es sich bei dem digitalen Signal um einen zeit- und wertdiskreten Ablauf, womit die Änderung des modulierten Parameters der Trägerschwingung in festen Zeitintervallen und mit vorgegebenen Stufen erfolgt. Der Ausdruck „Modulation“ wird deshalb bei digital modulierenden Signalen durch den Begriff „Tastung“ ersetzt.

10.1 Mögliche Trägertastverfahren

Ähnlich den bekannten analogen Modulationsverfahren wie

• Amplitudenmodulation (AM),

• Frequenzmodulation (FM),

• Phasenmodulation (PM) und

• Quadraturamplitudenmodulation (QAM), als Amplitudenmodulation mit unterdrücktem Träger auf einer Cosinus- und einer Sinus-Trägerkomponente

gibt es die entsprechenden Äquivalente bei den digitalen Modulationsverfahren, wobei man nun von „Tastung“ bzw. genauer ausgedrückt von einer „Umtastung“ des Trägerparameters spricht.

Man kommt so zur

• Amplitudenumtastung,

• Frequenzumtastung,

• Phasenumtastung und

• Quadratur-Amplituden-Phasenumtastung (Quadraturmodulation), als Amplitudenumtastung mit unterdrücktem Träger auf einer Cosinus- und einer Sinus-Trägerkomponente.

Die dazu gehörigen Kurzbezeichnungen fehlen, weil schon sehr bald die englischsprachigen Begriffe, zumindest mit ihren Kurzbezeichnungen, im deutschen Sprachgebrauch übernommen wurden. Deshalb sind die Bezeichnungen üblich.

• Amplitude Shift Keying (ASK),

• Frequency Shift Keying (FSK),

• Phase Shift Keying (PSK) und

• Quadratur Amplitude Phase Shift Keying (QAPSK).

Von Bedeutung beim Digitalen Fernsehen DVB in Europa sind die Verfahren der Phasenumtastung, insbesondere 4-PSK, und die Quadratur-Amplituden-Phasenumtastung mit 16-QAPSK und 64-QAPSK. Eine Amplitudenumtastung findet sich beim US-ATSC-Standard mit 8-ASK und Restseitenbandübertragung (8-VSB, Vestigial Sideband). Außerdem sieht der US-J.83/A/C-Standard bei Kabelübertragung auch 128- und 256-QAPSK vor [51].

10.2 Basisband-Filterung

Das modulierende, digitale Datensignal setzt sich aus einer Folge von „0“- und „1 Bits zusammen. Mehrere Bits können dabei zu einem Symbol zusammengefasst werden. So leiten sich aus zwei aufeinanderfolgenden Bits jeweils 4-wertige Symbole, vier aufeinanderfolgenden Bits jeweils 16-wertige Symbole und sechs aufeinanderfolgenden Bits jeweils 64-stufige Symbole ab. Das Spektrum der binären Datenfolge, wie auch der mehrstufigen Symbolfolgen, reicht theoretisch von der Frequenz Null (Gleichkomponente bei unipolaren Signalen) bis zu Unendlich. Wenn auch die Intensität der Spektralkomponenten im Groben mit einer 1/f-Funktion abklingt, so wird es aus frequenzökonomischen Gründen doch erforderlich sein, eine Begrenzung des Spektrums des Datensignals auf einen für die Auswertbarkeit mindest notwendigen Bereich vorzunehmen.

Das Spektrum eines zufälligen Datensignals erhält man über eine FOURIER-Transformation der Zeitfunktion des Codesignals c(t) in die Frequenzfunktion g(f). Es ist aber auch eine pragmatische Ableitung möglich. Bei dieser Herleitung wird von einem periodischen Rechtecksignal s(t) mit der Periodendauer ![]() und der Impulsdauer

und der Impulsdauer ![]() rausgegangen. An die Stelle der FOURIER-Transformation tritt bei periodischen Signalen die FOURIER-Reihenentwicklung zur Berechnung der Spektralkoeffizienten. Die Amplitude der Spektralkomponenten

rausgegangen. An die Stelle der FOURIER-Transformation tritt bei periodischen Signalen die FOURIER-Reihenentwicklung zur Berechnung der Spektralkoeffizienten. Die Amplitude der Spektralkomponenten ![]() und damit auch die Einhüllende zu den Spektralkomponenten wird durch den Betrag der si(x)-Funktion bestimmt, mit

und damit auch die Einhüllende zu den Spektralkomponenten wird durch den Betrag der si(x)-Funktion bestimmt, mit

si(x) = (sin x)/xund dem Argument ![]() wobei wertmäßig gilt

wobei wertmäßig gilt

Nullstellen im Spektrum treten bei den Frequenzen ![]() auf. An die Stelle der Impulsdauer tritt nun die Bitdauer

auf. An die Stelle der Impulsdauer tritt nun die Bitdauer ![]() .

.

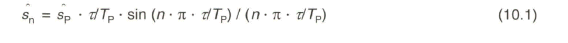

Bild 10.1 a zeigt dazu als Erstes die Zeitfunktion eines periodischen 1-O-Datensignals und einen Ausschnitt des Amplitudenspektrums. Die erste Harmonische aus dem schnellstmöglichen Zustandswechsel, hier also aus einer Periode ![]() wird als NYQUIST-Frequenz fN bezeichnet. Die Nullstellen im Spektrum liegen bei

wird als NYQUIST-Frequenz fN bezeichnet. Die Nullstellen im Spektrum liegen bei ![]()

Nach dem 1. NYQUIST-Theorem muss für die eindeutige Erkennung der Symbolfolge das Spektrum eines Datensignals mindestens bis zur NYQUIST-Frequenz übertragen werden.

Als Nächstes gibt Bild 10.1b die Zeitfunktion und das Spektrum einer periodischen 1-0-0-0-0-Bitfolge wieder. Die Periodendauer beträgt nun ![]() und die erste Harmonische aus dieser Periode, die NYQUIST-Frequenz fN, liegt bei einer Frequenz f = 1/5 - TBit. Die Nullstellen im Spektrum bleiben aber weiter bei

und die erste Harmonische aus dieser Periode, die NYQUIST-Frequenz fN, liegt bei einer Frequenz f = 1/5 - TBit. Die Nullstellen im Spektrum bleiben aber weiter bei ![]() .

.

Schließlich wird in Bild 10.1c eine fortlaufend zufällige Bitfolge aus einem NRZ-Datensignal angenommen. Man könnte durch Variieren des Tastverhältnisses von periodischen Bitfolgen demonstrieren, dass letztendlich beim Übergang zu einer unendlichen Periodendauer ein kontinuierliches Spektrum mit den im Abstand gegen Null aufeinanderfolgenden Spektrallinien auftritt. Die Einhüllende zu den Spektralkomponenten bleibt weiterhin die Betrag-si(x)-Funktion mit Nullstellen bei fN = n ■ 1/TBit. Die NYQUIST-Frequenz des Datensignals liegt bei fN = 1/2 -TBit. Eine NYQUIST-Bandbreite BN erstreckt sich von f=0 bis fN.

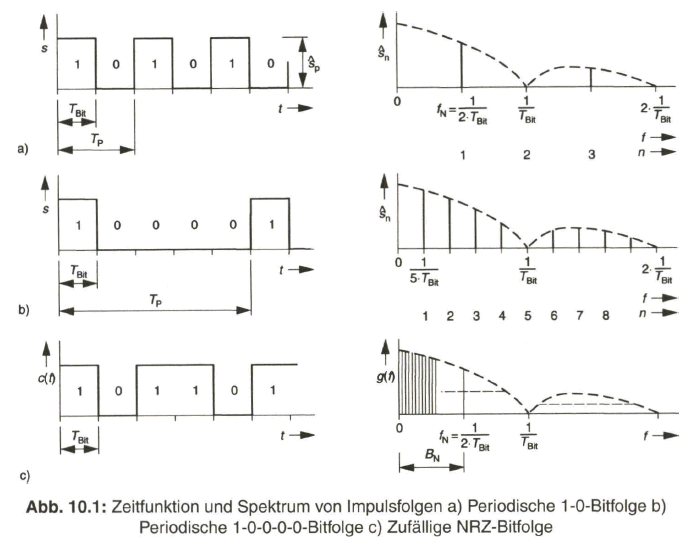

Das Spektrum des Datensignals ändert sich nicht, außer dem Wegfall der Gleichspannungskomponente, wenn an Stelle des unipolaren NRZ-Signals ein bipolares NRZ-Signal angenommen wird. Nach dem 1. NYQUIST-Theorem kann eine Begrenzung des Spektrums auf die NYQUIST-Bandbreite vorgenommen werden. Die Bandbegrenzung hat aber eine Signalverzerrung in der Zeitfunktion zur Folge, wie in Bild 10.2 an einer simulierten Bitfolge zu erkennen ist. Trotzdem kann aus dem verzerrten Datensignal durch Abtasten der Momentanwerte jeweils in der Bitmitte eine eindeutige Schwellenentscheidung getroffen werden. Auf Grund der nicht mehr voll ausnutzbaren Amplitude wird bei Überlagerung eines Störsignals aber nun eher mit Bitfehlern zu rechnen sein.

Eine sehr anschauliche Darstellung zur Auswertbarkeit des verzerrten Datensignals liefert das Augendiagramm. Man erhält dieses durch laufendes Übereinanderschreiben des Signalverlaufs während der Bitdauer ![]() mittels Oszilloskop. Das Oszilloskop wird dabei vom Bit-Takt getriggert. In Bild 10.2 ist das aus der simulierten Bitfolge abgeleitete Augendiagramm wiedergegeben. Man erkennt eine vertikale Augenöffnung sAuge und eine horizontale Augenöffnung

mittels Oszilloskop. Das Oszilloskop wird dabei vom Bit-Takt getriggert. In Bild 10.2 ist das aus der simulierten Bitfolge abgeleitete Augendiagramm wiedergegeben. Man erkennt eine vertikale Augenöffnung sAuge und eine horizontale Augenöffnung ![]() . Je näher die relative vertikale Augenöffnung

. Je näher die relative vertikale Augenöffnung ![]() gegen eins geht, umso eindeutiger wird die Schwellenentscheidung. Aber auch die horizontale Augenöffnung TAuge sollte möglichst groß sein, d. h. an

gegen eins geht, umso eindeutiger wird die Schwellenentscheidung. Aber auch die horizontale Augenöffnung TAuge sollte möglichst groß sein, d. h. an ![]() herankommen, um eine Sicherheit gegen Schwankungen beim Abtast-Takt zu gewährleisten.

herankommen, um eine Sicherheit gegen Schwankungen beim Abtast-Takt zu gewährleisten.

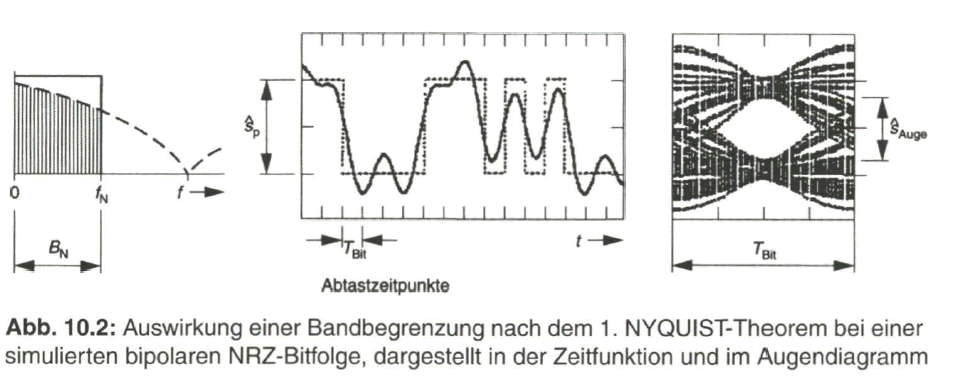

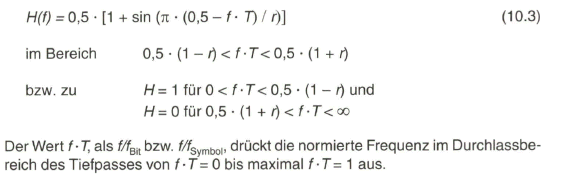

Nach der 1. NYQUIST-Bedingung kann das Spektrum des Datensignals „hart“, d. h. steil abfallend, auf den Bereich bis zur NYQUIST-Frequenz begrenzt werden. Eine starke Impulsverzerrung ist die Folge. Gemäß dem 2. NYQUIST-Theorem kann die Begrenzung des Spektrums aber auch flach erfolgen, wenn der Übertragungsfaktor H, d.h. der Betrag aus der Übertragungsfunktion ![]() , symmetrisch zu dem 50%-Wert bei der NYQUIST-Frequenz abfällt. Nachdem eine Übertragungsfunktion mit Knickstellen im Verlauf nicht möglich ist, führt das zu einem kontinuierlichen Übergang und man spricht von dem Roll-Off-Filter. Ein typischer und vielfach zur Anwendung kommender Verlauf des Übertragungsfaktors ist cosinus- bzw. cosinusquadratförmig, je nach Bezug auf das Argument der Funktion. Der Bereich des „Abrollens“, mit

, symmetrisch zu dem 50%-Wert bei der NYQUIST-Frequenz abfällt. Nachdem eine Übertragungsfunktion mit Knickstellen im Verlauf nicht möglich ist, führt das zu einem kontinuierlichen Übergang und man spricht von dem Roll-Off-Filter. Ein typischer und vielfach zur Anwendung kommender Verlauf des Übertragungsfaktors ist cosinus- bzw. cosinusquadratförmig, je nach Bezug auf das Argument der Funktion. Der Bereich des „Abrollens“, mit ![]() unterhalb und

unterhalb und ![]() oberhalb der NYQUIST-Frequenz fN wird über den Roll-Off-Faktor r mit

oberhalb der NYQUIST-Frequenz fN wird über den Roll-Off-Faktor r mit

![]()

angegeben.

Der Roll-Off-Faktor r liegt zwischen dem Wert Null (harte Bandbegrenzung) und eins (flacher Übergang). Der Übertragungsfaktor H(f) berechnet sich bei cosinusquadratförmigem Roll-Off mit dem Parameter ![]()

Wegen der vom Wert Null aus um den Betrag 0,5 „angehobenen“ Cosinus-Funktion spricht man im Englischen vom Raised-Cosine-Filterverlauf.

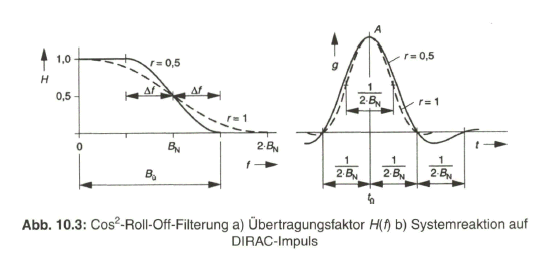

Bild 10.3 gibt den Verlauf des Übertragungsfaktors H(f) bei cos2-Roll-Off mit r-0,5 und r= 1 sowie die Systemreaktion g (f) bei Anregung dieses Tiefpassfilters durch einen DIRAC-Impuls, mit konstanter spektraler Leistungsdichte bis ![]() , wieder. Das Überschwingen würde bei harter Bandbegrenzung (r= 0) maximal 22 % betragen, es geht bei vollkommen flachem Übergang (r - 1) auf etwa 1,5 % zurück.

, wieder. Das Überschwingen würde bei harter Bandbegrenzung (r= 0) maximal 22 % betragen, es geht bei vollkommen flachem Übergang (r - 1) auf etwa 1,5 % zurück.

Die notwendige Übertragungsbandbreite ![]() für das begrenzte Spektrum ergibt sich zu

für das begrenzte Spektrum ergibt sich zu

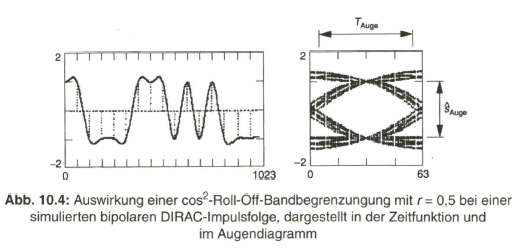

Die Auswirkung der cos2-Roll-Off-Filterung auf den zeitlichen Verlauf der simulierten Bitfolge bzw. auf das daraus abgeleitete Augendiagramm gibt Bild 10.4 bei einem Roll-Off-Faktor von r= 0,5 wieder. Dabei wird von einer bipolaren DIRAC-Impulsfolge ausgegangen, die durch Abtasten des bipolaren NRZ-Signals (siehe Bild 10.2) gewonnen wird.

Im Augendiagramm ist zu erkennen, dass die vertikale Augenöffnung nun optimal ist, was auf die DIRAC-Impulsfolge zurückzuführen ist. Die horizontale Augenöffnung ist umso größer, je mehr der Wert des Roll-Off-Faktors an r=1 kommt.

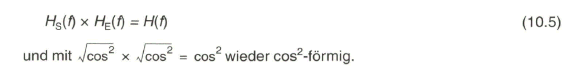

Die Roll-Off-Filterung bezieht sich auf den gesamten Übertragungskanal vom Eingang des Modulators auf der Sendeseite bis zum Ausgang des Demodulators auf der Empfangsseite. Nachdem sowohl auf der Sendeseite eine Tiefpass-Filterung zur Begrenzung des Spektrums am Ausgang des Modulators, als auch auf der Empfangsseite nach dem Demodulator ein Tiefpass zur Unterdrückung von unerwünschten Demodulationsprodukten und vor allem von Rauschen notwendig ist, bietet es sich an, die cos2-Übertragungsfunktion aufzuteilen in

• einen Tiefpass mit Wurzel-co2-Übertragungsfunktion ![]() vor dem Modulator und

vor dem Modulator und

• einen Tiefpass mit Wurzel-cos2-Übertragungsfunktion ![]() nach dem Demodulator.

nach dem Demodulator.

Die für das System gültige resultierende Übertragungsfunktion ist dann

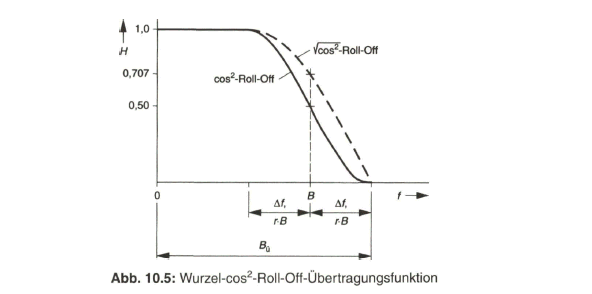

Bild 10.5 zeigt dazu den Verlauf der ![]() -Roll-Off- und der Wurzel-

-Roll-Off- und der Wurzel-![]() -Roll-Off- Funktion bei einem Roll-Off-Faktor von r= 0,35. Dieser Wert liegt im Satellitenkanal vor [46].

-Roll-Off- Funktion bei einem Roll-Off-Faktor von r= 0,35. Dieser Wert liegt im Satellitenkanal vor [46].

10.3 Phasenumtastung und Quadratur-Amplituden-Phasenumtastung

Im Folgenden werden die wichtigsten Verfahren der Phasenumtastung und der Quadratur-Amplituden-Phasenumtastung näher beschrieben mit der Aufbereitung und Demodulation des Modulationsprodukts sowie dem Bandbreitebedarf und der Empfindlichkeit gegenüber Rauschstörungen.

10.3.1 2-Phasenumtastung (2-PSK, BPSK)

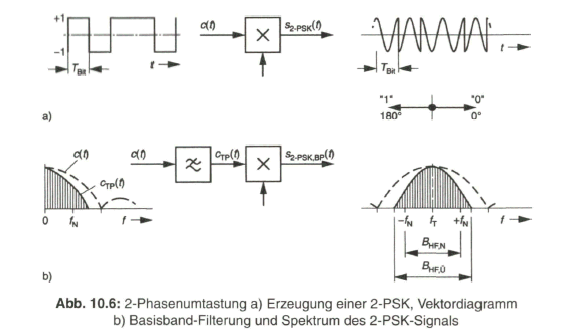

Die 2-Phasenumtastung, engl. Binary Phase Shift Keying (BPSK), hat zwar keine direkte Bedeutung beim digitalen Fernsehen, sie bildet aber die Grundlage für die weiteren höhenwertigen Trägertastverfahren. Zur Erzeugung des Modulationsprodukts wird mittels eines Multiplizierers die Phase der Trägerschwingung, bezogen auf einen Ausgangswert 0°, von dem bipolaren Datensignal c(t) so eingestellt, dass z. B. bei Anliegen einer „0“ die Phasenlage 0° ![]() beibehalten wird und bei Anliegen einer „1“ die Phasenlage um 180° gedreht wird

beibehalten wird und bei Anliegen einer „1“ die Phasenlage um 180° gedreht wird ![]() . Man spricht in diesem Fall von Absolutphasencodierung. Bild 10.6a zeigt dies zusammen mit dem Vektor- oder Zeigerdiagramm.

. Man spricht in diesem Fall von Absolutphasencodierung. Bild 10.6a zeigt dies zusammen mit dem Vektor- oder Zeigerdiagramm.

Das Spektrum des Datensignals c(f) bzw. des über einen Roll-Off-Tiefpass begrenzten Spektrums wird durch die Multiplikation mit der Trägerschwingung aus der Frequenzlage um Null - im mathematischen Sinn mit positiven und negativen Frequenzen - in die Frequenzlage um die Trägerfrequenz fT umgesetzt (Bild 10.6b).

Die notwendige Übertragungsbandbreite im Trägerfrequenzbereich kann nun durch die mindest notwendige NYQUIST-Bandbreite ![]() bzw. mit der tatsächlich notwendigen Bandbreite

bzw. mit der tatsächlich notwendigen Bandbreite ![]() unter Bezugnahme auf die Bitfolgefrequenz

unter Bezugnahme auf die Bitfolgefrequenz ![]()

angegeben werden.

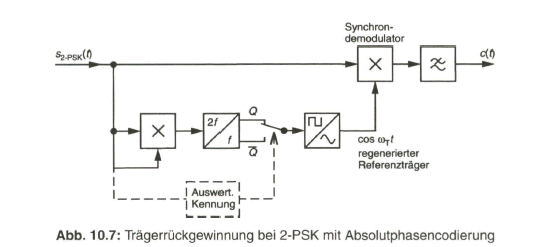

Die Trägerkomponente selbst ist unterdrückt, wenn davon ausgegangen werden kann, dass das Datensignal c(t) gleichspannungsfrei ist, d. h. im Mittel gleich viele „T‘- und „0“-Bits auftreten. Zur Rückgewinnung des übertragenen Datensignals auf der Empfängerseite ist eine Synchrondemodulation erforderlich. Das Modulationsprodukt ![]() muss dazu mit der Trägerschwingung mit dem ursprünglichen Phasenwinkel 0° multipliziert werden, die aber nicht übertragen wird. Es ist eine Trägerrückgewinnung notwendig. Dazu wird das Modulationsprodukt

muss dazu mit der Trägerschwingung mit dem ursprünglichen Phasenwinkel 0° multipliziert werden, die aber nicht übertragen wird. Es ist eine Trägerrückgewinnung notwendig. Dazu wird das Modulationsprodukt ![]() das als + cos

das als + cos ![]() oder - cos

oder - cos  erscheint, quadriert, d. h. mit sich selbst multipliziert. Man erhält eine durchlaufende Schwingung mit der 2-fachen Trägerfrequenz. Über eine Frequenzteilung 2:1 gewinnt man eine Rechteckschwingung mit der Trägerfrequenz

erscheint, quadriert, d. h. mit sich selbst multipliziert. Man erhält eine durchlaufende Schwingung mit der 2-fachen Trägerfrequenz. Über eine Frequenzteilung 2:1 gewinnt man eine Rechteckschwingung mit der Trägerfrequenz ![]() , allerdings mit einer nicht eindeutigen Phasenlage. Je nach Abgriff am I- oder Q-Ausgang des Untersetzers liegt die Phasenlage 0° oder 180° vor. Zur Synchrondemodulation ist aber die frequenz- und phasenrichtige Trägerschwingung erforderlich, um das Original-Datensignal zu erhalten. Bei falscher Referenzphase würde das übertragene Datensignal invertiert erscheinen. Bei der Absolutphasencodierung wird deshalb zusätzlich ein „Kennungssignal“ übertragen, das nach dem Frequenzteiler die korrekte Trägerphase einstellt (Bild 10.7).

, allerdings mit einer nicht eindeutigen Phasenlage. Je nach Abgriff am I- oder Q-Ausgang des Untersetzers liegt die Phasenlage 0° oder 180° vor. Zur Synchrondemodulation ist aber die frequenz- und phasenrichtige Trägerschwingung erforderlich, um das Original-Datensignal zu erhalten. Bei falscher Referenzphase würde das übertragene Datensignal invertiert erscheinen. Bei der Absolutphasencodierung wird deshalb zusätzlich ein „Kennungssignal“ übertragen, das nach dem Frequenzteiler die korrekte Trägerphase einstellt (Bild 10.7).

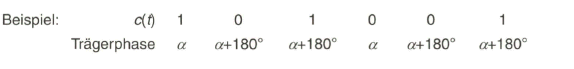

Bei der 2-Phasenumtastung wird die Absolutphasencodierung kaum angewandt. Vielmehr bietet sich über die Phasendifferenzcodierung die Möglichkeit, von der Absolutphase des Referenzträgers bei der Synchrondemodulation unabhängig zu sein. Das Datensignal c(f) wird dabei in einem Phasensummenrechner so aufbereitet, dass z. B. bei Vorliegen einer „1“ die momentane Phase der Trägerschwingung beibehalten wird und beim Auftreten einer „0“ ein Phasensprung um 180° erfolgt. Übertragen wird das phasendifferenzcodierte Signal ![]() in dem Modulationsprodukt der 2-DPSK oder Differential Binary Phase Shift Keying (DBPSK).

in dem Modulationsprodukt der 2-DPSK oder Differential Binary Phase Shift Keying (DBPSK).

Zur Synchrondemodulation kann nun der regenerierte Referenzträger mit 0° oder 180° Phase zugeführt werden. Das demodulierte Signal ![]() , nicht invertiert oder invertiert, wird einem Phasendifferenzrechner zugeführt, an dessen Ausgang das ursprüngliche Datensignal c(t) anliegt (Bild 10.8).

, nicht invertiert oder invertiert, wird einem Phasendifferenzrechner zugeführt, an dessen Ausgang das ursprüngliche Datensignal c(t) anliegt (Bild 10.8).

10.3.2 4-Phasenumtastung (4-PSK, QPSK)

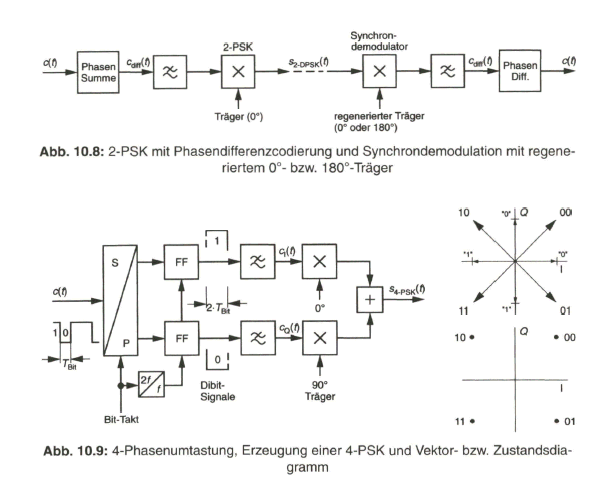

Durch Zusammenfassen von jeweils zwei aufeinanderfolgenden Bits gewinnt man 4-wertige Signalelemente, Symbole, deren vier mögliche Zustände in vier Phasenzustände der Trägerschwingung umgesetzt werden. Man erhält diese durch eine vektorielle Addition der Modulationsprodukte einer 2-PSK mit 0°-Phase der zugeführten Trägerschwingung und einer 2-PSK mit 90°-Phase der zugeführten Trägerschwingung. Dazu wird das binäre NRZ-Datensignal über eine Serien-Parallel-Wandlung in zwei parallele Dibit-Signale mit einer Schrittdauer von jeweils 2 ![]() aufgeteilt. Die Dibit-Signale werden nach Roll-Off-Tiefpass-Filterung als modulierende

aufgeteilt. Die Dibit-Signale werden nach Roll-Off-Tiefpass-Filterung als modulierende ![]() und

und ![]() Signale an die beiden 2-PSK-Modulatoren angelegt. Im Vektordiagramm werden den vier möglichen Phasenlagen bei der 4-PSK bzw. Quaternary Phase Shift Keying (QPSK) jeweils 2-Bit-Kombinationen zugeordnet. Vielfach gibt man, insbesondere bei höherwertigen Trägertastverfahren, nur noch die Vektorendpunkte in dem Zustandsdiagramm oder constellation diagram an. Siehe dazu Bild 10.9.

Signale an die beiden 2-PSK-Modulatoren angelegt. Im Vektordiagramm werden den vier möglichen Phasenlagen bei der 4-PSK bzw. Quaternary Phase Shift Keying (QPSK) jeweils 2-Bit-Kombinationen zugeordnet. Vielfach gibt man, insbesondere bei höherwertigen Trägertastverfahren, nur noch die Vektorendpunkte in dem Zustandsdiagramm oder constellation diagram an. Siehe dazu Bild 10.9.

Das Spektrum des 4-PSK-Modulationsprodukts belegt nun wegen der gegenüber 2-PSK doppelten Schrittdauer nur noch den halben Frequenzbereich. Die für die Datenübertragung erforderliche Bandbreite ist

Zur Rückgewinnung des übertragenen Datensignals c(t) ist wieder Synchrondemodulation mit einem 0°- und einem 90°-Referenzträger notwendig. Die Trägerrückgewinnung erfordert nun ein zweimaliges Quadrieren des Modulationsprodukts, um die 90°-Phasensprünge zu beseitigen, und eine Frequenzteilung von 4:1. Dabei tritt erneut das Problem der Mehrdeutigkeit der Phase des Referenzträgers, hier mit n= 90°-Schritten, auf. Aus den demodulierten Dibit-Signalen wird über eine Parallel-Serien-Wandlung das übertragene Datensignal c(t) zurückgewonnen.

Bei der Trägerrückgewinnung und Synchrondemodulation kommt vielfach die so genannte COSTAS-Schleife zum Einsatz [51]. Die Vierdeutigkeit der Phase des zurückgewonnenen Referenzträgers kann wiederum über eine Phasendifferenzcodierung oder durch Übertragung einer Phasenkennung umgangen werden. Mit der Phasendifferenzcodierung ist eine etwas größere Störanfälligkeit gegenüber Rauschen im Vergleich zur Absolutphasencodierung verbunden, weil zwei zusammengehörige Bits gestört werden. Auf gleiche Bitfehlerhäufigkeit bezogen ist bei Phasendifferenzcodierung ein um etwa 0,5 dB höherer Signal-zu-Rausch-Abstand am Demodulator notwendig. Bei der Übertragung des MPEG-2-Transportstroms im Satellitenkanal durch 4-Phasenumtastung bietet sich an, das zu Beginn eines jeden Transportstrompakets übertragene SYNC-Byte mit bekanntem Bitmuster als Kennsignal zur Phaseneinstellung bei der Synchrondemodulation zu verwenden, womit die Absolutphasencodierung angewendet werden kann. Die zur Einstellung der richtigen Referenzträgerphase notwendigen Maßnahmen werden in [2] genauer beschrieben.

10.3.3 Quadratur-Amplituden-Phasenumtastung (QAPSK)

Die benötigte Übertragungsbandbreite kann durch Verlängern der Schrittdauer der übertragenen Daten-Symbole weiter reduziert werden. Mit dem Zusammenfassen von vier aufeinanderfolgenden Bits erhält man 16-wertige Symbole, sechs aufeinanderfolgende Bits liefern 64-wertige Symbole. Das Umsetzen der höherwertigen Symbole nur auf entsprechende Phasenzustände ist aus Gründen des Störeinflusses ab 16 Zuständen nicht mehr sinnvoll. Die n-wertigen Symbole, mit n= 16,32,64,128, 256,..., werden deshalb in Kombinationen von verschiedenen Amplituden- und Phasenzuständen umgesetzt. Beim europäischen DVB-System sind von Bedeutung.

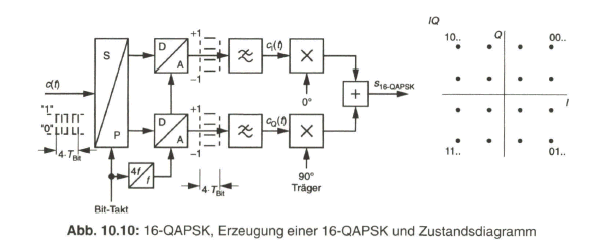

Die Erzeugung des Modulationsprodukts erfolgt wieder über eine Phasenumtastung und nun zusätzlich über die Amplitudenumtastung einer 0°-Trägerkomponente (In-Phase) und einer 90°-Trägerkomponente (Quadratur-Phase), weshalb insbesondere hier, aber auch schon bei der 4-PSK oder QPSK, von I-Q-Modulation gesprochen wird. Bei der 16-QAPSK werden sowohl auf der 0°-Trägerachse als auch auf der 90°-Trägerachse jeweils vier Trägerzustände erzeugt, bei der 64-QAPSK sind dies jeweils acht Trägerzustände. Im Fall der 16-QAPSK werden dazu aus einer 4-Bit-Kombination durch eine Serien-Parallel-Wandlung das 1. und 3. Bit bzw. das 2. und 4. Bit jeweils zu einer 2-Bit-Kombination zusammengefasst. Über einen Digital-Analog-Wandler gewinnt man 4-stufige Signale mit der Schrittdauer ![]() . Die Codesignale

. Die Codesignale ![]() werden den Multiplizierern über bandbegrenzende Tiefpass-Filter zugeführt. Aus der vektoriellen Addition der Ausgangssignale der Multiplizierer ergibt sich das resultierende Modulationsprodukt mit den 16 möglichen Vektorzuständen, deren Endpunkte im Zustandsdiagramm markiert sind (Bild 10.10).

werden den Multiplizierern über bandbegrenzende Tiefpass-Filter zugeführt. Aus der vektoriellen Addition der Ausgangssignale der Multiplizierer ergibt sich das resultierende Modulationsprodukt mit den 16 möglichen Vektorzuständen, deren Endpunkte im Zustandsdiagramm markiert sind (Bild 10.10).

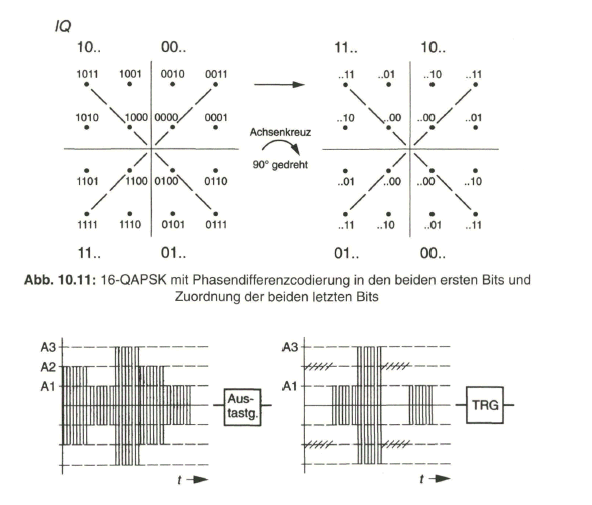

Zu beachten ist, dass die Vektoren in einem Quadranten jeweils mit der Kombination des ersten und des zweiten Bits aus der zusammengefassten 4-Bit-Folge verbunden sind. Dies ist notwendig, weil zum Zweck der Trägerrückgewinnung auf die Quadranten Bezug genommen wird, indem eine Phasendifferenzcodierung in den ersten beiden Bits erfolgt. Die beiden letzten Bits werden so zugeordnet, dass bei einem Drehen des I-Q-Achsenkreuzes um Vielfache von 90°, was bei der Synchrondemodulation mit Phasendifferenzcodierung in den beiden ersten Bits geschehen kann, die Zuordnung der beiden letzten Bits auf die I- und Q-Achse erhalten bleibt [52], Siehe dazu Bild 10.11.

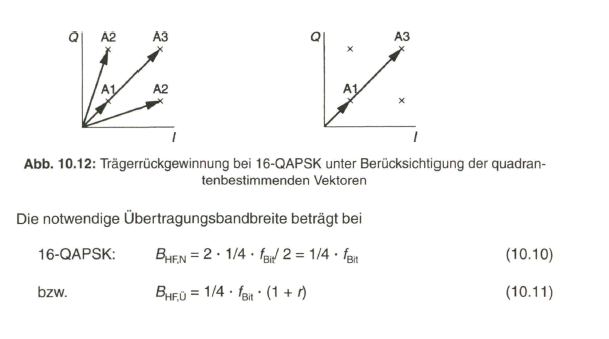

Zur Trägerrückgewinnung können nur die Vektoren herangezogen werden, die entsprechend einer 4-PSK als Winkelhalbierende in den Quadranten vorliegen. Um diese Vektoren zu selektieren, wird in der Zeitfunktion des 16-QAPSK-Signals eine Ausblendung der Trägerzustände vorgenommen, die mit den von n ■ 45° mit n= 1,3, 5 und 7 abweichenden Winkeln verbunden sind. Dies geschieht über die unterschiedlichen Amplituden, wie in Bild 10.12 gezeigt wird.

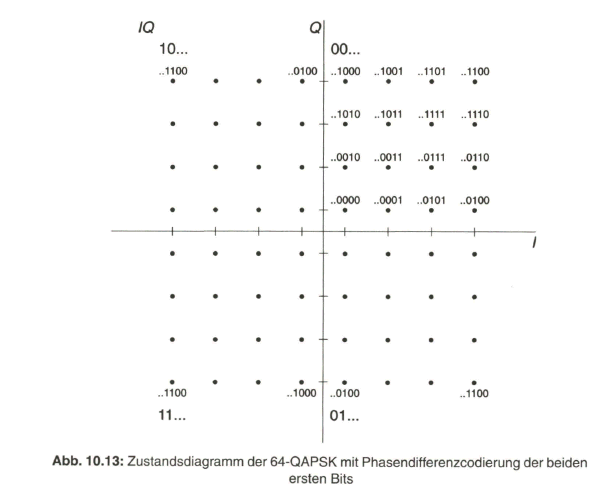

Zur Erzeugung einer 64-QAPSK werden jeweils 6 aufeinanderfolgende Bits zu einem Symbol zusammengefasst, das 64 Wertigkeiten aufweisen kann, mit Abbildung über 8 Zustände auf der 0°-(l-)Achse und über 8 Zustände auf der 90°-(Q-) Achse (Bild 10.13). Die Signalverarbeitung ist ähnlich wie bei der 16-QAPSK, nun mit Zuordnung von jeweils 3 Bits auf den I- und den Q-Zweig, was zu 8-stufigen Signalen führt. Die beiden ersten Bits aus der 6-Bit-Kombination bestimmen wieder den Quadranten. Sie werden differenzcodiert übertragen. Die Zuordnung der letzten vier Bits erfolgt ähnlich wie bereits bei der 16-QAPSK erläutert, so dass für jede der möglichen vier Phasenlagen der Referenzträgerschwingung die Trägerzustände auf der I- und Q-Achse richtig demoduliert werden.

Zur Trägerrückgewinnung wird das 64-QAPSK-Signal zweimal quadriert. Damit tritt das Spektrum um die vierfache Trägerfrequenz auf, mit einer dominierenden Komponente bei der Frequenz ![]() . Diese wird über einen Bandpass ausgefiltert und zur Synchronisation in einen frequenz- und phasenselektiven Regelkreis (PLL) eingeführt. Dessen Oszillator (VCO) liefert die frequenz- und phasenrichtige Referenzträgerschwingung mit der Frequenz

. Diese wird über einen Bandpass ausgefiltert und zur Synchronisation in einen frequenz- und phasenselektiven Regelkreis (PLL) eingeführt. Dessen Oszillator (VCO) liefert die frequenz- und phasenrichtige Referenzträgerschwingung mit der Frequenz ![]() für die Synchrondemodulation [2].

für die Synchrondemodulation [2].

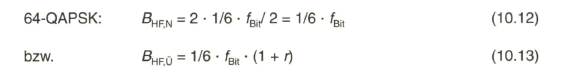

Die notwendige Übertragungsbandbreite reduziert sich nun nochmals gegenüber der 16-QAPSK. Sie beträgt, bezogen auf die Bitfolgefrequenz ![]() , bei

, bei

Zu berücksichtigen ist aber, dass die Störanfälligkeit mit zunehmender Wertigkeit des Modulationsprodukts zunimmt, was noch ausführlicher erläutert wird.

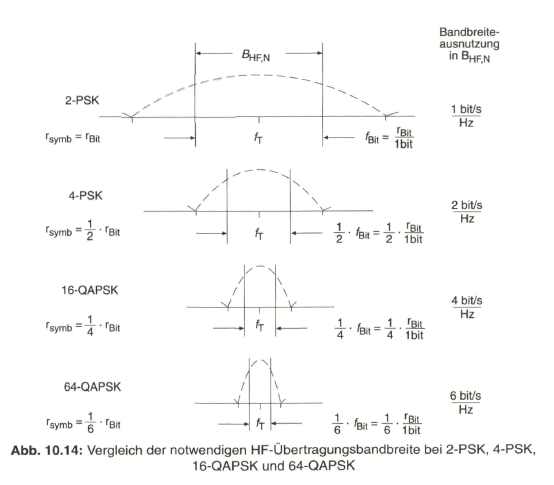

10.3.4 Vergleich der Trägertastverfahren nach Bandbreitebedarf

Durch das Zusammenfassen von jeweils zwei, vier oder sechs Bits zu mehrstufigen Symbolen wird die Schrittgeschwindigkeit des Datensignals entsprechend reduziert. Damit verringert sich die notwendige Übertragungsbandbreite, die einmal im Basisband durch die NYQUIST-Bandbreite ![]() und zum anderen im Trägerfrequenzbereich durch die mindest notwendige HF-Bandbreite

und zum anderen im Trägerfrequenzbereich durch die mindest notwendige HF-Bandbreite ![]() charakterisiert wird. Mit zunehmender Wertigkeit der Symbole rücken die Nullstellen im Spektrum näher zusammen. Für eine vorgegebene zu übertragende Bitrate rBit wird das zwischen den Nullstellen belegte Spektrum schrittweise geringer. Eine Übersichtsdarstellung in Bild 10.14 gibt dies im Vergleich der Spektren von 2- PSK, 4-PSK, 16-QAPSK und 64-QAPSK wieder.

charakterisiert wird. Mit zunehmender Wertigkeit der Symbole rücken die Nullstellen im Spektrum näher zusammen. Für eine vorgegebene zu übertragende Bitrate rBit wird das zwischen den Nullstellen belegte Spektrum schrittweise geringer. Eine Übersichtsdarstellung in Bild 10.14 gibt dies im Vergleich der Spektren von 2- PSK, 4-PSK, 16-QAPSK und 64-QAPSK wieder.

An Stelle der zu übertragenden Bitrate ![]() wird bei mehrstufiger Modulation vielfach die Symbolrate

wird bei mehrstufiger Modulation vielfach die Symbolrate ![]() angegeben, die sich gemäß den Angaben in Bild 10.14 berechnet. Ein weiteres Kriterium ist die Bandbreiteausnutzung in der HF-Bandbreite

angegeben, die sich gemäß den Angaben in Bild 10.14 berechnet. Ein weiteres Kriterium ist die Bandbreiteausnutzung in der HF-Bandbreite ![]() , die auch in Bild 10.14 angegeben ist. Man sieht deutlich, dass dieser Wert zahlenmäßig durch die Anzahl der Bits, die zu einem Symbol zusammengefasst werden, zum Ausdruck kommt. Die Dimension für diesen Wert beträgt bit/s pro Hz Bandbreite.

, die auch in Bild 10.14 angegeben ist. Man sieht deutlich, dass dieser Wert zahlenmäßig durch die Anzahl der Bits, die zu einem Symbol zusammengefasst werden, zum Ausdruck kommt. Die Dimension für diesen Wert beträgt bit/s pro Hz Bandbreite.

10.3.5 Einfluss von Rauschstörungen

Die Auswahl des Modulationsverfahrens wird bestimmt durch die in einem Verteilkanal mit vorgegebener Bandbreite zu übertragende Bitrate und durch den am Demodulatoreingang mindest notwendigen Träger-zu-Rausch-Abstand. Die für Fernsehsignalverteilung zugewiesenen Satellitenkanäle im Mikrowellenbereich weisen Kanalbandbreiten zwischen 25 und 50 MHz auf. Bei der DVB- Satellitenübertragung wird vornehmlich von einer Kanalbandbreite von ![]() = 33 MHz ausgegangen. Es kommen aber auch Transponder mit einer Kanalbandbreite von

= 33 MHz ausgegangen. Es kommen aber auch Transponder mit einer Kanalbandbreite von ![]() = 26 MHz für die Übertragung von digitalen Fernsehsignalen zum Einsatz. In Kabelverteilsystemen und beim terrestrischen Fernsehen erfolgt die Übertragung des DVB-Signals in den UHF-Kanälen mit einer Bandbreite von

= 26 MHz für die Übertragung von digitalen Fernsehsignalen zum Einsatz. In Kabelverteilsystemen und beim terrestrischen Fernsehen erfolgt die Übertragung des DVB-Signals in den UHF-Kanälen mit einer Bandbreite von ![]() = 8 MHz. Beim terrestrischen Fernsehen werden auch die von analoger Übertragung frei geschalteten 7-MHz-Kanäle verwendet.

= 8 MHz. Beim terrestrischen Fernsehen werden auch die von analoger Übertragung frei geschalteten 7-MHz-Kanäle verwendet.

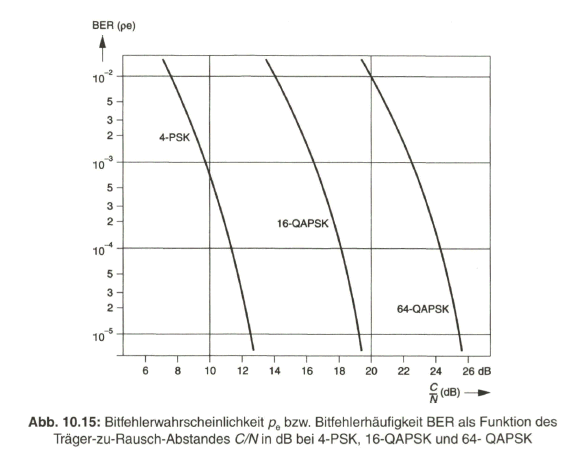

Auf Grund der sendeseitigen Vorgaben, wie Transponderleistung und Antennengewinn beim Satelliten sowie Übertragungsdämpfung bis zur Empfangsantenne und realistischen Empfangsanlagen mit z. B. 60cm Parabolantenne, kann man im Satellitenübertragungskanal am Demodulatoreingang von einem Träger-zu-Rausch-Abstand mit etwa C/N= 10 dB ausgehen. Bei einer Bitfehlerhäufigkeit von BER ![]() (siehe Abschnitt 9.2.4) erfordert diese Situation, dass höchstens die 4-PSK als Modulationsverfahren in Frage kommen kann. Siehe dazu das Diagramm in Bild 10.15 mit den Werten von BER abhängig vom Träger-zu-Rausch-Abstand C/N für die beim digitalen Fernsehen relevanten Trägertastverfahren.

(siehe Abschnitt 9.2.4) erfordert diese Situation, dass höchstens die 4-PSK als Modulationsverfahren in Frage kommen kann. Siehe dazu das Diagramm in Bild 10.15 mit den Werten von BER abhängig vom Träger-zu-Rausch-Abstand C/N für die beim digitalen Fernsehen relevanten Trägertastverfahren.

Beim Kabelverteilsystem kann auf Grund der Planungsvorgaben von einem Träger-zu-Rausch-Abstand am Demodulator von etwa C/N - 30 dB ausgegangen werden. Mit der in diesem Fall geforderten Bitfehlerhäufigkeit von BER ![]() (siehe Abschnitt 9.2.4) kann 64-QAPSK zur Anwendung kommen.

(siehe Abschnitt 9.2.4) kann 64-QAPSK zur Anwendung kommen.

Beim Digitalen Terrestrischen Fernsehen muss neben dem Einfluss von Rauschstörungen noch sehr mit Interferenzstörungen durch Echosignale und Mehrwegeempfang gerechnet werden. Der Einfluss von Rauschstörungen ist damit nicht alleine für die Bitfehlerhäufigkeit verantwortlich.

Das Diagramm in Bild 10.15 gibt eigentlich die zu erwartende theoretische Bitfehlerwahrscheinlichkeit ![]() als Funktion des Träger-zu-Rausch-Abstandes C/N in dB wieder. Die praktisch vorliegende Bitfehlerhäufigkeit BFH oder das „Verhältnis“, Bit Error Ratio BER, von falsch empfangenen zu den insgesamt übertragenen Bits, deckt sich meistens sehr gut mit dem Wert

als Funktion des Träger-zu-Rausch-Abstandes C/N in dB wieder. Die praktisch vorliegende Bitfehlerhäufigkeit BFH oder das „Verhältnis“, Bit Error Ratio BER, von falsch empfangenen zu den insgesamt übertragenen Bits, deckt sich meistens sehr gut mit dem Wert ![]() .

.

Bei dem mit C/N angegebenen Träger-zu-Rausch-Abstand, handelt es sich um eine logarithmierte Größe, die im Gegensatz zu dem linearen Verhältnis der Träger(C)- zu Rausch (N)-Leistung besonders gekennzeichnet werden sollte. Es gilt:

![]()

Im praktischen Gebrauch wird jedoch meist mit dem Begriff C/N der logarithmierte Wert zum Ausdruck gebracht. Vielfach erscheint auch der Begriff ![]() , womit das meist im logarithmischen Maß angegebene Verhältnis von Energie je übertragenes Bit zur Rauschleistungsdichte angegeben wird. Genauso wie der Wert C/N ist auch der Wert

, womit das meist im logarithmischen Maß angegebene Verhältnis von Energie je übertragenes Bit zur Rauschleistungsdichte angegeben wird. Genauso wie der Wert C/N ist auch der Wert ![]() auf den Eingang des Demodulators bezogen.

auf den Eingang des Demodulators bezogen.

Die Energie ![]() je Bit berechnet sich aus der Trägerleistung C multipliziert mit der Bitdauer

je Bit berechnet sich aus der Trägerleistung C multipliziert mit der Bitdauer ![]() .

.

Die Rauschleistungsdichte ![]() gibt die Rauschleistung in einem Frequenzintervall von 1 Hz an. Sie berechnet sich aus der gesamten Rauschleistung N innerhalb des Übertragungskanals mit der Rauschbandbreite

gibt die Rauschleistung in einem Frequenzintervall von 1 Hz an. Sie berechnet sich aus der gesamten Rauschleistung N innerhalb des Übertragungskanals mit der Rauschbandbreite ![]() zu.

zu.

Die Rauschbandbreite oder Leistungsbandbreite erhält man aus der quadrierten, normierten Spannungsübertragungsfunktion ![]() mit dem Maximalwert eins und Umwandlung der Fläche unterhalb

mit dem Maximalwert eins und Umwandlung der Fläche unterhalb ![]() in ein flächengleiches Rechteck mit der Höhe eins und der Breite gleich der Rauschbandbreite Br.

in ein flächengleiches Rechteck mit der Höhe eins und der Breite gleich der Rauschbandbreite Br.

Beim ![]() -Roll-Off-Tiefpass oder entsprechend auch auf den symmetrischen Bandpass übertragen berechnet sich die Rauschbandbreite zu

-Roll-Off-Tiefpass oder entsprechend auch auf den symmetrischen Bandpass übertragen berechnet sich die Rauschbandbreite zu

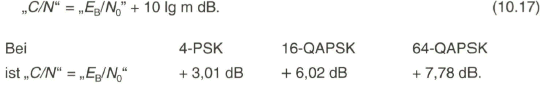

Der Zusammenhang zwischen den logarithmierten Größen

Der Zusammenhang zwischen den logarithmierten Größen

![]()

ergibt sich mit dem Wert von m Bits pro Symbol zu

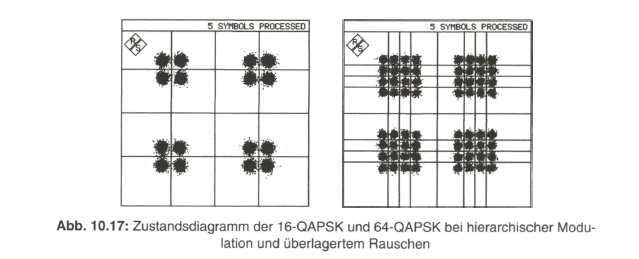

10.3.6 Hierarchische Modulation

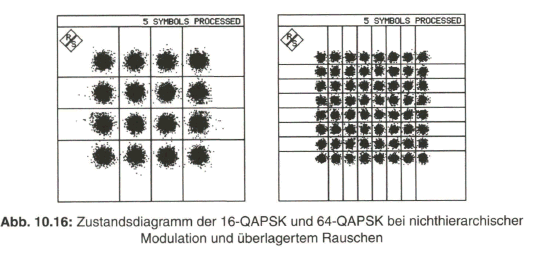

Bei der Überlagerung von Rauschen auf das Modulationsprodukt zeigt sich im Zustandsdiagramm eine „Rauschwolke“ um den eigentlichen Vektorendpunkt. Es ist zu berücksichtigen, dass „Rauschen“ ein statistischer Schwankungsvorgang ist und theoretisch alle Momentanwerte zwischen Null und Unendlich auftreten können. Abgesehen von der praktischen Begrenzung des Spannungsbereiches gilt die GAUSS’sche Wahrscheinlichkeitsverteilung für Momentanwerte des Rauschens, wonach die Wahrscheinlichkeit für höhere Momentanwerte exponentiell absinkt. Maßgeblich für die Rauschstörung ist die Rauschleistung ![]() innerhalb des Übertragungskanals und der daraus abgeleitete Effektivwert der Rauschspannung

innerhalb des Übertragungskanals und der daraus abgeleitete Effektivwert der Rauschspannung ![]() . Das überlagerte Rauschen wird im Zustandsdiagramm im Wesentlichen bis zum Effektivwert sichtbar werden. Bild 10.16 zeigt dazu das Zustandsdiagramm bei 16-QAPSK und 64-QAPSK mit überlagertem Rauschen bei einem Signal-zu-Rausch-Abstand von „C/N“ = 20 dB bzw. 25 dB. Eingetragen sind darin auch die Entscheidungsgrenzen zu den einzelnen Vektorendpunkten [61].

. Das überlagerte Rauschen wird im Zustandsdiagramm im Wesentlichen bis zum Effektivwert sichtbar werden. Bild 10.16 zeigt dazu das Zustandsdiagramm bei 16-QAPSK und 64-QAPSK mit überlagertem Rauschen bei einem Signal-zu-Rausch-Abstand von „C/N“ = 20 dB bzw. 25 dB. Eingetragen sind darin auch die Entscheidungsgrenzen zu den einzelnen Vektorendpunkten [61].

In dem angenommen weißen Rauschen mit der GAUSS'schen Wahrscheinlichkeitsverteilung kommt der Effektivwert UR mit einer Wahrscheinlichkeit von ![]() = 0,24 vor, während für den zweifachen Effektivwert die Wahrscheinlichkeit bei

= 0,24 vor, während für den zweifachen Effektivwert die Wahrscheinlichkeit bei ![]() = 0,06 und die Wahrscheinlichkeit für das Überschreiten des fünffachen Effektivwerts nur noch bei

= 0,06 und die Wahrscheinlichkeit für das Überschreiten des fünffachen Effektivwerts nur noch bei ![]() liegt.

liegt.

Der bei DVB übertragene Transportstrom beinhaltet im Allgemeinen mehrere Programme mit den gleichen Grundparametern (Zeilenzahl, Bildpunktauflösung u. a.). Es wäre aber auch möglich, ein HDTV-Programm zu übertragen mit dem Basis-SDTV-Anteil und zusätzlich einem ergänzenden HDTV-Anteil. Des Weiteren gibt schon MPEG-2 mit den „Skalierbaren Profilen“ die Möglichkeit, einen Datenstrom in Anteile mit unterschiedlicher Priorität aufzuteilen [33, 43].

Die Umsetzung in das Modulationsprodukt erfolgt dann über eine sog. hierarchische Modulation. Dabei werden die Vektorendpunkte auf einen kleineren Bereich im Quadranten zusammengefasst mit dem Ziel, dass bei einer überlagerten Rauschstörung aus den empfangenen Symbolen zumindest der Quadrant (in den ersten beiden Bits codiert) einwandfrei erkannt wird. Damit ist in einer 16-QAPSK ein resistenter 4-PSK-Anteil enthalten. Bild 10.17 gibt dazu das Zustandsdiagramm bei hierarchischer Modulation mit 16-QAPSK und 64-QAPSK wieder, bei einem Träger-zu-Rausch-Abstand von „C/N“ = 26 dB bzw. 28 dB. Eine Kenngröße a charakterisiert den Grad der „unsymmetrischen“ Verteilung der Vektorendpunkte in einem Quadranten. In den Beispielen nach Bild 10.17 ist a = 4 [2].

Mit der hierarchischen Modulation, die eigentlich nur in einem Übertragungskanal mit zeitlich schwankenden Parametern wie beim terrestrischen Fernsehen angebracht ist, könnte die „graceful degradation“auch so ausgenutzt werden, dass ein TV-Programm aus der Grundversorgung in dem „high priority“-Anteil des Datenstroms übertragen wird und ein weiteres Programm in dem ,,low priority“-Anteil. Oder es wird unter Ausnutzung des skalierbaren MPEG-2-Profils ein TV-Programm mit nur bescheidener Bild- und Tonqualität im robusten 4-PSK-Anteil übertragen und in dem verbleibendem Anteil des 16-QAPSK-Datenstroms ein qualitätserhöhender Beitrag zum Video- und Audiosignal.

Die hierarchische Modulation beim digitalen terrestrischen Fernsehen hat bislang nur wenig Beachtung gefunden. Untersuchungen haben jedoch ergeben, dass mit der Übertragung von zwei unabhängigen Multiplex-Transportströmen auf einer Frequenz mit unterschiedlichen Qualitätsansprüchen, d. h. als „high priority”- und „low priority”- Anteil des Gesamtdatenstroms, ein höheres Gesamtversorgungspotential erreicht wird.

Dieses wird definiert entweder über die erreichbare Bevölkerung durch ein

• Datenversorgungsteilnehmerpotential als Produkt der Anzahl der versorgten Bevölkerung und der übertragenen Datenrate

• beziehungsweise durch ein Datenversorgungsflächenpotential als Produkt der versorgten Fläche und der übertragenen Datenrate.

Ausführliche Ergebnisse dazu werden am Beispiel des DVB-T-Senders Alexanderplatz in Berlin dargestellt [79].

10.4 Orthogonal Frequency Division Multiplex (OFDM)

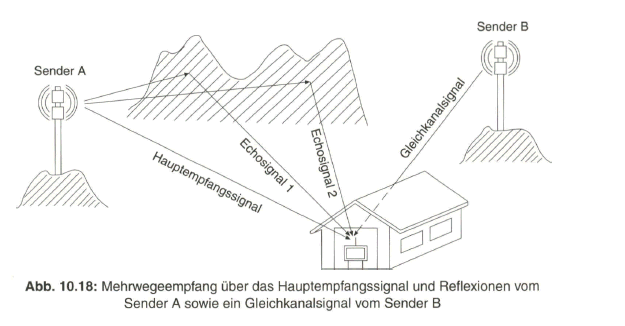

Die bisher beschriebenen digitalen Trägermodulationsverfahren kommen in einem Übertragungskanal zur Anwendung, der ein nahezu optimales Empfangssignal liefert, das von einer Richtantenne aufgenommen oder am Kabelanschluss abgenommen wird, und das nur wenig oder in tragbarem Maß durch Rauschen gestört ist. Man spricht in diesem Fall von einem „GAUSS'schen Kanal“ oder von dem AWGN-Kanal (Additive White GAUSSian Noise). Es trifft für den Satellitenübertragungskanal und im Wesentlichen auch für den Kabelkanal zu. Beim terrestrischen Funkkanal können durch Richtempfangsantennen zwar Echosignale stark unterdrückt und der Träger-zu-Rausch-Abstand beachtlich verbessert werden, aber dies führt u. U. zu sehr umfangreichen Antennengebilden. Mit der Einführung des digitalen terrestrischen Fernsehens sollte deshalb an Stelle der Richtempfangsantenne eine kurze Stabantenne treten, die zudem portablen Empfang auch innerhalb von Gebäuden ermöglicht. Damit aber entfallen die Richtwirkung und das Ausblenden von Echo- oder Mehrwegesignalen. Man hat es nun mit einem so genannten „RICE-Kanal“ zu tun.

Eine weitere Forderung war, digitales terrestrisches Fernsehen in Gleichwellennetzen mit einer Senderkette auszustrahlen, bei der jeder Sender synchron auf der gleichen Sendefrequenz einen zu den anderen Sendern absolut identischen Datenstrom ausstrahlt. Damit unterstützen sich benachbarte Sender in einem gewissen Versorgungsgebiet. Es gibt nun keinen eindeutigen direkten Signalpfad mehr, das heißt es liefern mehrere Empfangssignale einen Beitrag zum Gesamtempfangssignal. Durch Interferenzen können starke Signaleinbrüche bei bestimmten Frequenzen im Empfangsband auftreten, die zudem zeitlichen Schwankungen unterworfen sind.

Bild 10.18 gibt eine mögliche Situation beim Mehrwegeempfang wieder, die insbesondere bei der Benutzung einer einfachen Stabantenne ohne Richtwirkung zu starken Interferenzen im Empfangssignal führen kann. Eine Modellierung dieser Situation repräsentiert der „RALEIGH-Kanal [2].

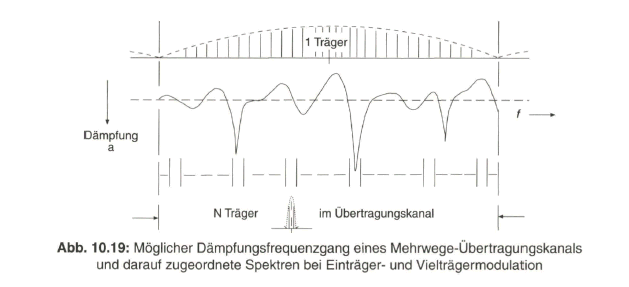

Die Übertragungsfunktion des Mehrwegekanals weist starke Dämpfungs- und Phasenverzerrungen auf, die noch dazu temporären Schwankungen unterworfen sind. Mittels geeigneter, jedoch sehr aufwendiger Entzerrerfilter könnten gegebenenfalls die entstandenen Verzerrungen im Frequenzbereich wieder ausgeglichen werden. Das Spektrum bei Einträgermodulation würde in einem breiten Frequenzbereich durch die stark schwankende Übertragungsfunktion sehr störend beeinflusst werden. An einem Beispiel ist dies in Bild 10.19 an Hand des Dämpfungsfrequenzgangs des Übertragungskanals dargestellt.

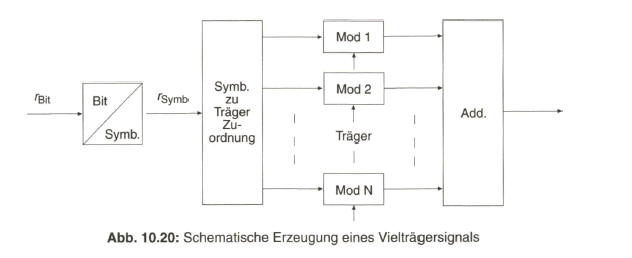

Bei Aufteilung des Datenstroms auf eine Vielzahl von N Trägern mit jeweils nur anteiliger Datenrate verringert sich der Einfluss der schwankenden Übertragungsfunktion innerhalb des Spektrums eines der N Träger. Dies trifft umso mehr zu, je höher die Anzahl N der einzelnen Träger innerhalb des gesamten Übertragungskanals ist. Eine schematische Erzeugung des resultierenden Vielträgersignals, ausgehend vom zu übertragenden Datenstrom mit der Bitrate ![]() beziehungsweise der Symbolrate

beziehungsweise der Symbolrate ![]() und die nachfolgende Zuordnung auf N Träger zeigt Bild 10.20. Die tatsächliche praktische Realisierung der Vielträgermodulation erfolgt jedoch über das Verfahren der Diskreten Inversen FOURIER-Transformation im Software-Bereich, wie im Folgenden noch ausführlich erläutert wird.

und die nachfolgende Zuordnung auf N Träger zeigt Bild 10.20. Die tatsächliche praktische Realisierung der Vielträgermodulation erfolgt jedoch über das Verfahren der Diskreten Inversen FOURIER-Transformation im Software-Bereich, wie im Folgenden noch ausführlich erläutert wird.

10.4.1 Prinzip der OFDM

Eine Anwendung fand die Vielträgermodulation bei der digitalen Tonsignalübertragung mit besonderer Berücksichtigung des mobilen Rundfunkempfangs. Bei dem DAB-System (Digital Audio Broadcasting) ist das OFDM-Verfahren (Orthogonal Frequency Division Multiplex) erstmals zum praktischen Einsatz gekommen. Der zu übertragende Datenstrom mit der Bitrate ![]() bzw. bei mehrstufiger Modulation mit der Symbolrate

bzw. bei mehrstufiger Modulation mit der Symbolrate ![]() wird auf eine Vielzahl von N einzelnen Trägern aufgeteilt, womit auf jedem Einzelträger ein Datenstrom mit

wird auf eine Vielzahl von N einzelnen Trägern aufgeteilt, womit auf jedem Einzelträger ein Datenstrom mit ![]() / N übertragen wird. Selektiv auftretende Einbrüche in der Übertragungsfunktion des Kanals betreffen damit nur einzelne Träger, was durch geeignete Kanalcodierung ausgeglichen werden kann. Man spricht dann von Coded Orthogonal Frequency Division Multiplex (COFDM). Der Frequenzabstand

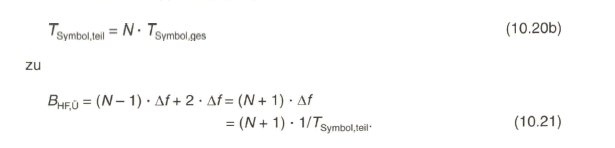

/ N übertragen wird. Selektiv auftretende Einbrüche in der Übertragungsfunktion des Kanals betreffen damit nur einzelne Träger, was durch geeignete Kanalcodierung ausgeglichen werden kann. Man spricht dann von Coded Orthogonal Frequency Division Multiplex (COFDM). Der Frequenzabstand ![]() zwischen den Einzelträgern ergibt sich nach der Orthogonalitätsbeziehung (Gl. 10.18) aus dem reziproken Wert der Symboldauer des Teildatenstromes:

zwischen den Einzelträgern ergibt sich nach der Orthogonalitätsbeziehung (Gl. 10.18) aus dem reziproken Wert der Symboldauer des Teildatenstromes:

Die Symboldauer ist hier maßgeblich, weil jeder Einzelträger in sich nach einem Verfahren der 4-PSK, 16-QAPSK o. a. moduliert wird, selbstverständlich alle Einzelträger zunächst mit dem gleichen Verfahren. Die Symboldauer beträgt bei

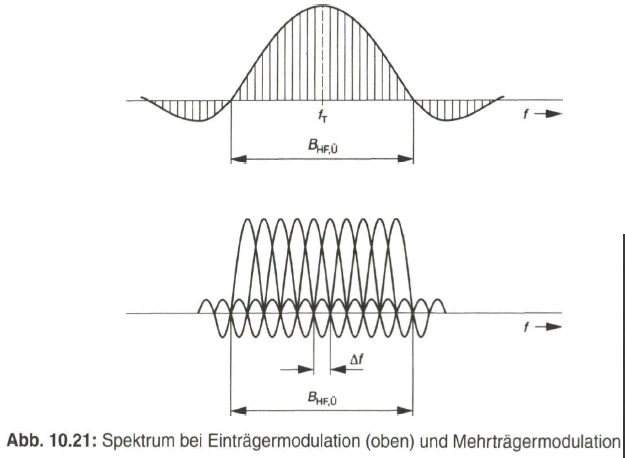

Eine Gegenüberstellung des Spektrums bei der Einträgermodulation und bei der Mehrträgermodulation zeigt Bild 10.21, wobei das Spektrum des oder der modulierten Träger ohne Basisbandbegrenzung und einschließlich der Phasenbeziehung in dem Frequenzbereich über die erste Nullstelle hinaus dargestellt ist.

Unter Zugrundelegung der Orthogonalitätsbeziehung überlappen sich die Teilspektren so, dass Maxima und Nullstellen der benachbarten Spektren aufeinander fallen. Damit kommt keine gegenseitige Störung zustande. Das belegte Frequenzband ![]() zwischen den ersten Nullstellen im Spektrum bei der Einträgermodulation und zwischen den ersten äußersten Nullstellen bei der Mehrträgermodulation ist, mit der Annahme von N» 1, annähernd gleich. Es berechnet sich bei der Einträgermodulation bezogen auf den Gesamtdatenstrom

zwischen den ersten Nullstellen im Spektrum bei der Einträgermodulation und zwischen den ersten äußersten Nullstellen bei der Mehrträgermodulation ist, mit der Annahme von N» 1, annähernd gleich. Es berechnet sich bei der Einträgermodulation bezogen auf den Gesamtdatenstrom ![]() zu.

zu.

(siehe dazu Bild 10.21, unten)

Die Frequenz f der Einzelträger mit der laufenden Ordnungszahl k erhält man, bezogen auf die unterste Frequenz f0, wie folgt:

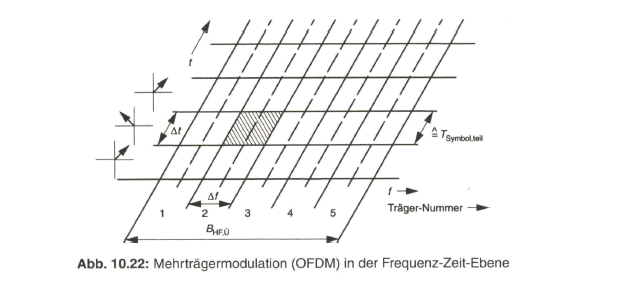

Eine zweidimensionale Darstellung gibt Bild 10.22 ausschnittsweise in der Frequenz-Zeit-Ebene wieder. Die angegebenen Vektoren beziehen sich auf eine 4-PSK der einzelnen Träger, wobei der Vektorzustand über jeweils die Symboldauer ![]() beibehalten wird. Die Schrittgeschwindigkeit oder die Symbolrate der Teildatenströme beträgt nur ein N-tel der Symbolrate des Gesamtdatenstroms, womit auch von jedem Einzelträger nur ein N-tel der Gesamtbandbreite im Spektrum belegt wird.

beibehalten wird. Die Schrittgeschwindigkeit oder die Symbolrate der Teildatenströme beträgt nur ein N-tel der Symbolrate des Gesamtdatenstroms, womit auch von jedem Einzelträger nur ein N-tel der Gesamtbandbreite im Spektrum belegt wird.

10.4.2 Einfügung eines Schutzintervalls

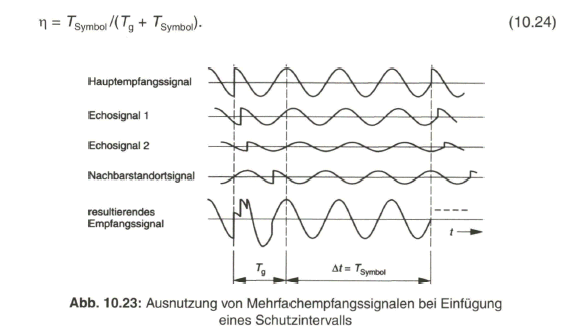

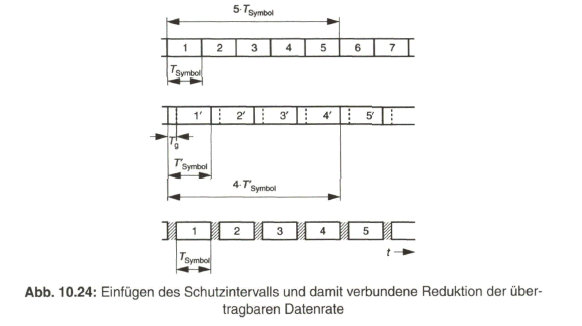

Die Praxis unter realen Empfangsbedingungen ergibt eine Überlagerung der auf Umwegen am Empfangsort eintreffenden Signale mit dem direkt empfangenen Signal mit der Folge, dass die Orthogonalitätsbeziehung gestört und dadurch eine Intersymbolinterferenz mit der Folge von Symbolfehlern verursacht wird. Dieses Problem kann umgangen werden, indem bei der Signalübertragung ein so genanntes Schutzintervall (guard intervall) der Dauer Tg vor der eigentlichen Symboldauer ![]() eingefügt wird, innerhalb dessen die verzögerten Signalanteile beim Empfänger eintreffen. Das Einfügen des Schutzintervalls ist gleichbedeutend mit der Verlängerung der Symboldauer. Die Dauer des übertragenen Symbols erhöht sich damit auf

eingefügt wird, innerhalb dessen die verzögerten Signalanteile beim Empfänger eintreffen. Das Einfügen des Schutzintervalls ist gleichbedeutend mit der Verlängerung der Symboldauer. Die Dauer des übertragenen Symbols erhöht sich damit auf

Auch das Spektrum wird beeinflusst, weil Maxima und Nullstellen nicht mehr genau aufeinander fallen. Dies ist aber mit der weiteren Signalverarbeitung bedeutungslos. Die Auswertung des empfangenen Symbols geschieht erst nach Ablauf der Schutzintervalldauer im Bereich der eigentlichen Symboldauer und dort gilt wieder die Orthogonalitätsbeziehung. Die neben einem Direktempfangssignal einfallenden Echosignale und Nachbarstandortsignale aus einem Gleichwellennetz bilden zusammen ein resultierendes Empfangssignal, das nun durch die Mehrfachsignalanteile sogar noch verstärkt wird. Siehe dazu Bild 10.23 [2]. Die effektiv übertragbare Datenrate wird allerdings durch das zusätzlich eingefügte Schutzintervall reduziert. Man erhält einen Reduktionsfaktor ![]() mit

mit

Die Dauer des Schutzintervalls wird üblicherweise auf die Symboldauer bezogen. Werte von 1/4, 1/8, 1/16 und 1/32 der Symboldauer sind nach dem DVB-T-Standard vorgesehen.

Bild 10.24 erläutert am Beispiel mit ![]() die Reduzierung der effektiv übertragbaren Datenrate auf

die Reduzierung der effektiv übertragbaren Datenrate auf ![]() , mit der Beziehung

, mit der Beziehung

Die Dauer des Schutzintervalls wird durch die mögliche Umweglaufzeit und durch den Abstand zu Nachbarsendern bei Gleichwellennetzen bestimmt. Bei einer auf dem Funkweg zurückgelegten Strecke von 300 m pro Mikrosekunde und einem Abstand des Nachbarsenders von 60 km zu dem nahe des direkt empfangenen Senders angenommenen Empfangsort trifft das Nachbarkanalsignal um 180 ![]() verzögert ein. Bei einer Symboldauer

verzögert ein. Bei einer Symboldauer ![]() von 1 ms (siehe dazu eine Erläuterung und genaue Zahlenangaben im Abschnitt 11.3) erfordert dies ein Schutzintervall von > 180

von 1 ms (siehe dazu eine Erläuterung und genaue Zahlenangaben im Abschnitt 11.3) erfordert dies ein Schutzintervall von > 180 ![]() , d. h. es wird ein Wert Tg

, d. h. es wird ein Wert Tg ![]() .

.

Längere Schutzintervalle sind für Gleichwellennetze mit Sendern höherer Leistung und Abständen über 30 km vorgesehen. Je kleiner der Abstand zwischen den Senderstandorten ist, umso kürzer kann das Schutzintervall ![]() sein. Dies betrifft regionale oder lokale Netzwerke mit Sendern kleiner Leistung. Der Betrieb eines Gleichwellennetzes (Single Frequency Network, SFN) erfordert die zeitsynchrone Abstrahlung der Datensymbole von den verschiedenen Senderstandorten. Die Zuführung des Modulationssignals zu den Gleichwellensendern erfolgt meistens über einen geostationären Satelliten auf der Äquatorposition. An den einzelnen Senderstandorten muss dennoch ein „Feinabgleich“ der Signallaufzeit vorgenommen werden, der die geringfügig unterschiedliche Entfernung der Senderstandorte zum Satelliten berücksichtigt.

sein. Dies betrifft regionale oder lokale Netzwerke mit Sendern kleiner Leistung. Der Betrieb eines Gleichwellennetzes (Single Frequency Network, SFN) erfordert die zeitsynchrone Abstrahlung der Datensymbole von den verschiedenen Senderstandorten. Die Zuführung des Modulationssignals zu den Gleichwellensendern erfolgt meistens über einen geostationären Satelliten auf der Äquatorposition. An den einzelnen Senderstandorten muss dennoch ein „Feinabgleich“ der Signallaufzeit vorgenommen werden, der die geringfügig unterschiedliche Entfernung der Senderstandorte zum Satelliten berücksichtigt.

10.4.3 Technische Realisierung der OFDM

Zur technischen Realisierung der OFDM sind folgende Maßnahmen notwendig:

• Die zyklische Symbolzuordnung der ankommenden Daten auf die N Einzelträger, ein numerischer Vorgang, der mit „Nummern“ für die Trägerfrequenzen dem Frequenzbereich zuzuordnen ist.

• Die Transformation aus dem Frequenzbereich in den Zeitbereich zur Gewinnung des OFDM-Signals.

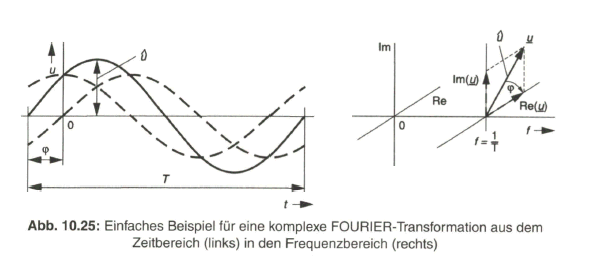

Eine Transformation vom Frequenzbereich in den Zeitbereich wird bei digitaler Signalverarbeitung über die Discrete Inverse FOURIER-Transformation (DIFT) vorgenommen, das heißt mittels des Algorithmus der Discrete Inverse Fast Fourier Transformation (DIFFT). Eine kurze, bildliche Erläuterung der FOURIER-Transformation (FT) sei zunächst vorangestellt. Es wird von einer periodischen Zeitfunktion f(t) ausgegangen, die z. B. als Sinusschwingung mit den Parametern Amplitude u, Periodendauer T und Nullphasenwinkel ![]() angenommen wird (Bild 10.25, links). Nach den Gesetzen der Wechselstromlehre wird im Zeitbereich diese phasenverschobene Sinusschwingung durch die Addition einer Sinus- und einer Cosinuskomponente gebildet (gestrichelt gezeichnet). Im Frequenzbereich (Bild 10.25, rechts) wird die phasenverschobene Sinusschwingung durch eine Cosinuskomponente (Realteil Re) und durch eine Sinuskomponente (Imaginärteil Im) repräsentiert (gestrichelt gezeichnet), bzw. durch den Vektor u(f) bei der Frequenz

angenommen wird (Bild 10.25, links). Nach den Gesetzen der Wechselstromlehre wird im Zeitbereich diese phasenverschobene Sinusschwingung durch die Addition einer Sinus- und einer Cosinuskomponente gebildet (gestrichelt gezeichnet). Im Frequenzbereich (Bild 10.25, rechts) wird die phasenverschobene Sinusschwingung durch eine Cosinuskomponente (Realteil Re) und durch eine Sinuskomponente (Imaginärteil Im) repräsentiert (gestrichelt gezeichnet), bzw. durch den Vektor u(f) bei der Frequenz ![]() mit der Amplitude u und dem auf die Realteil-Achse bezogenen Phasenwinkel

mit der Amplitude u und dem auf die Realteil-Achse bezogenen Phasenwinkel ![]() .

.

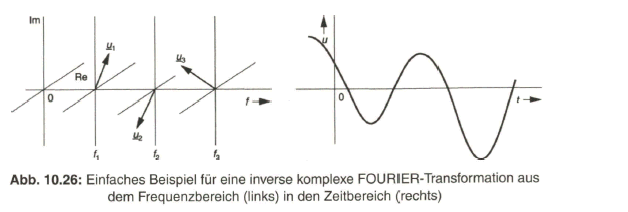

Bei der inversen FOURIER-Transformation (IFT) erfolgt die Umsetzung einer oder mehrerer Spektralkomponenten der Funktion F(f) aus dem Frequenzbereich in den Zeitbereich, wie an einem Beispiel in Bild 10.26 gezeigt wird.

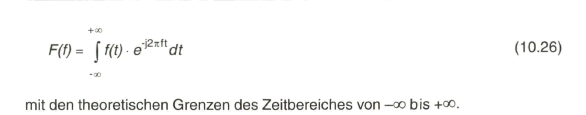

Die FOURIER-Transformation der Funktion f(t) vom Zeitbereich in den Frequenzbereich mit der Funktion F(f) erfolgt nach der mathematischen Beziehung

Für die inverse FOURIER-Transformation der Funktion F(f) aus dem Frequenzbereich in den Zeitbereich mit f(f) gilt

Bei der digitalen Signalverarbeitung bezieht man sich auf diskrete Abtastwerte, die als binäre Codeworte vorliegen. Die Grenzen im Zeitbereich werden jetzt mit endlichen Werten definiert. Über einen bestimmten Bereich mit N Abtastwerten, der wegen der „schnellen“ FOURIER-Transformation (FFT) in Zweierpotenzen festgelegt wird mit z. B. N= ... 1024, 2048 (= 2k), ... , 8192 (= 8k) erfolgt die Berechnung der Funktion nach Gleichung (10.26) bzw. (10.27), wobei die Integration jetzt durch eine Aufsummierung von Teilflächen ersetzt wird.

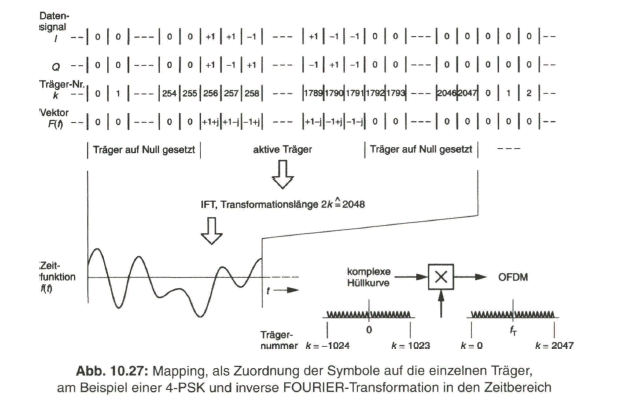

Bei der OFDM ist eine Transformation vom Frequenzbereich in den Zeitbereich vorzunehmen. Es kommt die Discrete Inverse Fast Fourier Transformation (DIFFT) zur Anwendung. Die Zuordnung der Datensymbole auf die einzelnen Träger mit der Nummer /c = 0 bis k = N-1 und Festlegung ihres Vektorzustandes über die Werte von Realteil und Imaginärteil, je nach dem gewählten Modulationsverfahren, bezeichnet man als „Mapping“. Wegen der mit digitaler Signalverarbeitung am Ende des Prozesses notwendigen Digital-Analog-Wandlung und der damit verbundenen Tiefpass-Filterung werden nicht alle bei der Transformation möglichen Einzelträger aktiviert, sondern jeweils im unteren und im oberen Bereich eine bestimmte Anzahl von Träger auf „Null“ gesetzt, d. h. beim Mapping mit Null multipliziert.

Die Zusammenstellung in Bild 10.27 gibt schematisiert den Signalablauf beim Mapping mit angenommener 4-PSK und Ausnutzung von 1536 Trägern aus den bei einer 2k-Transformation möglichen 2048 Trägern wieder und zeigt schließlich das einer komplexen Zeitfunktion (komplexe Hüllkurve) zugeordnete Spektrum des OFDM-Signals im Basisband um die Frequenz Null sowie nach Umsetzung auf eine Trägerfrequenz als „Mittenfrequenz“ des OFDM-Spektrums.

Das in Bild 10.27 zugrunde liegende Beispiel basiert auf den Parametern des DAB-Systems, wo 1536 Träger mit Daten belegt sind. Die aus der 2k-Transformation resultierenden weiteren Träger an den äußeren Grenzen des Basisbandes werden auf Null gesetzt, damit im umgesetzten Trägersignal das Spektrum ohne aufwändige Bandpassfilterung auf die vorgegebene Kanalbandbreite begrenzt wird.

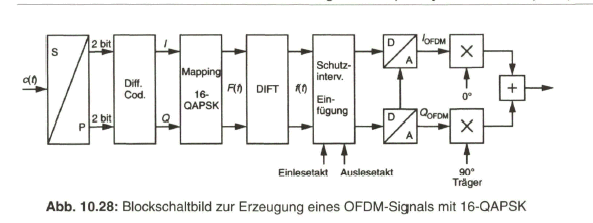

Mit Berücksichtigung eines Schutzintervalls, das über eine Zwischenspeicherung der Realteil- und Imaginärteil-Sequenzen der transformierten Zeitfunktion f(t) und langsameres Auslesen des Speichers entsteht, erhält man das vereinfachte Blockschaltbild zur Erzeugung eines OFDM-Signals, mit hier z. B. 16-QAPSK der Einzelträger, nach Bild 10.28. Auch bei dieser Anwendung der 16-QAPSK erfolgt eine Differenzcodierung der ersten beiden Bits in den Symbolen und für die weiteren Bits eine Zuordnung nach einer GRAY-Mapping-Vorschrift, wie bereits bei 16-QAPSK erläutert wurde.

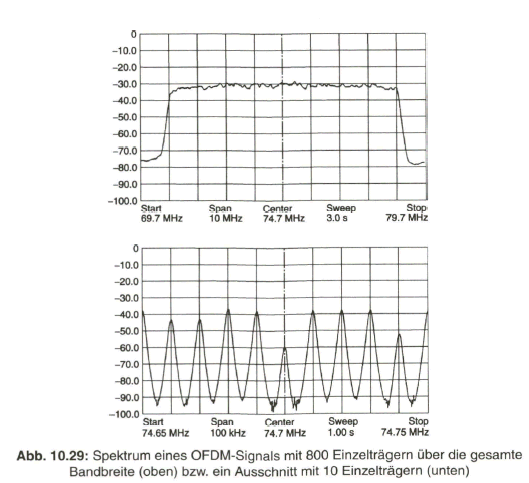

Sowohl die Zeitfunktion als auch das Spektrum eines OFDM-Signals erinnern an ein rauschartiges Signal. Bild 10.29 zeigt dazu das Spektrum eines OFDM-Signals mit 800 Einzelträgern innerhalb eines Frequenzbandes von 8 MHz (oben), d. h. mit einem Trägerabstand von 10 kHz, und eine „Momentanaufnahme“ eines Spektrumausschnitts mit 10 Einzelträgern (unten), bei 64-QAPSK der Einzelträger, aufgenommen mit einem Spektrumanalysator FSEA der Firma Rohde & Schwarz. Der mittlere Träger ist zur „Markierung“ um mehr als 20 dB unterdrückt. Man erkennt, dass der Pegel der Einzelträger je nach der Amplitude des Vektors bis zu 17 dB unterschiedlich sein kann.

Zur Demodulation des OFDM-Signals wird nach Umsetzung des Empfangssignals in den Zwischenfrequenzbereich eine Analog-Digital-Wandlung vorgenommen, aus der zwei Datenströme hervorgehen, die dem I- und Q-Zweig zugeordnet werden. Es folgt eine Discrete Fast Fourier Transformation (DFFT) und entsprechendes De-Mapping zur Rückgewinnung des übertragenen Datenstroms [24].