Fernsehentwicklung bei Grundig

Niemand kann die grosse Geschichte der Firma Grundig besser berichten als ein wirklicher Insider. Konrad Maul war 37 Jahre in der Fernsehentwicklung der Grundig AG und in der Nachfolge in der Grundig Intermedia AG tätig, davon 30 Jahre in leitender Position. Von 1977 bis Anfang der 1980er war er als Teamleiter Vorentwicklung und Digitale Signalverarbeitung auch mit der Entwicklung microprozessorgesteuerter Videospiele betraut. Als Gruppenleiter war er unter anderem für das erste Grundig 100-Hz-Gerät verantwortlich. Als Abteilungsleiter war er später dann für die Digitale Signalverarbeitung und die elektrische Entwicklung Großsignal im Fernsehbereich zuständig. Von 2001 bis 2008 leitete er dann die gesamte Fernsehentwicklung.

Konrad Maul, Fernsehentwicklung bei Grundig

Inhaltsverzeichnis:

1. Der weltweit erste flimmerfreie Fernseher

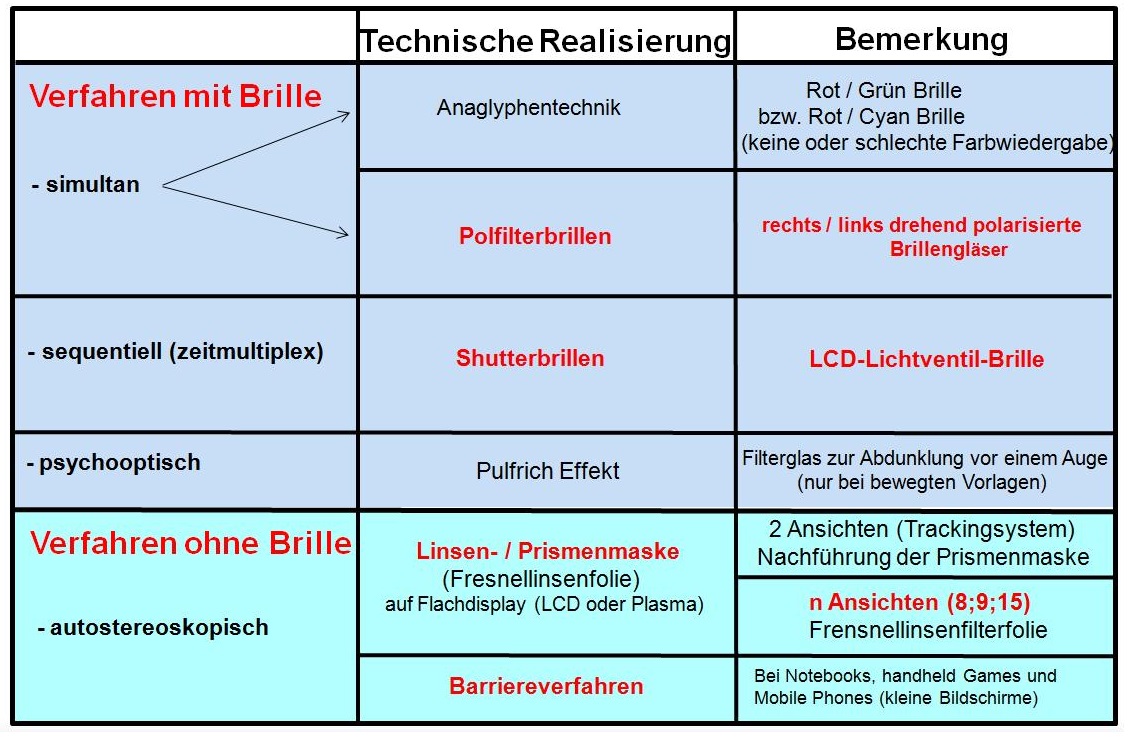

2. Die besten Grundig Farbfernsehserie ("made for you")

3. Wie das Spielen auf den Bildschirm kam

4. Der Weg zur naturgetreuen Bildwiedergabe und die physiologischen Hintergründe

5. Grundig 3D TV Entwicklung 1989-2008

1. Das weltweit erste flimmerfreie TV-Seriengerät

Der Grundig Monolith 70-390/7 Text mit 100 Hz Technik oder wie die digitale Bildsignalverarbeitung in Grundig High-End Fernsehgeräte Einzug hielt.

Die Grundig Fernseher - die Vorreiter der 100 Hz Technik.

1987 präsentierte Grundig mit dem Monolith 70-390/7 Text weltweit das erste 100 Hz TV-Seriengerät. 20 Jahre später setzte Grundig die Erfolgsgeschichte von 100 Hz mit einem der ersten 100 Hz LCD-TV-Geräte, dem Lenaro 37 LXW 94-9710, fort. Das Foto zeigt Konrad Maul auf der IFA 2007 in der Grundig Halle vor diesen ersten 100 Hz LCD-TV-Geräten.

Stand der Digitaltechnik

Die Digitalisierung ist heute Thema in allen Medien und wird auch in der breiten Öffentlichkeit diskutiert. Stillschweigend wird davon ausgegangen, dass dies eine Technik ist, die erst in den beiden letzten Jahrzehnten entwickelt worden wäre. Dem ist aber nicht so. So hatte Harry Nyquist, ein schwedisch-amerikanischer Ingenieur der Elektrotechnik, schon 1927 festgestellt, dass ein analoges Signal (z. B. Sprache, Musik oder Bilder) mit mehr als der doppelten Signalfrequenz abgetastet werden muss um aus dem digitalen Abbild wieder das analoge Ausgangssignal rekonstruieren zu können. D.h., wenn wir vom menschlichen Hörbereich, der bis ca. 20.000 Hz geht, ausgehen, muss man für die Digitalisierung von akustischen Signalen mindestens 40 000 Abtastwerte pro Sekunde entnehmen (bei der Audio-CD verwendet man 44.100 Abtastwerte pro Sekunde).

Nyquist hatte sein Forschungsergebnis 1928 publiziert. Sein Abtasttheorem und seine Erforschung der erforderlichen Bandbreite bildeten eine wichtige Grundlage für Claude Shannons theoretische Arbeiten, die letztlich zur Begründung der Informationstheorie führten. Im Folgenden soll nun gezeigt werden wie die digitale Bildsignalverarbeitung in die Grundig Fernsehgeräte Einzug hielt, denn Mitte der 1980er Jahre machten die Fortschritte in der IC-Technologie es möglich Analog Digital Converter (ADC) zu fertigen, die schnell genug waren um Bildsignale zu digitalisieren und auch preislich für den Einsatz in der Consumer-Elektronik geeignet waren.

Der Halbleiter Hersteller ITT Intermetall (später Micronas) hatte bereits Anfang der 1980er Jahre unter der Marketingbezeichnung Digit2000 einen Satz von Integrierten Schaltkreisen (IC) entwickelt, der die komplette Video- und Audiosignalverarbeitung im Fernsehgerät digital durchführte. Einige Unterhaltungselektronikhersteller setzten dieses Konzept in ihren Geräten ein. Da es aber von der Bild- und Tonqualität einem analogen IC-Konzept unterlegen war und somit für den Kunden keinen verbesserten Nutzen hatte, ging Grundig einen anderen Weg, wie im Folgenden erläutert wird.

Stand der Bildqualität von Fernsehgeräten in den 1980er Jahren

Die in den 1980er Jahren, nach dem PAL-System arbeitenden Fernsehgeräte lieferten eine durchaus gute Bildqualität. Trotzdem waren im damaligen analogen Übertragungssystem (CCIR-Norm B und G; Horizontalablenkfrequenz 15.625 Hz; Vertikalablenkfrequenz 50 Hz; 625 Zeilen im Zeilensprungverfahren) noch bestimmte Störeffekte vorhanden. Seit der Einführung dieses Übertragungssystems waren Bildröhren mit höherer Bildhelligkeit sowie größeren Bildformaten entwickelt worden, die die folgenden vier Effekte nun stärker sichtbar werden ließen:

Großflächenflimmern

Große, helle Bilder oder Bildteile zeigten ein deutliches Flimmern. Die Ursache dafür lag in der zu niedrigen Bildwechselfrequenz. Physiologische Untersuchungen erbrachten, dass Bildwechselfrequenzen von mindestens 70 Hz für eine flimmerfreie Bildwiedergabe erforderlich waren. Dies galt bereits für Bildschirmarbeitsplätze in der EDV-Technik als Richtlinie.

Zwischenzeilenflimmern

Bedingt durch das Zeilensprungverfahren sprangen horizontale oder nahezu horizontale Linien bzw. Kanten des Bildinhaltes (z. B. die Grundlinie bei Tennisübertragungen) im Rhythmus der Vollbildfrequenz also mit 25 Hz. Der Effekt wurde auch mit Kantenflackern oder Zwischenzeilenflimmern bezeichnet.

Cross-Color

Durch Übersprechen des Luminanzsignals in den Color-Verarbeitungsteil des Fernsehgerätes wurden feine Helligkeitswechsel des Luminanzsignals eingefärbt, z.B. deutlich sichtbar wenn der Nachrichtensprecher ein graugestreiftes Jackett trug.

Cross-Luminanz

Durch Übersprechen des Chrominanzsignals in den Luminanzverarbeitungsteil des Fernsehgerätes wurden bei Farbsprüngen Störeffekte sichtbar, z. B. unbunte Störung beim Farbbalkentestbild an den Farbübergängen.

Abb. 1: Der Grundig Monolith 70-390/7 Text, das erste 100 Hz TV-Seriengerät. Der Normwandler-Baustein bestand aus zwei Platinen (im Foto aufgeklappt) mit ca. 100 Integrierten Schaltkreisen. Als Gruppenleiter war der Autor Herr Konrad Maul für dieses 100 Hertz-TV-Gerät verantwortlich.

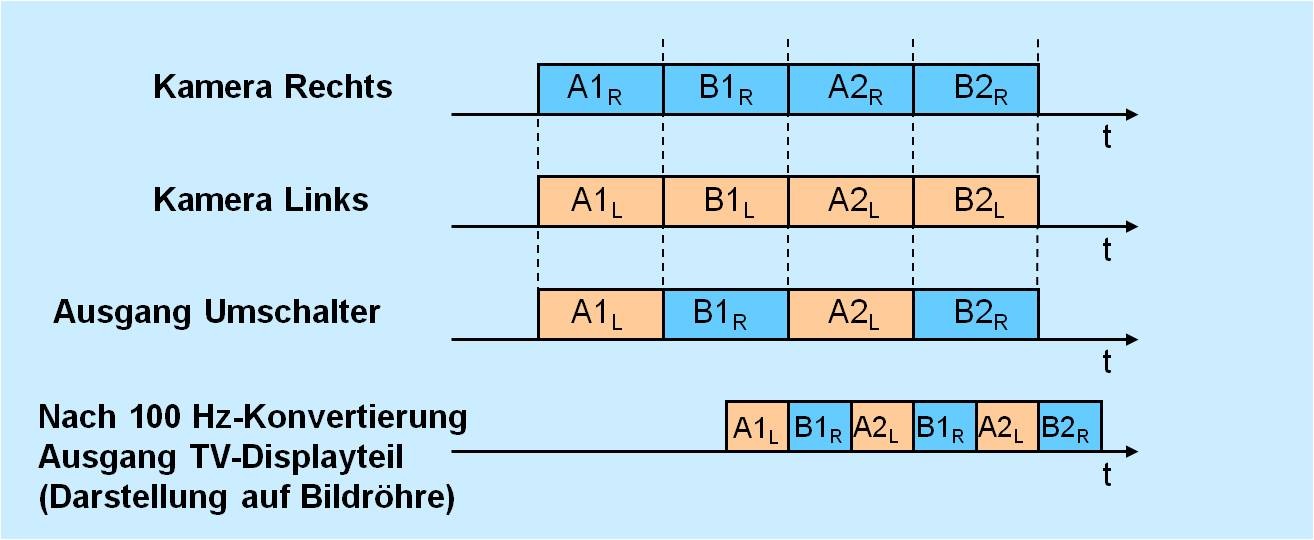

Verdopplung der Bilderzahl pro Sekunde beseitigt Großflächenflimmern

Legte man die damaligen und auch heute noch bei Fernsehgeräten üblichen Betrachtungsabstände von ca. 4- bis 5 facher Bildhöhe zugrunde (bei der damals üblichen 70 cm Bildschirmdiagonale ergab sich dann ein Betrachtungsabstand von ca. 2 bis 3 m) war für die meisten Testpersonen das Großflächenflimmern am störendsten. Da es systembedingt war, das PAL-Übertragungs-Verfahren aber beibehalten werden musste, erschien es am sinnvollsten, im Fernsehempfänger selbst das Großflächenflimmern zu beseitigen. Dies geschah mit digital arbeitenden Bildspeichern. Sie ermöglichten eine Art Normumwandlung im Fernsehgerät. Aus 50 Halbbildern pro Sekunde wurden 100 Halbbilder pro Sekunde erzeugt. Bei 100 Halbbildwechseln in der Sekunde war selbst bei sehr großen Helligkeitswerten kein Großflächenflimmern mehr erkennbar.

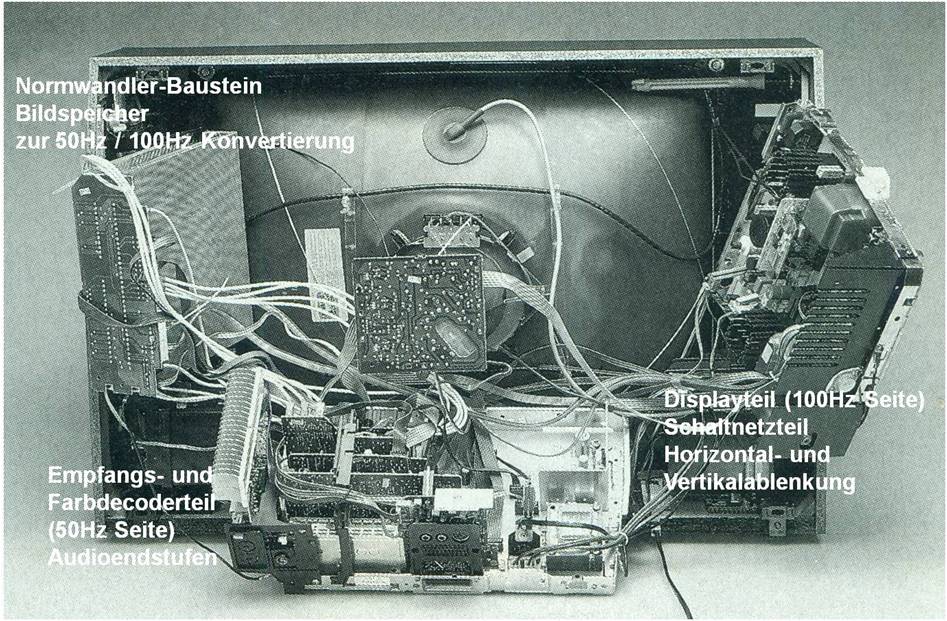

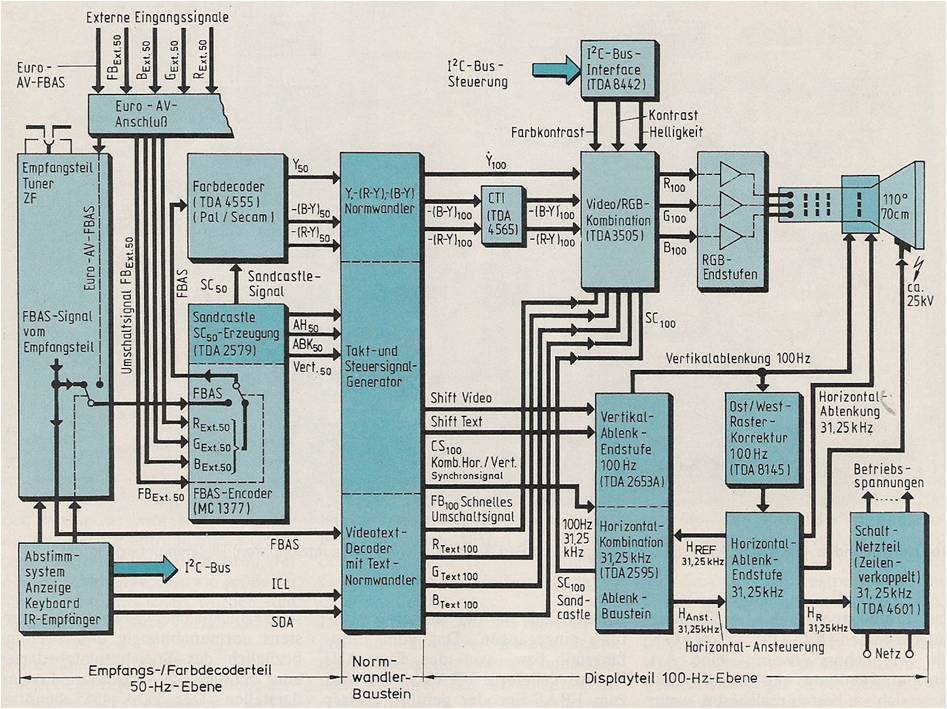

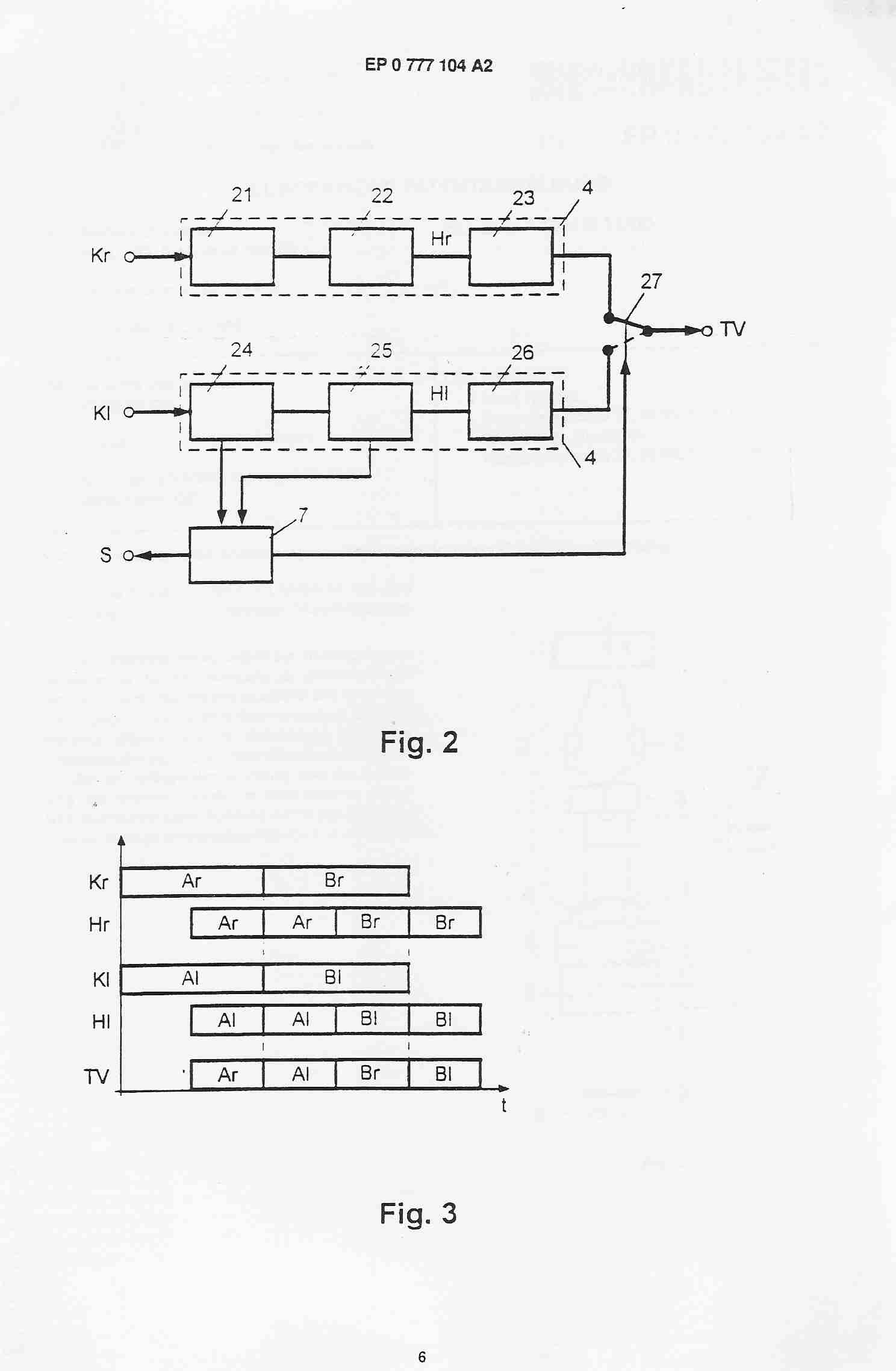

Wurde diese Flimmerreduktion zusammen mit der damals schon verwendeten Farbsignalsprung-VersteilerungsSchaltung (CTI = Colour Transient Improvement) eingesetzt, ergab dies einen außerordentlich guten Bildeindruck. Mit dem Monolith 70-390/7 Text wurde nun erstmals ein großflächenflimmer befreites Fernsehgerät in das Produktspektrum von Grundig aufgenommen (Abb. 1). Da dieses Gerät, wie schon erwähnt eine Art Normumwandlung durchführte, ließ diese sich am besten realisieren, wenn man das Gerät in drei Funktionsbereiche aufgliederte (Abb. 2). Diese drei Teilbereiche waren Empfangs-Farbdecoderteil, Normwandlerbaustein und Displayteil.

Das Empfangs-Farbdecoderteil arbeitete mit 50 Hz Vertikal- und 15.625 Hz Horizontalfrequenz; deshalb wird es hier kurz mit 50-Hz-Ebene bezeichnet. Signale dieser Ebene erhalten im Folgenden den Index 50. Das Displayteil arbeitete mit 100 Hz Vertikal- und 31.250 Hz Horizontalfrequenz; deswegen wird es hier kurz mit 100-Hz-Ebene bezeichnet. Signale dieser Ebene erhalten im Folgenden den Index 100. Im Anschluss werden die Teilbereiche näher beschrieben. Abb. 2 zeigt den mechanischen Aufbau des Monolith 70-390/7 Text und Abb. 3 die Blockschaltung der Video- und Ablenksignal-Verläufe. Auch der Videotext wurde im Monolith 70-390/7 Text auf flimmerfreie 100 Hz Wiedergabe konvertiert. Darauf soll aber hier nicht eingegangen werden.

Abb. 2: Grundig Monolith 70-390/7 Text weltweit das erste flimmerfreie Fernsehgerät. Die Ansicht von hinten zeigt die Funktionsbereiche Empfangs- und Farbdecoderteil, Normwandlerbaustein und Displayteil. Die zwei Chassis und der Normwandlerbaustein sind zur besseren Sichtbarkeit herausgezogen.

Empfangs- und Farbdecoderteil

Das Empfangsteil war im wesentlichen identisch mit dem eines Monolith 70-390/9 mit normaler 50-Hz-Bildwiedergabe. Daher wird hier nur auf die Unterschiede in der Signalverarbeitung eingegangen. Der analoge Farbdecoder arbeitete mit dem TDA 4555 und lieferte das demodulierte Luminanzsignal (Y50) und die demodulierten Farbdifferenzsignale (-(R-Y)50 und -(B-Y)50). Diese Signale wurden als Schnittstelle zum Normwandlerbaustein (Bildspeicher) gewählt, da sie erstens von der Farbfernsehnorm unabhängig waren und zweitens bezüglich des Speicherplatzbedarfes eine ökonomisch vertretbare Lösung darstellten.

Abb. 3: Blockschaltung der Video- und Ablenksignal-Verläufe des Grundig Monolith 70-390/7 Text

Digitaltechnik für den Normwandler

Für die 50/100-Hz-Konvertierung sind damals verschiedene Prinzipien diskutiert worden. Als guter Kompromiss hinsichtlich Leistungsfähigkeit und Aufwand wurde die Halbbildwiederholung gesehen, da keine Anpassung an Bewegungsabläufe erforderlich war. Dabei wurde das vom Sender empfangene Halbbild (20 ms) in einem Halbbildspeicher abgelegt und anschließend mit einer Halbbilddauer von 10 ms zweimal auf dem Bildschirm dargestellt. Um schnellstmöglich ein großflächenflimmerbefreites Gerät fertigen zu können, wurde auf die Verwendung von kundenspezifischen Schaltkreisen verzichtet. Deshalb mussten als Speicher-Schaltkreise digitale CCD-Speicher (317 kBit) verwendet werden, da diese einen wesentlich geringeren Steueraufwand für die mit Standard- Logik-Schaltkreisen (74F..., 74LS...,74HCT...) aufgebaute Speichersteuerung erforderten.

Dieser digitale CCD-Speicher (SAA 9001 von Valvo) besaß eine serielle Struktur. Dies bedeutete bei Verwendung in einem Normumsetzer zur Halbbildverdoppelung, dass zwei Halbbildspeicher benötigt wurden. Der eine wurde mit dem jeweils aktuellen Sender-Halbbild beschrieben, während der andere, der das vorherige Halbbild enthielt, zweimal aus gelesen und sein Inhalt auf dem Bildschirm dargestellt wurde. Dieser Nachteil der seriellen Speicherstruktur des digitalen CCD-Speichers, der bei Großflächenflimmerbefreiung eine Verdoppelung der Speicherkapazität erforderte wurde aber in Kauf genommen um Time to Market für das Grundig 100 Hz-Fernsehgerät möglichst kurz zu halten.

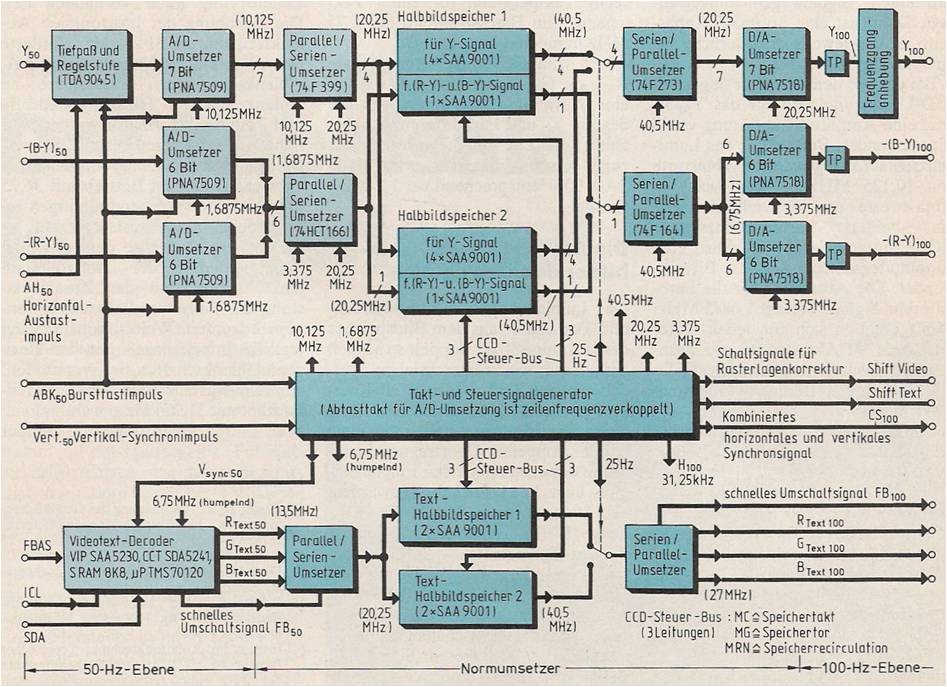

Das Einfügen der CTI-Schaltung nach der D/A-Wandlung ermöglichte, die Abtastrate für die beiden Farbdifferenzsignale drastisch herabzusetzen. Da die farbfernsehnorm unabhängigen Komponenten (Y50), -(R-Y)50 und -(B-Y)50 digitalisiert wurden, war PAL/SECAM-Betrieb möglich. Auf NTSC Wiedergabe wurde bewusst verzichtet, da dies eine aufwendige Speichersteuerungs-Umschaltung erfordert hätte (60 Halbbilder/s). Die Schaltungsauslegung und Funktion des Normwandlers ist aus der Blockschaltung in Abb. 4 zu ersehen.

Abb. 4: Blockschaltung des Normwandlers des Grundig Monolith 70-390/7 Text

Sowohl für die A/D- und die D/A-Umsetzung der Luminanz- und Farbdifferenzsignale als auch für die Speichersteuerung benötigte man geeignete Taktsignale. Wichtig war dabei, dass diese Taktsignale zeilenfrequenzverkoppelt waren, d. h., die Taktsignalfrequenzen mussten ein ganzzahliges Vielfaches der Zeilenfrequenz (fz = 15.625 kHz) sein. Nur dann konnte eindeutig und in einfacher Weise (ohne aufwendige Interpolation) ein im Speicher abgelegter Signalwert auch einem bestimmten Bildpunkt auf dem Bildschirm zugeordnet und Auflösungsverluste vermieden werden. Die den abgetasteten Signalwerten auf dem Bildschirm zugeordneten Bildpunkte lagen dann nämlich in einem festen, orthogonalen (rechtwinkligen) Raster zueinander und die Bildpunkte einzelner Vollbilder fielen genau übereinander. Wie Abb. 4 zeigt, erhielt der Block "Takt- und Steuersignalgenerator" einen Zeilenimpuls ABK50 (Bursttastimpuls), der über eine PLL (Phase Locked Loop) den VCO (Voltage Controlled Oscillator) des Taktgenerators (40,5 MHz) mit der Zeilenfrequenz 15,625 kHz verkoppelte.

Aus diesem 40,5-MHz-Systemtakt wurden dann alle anderen Takt- und Speichersteuerungssignale der Bildnormumsetzung abgeleitet und diese waren damit ebenfalls zeilenverkoppelt. Um den Speicheraufwand gering zu halten, wurden die Luminanzinformation (Y50) und die Farbinformationen -(R-Y)50 und -(B-Y)50 auf zwei getrennten Signalwegen umgewandelt. Damit war eine optimale Anpassung an die jeweils erforderliche Signalbandbreite möglich.

Bei der vor dem Speicher liegenden A/D-Umsetzung wurde für das Y50-Signal eine Amplitudenauflösung von 7 Bit verwendet. Bei der für das Luminanzsignal (Y50) gewählten Abtastrate von 10,125 MHz ergaben sich 540 Abtastwerte pro Fernsehzeile. Für die beiden Farbdifferenzsignale -(R-Y)50 und -(B-Y)50 wurde eine Amplitudenauflösung von 6 Bit verwendet. Die Abtastrate für die Farbdifferenzsignale betrug 1,6875 MHz. Somit ergaben sich für jedes Differenzsignal 90 Abtastwerte pro Fernsehzeile. Insgesamt wurden pro Halbbild 294 Zeilen Bildinhalt abgespeichert.

Damit ergab sich ein Speicherbedarf für das Y50-Signal pro Halbbild von:

7 Bit x 540 x 294 = 1,2 MBit

Für das -(R-Y)50 und -(B-Y)50 Signal ergab sich pro Halbbild:

6 Bit x (90+90) x 294 = ca. 0,3 MBit

Insgesamt wurden also pro Halbbild 1,5 MBit Speicherkapazität benötigt. Für einen Halbbildspeicher des Normumsetzers wurden somit fünf CCDSpeicher SAA 9001 (mit jeweils 317 520 Bit) benötigt, vier für das Luminanzsignal und einer für die beiden Farbdifferenzsignale. Für die benötigten zwei Halbbildspeicher des Normumsetzers wurden somit insgesamt zehn digitale CCD-Speicher eingesetzt. Um immer optimale A/D-Converter-Aussteuerung zu gewährleisten, war dem Y50-A/D-Umsetzer eine Regelstufe mit Klemmschaltung (TDA 9045) vorgeschaltet. Weiterhin war ein Tiefpass am Y50-Eingang erforderlich (Anti-Aliasing-Filter). Nach der D/A-Umsetzung mussten das Y100 und die Farbdifferenzsignale -(R-Y)100 und -(B-Y)100 zunächst durch Tiefpässe (TP) gefiltert werden bevor sie an die Video/RGB-Kombination (TDA 3505) bzw. an den CTI Schaltkreis (TDA 4565) geführt wurden.

Displayteil

Da Luminanzsignal und Farbdifferenzsignale aus dem Bildspeicher des Normumsetzers doppelt so schnell ausgelesen wie eingeschrieben wurden, mussten CTI, Video/RGB-Kombination und RGB-Endstufen eine obere Grenzfrequenz haben, die etwa bei der doppelten Übertragungsbandbreite des entsprechenden Eingangssignals lag.

Da die Vertikalablenkendstufe des TDA2653A über eine Wechselstromkopplung mit der Ablenkeinheit verbunden war, mussten beim 100-Hz-Betrieb Rasterkorrektursignale direkt in die Vertikalablenkspulen eingespeist werden. Diese Korrektursignale wurden vom Steuersignalgenerator des Normwandler-Bausteins erzeugt (Shift-Video). Das Shift-Video-Signal war immer dann aktiv, wenn normaler Fernseh-VideoBetrieb vorlag. Dann mussten mit Hilfe dieses Shift-Video-Signals jeweils vier aufeinanderfolgende 100- Hz-Halbbilder, in der Zeitdauer einer 25 Hz Vollbildsequenz des Senders, in die zueinander richtige Vertikallage gebracht werden (sogenannter AABB-Betrieb).

Die Erhöhung der horizontalen Ablenkfrequenz auf 31.250 Hz erforderte einen kompletten Neuentwurf der Horizontalablenkschaltung. Insbesondere an Ablenkeinheit, Horizontalendstufe und Zeilentransformator wurden sehr hohe Anforderungen gestellt. Es wurde ein System Zeilentrafo/Kaskade entwickelt, das bei Betrieb mit 31,250 kHz einen entsprechend niedrigen Innenwiderstand in der Hochspannungserzeugung aufwies. Das Netzteil musste dem erhöhten Leistungsbedarf der Horizontalablenkschaltung und der Zusatzbelastung des Normwandlerbausteins angepasst werden. Weiterhin wurde, um jegliche Interferenzen mit der Horizontalablenkschaltung zu vermeiden, ein zeilenverkoppeltes Schaltnetzteilkonzept mit 31,250 kHz gewählt.

Der Monolith 70-390/7 Text wurde 1987/88 in limitierten Auflage gefertigt und erzielte ausgezeichnete Testergebnisse. Die Testzeitschrift "video" schrieb in ihrer Ausgabe 9/1987: „Im video-Testlabor trat der erste 100-Hertz-Serienfernseher gegen sein Schwestermodell ohne Flimmerfrei-Schaltung an, den Monolith 70-390, der in der video-Bestenliste Platz eins inne hat. Der bei der Bildqualität erzielte Fortschritt war allen Testpersonen sofort augenfällig.“ Und schlussfolgerte schließlich: „Denn oberstes Ziel bleibt für die Fürther die Verbesserung des bewegten Bildes.“ Dieser Erfolg war eine sehr schöne Bestätigung und zugleich Ansporn auch in Zukunft weiter eine Vorreiterrolle bei der Entwicklung von Bildqualitätsverbesserungen zu spielen.

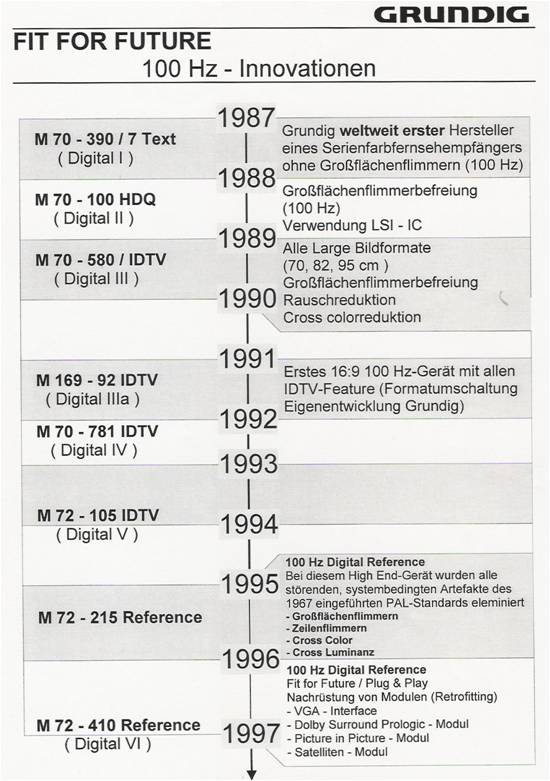

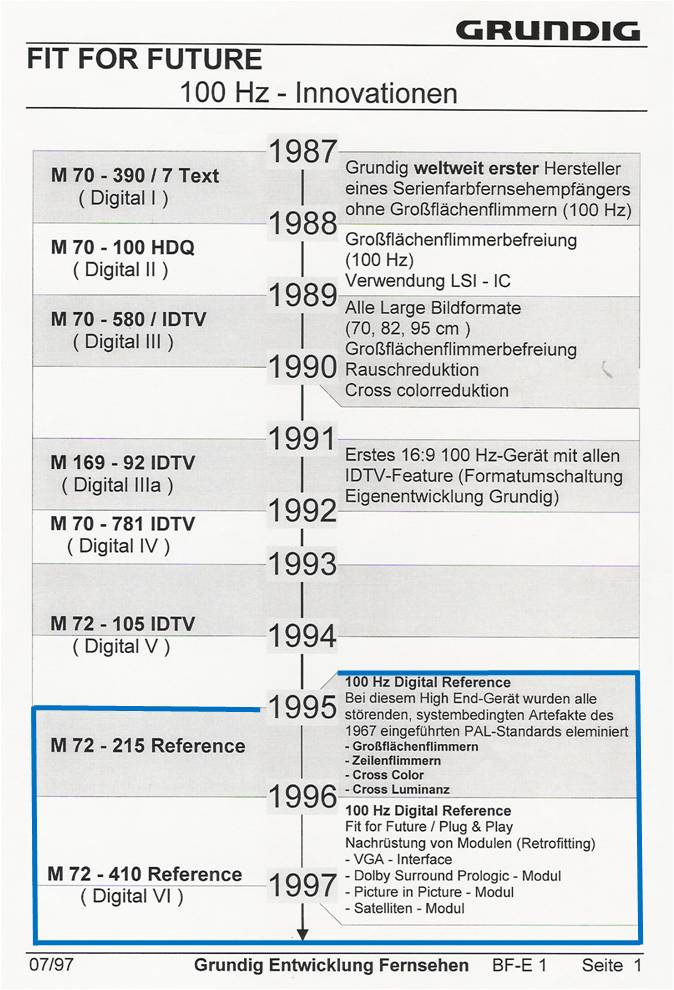

Grundig 100 Hz Weiterentwicklungen bis zum 100 Hz LCD-TV

Im Rahmen der Weiterentwicklung der Halbleitertechnologie konnten aufgrund der nun möglichen kleineren Strukturen der Integrierten Schaltkreise (Large Scale Integration) immer mehr Funktionen in die ICs integriert werden. So konnten in den folgenden Jahren alle noch bestehenden Störeffekte (Artefakte) des PAL-Systems unter Beibehaltung des analogen Übertragungsstandards im Fernsehgerät durch digitale Signalverarbeitung beseitigt werden. Abb. 5 zeigt den zeitlichen Verlauf der weiteren empfängerseitigen Bildverbesserungen in Grundig High-End-Farbfernsehgeräten.

Abb. 5: Grundig 100 Hz-Innovationen

Und was ist heute im Zeitalter von Flachbildschirmen und digitaler Übertragungstechnik für HDTV von der 100 Hz Technik noch geblieben? Das digitale Übertragungsverfahren für HDTV hat die eingangs aufgeführten Schwachstellen des PAL-Systems nicht. Aber Flachbildschirme in LCD- und OLED-Technik haben bei all ihren Vorteilen doch einen Schwachpunkt gegenüber der guten alten Bildröhre. Aufgrund ihres technischen Prinzips können diese Flachbildschirme Bewegung schlechter wiedergeben. Um diesen Effekt zu vermindern kommt die 100 Hz Technik wieder zu Ehren. Es werden durch digitale Signalverarbeitung empfängerseitig zusätzliche Bilder berechnet. Bei den HDTV Standards 720p/50 (ARD, ZDF) und 1080p/50 werden zum Beispiel zu den vom Sender übertragenen 50 Bildern pro Sekunde weitere 50 berechnet. Besonders hochwertige LCD-TV-Geräte arbeiten sogar mit 200 Hz. Hier kann nicht im Detail auf das Prinzip eingegangen werden aber bei Interesse kann unter http://www.gisela-und-konrad-maul.de/HV07_Essay.pdf ein Technik-Essay des Autors „Die raffinierten Tricks der Bildverbesserer“ nachgelesen werden, in dem das Prinzip der Verbesserung der Bewegungswiedergabe von LC-Displays erklärt wird.

Und selbst bei UHD1-Phase1, dem Ultra High Definition TV-System mit der Auflösung von 3840 x 2160 Bildpunkten, wird die empfängerseitige Berechnung von Zwischenbildern (100 Hz Technik) zur Verbesserung der Bewegungswiedergabe empfohlen (siehe [8] Sachstand: UHDTV des Instituts für Rundfunktechnik IRT). Erst bei UHD1-Phase 2 ist dann eine senderseitige (native) Übertragung in HFR (High Frame Rate) also 100 bzw. 120 Bildern pro Sekunde (100 bzw. 120 Hz) vorgesehen um die Bewegungswiedergabe vor allem bei Sportübertragungen zu verbessern.

2. Die beste Grundig Farbfernsehserie "made for you"

Die Grundig TV "made for you"-Serie aus der guten alten Zeit der großen klobigen Bildröhre hatte viele innovative Features wie 100 Hz, 16:9, PALplus, Satellitenempfang, Bild-im-Bild, Dolby Surround, VGA ...

Grundig Fernseher M82-269 Reference bei dem, wie bei allen Geräten der "made for you"-Serie, alle Schwachstellen des PAL Farbfernsehsystems beseitigt wurden. Mit dem Burosch Referenz Testbild werden eventuelle Schwächen in der Bildeinstellung oder in der eigentlichen Bildwiedergabe deutlich sichtbar gemacht. Perfekte Bildwiedergabe!

Bei der Vorgängerserie, dem Grundig TV M72-215 Reference, wurden schon alle störenden, systembedingten Schwachstellen des 1967 eingeführten PAL Systems empfängerseitig beseitigt wie:

- Großflächenflimmern

- Zeilenflimmern

- Cross Color

- Cross Luminanz

Auf Grund dessen trug er die Bezeichnung "Reference" zu Recht.

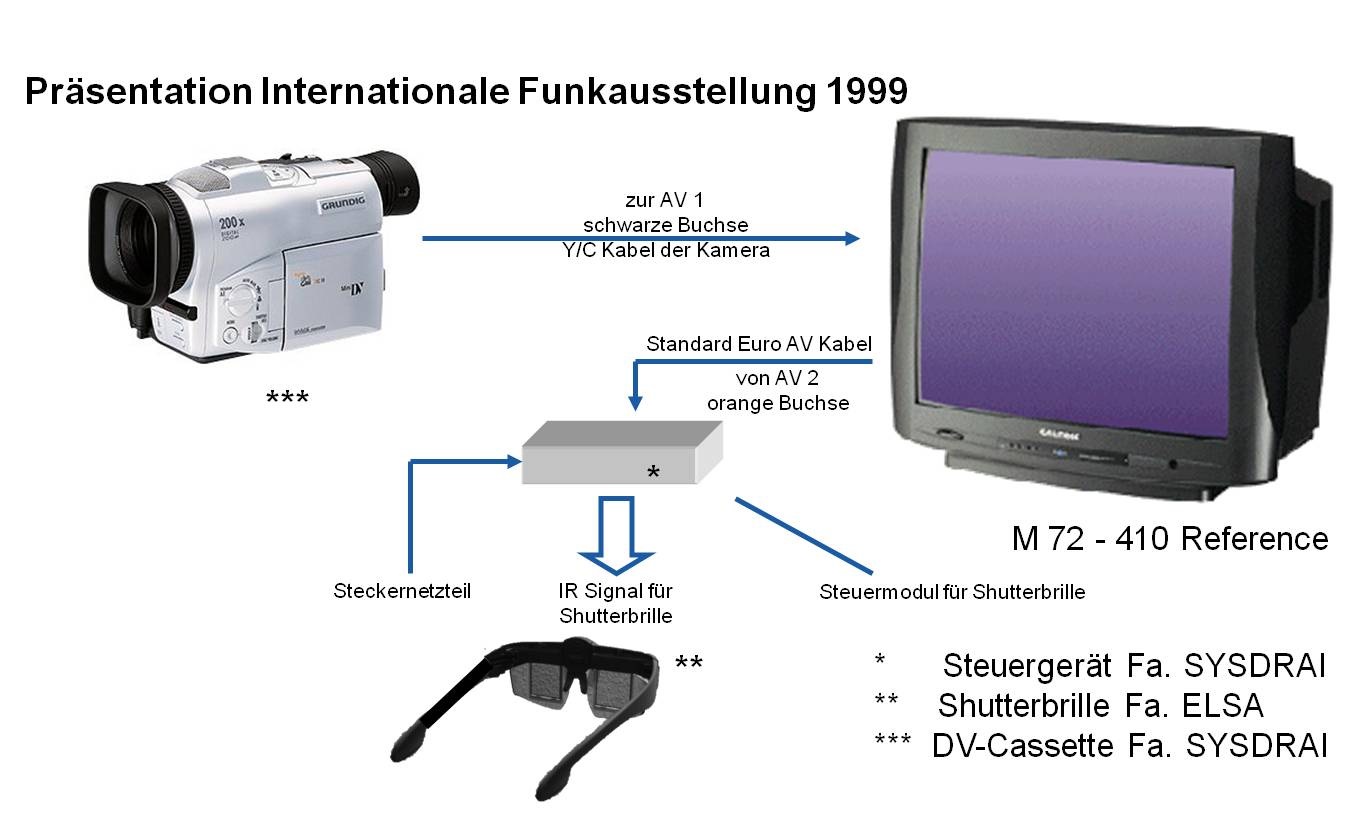

Hier soll aber die Nachfolgerserie am Beispiel des M72-410 Reference beschrieben werden, der die gleiche Performance aufwies aber noch mehr Features bot. Er war mit dem Digital VI Chassis ausgestattet. Dieses Konzept ermöglichte auch PALplus 16:9 Geräte und war für alle gängigen 4:3 und 16:9 Großbildformate geeignet (siehe Grundig Presseinformation 61 / 1997 im Folgenden).

Das Grundig Fernsehlabor entwickelte 1996/1997 das Digital VI Chassiskonzept mit dem wie beim M72-215 Reference alle Schwachstellen des PAL Farbfernsehsehsystems empfängerseitig beseitigt werden konnten. Das Foto zeigt den M72-410 Reference, der mit dem Chassis Digital VI ausgestattet war. Bei Grundig lief 1997 die Serienproduktion der „made for you“-Serie, der sechsten Generation (Digital VI) der 100 Hz Fernsehgeräte, an.

Abb. 2 zeigt die Grundig 100 Hz-Innovationen von 1987 an. Der M72-215 Reference wurde nur mit 72 cm Bildröhre gebaut. Das Nachfolgechassis konnte für alle gängigen Großbildformate eingesetzt werden und hatte noch einige Features mehr (siehe Grundig Presseinformation 61 / 1997 im Text).

Schon das weltweit erste 100 Hz Farbfernsehgerät in Serienproduktion von Grundig hatte ja dank eines Halbbildspeichers und der 100 Hz-Technik kein Großflächenflimmern mehr. In den Geräten der Grundig "made for you"-Serie (Digital VI), also auch im M72-410 Reference, sorgte nun ein digitales Kammfilter im digitalen Videoprocessing für die Eliminierung der Cross Color und Cross Luminanz Störung (Beschreibung dieser Artefakte siehe "Das weltweit erste flimmerfreie TV-Seriengerät").

Die letzte verbleibende Schwachstelle des PAL/CCIR sowie des SECAM TV-Standards war das Zwischenzeilenflimmern (auch mit Kantenflackern bezeichnet). Dieser Artefakt wurde nun in den Geräten der Grundig "made for you"-Serie (Digital VI) beseitigt, was einen erheblichen Aufwand und clevere Signalverarbeitungsalgorithmen erforderte.

Bei Einführung des elektronischen Fernsehens mit 625 Zeilen und 25 Vollbildern pro Sekunde nach dem zweiten Weltkrieg wurde festgelegt das Zeilensprungverfahren zu verwenden. Dabei werden zunächst die ungeraden Zeilen eines Vollbildes also Zeile 1, 3, 5, 7 usw. bis Zeile 625 übertragen und danach die geraden Zeilen dieses Vollbildes also 2, 4, 6, 8 und so fort bis Zeile 624. Ein Vorteil dabei ist, dass dadurch zwei Halbbilder entstehen (A und B) mit jeweils nur 20 msec Dauer und sich dadurch eine Bildfrequenz von 50 Hz ergibt und damit das Großflächenflimmern stark verringert werden konnte als wenn Vollbilder mit 25 Hz Bildfrequenz übertragen worden wären. Ein Übertragen des kompletten 625 Zeilenvollbildes mit einer Vollbildfrequenz von 50 Hz hätte natürlich auch das Großflächenflimmern reduziert aber die doppelte Übertragungsbandbreite erfordert.

Da nun aber bei diesem Zeilensprungverfahren benachbarte Zeilen ja aus verschiedenen Halbbildern stammen tritt an horizontale Kanten des Fernsehbildes eine Flackererscheinung von 25 Hz auf. So springt z.B. bei einer Tennisübertragung die Kante der Grundlinie in diesem 25 Hz-Rhythmus. Um diese Störung zu beseitigen benötigte man einen Bildspeicher der beide Halbbilder, also alle 625 Zeilen eines Vollbildes abspeichern konnte. Damit war es dann möglich das Vollbild nicht wie bisher nur in Halbbildwiederholung AABB, sondern auch in der Sequenz ABAB mit einer verdoppelten Zeilensprungsequenz wiederzugeben. Bezüglich der Synchronisation des Rasters spricht man von αβαβ anstatt wie bisher bei 100 Hz-Geräten mit nur einem Halbbildpeicher ααββ (alpha, beta). Damit konnte man bei Fernsehbildern mit keinem oder nur sehr geringem Bewegungsanteil das Zeilenflimmern komplett eliminieren.

Bei bewegten Objekten oder Kamerabewegungen (z.B. Schwenk) führte dieses einfache Verfahren aber zu Störungen an senkrechten Kanten (Auszahnen), weil ein Rücksprung in alte Bewegungsphasen erfolgte. Deswegen war ein Bewegungsdetektor erforderlich, der durch blockweisen Bildvergleich den Grad von Bewegungen im Fernsehbild feststellen konnte. Bei einer mittleren Bewegung wurden mittels einer Rechenvorschrift (Algorithmus) dann die Bildpunkte von benachbarten Zeilen so korrigiert, dass dies das Zwischenzeilenflimmern beseitigte. Bei Grundig wurde ein Verfahren eingesetzt, dass auf dem Algorithmus von Prof. Dr. Schröder (Universität Dortmund) der für Grundig patentiert wurde, aufsetzte. Dabei wird das digitale Fernsehsignal in den vertikalen Höhen- und Tiefenanteil aufgespaltet und unterschiedlich prozessiert. Wurde vom Bewegungsdetektor sehr starke Bewegung signalisiert ging das System automatisch in den Rückfallmodus AABB mit der Rastersequenz ααββ (alpha, beta).

Bei Kinofilmen die ja mit 24 Bildern pro Sekunde gedreht werden und im Fernsehen mit 25 Vollbildern wiedergegeben werden sind die beiden Halbbilder A und B bezüglich der Bewegungsphase identisch. Also konnte man generell das Verfahren ABAB mit der Rastersequenz αβαβ ohne Umschaltung auf „Schröder Algorithmus“ oder Rückfallmodus verwenden. Firma Siemens Halbleiter setzte mit der Unterstützung der Grundig Fernsehentwicklung dieses Verfahren in einen digitalen CMOS-Signalprozessor um. Er wurde als Fieldmixer (SDA 9270) bezeichnet.

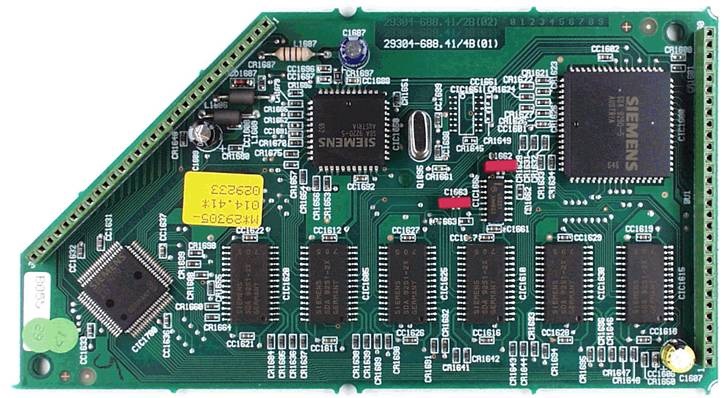

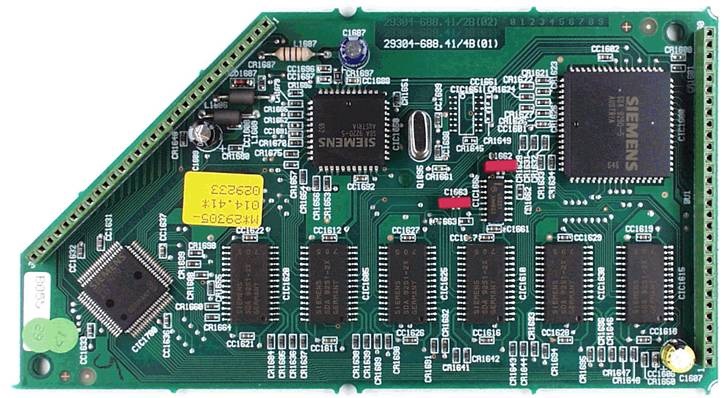

Abb. 3 zeigt die Speicherplatte eines 100 Hz Seriengerätes der Serie Digital VI z.B. Grundig M72-410 Reference. Es sind die sechs Speicherbausteine SDA 9251 mit je 212k x 4 Bit, die den Videovollbildspeicher mit rund 5 Megabit bilden, zu sehen. Links unten ist der Fieldmixer SDA 9270, oben rechts der Picture Prozessor SDA 9290 und oben links der Displayprozessor SDA 9280 angeordnet.

Abb. 3: Speicherplatte eines 100 Hz Seriengerätes der Serie Digital VI z.B. M72-410 Reference. Es sind die sechs Speicherbausteine SDA 9251 mit je 212k x 4 Bit Speicherkapazität, die den Videovollbildspeicher mit rund 5 Megabit bilden. Links unten der Fieldmixer SDA 9270. Oben rechts der Picture Prozessor SDA 9290. Oben links der Displayprozessor SDA 9280.

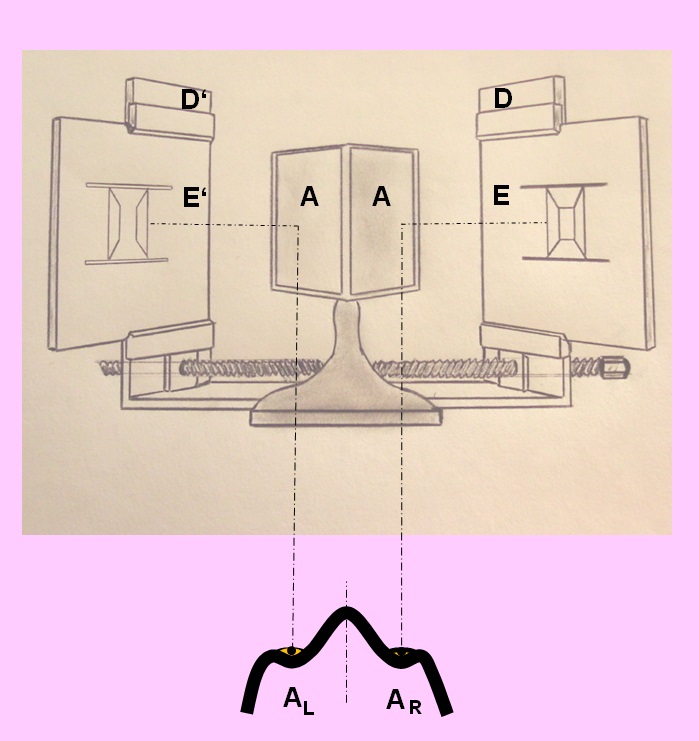

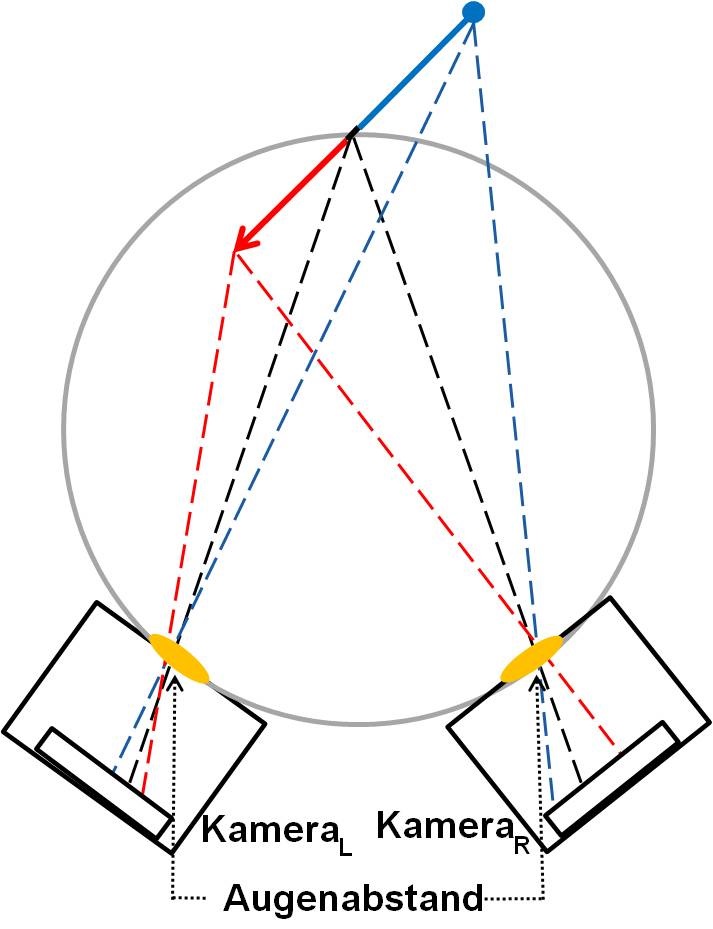

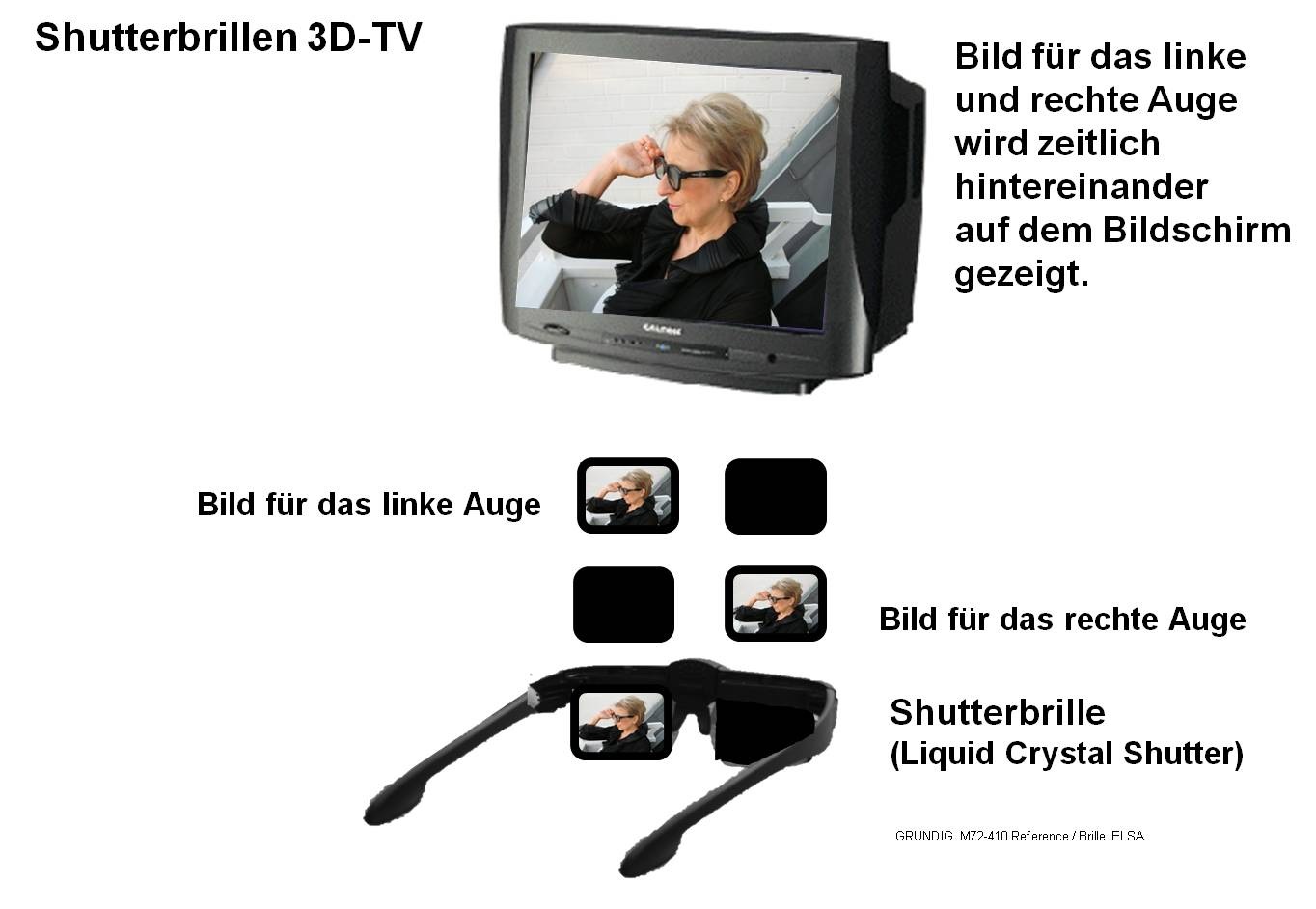

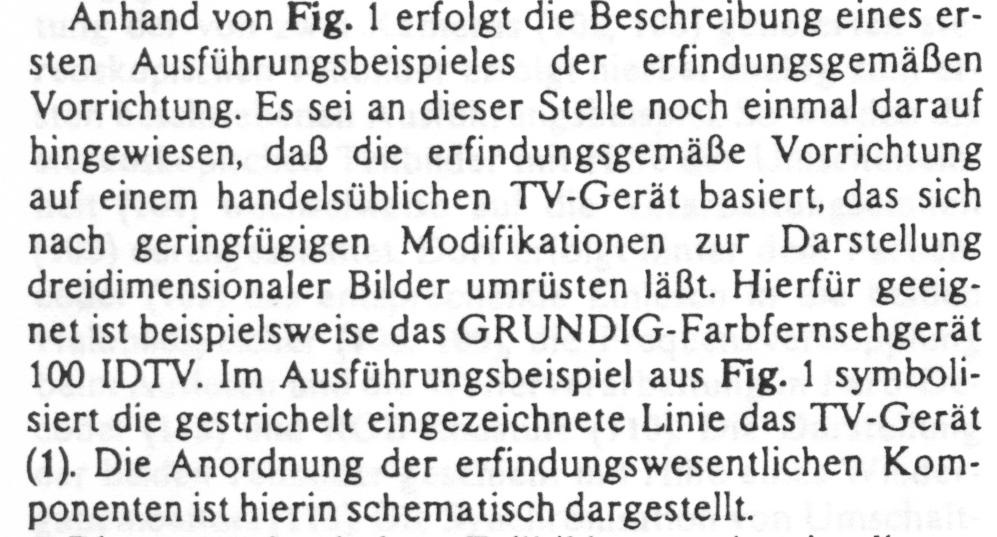

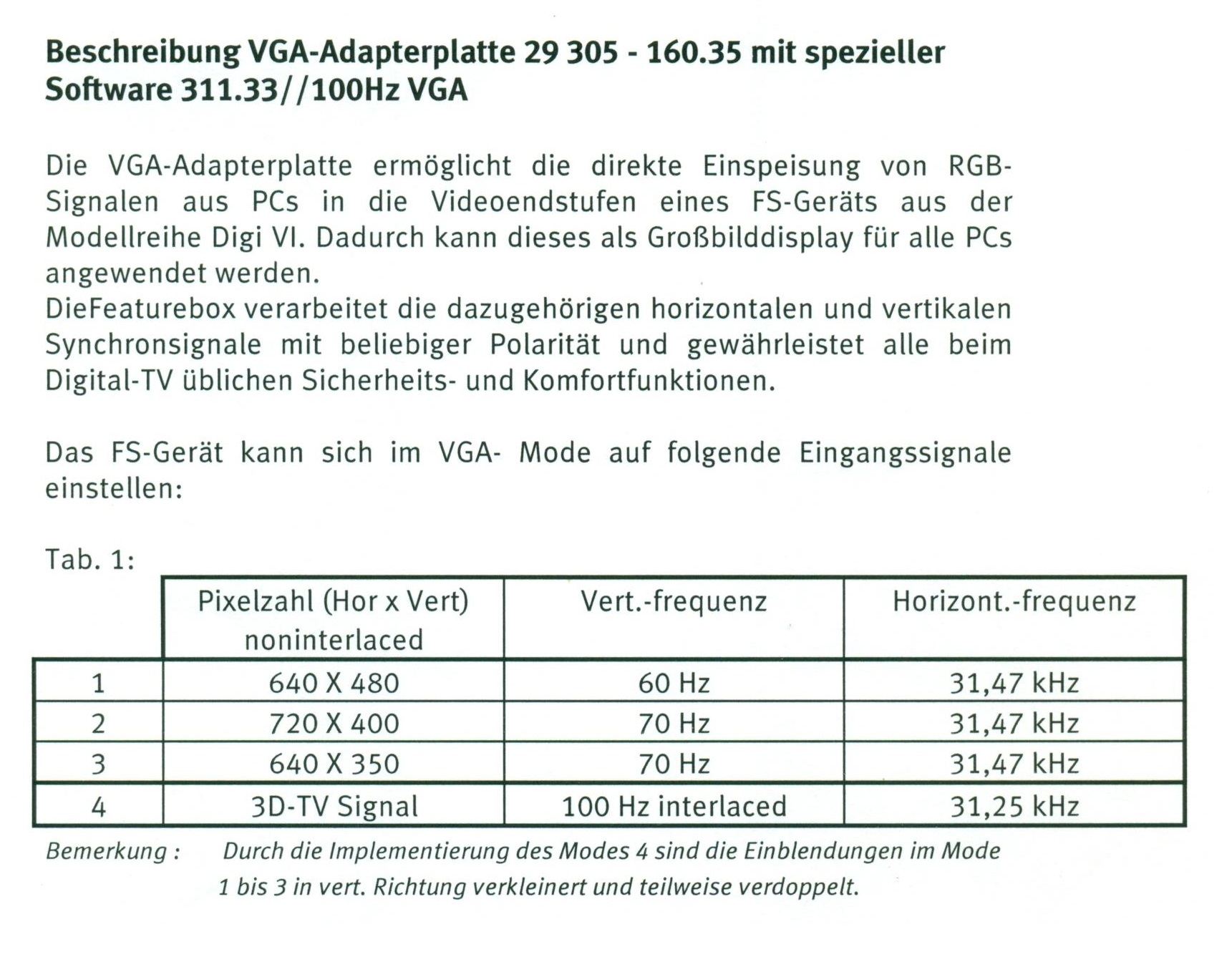

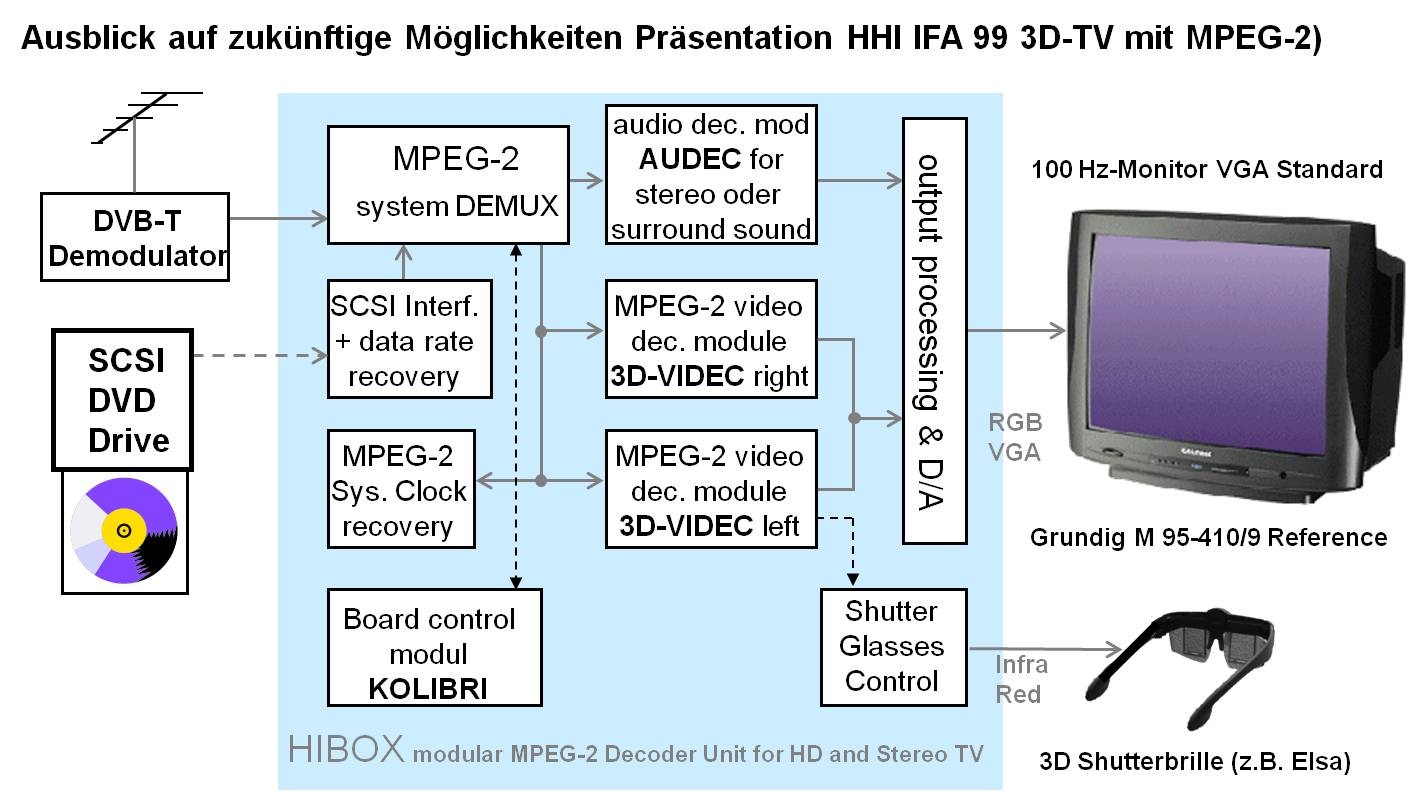

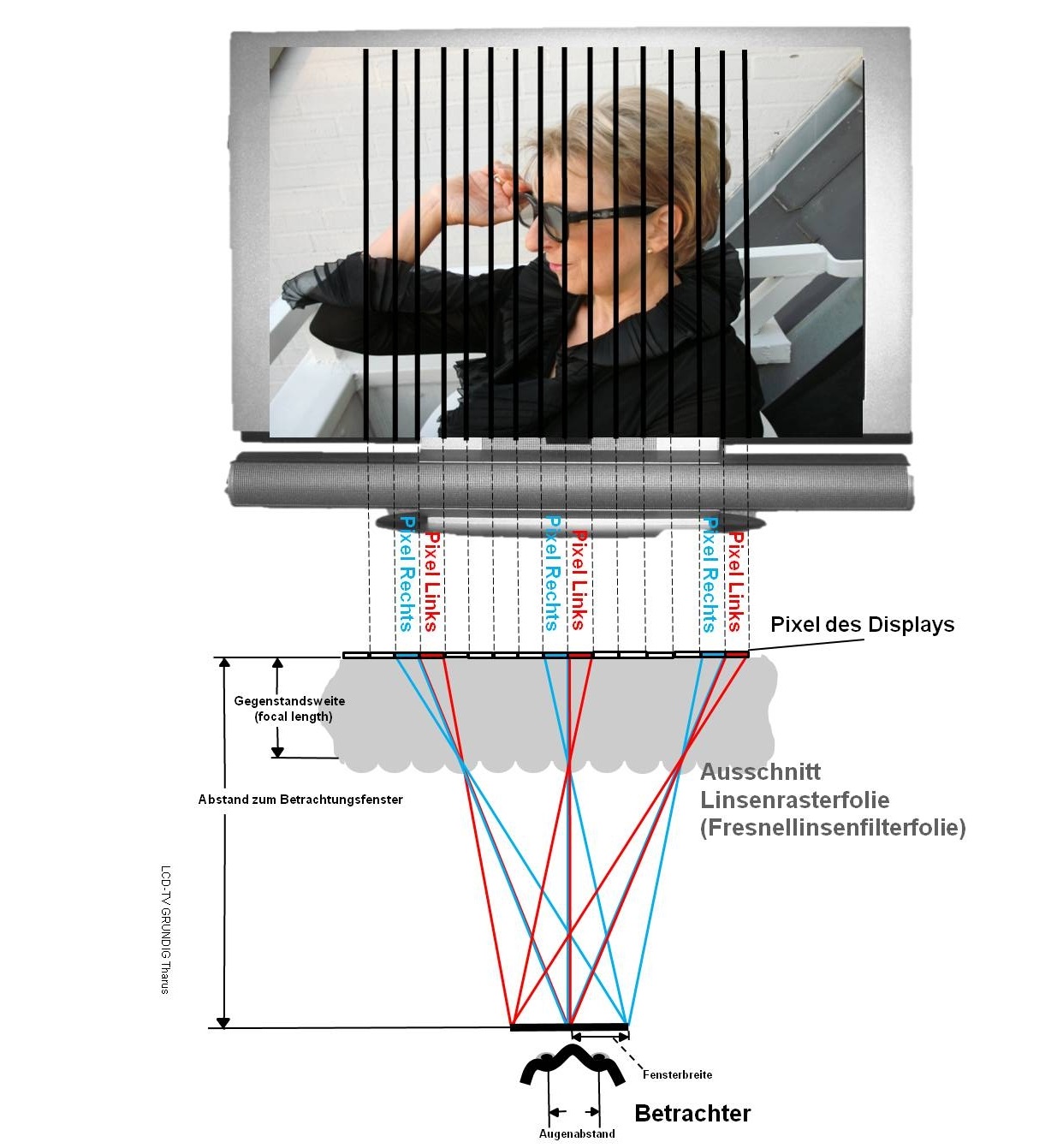

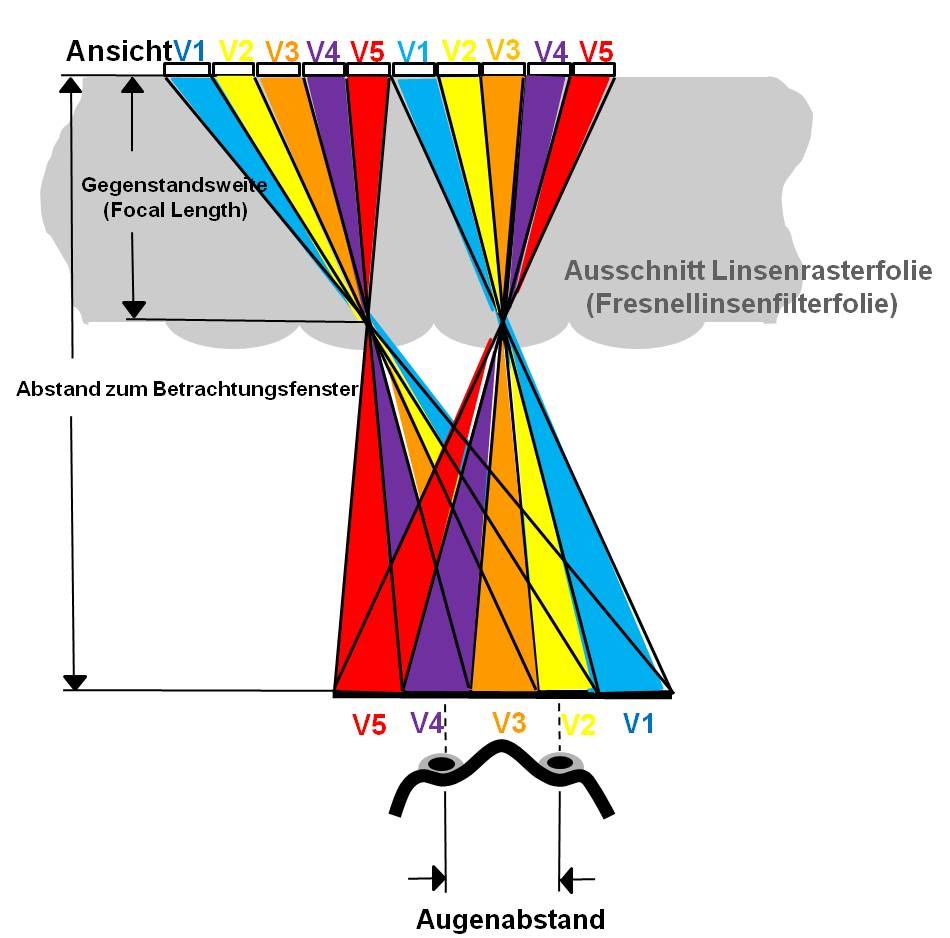

Die zweite Weiterentwicklung der Digital VI 100 Hz Geräteserie betraf die Erweiterung um einen VGA Eingang. Inzwischen hatte sich das Internet etabliert und ein großformatiges Fernsehgerät als Monitor für einen PC verwenden zu können stellte ein sehr gutes Gerätefeature dar. Da die Grundig 100 Hz-Geräte ja mit Zeilenablenkfrequenzen von 31,25 kHz liefen, die RGB-Endstufen für die 100 Hz Wiedergabe auf die doppelte Videobandbreite ausgelegt waren (10 MHz anstatt 5 MHz) und eine gleichstromgekoppelte Vertikalablenkung zum Einsatz kam war die Einführung eines VGA-Standard-Eingangs möglich. Dazu war ein VGA-Steckmodul entwickelt worden, das in jedes Gerät der Digital VI Geräteserie nachgerüstet werden konnte. Schon zur Internationalen Funkausstellung 1997 hatte das Heinrich Herz Institut zwei Grundig M 95-410/9 Reference Digital VI als 100 Hz-Monitore mit Shutterbrillen zur Präsentation ihrer 3D-Forschungen benutzt.

Die Grundig Presseinformation Nr. 61/1997 fasste die Gerätefeatures wie folgt zusammen:

„In allen Großbildklassen bietet Grundig „made for you“-Fernsehgeräte. Neben gesteigertem TV-Genuß mit bestem Bild in flimmerfreier 100 Hz-Reference-Technik gibt es für die „made for you“-TV Geräte eine große Vielfalt an Ausstattungsvarianten. Das Produktkonzept erlaubt die individuelle Ausrüstung der Geräte mit einer VGA-Schnittstelle, einem Satelliten-TV-Receiver sowie Dolby Surround und Bild-im-Bild-Modulen.

Die Grundig TV „made for you“-Serie beinhaltet folgende Geräte:

M 95-410 Reference

M 72-410 Reference

M 72-410 Reference / PiP (Bild im Bild)

M 82-269 Reference

M 70-269 Reference

M 82-269 PALplus

MW 70-269 PALplus

Das Gerät wird vom Fachhandel nach Kundenwunsch maßgeschneidert ausgestattet, soweit die einzelnen Komponenten nicht serienmäßig eingebaut sind.

Und die Testzeitschrift "video" hat in ihrer Nr. 6 / 1997 den Grundig M72-410 Reference getestet und schreibt: „Der Nachfolger des bisher besten 70 Zentimeter-TV, den video je getestet hat (Anmerkung des Autors: Der Grundig M72-215 Reference) ist der M72-410 Reference. Für 2700 Mark bekommt der Käufer mithin einen 100-Hertz-Fernseher, in dessen Innenleben eine scharfe 72-Zentimeter-Toshiba-Bildröhre ihre Dienste versieht. Über diese zeichnet der Stammhalter ein brillantes Bild auf die Mattscheibe, das eine höhere Auflösung zeigte als das eines Profi-Monitors. Besonders Landschaftsaufnahmen mit sattem Grün und warmen Brauntönen wirkten plastisch und brillant. Schrillbunte Studiokulissen parierte er ebenso mühelos. Dabei brachten ihn dank Reference-Schaltung auch keine Schwenks aus dem Tritt, die normalerweise 100-Hz-Fernseher zum Bildruckeln verleiten.“

Und in der video Bestenliste (Nr. 6 / 1997) nahm der Grundig M72-410 Reference in der Sparte beste TV-Geräte mit 70-Zentimeter-Röhre den ersten Platz ein. Der Grundig M82-169 PALplus, mit dem gleichen Digital VI Chassiskonzept, konnte sich in der Sparte 16:9-Geräte mit Dolby Surround ebenfalls den ersten Platz erobern.

3. Wie das Spielen auf den Bildschirm kam

Vom ersten Videospiel über den Grundig Super Play Computer bis zur Virtual Reality

Grundig Super Play Computer SPC 4000 angeschlossen an ein Grundig Lenaro 37 LCD-TV Gerät.

Homo ludens – Der spielende Mensch

Spiele sind ein integraler Teil aller Kulturen und die ältesten Formen sozialer Interaktion. Denken wir zum Beispiel nur an Würfelspiele im antiken Rom, wie sie auf Wandmalereien zu sehen sind oder an das älteste Schachlehrbuch aus dem alten Persien. Darum ist es nicht verwunderlich, dass Menschen auch jede neue Technologie früher oder später zum Spielen nutzen, so auch das Fernsehgerät. Aber sehen wir uns zunächst an wie es dazu kam.

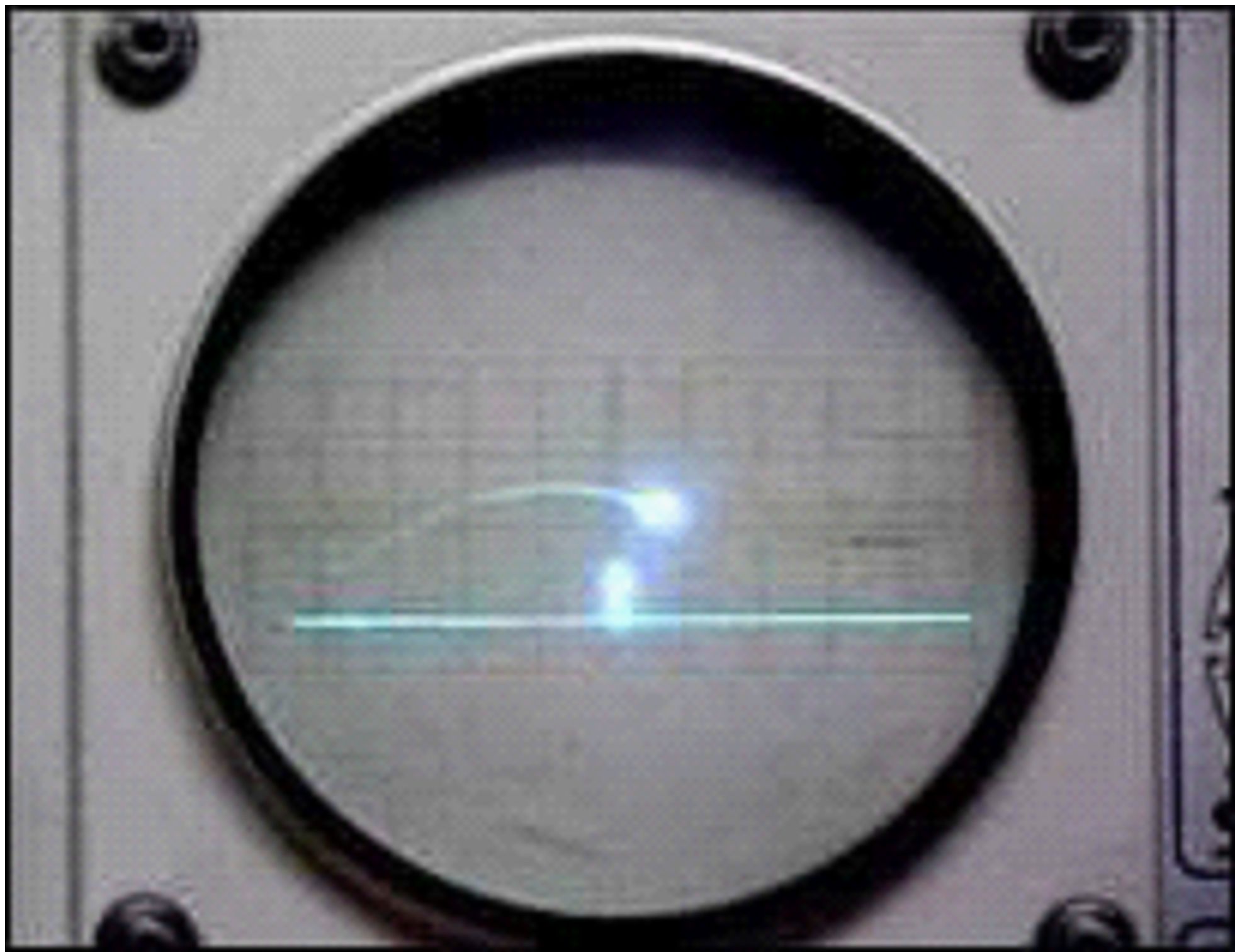

Der Beginn: Das erste Videospiel

Alles begann 1958 in den USA damit, dass der Physiker und Leiter der Abteilung für Mess- und Analyse-Instrumente am Brookhaven National Laboratory William Higinbotham darüber nachdachte, was man denn „Am Tag der Offenen Tür“ des Instituts den Besuchern vorführen könnte. Dabei kam ihm das Benutzerhandbuch des Analogrechners der Abteilung in den Sinn. In diesem Handbuch wurde beschrieben, wie man Kurven auf einem Oszillographenbildschirm darstellen konnte.

Ein Analogrechner wurde damals benutzt um z.B. Differentialgleichungen aus der Regelungstechnik zu lösen, denn die wenigen „Elektronenrechner“, wie damals Digitalrechner noch genannt wurden, waren sehr teuer und für viele Problemstellungen noch nicht geeignet. So ein Analogrechner bestand aus mehreren Operationsverstärkern, die entsprechend des Rechenproblems verschaltet werden konnten. Dabei wurde die jeweilige physikalische Größe durch eine entsprechende elektrische Spannung nachgebildet.

Und in dem besagten Benutzerhandbuch fand sich nun ein Beispiel eines springenden Balls. Das brachte Higinbotham auf die Idee ein Tennisspiel für den „Tag der Offenen Tür“ zu entwickeln. Er nannte es „Tennis for Two“. Abb.1 zeigt ein Bildschirmfoto des Oszillographen, der für die Darstellung verwendet wurde. Der Tennisplatz ist im Aufriss dargestellt, d.h., der Boden als waagrechte Linie, das Tennisnetz als senkrechte Linie. Die Flugbahn des Balls ist durch das Nachleuchten des Bildschirms deutlich zu sehen. Nachdem der Ball im eigenen Feld aufgesprungen war musste der Spieler durch entsprechende Verstellung seines Schlägers den Ball wieder zurückschlagen. Dabei war sogar durch die Verstellung des Schlägerwinkels die Flugbahn durch den Spieler beeinflussbar. Es wurde berichtet, dass die Besucher in Zweierreihen anstanden um einmal selbst „Tennis for Two“ spielen zu können.

Auf dem Eingangsfoto sehen wir wie zwanzig Jahre später mit dem Grundig SPC 4000 diese Tennisvariante mikroprozessorgesteuert ganz ähnlich dargestellt wurde. Jetzt wurde die Flugbahn des Balls mit dem Mikroprozessor digital berechnet. Higinbotham verfolgte seine Idee damals nicht weiter und ließ sich das Prinzip auch nicht patentieren.

Abb.1: Das erste Videospiel „Tennis for Two“

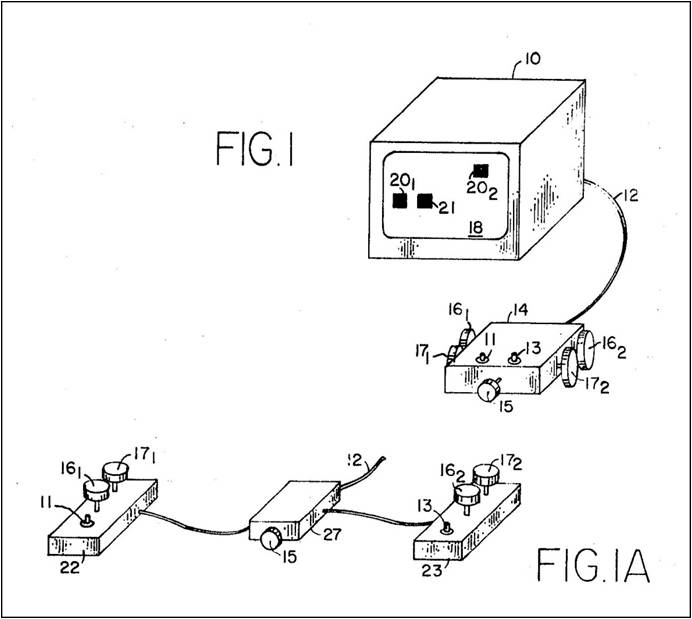

Ralph Baer - der Vater der Videospiele

Ralph Baer war Divisionsmanager bei Sanders Associates Inc. und in seinem Bereich waren 500 Ingenieure tätig. In den 1960er Jahren gab es schon Millionen Farb- und Schwarz-Weiß-Fernsehgeräte in den amerikanischen Haushalten. Baer überlegte wie man diese TV-Geräte zu mehr als nur passivem Fernsehen nutzen könnte. Da kam er auf die grandiose Idee ob es wohl möglich sei Spiele auf den Fernsehbildschirm zu bringen. Und 1966 begann Baer die für diesen Zweck anwendbaren technischen Möglichkeiten zu untersuchen. Zwischen 1967 und 1968 entwickelte Baer zusammen mit seinen Mitarbeitern Harrison und Rusch einige Videospiel-Prototypen zum Testen. Das Ergebnis war dann die erste „Brown Box“, ein Prototyp des ersten Video Game Systems. „Brown Box“ deswegen weil die Schaltung und die Bedienteile in braun furnierte Holzkästchen eingebaut worden waren. Dieses Spielesystem konnte mehrere Spiele, unter anderem Fangen, Jagen und Ping Pong. Es war für mehrere Spieler ausgelegt. Aufgebaut war es mit diskreten Bauteilen (Transistoren, Dioden, Widerständen, Kondensatoren etc.). Integrierte Schaltkreise waren damals für diese Applikation viel zu teuer.

Als erfahrener Entwicklungsingenieur dokumentierte Ralph Baer seine Schaltungen ganz genau und sein Arbeitgeber Sanders Associates Inc. meldete eine Reihe von Patenten an. Abb.2 zeigt die Anordnung seiner Erfindung aus einer Patentschrift von 1972. Der HF-Modulator des Spielesystems wurde über ein HF-Kabel an den Antenneneingang des Fernsehgerätes angeschlossen. Sanders Associates Inc. war selbst nicht auf dem Gebiet der Unterhaltungselektronik tätig und lizensierte deswegen das System an Magnavox, damals einer der großen Fernsehhersteller in den USA. Magnavox brachte das Spielesystem 1972 unter dem Namen „Odyssey“ auf den Markt. Es war die weltweit erste Spielekonsole und immer noch aufgebaut mit diskreten Bauteilen. Von der Magnavox Spielekonsole „Odyssey“ wurden ca. 200 000 Exemplare verkauft. Magnavox sah damals „Odyssey“ nur als Mittel um Fernsehgeräte zu verkaufen. Es wurde nicht erkannt welches ungeheure Potential Videospiele in sich bargen. Wer konnte auch schon ahnen, dass sich viele Jahre später eine unabhängige Video Game Industrie entwickeln würde.

Abb.2: Baers United States Patent Nr. 3 659 285 Television Gaming Apparatus and Method (Fernseh-Spiele-Apparat und Prinzip). Auszug Patentschrift.

Integrierte Schaltkreise für Videospiele

Wie erwähnt war das erste Videospielsystem „Odyssey“ aus vielen diskreten elektronischen Bauteilen aufgebaut. Nun hatten 1958 Jack Kilby (Texas Instruments) und Robert Noyce (Fairchild) den Integrierten Schaltkreis (IC) erfunden. Damit konnten die Bauteile einer elektronischen Schaltung, wie Transistoren, Dioden, Widerstände und Verbindungsleitungen, quasi zusammengefasst und mit einem einzigen „Integrierten Schaltkreis“ realisiert werden. Das ermöglichte kleinere Abmessungen der Elektronik.

Anfangs waren diese ICs noch sehr teuer und auf wenige Funktionen beschränkt. Aber mit dem technischen Fortschritt im Halbleiterbereich gelang es General Instrument, damals ein großer Hersteller von Halbleiterbauelementen in den USA, 1976 als erstem sechs auswählbare Spiele auf einem IC zu integrieren. Die Spiele waren Pelota, Squash, Tennis, Fußball, Treibjagd und Tontaubenschießen. Damit war nur noch eine kleine Menge an Bauteilen für das komplette Spielesystem erforderlich und kostengünstige Konzepte wurden ermöglicht. Auf Basis dieses General Instrument ICs (AY-3-8500) entwickelte Grundig seine Tele-Spiel-Cassette 1 und brachte das System 1976 auf den Markt.

Der Autor, der mit seinem Team ab 1977 auch für die Grundig Video Spiele Entwicklung zuständig war, begann noch mit der Entwicklung der Grundig Tele-Spiel-Cassette 2. Es sollte auf dem General Instrument IC AY-3-8760 „Motor Cycle“ basieren. Bei diesem Spiel musste man wie ein Stuntman durch geschicktes Gasgeben auf einer Rampe Objekte (Autos, Busse) überspringen. Doch diese Entwicklung wurde abgebrochen.

Ein weiterer Technologiesprung, die Erfindung des Mikroprozessors, hatte einen neuen Ansatz zur Realisierung von Videospielen geliefert. Die Idee alle Baugruppen eines Digitalrechners auf einem Schaltkreis zu integrieren und damit quasi einen „Mikroprozessor IC“ (µP) zu realisieren wurde 1968 unabhängig voneinander durch Ted Hoff (Intel) und Gilbert Hyatt (Hyatt Micro Computer Inc.) geboren. Intel hatte bereits 1971 den weltweit ersten Mikroprozessor, den 4 Bit Intel 4004, im Markt eingeführt. Aber es dauerte natürlich noch ein paar Jahre bis bezüglich Preis und Leistungsfähigkeit an den Einsatz von Mikroprozessoren bei Videospielen gedacht werden konnte. Doch 1977 war es dann soweit.

Mikroprozessor gesteuerte Videospiele am Beispiel des Grundig SPC 4000

Die bisher verfügbaren Integrierten Spiele Schaltkreise (ICs) erlaubten keine vielseitigen Spielesysteme, die auch noch kostengünstig waren, da für jedes Spiel ein neuer integrierter Schaltkreis entwickelt werden musste. Das änderte sich mit der Einführung des Mikroprozessors. Es war nun zum ersten Mal möglich ein Spiel in Software zu realisieren. Durch Änderung des gespeicherten Programms konnte nun ein neues Spiel gespielt werden, ohne dass eine neue Hardware (Schaltung) erforderlich wurde. Das bedeutete kürzere Entwicklungszeiten und damit viele attraktive Spiele.

In den USA hatte die Firma Atari 1977 mit der Produktion der ersten von einem Mikroprozessor gesteuerten Spielekonsole begonnen. Die verschiedenen Spieleprogramme wurden mittels Steckmodulen geladen, die Halbleiterspeicher (Read Only Memory) enthielten. Die Atari 2600 wurde 30 Millionen mal verkauft. Verständlich dass Grundig ebenfalls ein solch erfolgreiches Produkt in seiner Produktpalette haben wollte. Der Philips-Halbleiter-Bereich, Interton (ein deutscher Videospieleproduzent) und Grundig bildeten eine Systempartnerschaft, denn nur eine Bündelung der Entwicklungs- und Produktionskapazitäten ermöglichte kurze Entwicklungszeiten und akzeptable Stückzahlen. Und so wurde 1978/1979 der Grundig SPC 4000 entwickelt.

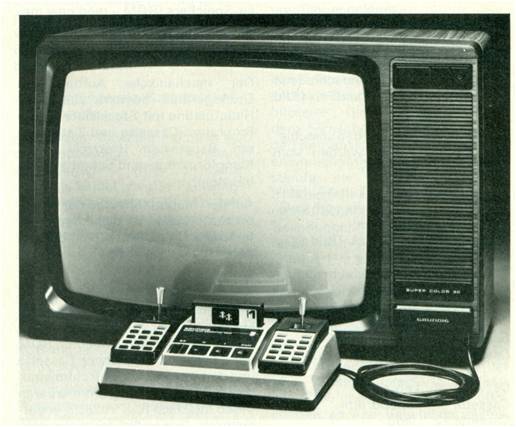

Er war unter den mikroprozessorgesteuerten Bildschirmspielen die qualitativ beste Lösung. Durch RGB-Ansteuerung des Fernsehgerätes in 75 Ohm Videotechnik lieferte er eine Farbwiedergabequalität und Bildschärfe wie sie nur von der kommerziellen RGB-Fernsehübertragung her bekannt war. Es sei daran erinnert, dass es zu dieser Zeit keine Euro-AV Anschlussbuchse (SCART) gab und die meisten Fernsehgeräte noch nicht netzgetrennt waren. Grundig Fernsehgeräte der Super Color 80 Serie ab Baujahr 1979 waren netzgetrennt und enthielten einen frontseitigen Universalschacht, der schon die Anschlussmöglichkeiten der späteren Euro-AV Buchse vorwegnahm. An diesen Universalschacht konnte der SPC 4000 angeschlossen werden (siehe Abb.3). Ebenso war es möglich über diesen Universalschacht eine Videotext-Cassette oder ein externes Bildschirmtextgerät anzuschließen.

Abb. 3: Grundig Super Play Computer SPC 4000 mit eingeschobenem Cassettenschacht-Anschluss in ein Fernsehgerät der Super Color 80 Geräteserie (ab Baujahr 1979)

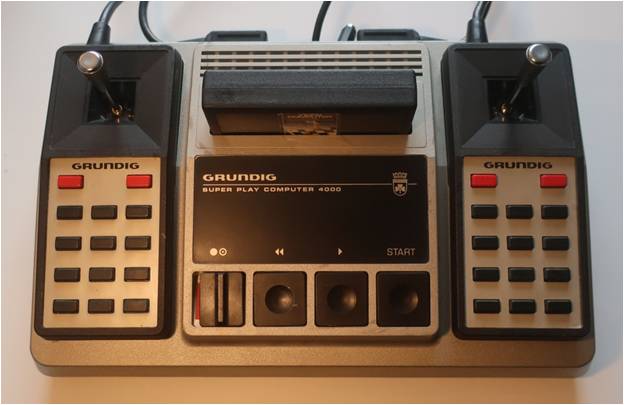

Aufbau des Grundig Super Play Computer SPC 4000

Der SPC 4000 bestand aus der Kompaktkonsole (Abb.4), den beiden Handspielgeräten mit Steuerknüppeln (heute mit Joystick bezeichnet) und Tastenfeld sowie dem Anschlussstecker (Abb.5) der in den Universalschacht des Fernsehgerätes eingeschoben wurde. Die gewünschte Spielecassette wurde in die Öffnung der Konsole eingesteckt.

Abb. 4: Grundig Super Play Computer SPC 4000 (Spielekonsole; Handspielgeräte mit Steuerknüppeln und Tastenfeld).

Abb. 5: Anschlussstecker des Grundig Super Play Computer SPC 4000

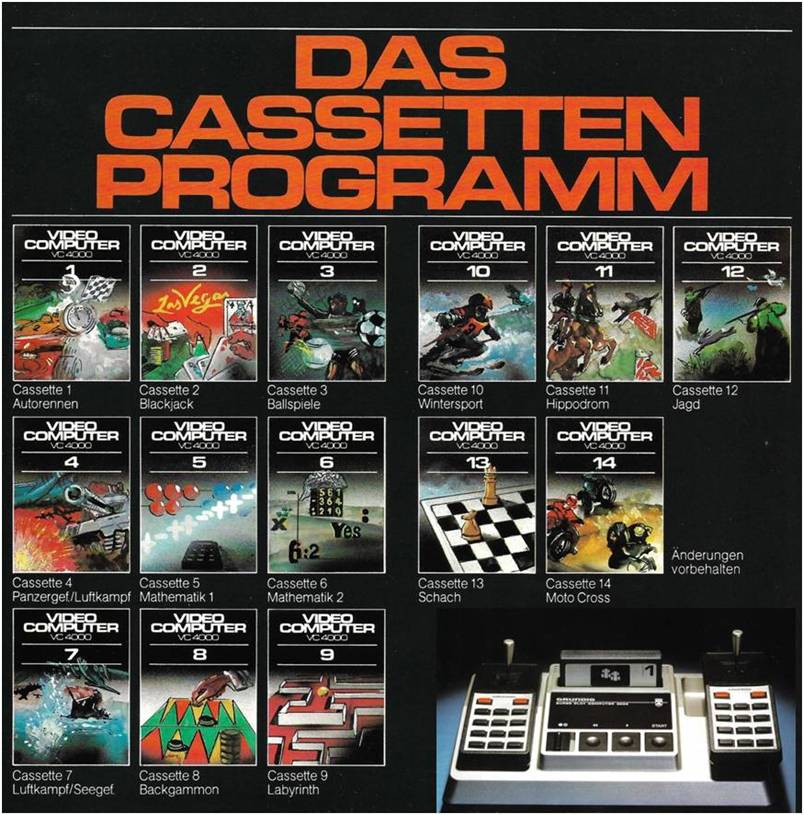

Spielecassetten für den Grundig Super Play Computer SPC 4000

Dem SPC 4000 lag die Spielecassette Nr. 1 für Autorennen bei. Diese enthielt zehn verschiedene Spielevarianten wie z.B. Grand Prix und Rallye. Die Abb. 6 zeigt das damalige Spieleangebot, das im Fachhandel angeboten wurde.

Abb. 6: Das Cassetten Programm des Grundig Super Play Computer SPC 4000. Foto Grundig AG Bedienungsanleitung SPC 4000.

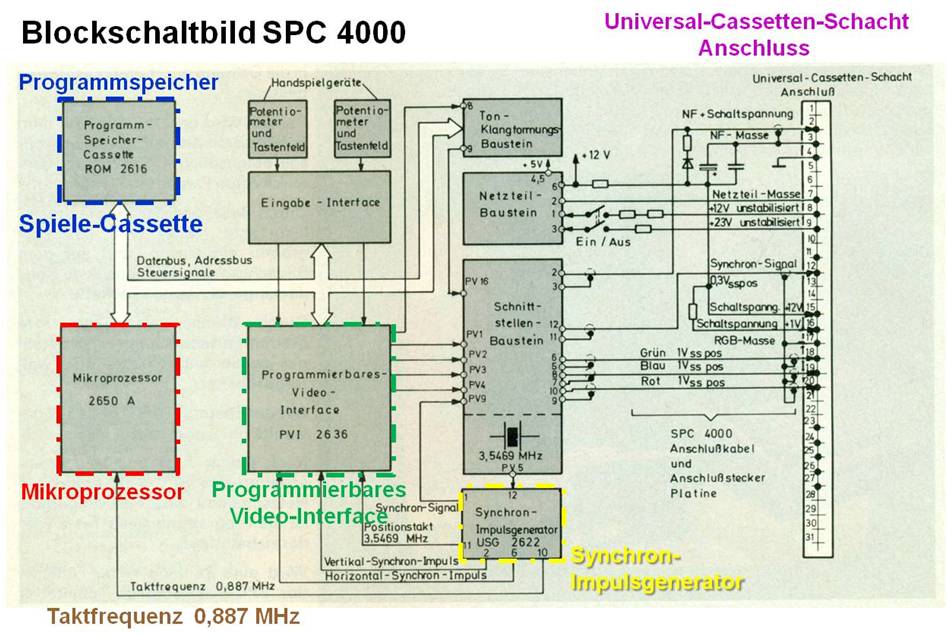

Systembeschreibung

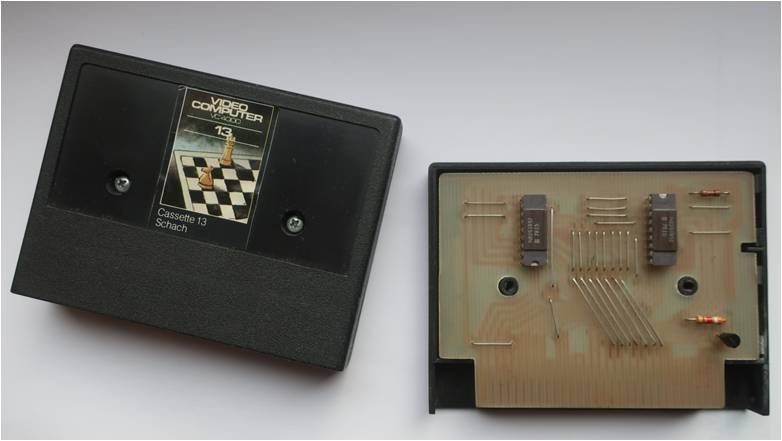

Das Blockschaltbild des SPC 4000 ist in Abb.7 dargestellt. Der Einsatz von Mikroprozessoren führte bei Bildschirmspielen, wie schon erwähnt, zu einer völlig anderen Schaltungskonzeption und ermöglichte den Einsatz von programmierbaren Bauelementen. Durch Auswechseln des programmierten Lesespeichers (ROM Read Only Memory; in Abb. 7 blau umrandet) ließen sich immer wieder neue Spiele laden. In etwa vergleichbar mit dem Laden einer neuen App heutzutage. Abb. 8 zeigt eine geöffnete Spielecassette für den SPC 4000.

Abb. 7: Grundig Super Play Computer SPC 4000 Blockschaltbild. Siehe Grundig Technische Informationen 4/1979.

Abb. 8: Geöffnete Spielecassette des Grundig Super Play Computer SPC 4000

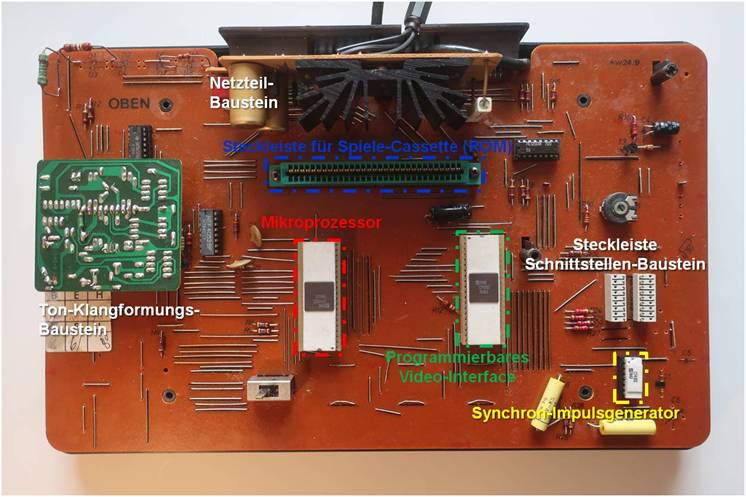

Der mechanische Aufbau des Grundgerätes bestand aus einer Hauptplatine mit einer Steckleiste für die Programm-Cassette und drei steckbaren Bausteinen (Netzteil-, Ton-Klangformungs- und Schnittstellenbaustein). Die Abb. 9 zeigt diesen Aufbau. Der Schnittstellenbaustein ist in der Abb. 9 abgezogen. Direkt auf der Hauptplatine waren der Mikroprozessor, das programmierbare Video-Interface und der Synchron-Impulsgenerator untergebracht. In der Entwicklungszusammenarbeit mit Philips (Halbleiter) und Interton hatte Grundig die Aufgabe den Fernsehgeräte Schnittstellen-Baustein, den Netzteil-Baustein, die RGB-, Synchron- und Ton-Signal Übertragung zum Fernsehgerät, den Anschlussstecker, den Cassettenschacht und die komplette Signalumschaltung im Fernsehgerät zu entwickeln übernommen.

Abb. 9: Grundig Super Play Computer SPC 4000 Hauptplatine. Der Schnittstellen-Baustein ist abgezogen um die Sicht auf die Grundplatte freizugeben.

Mikroprozessor und PVI

Das Gehirn der Schaltung bildete der 8Bit Mikroprozessor 2650A (Signetics/Philips). Er stand über Daten- und Adressbus mit dem ROM der Programm-Cassette und dem speziell für Bildschirmspiele entwickelten Programmierbaren Video Interface IC (PVI 2636 von Philips) in Verbindung. Dieses PVI stellte eine Art programmierbaren Generator für das Videosignal dar. Es verfügte über einen eigenen RAM-Speicher (Random Access Memory = Schreib-Lese-Speicher), in den vier sich bewegende Objekte (Autos, Flugzeuge etc.) und deren Duplikate sowie die Objektkoordinaten aus dem ROM-Programmspeicher übernommen werden konnten. Außerdem konnte durch das PVI eine aus waagerechten und senkrechten Balken gebildete Kulisse (siehe Spielfeld und Tennisnetz im Eingangsfoto) dargestellt werden. Ferner konnten mit dem PVI noch der Spielstand (Anzahl Fehler, Kilometerzähler usw.) angezeigt werden. Diese Anordnung von Mikroprozessor und PVI wurde als „objektorientiertes System“ bezeichnet, da nicht für jeden Bildpunkt (Pixel) des Bildschirms ein Speicherplatz benötigt wurde, sondern nur für die einzelnen Objekte, wie z.B. Ball, Auto, oder Flugzeug. Diese Objekte konnten dann durch die Veränderung ihrer horizontalen und vertikalen Koordinaten durch den Mikroprozessor über den ganzen Bildschirm verschoben werden.

So konnte dann beispielsweise die Flugbahn eines Tennisballs dargestellt werden. Dieses Konzept war unter anderem besonders gut für schnelle Bewegungsspiele geeignet. Auf RAM basierende Systeme, bei denen die Bewegung von Objekten durch fortwährendes Umschreiben des Bildspeichers erzielt wird, waren damals aufgrund der geringen Arbeitsgeschwindigkeiten (Taktfrequenz beim Mikroprozessor 2650A ca. 1MHz) und der hohen Speicherkosten für einen kompletten Bildspeicher nicht möglich. Bei den heute möglichen Taktfrequenzen und den entsprechend schnellen und kostengünstigen Speicherbausteinen kommt dieses Prinzip in jedem Desktop, Notebook, Tablet oder Smartphone zum Einsatz. Zum Vergleich der neueste Gaming Prozessor von Intel, der Core i9-9900K, hat eine Taktfrequenz von 3600 MHz (3,6 GHz). Eine ausführlichere Beschreibung der Funktionsweise des Grundig SPC 4000 hatte der Autor für die Grundig Technischen Informationen 4/1979 verfasst.

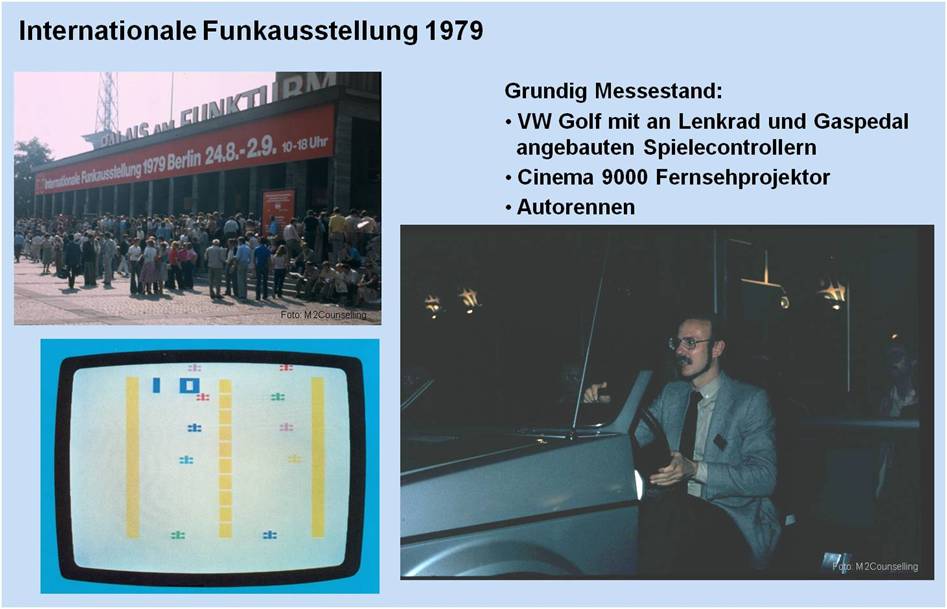

Grundig Super Play Computer SPC 4000 - ein Highlight der Internationalen Funkausstellung 1979

Grundig hatte, wie schon erwähnt die Super Color 80 Fernsehgeräteserie entwickelt. Diese Modelle der 66 cm Spitzenklasse, sowie der Fernsehprojektor Cinema 9000 waren mit Sicherheits-Bausteinen und dem erwähnten Cassetten-Schacht zum Anschluss des SPC 4000 ausgestattet. Auf der Internationalen Funkausstellung 1979 konnten die Besucher am Grundig Messestand alle verfügbaren Spiele ausprobieren.

Besonders spektakulär war der Aufbau mit dem Spiel „Grand Prix“ Autorennen. Auf einem Podium war die originale vordere Hälfte eines VW Golf montiert. An Lenkrad und Gaspedal waren die Spielecontroller angebaut. Der Spieler saß also in einem richtigen Auto mit Lenkrad und Gaspedal. Vor dem Golf war die Leinwand des Grundig Cinema 9000 Fernsehprojektors montiert (Abb.10). Viele Messebesucher drehten begeistert ihre Runden. Der erreichte Kilometerstand und die Fehlerzahl wurden notiert, zum Ansporn für die nächsten Testfahrer um den bisherigen Rekord zu brechen.

Abb. 10: „Grand Prix“ Autorennen auf der Internationalen Funkausstellung 1979. Damals am Steuer der Autor (Konrad Maul) in jüngeren Jahren.

Videospielen mit dem Heim- und Personalcomputer

Anfang der 1980er Jahre begann das Zeitalter der Homecomputer. Als Beispiel seien Apple II, Radio Shack TRS-80 und Commodore 64 genannt. Diese konnten zum Spielen und für andere Programme (z.B. Schreiben von Texten oder Programmieren in Basic) benutzt werden. Das schien den Kunden eine bessere Investition zu sein als ein System, das nur für Spiele geeignet war. Die Verkaufszahlen von Spielekonsolen und Cassetten sanken. Magnavox und andere Hersteller stoppten die Video Spiele Produktion. Grundig stoppte den Verkauf des SPC 4000. Atari kämpfte ums Überleben.

Auch in Franken wurde ein Heimcomputerkonzept entwickelt. Die Firma Triumph-Adler entwickelte die „alphatronic“, den persönlichen Computer zum Spielen und Lernen. Die Spiele für Homecomputer wurden zunächst von Digitalen Compact-Cassetten geladen, später dann von Floppy Disk und danach von der Daten CD. 1981 stellte IBM seinen legendären Personal Computer IBM 5110 in den USA vor. Die IBM Werbung dafür las sich so:

„Ein IBM Personal Computer kann Ihren Kindern helfen. Indem sie Spiele spielen oder Grafiken zeichnen wird Ihr Sohn oder Ihre Tochter entdecken wie ein Computer arbeitet und was er machen kann. Ihre Kinder mögen sogar Computer Smart werden und beginnen ihre eigenen Programme in Basic oder Pascal zu schreiben. Zu guter Letzt kann ein IBM Personal Computer eine der besten Investitionen in die Zukunft Ihrer Familie sein.“ Wer wollte da noch eine Spielekonsole kaufen und damit die Zukunft seiner Familie aufs Spiel setzen?

Renaissance der Spielekonsolen

Eine damals kleine japanische Firma zeigte, dass gegen Homecomputer und PC doch ein Kraut gewachsen war. 1985 stellte Nintendo sein Nintendo Entertainment System vor. Der Game Boy war geboren. Ein kleiner Computer mit Display, den man in der Hand halten konnte. Damit konnte man nun überall spielen. Der kommerzielle Erfolg übertraf alle vorigen Spielekonsolen. Die Video Games waren nun im Alltag angekommen.

Nach Nintendo brachten nun auch Sony und Microsoft Spielekonsolen auf den Markt. Allerdings für den stationären Betrieb im Heim und ohne Bildschirm. Aber warum konnte sich die Spielekonsole wieder am Markt etablieren? Da war die sehr einfache Bedienung. Im IT-Jargon als „turn key system“ bezeichnet, was bedeutet Einschalten und loslegen. Dann der trotz Spitzentechnologie in den Hardwarekomponenten attraktive Verkaufspreis, da die Hersteller den Hauptteil des Gewinnes mit Spieleprogrammen erzielen (Vermarktungskonzept wie bei Druckern). Und last but not least der Fernsehbildschirm kann als Monitor benutzt werden, man konnte also auch wieder im Wohnzimmer spielen. Und inzwischen ist mit dem Siegeszug der Smartphones das Video Gaming für jeden und zu jeder Zeit möglich. Es braucht nur die entsprechende App geladen zu werden.

Video Games in Virtual Reality (VR)

Den nächsten Technologiesprung stellte sicher die Anwendung von Virtual Reality Technik bei Video Games dar. Zur Einleitung sei vielleicht eine kurze Erklärung versucht. Nehmen wir das Duden Fremdwörterbuch zu Hilfe: „Virtuelle Realität: Von Computern simulierte, künstliche Welt, in die man sich mithilfe der entsprechenden Ausrüstung hineinversetzen kann.“ In Abb.11 sind in Stichpunkten die Merkmale der Virtual Reality dargestellt sowie ein Foto der Samsung Gear VR (mit Sennheiser Kopfhörer) zu sehen. Es kann in diesem Artikel nicht im Detail auf VR eingegangen werden.

Bei weiterem Interesse seihttps://www.m2counselling.de/3D_Virtual_Reality_Brille.htm empfohlen. Dort kann man sich auch 3D-Testbilder für das Smartphone herunterladen, die man dann z.B. mit der Google Card Box VR-Brille oder ähnlichen einfachen VR-Brillen für das Smartphone betrachten kann, um zumindest einen Eindruck der räumlichen Darstellung zu gewinnen. Aber zurück zum Video Gaming. Das mit Immersion bezeichnete Eintauchen in die Spielewelt bringt sicherlich ein ganz neues Erlebnis mit sich.

Eine Reihe von Spielen wurde regelrecht für die Virtual Reality Headset Technologie entwickelt. Exemplarisch sei hier nur Valkyrie von Eve angeführt, das vom Portal pcgamesn unter die besten VR-Games gewählt wurde (https://www.pcgamesn.com/best-vr-games). Valkyrie ist ein Multiplayer Dogfighting Shooter Game. Der Begriff Dogfighting wurde im ersten Weltkrieg geprägt und bedeutete im Luftkampf das Duell zweier Piloten. Heute sitzen virtuelle Piloten anstatt in Jagdflugzeugen in Raumgleitern. Wenn wir kurz auf den SPC 4000 zurückblicken, dann gab es 1979 auch schon die „Cassette 7 Luftkampf“. Warum solche Spiele so beliebt waren und immer noch sind wollen wir lieber der Psychologie überlassen.

Abb. 11: Virtual Reality: Gaming mit 3D Bild und 3D Ton.

Ausblick: Zukünftige Spielewelten

In der Science Fiction Serie Star Trek „The Next Generation“ ist das Holodeck ja schon erfunden und realisiert. Also eine Technik mit der sich die Besatzung in verschiedene Umgebungen versetzen und dort auch handeln kann. Wir haben ja schon über die Möglichkeiten der Virtual Reality Games gesprochen. Aber bisher (Stand 2022) ist es damit nicht möglich, wenn z.B. in der Spielewelt eine Tür zu öffnen ist auch das haptische Empfinden zu vermitteln. Nehmen wir an ich werde in einer Star Wars Spielhandlung verfolgt und die Stormtroopers sind mir schon auf den Fersen und dann komme ich an eine Tür, die mit einem elektronischen Zahlenschloss verriegelt ist. Ich muss eine Zahlenkombination eingeben. Aber in der bisherigen VR-Technik greift meine Hand ins Leere. Keine Tasten und keine Tür zu spüren.

Abhilfe schafft hier die Firma „The Void“, die begehbare Virtual Reality Spielewelten ermöglicht, die über typische VR-Brillen Erfahrungen hinausgehen. Die erste „The Void“ Erfahrungswelt wurde 2016 bei Madam Tussauds in New York eröffnet. Die neueste VR Erfahrungswelt hat das Thema „Star Wars: Secrets of the Empire“ und wurde in Zusammenarbeit mit der Walt Disney Company kreiert. (Zu sehen an verschiedenen Locations in USA.) Was ist nun das Neue bei „The Void“? Die Spieler tragen ein VR Headset mit Kopfhörern und eine Art Rucksack, in dem ein Hochleistungsrechner eingebaut ist. Das wirklich Neue ist, dass dort, wie oben beschrieben, wo in der Spielhandlung eine Tür ist wirklich eine Tür zu ertasten ist. D.h., bei „The Void“ werden die Räumlichkeiten und das Inventar, in denen sich die Spielhandlung abspielt in groben Abmessungen nachgebaut. Die feinen Details generiert dann der Rechner für den Spieler.

Über das „The Voids fully immersive Star Wars VR“ Erlebnis urteilt time.com: „Diese Kerle haben praktisch ein Holodeck geschaffen.“ Na ja eine Spielhandlung macht noch kein Science Fiction Holodeck. Es gibt also noch viel Raum für zukünftige Entwicklungen, die das Eintauchen in virtuelle Spielewelten perfektionieren könnten. Wir dürfen also gespannt sein was uns die Zukunft beim Gaming noch bringen wird.

4. Der Weg zur naturgetreuen Bildwiedergabe

Die räumliche Bildwiedergabe (3D / Stereo Vision / Stereopsis)

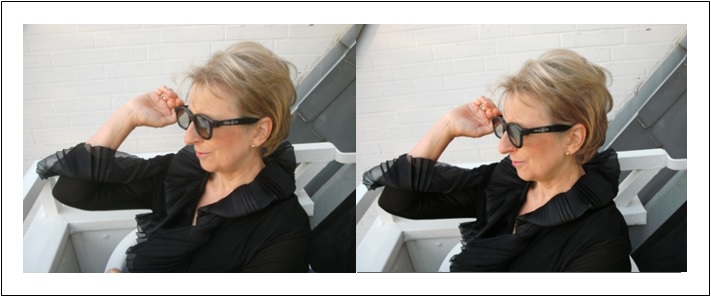

Beispiel für ein Stereobildpaar; Ansicht des linken und rechten Auges; am Galeriebrüstungsansatz ist die unterschiedliche Perspektive gut zu erkennen.

Einführung

Dem Traum der Menschen von einer naturgetreuen Übertragung und Wiedergabe von Szenen und Ereignissen in die eigenen vier Wände kommen heutige Fernsehgeräte mit neuester Signalverarbeitung und Displaytechnologie schon sehr nahe. Der flache Bildschirm an der Wand ist Realität geworden. Die großformatige, detailgetreue Wiedergabe, angepasst an die Physiologie des menschlichen Gesichtssinnes durch 16:9 und HDTV ermöglicht eine bisher nicht gekannte Einbezogenheit in das Geschehen auf dem Bildschirm (Telepräsenz). Nun fehlt den hochauflösenden Bildern nur noch die dritte Dimension der realen Welt d.h. die räumliche Darstellung.

In vielen Abhandlungen und Artikeln über das räumliche Sehen wird von einem naiven Verständnis dieses physiologischen Prozesses ausgegangen. Man bietet den Augen einen linken und rechten Bildauszug an und schon entsteht ein räumlicher Bildeindruck. Dies wird der Komplexität des Systems Auge-Gehirn in keiner Weise gerecht. Deswegen möchte ich den Versuch unternehmen zunächst die physiologischen Grundlagen etwas abzuklären.

Physiologische Hintergründe / System Auge-Gehirn

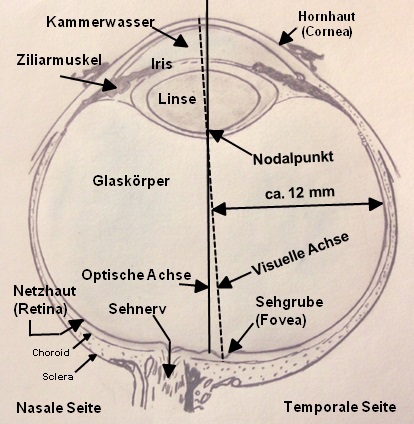

Ein horizontaler Querschnitt durch das menschliche Auge ist in Abb. 2 zu sehen.

Horizontaler Schnitt durch das rechte menschliche Auge.

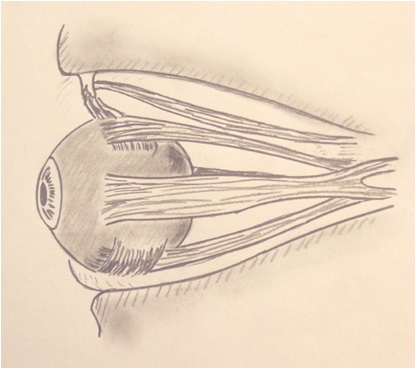

Das menschliche Auge ist annähernd kugelförmig mit einem Durchmesser von ca. 24 mm. Die Hornhaut (Cornea) hat einen Durchmesser von ungefähr 12 mm und einen Kurvenradius von ca. 8 mm. Es wird oft angenommen, dass die Linse dazu dient, die einfallenden Lichtstrahlen zu bündeln und das Bild auf der Netzhaut (Retina) zu erzeugen. Der Ort an dem beim menschlichen Auge die Lichtstrahlen am stärksten gebrochen werden ist aber die Vorderseite der Cornea. Dies ist darin begründet, dass die Brechkraft einer Linse grundsätzlich von dem Unterschied zwischen den Brechungskoeffizienten des umgebenden Mediums und dem des Linsenmaterials bestimmt wird. Der Brechungskoeffizient der Luft ist niedrig, während der des Kammerwassers hinter der Cornea annähernd so hoch wie der Brechungskoeffizient der Linse des Auges ist. Dadurch hat die Cornea mit ca. 42 Dioptrien ungefähr 70% der Brechungskraft des gesamten Auges. Die Linse besitzt einen Durchmesser von ca. 9 mm und ist ungefähr 4 mm dick. Die Brechkraft der Linse kann durch den Ziliarmuskel um ca. 10 Dioptrien verändert werden und sorgt durch Verstellung (Akkommodation) dafür, dass das Netzhautbild bei entfernten und nahen Objekten scharf gestellt werden kann. Damit hat das Gesamtsystem Cornea-Linse eine Brechkraft die von ca. 60 bis zu 70 Dioptrien variiert werden kann. Als visuelle Achse (Mittelpunktstrahl) wird die Verbindungslinie zwischen einem Punkt eines fixierten Gegenstandes und dem Zentrum der Sehgrube (Fovea centralis) bezeichnet. Als optische Achse wird der am besten passende Strahl durch die vier brechenden Oberflächen des Auges bezeichnet. Die optische Achse schneidet die Retina ca. 1,5 mm seitlich entfernt von der Sehgrube und ca. 0,5 mm über der Sehgrube. Sie bildet somit mit der visuellen Achse einen Winkel von ca. 5°. Beide Achsen müssen gemäß den optischen Gesetzen durch den resultierenden Knotenpunkt /Nodalpunkt (nodal point) des optischen Systems Auge gehen. Dieser liegt beim nicht akkommodierten Auge ca. 17 mm vor der Retina und durch ihn gehen alle Strahlen die eine eins zu eins Abbildung der Punkte des Sehfelds auf der Netzhaut reproduzieren. Die Iris (Regenbogenhaut) in Verbindung mit den Irismuskeln kontrolliert die Linsenöffnung des Auges (Apertur, Pupillengröße). Oft wird angenommen, dass die Veränderung der Pupillengröße dem Auge erlaubt, ein breites Spektrum von Lichtintensitäten auszunutzen. Da sich ihre Fläche aber nur in einem Verhältnis von 16:1 verändert, kann dies nicht ihre Hauptaufgabe sein, da das Auge einen Helligkeitsbereich von mehr als 1.000.000 : 1 zu nutzen imstande ist. Offensichtlich kontrahiert die Pupille, um die Lichtstrahlen auf den zentralen und optisch effektivsten Teil der Linse zu beschränken und damit Linsenfehler zu minimieren. Die maximale Öffnung wird nur dann eingestellt wenn maximale Empfindlichkeit benötigt wird. Jedes Auge wird von sechs Muskeln bewegt wie in Abb. 3 dargestellt.

Augenmuskeln des linken menschlichen Auges.

Dies ist erforderlich, da der Mensch nur in der Sehgrube ein hohes Auflösungsvermögen der Netzhaut besitzt und dadurch die Augen bewegt werden müssen um auszuwählen was scharf gesehen werden soll. Wird ein Objekt betrachtet, so konvergieren beide Augen sodass die Abbildung unabhängig von der Entfernung des Objektes auf der Sehgrube zentriert wird. Die Augenmuskeln schwenken dabei die Augäpfel um den Rotationsmittelpunkt jeweils in Richtung der Nase hin (nasal). Wie wir noch sehen werden wird dieser Konvergenzwinkel auch als einer von vielen Parametern zur Ermittlung des Raumeindruckes vom Gehirn genutzt.

Bildsensor Netzhaut (Retina) - Außenstelle des Gehirns

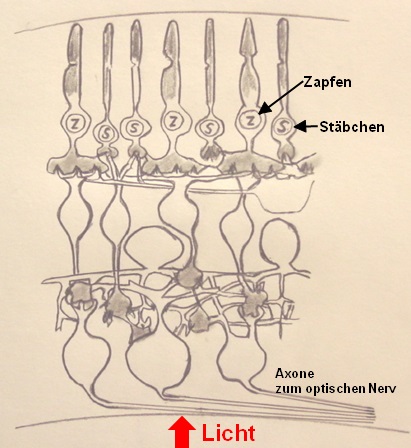

Die Struktur der Netzhaut ist in Abb. 4 aufgezeigt.

Abb. 4: Die Struktur der Netzhaut.

Diese Struktur wurde zuerst von Ramón y Cajal ermittelt und in einer Serie von Abhandlungen zwischen 1888 und 1933 beschrieben. Die Netzhaut ist eine mehrlagige Membran mit einer Fläche von ungefähr 1000 mm². Sie weist in der Sehgrube eine Dicke von etwa 250 µm auf, die in der Peripherie auf ca. 100 µm abnimmt. Die Fotorezeptoren sind dicht gepackt in der äußeren Schicht, also der Schicht die am weitesten von der Lichtquelle entfernt ist. Das bedeutet, dass das Licht vor dem Erreichen der Rezeptoren durch die Blutgefäße und das feine Netzwerk der Nervenfasern, einschließlich dreier Schichten von Zellkörpern und einer Menge Stützgewebe, dringen muss. Es gibt zwei Arten von Fotorezeptoren. Die Stäbchen haben eine sehr hohe Lichtempfindlichkeit, breite spektrale Abstimmung und sind ausschließlich in der Peripherie, also außerhalb der Sehgrube, verteilt. Sie werden für die Wahrnehmung der Schwarz/Weiß-Helligkeitsempfindung genutzt. Die Zapfen, die für die Farbwahrnehmung genutzt werden, haben eine niedrigere Lichtempfindlichkeit und eine hohe Dichte in der Sehgrube, die in der peripheren Netzhaut abnimmt. Es gibt drei Typen von Zapfen mit jeweils verschiedener spektraler Empfindlichkeit: S-Zapfen mit einer maximalen Empfindlichkeit bei ungefähr 450 nm Lichtwellenlänge (blau). M-Zapfen mit einer Spitzenempfindlichkeit von ca. 535 nm (grün). L-Zapfen mit einem Maximum bei 565 nm (gelb/rot). 5 bis 10% der Zapfen sind S-Zapfen. M- und L-Zapfen sind etwa gleich häufig verteilt.

In dieser Struktur liegt auch die Basis, die unsere technischen Fernsehsysteme bei der Redundanz-Datenreduktion benutzen, bei der keine sichtbaren Verluste entstehen. So kann z.B. die Digitalisierung der Farbinformation mit einer geringeren Datenrate erfolgen als der für die Helligkeitswerte erforderliche Wert. Der normale Bereich der Lichtempfindlichkeit des menschlichen Auges erstreckt sich über drei logarithmische Einheiten von 0,0000007 cd/m² bis 0,0004 cd/m². Die Helligkeit von äußeren Stimuli variiert um ca. 10 logarithmische Einheiten (log). Spezielle Mechanismen kompensieren den begrenzten dynamischen Bereich des Auges. Um einen Vergleich der örtlichen Auflösung (Wiedergabe von Details) des menschlichen Auges mit technischen Bildwiedergabesystemen ziehen zu können sind die folgenden Werte des menschlichen Auges wichtig.

Die Retina des erwachsenen Menschen hat zwischen 4 und 6 Millionen Zapfen mit einer Spitzendichte von 100 000 bis 320 000 pro mm² in der Sehgrube. Diese nimmt in der Peripherie stark ab auf z.B. 6000 pro mm² bei 10° Exzentrität. Die Fovea ist eine Grube von ungefähr 1,5 mm Durchmesser, die ein regelmäßiges hexagonales Mosaik von Zapfen im Abstand von 2 bis 3 µm enthält. Die zentrale Sehgrube (Fovea centralis) hat einen Durchmesser von ca. 0,27 mm, was einem Öffnungswinkel (subtend) von ca. 1° entspricht, und enthält ca. 6000 Zapfen. Die menschliche Retina hat mehr als 100 Millionen Stäbchen, die in der Fovea nicht vorhanden sind. Die Fotorezeptoren der Netzhaut bilden 70% der Rezeptoren des menschlichen Körpers.

Wenn wir den Vergleich zu unserem modernen hochauflösenden Fernsehen ziehen (HDTV) dann besitzt das Display ca. 2 Millionen Bildpunkte, die jeweils aus einem roten, grünen und blauen Subpixel bestehen. D.h. insgesamt sind nur ca. 6 Millionen Bildpunkte vorhanden, die gleichmäßig über die gesamte Displayfläche verteilt sind. Beim menschlichen Auge sorgen dagegen die 100 Millionen Stäbchen, die insbesondere sehr empfindlich auf bewegte Objekte reagieren, dafür dass die Objekte denen unsere jeweilige Aufmerksamkeit gilt, durch die entsprechenden Augenbewegungen scharf auf der Fovea mit höchster Auflösung abgebildet werden können. Die Natur hat das, was wir heute in der Fernsehtechnik mit Telepräsenz bezeichnen schon in idealer Weise realisiert.

Man hat die Retina als eine Art Ausstülpung des Gehirns beschrieben. Entwicklungsgeschichtlich spezialisierte sich also ein Teil der Gehirnoberfläche, wurde nach außen verlagert und lichtempfindlich. Die Retina hat bei diesem Prozess typische Gehirnzellen beibehalten, die zwischen den Lichtrezeptoren und den Sehnervenfasern, also in den vorderen Schichten der Netzhaut liegen, und die elektrische Aktivität der Rezeptoren stark modifizieren. D.h. ein Teil der Wahrnehmungssignalverarbeitung findet bereits im Auge statt. Damit wird dieses auch funktional ein Bestandteil des Gehirns. Diese Vorverarbeitung führt die über 100 Millionen Rezeptorsignale auf ca. 1 Million Sehnervenfasern zusammen. Dadurch kann sich die Dicke des Sehnervs stark verringern, was Augenbewegungen erst ermöglicht.

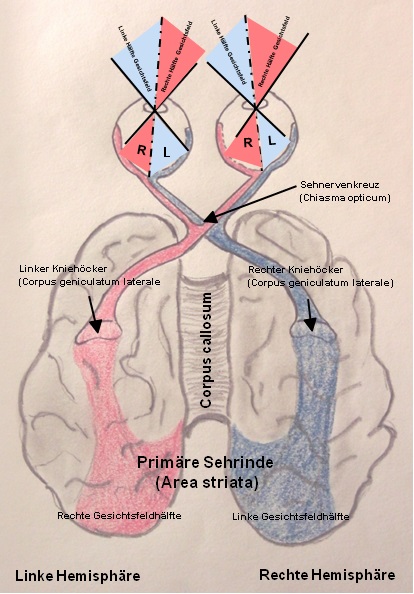

Bilddatenübertragung (Chiasma opticum , primäre Sehrinde)

Das für das Sehen verantwortliche neuronale System beginnt, wie oben gezeigt, schon mit der unglaublich komplexen Struktur der Netzhäute. Jede Netzhaut ist senkrecht in zwei funktionale Hälften geteilt. Die Sehnervenfasern der inneren (nasalen) Hälfte wechseln am Sehnervenkreuz (Chiasma opticum) auf die andere Seite um zur gegenseitigen Hirnhemisphäre zu ziehen (Abb. 5).

Abb. 5: System Auge/Gehirn von oben gesehen. Schema der Sehbahnen, das die linken und rechten Gesichtsfeldhälften mit den retinalen Bildern und der teilweisen Kreuzung im Sehnervenkreuz zeigt.

Die Fasern der äußeren Netzhauthälfte gelangen zur gleichseitigen Hemisphäre. Am jeweiligen seitlichen Kniehöcker, quasi einer Relaisstation, sind die Sehnerven dann an die jeweilige Hemisphäre angeschlossen. Interessanterweise empfangen die Kniehöcker mehr „absteigende“ Bahnen von höheren Zentren des Gehirns als aufsteigende Bahnen von den Augen. Dies ist die anatomische Basis dafür, dass höhere Zentren des Gehirns die von den Netzhäuten kommenden Signale beeinflussen oder erweitern und damit die Netzhautbilder deuten.

Bildsignalverarbeitung im Gehirn (visuelle Merkmale in spezialisierten Modulen)

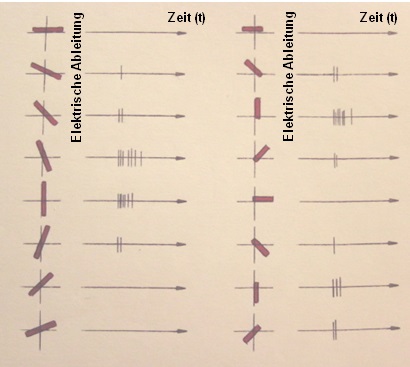

Zu einer der wichtigsten Entdeckungen bezüglich der visuellen Signalverarbeitung im Gehirn gehört die der beiden amerikanischen Physiologen David Hubel und Torsten Wiesel. Sie registrierten bei der Katze die Aktivität einzelner Zellen der Sehrinde, während den Katzenaugen einfache visuelle Formen, meist Lichtbalken, angeboten wurden. Dies geschah mittels eines Diaprojektors, der diese Muster auf einen Schirm vor der Katze projizierte. Hubel und Wiesel stellten fest, dass einige kortikale Zellen der ersten Verarbeitungsstufe nur dann aktiv waren (feuerten), wenn ein Balken in einem ganz bestimmten Winkel angeboten wurde (Abb. 6).

Abb. 6: Hubels und Wiesels Ableitungen von einzelnen Zellen im visuellen Cortex der Katze.

Bei anderen Winkeln blieb diese Zelle stumm. Die zur Aktivierung erforderliche Neigung des Balkens wechselte von Zelle zu Zelle. Weiterhin stellten Sie fest, dass manche Zellen sich nur durch Bewegung aktivieren ließen oder nur durch Bewegung in eine bestimmte Richtung. Der Professor für Neuropsychologie Richard L. Gregory schreibt: „Es wird immer deutlicher, dass das Gehirn visuelle Merkmale in spezialisierten „Modulen“ verarbeitet, wobei es unterschiedliche neuronale Kanäle für Form, Bewegung, Tiefenwahrnehmung, Farbe usw. gibt. Allmählich kristallisiert sich die Organisation der Sehrinde heraus, wenn auch noch immer unklar ist, wie sie mit dem Sehen komplexer Objektformen verknüpft ist. Vielleicht werden wir das visuelle Gehirn erst dann vollständig verstehen, wenn es uns gelingt, eine Maschine zu entwerfen und zu konstruieren, die über ein komplexes Sehvermögen verfügt.“

Disparationsneuronen

Die Tiefenwahrnehmung ist im Prinzip abhängig von Ungleichheiten (Disparität) der beiden Abbildungen auf den beiden Netzhäuten, die durch den 50 bis 70 mm betragenden Augenabstand entstehen. Sie kann auch als eine Täuschung betrachtet werden, weil es auf der Retina nur ein zweidimensionales Bild gibt. Dieses wird aber so interpretiert als ob es aus einem dreidimensionalen Objekt resultieren würde. Mit dem Entstehen dieser Täuschung befasst sich die psychologische und physiologische Forschung der visuellen Wahrnehmung.

Raymòn y Cajal hatte schon 1911 die Theorie entwickelt, dass Eingangssignale von korrespondierenden Bereichen der beiden Netzhäute in den von ihm mit „isodynamic cells“ bezeichneten neuronalen Zellen zusammengeführt würden und damit die Basis für das binokulare Sehen gebildet würde. Diese Idee wurde von David Hubel und Torsten Wiesel (1959; 1962) experimentell verifiziert. Sie berichteten dass Paare von Sehnervenbahnen der Katze in „binokularen“ Zellen in dem Teil der Hirnrinde, der visuelle Signale verarbeitet (visueller Cortex), zusammenlaufen. Und dass die rezeptiven Felder jeder „binokularen“ Zelle korrespondierende Positionen in den beiden Augen besitzen. Wenn eine „binokulare“ Zelle identische rezeptive Felder hätte werden, die in jedem Auge identisch positioniert wären, würde diese optimal auf Netzhautbilder (Stimuli) mit null Disparität reagieren und keine Tiefeninformation könnte am Ausgang der Zelle gewonnen werden. Das war schon ein Argument das der Physiologe, Physiker und Psychologe Hermann von Helmholtz gegen die Idee von konvergenten visuellen Eingangssignalen angeführt hatte. Helmholtz neigte zu der Auffassung, dass die räumliche Wahrnehmung ein erlernter Prozess sei und sich in den „höheren“ Verarbeitungsschichten des Gehirns abspielen würde.

Der Psychologe Ian P. Howard schreibt dazu in „Seeing in Depth“: „Das Problem würde gelöst werden können wenn es Zellen gäbe, die speziell darauf abgestimmt wären, auf ähnliche Bilder in leicht unterschiedlichen Positionen der beiden Retinae, zu reagieren. Unterschiedliche Zellen die optimal auf differente Disparitäten abgestimmt sind. Einfach wie diese Idee klingt wurde diese bis 1965 nicht vorgeschlagen. Wahrscheinlich weil die Idee einer auf spezifische Stimuli-Eigenschaften reagierenden kortikalen Zelle nicht „en vogue“ war, bis 1959 Hubel und Wiesel kortikale Zellen entdeckten, die abgestimmt waren auf Ausrichtung und Bewegung zu reagieren. Hubel und Wiesel gelang es nicht Zellen zu finden, die sensitiv auf Disparitäten reagierten.

Jack Pettigrew lieferte den ersten Beweis von Disparitäts-Detektoren in einer frühen Stufe der visuellen Signalverarbeitung. Er machte diese Arbeit im Rahmen seiner „undergraduate thesis“, die er 1965 an der Universität von Sydney geschrieben hat.“ In vielen weiteren Arbeiten wurde diese Theorie der „Disparationsneuronen“ inzwischen bestätigt.“ Marr und Poggio haben 1979 basierend auf diesen neuronalen Fakten ein erstes nachrichtentechnisches Signalverarbeitungsmodell (A Computational Theory of Human Stereo Vision) entwickelt. Inwieweit solche Modelle die tatsächlichen Mechanismen der höheren Hirnprozesse abbilden, konnte aufgrund deren ungeheuren Komplexität bisher noch nicht gezeigt werden.

Sehen in der Tiefe (Disparation, Konvergenz, monokulare Informationen)

Nachdem wir mit den Disperationsneuronen quasi die unterste Ebene des Tiefensehens kennengelernt haben wollen wir uns auf der Ebene der Wahrnehmungspsychologie mit dem Sehen in der Tiefe beschäftigen.

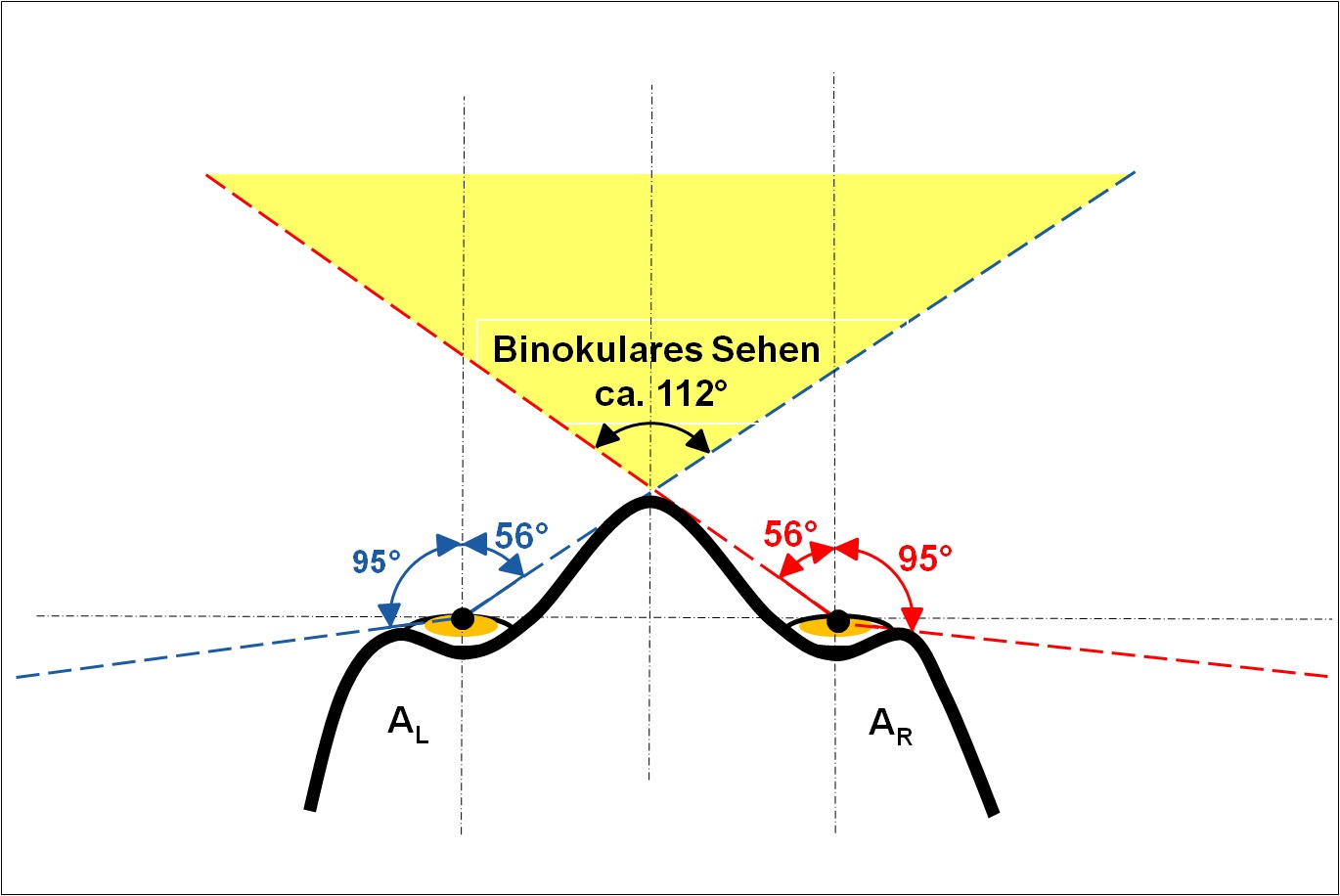

Das menschliche horizontale Blickfeld ist in Abb. 7 dargestellt.

Abb. 7: Das binokulare Gesichtsfeld des Menschen.

Das monokulare Gesichtsfeld des statischen Auges beträgt ungefähr 95° in Richtung der Schläfe (temporal) und ungefähr 56° in Richtung der Nase. Das gesamte Gesichtsfeld ist der volle Winkel der ausgehend von einem Punkt in der Mitte zwischen beiden Augen alle Punkte im Raum einschließt, die entweder einem Auge oder beiden Augen sichtbar sind. Beim Menschen beträgt dieses horizontale Gesichtsfeld (lateral) bei feststehenden Augen ca. 190° und erreicht 290° wenn die Augen seitlich bewegt werden können. Das binokulare Gesichtsfeld ist der Teil des gesamten Gesichtsfeldes innerhalb dessen ein Objekt liegen muss um für beide Augen sichtbar zu sein (bei fester Augenposition). Das binokulare Gesichtsfeld ist von den monokularen Sektoren des linken und rechten Auges flankiert. Jeder monokulare Sektor erstreckt sich ungefähr 37° seitlich (lateral) vom Schläfenring bis zur Grenze des binokularen Sektors. Die rechte und linke Grenze des binokularen Sehens wird durch die Nase geformt. Für binokulares Sehen ergibt sich daraus ein Winkel von ca. 112°, wenn die Augen symmetrisch konvergieren.

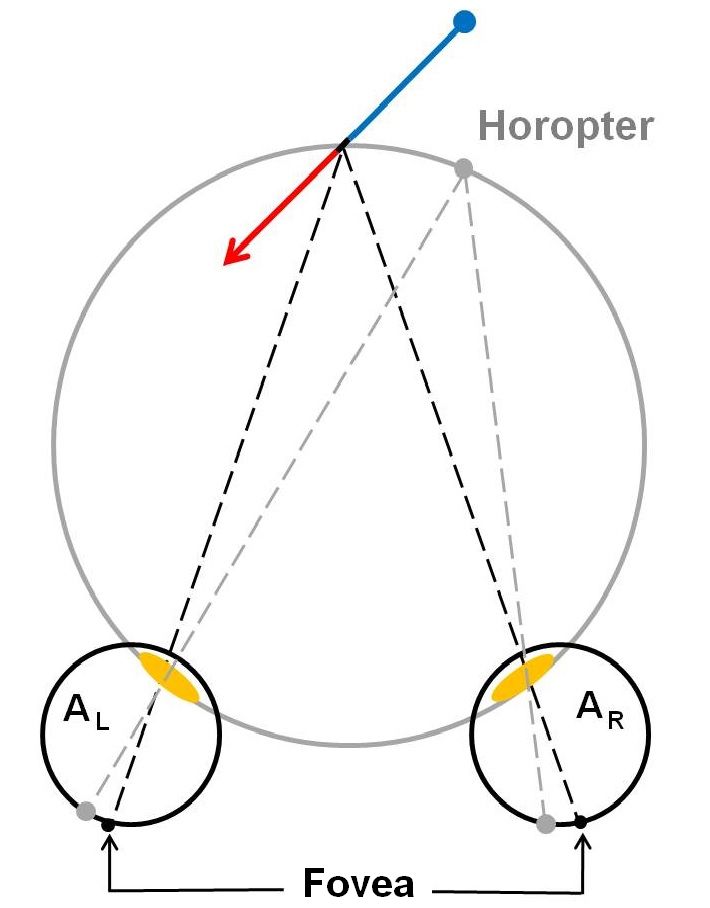

Betrachten wir zunächst die geometrische Basis. Weil die beiden Augen horizontal um den Augenabstand voneinander getrennt sind, sehen diese dieselbe visuelle Szene von zwei unterschiedlichen Ausgangspunkten. Wenn wir einen speziellen Punkt im Raum, wie z.B. den schwarzen Punkt auf dem Pfeil in Abb. 8A fixieren, sorgen wir dafür dass das Abbild dieses Punktes in die Sehgrube (Fovea) des linken und des rechten Auges fällt, also in die Region der Netzhaut mit der höchsten Auflösung.

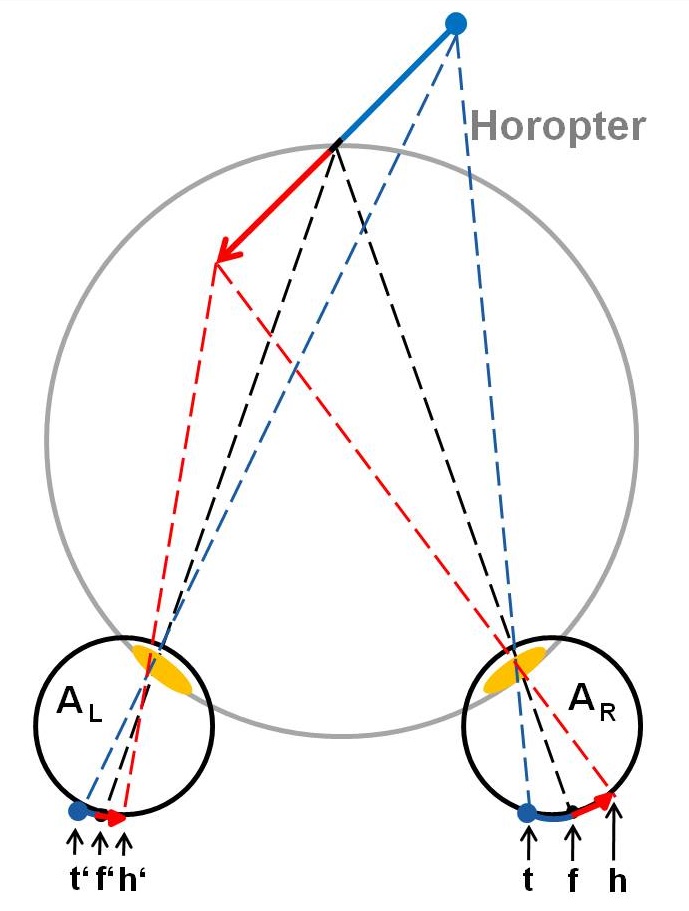

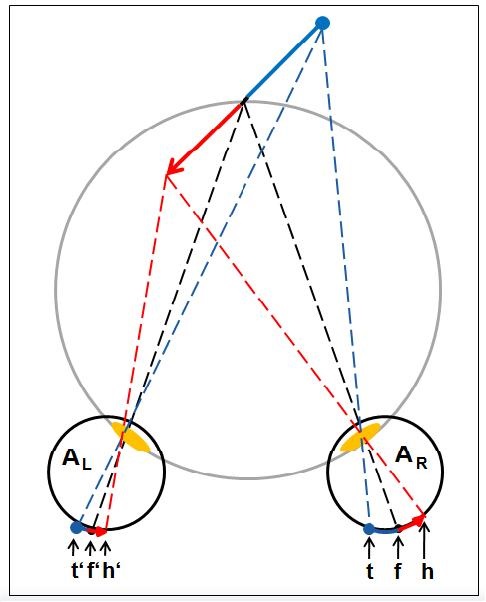

Abb. 8A: Die Geometrie der Stereopsis.

Horizontaler Schnitt durch das rechte (AR) und linke Auge (AL) von oben gesehen. Auf dem Horopter liegende Punkte produzieren Abbildungen auf korrespondierenden Punkten der beiden Netzhäute. Als Horopter wird die kreisförmige horizontale Linie bezeichnet auf der alle Punkte liegen, die bei gegebener Augenstellung mit beiden Augen nur einfach gesehen werden.

Abb. 8B: Die Geometrie der Stereopsis.

Horizontaler Schnitt durch das rechte (AR) und linke Augen (AL) von oben gesehen. Punkte auf dem Pfeil, die nicht auf dem Horopter liegen, mit verschiedenen Abständen vom Beobachter produzieren Abbildungen mit verschiedenen Abständen von der Fovea auf den zwei Netzhäuten. Diese Differenz wird binokulare Disparität genannt und ist die Basis für die allgemein bekannteste Art der Tiefenwahrnehmung.

Dazu schwenken die Augenmuskeln die Augen in den jeweils entsprechenden Winkel (Konvergenz) und der Muskel der Augenlinse sorgt durch Akkommodation (Veränderung der Brennweite) für eine scharfe Abbildung. Dieser Akt definiert die horizontale Fixierungskurve. Wenn wir auf diesem schwarzen Punkt des Pfeiles starten und uns eine bestimmte Distanz auf dem grauen Kreis bewegen werden sich die Projektionen des neuen Punktes in den beiden Augen um die exakt gleiche Distanz auf den beiden Netzhäuten bewegen. Diese Projektionspunkte auf den beiden Retinae werden als „korrespondierende Punkte“ bezeichnet. Der „geometrische Horopter“ ist die Zusammenfassung all der Punkte eines Bildes, die auf „korrespondierende Punkte“ auf den Retinae projizieren. Für einen Beobachter dieser Punkte erscheint es so als ob alle diese Punkte ungefähr in derselben Tiefe wie der Fixierungspunkt liegen würden. Die Menge aller Punkte die exakt in derselben Tiefe erscheinen wird als „empirischer Horopter“ bezeichnet und ist etwas flacher als der kreisförmige „geometrische Horopter“. Für prinzipielle Überlegungen kann zur Vereinfachung mit dem „geometrischen Horopter“ gearbeitet werden.

Betrachten wir nun Teile des Objektes die entweder vor oder hinter dem „Geometrischen Horopter“ liegen, wie zum Beispiel Spitze und Schwanz des Pfeils in Abb. 8B. Diese Objektpunkte werden nicht auf „korrespondierende Punkte“ der Retinae projizieren, weil die Distanz von f nach h auf der rechten Netzhaut nicht gleich der Distanz von f‘ nach h‘ auf der linken Netzhaut ist. Diese Differenz der Netzhaut-Kreisbögen (hf-h’f‘) wird als „binokulare Disparität“ bezeichnet und meist als Bogenmaß oder Winkel angegeben. Die Projektionslinien für Punkte auf der Netzhaut für nahe Objekte kreuzen sich vor dem Horopter und produzieren was man als „gekreuzte Disparitäten“ bezeichnet und umgekehrt produzieren weit entfernte Objekte, wie z.B. der Schwanz des Pfeils in Abb. 8B, „nicht gekreuzte Disparitäten“.

Wenn die retinalen Disparitäten, die ein Objekt produziert, in einen begrenzten Bereich fallen (ungefähr 0,5° in der Nähe der Fovea, etwas mehr bei einer größeren Exzentrizität), wird es als ein einzelnes verschmolzenes Objekt mit Tiefe erscheinen. Außerhalb dieses Bereiches, der als „Panums“ Verschmelzungsbereich bekannt ist, wird das Objekt doppelt erscheinen. Dem Beobachter wird dann jedes der beiden retinalen Bilder bewusst, was dann als „Doppeltsehen“ bezeichnet wird. Trotzdem kann das visuelle System sinnvolle Tiefeninformationen bis zu binokularen Disparitäten von einigen Grad extrahieren, in Abhängigkeit von der Größe des Objektes.

Es ist zu bemerken, die obige Diskussion vorausgesetzt, dass man wissen muss wie zur Abbildung eines Objektes im rechten Auge die passende Abbildung des gleichen Objektes im linken Auge gefunden wird. Dies stellt ein schwieriges Problem dar und ist im Bereich der Bilddatenverarbeitung als „Correspondence Problem“ bekannt. Dieses Problem ist äußerst schwierig, wenn man versucht die einzelnen korrespondierenden Punkte (pixel) auf den zwei retinalen Bildern zu finden (weil es eine große Zahl von Übereinstimmungen gibt). Diese Problemstellung wird leichter handhabbar wenn man lokale Felder von Punkten, z.B. kurze Liniensegmente zum Finden der Übereinstimmungen heranzieht. Zusätzlich ist es wahrscheinlich dass Bildeigenschaften höherer Ordnung, wie z.B. die globale Form eines Objektes, dazu benutzt werden die lokalen Objektübereinstimmungen zu erhärten.

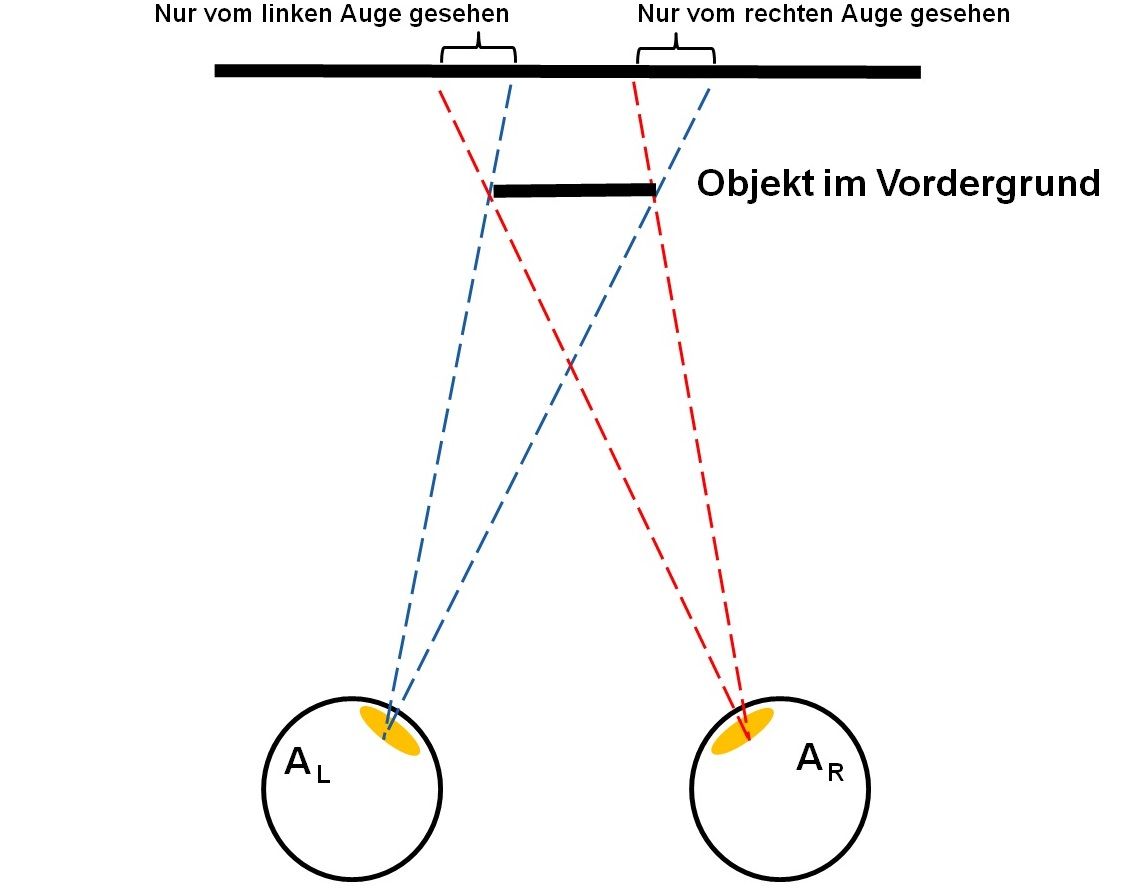

Es gibt noch eine andere Art von Stereopsis bekannt als „da Vinci Stereopsis“ (benannt nach Leonardo da Vinci, der diese zuerst beschrieben hat), die die Benutzung von nicht gepaarten Bereichen der Abbilder in den beiden Retinae der beiden Augen beinhaltet. Dies kommt bei der Überdeckung von Objekten vor. Prinzipiell deswegen, weil das Auge nicht um Objekte herum sehen kann. Ein Objekt in der Form eines Quadrats im Vordergrund wird einen vertikalen Streifen des Hintergrundes auf der linken Seite verursachen der nur durch das linke Auge (AL) gesehen werden kann. Auf der rechten Seite wird dieses quadratische Objekt einen Streifen verursachen, der nur mit dem rechten Auge (AR) gesehen werden kann (Abb.9). Diese Art von Stereopsis ist ebenfalls für die Tiefenwahrnehmung nützlich, speziell zur Definition der Verdeckung. Wir wollen hier aber nicht näher auf die „da Vinci Stereopsis“ eingehen.

Abb. 9: Die Basis der „da Vinci Stereopsis“

Horizontaler Schnitt durch das rechte (AR) und linke Auge (AL) von oben gesehen. Ein im Vordergrund vorhandenes Objekt hat zur Folge, dass Bereiche im Hintergrund jeweils nur von einem Auge gesehen werden können.

Räumliche Auflösung des binokularen Sehens (Stereopsis)

Weil die elementaren Daten mit denen das Gehirn arbeiten muss die binokularen Disparitäten sind, wird die kleinste Tiefendifferenz die unterschieden werden kann durch die kleinste retinale Disparität die aufgelöst werden kann bestimmt. Bei menschlichen Beobachtern, erreicht diese Differenz 5 Bogensekunden (entsprechend 0,0014°), wenn das beobachtete Objekt auf der Fovea abgebildet wird. Dies ist eine wahrlich bemerkenswerte Präzision, wenn man bedenkt dass der Abstand zwischen den Zapfen auf der Fovea in der Größenordnung von 30 Bogensekunden liegt.

Die binokulare Disparität, die sich bei einer gegebenen Tiefendifferenz ergibt, variiert mit dem inversen Quadrat der Distanz zum Objekt. Das bedeutet, dass bei nahen Objekten äußerst kleine Tiefendifferenzen unterschieden werden können. Das können bis zu 25 µm sein, was ungefähr der Dicke eines feinen menschlichen Haares entspricht. Auch bei relativ großen Objektentfernungen kann das binokulare Sehen eine Rolle spielen, vorausgesetzt die Tiefe des Objektes ist groß genug. Für eine Entfernung von 100 m z.B. beträgt die minimale auflösbare Tiefe ungefähr 4 m (Ponce 2008)

Andere Parameter für Tiefenwahrnehmung (monokulare Parameter)

Einem signifikanten Anteil der menschlichen Population (ungefähr 5 bis 10%) fehlt die stereoskopische (binokulare) Tiefenwahrnehmung. Man müsste annehmen, dass diese Personen bezüglich ihrer Sehfähigkeit stark behindert wären. Dies ist aber nicht der Fall. Einige von ihnen haben in Berufen Karriere gemacht für deren Ausübung man eine gute räumliche Einschätzung annehmen muss, wie z.B. Chirurgie, Zahnmedizin und professionelles Skifahren. Der Grund dafür ist wahrscheinlich dass es eine Anzahl von anderen Methoden zur Erhaltung von Tiefeninformation gibt. Eine der nützlichsten Verfahren ist durch Kopfbewegungen quasi mehrere Ansichten über die Zeit zu erhalten und damit eine „Bewegungs-Parallaxe“ zu produzieren. Wenn man seinen Kopf in dieser Art bewegt werden Objekte, die sich näher als der Fixierungspunkt befinden, als sich in die Gegenrichtung der Kopfdrehung bewegend wahrgenommen. Objekte, die weiter als der Fixierungspunkt entfernt sind, werden als sich mit der Kopfbewegung bewegend wahrgenommen. Die Geschwindigkeit der wahrgenommenen Bewegung indiziert die Größe der Tiefendifferenz. Im Vergleichstest bei ähnlichen Bedingungen kann die Tiefenwahrnehmung gewonnen aus der „Bewegungs-Parallaxe“ fast so gute Ergebnisse liefern wie die Stereopsis also das binokulare Sehen.

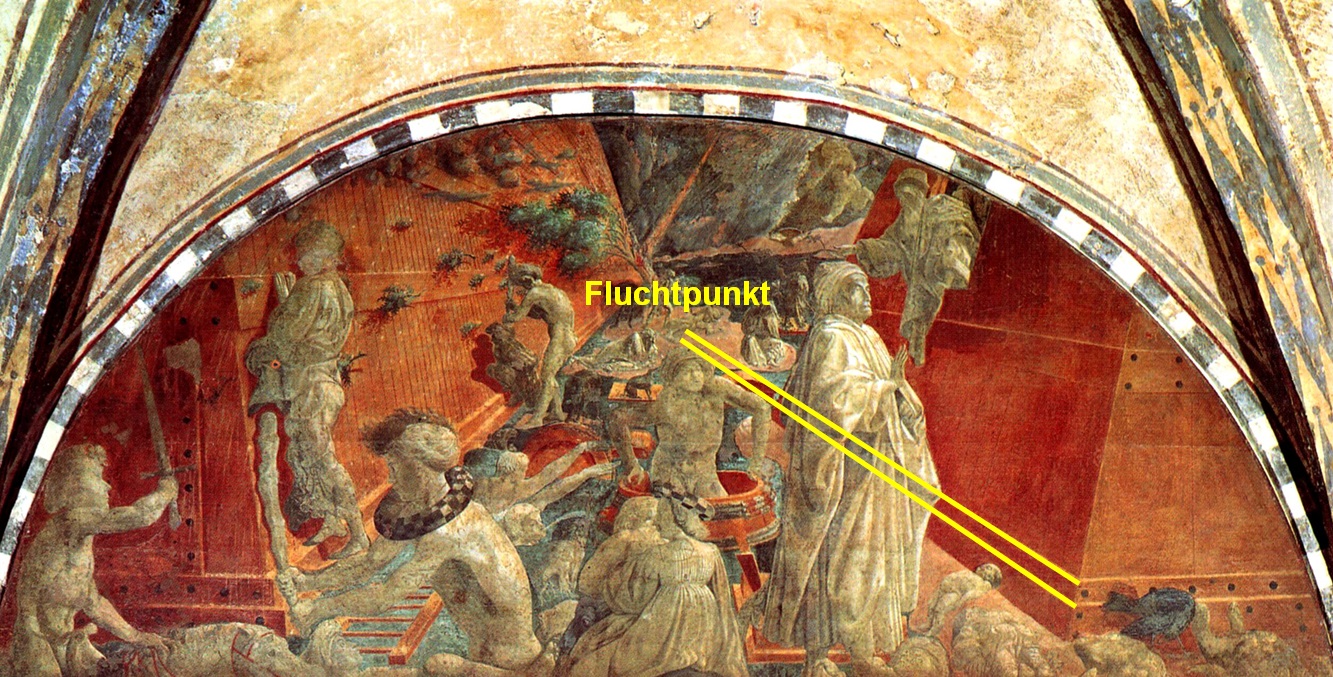

Zusätzlich zur „Bewegungs-Parallaxe“ gibt es noch eine Reihe von Bildparametern, die einen Hinweis auf Tiefe geben. Dies sind auch die Indikatoren die Künstler benutzen um Tiefe auf einer flachen Leinwand vorzutäuschen (Eccles 1990):

- Die Position eines Objektes im Bild. Je entfernter ein Objekt ist, desto höher wird es im Bild angesetzt.

- Perspektivische Darstellung.

- Abgestufte Maserung, die mit der Entfernung feiner wird.

- Schatten, die die relative Stellung im Raum anzeigen.

- Überdeckungen und Überschneidungen beweisen unzweifelhaft, wie die Objekte relativ zueinander stehen.

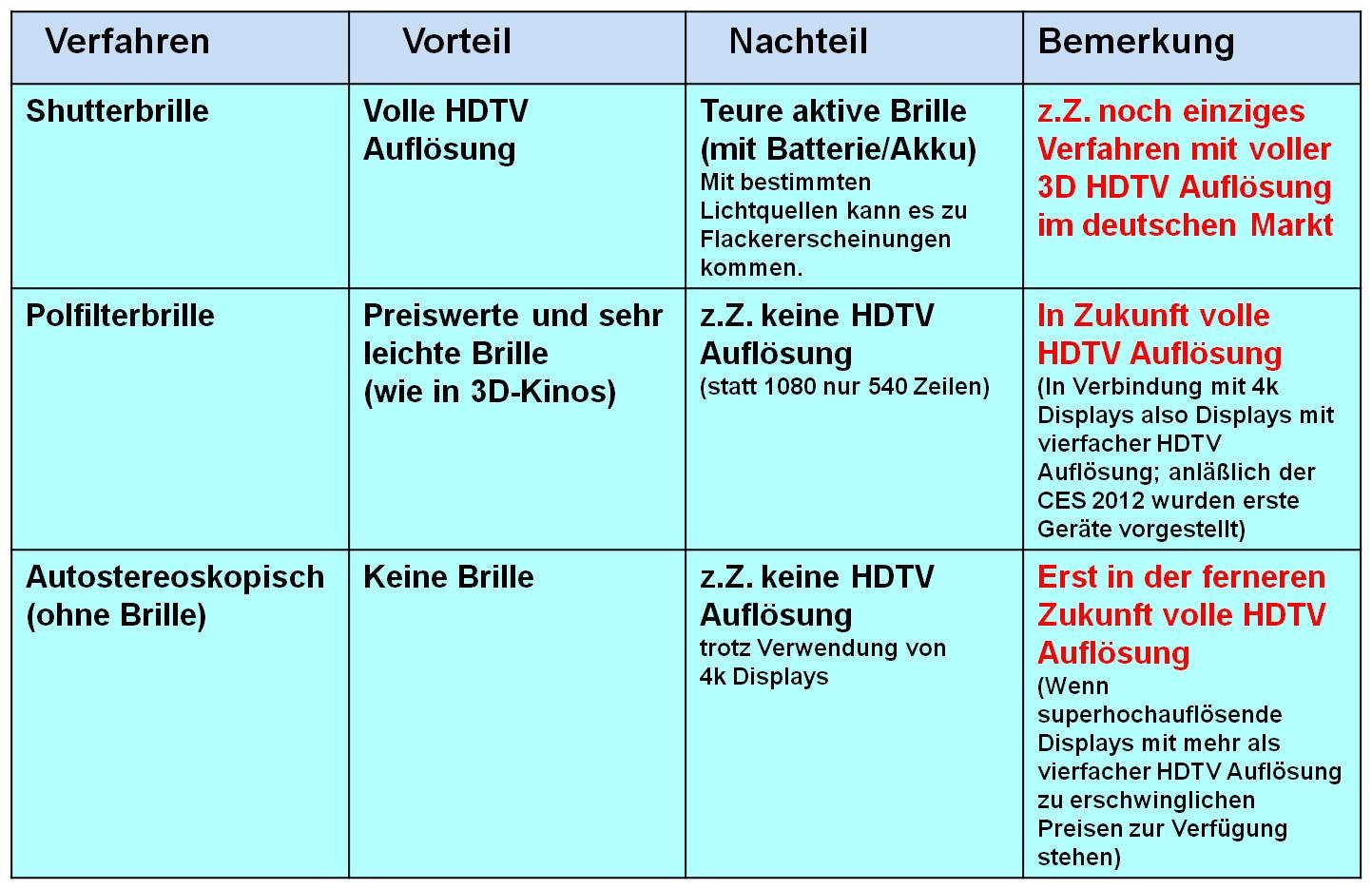

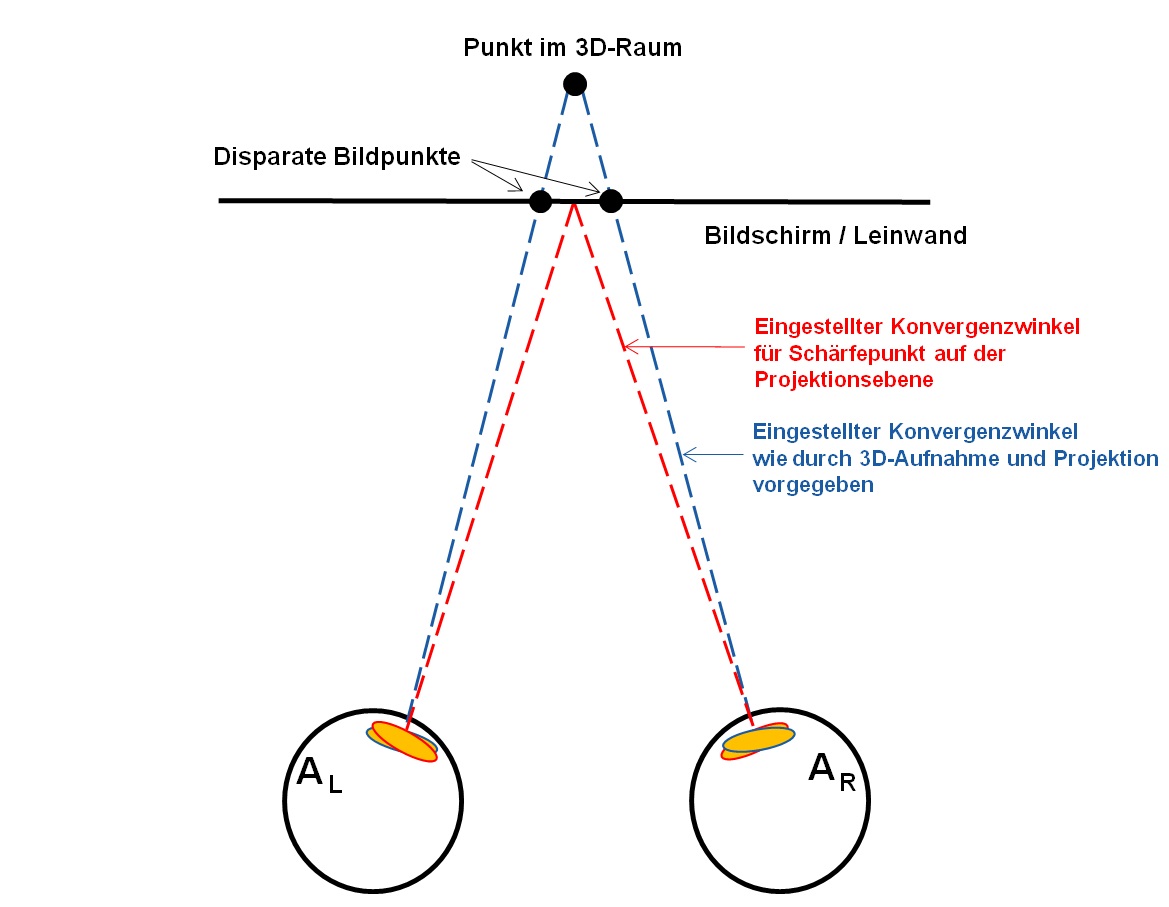

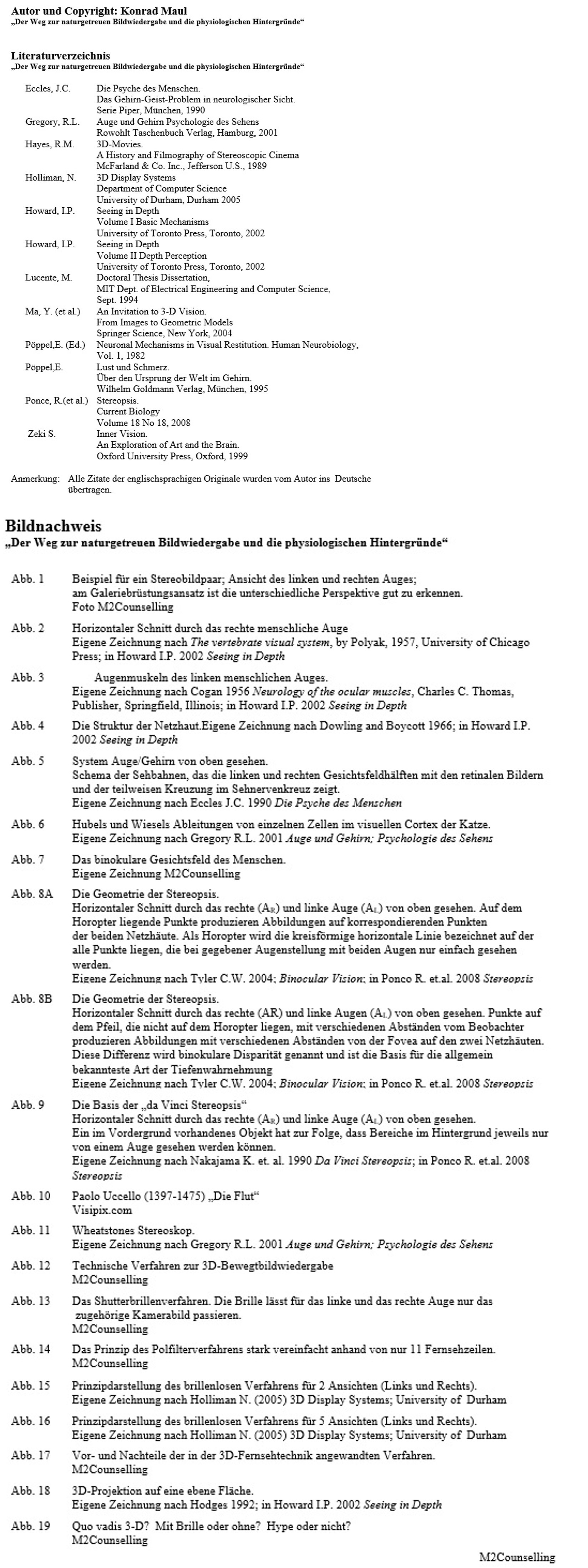

- Der Freilichteffekt: Verschwommene und mehr blaue Einfärbung entfernter Objekte.