Die Fernsehtechnik

Hätte Thomas Alva Edison seinerzeit nicht die Glühlampe erfunden, hätte es vielleicht ein anderer getan. Und dennoch ist dem US-amerikanischen Erfinder und Unternehmer nicht nur die Markteinführung des elektrischen Lichtes zu verdanken. Die Ergebnisse seiner industriellen Forschung in den Bereichen Elektrizität und Elektrotechnik sind letztlich die Basis für die heutige Telekommunikation sowie die modernen Medien für Ton und Bild.

Edison entdeckte zum Ende des 19. Jahrhunderts die Glühemission im Zusammenhang mit einer geheizten Glühkathode im Vakuum eines Glaskörpers. Der sogenannte Edison-Richardson-Effekt wurde vom englischen Physiker John Ambrose Fleming aufgegriffen, der sich im Jahre 1904 die Vakuum-Diode patentieren ließ. Nur zwei Jahre später meldete der österreichische Physiker Robert von Lieben seine quecksilberdampfgefüllte Liebenröhre als Kathodenstrahlrelais zur Verstärkung des elektrischen Signals mit zwei Elektroden beim Kaiserlichen Patentamt an.

Im Gegensatz zur Liebenröhre verfügte die ebenfalls gasgefüllte Audionröhre des US-amerikanischen Erfinders Lee de Forest bereits über drei Elektroden. Im Oktober 1912 stellte De Forest seinen Röhrenverstärker der Firma Bell Telephone Laboratories vor. Schon ein Jahr später war diese Technologie markttauglich. Anstatt der Gasfüllung wurde in den Röhren nunmehr ein Hochvakuum erzeugt, die ab 1913 für Telefonverbindungen zwischen New York und Baltimore genutzt wurden. Auch in Österreich stellte Robert von Lieben seine gasgefüllten Röhren auf Vakuumröhren um. 1916 entwickelte der deutsche Physiker und Elektrotechniker Walter Schottky bei Siemens & Halske die Schirmgitterröhre (Tetrode), die sich allerdings wie auch die Pentode nur als Verstärker für den Niederfrequenzbereich eignete.

Für den Hochfrequenzbereich wurde im selben Jahr bei der englischen Marconi Company die Hochfrequenztriode V24 entwickelt – unter der Führung des englischen Forschers Henry Joseph Round, der ebenfalls als Erfinder der Leuchtdiode gilt. Mit der voranschreitenden Entwicklung der UKW- und Fernsehempfänger setzten sich letztlich die Trioden durch, die ihrem Namen nach aus drei Bauteilen bestehen: der Kathode (negative Elektrode) und der Anode (positive Elektrode) sowie dem Steuergitter, das sich dazwischen befindet.

In Deutschland revolutionierten Manfred von Ardenne und Siegmund Loewe im Jahre 1926 die Röhrentechnologie durch die Entwicklung der Dreifachröhre (3NF), die im Radioempfänger OE333 der Firma Loewe ihren Einsatz fand. Diese Mehrsystemröhre enthielt neben drei Trioden-Systemen auch zwei Kondensatoren und vier Widerstände.

Bis in die späten 1950er Jahre wurden in Rundfunk- und Fernsehempfängern ausschließlich Elektronenröhren verwendet, die allerdings zunehmend durch Transistoren ersetzt wurden. Erst mit der Jahrtausendwende verschwanden Röhren und Transistoren aus den Geräten der Unterhaltungselektronik. Heute stehen (fast) ausnahmslos LCD-/OLED-Flachbildschirme zur Verfügung. Die Plasma-Geräte sind bereits wieder vom Markt verschwunden. Nach diesem kleinen Exkurs in die Ursprünge der Bildübertragung sollen nun die technischen Grundlagen erörtert werden.

Bildübertragung

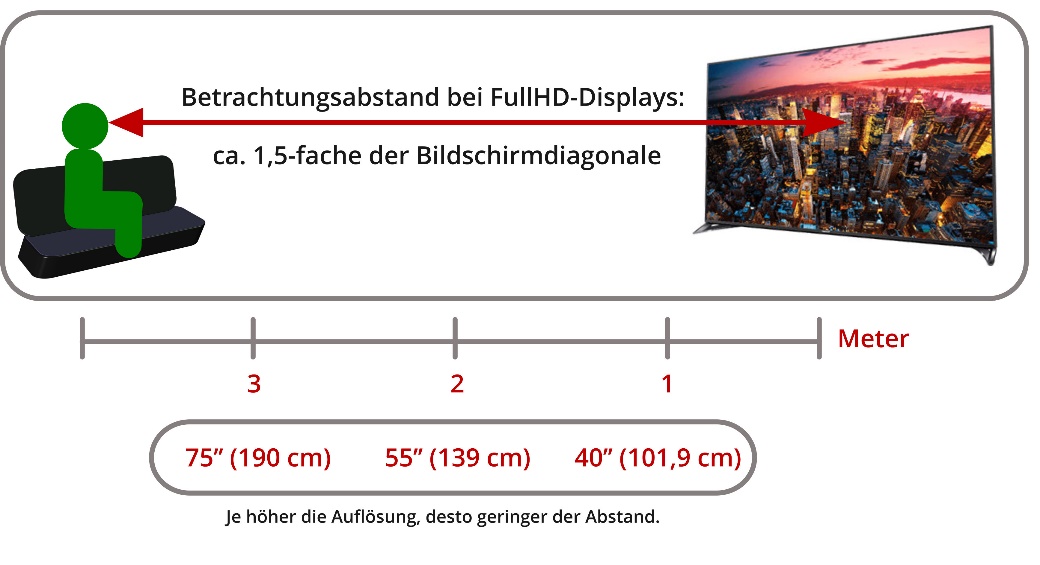

Neben individuellen Präferenzen sind doch allgemeinhin die Anforderungen an Bildwiedergabesysteme bis heute dieselben geblieben. Ein Bildwiedergabewandler (z.B. Fernseher) soll bei geringem Leistungsbedarf über eine hohe Helligkeit und Auflösung, kleine Trägheit, einen großen Betrachtungswinkel und natürlich eine große Bilddiagonale verfügen. Mit der modernen HDTV-Technologie sind Displays mit Bildschirmdiagonalen von einem Meter und darüber hinaus keine Seltenheit mehr. Auch Großbildprojektionen im Heimkinobereich finden immer mehr Verwendung.

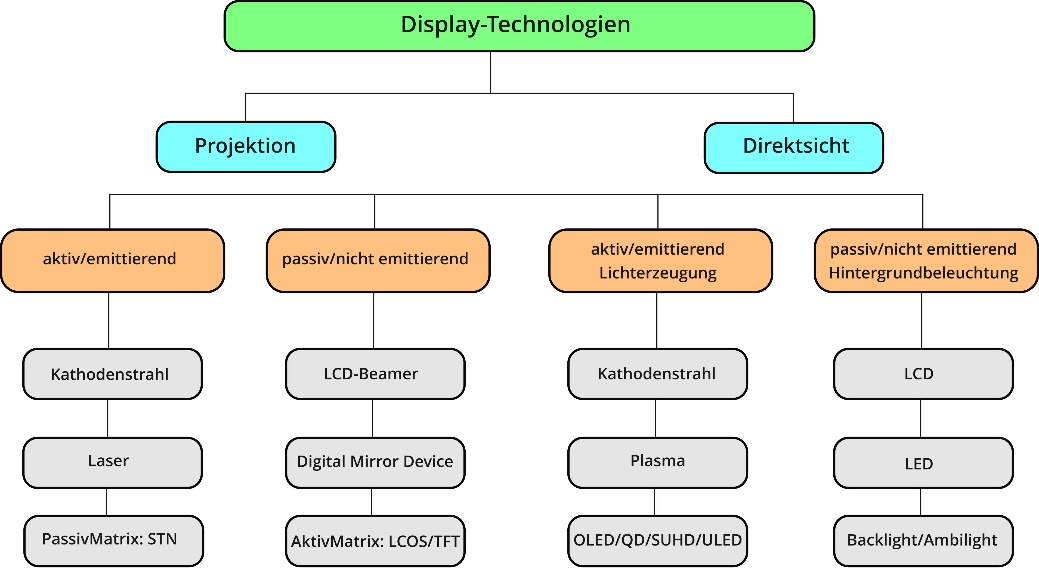

Allen gemeinsam ist das Grundprinzip: die Rekonstruktion des auf der Aufnahmeseite erzeugten Bildes und die Umsetzung des Videosignals in sichtbares Licht. Grundsätzlich lassen sich Wiedergabewandler in aktive (emittierende) und passive (nicht emittierende) Systeme unterteilen.

Im 21. Jahrhundert haben wir uns längst an die leichten und flachen LCD- oder aber QLED- und OLED-Displays gewöhnt. Obwohl diese Technologien noch gar nicht so alt sind – vor allem wenn man bedenkt, dass knapp einhundert Jahre lang die Kathodenstrahlröhre unter anderem die Unterhaltungselektronik dominierte. Deshalb soll im Folgenden dieses einstige Wunderwerk der Technik gebührend erläutert werden.

Displaytechnologien im Vergleich

Kathodenstrahl/Elektronenstrahl

Eine Kathode (griechisch: káthodos = Hinabweg) ist die Gegenelektrode zur Anode (griechisch: ánodos = Aufweg). Es handelt sich dabei um eine Elektrode, an der Elektronen einem System zugeführt werden, das beispielsweise aus einem Vakuum (Elektronenröhre) besteht. Zwischen diesen Elektroden wandern Ionen (griechisch: Ión = wanderndes Teilchen); die Kationen zur Kathode und die Anionen zur Anode.

Bereits zum Ende des 19. Jahrhunderts wurden Kathodenstrahlen systematisch untersucht. Der österreichisch-ungarische Physiker Philipp Eduard Anton Lenard entwickelte im Rahmen seiner Untersuchungen das sogenannte Lenard-Fenster und bewies damit, dass Kathodenstrahlen in der Lage sind, eine Metallfolie, die aus mehreren Tausend Atomschichten besteht, zu durchqueren. Darüber hinaus erkannte Lenard, dass Kathodenstrahlen photographische Platten belichten und unter gewissen Umständen Phosphoreszenz hervorrufen können. Im Jahre 1905 wurde Lenard dafür mit dem Nobelpreis für Physik ausgezeichnet. Allerdings war seinerzeit noch nicht bekannt, dass die Kathodenstrahlen auf Elektronen zurückzuführen sind. Deshalb wird in diesem Zusammenhang sowohl der Begriff Kathodenstrahl als auch Elektronenstrahl verwendet. In einer Kathodenstrahlröhre beziehungsweise Elektronenstrahlröhre (z.B. Braun‘sche Röhre) werden technisch Strahlenbündel mithilfe eines Strahlensystems (Elektronenkanone) erzeugt, Elektronen aus einer Glühkathode freigesetzt und durch ein elektrisches Feld beschleunigt.

Elektronenröhre (Kathodenstrahlröhre)

Die Kathodenstrahlröhre (engl. cathode ray tube/CRT) wird nach ihrem Erfinder15 auch Braun'sche Röhre genannt. Obwohl Braun eigentlich auf dem Gebiet der drahtlosen Telegrafie seinen Nobelpreis erhielt und mit dem einst durch den Kölner Schokoladenproduzenten Ludwig Stollwerck gegründeten Konsortium „Professor Braun’s Telegraphie Gesellschaft GmbH“ (der späteren Telefunken AG) finanziellen Erfolg hatte, verdankt er seine Bekanntheit grundsätzlich der Erfindung seiner Kathodenstrahlröhre. Da Brauns wissenschaftliche Untersuchungen in eine andere Richtung gingen, betrachtete er seine Erfindung für die seinerzeit noch ganz junge Fernsehtechnik als ungeeignet. Erst Manfred von Ardenne benutzte am 14. Dezember 1930 die Braun’sche Röhre bei der ersten vollelektronischen Fernsehübertragung.

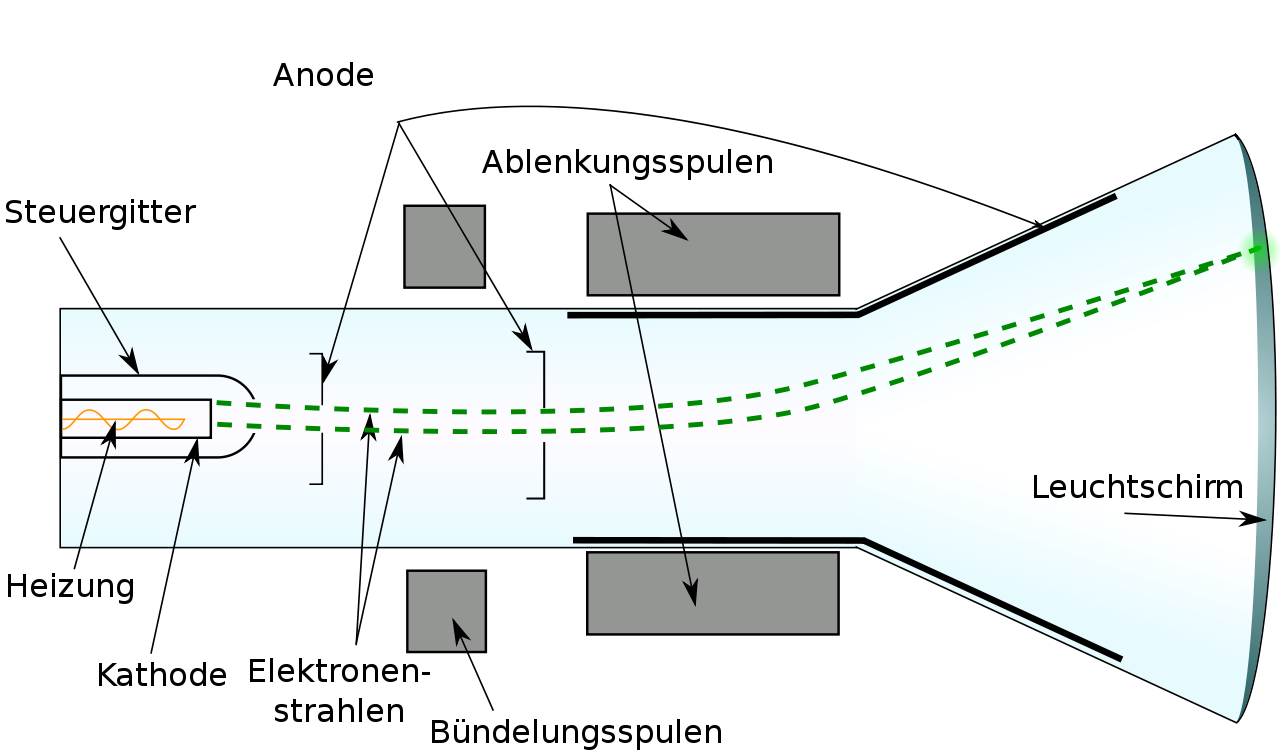

Aufbau

Im Laufe der sich entwickelnden Fernsehtechnik wurde aus der Braun’schen Kathodenstrahlröhre die Hochvakuumröhre, wie wir sie heute (im 21. Jahrhundert) allerdings überwiegend nur noch aus dem Museum kennen.

Schema der magnetischen Ablenkung bei der Kathodenstrahlröhre

Ähnlich wie Glühlampen bestehen Kathodenstrahlröhren aus geschlossenen, sogenannten evakuierten Glaskolben. Allerdings ist das Glas hier sehr viel dicker, um dem hohen Außendruck standhalten zu können. Je breiter die Fläche, desto höher der Druck. Wenn man von ca. 1 bar ausgeht, entspricht das ungefähr einem Druck von 1 kg/cm2. Deshalb müssen größere Geräte auch eine entsprechend dickere Glaskolbenwandung haben. Das Innere ist luftleer, es befindet sich also ein Vakuum im Glaskolben, damit der Elektronenstrom nicht von Luftmolekülen behindert wird.

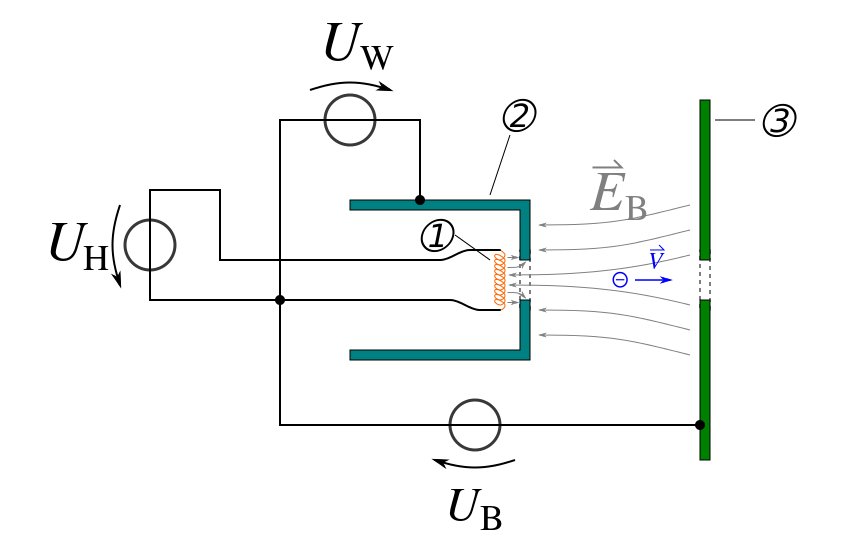

Die Elektronen werden erzeugt, indem eine Metallfläche (Kathode) mit einem Glühdraht erhitzt wird. Die Wärme oder auch thermische Energie, die dabei entsteht, macht es möglich, dass die Elektronen aus der Kathode austreten. Der sogenannte Wehneltzylinder mit negativem Potential umgibt die Kathode, wobei an der Seite, die zum Bildschirm zeigt, ein kleines Loch dafür sorgt, dass der Elektronenstrahl austreten kann. Über die Spannungsdifferenz zwischen Kathode und Wehneltzylinder wird die Strahlungsintensität gesteuert, das heißt, dass der Elektronenstrahl nicht unmittelbar nach seiner Erzeugung sofort wieder auseinander driftet (divergiert).

Aufbau einer Elektronenkanone mit Wehneltzylinder ➀ Glühkathode ➁ Wehneltzylinder ➂ Anodenblende

Wie bereits erwähnt, ist die Kathode die Gegenelektrode zur Anode. Diese besteht bei Kathodenstrahlröhren oft aus einer elektrisch leitenden Schicht an der Innenseite des konischen Glaskörpers und einem Zylinder, der direkt in der Strahlenbahn liegt. Bei Schwarz/Weiß-Röhren werden die Elektronen mit ungefähr 18 kV auf die Anode beschleunigt. Dabei gelangen sie in den Bereich der sogenannten Fokussierelektroden, die für die Bildschärfe verantwortlich sind. Hier wird ein elektrisches Feld erzeugt, das den Elektronenstrahl bündelt. Sobald die Elektronen die Anode passiert haben, „fliegen“ die Elektronen bei konstanter Geschwindigkeit bis zur Leuchtschicht weiter. Dabei werden die Leuchtstoffe (Phosphore) zur Lichtemission angeregt. Diese erfolgt ungerichtet, weshalb bei der Betrachtung eines Röhrenbildschirms die Blickrichtung relativ unabhängig ist.

Je schneller der Elektronenstrahl, desto höher die Leuchtdichte. Dies gilt es zu vermeiden: Denn bei großem Strahlstrom würde sich auch der Elektronenstrahldurchmesser erhöhen, was wiederum eine verringerte Bildschirmauflösung zur Folge hätte. Deshalb wird die Strahlstromstärke relativ gering gehalten (unter 1 mA). Auch die Beschleunigungsspannungen am Anodenanschluss liegen unterhalb von 30 kV. Wären die Elektronen zu schnell, würden sie beim Auftreffen auf die Leuchtschicht beziehungsweise die Glaskolbenwand so stark abgebremst werden, dass eine ungewollte Röntgenstrahlung entstünde.

9″-Schwarz-Weiß-Bildröhre mit zugehöriger Ablenkeinheit

Der Leuchtschirm besteht aus einer leitfähigen Schicht und ist mit einer dünnen Aluminiumschicht hinterlegt. Damit ist zum einen möglich, dass die Elektronen zur Anode abfließen können und sich damit der Stromkreis schließt. Zum anderen werden durch den aluminiumhinterlegten Leuchtschirm die Sekundärelektronen abgeleitet, welche dabei entstehen, wenn der Elektronenstrahl auf die Leuchtschicht trifft. Darüber hinaus reflektiert diese das Licht, damit die Leuchtstoffe in den Röhreninnenraum abstrahlen können. Infolgedessen wird sowohl die Bildhelligkeit als auch gleichzeitig der Kontrast erhöht. Letzterer wird auch durch die Verwendung von Grauglas gesteigert, das zumeist für die Herstellung der Röhren verwendet wurde.

Von außen ist der Glaskolben am konischen Teil oft mit einer dünnen Graphitschicht überzogen. Die Erdung dieser Schicht bewirkt, dass das Gerät vor Ladungsausgleichen geschützt ist (Faradayscher Käfig). Gemeinsam mit der inneren Anodenbeschichtung wirkt die äußere Grafitschicht wie ein Kondensator, der die Anodenspannung „glättet“. Mit diesem Grafitbelag sind elektrisch leitende Gitter verbunden. So kann der dadurch entstehende elektrische Widerstand die hohe Anodenspannung (bis 27 kV) auf geringere positive Potenziale senken.

Strahlablenkung

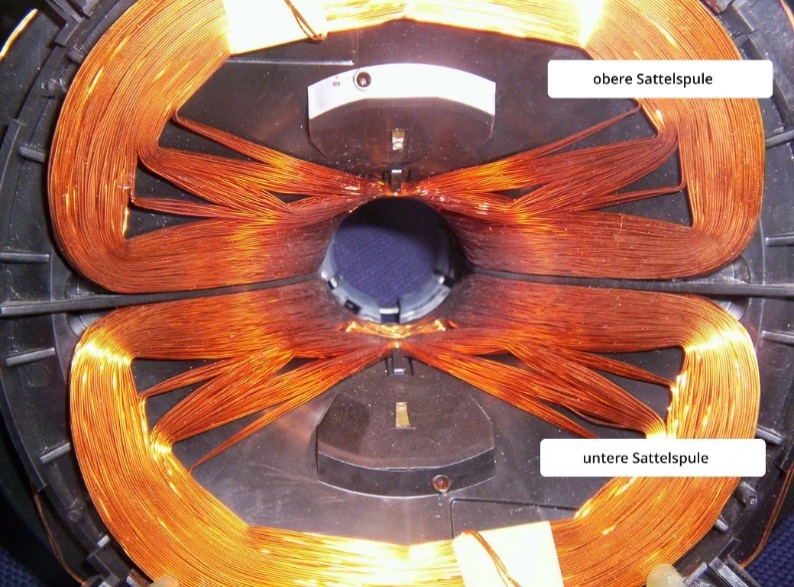

Für eine zweidimensionale Bilddarstellung muss der gebündelte Elektronenstrahl sowohl vertikal als auch horizontal abgelenkt werden. Diese Strahlablenkung kann entweder durch elektrische oder magnetische Felder erfolgen.

Ablenksystem / Horizontalablenkspulen einer Fernseh-Bildröhre

Da Fernseh- und Monitorröhren in der Regel einen großen Bildschirm und einen kurzen Röhrenhals haben, ist es notwendig, den relativ kurzen Elektronenstrahl in einem breiten Winkel zu streuen. Dazu dienen starke magnetische Felder, die zum einen durch zwei verschiedene Spulensysteme auf einem gemeinsamen Ferritkörper erzeugt werden. Diese Spulenanordnung ist auf dem Röhrenhals angebracht (vgl. Abbildung).

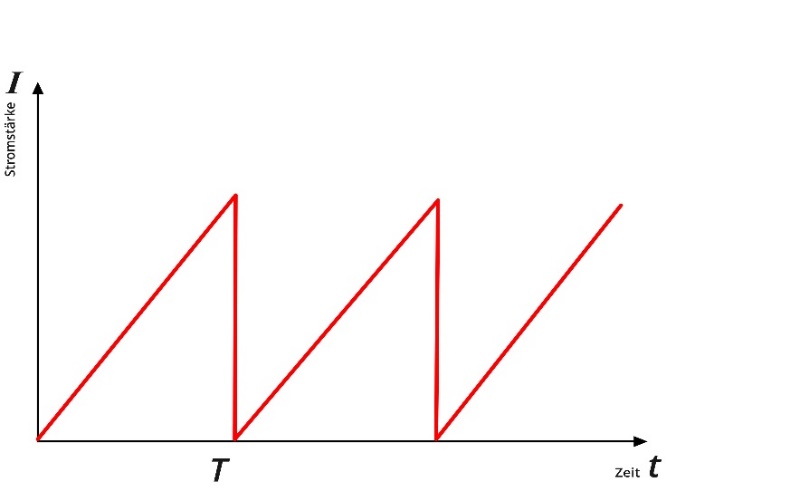

Während der Ablenkung ist der Stromverlauf annähernd sägezahnförmig, das heißt, dass die Frequenzen sehr kurz und damit die Amplituden spitz zulaufen, wie in der folgenden Abbildung dargestellt.

Schematische Darstellung einer Sägezahnspannung

Während der aktiven Zeilendauer wird der Elektronenstrahl durch die innenliegenden Sattelspulen von links nach rechts über den Leuchtschirm geführt (Horizontalablenkung). Dabei steht ihr Magnetfeld senkrecht zur Ablenkrichtung. Die Vertikalablenkung erfolgt nach demselben Prinzip durch das Magnetfeld, welches durch die Toroid- oder Ringspulen erzeugt wird. Sie liegen unterhalb der Sattelspulen und sind um den Ferritkern gewickelt. In der sogenannten Austastlücke springt der Strahl – für das menschliche Auge unsichtbar – an seinen Ausgangspunkt zurück. Das sogenannte Zeilensprungverfahren wird im Kapitel „Bildabtastung“ noch eingehender erläutert.

Comeback der Bildröhre?

Die Firma Samsung hat im Jahre 2014 tatsächlich einen neuen Versuch gestartet und ihren Röhrenfernseher Vixlim (ein Kunstwort aus "Victory" und "Slim") vorgestellt. Dem koreanischen Unternehmen war es seinerzeit gelungen, den Ablenkwinkel auf 125 Grad zu erhöhen, sodass der Elektronenstrahl über kürzere Wege die gesamte 32 Zoll (81 Zentimeter) große Bildfläche erreicht. Doch damit nicht genug. Im Gegensatz zu dem bisherigen Manko der Röhrenfernseher – den gewaltigen Geräteproportionen – gelang es Samsung mithilfe moderner Computertechnik, ein relativ schmales Design herzustellen. Die Bildröhre des Vixlim war nun nicht mehr wie bisher 60 Zentimeter, sondern nur noch magere 35 Zentimeter tief. Dazu musste die herkömmliche Form des Glaskörpers der Röhre von Grund auf neu konzipiert werden.

HD ready Röhren-TV von Samsung WS-32Z409T

Im Jahre 2006 machte Samsung für seine HD-fähige Röhre (WS-32Z409T) auf der CeBIT Werbung und stellte dort den ersten Röhrenfernseher vor, der in der Lage war, HDTV-Standards 720p und 1080i sowohl mit 50 Hz als auch 60 Hz darzustellen.

Dennoch waren der Stromverbrauch und die Geräteabmessungen sowie das Gewicht für die Verbraucher ausschlaggebend. Deshalb scheiterte der Versuch, die Röhre ein letztes Mal zu „reanimieren“. Auch wenn die Herstellung der Röhrenfernseher in der Regel preiswerter war, konnte sich die neue-alte Technologie (jedenfalls in Europa) nicht durchsetzen. Die klobige Glotze und damit das Vermächtnis von Nipkow, Braun, Ardenne & Co. wanderte ins Museum oder auf den Sperrmüll. Doch gehen wir gemeinsam noch einmal einen Schritt zurück. Wie war das damals, als das Fernsehen bunt wurde?

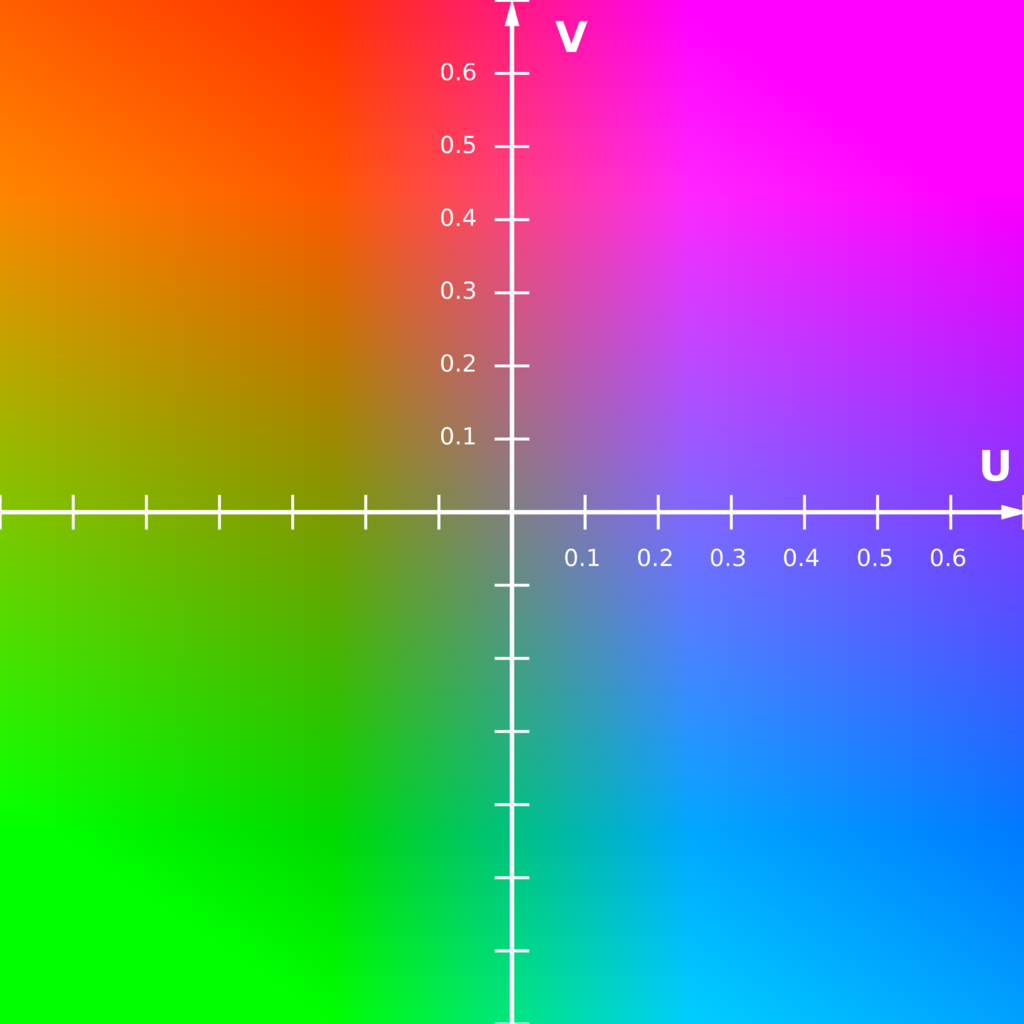

Farbbildwiedergabe

Der deutsche Fernsehpionier Werner Flechsig ließ sich im Juli 1938 seine Erfindung mit dem Titel „Kathodenstrahlröhre zur Erzeugung mehrfarbiger Bilder auf einem Leuchtschirm“ vom Deutschen Reichspatent patentieren. Sie funktionierte nach dem Grundprinzip zur Erzeugung farbiger Bilder mit Schattenmasken-Bildröhren. Allerdings geriet die technische Umsetzung durch den 2. Weltkrieg ins Stocken und musste letztlich ganz eingestellt werden. Die Radio Corporation of America begann im Jahre 1949 mit der kommerziellen Realisierung dieses Patentes, das als erstes seiner Art die additive Farbmischung mit drei Grundfarben zur Erzeugung aller Farben beinhaltete.

Loch- und Schlitzmaskenröhre

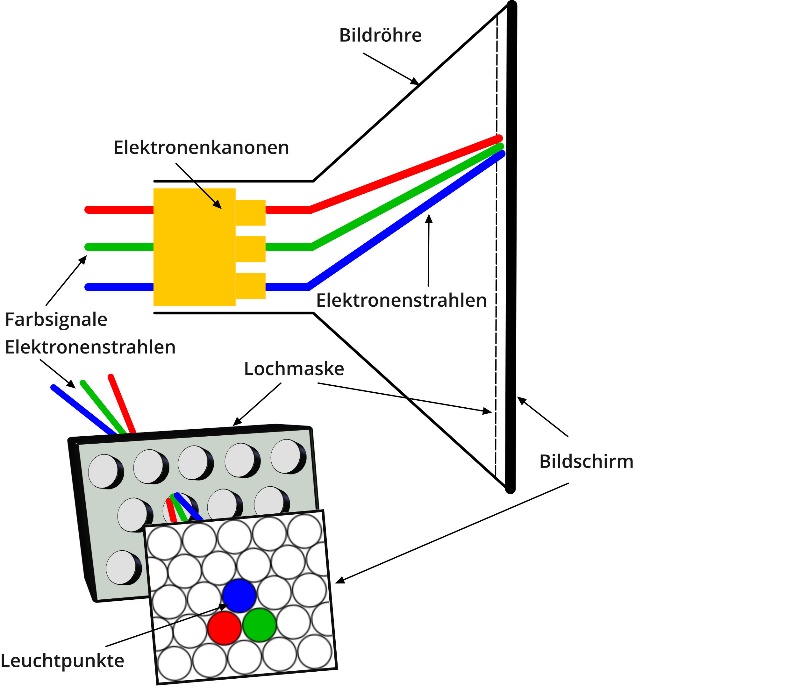

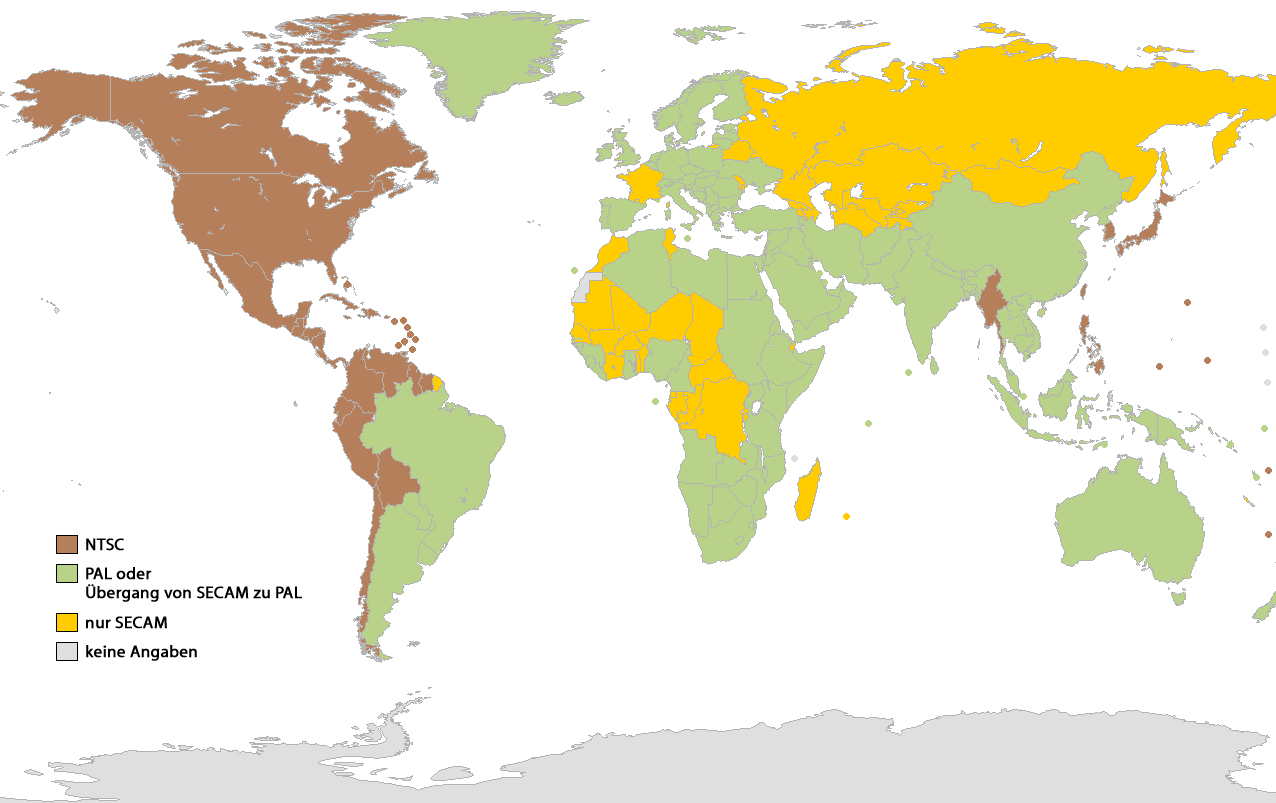

Für die drei Grundfarben (Rot, Grün, Blau) werden in Farbbildröhren jeweils Leuchtstoffe (Farbstoffphosphore) verwendet, die in diesen drei Farben leuchten. In kleinen Strukturen werden diese sehr eng beieinander angeordnet, wobei jeder Bildpunkt aus drei Pixeln (Farbtripel) besteht, die das Licht der jeweiligen Farbe durchlassen. Durch die additive Farbmischung wird die Farbe der einzelnen Bildpunkte erreicht. Für die „Erregung“ der Farbstoffphosphore von drei Grundfarben werden nunmehr auch drei Elektronenstrahlquellen benötigt. Diese Elektronenkanonen sind im Hals der Bildröhre entweder nebeneinander oder im Dreieck angeordnet (Dreistrahlröhre). Das Prinzip der Ablenkspulen findet auch hier seine Anwendung. Mit dessen Hilfe ist es möglich, dass die (drei) Elektronenstrahlen in 1/25 Sekunden (PAL, SECAM) oder 1/30 Sekunden (NTSC) den gesamten Bildschirm Zeile für Zeile abtasten können.

Schematische Darstellung einer Kathodenstrahlröhre mit Lochmaske

Die Herausforderung besteht nun darin, dass jeder der drei Elektronenstrahlen auch „seine“ Farbe findet. Dazu dienen sogenannte Schattenmasken, die sich in einem fest definierten Abstand zirka 15 Millimeter vor dem Leuchtschirm befinden. Hier kreuzen sich die drei Strahlen in jeder Position auf der Ebene der Maske und lassen jeweils nur die „richtigen“ Elektronen durch. Diese Maske besteht aus einem dünnen Blech, das ein regelmäßiges Muster punkt- oder schlitzförmiger Löcher (Loch- oder Schlitzmaske) aufweist oder aus vertikalen Streifen besteht (Trinitron-Bildröhre). Das Raster der Schattenmaske ist so konzipiert, dass der Fernseher verschiedene Fernsehnormen (vgl. Kapitel „Fernsehnormen“) anzeigen kann - also unabhängig von der Zeilenzahl und der horizontalen Auflösung.

Delta-Farbbildröhre (Lochmaske)

Bei der Lochmaske handelt es sich um die älteste Farbbildröhre, die ihren Einsatz in der Praxis fand. Vor allem Computermonitore sind beziehungsweise waren mit dieser Art der Farbbildröhre ausgestattet. Der Name „Delta“ steht für die Anordnung des Strahlsystems, das einem gleichseitigen Dreieck und damit dem griechischen Buchstaben Δ ähnelt. Entsprechend der Strahlungserzeugungsanordnung sind auch die Farbtripel in einem solchen Dreieck angeordnet (vgl. Abbildung).

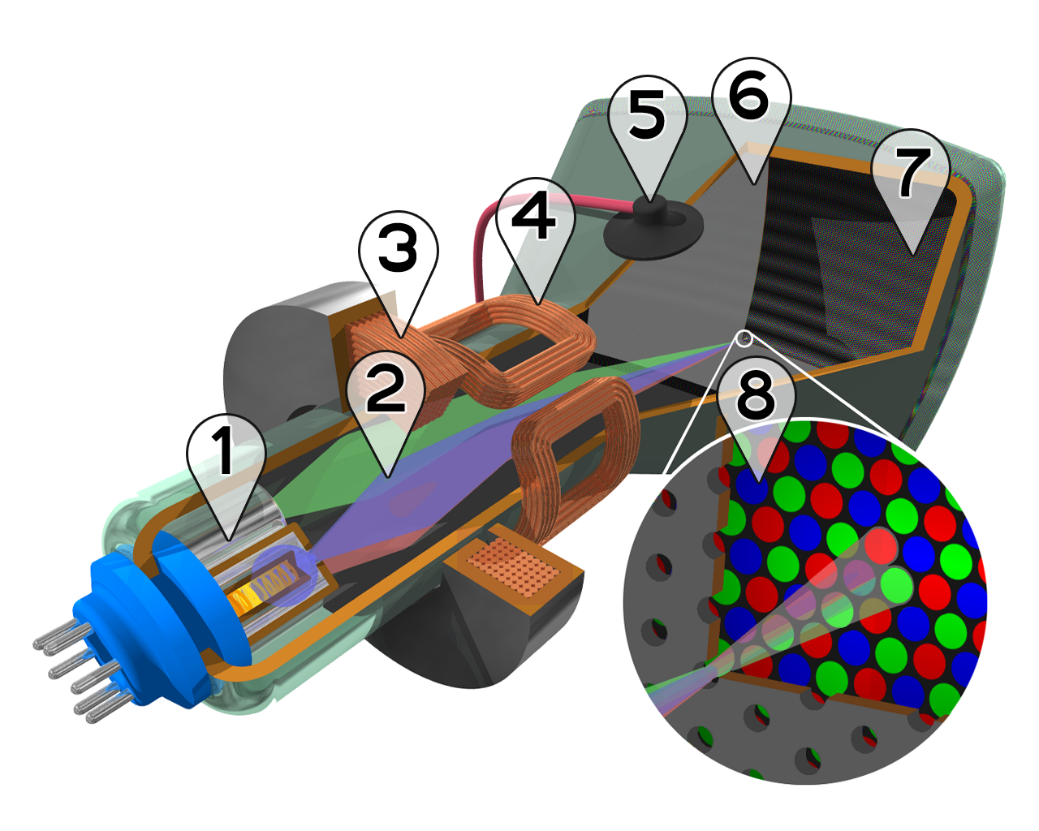

Aufbau einer Lochmasken-Bildröhre

1. Glühkathoden, 2. Elektronenstrahlen, 3. Bündelungsspulen, 4. Ablenkspulen, 5. Anodenanschluss, 6. Lochmaske, 7. Fluoreszenzschicht mit

roten, grünen und blauen Subpixeln, 8. Nahansicht der Fluoreszenzschicht

Damit sich die Strahlen auch tatsächlich in dem jeweiligen Loch der Maske treffen, ist der Lochdurchmesser (zirka 0,2 Millimeter) etwas kleiner als der Durchmesser der Farbstrahlen und Leuchtpunkte, der jeweils etwa 0,3 Millimeter beträgt. Der Schnittpunkt der drei Strahlen (Rot, Grün, Blau) liegt in dem jeweiligen Loch der Maske, weshalb sie auch Lochmaske genannt wird. Bei typischen Farbbildröhren mit einer Bildschirmdiagonale von 60 Zentimetern beträgt die Anzahl der Löcher einer Maske ca. 400.000 und der Abstand zwischen zwei Leuchtpunkten einer Reihe (Pitch) ungefähr 0,7 Millimeter.

Aufgrund der sehr dicht liegenden Farbtriple verfügt die Delta-Lochmasken-Farbbildröhre über eine relativ hohe Bildauflösung. Allerdings sind umfangreichere Korrekturschaltungen mithilfe von Zusatzspulen nötig, um eine ausreichende Konvergenz (exakte Kreuzung der Strahlen im Maskenloch) zu erzielen. Auch die geringe Maskentransparenz (ca. 17 Prozent) ist ein Nachteil gegenüber Schlitz- und Streifenmasken, da ein Großteil der Elektronen ungenutzt auf der Maske landet. Dennoch überzeugte die Darstellungsqualität, sodass insbesondere im professionellen Bereich der Computertechnik (z.B. Medizin) die hochauflösenden Monitore mit einer Delta-Farbbildröhre umfangreiche Verwendung fanden. Im Laufe der Zeit wurden mit immer exakter funktionierenden Ablenkspulensystemen die technischen Schwierigkeiten im Zusammenhang mit der Konvergenz nahezu behoben.

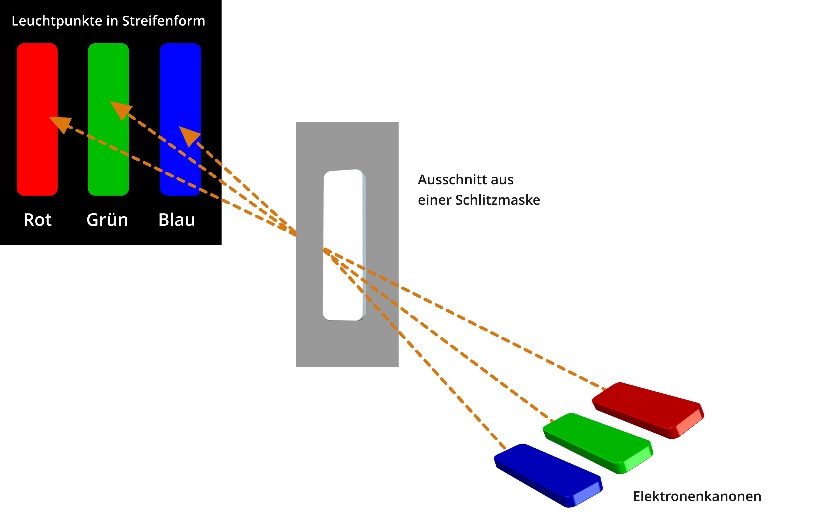

Inline-Farbbildröhre (Schlitzmaske)

Mitte der 1970er Jahre wurde ein weiterer Farbbildröhrentyp entwickelt, der das Problem der präzisen Konvergenzeinstellungen vereinfachen sollte. Mit fortschreitender technischer Entwicklung war es möglich, die Strahlerzeugungssysteme zu verkleinern und damit gleichzeitig den Durchmesser des Bildröhrenhalses zu verringern. Deshalb konnten die Strahlerzeugungssysteme nicht mehr als Delta angeordnet werden, sondern nunmehr nebeneinanderliegend in einer In-Line-Anordnung.

Aufgrund der größeren Schlitze in der Maske waren weitaus weniger Korrekturmaßnahmen nötig, um eine genaue Strahlkonvergenz zu erreichen. Die Konvergenzfehler reduzierten sich von drei auf zwei Dimensionen. Im Umkehrschluss mussten die Ablenkeinheiten nicht mit demselben hohen Aufwand arbeiten, wie bei den Delta-Farbbildröhren.

Schematischer Verlauf der Elektronenstrahlen durch eine Schlitzmaske

Durch die Schlitze vergrößerte sich auch die offene Fläche der Maske, was zur Folge hatte, dass mehr Elektronen zur Leuchtschicht gelangen konnten (vgl. Abbildung). Deshalb lieferten die In-Line-Farbbildröhren auch bei herkömmlichem Strahlstrom ein helleres Bild als die Delta-Röhren. Aufgrund des geringeren technischen Aufwandes avancierte dieser Typ zur Standardbildröhre in Fernsehgeräten. Später wurde aus der Inline-Röhre die Black-Matrix-Röhre, die zwar nach demselben Prinzip der Schlitzmaske arbeitete, jedoch kleine Veränderungen enthielt (z.B. lichtabsorbierendes Material), die den Kontrast aber auch die Farbreinheit verbesserten.

Trinitron-Röhre

Im April 1968 stellte das noch junge japanische Unternehmen Sony (1949 gegründet) eine neue Farbbildröhre vor. Diese unterschied sich grundsätzlich von der bis dahin gebräuchlichen Delta-Röhre. Im selben Jahr kamen die ersten Fernsehgeräte mit dieser neuen Technologie auf den Markt, deren Bildschirmdiagonale für damalige Verhältnisse stolze 33 Zentimeter betrug. Seither ist Sony einer der führenden Hersteller in dieser Branche.

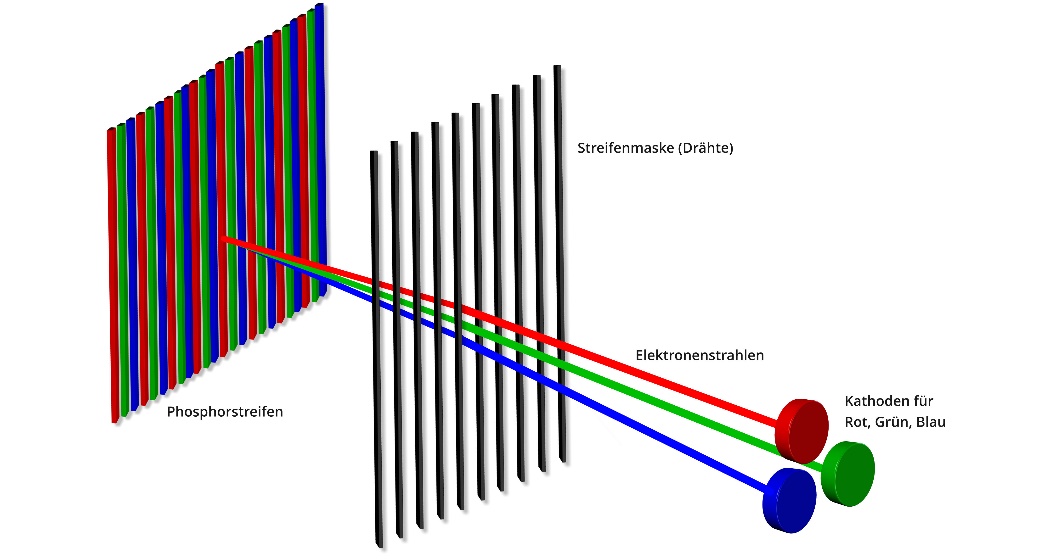

Im Gegensatz zur Loch- oder Schlitzmaske sind hier die Leuchtstoffe in vertikaler Richtung nicht unterbrochen. Die Phosphore laufen als durchgehende Streifen senkrecht über den Bildschirm. Die Schattenmaske ist vielmehr ein Blendengitter, das ebenfalls aus senkrecht verlaufenden Streifen besteht, weshalb diese auch als Streifenmaske bezeichnet wird.

Sony Trinitron KV-1310 colour TV

Um die Maske zu stabilisieren, wurden die Streifen jeweils unter Spannung gesetzt. Darüber hinaus waren sie mit querverlaufenden dünnen Drähten fixiert, um Schwingungen zu vermeiden. Das Strahlsystem war wie bei der In-Line-Röhre in einer Reihe angeordnet. Die Maskentransparenz lag aufgrund der durchgehend verlaufenden Streifen bei ungefähr 22 Prozent und war damit von allen Farbbildröhren auf dem höchsten Niveau. Deshalb boten Trinitron-Röhren ein sehr helles Bild. Allerdings führten die relativ hohe Durchlässigkeit der Maske und die Anordnung der Leuchtstoffe zu einer schlechteren Auflösung, einem geringeren Kontrast und mitunter zu Alias- und Treppeneffekten an senkrechten Linien. Darüber hinaus war die mechanische Empfindlichkeit der fragilen Maskenkonstruktion mit ihren dünnen Drähten ein Problem, da sie vor allem bei Erschütterungen zu Schwingungen neigte, die zulasten der Bildqualität ging.

Insofern schaffte Sony mit dieser Technologie zwar nicht den Einstieg in den Markt der sogenannten CAD-Systeme, also im Anwendungsbereich der computerunterstützten Entwicklungs-, Entwurfs- und Konstruktionstechnik (Computer Aided Design: CAD). Jedoch konnte im Gegenzug auf die teure Technologie der Konvergenzeinheit umfassend verzichtet werden. Das ermöglichte erstmals die Produktion relativ simpel konstruierter Fernsehgeräte, die entsprechend preiswert auf den Markt gebracht werden konnten. Damit gelang Sony bis Ende der 1970er Jahre der Durchbruch auf dem entstehenden weltweiten Massenmarkt der Farbfernsehgeräte.

Abbildung 46: Streifenmaske (Trinitron-Röhre)

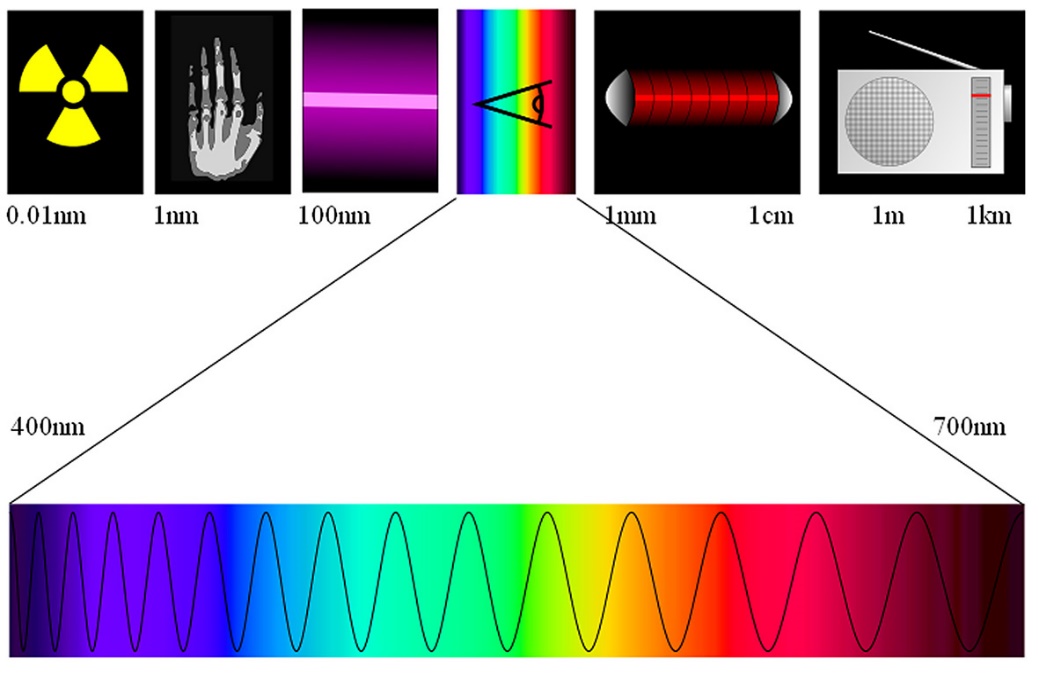

Bildaufbau

Die elektronische Übertragung von Bildern erfolgt durch Umwandlung elektrischer Signale und der Abbildung auf einer sogenannten Bildwandlerfläche. Dabei werden bei der Fernsehübertragung dieselben Basistechnologien verwendet wie beispielsweise beim Radio oder allgemeinhin bei der Funkübertragung (Telefon), da sowohl Bilder als auch Töne nichts anderes sind als elektromagnetische Wellen.

So werden bei der elektronischen Bildaufnahme und -wiedergabe einzelne Bildpunkte nacheinander und Zeile für Zeile durch den bereits beschriebenen Elektronenstrahl „abgetastet“. Anschließend wird jedes Bild in elektrische Signale zerlegt und als hochfrequente elektromagnetische Signale zu den einzelnen Empfängern übertragen. Dazu dient heute nicht nur die klassische Fernsehantenne, die Übertragung erfolgt darüber hinaus über Kabel, Satellit oder aber das IP-Signal. Im Bildempfänger werden die jeweiligen Signale wieder in Lichtpunkte umgewandelt, wie anhand des Prinzips der Kathodenstrahlröhre bereits beschrieben.

Auf der Leuchtschicht der jeweiligen Röhre wird das Bild nunmehr Punkt für Punkt zeilenförmig aufgebaut. Das klassische Fernsehbild besteht insofern aus Bildzeilen, die nacheinander „eingelesen“ werden. Die Frequenzen beziehungsweise die Geschwindigkeit des Bildaufbaus können dabei variieren, sind jedoch in jedem Fall so schnell, dass das menschliche Auge aufgrund seiner Trägheit weder die einzelnen Zeilen noch die separaten Bilder wahrnimmt, sondern den Film als Ganzes erkennt. Im Laufe der sich entwickelnden Fernsehtechnik haben sich verschiedene Normen und Bildübertragungsverfahren etabliert, die auf unterschiedliche Bildfrequenzen und -formate zurückgreifen. Hierauf wird im folgenden Kapitel noch gesondert eingegangen.

Gerade zu Beginn des Fernsehens war eine parallele Übertragung – also Bild für Bild – aufgrund geringer Speicherkapazitäten ineffizient. Auch heute noch werden Vollbilder teilweise in zwei Halbbildern dargestellt, die versetzt gesendet werden. In diesem Zusammenhang spricht man auch von einer räumlichen und zeitlichen Diskretisierung. Damit ist pauschal die Gewinnung einer Teilmenge aus einer kontinuierlichen Daten- oder Informationsmenge gemeint, die das Ziel hat, die Übertragung wirtschaftlicher beziehungsweise effizienter zu gestalten. Dabei werden die Bildpunktinformationen seriell statt parallel übertragen, was zur Folge hat, dass die Menge der Bildpunkte reduziert werden kann und damit eine schnellere Übertragung möglich ist.

Bildraten von 24 bis 120 Hz

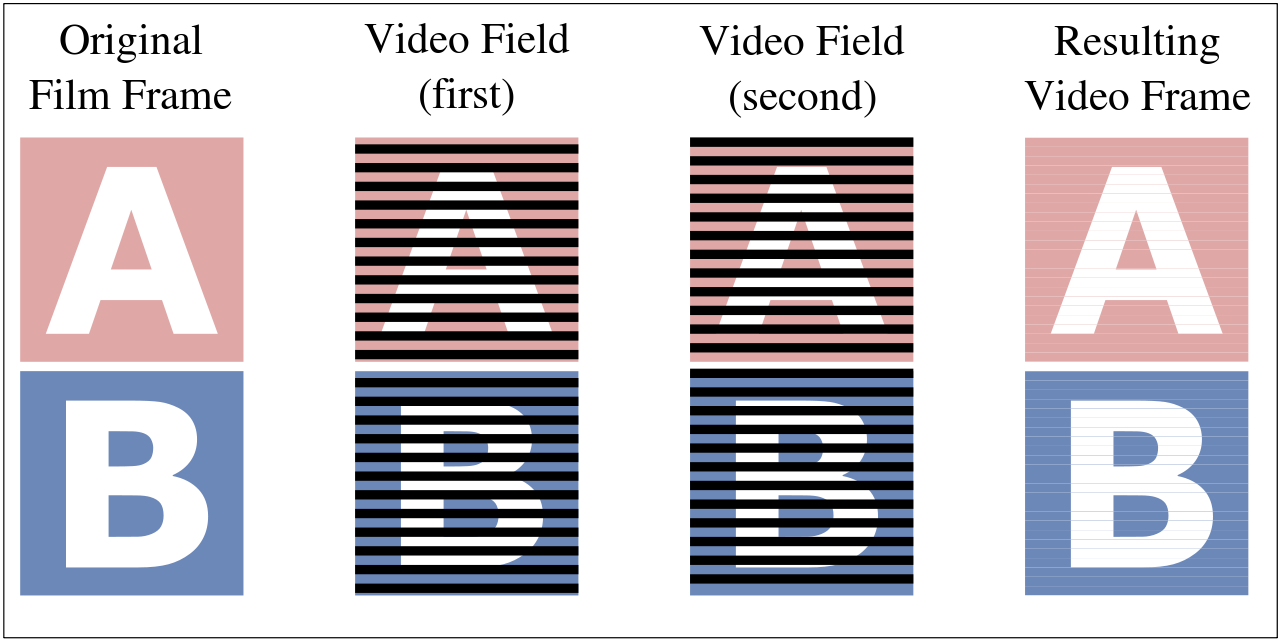

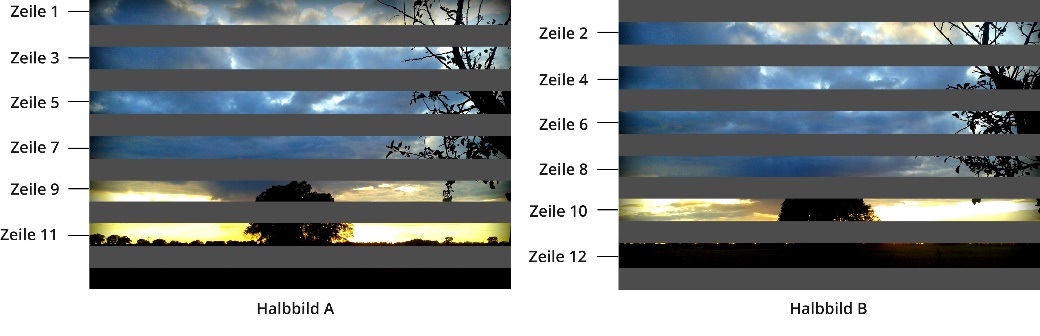

Die klassische Methode zur Bildübertragung seit der Erfindung des Fernsehens bildet das sogenannte Zeilensprung- oder Halbbildverfahren. Dabei werden zwei Halbbilder (Abbildung 45) nacheinander und Zeile für Zeile gesendet und empfangen, wobei beim ersten Halbbild mit der ersten Bildzeile begonnen wird.

Halbbilder im Zeilensprungverfahren

Demnach erfolgt zuerst die Abtastung der ungeraden Zeilen und im Anschluss die der geraden Bildzeilen. Als zweite Variante der Bildübertragung entwickelte sich das Vollbildverfahren, bei dem die vollwertigen Bilder nacheinander übertragen werden. Als einer der wichtigsten Parameter des Videosignals ist deshalb die Bildwechselfrequenz zu betrachten, die auch als zeitliche Diskretisierung oder Zeitauflösung bezeichnet wird.

Damit der menschliche Gesichtssinn die bewegten Bilder als einen zusammenhängenden Bewegungsablauf erfassen kann, war seinerzeit die Frage zu klären, wie viele Bilder pro Sekunde übertragen werden müssen. Als die Fernsehtechnik noch in den Kinderschuhen steckte, wurde bereits mithilfe des Daumenkinos (vgl. Abbildung) festgestellt, dass mindestens 20 Bilder pro Sekunde ausreichend sind, damit unser Auge beziehungsweise unser Gehirn eine scheinbar gleichmäßige Bewegung wahrnimmt.

Bevor das Fernsehen Einzug in die heimischen Wohnzimmer hielt, waren Filme nur im Kino zu sehen. Hier wurden 24 (Voll-)Bilder pro Sekunde gezeigt, wie es auch heute noch im modernen Cinema grundsätzlich üblich ist.

Der Kineograph im Jahre 1868

Allerdings ist dieser vermeintlich langsame Bildwechsel, der mit Dunkelpausen verbunden ist, für unsere Wahrnehmung mit einem erheblichen Kraftaufwand verbunden. Die rezeptiven Felder (vgl. Kapitel „Kontrast/Schärfe“) müssen permanent zwischen Erregung und Hemmung der Neuronen wechseln, was auf Dauer sehr anstrengend ist und als ein unangenehmes Flackern empfunden wird. Je schneller der Bildwechsel, desto geringer erscheint dieses Großflächenflimmern, bei dem das menschliche Auge auf alle Bildpunkte gleichzeitig reagieren muss. Erst ab einer Bildrate über 50 Hz (also mehr als 50 Bilder pro Sekunde) wird die sogenannte Flimmer-Verschmelzungsfrequenz erreicht, bei der diese für den Menschen unangenehme Erscheinung verschwindet.

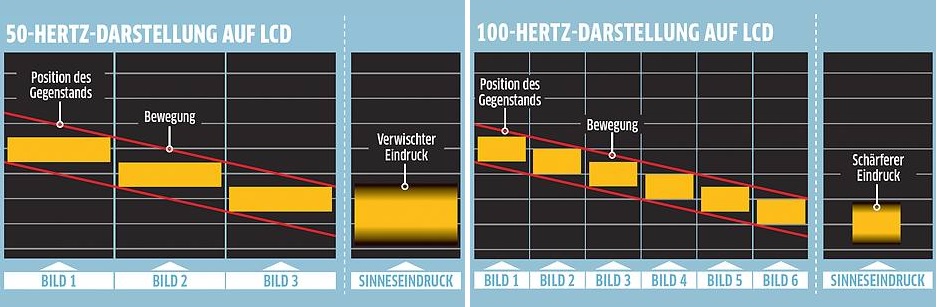

Unterschiedliche Wahrnehmung bei 50 Hz bzw. 100 Hz

Kino

Aber auch die Helligkeit des Bildes und der Blickwinkel sind ausschlaggebend für die Flimmerempfindlichkeit. Im Kino werden die Filmbilder deshalb in einem weitgehend abgedunkelten Umfeld zwei- oder dreimal projiziert. Daraus ergibt sich eine Verdopplung der Dunkelpausen bei einer Flimmerfrequenz von 48 Hz (doppelte Projektion) beziehungsweise 72 Hz (dreifache Projektion). Auch die Leuchtdichte der Kinoleinwand liegt unter 50 cd/m2, was die Helligkeit der Bildwiedergabe dimmt und damit die Flimmerempfindlichkeit verringert.

Gerade im Zusammenhang mit stereoskopischen Anwendungen (3D) wird mittlerweile empfohlen, die Bildwechselfrequenz in allen Formaten zu erhöhen. Kino- und Fernsehstandards sollten demnach mit 80, 100 oder sogar 120 Bildern pro Sekunde arbeiten, denn eine höhere Bildwiederholungsrate kann (gerade bei 3D-Filmen) die Qualität erheblich verbessern, da sie das Bildflimmern beziehungsweise -ruckeln und damit die Bewegungsunschärfe vermindert. Im Rahmen der Digitalisierung der Formate für Kinofilme (High Frame Rate: HFR/HFR 3D) etablierte sich Digital Cinema Initiatives (DCI) als entsprechender Standard.

In Deutschland wurde der erste Kinofilm im Jahre 2012 mit 48 Bildern pro Sekunde veröffentlicht (Der Hobbit). Die Fortsetzung von James Camerons „Avatar“, dessen Kinostart für 2017 vorgesehen ist, soll mit 60 Bildern pro Sekunde gedreht und projiziert werden. Dafür müssen die Kinos entsprechend auf Projektoren umrüsten, die die erforderlichen 96 beziehungsweise 120 Hz beherrschen. Der erste HFR-3D-Projektor mit 60 Bildern pro Sekunde wurde im Jahre 2013 im österreichischen Cinepoint in Tirol installiert.

Fernsehen

Im Laufe der Entwicklung der Fernsehtechnik erhöhte sich die Anzahl der Bildzeilen, bis sich schließlich zwei Werte etablierten. In Europa ergab sich schon allein aus der traditionellen Frequenz des Netzwechselstroms von 50 Hz eine Festlegung von 625 Zeilen pro Bild, was 25 Vollbildern in der Sekunde und damit einer Bildrate (Halbbilder) von 50 Hz entsprach (15.625 Zeilen pro Sekunde: PAL). Parallel dazu wurde der US-amerikanische Standard von 30 Vollbildern pro Sekunde festgelegt, was wiederum 525 Zeilen pro Bild beziehungsweise 15750 (NTSC) zu bildende Zeilen in der Sekunde entspricht (vgl. Kapitel: „Fernsehnormen“).

Aufgrund der bestehenden Fernsehnormen (in Europa) funktioniert auch mit der Halbleitertechnik bei modernen digitalen Videosignalen die Fernsehbildübertragung auf der Basis einer Bildwiederholungsfrequenz von 50 Hz. Allerdings setzt sich allmählich - schon allein aufgrund der mittlerweile sehr großen Fernsehgeräte - eine verdoppelte Bildwiederholungsfrequenz (100 Hz) durch. Denn das bereits beschriebene Großbildflimmern erhöht sich vor allem bei Standbildern oder aber ruckartigen Bewegungen beziehungsweise Kameraschwenks, je größer der Bildschirm ist. Allerdings arbeiten auch hier manche Fernsehgeräte mit der einfachen Methode, die einzelnen Halbbilder doppelt zu projizieren. Die daraus resultierenden Qualitätseinbußen machen sich vor allem an „ausgefranzten“ horizontalen Laufschriften (z.B. Börsenticker) bemerkbar. Teurere Geräte verfügen über eine aufwendige Technologie, die es ermöglicht, die empfangenen Bilder neu zu berechnen, bevor sie dargestellt werden. Bewegtbilder erscheinen hier flüssiger. Doch grundsätzlich kann die Qualität der Bilder nur so gut sein, wie sie einst aufgenommen wurden.

Bildabtastung

Für das Auslesen und Anzeigen von Bildinformationen stehen heutzutage generell zwei Techniken zur Verfügung: das Zeilensprungverfahren und die progressive Abtastung im Vollbildmodus. Werden beide Verfahren kombiniert, kommt es nicht selten zu Fehlern in der Darstellung und damit zu sogenannten Artefakten. Denn moderne Fernseh- und Computerbildschirme, die mit der sogenannten progressiven Bildabtastung arbeiten, können herkömmlich im Halbbildverfahren erstellte Bilder nur bedingt „zusammensetzen“. Wurde beispielsweise ein Film im Jahre 1973 mit 25 Voll- beziehungsweise 50 Halbbildern im Zeilensprungverfahren gedreht, so kann er über vierzig Jahre später selbst mit einem hochwertigen 100-Hz-Fernseher kaum in bester HD-Qualität gezeigt werden. Deshalb ist nicht selten der Spruch zu hören oder zu lesen, dass ausschließlich die gute alte Röhre knackscharfe Halbbilder wiedergeben kann, weil nur sie seinerzeit dafür konzipiert wurde. Da ist etwas Wahres dran.

Zeilensprung-/Halbbildverfahren (Interlaced Scan)

Der englische Begriff „Interlace“ bezeichnet Bildsignale, die im Zeilensprungverfahren arbeiten. Die entsprechenden Formate sind PAL, NTSC und das HD-Format 1080i. Das Zeilensprungverfahren oder auch Zwischenzeilenverfahren wurde bereits Ende der 1920er Jahre von Fritz Schröter (Telefunken) entwickelt und 1930 als „Verfahren zur Abtastung von Fernsehbildern" patentiert (DRP-Patent Nr. 574085). Ziel der Entwicklung war die flimmerfreie Anzeige von Signalen mit einer möglichst geringen Bandbreite. Noch heute wird teilweise mit diesem Zeilensprungverfahren gearbeitet und vor allem in CCD-Sensoren verwendet.

Wird ein Zeilensprungbild erzeugt, werden dabei zwei Felder mit Zeilen generiert. Aus einem Videovollbild (Frame) entstehen somit zwei unterschiedliche Halbbilder (Fields), die nacheinander übertragen und aufgebaut werden. Das erste Halbbild (Upper Field) enthält alle ungeradzahligen Zeilen des Bildes. Für das zweite Halbbild (Bottom Field oder Lower Field) werden nur die geradzahligen Zeilen dargestellt.

Vereinfachte Darstellung des Zeilensprungverfahrens

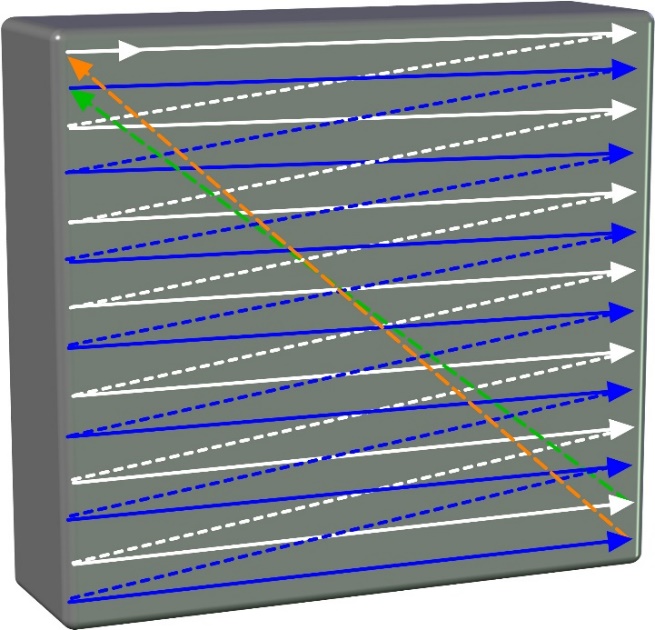

Neben der später entwickelten progressiven Bildabtastung (vgl. Kapitel „Vollbildverfahren“) erfolgt der Bildaufbau bei der klassischen Fernsehübertragung im Rahmen des Zeilensprungverfahrens, wie in obiger Abbildung dargestellt. Dabei wird oben links gestartet (weißer Pfeil).

Ein sogenannter Zeilen-Synchronimpuls im Fernsehsignal löst den Zeilenrücklauf aus, wobei der Elektronenstrahl in der Bildröhre für diese Zeit dunkel geschaltet wird. So wird Zeile für Zeile abgetastet, bis der untere Bildrand erreicht ist. Anschließend folgen einige Zeilen mit sogenannten Kennimpulsen (Vortrabanten, Bildsynchronimpuls, Nachtrabanten), bis der Bildrücklauf initiiert wird (grüner Pfeil). Während dieser sogenannten Austastlücke werden keine Bildinformationen übertragen, der Elektronenstrahl wird dunkelgetastet – ist also für das menschliche Auge nicht erkennbar. Das zweite Halbbild wird auf dieselbe Art und Weise übertragen (blaue Pfeile), am Ende landet der Rückstrahl (oranger Pfeil) wieder auf der ersten Bildzeile.

Allerdings werden diese Zeilen dennoch genutzt, beispielsweise für den klassischen Videotext oder aber IP-gestützte Informationen in Smart-TVs. Ist dieser Vorgang abgeschlossen, wird das nächste Bild aufgebaut. Der Bildaufbau erfolgt abwechselnd zeilenversetzt (weiße/blaue Pfeile). Im Idealfall werden die Zeilensprünge zu einem Gesamtbild von 625 Zeilen (Europa) integriert, wovon maximal 525 sichtbar (aktiv) sind. Die ungerade Zeilenzahl ist auf den Strahlrücksprung zurückzuführen, der bei beiden Halbbildern auf dem gleichen Vertikalspannungsniveau stattfindet. Wäre dies nicht gegeben, müssten die Spannungen pro Halbbild leicht verändert werden, was zu dem Problem führen kann, dass die Zeilen des zweiten Halbbildes nicht exakt zwischen denen des ersten abgebildet werden können.

Da also beim Senden eines Zeilensprungbildes immer nur die Hälfte der Zeilen übertragen wird, halbiert sich damit auch die Bandbreitennutzung. Sofern der Empfänger (z.B. Röhrenfernseher) ebenfalls mit der Zeilensprungtechnik arbeitet, werden auch hier zuerst die ungeraden und dann die geraden Zeilen eines Bildes angezeigt. Im Wechsel werden die so entstehenden Bilder mit einer Bildrate von 25 (PAL) oder 30 (NTSC) Vollbildern pro Sekunde aktualisiert. Das menschliche Auge kann diese Zeilensprünge nicht wahrnehmen, sondern erkennt nur vollständige Bilder. Im englischen Sprachraum wird diese Art der Bildübertragung „interlaced scan“ genannt, aber auch in Deutschland hat sich dieser Begriff mittlerweile durchgesetzt.

Vereinfachte Darstellung des Halbbild- bzw. Zeilensprungverfahrens (interlaced)

Deshalb werden Zeilensprungdarstellungen generell mit dem Buchstaben „i“ (wie interlacing) gekennzeichnet. Taucht also die Bezeichnung „480i“ auf, handelt es sich um eine Darstellung im Zeilensprungverfahren mit zwei Halbbildern. Gerade bei dem Wert „1080i“ im HDTV-Bereich kommt es nicht selten zu Missverständnissen, da im Allgemeinen oft angenommen wird, dass dieses Verfahren ausschließlich im analogen Fernsehen angewendet wurde. Doch tatsächlich steht in der digitalen Videodarstellung das „i“ ebenfalls für das Zeilensprungverfahren (Interlace) und die Zahl 1080 für die vertikale Auflösung.

Im Gegensatz zum ursprünglichen Analog-Fernsehen im PAL-Format löst HDTV (1080i) mit einem Wert von 2.073.600 Bildpunkten fünf Mal so hoch auf. Näheres hierzu findet sich in den Kapiteln „Grundlagen des Digitalfernsehens“ sowie „Video-Features der Zukunft“.

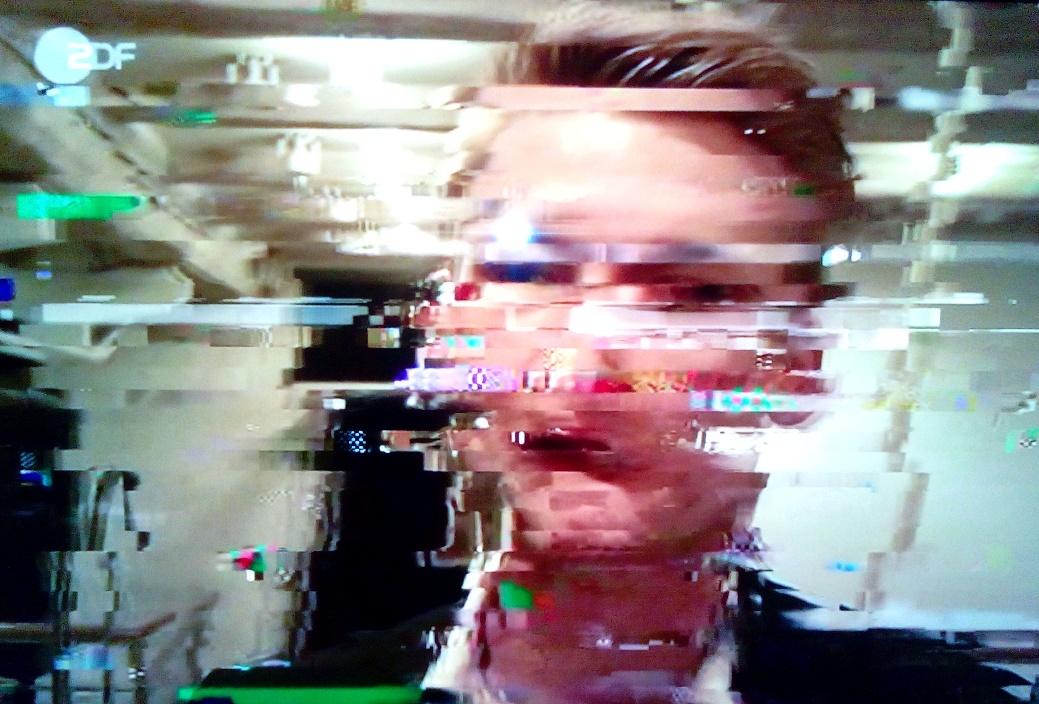

Zeilensprung-Artefakte

Wie bereits erwähnt, kommt es weniger innerhalb des Zeilensprungverfahrens, sondern vor allem bei der Kombination verschiedener Abtasttechniken zu sogenannten Artefakten. Werden Filme, die im Zeilensprungverfahren generiert wurden, auf Computerbildschirmen oder Fernsehgeräten mit progressiver Abtastung dargestellt, entstehen quasi zwangsläufig Fehldarstellungen; umgekehrt trifft dies ebenfalls zu: horizontale Kanten tanzen scheinbar auf und ab, einst homogene Flächen werden streifig dargestellt. Hat man also den Anspruch, mit einem digitalen ultrahochauflösenden Bildschirm mit Vollbildfahren einst analog und im Halbbildverfahren hergestellte Filme in bester Qualität zu sehen, wird man in der Regel enttäuscht.

Der Grund: Was einmal zerlegt war, kann niemals wieder vollständig zusammengefügt werden. Doch auch die immer höhere Bildkomprimierung in digitalen Displays ist für Mängel in der Wiedergabe verantwortlich. Hier werden Verzerrungen erzeugt, die man ebenfalls als Artefakte bezeichnet. Bei zeilensprungfähigen Monitoren oder Fernsehern sind diese kaum erkennbar, die neueren Geräte arbeiten allerdings zumeist mit progressiver Abtastung, bei der die Bildzeilen fortlaufend aufgebaut werden. Hier sind die Artefakte sichtbar und werden unter anderem als „Zacken“ wahrgenommen, die ursprünglich durch kurze Verzögerungen bei der Aktualisierung der geraden und ungeraden Zeilen entstanden sind. Denn ursprünglich stellte nur die eine Hälfte der Zeilen im Bild jeweils eine Bewegung dar, während die andere Hälfte aktualisiert wurde.

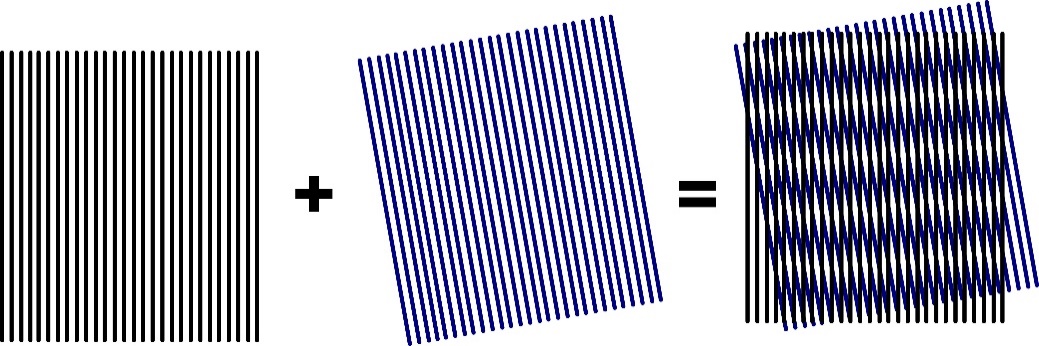

Besonders Standbilder von Videos, die seinerzeit im Zeilensprungverfahren erzeugt wurden, neigen bei Geräten mit progressiver Abtastung zu Fehldarstellungen. Werden diese Standbilder von einem Halbbild gemacht, reduziert sich die vertikale Auflösung. Dieser Bildverlust wird auch als Interlace-Faktor bezeichnet und mit etwa 30 Prozent beziffert. Bei einem Vollbild weisen vor allem bewegte Bildelemente kammerartige Doppelstrukturen auf und es kommt zu einer unschönen Zackenbildung. Hier stecken beide Halbbilder wie Kämme ineinander und wirken seitlich versetzt. So entsteht der sogenannte Moiré-Effekt (vgl. Abbildung), der durch eine falsche Überlagerung der Halbbilder verursacht wird. Es kommt zu einem Flackern des Bildes, das typisch ist für den Spezialfall des Alias-Effekts durch Unterabtastung.

Moiré-Effekt

Auch bei schnellen Bewegungen oder rasanten Kameraschwenks ist es beim Zeilensprungverfahren kaum mehr möglich, aus den beiden Halbbildern ein deckungsgleiches Bild zu erstellen. Unsaubere Konturen und unruhige Bilder mit störenden Streifenmustern sind die Folge. Zur Lösung dieser Probleme wurde eine neue Form der Bildabtastung entwickelt, bei der die mängelbehaftete Halbbildwiedergabe entfällt.

Progressive Abtastung (Vollbildverfahren)

Die progressive Abtastung wurde ursprünglich in CCD- und CMOS-Sensoren und heute überwiegend in der Bildübertragung verwendet. Hier werden Vollbilder dargestellt, die sich kontinuierlich Zeile um Zeile von oben nach unten aufbauen. Die Darstellung der einzelnen Zeilen eines Progressive-Scan-Bildes erfolgt insofern fortlaufend (also progressiv): zuerst Zeile 1, gefolgt von Zeile 2, dann 3, 4, 5 und so weiter. Im Computerbereich war von jeher die progressive Abtastung üblich. Videokameras der Neuzeit, Flachbildschirme auf Plasma- oder LCD-Technologie sowie Displays und Monitore im Allgemeinen arbeiten heute generell „progressive“. Hierfür steht das „p“ in den Bildratenangaben von Videoformaten (z. B. 24p oder 25p). Bei der Bezeichnung „1080p“ handelt es sich um eine progressive HDTV-Darstellung mit 1080 Zeilen, bei „1080/24p“ um die gleiche Darstellung mit 24 Vollbildern (im Kino).

Wenn also - anders als beim Zeilensprungverfahren – echte Vollbilder und keine zeilenverschränkten Halbbilder gesendet und empfangen werden, verschwindet somit auch das Zeilenflimmern weitgehend. Mit dem Vollbildverfahren wird insofern eine höhere vertikale Auflösung erreicht, was wiederum dazu führt, dass Artefakte (z.B. ausgefranste Objektkanten) vermieden werden können.

De-Interlacing

Da viele aber auch heute noch Gefallen an den TV-Evergreens und Kino-Hits des 20. Jahrhunderts finden, wurde ein technisches Verfahren entwickelt, um quasi das einst historisch produzierte Filmmaterial für die Neuzeit bestmöglich aufzubereiten – also Halb- in Vollbilder zu konvertieren. Die aus dem Englischen übernommene Bezeichnung „De-Interlacing“ beschreibt im Grunde jenen Vorgang dieser Zeilenentflechtung. Wie wir wissen, ist dies heutzutage generell nötig, insbesondere dann, wenn Filme im Zeilensprungverfahren aufgenommen wurden, aber über Anzeigegeräte dargestellt werden sollen, die über einen anderen zeitlichen beziehungsweise vertikalen Bildaufbau verfügen. Mit der heutigen Technik stellt das De-Interlacing an sich kaum mehr ein Problem dar.

Moderne Fernsehgeräte sowie DVB-Empfänger, Blu-ray-Player oder Computer verfügen über einen integrierten De-Interlacer, der die Bildfrequenz zumeist automatisch anpasst. Jedoch basieren sowohl DVD- als auch antennenbasierte TV-Tunersignale (DVB-T) nach wie vor auf den Standards des Halbbildverfahrens. Insofern bleibt auch zukünftig ein exaktes De-Interlacing äußerst wichtig – jedenfalls bis zur generellen Umstellung auf DVB-T2 und restlichen Entsorgung der DVD-Player. Dabei bleibt das Grundproblem: Was einmal in Halbbilder aufgeteilt war, lässt sich nicht mehr exakt in Vollbilder wandeln. Exemplarisch sollen im Folgenden zwei Verfahren im Rahmen des De-Interlacings erläutert werden, wobei sich diese nicht generell auf die Konvertierung von Halb- in Vollbilder beziehen, sondern im ersten Beispiel auf die Bearbeitung von Halbbildern und ihren Bildwechselfrequenzen.

Pulldown

Wer es sich am Freitagabend auf seinem Sofa gemütlich macht und die preiswert erstandene DVD mit einem Blockbuster aus seiner Jugendzeit in den Blu-ray-Player schiebt, der denkt natürlich kaum darüber nach, ob sich die Bildformate und Bildraten überhaupt vertragen. Möchte man also einen Kinofilm (24 Vollbilder) für PAL (50 Halbbilder) optimieren, ist dies nicht ganz so einfach zu realisieren. Der Trick besteht darin, dass bei einer PAL-DVD anstatt der 24 Bilder im Original eben 25 überspielt werden (2:2-Pulldown). Insofern ist die logische Schlussfolgerung, dass ein Kinofilm auf einer DVD minimal schneller läuft, sich also die Laufzeit um zirka vier Prozent verkürzt.

Bei der Optimierung für NTSC mit einer Bildwechselfrequenz von 60 Hz ist das 2:2-Pulldown-Prinzip allerdings nicht möglich, da in diesem Fall von 24 Vollbildern in 60 Halbbilder konvertiert werden muss. Hier wird deshalb das erste Film-Einzelbild (A) dreimal wiederholt, das zweite Film-Einzelbild (B) nur zweimal. Diese Sequenzen werden nun sechs Mal im 3:2-Rhytmus wiederholt und in jeweils zwei Halbbilder zerlegt. Drei Bilder (A) und zwei Bilder (B) ergeben also insgesamt fünf Vollbilder. Sechsfach erstellt, ergeben sich insofern 30 Vollbilder, die in 60 Halbbilder zerlegt werden können. Diese Vorgehensweise wird entsprechend als 3:2-Pulldown bezeichnet. Aber auch für Videomaterial im Heimkinobereich ist das exakte De-Interlacing mittlerweile unabdingbar, zumal die hochauflösenden Wiedergabegeräte jede Bildverschlechterung konsequent anzeigen.

Referenzvideo der Firma BUROSCH zur Überprüfung eines De-Interlacers

Die Firma BUROSCH bietet hierzu Realfilmsequenzen an, die die Struktur von Hausdächern zeigen (vgl. Abbildung). Der Film funktioniert quasi wie ein Testbild: Flimmern die einzelnen Dachziegel, so arbeitet der De-Interlacer nicht akkurat. Ruckelt der Bewegungsablauf, so ist ebenfalls von einem unzureichenden De-Interlacing auszugehen.

Weave

Sollen im Umkehrverfahren Vollbilder als zwei aufeinander folgende Halbbilder mit demselben Zeitindex übertragen werden, muss vor der Darstellung das einfache Deinterlacing-Verfahren Weave angewendet werden. Hier wird das Bildmaterial im Vollbildverfahren aufgenommen und im Anschluss durch ein zusätzliches Videosignal in zwei Halbbilder zerlegt, um diese dann im Zeilensprungverfahren zu übertragen. Diese Technik wird als progressive segmented Frame (psF) bezeichnet und ermöglicht die Darstellung von Progressive-Scan-Bildern auf Geräten, die für das Zeilensprungverfahren ausgelegt sind.

Herkömmliche Übertragungsverfahren (z.B. PAL, NTSC) verwenden diese Methode, wozu im Übrigen auch das HDTV-Format 1080i gehört. Damit die übertragene Datenmenge ungefähr gleich bleibt, wird beispielsweise bei (Full HD) aufgrund der höheren Zeilen- oder Vertikal-Auflösung die zeitliche Auflösung halbiert. Filmmaterial, das auf diese Weise bearbeitet wurde, erhält die Kennzeichnung „psF“ (z.B. 1.080psF oder 576psF).

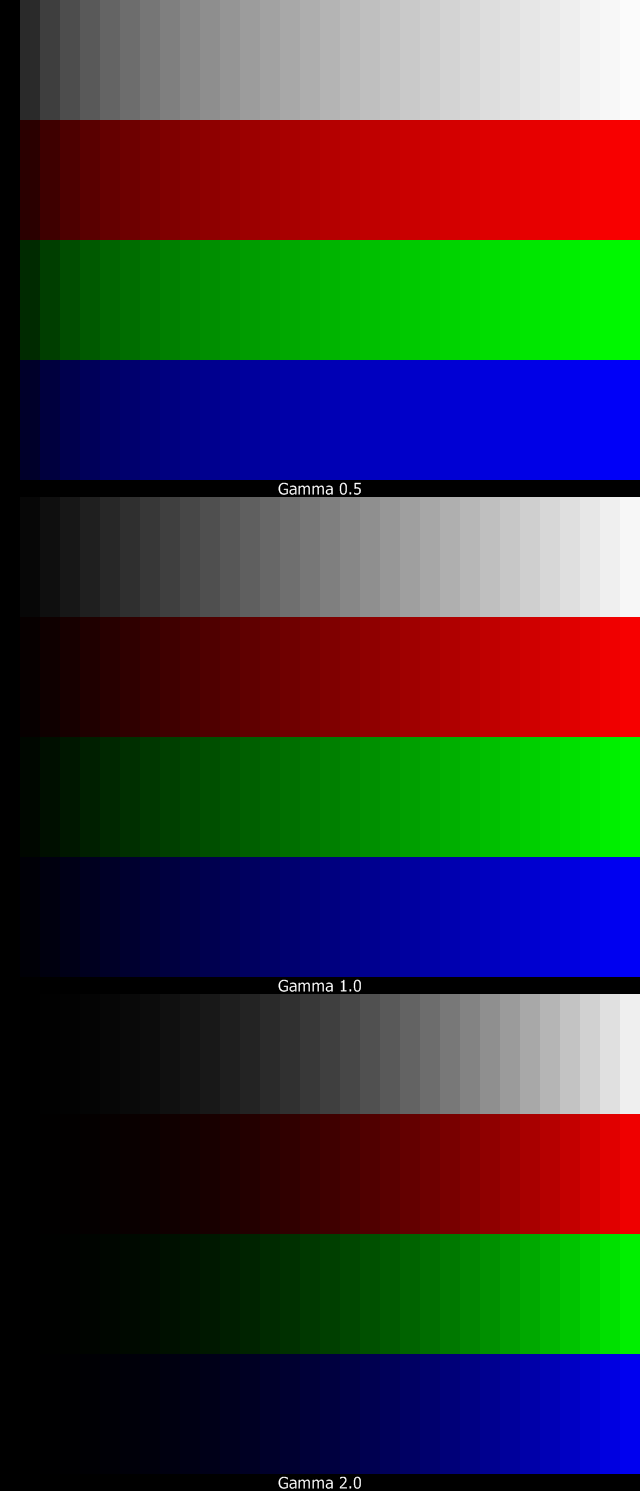

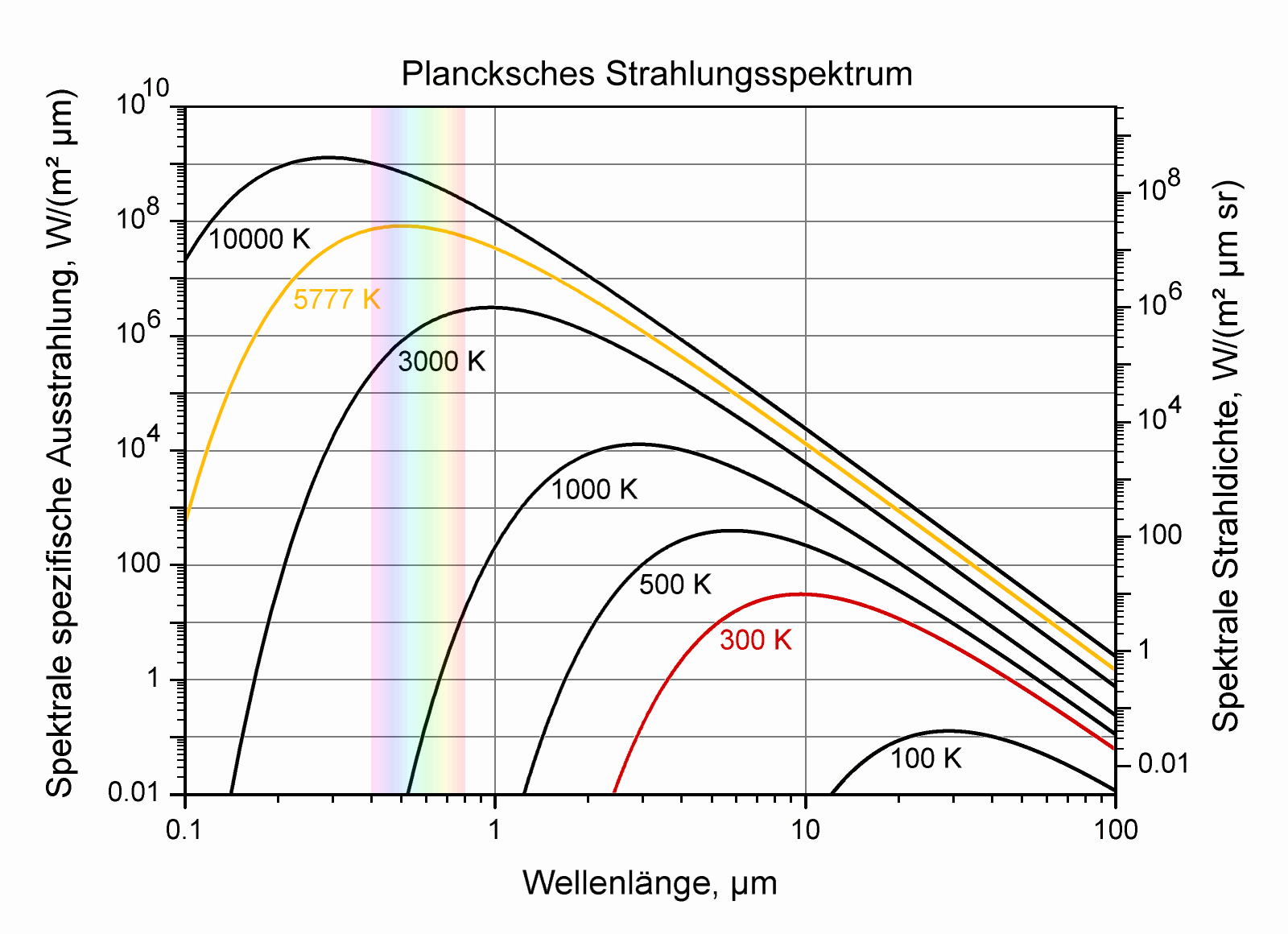

Gamma-Korrektur

Die Gammakorrektur ist eine hauptsächlich im Bereich der Bildverarbeitung oft verwendete Korrekturfunktion, welche ihre historischen Ursprünge jedoch in der Röhrenbildschirmtechnologie hat. Die Bildschirme früherer TV-Geräte konnten das Bildsignal nicht linear wiedergeben. Da es einfacher war, diese Nichtlinearität in den wenigen eingesetzten Kameras anstatt in allen Empfangsgeräten auszugleichen, wurden die Kameras dahingehend modifiziert mit nichtlinearen Signalen zu arbeiten.

Eine Gammakorrektur wird in abbildenden Systemen benötigt, um das nichtlineare Helligkeitsempfinden des menschlichen Auges zu kompensieren. Das Auge reagiert beim Anstieg auf eine doppelte Helligkeit nicht zwangsläufig mit einer Verdopplung der Helligkeitsempfindung. Die empfundene Helligkeit steigt in dunklen Bereichen steiler und in hellen weniger steil an. Das menschliche Auge hat ein Gamma von etwa 0,3 bis 0,5.

Grafik zur Bestimmung des Gammawerts im Selbsttest

Durch unterschiedliche Kontrastumfänge, Verläufe von Tonwertkurven, Gamma-Werte, Umweltbedingungen bei der Bildverarbeitung, individueller Wahrnehmung und Bildwiedergabe sowie der sequentiellen Anwendung mehrerer unterschiedlicher Verfahren mit verschiedenen Eigenschaften bei der Bilderzeugung, ist es notwendig, eine Gammakorrektur durchzuführen, um ein Bild als Ergebnis zu erhalten, welches entweder dem Originalbild entspricht oder aber mindestens den gewünschten Anforderungen.

Die Wahrnehmung des menschlichen Sehens ist nicht linear. Elektronische Displays sollen die menschlichen Sehgewohnheiten simulieren (nachbilden). Daher wird eine Korrektur notwendig, denn ein elektronischer Sensor, wie etwa ein CCD-Chip oder eine Elektronenstrahlröhre, arbeiten annähernd linear. Um dieses Problem so gut wie möglich zu beheben, wurde die Gammakorrektur eingeführt: A = EΥ (A: Ausgangssignal; E: Eingangssignal). Bei der Berechnung des Ausgangssignals A werden nur die Grauwerte verändert, Schwarz- und Weißpunkt bleiben erhalten, wenn das Eingangssignal E im Intervall [0,1] liegt, beziehungsweise auf 1 gesetzt wurde. Diese Korrekturfunktion trägt den Namen des Exponenten Gamma (Υ).

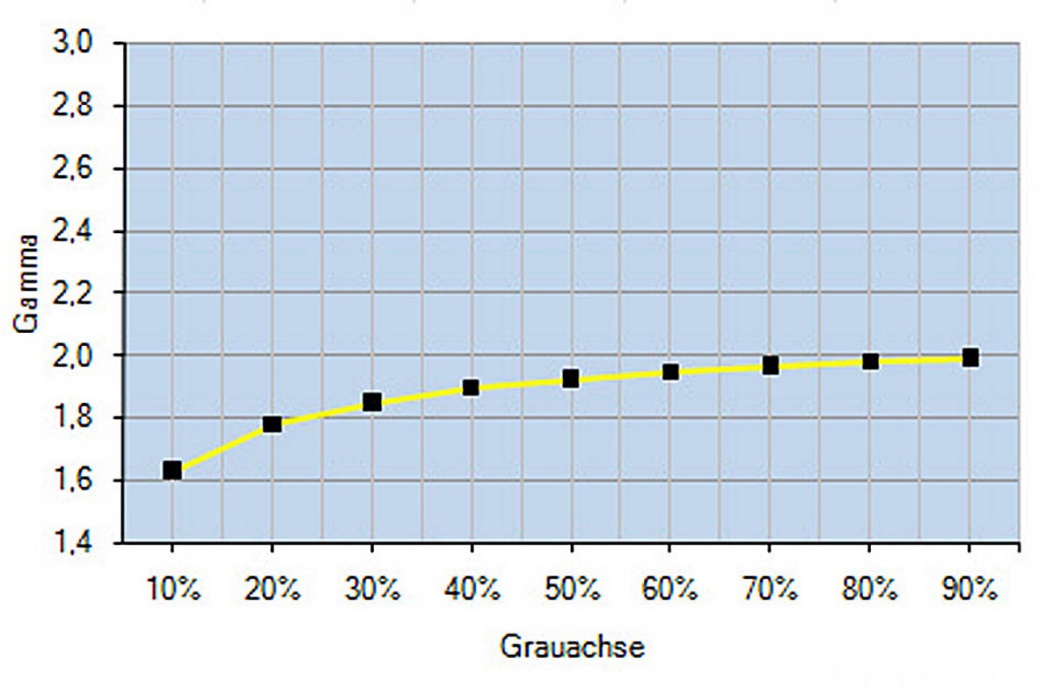

Beispiel für Gamma-Wert 2.0

Bei einem Gamma von 1 ist das Ausgangssignal gleich dem Eingangssignal. Bei einem Gamma größer als 1 wird die Ausgabe insgesamt etwas dunkler, hellere Stufen einer Grautreppe sind stärker abgestuft als die dunkleren. Bei einem Gamma kleiner als 1 wird die Ausgabe insgesamt heller, die dunkleren Stufen einer Grautreppe sind demnach stärker abgestuft als die hellen, ohne dass jedoch der hellste Wert Weiß (100 % Weiß) und der dunkelste Wert Schwarz (0 Prozent Weiß) dabei in der Helligkeit verändert wird.

Die Hersteller moderner Displays halten sich strikt an einen “idealen” Gammawert von ca. 2,2, um eine reale Helligkeitsempfindung des menschlichen Auges sicherzustellen. Der typische Gammakorrektur-Wert eines PC-Monitors oder eines digitalen TV-Gerätes liegt bei 2.2. Typischerweise kann dieser Wert auch über die Konfiguration des jeweiligen Bildschirms oder auch innerhalb des Betriebssystems verändert werden, eine Änderung ist jedoch nicht empfehlenswert. Auch fotographische Labore, welche Bildschirme testen, arbeiten mit einem Gammakorrektur-Wert von 2.2. Die entsprechende Belichtung eines für gut befundenen Bildes am Monitor ist daher nur bei einem Gammakorrektur-Wert von 2.2 garantiert.

Unter Mac OS galt für den Standard-Gammakorrektur-Wert von 2.2 bis vor kurzem noch eine Ausnahme. Mac OS verwendete in der Vergangenheit einen Gammakorrektur-Wert von 1.8. Dieser Wert war für einen Workflow ohne Farbmanagement gedacht. Der Gammakorrektur-Wert 1.8 führte dazu, dass die Darstellung auf dem Bildschirm besser der Tonwertreproduktion von Schwarzweißdruckern entsprach. Seit Mac OS X 10.6 (Snow Leopard) liegt der Standard-Gammakorrektur-Wert auch unter Mac OS bei 2.2.

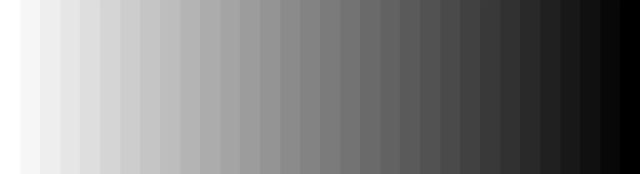

Nachfolgend wird anhand von vier markanten und geeigneten Beispielen die unterschiedlichen Gammafunktionen erklärt. Das Originalbild (folgende Abbildung) zeigt einen 32-stufigen Graustufenkeil mit zunehmender linear abgestufter Helligkeit von links nach rechts – linkes Feld 100 Prozent Weiß, rechtes Feld komplett Schwarz.

Gamma-Korrektur/Originalbild

Bei einem zu hohen Gamma sind die helleren Felder stärker abgestuft als die dunkleren, das heißt dunkle Bereiche im Bild lassen sich nicht mehr auseinanderhalten (vgl. folgende Abbildung).

Gamma-Korrektur/Gamma zu hoch

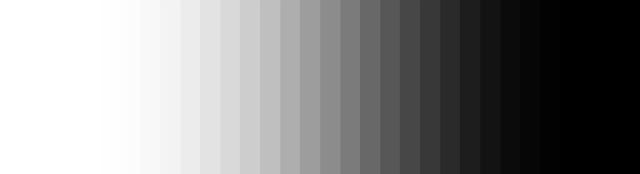

Bei einem zu niedrigem Gamma sind die dunkleren Felder stärker abgestuft als die helleren, das heißt helle Bereiche im Bild lassen sich nicht mehr auseinanderhalten (vgl. folgende Abbildung).

Gamma-Korrektur/Gamma zu niedrig

Bei einem S-förmig verzerrtem Gamma sind die mittelgrauen Felder stärker abgestuft als die äußeren, das heißt helle sowie dunkle Bereiche im Bild lassen sich nicht mehr auseinander halten (vgl. folgende Abbildung)

Gamma-Korrektur/ Gamma „S“-förmig verzerrt

Auch wenn die Gamma-Korrektur eigentlich aus dem Röhrenzeitalter stammt, ist diese insbesondere im Zusammenhang mit HDR immer noch aktuell. Moderne Displays müssen die Gamma-Korrektur einsetzen, um die Opto-Electronic-Transfer-Funktion (OETF) von Videokameras zu kompensieren. Die Gamma Korrektur bildet in diesem Fall die Nichtlinearität alter Röhrenbildschirme nach und wird eingesetzt, um über das gesamte System eine nahezu lineare Abbildung zu gewährleisten. Mehr zum Thema HDR findet sich in diesem Buch im Kapitel „Video-Features der Zukunft“.

Bewegungsunschärfe

Bewegungen darzustellen, war von jeher das größte Problem der Fernsehtechnik. Der Grund dafür ist nicht nur in den einzelnen Technologien zu suchen, sondern vor allem in der menschlichen Wahrnehmung. Läuft eine Maus über den Boden, sieht man unwillkürlich hin, blinkt irgendwo ein Licht, kann man es nicht ignorieren, und ein Fernseher in einer dunklen Kneipe zieht alle Augen auf sich. Unsere Netzhaut ist nur in der Mitte scharf, während die Ränder besonders empfindlich sind für jede Art der Bewegung oder Veränderung.

Das hat natürlich Folgen in Bezug auf die riesigen Bilddiagonalen moderner TV-Displays. Während sich früher das Bild eines Röhrenfernsehers mit einem Blick erfassen ließ und die Augen nicht hin- und herwandern mussten, kann man bei den großen Flachbildschirmen heute ein Objekt von links nach rechts verfolgen und wieder zurück – und stellt dabei plötzlich Veränderungen fest: Was im Stand knackscharf aussah, bekommt plötzlich weiche Konturen, die Bewegung erscheint ruckelnd und abgehackt. Bei rasanten Schwenks der Kamera bricht die Detailauflösung schlimmstenfalls komplett zusammen. So rückt die Bewegungsdarstellung ins Zentrum der Beurteilung von Bildschirmen. Schließlich handelt es sich bei Video- und TV-Signalen nicht um Standbilder. Anders als bei den Grundparametern Kontrast, Schärfe oder Farbumfang gibt es für die Darstellung von Bewegung aber kein genormtes Messverfahren, nicht einmal Testsignale für alle Problemfelder. Im Gegenzug gibt es jede Menge Probleme, die vielfältige Ursachen haben. Manche entstehen schon bei der Aufnahme, andere bei der Übertragung – und der Bildschirm selbst ist auch nicht ganz unschuldig.

Die Zeiten, in denen das Signal von der Kamera zum Fernseher direkt durchgeschleift wurde, sind nämlich vorbei. Eine Röhrenkamera tastete eine fotoempfindliche Schicht noch Zeile für Zeile ab und leitete die daraus entstehenden elektrischen Schwingungen weiter, bis sie schließlich auf dem Röhrenfernseher Zeile für Zeile wieder aufgebaut wurden. Heutzutage stecken zwischen CCD- beziehungsweise CMOS-Sensor und Flatscreen jede Menge Bildspeicher und Wandler, die das Signal an die Gegebenheiten von Studio, Übertragungsstrecke und Display anpassen.

Das klassische Bewegtbild ist der Kinofilm. Er wird schon seit bald einhundert Jahren mit 24 Bildern pro Sekunde aufgenommen. Absolut gesehen, sind 24 Bilder pro Sekunde (Hertz, Hz) viel zu wenig. Denn für eine flüssige Bewegungsdarstellung braucht man mindestens 50 Hz – erst dann erscheint dem Auge eine Abfolge von Einzelbildern ruckelfrei. Damit das Bild nicht erkennbar flackert, sollte die Bildwiederholungsfrequenz noch höher sein. Deshalb projiziert man jedes Bild im Kino zwei- oder dreimal, sodass man auf 48 oder 72 Hz kommt. Aber selbst wenn es dann nicht mehr flimmert, der unsaubere Bewegungsablauf bleibt. Und zwar auch dann, wenn der Film digital aufgenommen wurde, denn auch hier hat sich Hollywood auf 24 Hz festgelegt. Ein Grund dafür ist die Tatsache, dass schnelle Schwenks oder rasante Kamerabewegungen auf der großen Kinoleinwand eher zu Übelkeit im Publikum führen. Also nimmt man es in Kauf, dass quer durchs Bild fahrende Autos eben etwas ruckeln. In der DCI-Spezifikation für das digitale Kino ist zwar eine Verdoppelung auf 48 Hz bei der Aufnahme vorgesehen, realisiert wird diese Vorgabe jedoch nur bei 3D-Filmen. Denn 48 Hz lassen sich nicht zu 72 Hz verdoppeln, und die Wandlung in 60 Hz ist noch schwieriger als bei 24 Hz (vgl. Kapitel „Pulldown“). Neben den 24 Hz des Kinofilms existieren auch Filmaufnahmen mit 25 oder 30 Bildern pro Sekunde – beides sind Standards, die sich an der TV-Ausstrahlung orientieren.

Gern übersehen wird ein zweiter Punkt, der darüber entscheidet, wie stark Filmbilder ruckeln: die Verschlusszeit. Jeder Fotoamateur weiß, dass es verwischte oder verwackelte Aufnahmen gibt, wenn die Blende nicht schnell genug öffnet und schließt. Wenn der Kameramann also viel Licht braucht und deswegen den Verschluss lange offen lassen muss, sind bewegte Objekte im Bild ohnehin unscharf. In diesem Fall wirkt eine solche Aufnahme bei der Wiedergabe auch nicht ruckelig, sondern soft. Bei kurzer Shutter-Öffnung dagegen bleiben harte Kanten erhalten, dafür fällt das 24-Hz-Ruckeln umso mehr auf.

Ein Teufelskreis, der nicht so leicht zu durchbrechen ist. Bei 100-Hz-Geräten wird beispielsweise ein Zwischenbild errechnet, indem man das Bild vorher und nachher heranzieht. Wenn sich Objekte gegeneinander bewegen (wie beim EM-Halbfinale Fußball und Hintergrund), fehlen die Ergänzungsinformationen an den Konturen - der sogenannte Halo-Effekt tritt auf.

Für scharfe Konturen und ruckelfreie Bewegungen eignen sich nur Videokameras mit Vollbildabtastung (Progressive Scan) und mindestens 50 Hz. Aus diesem Grund haben sich zum Beispiel ARD und ZDF entschieden, bei HDTV auf das System 720p/50 zu setzen, das 50-mal pro Sekunde volle 1280 mal 720 Pixel liefert. Das von vielen anderen Sendern verwendete 1080i halbiert wie alle anderen Interlaced-Verfahren die Bewegungsschärfe. Das Ziel der TV-Übertragung heißt deshalb 1080p mit 50 oder 60 Bildern (je nach Fernsehnorm) pro Sekunde.

Local Dimming

Hersteller setzen immer mehr auf das sogenannte Local Dimming und machen mit dieser Funktion viel Werbung. Tatsächlich handelt es sich um ein Feature, das durchaus erwähnenswert ist. Grundsätzlich möglich ist das Local Dimming bei LCD/LED-Displays mit entsprechender Funktion und flächendeckender Hintergrundbeleuchtung (Direct-LEDs) oder aber seitlichem Backlight (Edge-LEDs). Wie wir es vom Lichtschalter mit Dimming-Funktion kennen, können die LEDs im Backlight partiell ausgeschaltet werden, was satte Schwarztöne und die Darstellung winziger Bilddetails in dunklen Szenen zur Folge hat. Das heißt, die Hintergrundbeleuchtung kann so besser dem Bild angepasst werden und wirkt weitaus homogener (gleichmäßiger) als bei herkömmlichen LCD-Panels. Besonders gut kann man die Qualität der Local-Dimming-Funktion in sehr dunklen Bildbereichen erkennen, in denen punktuell helle Sequenzen eingeblendet werden, beispielsweise bei einem Sternenhimmel oder einem beleuchten Hochhaus bei Nacht. Wenn die Hintergrundbeleuchtung qualitativ hochwertig ist, sind tatsächlich nur dort LEDs eingeschaltet, wo sich die Lichter in den Fenstern oder die Sterne befinden. Wenn nicht, kommt es zu unschönen Abbildungsfehlern. Lesen Sie dazu das folgende Kapitel.

Auch OLED-Displays profitieren von der innovativen Pixel-Dimming-Technologie, auf deren Basis nunmehr Bilder mit bisher undenkbaren Schwarzwerten, beeindruckender Tiefenwirkung und absolut lebensechten Farben dargestellt werden können. Anders als bei klassischen LED-Displays mit Hintergrundbeleuchtung kann hier jeder organische Pixel eigenständig und individuell Licht und damit Farbe erzeugen und sich ganz nach Bedarf selbständig an- oder ausschalten. Damit wird eine dynamische Genauigkeit bei der Bilddarstellung erreicht, die bei einem LCD-Bildschirm nicht möglich ist. Abgesehen davon sind OLED-Panels weitaus energieeffizienter und dünner, da auf eine Hintergrundbeleuchtung (LEDs) verzichtet werden kann. Darüber hinaus bieten OLED-Displays aus praktisch jedem Betrachtungswinkel ein verlustfreies und gestochen scharfes Seherlebnis – ohne Farbverzerrungen oder Detailverluste an den Bildschirmrändern.

Kurzum: Mit der Local-Dimming-Funktion können sich LEDs nicht nur selbständig ein- und ausschalten, sondern darüber hinaus auch noch je nach Bedarf heller oder dunkler regeln (dimmen), was sich überaus vorteilhaft auf die Schwarzwerte und damit auf den Kontrast auswirkt. Hinzu kommt die klare abgegrenzte Darstellung von einzelnen hellen Bildelementen (z.B. Sterne) ohne Lichthöfe. Gerade im Zeitalter von HDR ist also eine solche Funktion quasi notwendig. Und vor allem Fans des Horrorfilms aber auch Gamer werden sich freuen, wenn auf dem Display alle Feinheiten der dunklen Nacht und sogar die Regentropfen zu erkennen sind, die dem Killer von der schwarzen Kutte perlen. Näheres zur praktischen Anwendung findet sich im Kapitel „Bildwiedergabesystem – NEXT GENERATION“.

Abbildungsfehler

Was zu Beginn des Fernsehens quasi dazugehörte, schrumpfte mit dem technologischen Fortschritt auf einige wenige sogenannte Abbildungsfehler oder Artefekte. Im Zeitalter von 4K, OLED und HDR sind diese kaum noch vorhanden. Aber auch wenn diese Abbildungsfehler mit den aktuellen und zukünftigen Displaytechnologien perspektivisch ihre Relevanz verlieren, sollten sie Erwähnung finden und werden deshalb im folgenden Kapitel beispielhaft erläutert.

Klötzchenbildung

Der Antennenempfang hat generell den Nachteil, dass er witterungsabhängig ist. Dabei hat sich im Rahmen der Digitalisierung kaum etwas geändert. Das sogenannte Überreichweitensignal schwankt atmosphärisch bedingt, was sich in der Bild- und Tonqualität niederschlägt. Ein Aussetzen des Signals führt zur berühmten Klötzchenbildung, eingefrorenem Standbild und Audioverzerrungen. Bei Gewitter kann es passieren, dass der Empfang komplett gestört ist. Auch sind Signalverzögerungen von mehreren Sekunden typisch für den terrestrischen Empfang. Während sich der Nachbar mit terrestrischem Fernsehen bei einem Fußballspiel noch die Daumen drückt, freut sich der Nachbar mit Satellitenempfang bereits über das geschossene Tor. Grund für das verzögerte Signal ist die Videocodierung beziehungsweise Decodierung im Empfänger, die mehrere Bildsequenzen umfasst. Insofern stößt DVB-T an seine Grenzen, die nicht zuletzt damit zusammenhängen, dass die Videodaten hauptsächlich als MPEG-2 codiert werden, obwohl es technisch durchaus möglich wäre, mit MPEG-4 codierte Video-Datenströme zu versenden. Hier wird der neue Standard DVB-T2 zukünftig zeigen, ob die versprochene Verminderung der Abbildungsfehler tatsächlich eintritt.

Klötzchenbildung bei schlechtem DVB-T-Empfang

Doch neue Standards versprechen nicht immer Fehlerfreiheit. In punkto Hintergrundbeleuchtung hat sich in den letzten Jahren einiges getan. LCD-Displays werden nicht mehr mit Leuchtstoffröhren bestrahlt. Das Schlagwort „Backlight“ ist keine Neuheit mehr. Allerdings kommt es bei den einhergehenden Abbildungsfehlern hier mitunter zu Verwirrungen. Einige Effekte, die vor allem auf eine mangelnde Homogenität der Hintergrundbeleuchtung zurückzuführen sind, sollen deshalb im Folgenden kurz erläutert werden.

Banding/Clouding

Der Fachbegriff "Banding" definiert das schlechte visuelle Ergebnis des nicht-synchronen Zusammenspiels zwischen verschiedenen signalverarbeitenden Stufen unter anderem bei der Bildwiedergabe eines Fernsehers. Im Idealfall sollte der Bildverlauf gleichmäßig und weich dargestellt werden. Je großflächiger das Display ist, desto deutlicher werden etwaig vorhandene Probleme bei der Signalverarbeitung visualisiert. Umso "flacher" das eigentliche Bild (z.B. Wolkenbilder, Gesichter/Hauttöne) und umso größer die physikalische Displayauflösung sowie Displayfläche ist, desto deutlicher kann der Banding-Effekt zutage treten.

Ursachen dafür finden sich auch und vor allem in aktuellen TV-Modellen durch das fehlerhafte Zusammenspiel zwischen einem normalen 8-Bit-Bildinhalt an sich, einer 8-Bit-Signalverarbeitung in der TV-Software und einem 10-Bit-Panel. So kann es zu deutlichen Treppenstufen in der Bilddarstellung kommen. Je nach Filmproduktion, dem eigentlichen Bild und der Display-größe sind diese Bandung-Streifen sichtbar, das heißt besonders bei Bildern von Wolken am Himmel, weshalb dieser Effekt auch „Clouding“ genannt wird.

Blooming

Vorwiegend bei dunklen Bildszenen kommt dieser Effekt (Blooming) zum Vorschein und bei Full-LED-Displays mit einer flächendeckenden Hintergrundbeleuchtung und Local-Dimming-Funktion. Der Vorteil dieser Technologie ist natürlich der großartige Kontrast, da im Backlight einzelne Bereiche (Cluster) je nach Anforderung dunkel- oder sogar ausgeschaltet werden können. Schwarz bedeutet dann tatsächlich schwarz. Bei fehlerhafter Verarbeitung der Panels und seinen unzähligen LEDs kann es jedoch passieren, dass im eigentlich dunkelgeschalteten Cluster ein oder mehrere LEDs fälschlicherweise nicht gedimmt werden. Eine punktuelle Dunkelschaltung ist somit nicht mehr gegeben, was eigentlich schwarz oder dunkelgrau sein sollte leuchtet zumindest teilweise in hellem Grau. Das technisch nicht ganz einwandfrei funktionierende Segment mit seinem nichtausgeschalteten LED strahlt also in das geforderte Schwarz. Daher hat dieser Effekt auch seinen Namen, denn im Englischen bedeutet „bloom“ nicht nur blühen, sondern auch strahlen. Wobei hier eigentlich die Schönheit gemeint ist, was eine gewisse Ironie nicht entbehrt.

Flashlights

Dieser Effekt ist mit dem Clouding verwandt und meistens bei sehr dunkler Umgebungsbeleuchtung zu erkennen. Er tritt in der Regel bei LED-Edge-Fernsehern auf, bei denen die Hintergrundbeleuchtung aus den Ecken oder Seiten kommt. „Flashlights“ bedeutet Taschenlampe. Bestimmte Bildbereiche erscheinen punktuell heller als gewollt, als würde jemand von hinten mit einer Taschenlampe leuchten, weshalb hier auch vom Taschenlampeneffekt die Rede ist. Gemeint sind helle Lichtkegel, die zumeist in den Ecken eines Displays auftreten und besonders dunkle Bildszenen verfälschen. Der Grund für solche Flashlights ist in der Regel in einer mangelhaften Hintergrundbeleuchtung zu suchen. Mitunter kann dieser Effekt aber auch auftreten, wenn das Gerät zu heiß geworden beziehungsweise Spannungen ausgesetzt ist.

Dirty-Screen-Effect (DSE)

Eine ungleichmäßige Ausleuchtung des TV-Display-Hintergrunds kann auch den sogenannten Dirty-Screen-Effekt zur Folge haben. Wie der Name vermuten lässt, handelt es sich hier um Schmutz auf dem Bildschirm, der natürlich eigentlich gar nicht vorhanden ist. Insbesondere bei Kameraschwenks entsteht dieser Eindruck, der jedoch auch durch eine schlechte MPEG-Codierung verursacht werden kann. In diesem Fall ist zumeist die Rauschunterdrückung im Fernseher zu hoch eingestellt. Feine Bilddetails werden in der Signalverarbeitung fälschlicherweise als Rauschen interpretiert (Rauschmuster).

Crosstalk/Ghosting

Dieser Effekt tritt ausschließlich bei der 3D-Wiedergabe auf. Neben dem herkömmlichen Anaglyphenverfahren oder der Polfiltertechnik sind Shutterbrillen für den anspruchsvollen 3D-Heimkinonutzer die bekannteste und beste Lösung (vgl. entsprechende Kapitel in diesem Buch). Leider bietet diese Technologie auch ein paar technische Probleme: Der sogenannte Crosstalk stört die Bildqualität bei der 3D-Wiedergabe. Gemeint sind sogenannte Geisterbilder (Ghosting), eine fehlgeleitete Bildinformation im rechten Auge, die eigentlich für das linke Auge bestimmt war. Diese zeigen sich insbesondere in auftretenden Doppelkonturen oder bei hohen Kontrastwerten in Form von schwarzen senkrechten Linien vor hellem Hintergrund. Diese Fehler in der 3D-Wiedergabe können nur mit entsprechenden Testbildern gemessen werden. Entsprechend den Segmentabschnitten einer Uhr kann auf den Crosstalk-Testbildern der Wert definiert werden, um wieviel Prozent die Bildinformation vom linken Auge Einfluss auf das rechte Auge hat. Dieser Wert ist abhängig vom Luminanz-Kontrast-Verhältnis und auch vom Chrominanz-Signal. Technische Mängel in der Synchronisation führen zu ungewollten Doppelbildern beziehungsweise einer Geisterkontur.

Soap-Effect

Im Rahmen der Behebung von unschönen Bewegungsunschärfen (vgl. entsprechendes Kapitel) werden nicht selten zusätzliche Zwischenbilder berechnet. Dies hat jedoch bei LCDs mitunter zur Folge, dass bewegte Objekte sich vom Hintergrund abheben, welcher hingegen statisch wirkt. Das Ergebnis ist dann eine Videosequenz, die wie eine billige Studioaufnahme aussieht, etwa wie die Kulisse in einer Daily-Soap, weshalb man hier vom Soap-Effekt spricht.

Halo-Effekt

Auch als Nachzieheffekt bekannt, tritt dieser Abbildungsfehler ebenfalls auf, wenn Zwischenbilder auf Basis des vorherigen und des folgenden Bildes berechnet und sich in schnellen Videosequenzen Objekte gegeneinander bewegen (wie beim EM-Halbfinale Fußball und Hintergrund). Hier fehlen dann wichtige Ergänzungsinformationen in der Bildverarbeitung, weshalb besonders an den Konturen der sogenannte Halo-Effekt auftritt. So zieht beispielsweise der schnell fliegende Fußball einen dunklen oder hellen Schweif hinter sich her.

Tipps zur Fehlerbehebung

Tritt ein Fehler unregelmäßig oder nur bei einer bestimmten Blu-ray-Disc oder einem einzigen Film auf, handelt es sich meistens nicht um ein Problem im Gerät. Sollten oben genannte Abbildungsfehler jedoch regelmäßig und unabhängig vom Videomaterial auftreten, ist in der Regel die Hintergrundbeleuchtung oder aber die Bildverarbeitung fehlerhaft. Letztere kann nicht optimiert werden. Hier sollte man sich mit dem Hersteller oder Händler in Verbindung setzen. Einige Fehler können jedoch auch im TV-Signal zu finden sein, etwa in der Qualität des Empfangs via Satellit, Kabel oder Antenne. Deshalb sollte bei auftretenden Artefakten erste einmal hier die Empfangsstärke überprüft werden. Ähnlich verhält es sich beim Streaming. Mitunter leidet die Bildqualität, wenn das monatliche Datenvolumen aufgebraucht oder an einem DSL-Strang zu viele Verbraucher zapfen (vgl. Kapitel „Das richtige Netz(werk)“ in diesem Buch).

Wenn Abbildungsfehler auftreten, die mit einer mangelhaften Hintergrundbeleuchtung begründet werden können, so kann das zum einen an einer schlechten Verarbeitung liegen oder aber das Display steht unter Spannung. Ursache dafür kann eine Überhitzung sein. Treten Banding- oder Flashlights-Effekte nur manchmal auf, dann sollte das Gerät ausgeschaltet und gut belüftet werden. Außerdem sollten Fernseher niemals direkt neben einer Heizquelle stehen und über sehr lange Zeiträume ununterbrochen laufen.

Um die Qualität der Hintergrundbeleuchtung zu überprüfen, sollte ein graues vollflächiges Standbild mit einem fünfzig prozentigen Grauanteil genutzt werden. Während das Bild auf dem TV-Display dargestellt wird, wird nun die Helligkeit und der Kontrast hoch- und runtergeregelt und die Bildwiedergabe beobachtet. So können verschiedene Abbildungsfehler (z.B. Banding) identifiziert werden, bestenfalls sind falsch geschaltete LEDs sichtbar. In diesem Fall sollte das Gerät zurückgegeben oder besser gar nicht erst gekauft werden.

Videoauflösungen

Umgangssprachlich wird die Auflösung grundsätzlich für das Maß einer Bildgröße verwendet, das die Anzahl der Bildpunkte (Pixel) nach Spalten (vertikale Auflösung) und Zeilen (horizontale Auflösung) einer Rastergrafik angibt. Im physikalischen Sinne ist mit der Auflösung die jeweilige Punktdichte bei der Wiedergabe beziehungsweise Bildabtastung gemeint. Somit ist die Bildauflösung ein Qualitätsstandard unter anderem für die Farbtiefe. Während man in der Digitalfotografie zumeist die Gesamtzahl der Bildpunkte (Mega-Pixel = 1 Million Bildpunkte) beziehungsweise pro Zeile und Spalte angibt, wird in der Fernsehtechnik die Anzahl der Bildpunkte pro Zeile mal die Anzahl der Zeilen gemessen.

Neben der räumlichen Auflösung wird in der Videoauflösung insofern auch die zeitliche Auflösung interessant, da es sich um Bewegtbilder handelt. Wie bereits erwähnt, wird die zeitliche Auflösung (Bildfrequenz) in Hertz (Hz) angegeben. Dabei ist vor allem das Verfahren der Bildabtastung von maßgeblicher Bedeutung, das heißt, ob also zwei Halbbilder im Zeilensprungverfahren (interlaced) oder aber jeweils ein Vollbild (progressive scan) eingelesen werden.

Zeitliche/räumliche Auflösung

In diesem Zusammenhang soll noch einmal darauf hingewiesen werden, dass die bereits erörterten Fernsehnormen (PAL, NTSC oder SECAM) nicht generell per Definition zur Angabe für den Bildwechsel dienen. Videoauflösungen werden betreffend ihrer zeitlichen Auflösung mit den jeweiligen Bildabtastverfahren angegeben. Dazu werden im Allgemeinen die Abkürzungen „i“ für das Zeilensprungverfahren (interlaced) und „p“ für die progressive Bildabtastung (progressive) verwendet.

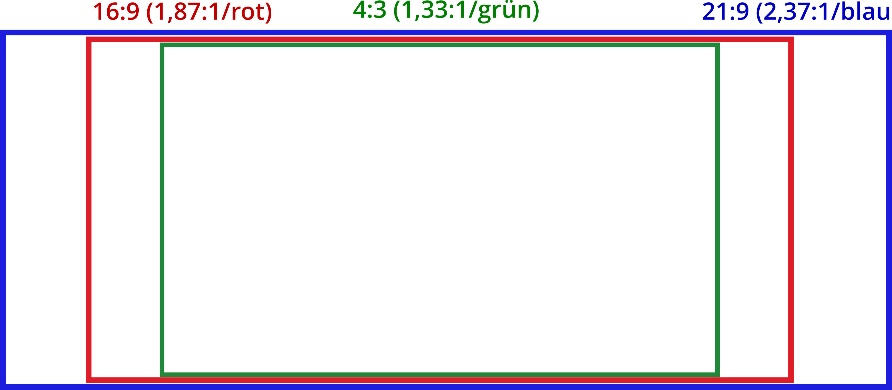

Aber auch andere Parameter sind für die Auflösung entscheidend. So beispielsweise das Seitenverhältnis, das generell als Bruch dargestellt (z.B. 16:9) wird, wobei sich der erste Wert auf die Breite und der zweite Wert auf die Höhe bezieht. Oftmals wird dieser Bruch auch auf 1 gekürzt beziehungsweise ausmultipliziert und entsprechend gerundet. Auf diese Weise wird aus der Angabe 4:3 beispielsweise der Wert 1,33:1.

Standard-Seitenverhältnisse im TV-Bereich

Die drei gebräuchlichsten Seitenverhältnisse für Fernsehgeräte sind in Abbildung 54 vergleichsweise dargestellt: Das im analogen Fernsehen als Standard verwendete Format 4:3 (1,33:1/grün), in den 1990er Jahren eingeführte Format 16:9 (1,87:1/rot) sowie das seit 2009 für besonders breite Geräte genutzte Format 21:9 (2,37:1/blau), das insbesondere Kinofilme (2,39:1) ohne horizontale Streifen wiedergeben kann.Fasst man alle Parameter der Bild-/Videoauflösung zusammen, so entstehen ganz unterschiedliche Werte für die einzelnen Videoformate, die in der folgenden Tabelle zusammengefasst sind (vgl. Abbildung). Nicht selten wird davon ausgegangen, dass die Bildauflösung beziehungsweise die Bildgröße mit der Größe der jeweiligen Videodatei zusammenhängt. Jedoch können auch sehr kleine Bilddateien über eine hohe Auflösung verfügen.

|

Videoformat |

Breite |

Höhe |

Seiten- verhältnis |

Pixel |

|

analog |

||||

|

320 |

240 |

4:3 |

76.800 (0,08 MP) |

|

|

533 |

400 |

4:3 |

213.200 (0,21 MP) |

|

|

digital |

||||

|

VCD (PAL) |

352 |

288 |

4:3 |

92.160 (0,09 MP) |

|

SVCD (PAL) |

576 |

480 |

4:3 |

276.480 (0,28 MP) |

|

DVB (PAL) |

720 |

576 |

4:3/16:9 |

414.720 (0,41 MP) |

|

HDTV (720p) |

1280 |

720 |

16:9 |

921.600 (0,92 MP) |

|

Full-HD (1080p) |

1920 |

1080 |

16:9 |

2.073.600 (2,07 MP) |

|

2048 |

1536 |

4:3 |

3.145.728 (3,15 MP) |

|

|

UHD-1 (4K) |

3840 |

2160 |

16:9 |

8.294.400 (8,30 MP) |

|

4096 |

3072 |

4:3 |

12.582.912 (12,58 MP) |

|

|

UHD-2 (8K) |

7680 |

4320 |

16:9 |

33.177.600 (33,2 MP) |

Übersicht gängiger Videoformate (Auflösung)

Insofern ist der Zusammenhang zwischen der Größe des Datenvolumens nicht zwangsläufig kongruent zur Höhe der Bildauflösung. Letztlich liegt es an der Qualität der Wiedergabe, wie hochwertig das Foto- oder Videomaterial verwendet werden kann. Deshalb können Aussagen über die Auflösung generell nur im Zusammenhang mit der Wiedergabe getroffen werden. Wenn beispielsweise Filme in Ultra HD produziert aber auf einem alten Röhrenfernseher wiedergegeben werden, dann ist relativ klar, dass die Bildqualität erhebliche Einbußen erfährt. Insofern ist die Bildauflösung allein noch kein direktes Maß für die Qualität.

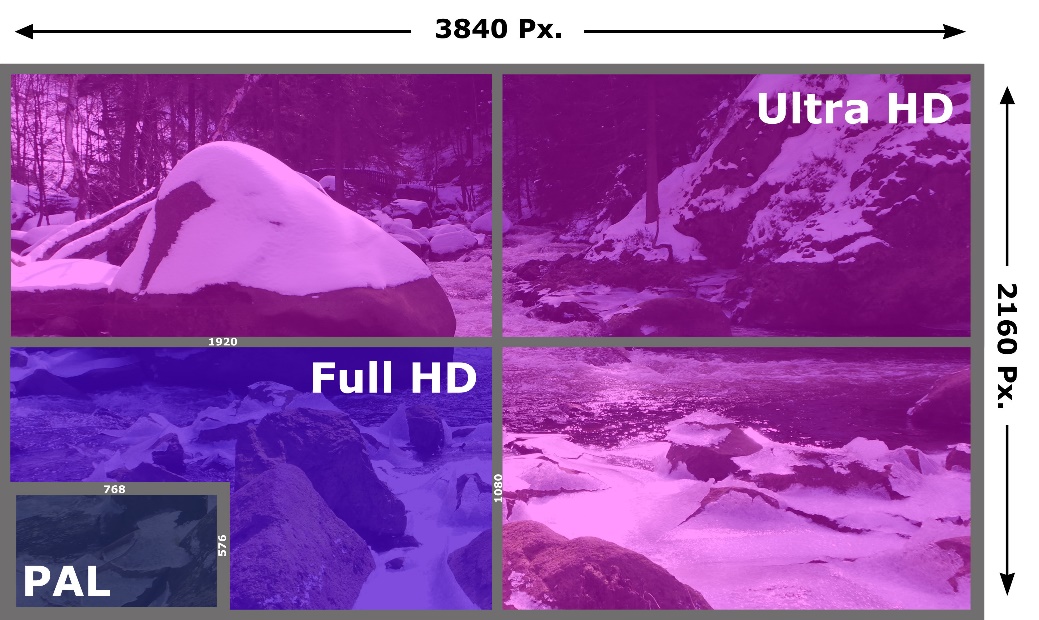

Beispiel für Bildauflösungen

Skalierung

In diesem Zusammenhang kann man auf die Aussage zurückkommen, dass nur die gute alte Röhre knackscharfe Bilder liefern kann. Denn nur bei analogen Röhren-Bildschirmen war das Format des Eingangssignals identisch mit der Wiedergabe. Hier konnten mithilfe der Steuerelektronik verschiedene Videoformate mit der gleichen vertikalen und horizontalen Bildauflösung wiedergegeben werden. Hingegen ist in modernen digitalen Bildschirmen das Wiedergaberaster vorbeschrieben und variiert je nach Bauart. Deshalb kann das Eingangssignal von der tatsächlichen Wiedergabe abweichen. Entsprechend müssen die eingegangenen Bildpunkte je nach Wiedergaberaster skaliert werden, wobei es hier nicht selten zu Verlusten kommt, die sowohl bei einer Verkleinerung als auch bei einer Vergrößerung entstehen können. Insbesondere bei der analogen Fernsehübertragung werden die Bildpunkte selbst oft nicht quadratisch, sondern rechteckig dargestellt. Aber auch durch die diversen Videoformate kommt es zu unschönen Begleiterscheinungen (vgl. Abbildung).

Bildverzerrungen bei unterschiedlichen Videoformaten

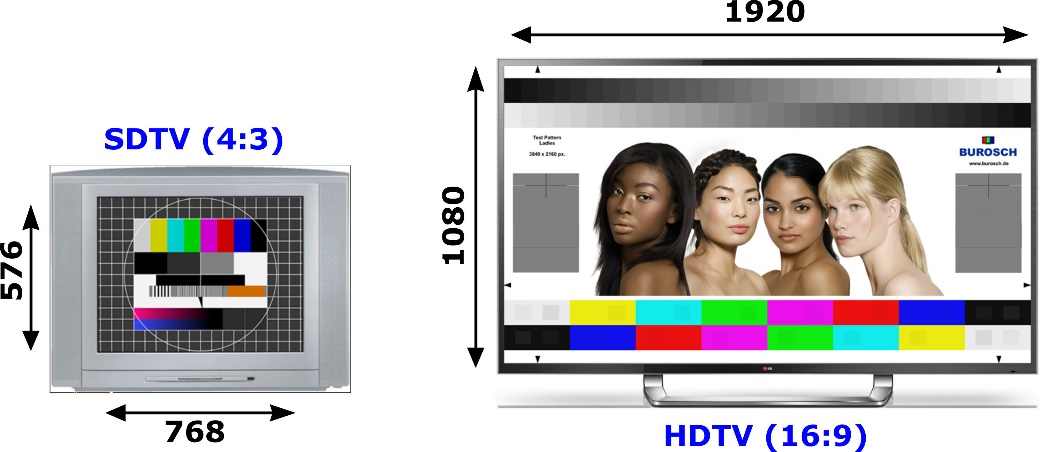

Um die Filmfläche optimal nutzen zu können, wurde bereits in den 1950er Jahren das sogenannte anamorphotische Verfahren (anamorph: griech. umgestaltet) in der Filmtechnik eingesetzt, um breitbandige Kinoformate auf analogen normalformatigen Fernsehgeräten abspielen zu können. Da es sich hierbei um geometrisch-optische Verzerrungen wie etwa bei einem Hohlspiegel handelt, ist die synonyme Verwendung des Begriffes im Zusammenhang mit der digitalen Bildübertragung falsch. Allerdings muss auch hier das Bild beispielsweise bei HDTV bis zu 25 Prozent gestaucht werden. Dies begründet sich aus den immer breiter werdenden Geräten. Der Unterschied zwischen dem herkömmlichen PAL-Format (SDTV) und HDTV ist in der folgenden Abbildung erkennbar.

Unterschied zwischen SDTV und HDTV

Grundsätzlich kann man hochauflösende Videos nur dann hundertprozentig genießen, wenn das Gerät der Wiedergabe die technischen Voraussetzungen erfüllt. Aber auch der beste Fernseher ist nur so gut, wie seine Einstellung. Da Farbe lediglich eine subjektive Wahrnehmung ist, sollte man sich hier nicht ausschließlich auf die Werkseinstellungen oder das bloße Auge verlassen. Um die heute üblichen hohen Qualitätsstandards auch tatsächlich in vollem Umfang ausnutzen zu können, sollten als „Feinschliff“ sogenannte Testbilder bei der präzisen Einstellung verwendet werden. Mehr zu diesem Thema steht unter anderem im folgenden Kapitel „Bildeinstellungen/Kalibrierung“ aber auch am Ende dieses Buches.

Abbildung 66:Burosch TV Refeerenz Testbild

Native Auflösung

Insofern ist gerade für die Feinheit der Farbabstufungen einzelner Bildelemente (Farbtiefe) die sogenannte native Auflösung qualitätsbestimmend. Damit ist die exakte digitale Auflösung des Gerätes gemeint, das zur Bildwiedergabe verwendet wird. Der schlichte Vergleich zwischen der PAL- und HDTV-Auflösung macht den Unterschied deutlich: Der PAL-Standard umfasst 576 sichtbare Zeilen (vertikale Auflösung) und 768 Linien (horizontale Auflösung) und entspricht damit 11.059.200 Bildpunkten pro Sekunde. HDTV-Standards hingegen bieten 51.840.000 (1080i) beziehungsweise 46.080.000 (720p) Bildpunkte pro Sekunde. Die Gesamtbildpunktzahl erhöht sich bei HDTV auf etwa das Fünffache, was sich sowohl in schärferen Konturen, brillanteren Farben und generell in einer höheren Tiefenschärfe des Fernsehbildes bemerkbar macht.

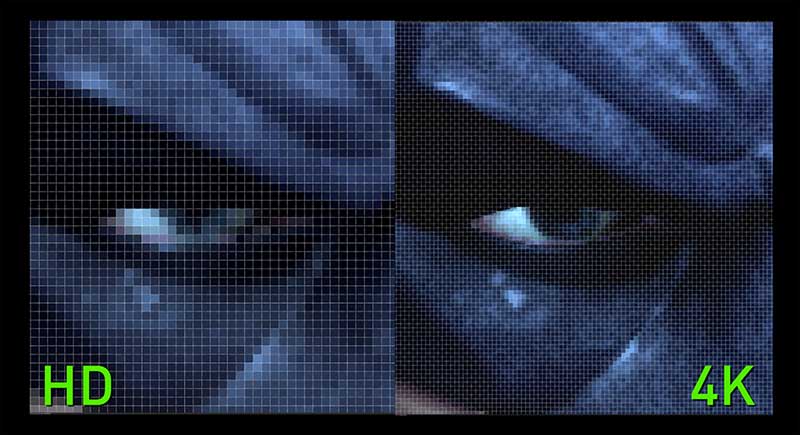

Im Jahre 2016 ist HDTV jedoch schon fast wieder Makulatur. Hier sprechen wir im Zusammenhang mit Ultra HD/4K über ein weiteres Vielfaches in Bezug auf die Pixelanzahl – nämlich von 8 Millionen Bildpunkten. Und auch dieser Wert stellt nur eine Momentaufnahme dar, insbesondere weil die bereits erwähnte ITU-Empfehlung Rec.2020 perspektivisch die Bildauflösung 8K (UHD TV2) vorsieht, welche in derzeitigen TV-Prototypen bereits realisiert wird.

|

PAL |

720p |

1080i |

|

|

Auflösung |

576 x 768 |

720 x 1280 |

1080 x 1920 |

|

Bildpunkte gesamt |

442.368 |

921.600 |

2.073.600 |

|

Bildpunkte/Sekunde |

11.059.200 |

46.080.000 |

51.840.000 |

|

Format |

4 : 3 |

16 : 9 |

16 : 9 |

|

Frequenz |

50 Hz |

50 Hz |

50 Hz |

|

Bilddarstellung |

Halbbild (interlaced) |

Vollbild (progressive scan) |

Halbbild (interlaced) |

Vergleich PAL/720p/1080i

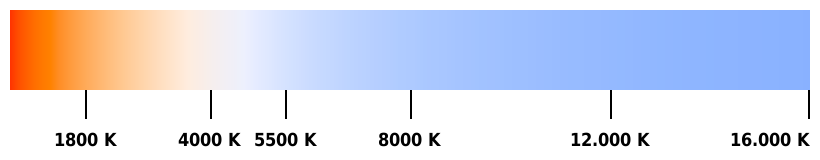

Pixeldichte