Das richtige Netz(werk)

Die Vielfältigkeit des Fernsehens hat natürlich auch seine Tücken. In Anbetracht der zahlreichen Übertragungsmöglichkeiten des TV-Signals kann einem bisweilen schwindlig werden. Während man noch vor fünfzig Jahren lediglich eine Steckdose benötigte und für die Zimmerantenne einen geeigneten Platz suchen musste, sind wir heute nicht selten mit dem Angebot komplett überfordert. Und Tatsache ist, die Lektüre einer einzigen Gebrauchsanweisung hilft heutzutage kaum noch weiter, um komplexe Themen wie Streaming oder gar das Internet zu verstehen. Durch die digitale Vernetzung und die Vielzahl der Methoden wird das Fernsehen zu einer durchaus komplizierten Angelegenheit. Doch wie überall im Leben ist auch diese Sache kinderleicht, wenn man sie versucht zu verstehen. Insofern ist ein gewisses Halbwissen über den modernen Fernsehbildschirm hinaus ein klarer Vorteil - nicht zuletzt um die ungeahnten Möglichkeiten tatsächlich nutzen und genießen zu können.

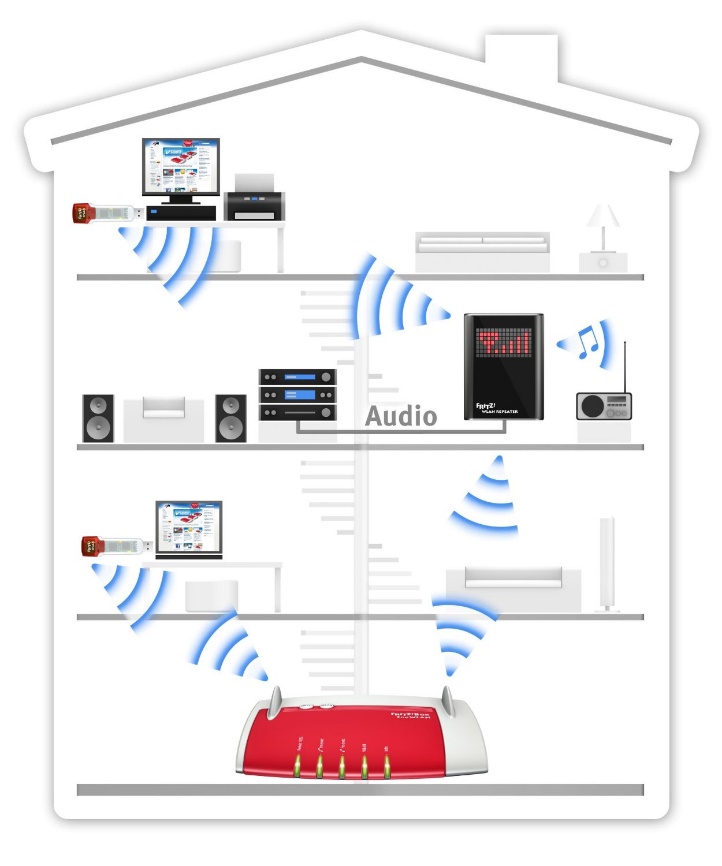

Abbildung 264: Netzwerk

Natürlich kann auch dieses Buch nur eine Basis vermitteln und vor dem Hintergrund der rasanten Entwicklungen lediglich eine Momentaufnahme darstellen. Deshalb sollen im Folgenden zumindest die wichtigsten Begriffe erläutert werden, die im Zusammenhang mit dem modernen, mobilen, multimedialen TV-Empfang der Gegenwart und Zukunft stehen. Denn egal, wie man es dreht und wendet, das Fernsehen ist schon längst kein lokales Gebilde mehr. Wir alle gehören zu einem virtuellen Netzwerk, ob wir nun via Satellit, Kabel, Antenne oder Internet empfangen. Selbst wenn wir gar kein klassisches Fernsehgerät mehr im heimischen Wohnzimmer zu stehen haben, sind wir dennoch Teil einer globalen Community.

Nun kann man sich in dieses Schicksal fügen und dem nächstbesten Angebot trauen, was ins Haus flattert. Im Zweifel einen Vertrag unterschreiben, den man gar nicht haben wollte und damit Leistungen, die man vielleicht gar nicht benötigt. Oder aber man wappnet sich für eine Zeit des großen technischen Umbruchs, öffnet sich für die Vielfalt des multimedialen Entertainments und sucht sich gezielt das heraus, was zu einem passt.

Im Zusammenhang mit sämtlichen Möglichkeiten des digitalen TV-Empfangs tauchen immer wieder dieselben Begriffe auf. Ob Triple Play, All-IP, SAT-IP oder IPTV - wir kommen um das Internet nicht mehr herum. Was ist aber nun das richtige Netz? Was bedeutet Heimnetzwerk überhaupt? Was ist der Unterschied zwischen Fernsehen aus dem Internet und Internet aus dem Fernsehen? Was bedeutet WiFi, Ethernet oder Powerline? Und warum benötigt man für WLAN trotzdem LAN? Welche Router sind die besten? Woher weiß mein Lieblingsfilm eigentlich, dass ich ihn heute auf meinem Tablet schauen möchte? Und wie findet er überhaupt den Weg durch das WWW zu mir?

Abbildung 265: World Wide Web (www.1und1.de)

Internet

Seit das Internet in den 1990er Jahren den Weg in die privaten Haushalte gefunden hat, kennt es irgendwie jeder. Faszinierend bleibt, wie per Mausklick oder Fingerdruck ein Film abgespielt werden kann, ohne dass man umständlich eine Disk in ein dafür vorgesehenes Laufwerk schieben muss. Wer VHS-Kassetten, Schmalfilm oder den guten alten Diaprojektor noch kennengelernt hat, ist wahrscheinlich über diesen Umstand noch viel begeisterter als die junge Generation, die im digitalen Zeitalter heranwächst.

Seit der Erfindung des ersten elektronischen Netzwerkes in den 1950er Jahren führte die Verbreitung des Internets zu einem fast revolutionären Wandel in Wirtschaft, Forschung, Technik, Kultur und Gesellschaft. Der weltweite Informationsaustausch hat ein Niveau erreicht, das der Erfindung des Buchdrucks gleichkommt. Und wieder ist es mehr oder minder einem Zufall zu verdanken, dass wir heute ganz selbstverständlich mit der Tante in Florida skypen, die Informationen für die Bachelorarbeit aus Onlinedatenbanken beziehen, die Mathenachhilfe am PC realisieren, Nachrichten aus aller Welt und das Wetter im Minutentakt direkt auf unserem Smartphone nachlesen oder eben die neueste Folge unserer Lieblingsserie auf dem Weg zur Arbeit anschauen können.

Denn wie die meisten Erfindungen der Neuzeit ist das Internet, wie wir es heute kennen, ein „Abfallprodukt“ der Militärforschung. Denn insbesondere im 20. Jahrhundert aber auch rückblickend auf die Menschheitsgeschichte wurde nirgendwo mehr Geld ausgegeben als für die Kriegsmaschinerie. Insofern kann man wohl von Glück sprechen, dass die Menschheit zu weitaus mehr in der Lage ist, als nur Vernichtungswaffen zu entwickeln. Funk, Fernsehen, Satelliten- und Computertechnik, GPS, Navigationsgeräte und noch vieles mehr wird heute und hoffentlich auch in Zukunft zumindest zu einem überwiegenden Teil friedlich genutzt.

Während im Jahre 2016 nahezu jedes Kind ein eigenes Smartphone, Tablet und/oder Laptop besitzt und im Internet surfen kann, war diese Technologie zu Zeiten des kalten Krieges absolute Geheimsache. 1958 wurde vom US-amerikanischen Verteidigungsministerium die Advanced Research Project Agency (ARPA) gegründet. Diese Forschungsbehörde wurde mit der Aufgabe betraut, ein System zu entwickeln, mit dessen Hilfe US-Regierungsstellen, Rüstungsbetriebe und natürlich das Militär selbst alle vorhandenen Daten zentral sichern kann. Die Angst vor einem atomaren Angriff war seinerzeit sehr groß. Vor allem in den USA aber auch in Europa wurden dazu zahllose Bunkersysteme entwickelt, um nach einer etwaigen Verseuchung den jeweiligen Staatsapparat am Laufen zu halten. Für den Datenaustausch benötigte man also eine Möglichkeit, die über lokale Systeme oder gar Papier und Kurierdienste hinausging. Vor diesem Hintergrund entstand die Idee eines elektronischen Netzwerkes, das alle wichtigen Informationen des amerikanischen Militärs beinhalten und darüber hinaus nicht mehr nur stationär aktualisiert werden sollte. Alle verknüpften Dienstrechner (Hosts) sollten unabhängig von ihrem lokalen Standort zeitgleich auf identische Daten zugreifen können.

Abbildung 266: Logo der Forschungsbehörde ARPA

Dazu gab die US Air Force im Jahre 1964 der RAND Corporation einen entsprechenden Auftrag, der allerdings scheiterte. Erst vier Jahre später gelang es der Forschungsbehörde ARPA, vier ihrer Großrechner zu vernetzen. Das erste dezentrale Netzwerk war geboren. 1972 waren im sogenannten ARPA-Netz bereits knapp 40 Computer angeschlossen. Die einheitliche Kommunikation der unterschiedlichen Stationen beziehungsweise Computer wurde im Jahre 1977 durch das TCP/IP-Protokoll (Transmission Control Protocol/Internet Protocol) realisiert, das seither im ARPA-Netz eingesetzt wurde und bis heute nicht nur dort Bestand hat. Bis zum Fall der Berliner Mauer und der offiziellen Beendigung des Kalten Krieges wurde das ARPA-Netz weiterentwickelt. 1989 spaltete sich der militärische Teil ab und wurde unter der Bezeichnung Military Network weitergeführt. In den nichtmilitärischen Teil des Internets wurde im selben Jahr das Schweizer Forschungsnetz SWITCH implementiert.

1992 war es dann endlich soweit. Die Europäische Organisation für Kernforschung CERN mit Sitz in der Schweiz entwickelte das WWW (World Wide Web) und damit den wohl bekanntesten Teil des Internets. Hier sind seither alle Stationen verknüpft, die über das sogenannte Hypertexttransferprotokoll (http) erreichbar sind. Somit ist das Internet – und das WWW im Besonderen - letztlich das größte Netzwerk, welches wiederum aus Netzwerken besteht. Weitere Teilbereiche des Internets bilden E-Mail, Telnet, Usenet und FTP. Allen gemein ist das Prinzip der Verbindung von Rechnern untereinander und der Datenaustausch, welcher über verschiedene Internetprotokolle realisiert wird, die je nach Einsatzgebiet technisch normiert sind.

Während E-Mail (POP3, IMAP und SMTP) heute ebenfalls gängige Begriffe sind, wissen nicht viele Nutzer des Internets, dass es überhaupt weitere Teilbereiche gibt. Das sogenannte Unix User Network (Usenet) ist vielleicht nicht so bekannt wie das WWW, bietet für seine zumeist wissenschaftlichen beziehungsweise fachspezifischen Nutzer ein kleines Paralleluniversum. Schnörkellos bildet Usenet die Grundlage für fachliche Diskussionsforen (Newsgroups) in reiner Textform. Über den Ableger Binary Usenet können darüber hinaus auch Binärdateien als Anhänge verteilt werden. Das Teletype Network (Telnet) ist dem durchschnittlichen Privatnutzer ebenfalls nicht zwingend geläufig. Allerdings ist diese Variante des Netzwerkprotokolls relativ weit verbreitet. Das sogenannte Clientprogramm wird vorrangig zur Ausgabe von Betriebsdaten sowie zur Fernsteuerung oder aber Konfiguration von Computern genutzt, die keine grafische Benutzeroberfläche verwenden. Die Befehle sind also auch hier rein textbasiert (z.B. UNIX- oder DOS-Shell). Typische Anwendung findet Telnet bei Datenbankabfragen.

Abbildung 267: Textbasierte Befehle (DOS)

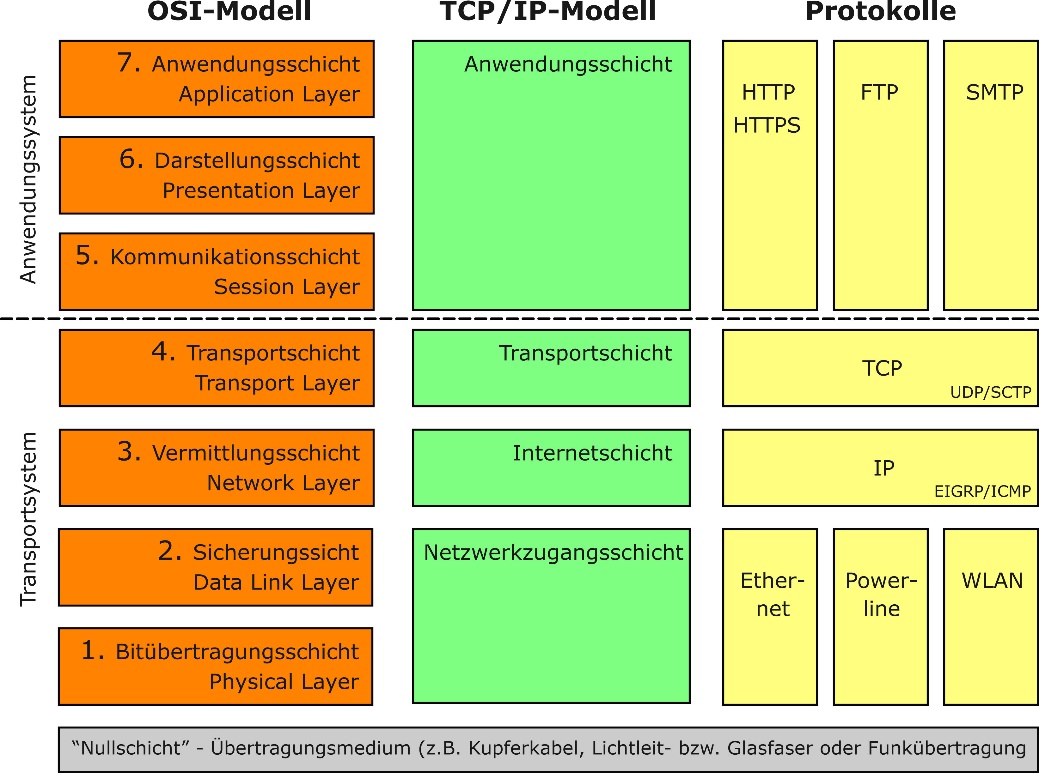

Das File Transfer Protocol (FTP) hingegen dient der Übertragung von Dateien innerhalb von IP-Netzwerken – also zwischen Server und Client. Dieses spezifische Netzwerkprotokoll, das es übrigens seit 1985 gibt, gehört zur Anwendungsschicht 7 des sogenannten OSI-Schichtenmodells, auf das im Rahmen der folgenden Ausführungen noch näher eingegangen wird.

Denn streng genommen kommunizieren nicht wir, die an unserem Laptop, Tablet oder Smartphone sitzen, sondern verschiedene Protokolle, die sich auf den unterschiedlichen Ebenen des OSI-Modells wiederfinden. Dabei wird dieses Modell grundsätzlich nicht vollständig abgebildet, sondern lediglich Teile (Schichten) davon verknüpfen sich gegenseitig und bilden somit eine komplexe Struktur in einem durchaus heterogenen Netzwerk. Auf Basis der Netzwerk- oder Kommunikationsprotokolle erfolgt der Datenaustausch zwischen den jeweiligen Rechnern, die in einem Netzwerk miteinander verbunden sind. Wie im richtigen Leben sind für eine erfolgreiche Kommunikation sowohl die Form als auch die Sprache beziehungsweise deren Bedeutung und Interpretation unabdingbar. Innerhalb der Rechnernetze bestehen deshalb ebenfalls definierte Vereinbarungen, die aus bestimmten Regeln und Formaten (Syntax) sowie einer festgelegten Sprache und einem Kommunikationsverhalten (Semantik) bestehen.

Abbildung 268: OSI- und TCP/IP-Modell – Struktur nach Schichten und Protokoll-Beispiele

Die verschiedenen Aufgaben werden nun auf unterschiedlichen Schichten wahrgenommen, wobei ein Zusammenspiel untereinander erfolgt. In diesem Zusammenhang spricht man auch von einer Internetprotokollfamilie oder im Kontext der Anordnung von einer Internetarchitektur. Zu den bekanntesten Protokollen gehören neben den bereits erwähnten die TCP/IP-Dienste, auf deren Basis sich Internetprotokollfamilien bilden und weltweit Millionen Computer miteinander kommunizieren.

Das TCP/IP-Referenzmodell beinhaltet – anders als das OSI-Modell – lediglich vier Schichten. Die Entwicklung begann ebenfalls in den 1960er Jahren im Auftrag des US-amerikanischen Verteidigungsministeriums. Im TCP/IP-Bereich werden Verbindungen zwischen Netzwerkteilnehmern hergestellt und Datenpakete über sogenannte Punkt-zu-Punkt-Verbindungen (Hops) weitervermittelt. TCP/IP ist insofern das vereinfachte Modell von Netzwerkprotokollen, das die folgenden vier Schichten beinhaltet:

Anwendungsschicht (OSI-Layer 5-7)

Wie der Name vermuten lässt, umfasst die Application Layer (Anwendungsschicht) alle Protokolle im Zusammenhang mit Anwendungsprogrammen beziehungsweise einer Nutzung der Netzwerkinfrastruktur für den anwendungsspezifizierten Datenaustausch. Dazu zählen die drei Transferprotokolle FTP (File Transfer Protocol/Dateitransfer), HTTP (Hypertext Transfer Protocol/WWW) und HTTPS (Hypertext Transfer Protocol Secure) als sichere Variante. Die Basis für die Kommunikation zwischen Domainnamen (www) und IP-Adresse entsprechend integrierter Geräte oder Gerätesysteme bildet das Domain-Name-System (DNS). Für die technische Steuerung von Kommunikationssitzungen im Internet (VoIP) ist das Session Initiation Protocol (SIP) zuständig und für den E-Mail-Versand das Simple Mail Transfer Protocol (SMTP).

Transportschicht (OSI-Layer 4)

In diese Schicht (Transport Layer) gehören alle Protokolle, die mit der Übertragung beziehungsweise dem Transport der Daten befasst sind. Neben dem Transportprotokoll SCTP (Stream Control Transmission Protocol) und dem User Datagram Protocol (UDP) ist vor allem das Transmission Control Protocol (TCP) das gängige Protokoll, welches die Verbindung zwischen Netzwerkteilnehmern herstellt, um ein zuverlässiges Versenden von Datenströmen zu ermöglichen.

Internetschicht (OSI-Layer 3)

Im Internet Layer werden die Datenpakete vermittelt und weitergeleitet. Dazu zählt beispielsweise die Wahl des Transportweges (Routing) und damit die Fragestellung, wie kommen die Daten von A nach B – oder vielleicht doch über ein Zwischenziel C. Im Mittelpunkt steht hier das Internet Protocol (IP), das sozusagen die Logistik übernimmt; aber auch der frühere Distanzvektor, der heute als EIGRP (Enhanced Interior Gateway Routing Protocol) bezeichnet wird und zuständig ist für den Informationsaustausch zwischen einzelnen Routern via IP.

Netzzugangsschicht (OSI-Layer 1-2)

Die vierte Schicht (Link Layer) im TCP/IP-Referenzmodell enthält interessanterweise keine Protokolle der TCP/IP-Familie. Sie dient lediglich als Platzhalter für diverse Datenübertragungstechniken zur Punkt-zu-Punkt-Übertragung. Die auch als Host-an-Netz-Schicht bezeichnete Netzzugangsschicht ist quasi die Tür, der Zugang zur Datenautobahn. Ab hier wird lokal weitergeleitet – über interne Netzwerkverbindungen: WLAN, Ethernet oder Powerline.

Neben der Verbindung im lokalen Netzwerk (mit oder ohne Kabel) ist aber auch die Kommunikationsform zwischen Client und Server beziehungsweise die Klassifizierung der Adressierung ausschlaggebend. Das heißt, es gibt verschiedene Wege der Netzwerkkommunikation, die auch als Routing-Methoden bezeichnet werden.

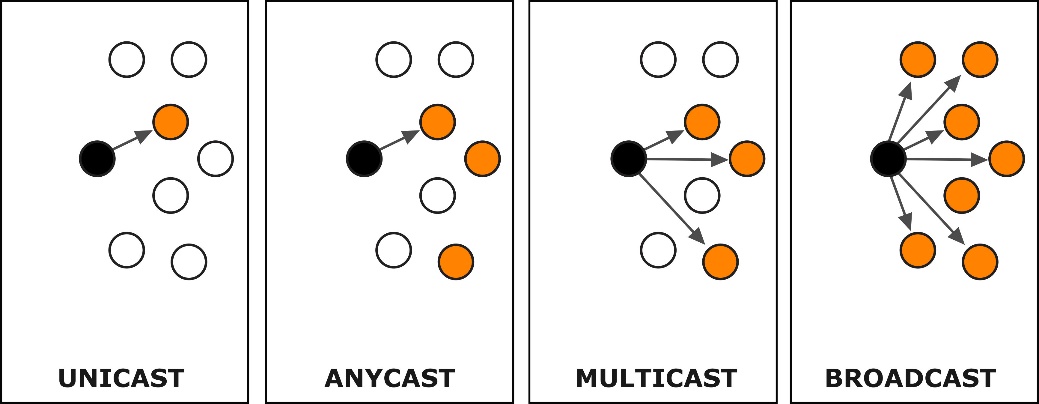

Abbildung 269: Klassifizierung der IP-Adressierung

Die schlichteste Variante bildet – wie der Name schon sagt: Unicast. Hier werden Nachrichten zwischen einem Sender und einem Empfänger übertragen. Nicht zu verwechseln ist diese Methode mit der Punkt-zu-Punkt-Verbindung zwischen zwei Netzwerkteilnehmern. Unicast-Verbindungen werden vor allem für Netzwerk-Prozesse verwendet, bei denen vertrauliche und spezialisierte Ressourcen vom Empfänger angefordert werden. Hierzu zählt beispielsweise das Video-Streaming (vgl. auch Kapitel über SAT-IP).

Bei Anycast funktioniert die Kommunikation über eine bestimmte IP-Adresse. Hierzu können mehrere gleichartige Server auf separaten IP-Netzen verteilt werden, die sogar in unterschiedlichen Ländern oder verschiedenen Kontinenten installiert sind. Jeder Server/Rechner hat dieselbe IP-Adresse. Somit können bestimmte Dienste auch dann angeboten werden, wenn ein oder mehrere Server ausfallen. Im Rahmen der Administration muss die entsprechend gleiche IP-Adresse vom Client angesprochen werden. Vor diesem Hintergrund besteht für den jeweiligen Client kein Unterschied zwischen Unicast und Anycast. Außerdem wird generell mit dem nächstgelegenen Server kommuniziert. Dadurch entsteht eine Lastverteilung, auf die der einzelne Client keinen Einfluss hat. Das Anycast-Konzept wird vor allem im Rahmen von Firmennetzwerken beziehungsweise für DNS-Rootserver genutzt.

Bei Multicast- oder auch Mehrpunkt-Verbindungen können zeitgleich von einem Sender mehrere Empfänger erreicht werden, wobei die Datenübertragungsrate nicht proportional zur Anzahl der erreichten Teilnehmer steigt. Dennoch bleibt bei Multicast die Verbindung geschlossen, das heißt, nur der kann die Datenpakete empfangen, der sich vorab beim Sender angemeldet hat. Der Spezialfall von Multicast ist Geocast. Hier kommt eine Verbindung in einem räumlich abgegrenzten Bereich zustande.

Eine weitere spezielle Mehrpunktverbindung ist Broadcast, was so viel wie „Rundruf“ bedeutet und mit dem umgangssprachlichen „Spaghetti-Prinzip“ verglichen werden kann. Denn von einem Punkt aus werden Datenpakete an alle Teilnehmer eines Netzwerkes versendet, wobei diese nicht explizit als Empfänger deklariert werden beziehungsweise die IP-Adressen nicht bekannt sein müssen. In der Praxis findet sich dieser Verbindungstyp beispielsweise bei der Suche oder Freigabe von Druckern sowie anderer Hardware via Bluetooth oder WLAN.

Netzwerkverbindungen

Dass mittlerweile nicht mehr nur Drucker, Scanner oder Fax-Geräte im heimischen Netzwerk miteinander verbunden werden können, ist seit einigen Jahren kein Geheimnis mehr. Wie bereits erwähnt, können Filme nicht mehr nur per Disk (DVD, Blu-ray) oder im klassischen Fernsehprogramm angeschaut werden. Smart-TV, HbbTV, Live-TV, Web-TV, Android TV, Apple TV, Amazon Fire TV, Video-Streaming, Set-Top-Boxen, Multimedia-Player, SAT-IP, IPTV, Triple Play, All-IP … und alles via IP über die verschiedenen lokalen Netzwerkverbindungen: Ethernet (LAN), Power-LAN, WPAN oder WLAN.

Allen gemeinsam ist, dass die Anzahl der Geräte, die in ein solches Heimnetzwerk eingebunden werden können, von Jahr zu Jahr steigt. Während zum Ende des 20. Jahrhunderts lediglich Computer und Drucker in Privathaushalten zu finden waren, die via LAN miteinander verbunden wurden, sind die Geräte heute kaum noch zählbar.

Abbildung 270: Entwicklung des Heimnetzwerkes

Für welche Verbindung man sich im heimischen Netzwerk entscheidet, hängt letztlich von der Beschaffenheit des Hauses, den Ansprüchen der Nutzer und natürlich vom Leistungsumfang des Netzes beziehungsweise der Datenübertragungsrate ab.

LAN (Ethernet)

Die älteste Möglichkeit ist die direkte Verbindung von Netzwerkkomponenten mithilfe von Kabeln. Hierbei stehen sich zwei Geräte quasi Face-to-Face gegenüber. Denn bei der Verbindung über LAN (Local Area Network) werden alle Clients einzeln mit dem Router verbunden, welche zusammen das Ethernet bilden. Klarer Vorteil ist die sichere und weitgehend störungsfreie Vernetzung. Im Rahmen der Netzwerkkonfiguration erfolgt die Zuweisung der IP-Adressen der jeweiligen Endgeräte (Clients) automatisch über den Ethernet-Anschluss vom Server (Router). In diesem Zusammenhang wird der Begriff DHCP (Dynamic Host Configuration Protocol) verwendet.

Ein weiterer Vorteil ist die Leistungsstärke. Keine andere Netzwerkverbindung bietet Datenübertragungsraten wie das Ethernet. Diese reichen bei Standardverbindungen von 10 Mbit/s über 100 Mbit/s - beim sogenannten Fast Ethernet bis hin zu sagenhaften 1000 Mbit/s im Gigabit-Ethernet. Die Qualität richtet sich grundsätzlich nach der Länge der Kabel innerhalb eines Gebäudes (vgl. hierzu auch das Kapitel „Schnittstellen“). Hier beträgt bei der modernen Form der Kupfer-basierten Twisted-Pair-Verkabelung (TP) die maximale Netzausdehnung hundert Meter. Allerdings bietet das Ethernet über Glasfaser auf Multimodebasis auch Reichweiten von bis zu dreihundert Kilometern.

Der Nachteil liegt auf der Hand. Je mehr Geräte in das Netzwerk integriert werden sollen, desto mehr Kabel müssen verlegt werden. In vielen Büros dienen dazu spezielle Kabelschächte. In der Mietwohnung oder im Eigenheim wird es hingegen beschwerlich, den Fußboden aufzureißen, um den Kabelsalat zu verstauen. Eine kleine Abhilfe könnte eine Patch-Kabeltrommel (Conrad) schaffen. Doch für alle, die Mobilität zu schätzen wissen, wäre diese Lösung auch lediglich ein Tropfen auf den heißen Stein.

Abbildung 271: Patchkabel U/UTP mit RJ45-Stecker (Conrad)

Power-LAN (Powerline)

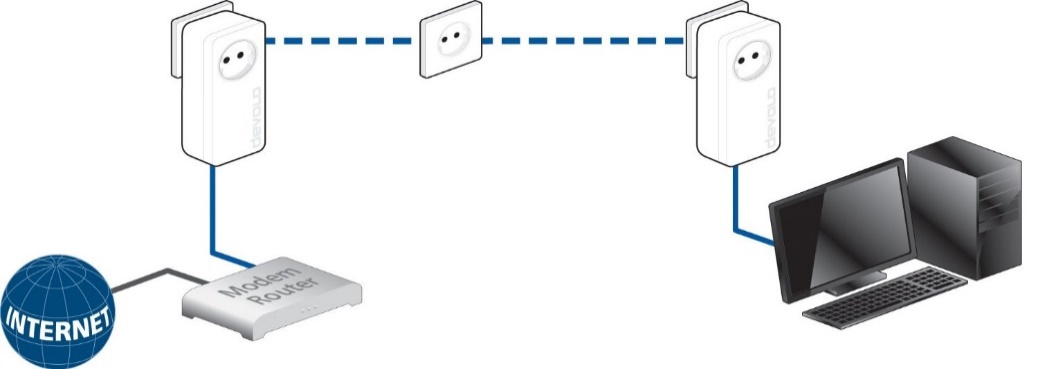

Bei diesem Begriff kann es leicht zu Verwirrungen kommen, da „Powerline“ sowohl als die Möglichkeit bezeichnet wird, das Internet direkt aus der Steckdose zu beziehen (Powerline Access) als auch über die Steckdose das heimische Netzwerk miteinander zu verbinden (Power-LAN).

Der Übertragungsweg via Stromnetz als DSL-Ersatz verkümmert zu einer regionalen Angelegenheit, wie im Kapitel (Powerline Access) noch näher erläutert werden soll. Die Alternative zum klassischen LAN via Kabel oder WLAN über Funk ist allerdings einen Blick wert, zumal sie sich zunehmend in den privaten Haushalten etabliert. Um weitere Verwirrungen zu vermeiden, wird im Folgenden der Begriff Power-LAN verwendet, auch wenn in der Fachliteratur und -presse parallel auch diverse andere Bezeichnungen praktiziert werden.

Der erste Vorteil, der im Zusammenhang mit dem Stromnetz zu nennen ist, liegt quasi auf der Hand. Die Infrastruktur ist bereits vorhanden. Kein Kabelverlegen. Kein Bohren. Keine Kosten. Im Vergleich zum funkbasierten WLAN bietet die Verteilung über das Stromkabel weniger Störanfälligkeit, jedenfalls was das Internet anbelangt.

Wie funktioniert Power-LAN?

Ganz ohne Kabel und weiteres Equipment geht es natürlich nicht. Das Netzwerksignal muss erst einmal aufgenommen und dann über die Stromleitung (power line) befördert werden. Dazu wird ein Power-LAN-Adapter via Patchkabel mit dem Router verbunden und in eine Steckdose gesteckt. Durch Plug & Play weiß dieser erste Adapter von ganz allein, was er zu tun hat. Er bereitet das Netzwerksignal auf (Modulation), macht es also passend für den Transport über das Stromnetz. Je nachdem, wo das nächste Endgerät (z.B. Smart-TV) steht, wird ein zweiter Adapter in eine Hausstromsteckdose gesteckt und via Patchkabel mit dem Fernseher oder einem anderen Endgerät verbunden.

Abbildung 272: Power-LAN - stabile und schnelles Internet via Stromleitung (devolo)

Hier wird das IP-Signal demoduliert und das Internet quasi in den Fernseher befördert. Das stationäre Endgerät kann also sowohl Strom als auch Internet aus der Dose beziehungsweise dem Adapter ziehen. Insofern bietet Power-LAN eine stabile Verbindung und lässt sich einfach installieren: Auspacken. Einstecken. Loslegen. Sogenannte Starterkids mit einem Sender und einem Empfänger gibt es im Handel schon für unter 100 Euro.

Zu den bekanntesten und erfolgreichsten Herstellern gehört neben AVM die Firma devolo. Nach eigenen Angaben besitzen weltweit über zehn Millionen Haushalte bereits die Power-LAN-Adapter aus diesem Hause. Die aktuellen Geräte versprechen stolze Datenraten bis zu 600 Mbit/s, und zwar aus jeder Steckdose. Mit dem Werbeslogan „Funktioniert, wo andere versagen“, macht sich devolo auf, den Markt zu erobern.

Die lokalen Steckverbindungen gewährleisten (ähnlich wie LAN) naturgemäß eine Sicherheit, die WLAN nicht bieten kann. Darüber hinaus muss man nicht bei jedem Gerät den mitunter langen Netzwerkschlüssel eingeben. Das Heimnetzwerk wird genau einmal konfiguriert. Die Hersteller bieten hierzu die passende Software, die in der Regel für alle Betriebssysteme (Windows, Mac OS X, Linux) kompatibel ist. Die automatische Verschlüsselung im Adapter bietet deshalb nicht nur mehr Freiheit, sondern vor allem einen aktiven Schutz vor unbefugtem Zugriff Dritter. Ein „Absaugen“ des Netzes durch den Nachbarn ist somit nicht mehr möglich.

Abbildung 273: Devolo dLAN 650 triple+ Starter Kit (600 Mbit/s, 3 LAN Ports)

Wer also viel Wert auf eine stabile, sichere und schnelle „Leitung“ legt, der könnte mit Power-LAN eine gute Alternative zum Kabelsalat finden. Multimediakonsolen, Set-Top-Boxen, Smart-TVs, Computer, Drucker etc. lassen sich als stationäre Geräte einfach anschließen. Für Vielnutzer gibt es nunmehr auch Adapter mit mehreren LAN-Anschlüssen.

Natürlich ist aber auch hier ein Haken zu finden. Mobile Smartphones, iPods, Tablets und insbesondere ausgesprochene WLAN-Geräte lassen sich über Power-LAN-Adapter selbstverständlich nicht im heimischen Netzwerk integrieren. Da jeder WLAN-Router aber über entsprechende Schnittstellen verfügt, ist eine parallele Anwendung jederzeit möglich. Außerdem verfügen viele Power-LAN-Adapter bereits über integrierte WLAN-Sender.

So bietet die Firma TP-Link einen Adapter, der über eine sogenannte WiFi-Clone-Taste verfügt, mit der SSID und Passwort des WLAN-Netzwerkes automatisch eingelesen werden. Der Hersteller verspricht mit seinem Modell TL-WPA4220KIT verschiedene Datenraten – je nach Übertragungsmodus: LAN (100 Mbit/s), Powerline (500 Mbit/s), WLAN (300 Mbit). Grundsätzlich eignen sich solche hybriden Adapter selbstverständlich auch, um das WLAN-Netzwerk zu erweitern. Denn die funkbasierte mobile Variante stößt in Bezug auf die Reichweite schnell an ihre Grenzen. Ist die Entfernung zum Netzzugangspunkt (Router) zu weit, weil sich dieser beispielsweise im Keller eines Einfamilienhauses befindet, könnte man im ausgebauten Dachgeschoss immer noch WLAN-Empfang haben, wenn man dort eine solche Adapter-Lösung verwendet.

Abbildung 274: Powerline WLAN Starter Kit 500 MBit/s (TP-LINK)

Wer schon auf Power-LAN umgestellt hat und nun seine Internetverbindung mit neuen Adaptern aufpeppen möchte, der sollte wissen, dass die Stecker der einzelnen Serien durchaus abwärtskompatibel sind. Jedoch funktionieren sie nach dem einfachen Prinzip: Wir sind nur so schnell, wie das schwächste Glied in der Kette. Sollte also beispielsweise zwischen Adaptern der 650er-Produktreihe von devolo irgendwo im Haus noch ein 200-Stecker sein Dasein fristen, dann ist es durchaus möglich, dass die versprochene Datenrate von 600 Mbit/s nicht erreicht wird.

Ebenfalls negativ zu bewerten sind die Störungen insbesondere im Kurzwellenbereich, die durch Power-LAN-Adapter verursacht werden. Obwohl die Hersteller behaupten, dass die aktuelle Technik nicht für solche Funkstörungen verantwortlich ist, kann sich der Einsatz eines Steckdosen-Netzwerks auf den Radioempfang auswirken. Dass Funkamateure und passionierte Radiohörer sehr wohl ein Knacken in der Leitung hören, liegt insbesondere daran, dass die Stromleitungen nicht für die Datenübertragung konstruiert wurden. Die klassischen Stromkabel sind ungeschirmt und nutzen für die Übertragung Frequenzbereiche zwischen 2 und 68 MHz. Damit wirken sie – wenn auch unbeabsichtigt - wie Antennen für den gesamten Kurzwellenbereich, der zwischen 3 und 30 MHz liegt.

Verschwiegen wird in den Hochglanzprospekten der Hersteller oft auch, dass die Entfernung zwischen Netzzugang und Endgerät bei Verlängerung über das Stromnetz entscheidend bleibt. Noch dazu ist die Datenrate von 600 Mbit/s zwar schön anzusehen, doch relevant für ruckelfreies Streaming ist der Downstream. Bei einem 16.000er DSL-Anschluss sind das direkt am Router tatsächlich 16 Mbit/s, ein Stockwerk höher liegt die Downloadgeschwindigkeit vielleicht noch bei 10 bis 12 Mbit/s, Tendenz auch hier fallend. Wobei natürlich zu erwähnen ist, dass Power-LAN immer noch stabiler funktioniert als WLAN.

WPAN (Bluetooth)

Obwohl Bluetooth keine klassische Netzwerkverbindung darstellt, eignet sich dieses spezielle Funkverfahren ebenfalls für die kabelfreie Datenübertragung zwischen Geräten – allerdings nur mit kurzer Distanz. Entwickelt wurde der Industriestandard gemäß IEEE 802.15.1 bereits in den 1990er-Jahren von der Bluetooth Special Interest Group (SIG).

Abbildung 275: Bluetooth-Logo

Dabei handelt es sich – ähnlich wie die Wi-Fi-Alliance - um einen Zusammenschluss von Unternehmen, die daran interessiert sind, die entsprechende Technologie zu entwickeln sowie zu vermarkten. Über 8000 Hersteller aus der ganzen Welt gehören mittlerweile zur Bluetooth-Group, die im Jahre 1998 von den Firmen Ericsson, IBM, Intel, Nokia und Toshiba gegründet wurde. Im Laufe der Zeit kamen weitere namhafte Größen der Technikbranche hinzu. So beispielsweise Microsoft und Motorola.

Was nun blaue Zacken oder Zähne mit einer modernen Funkübertragung zu tun haben, darüber könnte man sich streiten. Eine bekannte Erklärung ist die, dass der Name „Bluetooth“ tatsächlich auf den berühmten dänisch-norwegischen König Harald Blauzahn (King Bluetooth) zurückgeht, der im 10. Jahrhundert die verfeindeten Gebiete von Dänemark und Norwegen vereinte. Obwohl die Historiker sich nicht einmal einig darüber sind, warum der einstige König überhaupt „Blauzahn“ genannt wurde, könnte die Verknüpfung seiner Initialen durchaus das heute nicht nur in Skandinavien bekannte Bluetooth-Logo erklären.

Abbildung 276: Hintergrund des Bluetooth-Logos

Im Gegensatz zu WLAN und Wi-Fi steht hinter der Bezeichnung „Bluetooth“ sowohl das Markenzeichen als auch der Name der Spezifikation für das entsprechende Funkverfahren. Dieses wurde hauptsächlich von den Wissenschaftlern Jaap Haartsen (Niederlande) und Sven Mattisson (Schweden) im Auftrag von Ericsson entwickelt. Ergänzt wurde die Technologie von Nokia und Intel. Im Wesentlichen basiert Bluetooth auf dem WPAN-Verfahren (Wireless Private Local Area Networks) und unterstützt damit die Verbindungsstandards „Punkt zu Punkt“ sowie „Ad-hoc“. Insofern eignen sich Bluetooth-Verbindungen für die Funkkommunikation von Geräten mit geringer Reichweite. In diesem Zusammenhang spricht man auch von der Short-Range-Wireless-Technologie (SRW). Dabei werden Entfernungen von bis zu zehn Metern erreicht. Mithilfe von Verstärkern kann die Distanz zwischen zwei Endgeräten sogar auf maximal einhundert Meter erhöht werden.

Die Übertragung erfolgt im lizenzfreien ISM-Band (Industrial, Scientific and Medical Band) bei Frequenzen um 2,4 GHz. In diesem Zusammenhang kann es zu Störungen durch WLAN, Schnurlostelefone oder sogar Mikrowellengeräte kommen. Um dem entgegenzuwirken, wird ein sogenanntes Frequenzsprungverfahren eingesetzt. Beim „frequency hopping“ wird das verwendete Frequenzband in 79 Stufen mit einem jeweiligen Abstand von 1 MHz eingeteilt, der bis zu 1.600 Mal pro Sekunde gewechselt wird. Eine andere Möglichkeit bieten Multislot-Pakete, bei denen die Frequenz nicht so oft gewechselt wird. Hier existiert am oberen und unteren Ende des Frequenzbandes ein sogenanntes „guard band“ (Sicherheitsband), um die benachbarten Frequenzbereiche abzuschirmen.

Seit Dezember 2014 ist der neue 4.2-Standard auf dem Markt. Der Schwerpunkt liegt hier auf verbesserten Sicherheitsmerkmalen und einer höheren Übertragungsgeschwindigkeit. Hierzu bietet Bluetooth 4.2 erstmals die Verwendung des IPv6-Standards im Rahmen des Internet Protocol Support Profile (IPSP). Damit wird eine IP-IP-Konnektivität gewährleistet, die es bisher noch nicht bei Bluetooth gab. Denn die Sicherheit der Verbindung war seit der Markteinführung ein Manko, dem nur schwer begegnet werden konnte. Vor allem dann, wenn die Nutzer sich nicht freiwillig durch Passwort vor unbefugtem Eindringen Dritter geschützt haben. Auch zu kurz gewählte Pin-Codes können im Übrigen viel zu schnell gehackt werden. Deshalb sollte die bisher optionale Authentifizierung während des Verbindungsaufbaus in jedem Fall in Anspruch genommen werden.

Abbildung 277: Sony-Bluetooth-Kopfhörer MDR-XB950BT

Mit Bluetooth 4.2 werden zusätzliche Datenschutztechniken verwendet, die nicht mehr nur optional sind. So wird das Senden von Informationen über eine Bluetooth-Verbindung erschwert, wenn keine explizite Zustimmung des offiziellen Nutzers erfolgt, das heißt, bestimmte Dienste bedürfen zukünftig generell der ausdrücklichen Genehmigung des Anwenders. Darüber hinaus ist die beste Sicherheit selbstverständlich dann gegeben, wenn man die Bluetooth-Funktion an seinem Smartphone, Laptop etc. generell ausschaltet und nur während einer gewünschten Übertragung aktiviert.

Da moderne Bluetooth-Geräte ab Version 2.0 mit der DER-Technologie (Enhanced Data Rate) eine Übertragungsgeschwindigkeit von über 2 Mbit/s zulassen, wird Bluetooth nicht mehr nur für den Austausch geringer Daten (z.B. Fotos) genutzt.

Mithilfe entsprechender Klinkenanschlüsse können heute kabellos Kopfhörer oder kleine Soundanlagen mit dem Fernseher oder aber die Hi-Fi-Anlage mit Bluetooth-fähigen Laptops oder Smartphones verbunden werden. So kann die Musik aus der virtuellen Cloud vom mobilen Endgerät auf die alte Stereoanlage im Wohnzimmer oder aber das Autoradio gebracht werden. Der LogiLink Bluetooth Audio Receiver (2.1) erlaubt beispielsweise eine Abspieldauer von bis zu zwölf Stunden (Standby: über 200 Stunden) dank integriertem Akku – bei einer Reichweite von bis zu zehn Metern.

Abbildung 278: Bluetooth® Musik-Empfänger LogiLink BT0020 (Version: 2.1 + EDR)

Für die kabelfreie Verbindung kleiner Geräte auf kurzen Distanzen ist Bluetooth insofern eine geeignete Alternative, zumal die Übertragung als solche kostenlos ist. Allerdings bleibt die Bandbreite im 2,45-GHz-ISM-Frequenzband begrenzt. Bei synchronen Übertragungen können nur wenige Geräte miteinander verbunden werden. Auch wenn die Bluetooth-SIG spezielle Erweiterungen im Rahmen der PHY- und MAC-Schicht der IEEE-802.11-Spezifikationen plant, bleibt der WLAN-Standard die derzeit einzig praktikable Lösung im Rahmen einer komplett kabellosen Netzwerkverbindung.

WLAN (WiFi)

Und Fakt ist: modernes Entertainment funktioniert heute weitgehend kabellos – vom Keller bis zum Dach. So weit, so gut. Aber wie? In vielen Restaurants, Bahnhöfen, Hotels, öffentlichen Einrichtungen und sogar mobil über Hotspots ist heute die drahtlose Funkverbindung WLAN nahezu Standard.

Auch aus den meisten Privathaushalten ist Wireless Local Area Network (WLAN) - also die drahtlose örtliche Vernetzung - kaum noch wegzudenken. Smart-TVs, Set-Top-Boxen und die mobilen Endgeräte sowieso verfügen über entsprechende Schnittstellen (integriertes WLAN) oder zumindest Optionen für externe Adapter per USB (adaptiertes WLAN).

Obwohl der Begriff „Wireless Local Area Network“ aus dem Englischen stammt, sucht man insbesondere im englischsprachigen Raum, wie in den USA, Großbritannien, Kanada aber auch in Spanien, Frankreich, Italien oder der Niederlande die Bezeichnung WLAN zumeist vergeblich. Auch in Deutschland setzt sich immer mehr der Kunstbegriff WiFi durch, der oft auch synonym für WLAN-Hotspots oder eben die kabelfreien Netzwerkverbindung genutzt wird.

Dabei ist „Wireless Fidelity“ lediglich ein Markenbegriff und zudem eine Analogie zu „High Fidelity“ (Hi-Fi) – dem Qualitätsstandard aus der Audiotechnik. Der Kunstbegriff Wi-Fi ist im Grunde also nichts anderes als ebenfalls ein Qualitätsstandard aus der IP-Technik, der von einem Firmenkonsortium erfunden wurde, das entsprechende Zertifikate für Geräte mit Funkschnittstellen vergibt.

Aber auch wenn Wi-Fi, dem IEEE-Zertifizierungsstandard der WiFi-Alliance, streng genommen nicht identisch ist mit WLAN als Netzwerkverbindung über Funk, ist dieser Begriff heute auf der ganzen Welt bekannt. Ursprünglich bildete sich die Wi-Fi-Alliance unter dem Namen Wireless Ethernet Compatibility Alliance (WECA) Ende der 1990er Jahre und umfasste mehr als 300 Unternehmen. Zu ihnen gehörten unter anderem Apple, Asus, Canon, Dell, Hewlett-Packard, IBM, Intel, Lexmark, Microsoft, Nintendo, Nokia, Philips, Samsung, Sony, Toshiba. Das Konsortium prüfte und entwickelte diverse Komponenten und vergab auf Basis des IEEE-802.11-Standards das Wi-Fi-Zertifikat. Der Zusammenschluss aller namhaften Hersteller zur Wi-Fi-Alliance gewährleistet damit eine Kompatibilität verschiedener Wireless-Geräte und nicht zuletzt eine herstellerunabhängige Interoperabilität.

Abbildung 279: Logo der Wi-Fi-Alliance

Bis heute (Stand: 2016) setzt das Konsortium den weltweit allgemeingültigen Wi-Fi-Standard durch. Ende 2002 etwa wurde durch die Wi-Fi-Alliance der neue IEEE-Standard 802.11i etabliert, der auch als WPA2 (Wi-Fi Protected Access 2) bekannt ist. Dabei handelt es sich um eine seinerzeit neue Verschlüsselungstechnik, die Sicherheitsstandards in Funknetzwerke implementiert. WPA2 basiert auf verschiedenen Standards. Unter anderem auf dem WPA-Vorgänger Wired Equivalent Privacy (WEP), der mittlerweile als unsicher gilt. Im Gegensatz dazu wird WPA2 als relativ sicher eingestuft, weshalb auch der Begriff RSN (Robust Security Network) synonym verwendet wird.

WLAN findet sich auf der ersten und zweiten Schicht des OSI-Referenzmodells wieder. Als Modulationsverfahren wird in der Regel das orthogonale Frequenzmultiplexverfahren OFDM (Orthogonal Frequency-Division Multiplexing) verwendet. Je nach Hardwareausstattung und Anforderungsprofil kommen für WLAN verschiedenen Modi in Frage. Zum einen zählt hierzu der bereits erwähnte Ad-hoc-Modus, welcher grundsätzlich für die spontane Vernetzung einzelner Endgeräte genutzt wird. Allerdings sind in diesem Zusammenhang sowohl Infrarot als auch vor allem Bluetooth die bekanntere Methode. Das favorisierte und in Privathaushalten am meisten verbreitete Verfahren für WLAN ist der Infrastruktur-Modus mit einer Basisstation (Router) und mehreren Clients (z.B. Laptop, PC, Tablet, Smartphone, Smart-TV, Receiver, Streaming-Box).

Übertragungswege

Doch wer sich für modernes, mobiles und multimediales Fernsehen entschieden hat, stößt spätestens bei der Auswahl des richtigen Netzes an gewisse Grenzen. Denn auch wenn die Technik kaum mehr Wünsche offen lässt, hapert es nicht selten am Netz selbst. DSL, VDSL, Glasfaser, LTE, Breitbandausbau … alles schöne Worte. Nur was nützt der teuerste Smart-TV, die aktuellste Set-Top-Box und der schnellste Router, wenn die Datenautobahn vor der heimischen Netzwerktür quasi aus löchrigem Kopfsteinpflaster besteht?

Insofern sind Vergleiche der „schnellsten Netze“ nur bedingt sinnvoll und nützen letztlich nur dem, der auch eine Wahl treffen kann. Denn schnelles Netz ist zumeist nur denjenigen vorbehalten, die das Glück haben, in einer deutschen Großstadt zu wohnen. Auf dem platten Land kann man nicht einmal qualitativ hochwertig in die berühmte Röhre glotzen. Denn selbst wenn das Hightech-Glasfasernetz zum greifen nahe ist, scheitert der schnelle Internetzugang in nach wie vor weiten Teilen Deutschlands an der sogenannten „letzten Meile“. Für viel Geld kann man sich den Anschluss natürlich bis in die eigenen vier Wände legen lassen. Wer sich das nicht leisten kann oder will, muss auf Alternativen wie LTE zurückgreifen. Und so können vor allem Bewohner ländlicher Regionen vom Highspeed per (Glasfaser-)Kabel auch weiterhin nur träumen.

Abbildung 280: Breitbandverfügbarkeit Mecklenburg-Vorpommern (BMVI, 2015)

Welche Datenautobahnen gelten nun aber als halbwegs schlaglochfrei? Wo ist Highspeed möglich? Was ist die günstigste Variante? Was sind die wichtigsten Hintergründe? Wo kann man sich informieren? Was sind die Alternativen? Wie sehen die Netze der Zukunft aus? Diesen und weiteren Fragen soll im folgenden Kapitel nachgegangen werden.

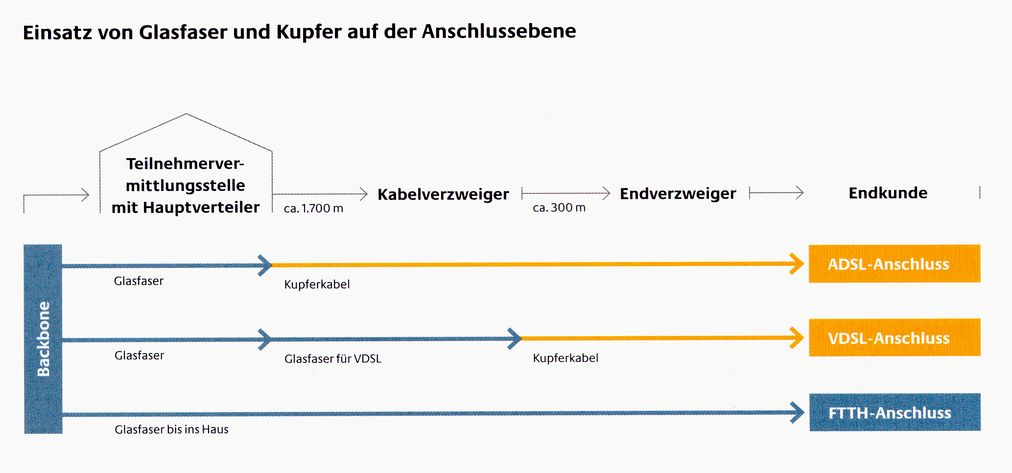

DSL/VDSL

Schon seit Jahren kennt jedes Kind das Schlagwort „DSL“. In letzter Zeit macht insbesondere die Telekom viel Werbung für ihr VDSL. Aber worum geht es dabei eigentlich? Und was ist der Unterschied zu ADSL?

Wer noch das gute alte Modem kennt und das piepsende Geräusch, das es bei der mitunter zeitraubenden Einwahl hinterließ, der weiß in der Regel, dass der digitale Teilnehmeranschluss (Digital Subscriber Line: DSL) die herkömmlichen Kupferkabel nutzt, die im Volksmund als Telefonleitungen bezeichnet werden. Das Internet via Fernsehkabel oder Satellit wird zwar ebenfalls unter dem Begriff „DSL“ vermarktet, allerdings gehören diese im klassischen Sinne eben nicht dazu.

Abbildung 281: Werbung für VDSL der Telekom

Simpel ausgedrückt, gab es seinerzeit noch freie Kapazitäten in den Telefonleitungen, die durch die Übertragung von Sprache allein nicht ausgelastet waren. Deshalb wählte man im Laufe der Digitalisierung des Telefonnetzes ebendiese Infrastruktur für die zusätzliche Datenübertragung. Wenn man nun bedenkt, wie alt das Telefon ist, kann man sich vorstellen, wie die erdverlegten Kupferleitungen nach jahrzehntelangem Einsatz aussehen. Wie bei jedem Kabel ist auch hier für die Qualität der Übertragung insbesondere die Länge aber auch die Beschaffenheit verantwortlich.

Veraltete Kabelschächte, Witterungsbedingungen, zum Teil fehlende Isolierungen und gegebenenfalls technisch nicht ganz einwandfreie Verteilerstellen sind nicht selten die Ursache für schlechten Empfang. Während ein Knacken oder Knirschen in der Telefonleitung irgendwann in den 1970er Jahren nicht weiter störte, möchte sich heute ein Kunde mit Festnetz- und DSL-Anschluss nicht mehr damit zufrieden geben. Denn wenn das Youtube-Video oder gar der spannende Thriller beim Streaming Aussetzer hat, dann hört der Spaß doch wirklich auf.

Abbildung 282: DSL-Varianten

Deshalb sollte bei der Anschaffung einer Streaming-Box oder eines Smart-TVs bereits im Vorfeld der Internetanschluss überprüft werden. Denn bei DSL gibt es Unterschiede, welche für Nichtkenner oft verwirrend sind. Wenn auf Routern beispielsweise steht „für VDSL und ADSL“, fragt sich der durchschnittliche DSL-Kunde, ob sein Anschluss damit überhaupt gemeint sein kann. Ja, er ist es! Denn die diversen „Präfixe“ vor der DSL-Bezeichnung geben in der Regel lediglich Auskunft über die verschiedenen Geschwindigkeiten der Übertragung (Stream).

Für das Senden (Upload) steht hierbei im Allgemeinen eine geringere Bandbreite zur Verfügung als für den Download - also den Datenempfang. Deshalb beziehen sich die Angaben der Provider (Anbieter) meistens auf die Downloadgeschwindigkeit, die für den Heimgebrauch weitaus wichtiger ist. Denn schließlich ziehen wir die Daten überwiegend aus dem Netz und nicht umgekehrt. Hinter der Abkürzung ADSL verbirgt sich beispielsweise nichts anderes als DSL. Das „asymmetrische DSL“ bedeutet lediglich, dass die Geschwindigkeiten für Download und Upload eben nicht symmetrisch, sondern unterschiedlich hoch sind.

Anders als SDSL (Symmetric Digital Subscriber Line). Hier können die Daten genauso schnell ins Netz wie aus dem Netz geladen werden, wobei diese Variante kaum im Privatbereich, sondern vielmehr für Unternehmen geeignet ist, die große Datenmengen ins Internet übertragen müssen. Aber egal, um welches DSL es sich handelt, das Prinzip als solches ist immer gleich.

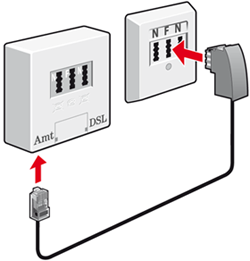

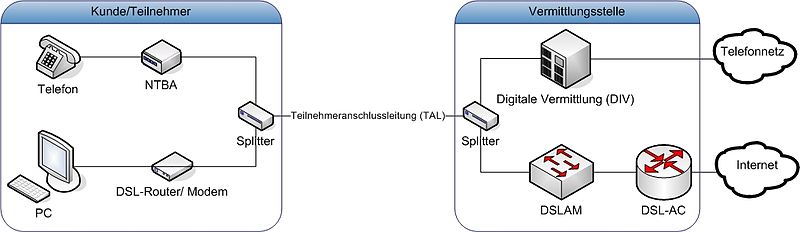

Die Datenübertragung erfolgt auf einer ursprünglich ausschließlich für Sprache ausgerichteten Telefonleitung. Deshalb muss mithilfe eines Splitters das Sprachsignal vom Datensignal getrennt werden. Darüber hinaus sind ein Modem sowie ein Router notwendig, um ins Netz zu kommen und die digitalen Endgeräte miteinander zu verknüpfen.

Abbildung 283: DSL-Splitter (links) und TAE-Dose (rechts) (www.avm.de)

Auch wenn das Modem heute nicht mehr piepst, ist das Prinzip bei DSL grundsätzlich dasselbe geblieben. Der Begriff setzt sich zusammen aus den Bezeichnungen der Arbeitsweise eines Modems. Denn die kleine Kiste ist sowohl MOdulator als auch DEModulator – dient also der Kommunikation zwischen Sender und Empfänger. Während zum Ende des 20. Jahrhunderts dieser digitale Datentransfer noch über das sogenannte Schmalband funktionierte, wird heute mit höheren (breiteren) Trägerfrequenzen gearbeitet, wonach sich auch der Begriff „Breitband“ definiert.

Im Zusammenhang mit dem Breitbandausbau und den damit einhergehenden Datenübertragungsraten wird heute auch von „Very High Speed Digital Subscriber Line“ – kurz VDSL gesprochen. Grundsätzlich funktioniert auch VDSL genauso wie sein langsamerer Vorgänger. Gerade durch die Etablierung von Web-TV und VoD in privaten Haushalten steigt hier der Bedarf an schneller Übertragung hoher Datenmengen. Entsprechend müssen die Provider ihr Angebot durch technische Optimierung anpassen. Seit 2015 werden typischerweise Übertragungsraten von durchschnittlich 50 Mbit/s angeboten. Perspektivisch soll sich diese Zahl verdoppeln. Allerdings sind für ein solch hohes Übertragungsvolumen nicht ausschließlich die Leitungen verantwortlich, die derzeit tatkräftig ausgebaut werden. Der sogenannte DSL-Zugangsmultiplexer beziehungsweise die Entfernung vom Shared Medium – also dem lokalen Netzwerk - zum DSLAM ist entscheidend für einen hohen Durchsatz. Bei diesem DSLAM (Digital Subscriber Line Access Multiplexer) handelt es sich im Grunde um nichts anderes, als den guten alten Telefonverteilerkasten.

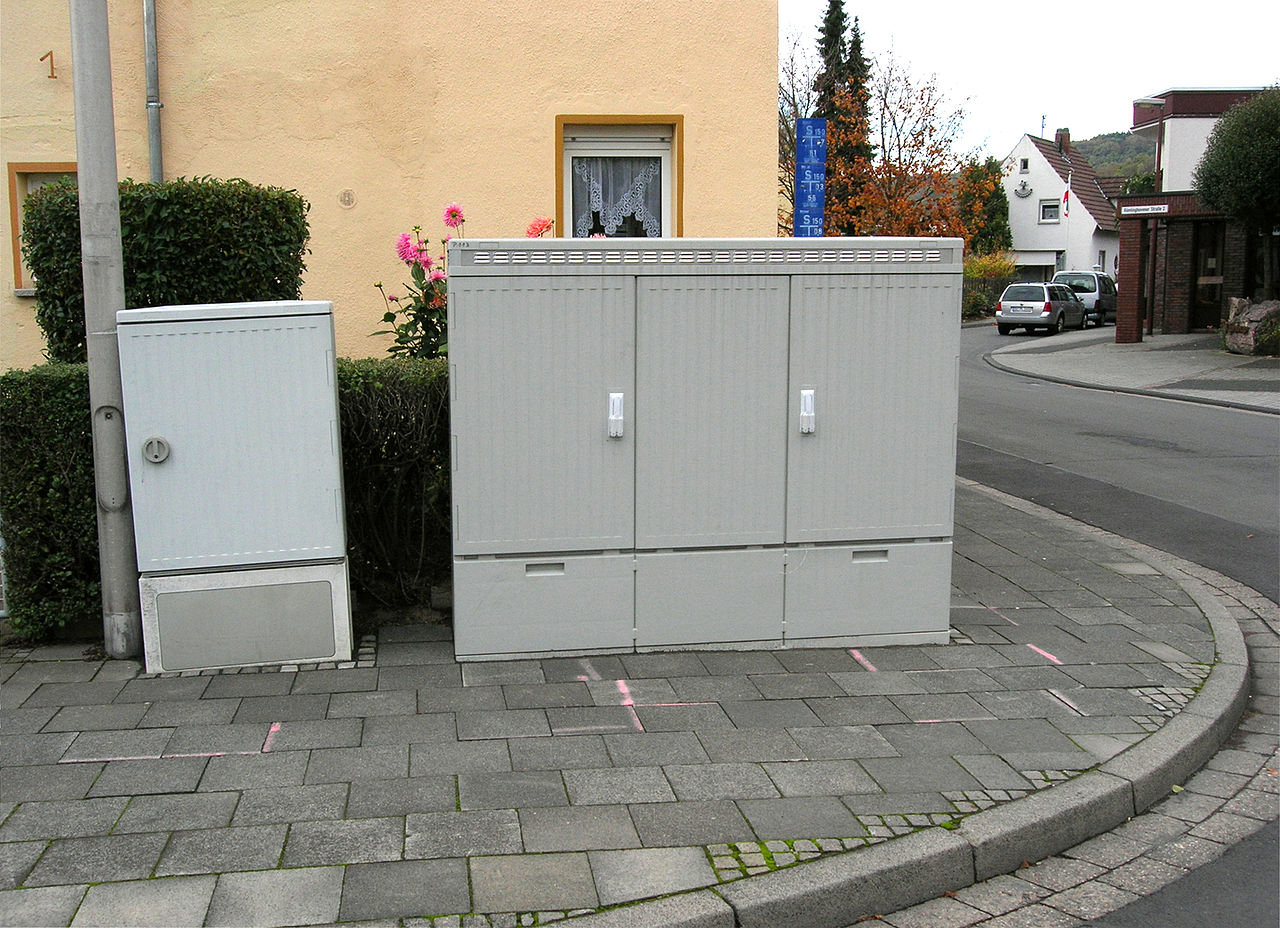

Abbildung 284: Kabelverzweiger (links), Outdoor-DSLAM (rechts) (Wikimedia Commons)

In der Regel stehen diese Vermittlungsstellen für den Privatgebrauch in Wohngebieten. Je nach Wohnsituation laufen hier zahlreiche Teilnehmeranschlüsse zusammen. Allerdings darf die Entfernung vom Heimnetzwerk zum DSLAM nur maximal vier Kilometer betragen. In weniger urbanisierten Gegenden müssen hingegen weite Strecken überbrückt werden, deshalb fehlen dort nicht selten solche Verteilerkästen, die den DSL-Datenverkehr bis zum Endverbraucher bringen. Da heißt es dann: abwarten und LTE nutzen. Alle (V)DSL-Kunden haben irgendwo in der Nähe ihres Hauses einen DSLAM stehen, der sozusagen das Gegenstück zum heimischen DSL-Modem bildet.

Da vor allem in Ballungszentren mitunter mehrere tausend Haushalte über eine solche Vermittlungsstelle gespeist werden, kann es durch die unterschiedlichen Anschlüsse ebenfalls zu Beeinflussungen kommen, die insbesondere dadurch entstehen, dass sich Frequenzen überlagern oder nicht genutzt werden. Deshalb gibt es hier nicht selten eine sogenannte Trainingsphase, in der die Kommunikation zwischen DSL-Modem und DSLAM „geübt“ wird, um den jeweils vertraglich festgelegten Up- und Downstream maximal synchronisieren zu können.

Abbildung 285: Schaubild DSL von der Vermittlungsstelle bis zum Kunden

(Wikimedia Commons)

Weniger Kuddelmuddel bieten „reine“ DSL-Anschlüsse. Da hier nicht mehr zwischen Telefonleitung und Datenübertragung differenziert wird, ist auch kein Splitter mehr erforderlich. Das neue Schlagwort in diesem Zusammenhang heißt: „Voice over IP“ – kurz VoIP. Einfach ausgedrückt, wird das ursprüngliche Telefonkabel ausschließlich für den Datentransfer genutzt. Wie der Begriff „IP“ vermuten lässt, kommt das Telefonsignal nunmehr ebenfalls über das Internet. Näheres hierzu findet sich im Kapitel „Netze der Zukunft“.

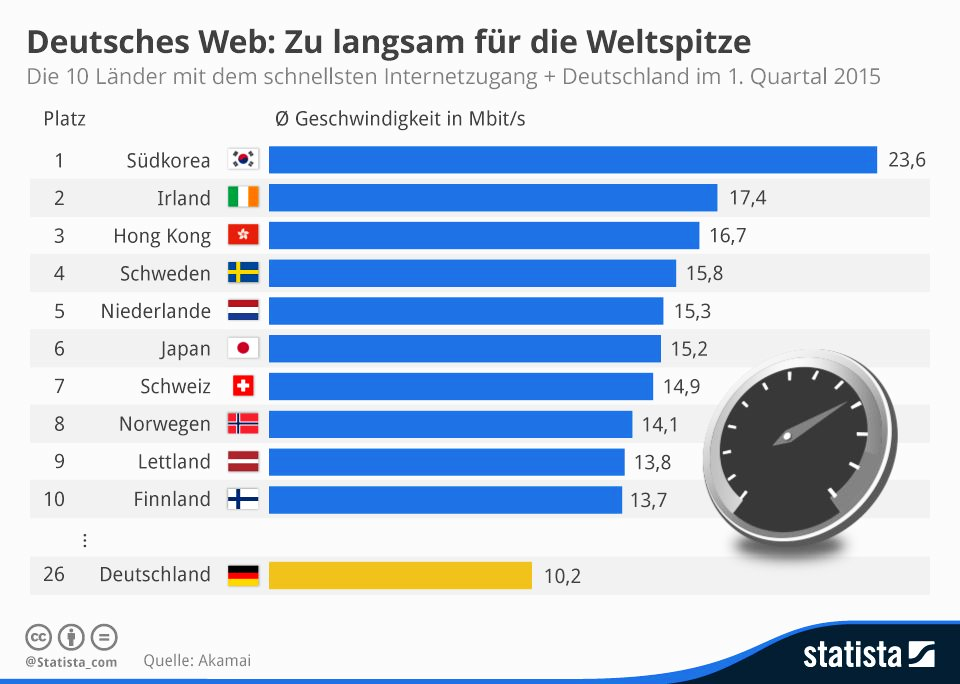

Allerdings ist die Zukunft für Bewohner in ländlichen Regionen nicht ganz so aussichtslos. Branchenverbände und Politik fordern seit Jahren die Beschleunigung des Netzausbaus, und das zu Recht. Die durchschnittliche Downloadgeschwindigkeit in Deutschland betrug statistisch gesehen im Jahre 2015 etwas über 10 Mbit/s. Im internationalen Vergleich ist das mehr als dürftig. Der Zentralverband Elektrotechnik- und Elektronikindustrie (ZVEI) äußerte dies in seiner Pressemitteilung vom 10.07.2015 und appellierte an alle Beteiligten, den Netzausbau insbesondere in Bezug auf die Nachhaltigkeit zu beschleunigen. Gemeint ist hier das Glasfasernetz, mit dem sowohl Privathaushalte als auch Unternehmen mit schnellem Internet im Gigabit-Bereich versorgt werden könnten. ZVEI hält eine flächendeckende Umsetzung bis zum Jahre 2030 für realistisch.

Nicht zuletzt muss die Politik die entsprechenden Rahmenbedingungen (Bundesnetzausbauplan) schaffen und zügig weiterentwickeln. Im Juli 2015 forderte die CDU sogar einen Rechtsanspruch auf eine Internet-Mindestgeschwindigkeit von 50 Mbit/s. Im Abschlussbericht der zuständigen CDU-Programmkommission heißt es dazu unter anderem, “dass jeder an den Chancen der Informationsgesellschaft teilhaben kann”. Hierbei geht es vor allem um den Standortfaktor Internet. Die Ansiedlung von Unternehmen in ländlichen Regionen scheitert allzu oft daran, dass kein entsprechender Anschluss möglich ist. Deshalb stellt die CDU fest, dass jeder “überall in Deutschland über schnelles Internet verfügen” sollte. Das geforderte Zeitfenster der Kommission wurde auf zwei Jahre festgelegt (Quelle: sueddeutsche.de).

Abbildung 286: Internationaler Vergleich der Downloadgeschwindigkeit Mbit/s (statista.com)

Glasfaser

Die Frage bleibt jedoch im Raum: Was ist nun eigentlich so schwer am Netzausbau? Natürlich bedarf es Zeit und vor allem Geld, kilometerlange Kabel vorwiegend durch das Erdreich zu ziehen. Aber selbst wenn die Infrastruktur in der Fläche vorhanden ist, kommt es nicht selten am oben beschriebenen Verteilerkasten zu Problemen, die nur durch einen kompletten Umbau zu lösen wären.

Denn Glasfaserkabel könnten tatsächlich problemlos Datenmengen im Gigabit-Bereich (< 1000 MBit/s) befördern. Theoretisch! Doch in der Regel werden diese im Verteilerkasten mit dem weitaus langsameren Kupferkabel kombiniert. Natürlich legen mittlerweile auch private Anbieter solche Glasfasernetze. Jedoch fallen nach wie vor weite Teile der kompletten Infrastruktur, das heißt inklusive DSLAM, in den Zuständigkeits- oder zumindest Verwaltungsbereich der Telekom. Das (staatliche) Monopol der ehemaligen „grauen Post“ wurde zwar im Rahmen der Privatisierung in den 1990er Jahren zerschlagen, doch immer noch haben es kleinere Unternehmen schwer, den Marktzugang zu finden. Hauptgrund sind letztlich die hohen Kosten für die aufwändige Bereitstellung der Glasfaser-Anbindungen. Regionale Anbieter sind bisher nur in großen Städten wie München, Köln oder Hamburg zu finden. Und selbst dort sind die Anschlüsse mit der Lupe zu suchen.

Doch wie funktioniert nun das Breitband-Internet über Glasfaser? Bei der Übertragung via Glasfasern werden die Daten als Lichtsignale codiert und weitergeleitet. Deshalb spricht man in diesem Zusammenhang auch von Lichtwellenleitern (LWL) oder auch optischen Leitungen, die aus langen und sehr dünnen Fasern aus geschmolzenem, hochreinem Quarzglas bestehen. Im Vergleich zu herkömmlichen Kupferkabeln (Telefonleitungen) bietet dieses Material eine weitaus geringere Anfälligkeit in Bezug auf elektromagnetische Störungen. Deshalb können im Glasfasernetz ohne „Reibungsverluste“ sehr viel höhere Datenmengen transportiert werden. Datenraten bis zu 40 GBit/s sind theoretisch möglich, wäre eben nicht die Überbrückung durch Kupferdraht bis zum Endkunden. Vor diesem Hintergrund wird im Rahmen der Glasfasertechnologie auch von „Fibre To The Curb“ (FTTC) gesprochen, was so viel wie „Glasfaser bis zum Bordstein“ bedeutet. Auch FTTN ist ein gängiger Begriff: Fiber To The Neighborhood (Glasfaser bis zur Nachbarschaft) oder FTTB (Fibre To The Basement/Building – also Glasfaser bis in den Keller beziehungsweise zur Grundstücksgrenze).

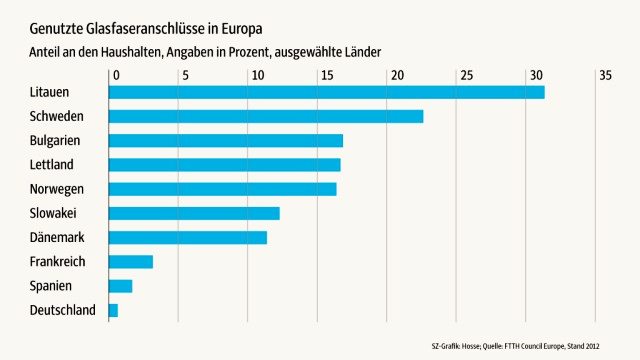

Abbildung 287: Glasfaseranschlüsse im europäischen Vergleich (2012)

Lediglich bei der Variante FTTH (Fiber To The Home) wird die Glasfaserleitung bis in die Wohnung gelegt. Allerdings sind nur sehr wenige Häuser bisher überhaupt mit LWL-Kabeln ausgestattet. Die Sanierung der gebäudeinternen Kabelinfrastruktur ist kostenintensiv, zumal die sehr dünnen Leitungen überaus empfindlich gegenüber mechanischen Belastungen sowie Flüssigkeiten sind. Auch dieser Umstand erschwert eine flächendeckende praktikable Lösung im Alltag. Deshalb wird Glasfaser in Deutschland fast ausschließlich für Datenfernleitungen (Backbone) verwendet. Die Zahl der Anbieter ist überschaubar, die Zahl der Verbraucher unterdurchschnittlich. Dabei könnte beim Neubau eines Eigenheimes gleich drauf geachtet werden, die „richtigen“ Strippen zu ziehen. Provider wie die Telekom beraten hierzu auf ihren Internetseiten oder via Hotline (www.telekom.de/bauherren oder 0800 33 01903).

Abbildung 288: Anschlussvarianten (Quelle: Jahresbericht 2005 Bundesnetzagentur)

Doch wie bereits erwähnt, müssen die Leitungen überhaupt bis zum Bordstein verfügbar sein. Wenn es nicht mal diesen gibt, wird es schwer in punkto Internetnutzung. Allerdings bedeutet „schwer“ noch nicht zwangsläufig unmöglich. Denn auch für die zahlreichen Nutzer, die vom Breitbandausbau bisher nicht profitieren konnten, gibt es Zugang zur Datenautobahn, auch wenn diese eher einer schmalen Landstraße ähnelt.

LTE (4G)

Die Angebote der LTE-Anbieter liegen bei spärlichen 7 bis 50 MBit/s, wobei das versprochene Maximum selten, das Downloadvolumenlimit dafür entsprechend schnell erreicht wird. Ähnlich wie beim Vorgänger UMTS (3G+) wird das ohnehin schon langsame Netz auf ein paar KBit/s gedrosselt, was den Ladevorgang um einiges erhöht. Denn Datenmengen von einem Gigabyte sind schnell erreicht, wenn man Streamingdienste in Anspruch nimmt oder sich einfach im Internet gerne Videos anschaut.

Insofern stellt LTE (Long Term Evolution) für den Multimediabereich zu Hause nicht die optimalste Lösung dar, die aber immerhin besser ist als nichts. Der im Jahre 2012 eingeführte Standard verfügt über optimierte Modulationsverfahren und die Nutzung verschiedener Frequenzbereiche. In ländlichen Regionen sind Frequenzen um 800 MHz, in Städten Bereiche von 1,8 bis 2,6 GHz möglich.

Diese Bandbreite macht in jedem Fall schnelleres Internet möglich, und zwar überall. Wer also keine Kupfer- oder Glasfaserkabel vor der Haustür oder gar in den eigenen vier Wänden hat, der könnte mit einem LTE-fähigen Router sein heimisches Netzwerk einrichten.

Abbildung 289: Werbung für LTE-Internet (2013)

Neben Funk- und Festnetz war Ende der 1990er Jahre eine weitere Alternative in der Entwicklung, die an sich sehr vielversprechend war – insbesondere da eine flächendeckende Internetversorgung einfach, schnell und kostengünstig hätte erfolgen können. Doch beim Internet aus der Steckdose gab es schlichtweg zu viele Hürden, die selbst die großen Konzerne wie E.ON, RWE, EnBW und MVV nicht überwinden konnten.

Powerline Access

Die Idee der vier größten deutschen Energieversorger klang auf den ersten Blick logisch und vor allem praktikabel. Schließlich ist das Stromnetz auch in der letzten Ecke Deutschlands verfügbar. Warum also nicht einfach Telefonie und Internet ebenfalls über die bereits vorhandene Infrastruktur legen und somit kosten- und zeitintensive Glasfaserkabelarchitektur sparen? Was auf den ersten Blick durch seine schlichte Ausführung besticht, wurde allerdings sogar von Experten beim Marktstart im Jahre 2001 als Flop deklariert, da nach deren Meinung das Konzept keine Chance gegen die Konkurrenz im kabel- oder funkbasierten Breitband habe. Und ebenjene Experten sollten Recht behalten: Powerline-Access hat den Durchbruch nie geschafft. Die Hintergründe dafür sind zum einen auf den starken Wettbewerb am Markt zurückzuführen. Die technischen Probleme, die Powerline-Access mit sich bringt, sind jedoch andererseits auch nicht von der Hand zu weisen.

Die Powerline-Technologie wirkte sich störend sowohl auf den Amateurfunk, aber insbesondere auf die Funkdienste von Polizei oder Militär aus. Grund dafür sind die verwendeten Trägerfrequenzen. Während die Elektrizität standardisiert 50 Hz nutzt, werden bei der Datenübertragung über das Stromnetz weitaus höhere Frequenzen (150 kHz bis 30 MHz) verwendet. Der Nebeneffekt: Stromleitungen werden zu Antennen, und die daraus resultierende Störfeld-Problematik führte nicht zuletzt zu einer Bundesratsinitiative im Frühjahr 2001, über die vonseiten der damaligen Regulierungsbehörde für Telekommunikation und Post (RegTP) bestimmte Grenzwerte festgelegt wurden. Die heutige Bundesnetzagentur musste die sogenannte Nutzungsbestimmung 30 (NB 30) allerdings wieder zurücknehmen, da vonseiten der EU diese als zu streng erachtet wurde. Geregelt wird Powerline dennoch - heute beispielsweise durch das Gesetz über die elektromagnetische Verträglichkeit von Betriebsmitteln (EMVG) und die Sicherheitsfunk-Schutzverordnung (SchuTSEV).

Die großen Energieversorger stiegen quasi kurz nach der Markteinführung schon wieder aus dem Geschäft aus. Bekannt für Internet aus der Steckdose ist bislang lediglich noch die Stadtwerke Hameln mit ihrem vor Ort angebotenen piper.net. Aber auch wenn sich Internet via Powerline-Access nicht durchsetzen konnte, nutzen die Energieversorger die Technologie für ihre Smart Grids und Privatanwender für die bereits erwähnte Heimvernetzung (Power-LAN).

Abbildung 290: Internet aus der Steckdose (www.stadtwerke-hameln.de)

Doch selbst wenn sich die eine oder andere Technologie nicht durchsetzen konnte, werden im Zukunftsmarkt der multimedialen Technik weitere Optionen entwickelt, um zumindest einen Basisstandard für alle Haushalte zu erreichen. Insofern ist das Ende der berühmten Fahnenstange noch längst nicht erreicht. Ähnlich wie beim Fernsehen gibt es deshalb auch für das Internet diverse Übertragungsmöglichkeiten, wobei mit zunehmender Nachfrage nunmehr auch Wege genutzt werden, die bis vor kurzem ausschließlich dem TV-Signal vorbehalten waren.

Netze der Zukunft

Die Not macht erfinderisch, könnte man meinen. Oder der Drang nach Vielfalt und das Ringen um Marktanteile kommt denjenigen zu Gute, die nicht ewig darauf warten wollen, bis der Breitbandausbau irgendwann auch ihre heimische Haustür erreicht hat. Wenn das IP-Signal über das Telefonsignal gelegt werden konnte, dann klappt das auch mit dem TV-Signal.

Abbildung 291: Werbung für Netzqualität (www.telekom.de)

Internet via Satellit

Richtig gedacht! Vor allem, weil schon das Satellitenfernsehen an sich nahezu überall verfügbar ist. So könnte IP over SAT durchaus eine flächendeckende Alternative zu DSL bedeuten und vielleicht sogar die Lösung für das Debakel um den Netzausbau und das Warten auf freiwerdende Frequenzkapazitäten durch die Digitalisierung des terrestrischen Radio- und Fernsehprogramms (DVB-T). Voraussetzung ist natürlich – wie bereits im Rahmen der Satellitentechnik erwähnt – die entsprechende Hardware, welche in der Anschaffung erst einmal nicht ganz billig ist, allerdings mittel- und langfristig gesehen durchaus preiswerter sein kann als Festnetz- oder Kabelanschluss.

Zumal mit einer Satellitenschüssel alle drei Dienste (Telefonie, TV und Internet) abgedeckt werden können. Das heißt, mit Eutelsat oder Astra ist Triple-Play verfügbar, und das gar nicht mal schlecht. Wo leitungsgebundene Technologien nicht möglich sind oder wem die funkgestützte Grundversorgung (1 MBit/s) zu wenig erscheint, der kann mit Satelliteninternet Übertragungsraten von bis zu 22 MBit/s im Downstream und 6 MBit/s im Upstream erreichen. Zur Erinnerung: Wer mit VDSL-Anschluss nicht direkt neben der Vermittlungsstelle wohnt, bei dem sinken die versprochenen 50 MBit/s proportional zur Entfernung zum DSLAM; ab 900 Meter bereits auf 26 beziehungsweise 5,5 Mbit/s, ab zwei Kilometern surft man lediglich auf ADSL-Niveau, das weit unter den Übertragungsraten via Satellit liegt.

Dank der Zweiwegetechnologie im KA-Band ist heutzutage auch beim Satelliteninternet sowohl Download als auch Upload möglich. Der französische Satelliten-Anbieter Eutelsat hat dazu die sogenannte TooWay-Technologie entwickelt. Wem das Inklusiv-Volumen der Anbieter zu niedrig ist, der kann den Vorteil der Nachoption nutzen. Hierzu bietet beispielsweise der Provider getinternet zwischen 0.00 und 6.00 Uhr morgens Surfen ohne Limit an, was insbesondere für Downloads größerer Datenmengen (z.B. Videodateien) interessant sein dürfte. Insofern lohnt sich der direkte Vergleich vor allem in Bezug auf das Inklusiv-Volumen und ein Blick in die jeweiligen AGBs. Denn auch bei Flatrates wird auf eine minimale Bandbreite gedrosselt, sofern das Datenvolumen erreicht wurde. Um eine Netzüberlastung in Hochnutzungszeiten zu umgehen, wird der Speed auf alle Nutzer fair verteilt (Fair Use Policy). Mithilfe eines sogenannten Volumen-Boosters kann man bei getinternet beispielsweise spontan sein Datenvolumen erhöhen.

Abbildung 292: skyDSL - Internet via Satellit (2015)

TooWay, SkyDSL, getinternet, selbst bei Angeboten der Telekom ist das Prinzip von SAT-Internet vom Grundsatz her gleich, lediglich die Tarife unterscheiden sich in der Datenrate und dem Inklusiv-Volumen. Ähnlich wie bei anderen Übertragungswegen kann man die Hardware direkt vom Provider beziehen und entweder als Einmalpreis oder aber als Leihgabe monatlich bezahlen.

|

TooWay-Anbieter im Überblick |

||||||

|

Provider |

Tarif |

Down- MBit/s |

Up- MBit/s |

Inklusiv-volumen/ Flatrate |

Kosten |

Hardware einmalig o. Leihgerät |

|

EUSANET |

Flexus |

20 |

6 |

bis 2 GB bis 10 GB ab 10 GB |

18,90 |

399,00 |

|

Sat Internet Services |

tooway 10 tooway 25 tooway 40 tooway Extra Flat Absolute |

22 22 22 22 20 |

6 6 6 6 6 |

10 GB 25 GB 40 GB 100 GB Flatrate |

29,90 44,90 64,90 89,90 89,95 |

399,00 399,00 399,00 399,00 399,00 |

|

skyDSL |

skyDSL 2+ Flat S skyDSL 2+ Flat M skyDSL 2+ Flat L |

6 12 20 |

1 4 6 |

Flatrate Flatrate Flatrate |

29,90 39,90 69,90 |

399,00 399,00 399,00 |

|

getinternet |

tooway 2 tooway 10 tooway 25 tooway 40 tooway Extra tooway Flat |

5 22 22 22 22 20 |

1 6 6 6 6 6 |

2 GB 10 GB 25 GB 40 GB 100 GB Flatrate |

19,90 29,90 44,90 64,90 89,90 99,90 |

189,00 129,00 109,00 99,00 99,00 99,00 |

Abbildung 293: Satelliteninternet-Tarife im Vergleich, Stand: Juni 2015 (www.teltarif.de)

Doch egal, für welchen Provider man sich entscheidet, der Lieferumfang beziehungsweise das benötigte Equipment ist vergleichbar:

-

Satellitenantenne mindestens 75 Zentimeter Durchmesser

-

Sende- und Empfangs-LNB (iLNB)

-

Modem mit Netzwerkanschluss (Ethernet/LAN)

-

Netzwerkkabel (Patch)

-

Koaxialkabel

-

Satellitenfinder (Point&Play-Werkzeug).

Für TV-Empfang und das Heimnetzwerk sind zusätzlich ein SAT-Receiver und ein WLAN-Router erforderlich. Da das Telefon nicht mehr über den herkömmlichen Telefonanschluss (ISDN) kommt, benötigt man für VoIP entsprechende Geräte. Wer zwei linke Hände hat und die Installation lieber einem Fachmann überlassen möchte, der findet bei seinem favorisierten Anbieter die nötige Unterstützung.

Abbildung 294: Montageservice für SAT-Internet (www.getinternet.de)

Internet via Kabel

Auch Kabelkunden können über ihren Fernsehanschluss ins Internet gehen. Die entsprechenden Provider (z.B. Kabel Deutschland oder Unitymedia) werben damit, dass TV-Kabel-Internet schneller als DSL und sogar VDSL sein soll. Dabei werden Datenraten von 32 bis 100 MBit/s versprochen. Allerdings ist auch hier Vorsicht geboten. Denn der tatsächliche Durchsatz reduziert sich proportional zur Anzahl der Nutzer. Das Maximum wird bestenfalls im Eigenheim erreicht, dagegen kaum in Mehrfamilienhäusern, wo sich zahlreiche Mieter einen Kabelanschluss teilen. Wer jedoch als DSL-Kunde in großer Entfernung zur nächsten Vermittlungsstelle wohnt, der könnte mit Internet via Fernsehkabel mehr Erfolg haben – jedenfalls in punkto Datenraten.

Mittlerweile kann man beim Kabelnetzbetreiber eben nicht nur Triple-Play – also Internet, Telefon und TV – buchen, sondern einen separaten Internetanschluss. Diejenigen, die auf das klassische Kabel-Fernsehen verzichten wollen, können also auch ohne Komplettpaket ins Netz. Hier wird das TV-Signal einfach gesperrt. Beim Preisvergleich zu DSL & Co. sollten die Geschwindigkeiten für Up- und Downstream aber auch das jeweilige Volumen der angebotenen Flatrates verglichen werden. In der Regel verbrauchen sich ein paar Gigabit schnell, danach wird standardgemäß gedrosselt.

Wer also seinen Internetanschluss für mehr als nur E-Mail nutzen möchte, sollte bei der Internetflatrate auf das Datenvolumen achten. Allerdings erreichen diese in den diversen Tarifen mittlerweile schwindelerregende Höhen. Die Firma Vodafone hat beispielsweise für ihre Kundschaft differenziert, wie viel Anwendungen in etwa 1.000 GB entsprechen. Die durchaus interessante Rechnung sieht wie folgt aus:

-

bis zu 147.000 Youtube-Videos oder

-

bis zu 241 HD Filmen (90 Minuten) oder

-

bis zu 900 Filmen (Standardqualität) oder

-

bis zu 694 Tagen oder 16.656 Stunden Musik hören oder

-

bis zu 2.760 Stunden bzw. 115 Tage Skypen oder

-

bis zu 2.500.000 Websites öffnen.

In der Erläuterung ihres Tarifes „Internet & Phone Kabel 200 V“ findet sich darüber hinaus der Hinweis, dass sich die maximale Geschwindigkeit von 200 MBit/s auf 10 MBit/s im Downstream reduziert, wenn dieses monatliche Inklusiv-Volumen von 1.000 GB verbraucht wurde. Jedoch bleibt zu bezweifeln, ob es selbst passionierten Couch-Potatos, Dauersurfern und HD-Guckern gelingt, dieses Limit überhaupt zu knacken.

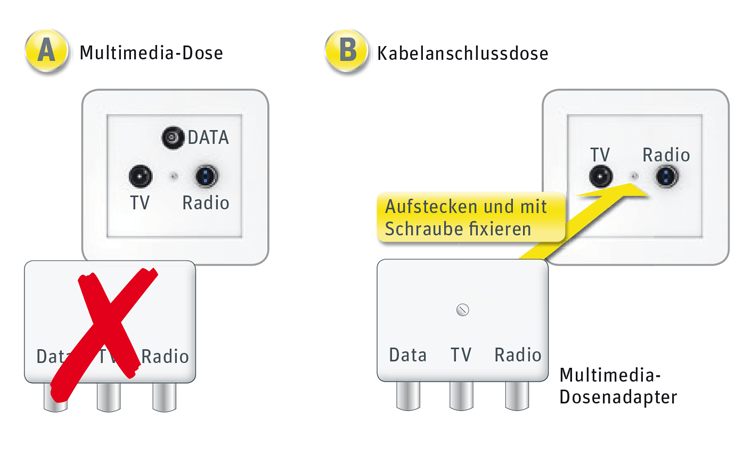

Abbildung 295: Umrüstung des alten Kabelanschlusses auf Triple Play (www.dslweb.de)

Wenn sowohl TV und Radio als auch Internet und Telefon über den kabelbasierten Anschluss übertragen werden sollen, muss in jedem Fall eine Umrüstung des Anschlusses erfolgen. Dazu kann entweder eine neue Multimedia-Dose installiert oder aber mithilfe eines Adapters die alte Dose umfunktioniert werden.

Wer also sowieso schon über einen Kabelanschluss verfügt oder sich demnächst einen solchen zulegen möchte, der könnte von Triple-Play profitieren und den separaten Telefon- und Internetanschluss (soweit vorhanden) kündigen. Denn der multimediale Paket-Service liegt voll im Trend und wird immer beliebter. Jedoch ist das sogenannte Next Generation Network (NGN) eigentlich schon wieder Makulatur. Was mit Voice over IP – dem Telefon über das Internet - begann und sich mit Triple-Play fortsetzte, wird demnächst sein kompaktes (vorläufiges) Finale im All-IP finden.

All-IP (Quad Play)

Wie der Begriff All-IP vermuten lässt, handelt es sich dabei um die Umstellung ALLER bisherigen Übertragungstechniken in Telekommunikationsnetzen auf IP-Basis: Telefon, Fernsehen, Mobilfunk und Internet kommt dann quasi aus einer Leitung. Als Nachfolger von Triple Play wird dieses Modell, das alle vier Segmente der Telekommunikation vereint, auch als Quad Play bezeichnet.

Abbildung 296: Umstellung auf All-IP bis 2018 (www.telekom.de)

Die digitale Paketvermittlung über das Netzwerkprotokoll (All-IP) ist zwar für junge Leute, Technikbegeisterte und alle jene, die beispielsweise von Berufs wegen an modernen Technologien interessiert sind, ein wahrer Segen. Doch gerade die ältere Generation aber auch Menschen mit schmalem Geldbeutel sind dabei die Leittragenden, denn sie werden nicht gefragt. Analoge Technologien sowie ISDN-Anschlüsse werden in naher Zukunft vom Markt verschwunden sein. Und das nicht unbedingt freiwillig.

Bis Ende 2018 soll die Umstellung auf All-IP abgeschlossen sein. Nicht nur die Telekom, sondern die gesamte deutsche Telekommunikationsbranche hat sich zum Ziel gesetzt, das öffentliche Fernmeldenetz und damit sämtliche Anschüsse auf die IP-basierte Technik umzustellen. Alle deutschen Privathaushalte aber vor allem Unternehmen, die bisher ISDN-Kommunikationssysteme genutzt haben, müssen sich langsam Gedanken darüber machen, wann und wie sie auf die IP-Technologie und damit auf neue Geräte umrüsten. Denn die alten Telefonanlagen sind dann ein Fall für die Müllabfuhr.

Und mehr noch: Wenn der Strom ausfällt, kommt die Kommunikation zum Stillstand. Während über die guten alten Telefonleitungen auch dann noch telefoniert werden konnte, wenn ansonsten Dunkelheit herrschte, wird mit VoIP diese Möglichkeit nicht mehr gegeben sein. Sämtliche Geräte sind auf den Strom aus der Leitung angewiesen. Wenn der Router nicht funktioniert, läuft also nichts mehr. Es sei denn, man verfügt über ein Notstromaggregat. Doch wer hat das schon?

Abbildung 297: Gigaset der Firma Siemens (ISDN und VoIP)

Die Telekom begann bereits im Herbst 2014, mit Zwangskündigungen zu drohen. Wechselunwillige Kunden werden sukzessive aus ihren Verträgen gedrängt. Auch wenn die große Kündigungswelle erst für 2017 geplant ist, wurde bereits im Jahre 2015 damit begonnen. Nach deutschem Vertragsrecht sind solche Zwangskündigungen rechtlich durchaus legitim.

Obwohl eine solche Vertragsbeendigung durch den Anbieter insbesondere für kleinere Telekommunikationsunternehmen bestenfalls die Ausnahme darstellen soll, bleibt sowohl den verbrauchenden Unternehmen als auch den zahlreichen Privatkunden nichts anderes übrig, als jetzt schon mal die Portokasse auf Eis zu legen. Denn je nach Umfang kommen mitunter hohe Investitionskosten auf sie zu. Bis 2018 will die Telekom ISDN komplett abschalten. Im Jahre 2016 gelten bereits etwa siebeneinhalb Millionen Anschlüsse in den Privathaushalten als umgestellt. Im Geschäftskundenbereich entwickelt sich die Umstellung auf die neue Übertragungsart hingegen etwas langsamer. Doch der Zeitplan für die Umstellung steht. ISDN war gestern. All-IP die weltweite Zukunft. Alternativen kaum vorhanden. Basta!

Abbildung 298: Werbung für IP-basierten Anschluss der Telekom (2015)

Doch der „Anschluss an die Zukunft“ ist als solcher natürlich auch kein Werk des Teufels. Im Gegenteil! Telefonieren, Surfen, Mailen, Faxen, Fernsehen – alles aus einer Hand, alles über IP – hat auch durchaus bestechende Vorteile zu bieten:

-

hohe Bandbreiten

-

mehrere Rufnummern

-

viele Funktionen ohne Aufpreis

-

kostenlose Rufumleitung

-

automatische Namensanzeige auch ohne Rufnummernspeicherung

-

kein Splitter oder NTBA mehr erforderlich

-

exzellente Sprachqualität ohne Rauschen

-

Festnetz über Smartphone

-

Mailboxnachrichten per E-Mail

-

geräteunabhängiger Zugriff auf alle Daten und Dokumente

-

WLAN TO GO: kostenloses Surfen an Millionen Hotspots weltweit

-

Regelung der Haustechnik (Beleuchtung, Entertainment, Alarm- oder Klimaanlage etc.) über Smartphone, Tablet oder PC

-

und natürlich Fernsehen sowie VoD inklusive.

Man könnte also behaupten, bei All-IP handelt es sich um Fluch und Segen zugleich. Ähnlich wie bei der Umstellung von VHS auf DVD, DVD auf Blu-ray, Kassette auf CD, Schreibmaschine auf Computer, Röhrenfernseher auf Flachbildschirm, SD auf HD und HD auf UHD/4K wird man in einigen Jahren auch über den Wechsel zu All-IP nur noch schmunzeln.

Das einzig Anstrengende an der Entwicklung der multimedialen Welt ist doch letztlich die rasante Geschwindigkeit, mit der diese vonstattengeht. Der gute alte Fernseher des 20. Jahrhunderts war quasi ein Mitglied der Familie. Heute hat man kaum noch Zeit, mit den Geräten vertraut zu werden. Im gefühlten Minutentakt gibt es schon wieder Nachfolgemodelle mit weiterentwickelten Standards auf dem Markt. Deshalb sollen im nächsten Kapitel einige Geräte für das heimische Netzwerk vorgestellt werden.

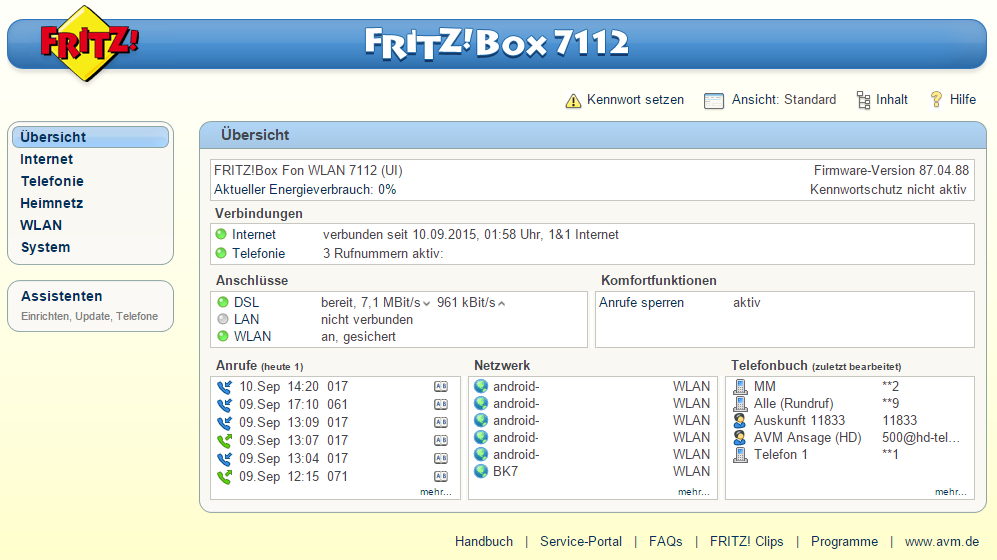

Router & Co.

Die Basisstation im Infrastruktur-Modus bildet ein sogenannter Wireless Access Point beziehungsweise drahtloser Router, der für die Koordination aller Clients verantwortlich ist. Dieser sendet in festgelegten Intervallen (z.B. zehnmal pro Sekunde) kleine Datenpakete an alle Geräte (Clients) innerhalb des Empfangsbereichs, wobei dabei immer die niedrigste Übertragungsrate von 1 MBit/s gewählt wird. Die Datenpakete, welche auch Beacons (Leuchtfeuer) genannt werden, beinhalten bestimmte Informationen. Dazu zählen unter anderem der Netzwerkname (Service Set Identifier: SSID) sowie einige Parameter in Bezug auf die Verschlüsselung. Auf diese Weise wird der Verbindungsaufbau zwischen Router und Clients erleichtert, und der permanente Kontakt ermöglicht eine stetige Überwachung der Empfangsqualität.

Abbildung 299: Beispiel für eine Fritz!Box-Oberfläche

Im Allgemeinen suchen sich die Clients die Verbindung zum Zugangspunkt (Router). Anders als bei einer kabelgebundenen Variante, wo eine direkte Steckverbindung den Zugriff nichtautorisierter Dritter fast unmöglich macht, kann bei WLAN dies nicht ausgeschlossen werden. Deshalb ist eine Verschlüsselung sinnvoll, da theoretisch jedes Gerät im unmittelbaren Umkreis auf das Funksignal zugreifen kann. Zum Schutz des heimischen Netzwerkes sollte der WLAN-Zugang grundsätzlich mit einem entsprechenden Key (WLAN-Pin) verschlüsselt werden.

Aktiviert wird dieser Netzwerkschlüssel entweder bei der Installation des Netzwerkes oder auch im Nachhinein. In diesem Zusammenhang sollte auf die Abkürzungen WEP (Wired Equivalent Privacy) und WPA (Wi-Fi Protected Access) geachtet werden, die den jeweiligen Verschlüsselungsstandard darstellen, wobei der Nachfolger WPA2 mehr Sicherheit durch längere Schlüssel (Keys) gewährleistet.

Grundsätzlich sollte dabei beachtet werden, dass unrechtmäßige Nutzer nicht nur kostenlos durch das Internet surfen können, sondern im Zweifel auch Zugriff auf alle persönlichen Daten haben oder aber im Namen des eigentlichen Netzwerkinhabers (Internetvertragskunden) Straftaten begehen können. Denn ein Netzwerk (ob lokal als WLAN oder dezentral im WWW) funktioniert immer in beide Richtungen. So können Daten jederzeit zurückverfolgt werden.

Besitzer einer Fritzbox haben mit der Fritz!Box-Oberfläche einen relativ schnellen und vor allem einfachen Überblick (Abbildung 285). Auf jedem Tablet, PC oder Laptop, das im Heimnetzwerk angemeldet ist, kann über den Internetbrowser die Oberfläche des jeweiligen Routers (Fritz!Box) aufgerufen werden. Auch hier sollte auf ein Kennwort nicht verzichtet werden. Neuere Modelle schreiben ein solches im Übrigen vor. Grundsätzlich sind – wie in Abbildung 285 dargestellt - auf einen Blick sämtliche Informationen erhältlich, was insbesondere dann sinnvoll ist, wenn es zu Komplikationen kommt.

Denn die an sich einfache und vor allem praktikable Lösung ohne Kabel hat auch ihre Nachteile. Neben der Sicherheit sei hier die Störanfälligkeit genannt. Wer in einem Haus wohnt, dessen Wände und Decken aus dickem Stahlbeton bestehen, der kann selbst mit dem besten und teuersten Router seine Empfangsprobleme haben. Auch die Reichweite ist begrenzt. Wenn sich die Basisstation im Keller befindet, wird es ziemlich schwer bis aussichtslos sein, im zweiten Stock noch verlustfrei streamen oder surfen zu können.

Zur Erhöhung von Reichweite und Sendeleistung können auch mehrere Access Points (Router) zu einem Wireless Distribution System (WDS) zusammengeschlossen werden. Aber auch sogenannte Repeater dienen quasi als verlängerter Arm. Im heimischen Netzwerk könnte ein solcher Signalverstärker einem Smart-TV im Obergeschoss schon ordentlich auf die Sprünge helfen. Ähnlich wie Power-LAN vergrößern WLAN-Repaeter die Reichweite des IP-Signals. Denn die kleinen Boxen, die man ebenfalls in die herkömmliche Steckdose steckt, bereiten das empfangene Signal auf und senden es neu moduliert weiter. Somit können größere Distanzen vom eigentlichen WLAN-Router zu stationären oder aber mobilen Endgeräten überbrückt werden, allerdings erhöhen sie nicht die bestehende Datenrate eines Netzes.

Abbildung 300: Repeater als Signalverstärker im WLAN-Netzwerk (AVM/www.amazon.de)

Auch wenn der WLAN-Repeater grundsätzlich die Reichweite eines drahtlosen Funknetzes erhöht, kann sich die Datenübertragungsrate des Funknetzes bei Verwendung eines solchen Signalverstärkers jedoch verringern. Denn der Repeater kommuniziert sowohl mit dem Client als auch mit dem Wireless Access Point – also dem WLAN-Router. Bei herkömmlichen Repeatern funktioniert diese Kommunikation auf derselben Frequenz. Eine Halbierung der Datenrate lässt sich also nur umgehen, wenn dafür unterschiedliche Kanäle genutzt werden. Jedoch ist diese Option nicht überall vorgesehen. Dennoch kann die Zwischenschaltung eines solchen Signalverstärkers die drahtlose Funkverbindung im WLAN-Netzwerk verstärken und damit die Qualität des Signals erhöhen. Grundsätzlich können nahezug beliebig viele WLAN-Verstärker im Privatbereich installliert werden. Allerdings kommt es bei über zwanzig Repeatern zu Funksignal-Überschneidungen.

Abbildung 301: Dyon D100004 WLAN Repeater + WPS-Datenverschlüsselung

Dreh- und Angelpunkt im heimischen Netzwerk bleibt jedoch der Router. Er bestimmt quasi die Verkehrsführung bei der Übertragung der Datenpakete. Dabei stellt er zum einen die Verbindung zum Internet her, zum anderen kommuniziert er mit den einzelnen Clients, indem er als sogenannter DHCP-Server fungiert und jedem Gerät innerhalb des Netzwerkes eine IP-Adresse zuteilt.

Wie in einem Logistikzentrum werden also Absender und Adressaten identifiziert sowie die effizientesten Routen für den Transport bestimmt. Im Bereich der Netzwerktechnik wird dabei generell zwischen zwei Prozessen unterschieden. Obwohl der Begriff „Routing“ im Allgemeinen als Oberbegriff gilt, wird darunter im eigentlichen Sinne lediglich der Weg des Nachrichtenstroms verstanden, der individuell festgelegt wird. Hingegen stellt das sogenannte Forwarding den Entscheidungsprozess dar, über welche Netzknoten die jeweilige Nachricht weitergeleitet werden soll. Für den Heimgebrauch reicht allerdings das Wissen, dass der Router ganz allein entscheiden kann, wie und wohin er die Daten übertragen soll.

Seit Jahren ungeschlagen sind die WLAN-Router von AVM. Während bereits die FRITZ!Box 7390 sämtliche Preise abräumte, ist auch das Nachfolgemodell FRITZ!Box 7490 wieder einmal Testsieger bei Stiftung Warentest (08/2014) und Computer Bild (05/2014) sowie Gewinner des Connect Community Award 2015. Natürlich gibt es auch diverse vergleichbare Geräte anderer Hersteller, aber nicht umsonst haben AVM-Produkte neben dem Berliner Kultstatus auch einen hohen Absatz und erfreuen sich großer Beliebtheit. Sie sind einfach, praktisch und technisch immer auf dem neuesten Stand. Insofern kann man tatsächlich behaupten, wer eine Fritz!Box sein Eigen nennt, besitzt die Nummer Eins unter den WLAN-Routern.

Für den durchschnittlichen Bedarf eines modernen Heimnetzwerkes ohne Kabel hat man mit diesem Router den entsprechenden WLAN-Accesspoint, eine kostenlose Firewall und natürlich eine vollwertige Telefonanlage. Der Hersteller verspricht mit seinem Modell 7490 rasante Verbindungen auf Highspeed-Niveau. Die Hardware wurde komplett überarbeitet und den neuen Standards angepasst. Neben USB-3.0 und Giga-LAN sorgt die neue WLAN-AC-Technologie mit zwei Funkbändern für drei Mal so schnelle Geschwindigkeit und optimale Einbindung aller Geräte. Mit dem aktuellen FRITZ!OS-Betriebssystem werden vor allem in punkto Sicherheit regelmäßige Updates durchgeführt. Diese sind genauso kostenlos wie die Apps, über die man auch mobil über das Smartphone etc. auf seine Daten zugreifen kann. Unliebsame SPAM-Nummern können jederzeit gesperrt und sogar die Webcam kann von unterwegs gesteuert werden. Es ist also weit mehr drin in dieser kleinen Box, als nur der Weg ins Internet, und zwar für alle kabelgebundenen Internetvarianten und via Satellit.

Abbildung 302: FRITZ!Box 7490 von AVM (www.avm.de)

Wer nicht das Glück hat und über einen Internetanschluss „aus der Dose“ verfügt, der kann sich mit diversen LTE-Geräten ein Heimnetzwerk schaffen. Auch wenn das Internet via Funksignal nicht mit einem Festnetz- oder Kabelanschluss mithalten kann, bieten sie doch zumindest eine Alternative. Der Hardware-Anbieter AVM verspricht mit seiner FRITZ!Box 6842 LTE auf Basis der sogenannten Triband-Technologie sogar Highspeed-Internet mit einer maximalen Downloadgeschwindigkeit von 100 MBit/s. Auch ohne Festnetzanschluss kann über die kleine Box telefoniert werden, denn sowohl ISDN-Schnurlostelefone als auch die analoge Variante finden hier Anschluss.

Abbildung 303: FRITZ!Box 6842 LTE (www.avm.de)

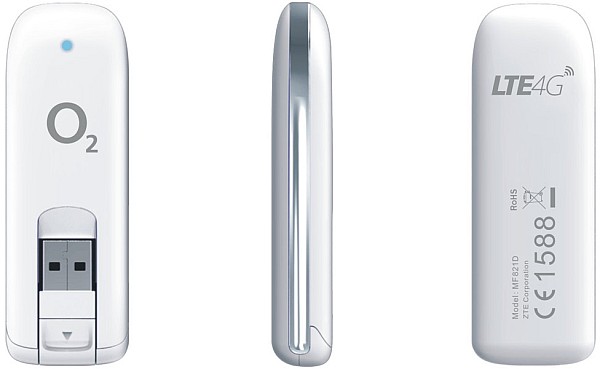

LTE-Router benötigen für den Weg ins Internet also kein Kabel, dafür aber eine SIM-Karte. Die üblichen Provider (z.B. Vodafone, Telekom oder O2) bieten im Rahmen ihrer Tarife auch entsprechende Hardware an. Neben dem klassischen Router gibt es im Übrigen auch Hybrid-Modelle, die DSL und LTE vereinen. Zwei weitere Möglichkeiten, um über LTE ins Netz zu kommen, bieten Surf-Sticks und WLAN-Hotspots.