Grundlagen der Wahrnehmung

Fakt ist: Selbst die beste Technik sucht seinesgleichen in der Natur. Das menschliche Auge ist in seiner Perfektion kaum zu übertreffen und arbeitet (sofern gesund) mit exakter Präzision und damit schärfer, schneller und sensibler als jedes vom Menschen geschaffene Gerät. Nicht umsonst wurden von jeher optische Apparate dem komplexesten aller Sinnesorgane nachempfunden. Wie in einem Uhrwerk sind alle Bestandteile akkurat aufeinander abgestimmt, damit im Bruchteil einer Sekunde aus reflektiertem Licht ein Bild entsteht. Auch die Fernsehtechnik baut auf diese geniale Technologie auf. Um zu verstehen, wie eine Bildröhre, hochauflösendes Fernsehen oder gar 3D funktioniert, sollte man sich zuvor mit dem menschlichen Auge, der Wahrnehmung generell und mit einigen im Zusammenhang stehenden physikalischen Gesetzmäßigkeiten der Optik näher befassen.

Das menschliche Auge

Grundsätzlich arbeitet das menschliche Auge wie ein Fotoapparat – oder vielmehr umgekehrt. Die Gemeinsamkeiten der „Bauteile“ sind in jedem Fall nicht von der Hand zu weisen. Ähnlich wie bei einer Kamera verfügt ihr natürliches Vorbild über ein Linsensystem (Objektiv), einen optischen Zoom, eine Blende und natürlich über einen leistungsstarken Prozessor: das menschliche Gehirn.

Aufbau

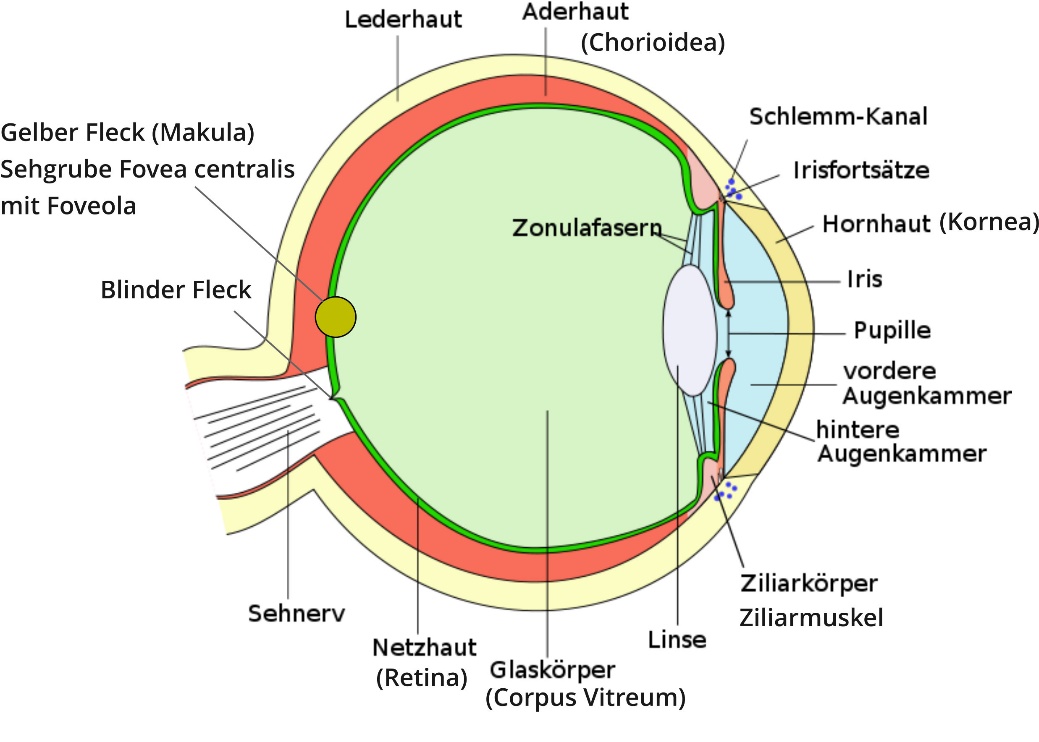

Zu den wichtigsten Bestandteilen des menschlichen Auges (vgl. Abbildung) gehören die Hornhaut (Kornea), Pupille, Iris, Linse, Netzhaut (Retina) sowie der Ziliarmuskel, Sehnerv und der Glaskörper (Corpus Vitreum). Dieser ist vielmehr ein Glaskörpergel beziehungsweise eine gelartige Substanz, die zu einem überwiegenden Teil aus Wasser sowie gleichmäßig verteilten Eiweißbestandteilen und feinsten Bindegewebsfasern besteht. Umgeben ist der Glaskörper von einer sehr dünnen Membran, die im vorderen Teil des Auges die Linse und seitlich die innerste Schicht der Augapfelwand (Netzhaut) unregelmäßig berührt. An der Netzhautmitte sowie im Bereich des Sehnervs und der äußeren Netzhautperipherie (Glaskörperbasis) bestehen hingegen regelmäßige Anheftungen zwischen dem Glaskörper und der Netzhaut.

Letztgenannte wird im Augenhintergrund von der Aderhaut (Chorioidea) umgeben, die für die Durchblutung des Auges und dessen Nährstoffversorgung zuständig ist.

Abbildung 3: Aufbau des menschlichen Auges

Photorezeptoren und Netzhaut

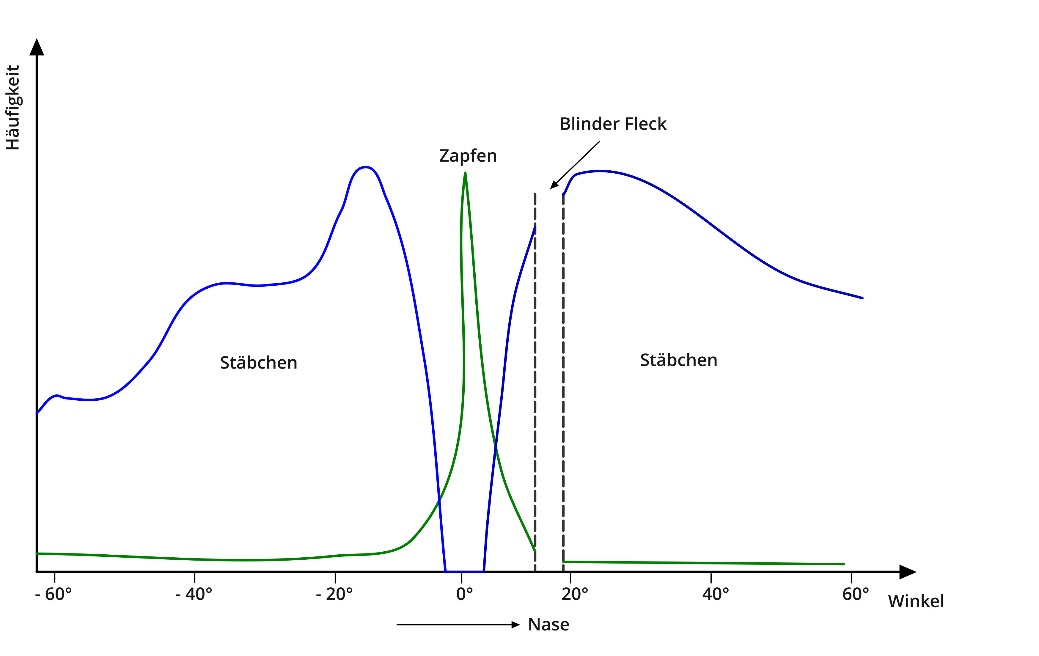

Die Netzhaut besteht aus Millionen lichtempfindlicher Sinneszellen (Zapfen und Stäbchen). Im Zentrum des sogenannten Gelben Flecks (Makula lutea) befindet sich eine Einsenkung, die in etwa 1,5 mm im Durchmesser beträgt und Fovea centralis (Sehgrube) genannt wird. An dieser Stelle des schärfsten Sehens in der Netzhautmitte konzentrieren sich die sogenannten Zapfen, die für das Scharfsehen zuständig sind und bei hohen Leuchtdichten (L > 10 cd/m2) als Rezeptoren zur Helligkeits- und Farbwahrnehmung dienen. Die Stäbchen sind dagegen mehr im Randbereich der Netzhaut zu finden. Aufgrund ihrer hohen Lichtempfindlichkeit übernehmen sie das Dämmerungssehen, da sie auch schwache Leuchtdichten (bis 0,08 cd/m2) registrieren können. Ab einer Leuchtdichte unter diesem Wert sind Farbunterscheidungen nicht mehr möglich (Nachtsehen). Die Netzhaut beziehungsweise ihre Rezeptoren sind insofern die Basis für unsere Sehfähigkeit und vergleichbar mit der Auflösungsqualität einer Digitalkamera.

Adaption

Im nicht-sichtbaren Teil des Auges wird selbiges durch die Lederhaut (Sklera) und im vorderen (sichtbaren) Teil durch die Hornhaut (Kornea) geschützt. Hier befindet sich die Pupille, durch die das Licht ins Auge fällt und die deshalb wie eine Blende wirkt. Je nach Intensität des Lichteinfalls kann sie sich verkleinern (hell) oder vergrößern (dunkel). Während dieses Anpassungsvorgangs, der als Adaption bezeichnet wird, kann sich der Pupillen-Durchmesser von 1,5 bis 8 Millimeter verändern.

Akkomodation

Den farblich individuellen Teil unseres Auges bildet die Iris, die umgangssprachlich auch Regenbogenhaut genannt wird. Direkt dahinter befindet sich die Augenlinse (Lens crystallina), die in ihrem Zentrum zirka vier Millimeter dick und im Durchmesser zwischen sechs und acht Millimeter groß ist. Die Linse ist nach außen (konkav) gewölbt und ebenfalls von einer feinen Membran umgeben sowie links und rechts jeweils mit dem Ziliarmuskel verbunden. Mithilfe dieses Muskels, der vom Gehirn gesteuert wird, kann die Linse ihre Form verändern. Dadurch ist sie in der Lage, das einfallende Licht unterschiedlich zu brechen. Je nachdem, wie weit der abzubildende Gegenstand entfernt ist, verformt sich die Linse, um das Abbild auf der Netzhaut „scharf“ zu stellen. Diese unterschiedliche Brechung beziehungsweise Bündelung des Lichtes (Akkomodation) macht die Augenlinse vergleichbar mit einem Kameraobjektiv.

Sehnerv

Den wohl kompliziertesten Bestandteil des menschlichen Auges bildet der Sehnerv. Er ist quasi die Datenleitung, über die alle Informationen von der Netzhaut an das Gehirn weitergegeben werden. Der Sehnerv besteht aus bis zu 1,2 Millionen Nervenfasern. Direkt neben der Fovea centralis – also der Stelle des schärfsten Sehens in der Netzhautmitte - tritt der Sehnerv aus dem Auge (Sehnervenkopf = Papille). Diese Stelle wird als blinder Fleck bezeichnet.

Abbildung 4: Funktionsweise des Auges (Zapfen/Stäbchen)

Fovea centralis

Von uns weder bewusst gesteuert noch wahrgenommen, erfassen wir unsere Umgebung durch permanentes Abtasten mithilfe der Fovea centralis. Wie auf dem Film in einer Kamera wird das in der Außenwelt reflektierte Licht durch Hornhaut, Pupille, Linse und Glaskörper geleitet und im Augeninneren auf der Netzhaut gebündelt. Die Lichtenergie wird anschließend in Nervenreize umgewandelt, die vom Gehirn zu einem Bild weiterverarbeitet werden. Für jede neue Blickrichtung akkommodiert oder adaptiert sich das Auge während des Abtastvorgangs jeweils neu. Das heißt, die natürliche Blende und das natürliche Objektiv im Auge regeln gemeinsam mit Millionen lichtempfindlicher Nervenzellen die Bildschärfe, die Farbe und den Kontrast. Allerdings läuft ohne Schaltzentrale gar nichts. Erst mithilfe unseres Gehirns sind wir in der Lage, aus der Flut von Lichtwellen und Reizen einen optischen Gesamteindruck zu bilden.

Das Licht: mehr als elektromagnetische Wellen

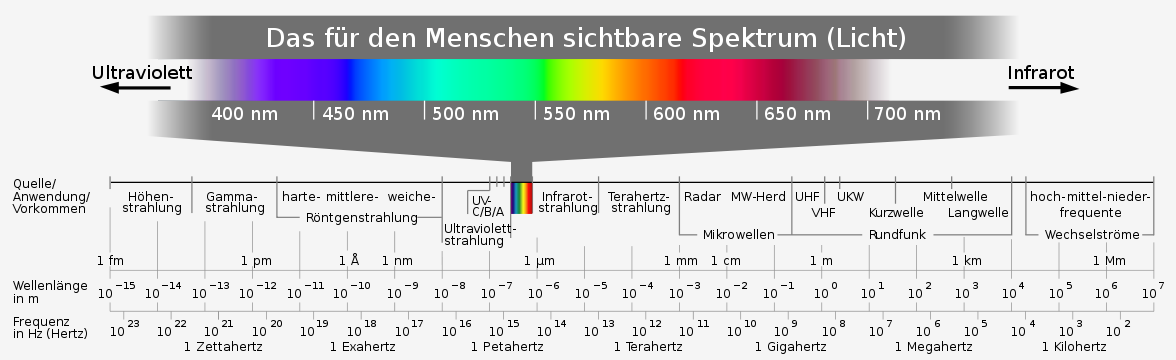

Und obwohl das menschliche Auge ein wahrer Meister seines Faches ist, kann es nur einen geringen Teil des elektromagnetischen Spektrums, nämlich ausschließlich das Lichtspektrum zwischen 380 und 780 Nanometern, visuell wahrnehmen. Die visuelle Wahrnehmung einiger Tiere ist hingegen besser ausgeprägt. So können beispielsweise Schlangen im Infrarotbereich und Insekten sogar ultraviolettes Licht erfassen (vgl. Abbildung). Dennoch ist es nur dem Menschen vergönnt, aufgrund seiner Gehirnkapazität aus dem vergleichbar minimalen Spektralbereich eine Vielfalt an Farben zu erkennen, zu verarbeiten und Großartiges zu schaffen – von zeitgenössischer Malerei bis hin zu ultrahochauflösender Videodarstellung.

Abbildung 5: Elektromagnetisches Spektrum

Denn streng genommen ist Farbe nichts anders als Licht - und Licht wiederum eine elektromagnetische Welle. Wie stark das menschliche Auge Helligkeit empfindet, hängt insofern von der Wellenlänge ab. Der Nachweis hierzu wurde bereits im 19. Jahrhundert von den Physikern James Maxwell und Heinrich Hertz erbracht. Neben dem Licht gehören auch Radio- und Mikrowellen zu den Wellen eines elektromagnetischen Feldes, allerdings sind diese für das menschliche Auge nicht sichtbar (vgl. Abbildung). Dies liegt an den unterschiedlichen Wellenlängen beziehungsweise deren Frequenz. So können wir beispielsweise Radiofrequenzen im Bereich zwischen 87.5 und 108.0 Megahertz hören aber nicht sehen.

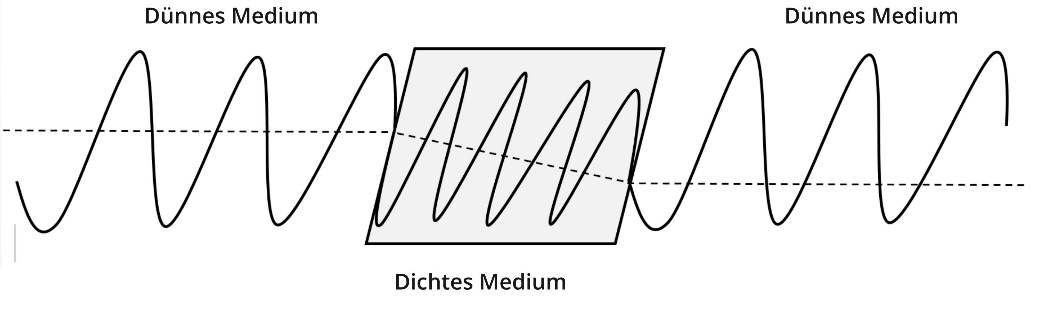

Licht breitet sich wellenförmig aus. Dabei beträgt die Ausbreitungsgeschwindigkeit im Vakuum c = 2,998 . 108 m/s, besser bekannt als Lichtgeschwindigkeit. Da bekanntermaßen in unserer Umwelt kein Vakuum herrscht, ist also das Licht als elektromagnetische Welle in seiner Ausbreitung von der Umgebung abhängig. Einen treffenden Vergleich bietet das Meer. Hier breitet sich das Wasser wellenförmig aus beziehungsweise wird durch bestimmte Objekte daran gehindert (z.B. Wellenbrecher). Trifft also das Licht auf verschiedene Körper, verändert sich sein Brechungsindex.

Abbildung 6: Schematische Darstellung der Lichtbrechung

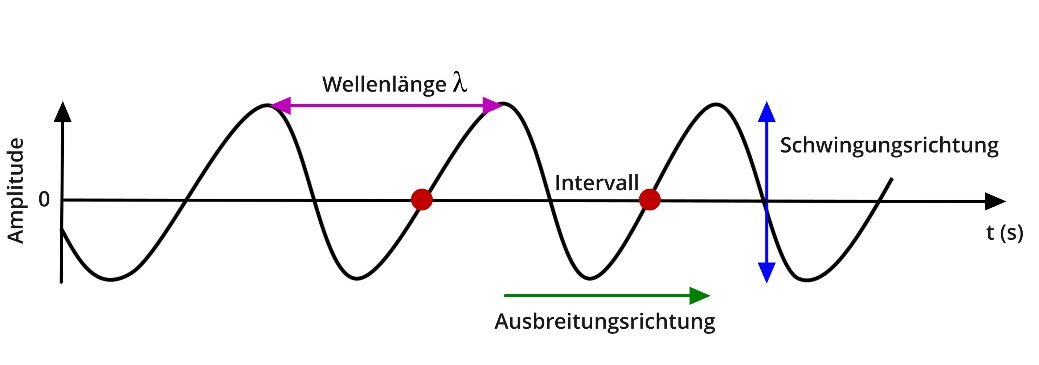

Die hier dargestellte Wellenform wiederholt sich in regelmäßigen Abständen in Zeit und Raum. Die Periodendauer beschreibt dabei die Zeitspanne einer Welle (Intervall). Die Anzahl der einzelnen Perioden pro Sekunde werden als Frequenz bezeichnet. Die räumliche Ausbreitung des Lichtes (Periode) wird durch die Wellenlänge λ gekennzeichnet. Die Ausbreitungsgeschwindigkeit einer Welle wird in der Wissenschaft wie folgt berechnet: c = λ . f.

Reflexion und Remission

In Zusammenhang mit der Beschreibung des Lichtes tauchen immer wieder Begriffe wie Reflexionsgrad und Remissionsgrad auf, welche gern verwechselt werden. Bei der regulären (gerichteten) Reflexion handelt es sich in der Physik um den Vorgang, bei dem eine Welle an eine Grenzfläche zurückgeworfen wird, sich also die Ausbreitung oder der Brechungsindex ändert. Der Reflexionsgrad beschreibt demnach das Verhältnis zwischen reflektierter und einfallender Intensität des Lichtstroms beziehungsweise in welcher Form die Ausbreitung der elektromagnetischen Welle gestört wird. Das einfachste Beispiel ist wohl der Spiegel: er lässt kein Licht durch, sondern wirft es zurück. Deshalb spielt im Wesentlichen die Oberflächenbeschaffenheit der Objekte, auf die das Licht trifft, eine Rolle.

Mit dem Wort „remittieren“ (lat. remittere) ist hingegen das Zurücksenden gemeint oder vielmehr eine diffuse (ungerichtete) Reflexion von Körpern, die nicht selbst leuchten. Dabei absorbiert ein Körper oder Objekt einen Teil des Lichtspektrums (Opazität). Insofern beschreibt der Remissionsgrad das Verhältnis zwischen remittiertem und eingestrahltem Licht. Der Prozentsatz gibt demnach an, wie viel des eingestrahlten Lichts tatsächlich „übrig“ bleibt. Diese Angabe nennt man auch Albedo-Wert1. Im Kapitel „Farbwahrnehmung“ wird hierauf noch einmal gesondert eingegangen. Einige Beispiele für verschiedene Materialien und ihre individuellen Remissionsgrade finden sich in der folgenden Tabelle:

|

Schnee (frisch) |

93 … 97 % |

Normalgrau (Fotokarte) |

18 % |

|

weißes Hemd |

80 … 90 % |

Mauerwerk |

10 … 15 % |

|

weißes Papier |

60 … 80 % |

schwarzes Papier |

5 … 10 % |

|

helle Haut |

25 … 35 % |

matte schwarze Farbe |

1 … 5 % |

|

grüne Blätter |

15 … 30 % |

schwarzer Samt |

0 % |

Abbildung 7: Remissionsgrade verschiedener Materialien

Bei transparenten Körpern oder Medien wird das Licht hingegen transmittiert. Dabei findet für die sogenannte Durchlichtmessung der Transmissionsgrad τ(λ) Verwendung, bei dem der farbige lichtfilternde Effekt gegen einen nichtfilternden Effekt gemessen wird (Kolorimetrie). Auch diese Größe ist (ähnlich wie auch der Remissionsgrad) nach dem Bouguer-Lambert-Beerschen Gesetz2 wellenlängenabhängig. In diesem Zusammenhang ist die Leuchtdichte ein erwähnenswerter Aspekt, der allerdings im Kapitel über die fotometrischen Größen ausführlich dargestellt werden soll.

Abgesehen von der Physik bietet das Licht jedoch weitaus mehr als nur Schwarz oder Weiß, Hell und Dunkel. Es kann auch unser Empfinden in starkem Maße beeinflussen. Dabei spielen nicht nur die wärmende Sommersonne und die dadurch produzierten Glückshormone eine Rolle. Wahrnehmungsstörungen und sogar körperliche Symptome hängen unmittelbar mit dem Licht zusammen. So kann das Licht visuellen Stress hervorrufen. Streifen- oder Gittermuster, flackerndes Neonlicht, gleichmäßig bewegte Objekte oder auch dreidimensionale Projektionen können Wahrnehmungsstörungen, Übelkeit oder gar epileptische Anfälle verursachen.

Doch diese vermeintlichen Nachteile bergen auch die vielfältigen Möglichkeiten, die unser Sehvermögen bietet: Das Licht, das in unserer Umwelt von allen Objekten reflektiert, absorbiert oder transmittiert wird, nehmen wir in seiner Gesamtheit wahr. Damit ist es uns möglich, Oberflächen auch bei unterschiedlicher Leuchtkraft gleichmäßig zu erkennen. Unser Gehirn differenziert das Licht und wandelt es um in Bilder mit unterschiedlicher Intensität, Farbe und Schärfe.

Dabei spielt die tatsächliche physikalische Größe des Lichtes in unserer Wahrnehmung nur eine nachgeordnete Rolle. Ein gutes Beispiel dafür sind die Sterne. Sie verändern grundsätzlich nicht ihre Leuchtkraft, doch bei Tag sehen wir sie gar nicht, in einer „sternenklaren“ Nacht dafür umso deutlicher. Selbst wenn die Sichtverhältnisse am Himmel – etwa zur selben Uhrzeit bei ähnlichen Witterungsverhältnissen - identisch sind, können wir dieselben Sterne an einem dunklen Strand trotzdem um einiges besser wahrnehmen, als im Lichtkegel einer Großstadt. Insofern sind weder die Licht absorbierenden Objekte selbst noch die Funktionalität unserer Augen per se dafür verantwortlich, wie genau wir sehen können. Es sind Faktoren der Umwelt (z.B. Umfeldbeleuchtung), die erst eine exakte Wahrnehmung möglich machen.

Ob nun in tiefschwarzer Nacht oder im Licht eines 1000-Watt-Halogenstrahlers: unsere Augen können sich grundsätzlich an die verschiedensten Lichtintensitäten anpassen. Differenzen in den Lichtverhältnissen kompensiert die Pupille durch Verengung oder Erweiterung (Adaption) sowie die Veränderung der Sensitivität der weiter oben beschriebenen Rezeptoren. Im Allgemeinen können 500 verschiedene Helligkeitswerte unterschieden werden, bei einem klassischen TV-Bildschirm sind es immerhin noch 200. Trotz hochentwickelter Technologien sind die Unterschiede zwischen einem künstlichen Display und dem Original in der Natur nach wie vor erheblich – auch wenn die nativen 4K-Auflösungen und die aufblühenden HDR-Technologien dichter dran sind als je zuvor.

Polarisation

Ein weiteres Beispiel für die Vielfalt es Lichtes ist die Polarisation. Das Licht als elektromagnetische Welle ist gleichzeitig eine sogenannte Transversalwelle, deren Amplitude senkrecht zur Ausbreitungsrichtung steht (vgl. Abbildung).

Abbildung 8: Schematische Darstellung einer Transversalwelle

Dabei beschreibt die Polarisation die Richtung der Schwingung. Wenn aus einem Mix verschiedener Polarisationsrichtungen eine bestimmte Richtung herausgefiltert wird, entsteht polarisiertes Licht. In der Natur findet man ein solches Licht bei der Reflexion an metallischen Oberflächen oder bei doppelbrechenden Kristallen. In der Technik (Leinwandprojektoren, Displays) wird sich mit Polarisationsfolien oder -filtern beholfen, um die Intensität der Strahlteilung zu beeinflussen. Praktische Information hierzu finden sich in den Kapiteln „Räumliche Wahrnehmung“ und „Heimkinoprojektoren“.

Kontrast und Schärfe

Jeder Lichtstrahl, der auf das Auge trifft, führt zu einem neuronalen Reiz. Da hierfür mehr Rezeptoren als Neuronen zur Verfügung stehen, kann eine Nervenfaser im Sehnerv (Nervus Opticus) von mehreren Rezeptoren „erregt“ werden. Das heißt, dass jede Nervenzelle (Ganglienzelle) im Sehnerv beziehungsweise jedes Projektionsneuron der Netzhaut gebündelte Informationen aus ungleich vielen Rezeptoren als Impulse an das Gehirn weiterleiten kann (106 Mio. Rezeptoren, 1 Mio. Ganglienzellen). Dieser Vorgang wird als rezeptives Feld bezeichnet, es ist also der Bereich einer Nervenzelle, an die Photorezeptoren ihre Informationen senden.

Wie bereits beschrieben, befinden sich die lichtempfindlichen Stäbchen (Photorezeptoren) außerhalb des Bereiches für das Scharfsehen (Fovea centralis) also mehr im Randbereich der Netzhaut. Die Lichtempfindlichkeit der Stäbchen wird nunmehr durch das rezeptive Feld (Überzahl an Rezeptoren) begünstigt. Dies führt dazu, dass am Rand des menschlichen Sichtfeldes – also aus den Augenwinkeln - schwach beleuchtete aber auch schnell bewegte Objekte zwar relativ unscharf, dafür aber mit einer hohen Bewegungsauflösung wahrgenommen werden können. Ein Grund dafür, warum wir bei einem Röhrenfernseher das Bildflimmern stärker aus dem seitlichen Blickwinkel als bei frontaler Ansicht erkennen können. Die geschwungenen Bildschirme, die unter der Bezeichnung Curved-TV spätestens seit 2015 den Mainstream erobert haben, zielen auf diesen Umstand ab.

Kontrast

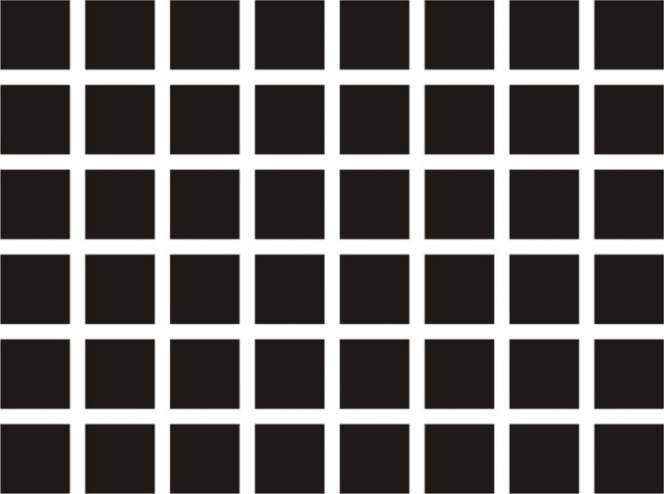

Das rezeptive Feld bewirkt allerdings noch weitere Phänomene. Es ist veränderlich und kann sich bei parallel auftretenden Reizen in einen Bereich der Erregung und in einen weiteren Bereich der lateralen Hemmung unterteilen (On-/Off-Zentrum). Das bekannte Hermann-Gitter3 (vgl. Abbildung) veranschaulicht, welche massive neuronale Informationsverarbeitung in unserem visuellen System beim bloßen Anblick eines solchen Gitters ausgelöst wird.

Abbildung 9: Hermann-Gitter

In den Zwischenräumen der schwarzen Quadrate werden weitere graue Vierecke wahrgenommen, die tatsächlich gar nicht vorhanden sind. Fixiert man einen Punkt, so verschwindet hier die Täuschung, bleibt allerdings im übrigen Bereich bestehen. Zu diesem Wahrnehmungseffekt kommt es durch ebenjene Wechselwirkung zwischen Erregung und Hemmung, die die „Feuerrate“ des jeweiligen Neurons erhöht.

Während die Peripherie des rezeptiven Feldes in den Bereich der schwarzen Quadrate fällt, wird diese nur schwach belichtet. Die sogenannte Hemmung ist also gering, die Zwischenräume erscheinen hell. An den Schnittpunkten der hellen Zwischenräume (Kreuzungsstellen) ist mehr Licht in der Peripherie, also eine größere Hemmung vorhanden. Die Kreuzungsstellen erscheinen dunkler und werden von ebenjenen (imaginären) grauen Vierecken überlagert.

Das menschliche Auge ist demnach damit befasst, zwei verschiedene Impulse aufzunehmen und zu verarbeiten. Nach dem französischen Physiker und Mathematiker Jean-Baptiste Joseph Fourier lässt sich ein zweidimensionales Abbild als Funktion der Helligkeit gegen den Ort interpretieren, der sogenannten räumlichen Frequenz oder auch Ortsfrequenz (Formelzeichen k oder R). Örtlich veränderliche Funktionen liefern die Grundlage für wissenschaftliche Erkenntnisse gemäß der Fourier-Optik und nicht zuletzt für die sogenannten Bildkompressionsalgorithmen (beispielsweise JPEG), die in der digitalen Technik unabdingbar sind.

Ortsfrequenz

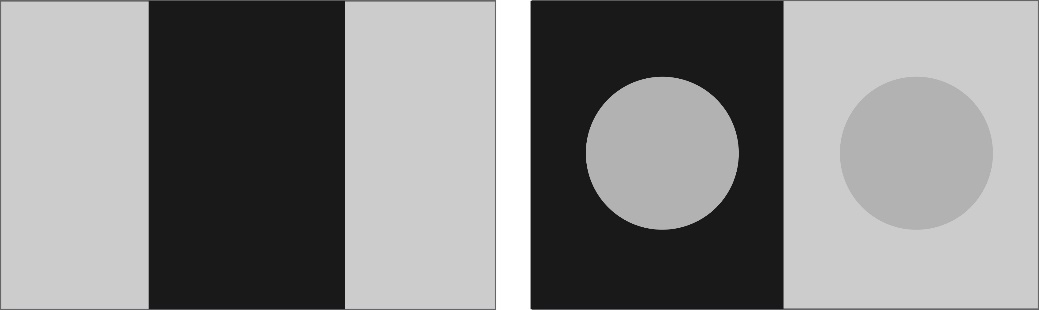

Die Ortsfrequenz bezeichnet in der Wahrnehmungspsychologie die Anzahl der Kanten pro Grad Sehwinkel. Hierbei unterscheidet man die niedrige Ortsfrequenz, bei der Bilder unscharf und flächig wirken (Tiefpass), und Bilder mit hoher Ortsfrequenz (Hochpass), die detailreich und scharf konturiert sind. Dies ist der Grund, warum die in der folgenden Abbildung (links) dargestellten Graukanten an den Übergängen subjektiv schärfer wahrgenommen werden. Ebenso wirkt in der Abbildung (rechts) der graue Kreis vor dem dunklen Hintergrund schärfer beziehungsweise heller als der gleiche Kreis im hellgrauen Rechteck daneben.

Abbildung 10: Graukanten (links) und Simultankontrast (rechts)

Im visuellen System unseres Gehirns (visueller Cortex oder Sehrinde) sind bestimmte Neuronen darauf spezialisiert, die Ortsfrequenz eines Bildes zu analysieren. Das sogenannte „retinotope“ Areal 17 (Area striata) der menschlichen Großhirnrinde ist dafür zuständig, dass nebeneinander abgebildete Punkte auf der Retina (Netzhaut) auch tatsächlich parallel liegen. Die Fovea, als Zentrum des Scharfsehens, ist hier überproportional gefordert.

Abbildung 11: Vertikal verlaufende Streifenmuster

Bei einer optimalen Funktionalität des Auges kann eine Rasterung von bis zu neun Linienpaaren (vgl. Abbildung) pro Grad Sehwinkel erkannt werden. Steigt die Frequenz (also der Wechsel zwischen hellen und dunklen Linien), sinkt der empfundene Kontrast proportional. Bei 36 Linienpaaren pro Grad beträgt dieser nur noch zehn Prozent. Bei Beeinträchtigung der Sehschärfe verschwimmen die Konturen schneller, bei Bewegtbildern können sie ganz verschwinden - z.B. die Speichen bei einem sich drehenden Rad.

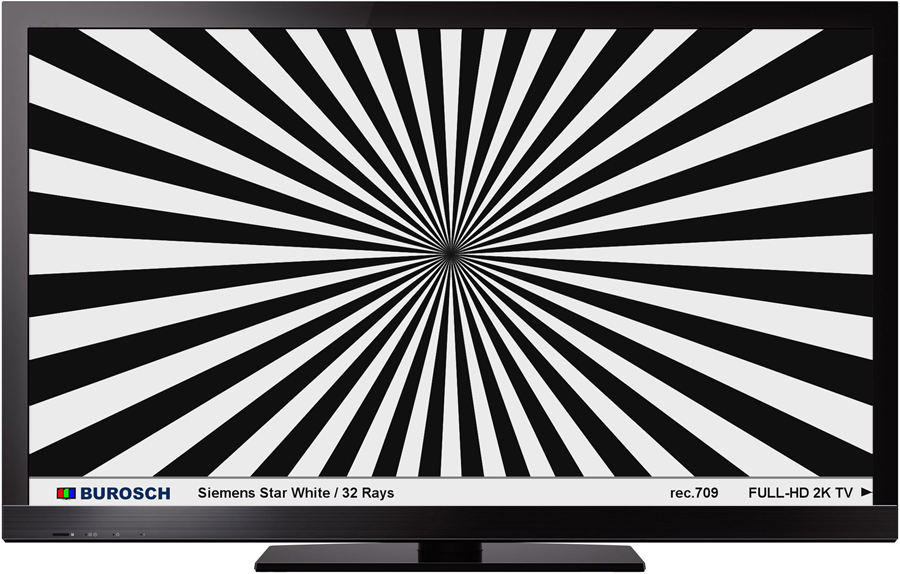

Abbildung 12: Siemensstern (www.burosch.de)

Der in obiger Abbildung dargestellte Siemensstern wurde mit einem Tiefpass gefiltert und verfügt über die maximale Ortsfrequenz von zirka 330 Linienpaaren pro Bildhöhe. Die Details in der Mitte des Bildes gehen dabei komplett verloren, während nach außen hin die Kanten breiter wirken.

Die Kontrastwahrnehmung hängt insofern von der Genauigkeit des menschlichen Sehvermögens (Sehschärfe) ab. Dieser sind allerdings Grenzen gesetzt, bis zu denen feine Details in Mustern beziehungsweise Objekten bei hohem Kontrast unterschieden werden können. Der Zahlenwert des Auflösungsvermögens des menschlichen Auges (anguläre Sehschärfe) ist der Kehrwert des kleinsten auflösbaren Sehwinkels, der in Winkelminuten angegeben wird.

Sehschärfe

Die sogenannte Sehschärfe ist nicht einfach nur die Feineinstellung eines Bildes. Sie unterscheidet sich im Allgemeinen in vier verschiedene Formen in Abhängigkeit von der Art, Anzahl und Qualität der wahrgenommen Objekte.

Punkt-Sehschärfe: Hierbei handelt es sich um das Erkennen eines Einzelpunktes ohne Trennung oder Beurteilung der Relativposition von zwei Objekten (1 Bogenminute = 1/60°).

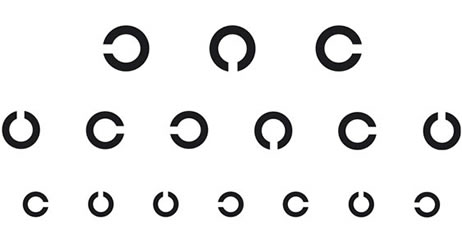

Gitter-Sehschärfe/Auflösungs-Sehschärfe: Hier werden die Abstände zwischen zwei Objekten erkannt und verknüpft, wobei bestimmte Leuchtdichteunterschiede zwischen Objektstrukturen (hell/dunkel) erkannt werden. Das menschliche Auge nimmt also Balken- oder Gittermuster und keine grauen Flächen wahr (1-2 Bogenminuten). Dabei bestimmt die Ortsfrequenz, in welchem Maße eine solche Balken- oder Gitterstruktur erkannt werden kann.

Buchstaben-Sehschärfe/Erkennungs-Sehschärfe: Diese Methode zur Bestimmung der Sehschärfe ist vor allem vom Augenarzt oder Optiker bekannt, wird deshalb im klinischen Sprachgebrauch auch als „Visus“ bezeichnet und definiert sich über den kleinsten Winkel, unter dem ein Objekt in seiner Form erkannt werden kann (5 Bogenminuten).

Für einen solchen Test zur Erkennungsschärfe (vgl. Abbildung) werden im Allgemeinen Buchstaben, Zahlen oder sogenannte Landolt-Ringe4 verwendet. Bei der letztgenannten Methode muss die richtige Lage der Lücke erkannt werden.

Abbildung 13: Landolt-Ringe: Test zur Sehschärfe

Stereo-Sehschärfe/Lokalisations-Sehschärfe: Grundsätzlich können Objekte in räumlicher Tiefe von beiden Augen gleichzeitig wahrgenommen werden (Binokularsehen). Hierzu zählt in einer ersten Stufe das Simultansehen, also die gleichzeitige Wahrnehmung über das linke und das rechte Auge (10 Bogensekunden). Werden die Bilder, die von beiden Augen erkannt werden, zu einem einzigen Bild verschmolzen, wird dies in einer zweiten Stufe als Fusion bezeichnet. Die höchste Stufe des Binokularsehens ist das räumliche Sehen (Stereopsis).

Räumliche Wahrnehmung (3D)

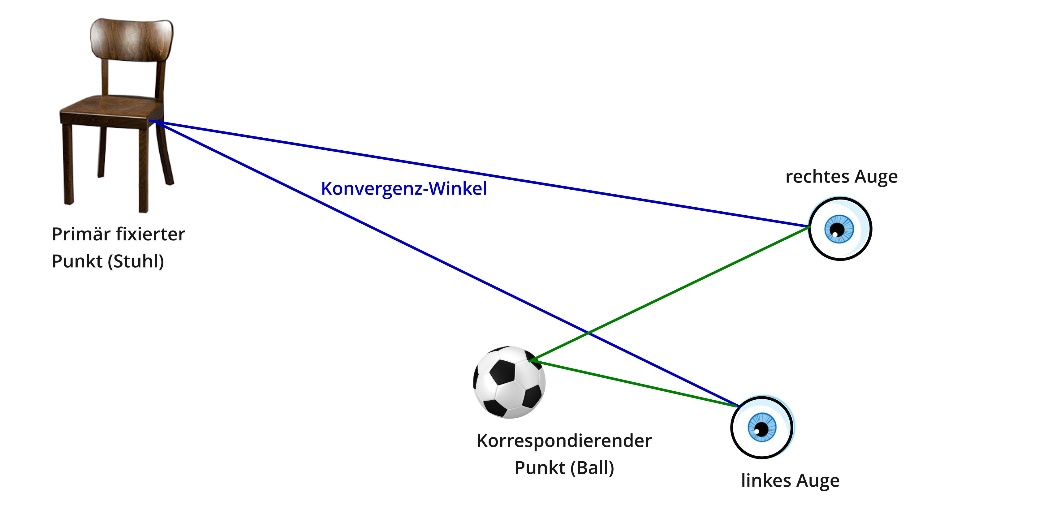

Anders als bei Tieren ist der Mensch besser in der Lage, seine Umwelt in der Höhe, der Breite und der Tiefe – also in drei Dimensionen – zu erfassen. Dabei ist das oben beschriebene binokulare Sehen Grundvoraussetzung für die Tiefenwahrnehmung. Der Abstand unserer Augen beträgt durchschnittlich 65 Millimeter. Fixiert man einen Punkt in einer gewissen Entfernung, kann somit die Perspektive des linkes Auges nicht hundertprozentig dieselbe des rechten Augen sein. Allerdings ist unser Gehirn in der Lage, beide Ansichten zu fusionieren, sodass nicht zwei einzelne Bilder, sondern nur ein Gesamtbild erkannt wird.

Aber selbst mit einem Auge kann bereits die Tiefe eines Raumes wahrgenommen werden. So erscheinen Objekte in weiter Entfernung kleiner oder aber eine Linie verjüngt sich mit zunehmendem Abstand (monekulares Sehen). Sind beide Augen gleichzeitig aktiv (binokulares Sehen), bilden die jeweiligen Blickachsen den sogenannten Konvergenzwinkel.

Neben dem primär fixierten Punkt beziehungsweise Gegenstand können weitere Objekte erkannt werden, welche als korrespondierende (gleichzeitig in Beziehung stehende) Punkte bezeichnet werden. Ein binokulares Merkmal im Zusammenhang mit der Tiefenwahrnehmung ist die sogenannte retinale Disparität. Unser Gehirn berechnet die relative Entfernung eines fixierten Objektes, indem es verschiedene Objekte miteinander in Relation stellt beziehungsweise vergleicht.

Abbildung 14: Binokulares Merkmal der Tiefenwahrnehmung: retinale Disparität

Gesichtsfeld

Tiere haben aufgrund der Lage und Beschaffenheit ihrer Augen nicht nur eine andere räumliche Wahrnehmung, auch die horizontale Ausdehnung des Gesichtsfeldes ist unterschiedlich. So kann beispielsweise ein Hund, deren Augen allgemein seitlich am Kopf liegen, etwa 240 Grad in der Breite sehen, während der Mensch nur ungefähr 180 Grad seiner horizontalen Umwelt wahrnimmt. Die dreidimensionale Wahrnehmung wiederum ist beim Menschen weitaus besser ausgeprägt (120 Grad) als beim Hund (60 Grad).

Die geringere Gradzahl der räumlichen Wahrnehmung ergibt sich unter anderem aus dem niedrigen vertikalen Betrachtungswinkel, der lediglich bei etwa 10 Grad liegt. Mit unserem relativ breiten Gesichtssinn können wir jedoch mehrere Gegenstände gleichzeitig wahrnehmen, auch wenn sich diese außerhalb unseres Blickwinkels befinden. Für die räumliche Feinanalyse eines Objektes ist die sogenannte binokulare Disparität verantwortlich, welche sich aus der Differenz der unterschiedlichen Blickwinkel ergibt. Wird ein Objekt innerhalb eines bestimmten Netzhautbereiches abgebildet, wandelt unser Gehirn es in ein Gesamtbild um.

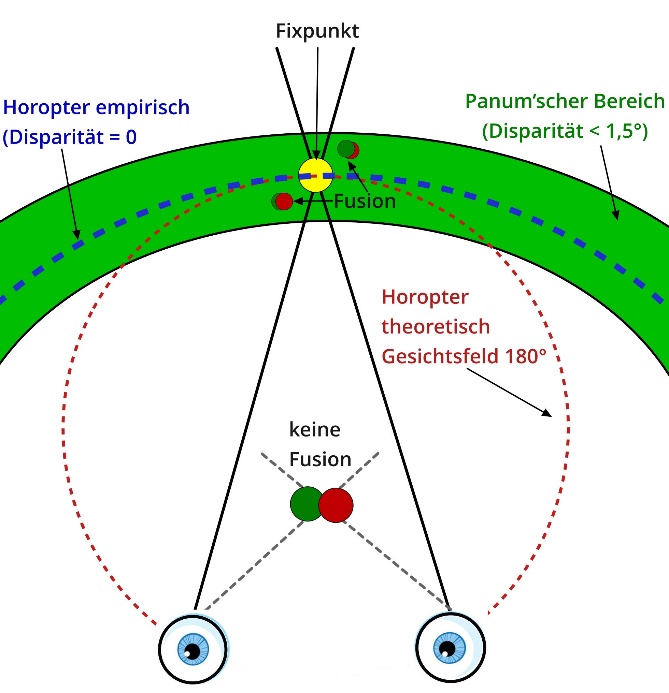

Diese Fusion kann allerdings lediglich im Bereich des binokularen Gesichtsfeldes (dem sogenannten Horopter oder genauer gesagt im Panum’schen Raum) vollzogen werden, also innerhalb der (grünen) Fläche, die in Relation zu dem in der folgenden Abbildung beschriebenen Fixpunkt steht. Die Disparität darf hier nicht mehr als 90 Bogenminuten beziehungsweise 1,5 Grad betragen, damit die Fusion gelingt. Objekte, die sich näher und weiter weg (also außerhalb dieser Fläche) befinden, können zwar ebenfalls erkannt, aber nicht fusionieren beziehungsweise direkt verknüpft werden.

In Bezug auf die 3D-Projektion bedeutet dies, dass die dreidimensional animierten Objekte sich innerhalb eines bestimmten Radius befinden müssen, damit wir sie entsprechend wahrnehmen können. Für die aktuellen Curved-TVs heißt es hingegen, dass unser Gesichtsfeld einem Winkel von 180 Grad entspricht, allerdings auch hier dennoch nur in der Mitte scharf sehen können, wenn wir geradeaus schauen, das heißt im unmittelbaren Umfeld eines fixierten Punktes.

Abbildung 15: Horopter und Gesichtsfeld (schematische Darstellung)

Ein weiterer Aspekt hierzu ist die bereits erörterte Beschaffenheit des menschlichen Auges. Objekte im äußeren Sichtfeld nehmen wir verschwommen wahr, was darauf zurückzuführen ist, dass sich der Bereich des Scharfsehens in der Mitte unseres Auges befindet. Nur wenn die Korrespondenz zwischen den dafür zuständigen Netzhautarealen intakt ist, kann die gleichzeitige und somit räumliche Abbildung eines fixierten Objektes auf den physiologisch identisch lokalisierenden Netzhautpunkten – die sogenannte Sehrichtungsgemeinschaft (retinale Korrespondenz) gelingen.

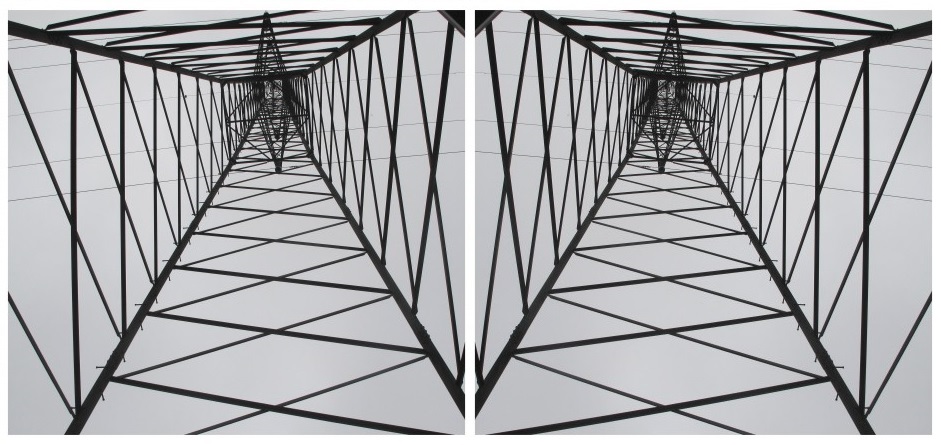

Die gespiegelte Darstellung in folgender Abbildung veranschaulicht die differenzierte Wahrnehmung des linken und rechten Gesichtsfeldes. Je nach Beschaffenheit und Funktionsweise des individuellen Sehvermögens können beide Bilder unterschiedlich erkannt werden, obwohl es sich um ein und dasselbe Foto handelt, das lediglich horizontal gespiegelt wurde. Gerade diese Form der Wahrnehmung oder aber ihre Einschränkung ist für die 3D-Projektion interessant, die im Folgenden erläutert wird. Für den Beweis der differenzierten Wahrnehmung kann ein simpler Selbsttest durchgeführt werden: Man sucht sich einen Punkt oder ein Objekt in unmittelbarer Nähe und kneift jeweils ein Auge zu. Sofort wird deutlich, dass der fixierte Punkt oder das Objekt nicht an derselben Stelle zu sein scheint. Dieses Phänomen bezeichnet man als parallaktische Verschiebung, bei der es sich per Definition um die Differenz (Abweichung) der unterschiedlichen Betrachtungswinkel auf einen Gegenstand handelt, die durch zwei unabhängige optische Systeme (z.B. Augen oder bestimmte Kameras) entstehen.

Abbildung 16: Beispiel für binokulares Sehens

Parallaxe

Aus dem parallaktischen Winkel, der sich aus den beiden Betrachtungsperspektiven ergibt, und dem Standort (Basislinie) kann die Entfernung zum fixierten Objekt bestimmt werden. Dabei gilt, je näher das Objekt beispielsweise vor den Augen ist, desto größer ist die Parallaxe – also die wahrgenommene Bildverschiebung. Was das menschliche Auge nur ungefähr schafft, wird in der Messtechnik präzise angewandt. Mit einem Sensor oder Messfernrohr ist es somit möglich, bestimmte Entfernungen nicht nur zu schätzen, sondern exakt zu messen.

Anwendung findet ein solches Verfahren vor allem in der Geodäsie (Messung der Erdoberfläche) und Astronomie aber auch bei Fotoapparaten. Als Basislinie und damit als Grundlage für die Distanzmessung von der Erde zum Mond dient beispielsweise der Erdradius. Der Mond ist es auch, der eine Parallaxe aufgrund seiner verhältnismäßig geringen Entfernung zur Erde besonders gut darstellt. Diese Mondparallaxe ist dafür verantwortlich, dass wir in Europa den Mond im Umfeld anderer Sterne betrachten, als wenn wir zum Beispiel in Südafrika in den Himmel schauen würden. Auch die differenzierte Wahrnehmung einer Sonnenfinsternis hängt (gemeinsam mit der Erdrotation) unmittelbar mit diesem Phänomen zusammen, das sowohl vertikal als auch horizontal auftritt.

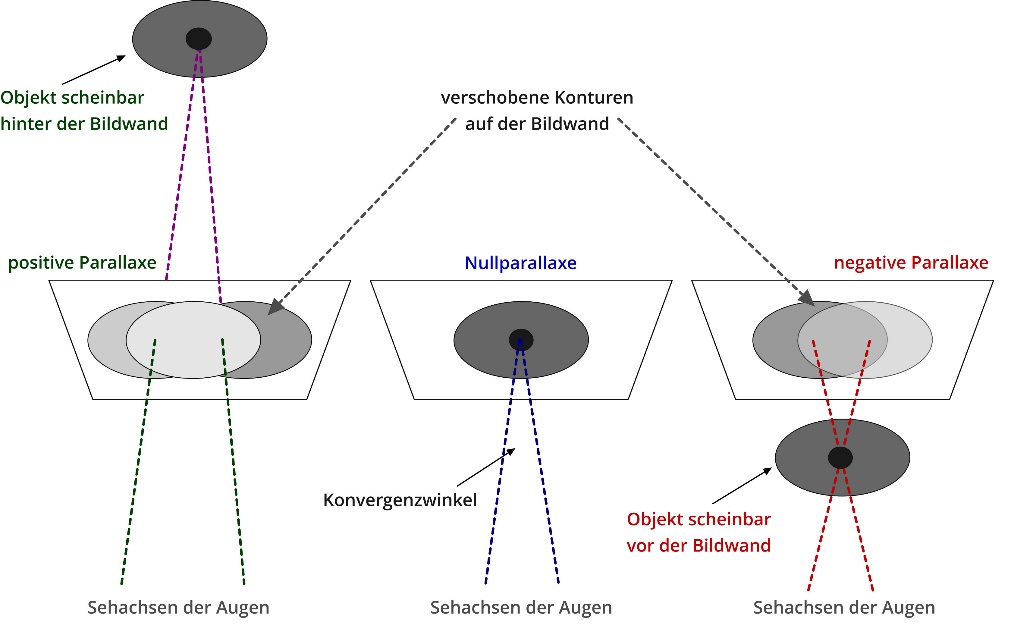

In der 3D-Technik wird der Begriff Parallaxe umgangssprachlich für den Unterschied zwischen dem linken und rechten Bild beziehungsweise für den Abstand korrespondierender Punkte in beiden Teilbildern verwendet. Im Weiteren sollen nun die vier Fälle einer Parallaxe mithilfe der folgenden Abbildung erläutert werden.

Abbildung 17: Schematische Darstellung einer Parallaxe

Null-Parallaxe

Bei dem auch als Zero Parallax Setting (ZPS) bekannten Phänomen verschieben sich die Konturen durch die unterschiedlichen Blickwinkel nicht. Es findet also keine Verschiebung beziehungsweise Abweichung statt, da sich die aufeinander zulaufenden Blickachsen direkt auf dem Fixpunkt treffen. Der hierbei entstandene Konvergenzwinkel hängt allerdings unmittelbar vom Betrachtungsabstand ab. Im 3D-Bereich bildet die Projektionsfläche die Null-Parallaxe. Deshalb ist die Qualität der 3D-Animation insbesondere vom richtigen Abstand zwischen Leinwand und Zuschauer abhängig. Eine veränderte Tiefwahrnehmung ist gleichzeitig eine Abweichung von der Nullparallaxe. Diese kann sowohl positiv als auch negativ sein.

Positive Parallaxe (Outscreen)

Verschieben sich die beiden Halbbilder voneinander nach rechts, verändert sich auch der jeweilige Winkel. Die Sehachsen treffen sich somit scheinbar hinter der Projektionsfläche. Je größer die Abweichung (Parallaxe) ist, umso weiter ist das fixierte Objekt scheinbar im Raum entfernt. Eine positive Parallaxe ist maximal erreicht, wenn die voneinander abweichenden Halbbilder mit dem Abstand unserer Augen (65 mm) übereinstimmen, das heißt parallel verlaufen.

Negative Parallaxe (Inscreen)

Scheint sich ein Objekt vor die Null-Parallaxe in die linke Richtung zu schieben, kreuzen beziehungsweise konvergieren sich die Sehachsen sozusagen vor der Projektionsfläche. Dieses Objekt wird daher weiter vorn wahrgenommen und befindet sich (z.B. im 3D-Kino) scheinbar direkt im Zuschauerraum.

In diesem Zusammenhang sei darauf hingewiesen, dass die Projektionsfläche einen virtuellen Rahmen darstellt. Insofern können Objekte nur im unmittelbaren Zentrum dieses scheinbaren Fensters in den Raum hineinragen. Befinden sie sich weiter am Rand und werden so durch den Rahmen beschnitten, kommt es zu einem kognitiven Konflikt. Denn in der Natur kommt eine solche Beschneidung nicht vor, im Gegenteil: der Raum hinter einem Vordergrundobjekt ist größer (bis unendlich) und wird gegebenenfalls von diesem verdeckt, kann aber umgekehrt dieses Objekt in der negativen Raumtiefe (also im Vordergrund) nicht beschneiden. Die besten Effekte bei 3D-Animationen lassen sich insofern nur im Zentrum der Leinwand realisieren. Jeder kennt die Gummibärchen, die im 3D-Kino scheinbar in den Raum schweben. Wer genau darauf achtet, erkennt die zentrierte und nacheinander erfolgende Visualisierung sowie die unterschiedliche Raumtiefe in Abhängigkeit von der Bewegungsrichtung.

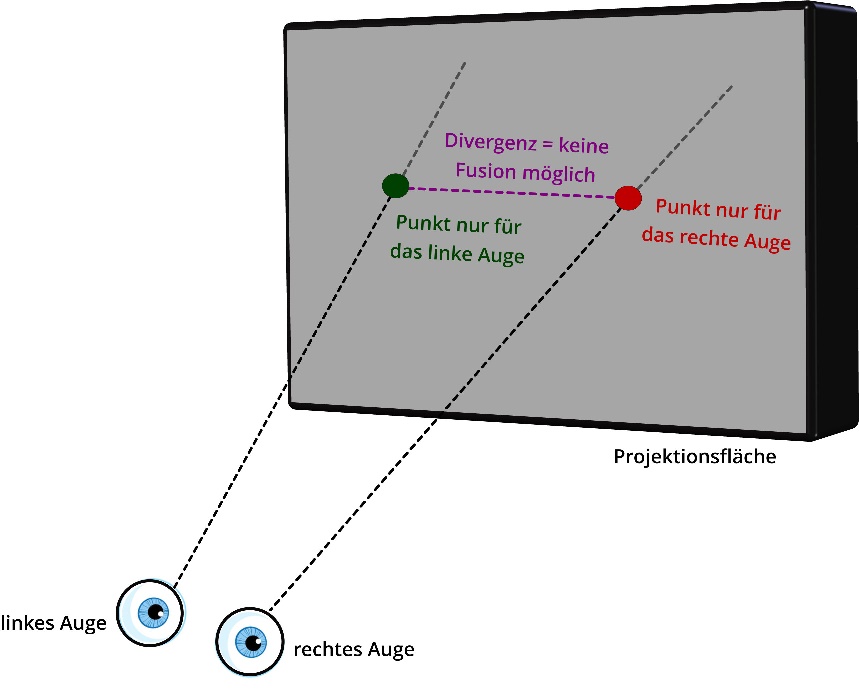

Divergente Parallaxe

Befinden sich die beiden Stereo-Teilbilder zu weit auseinander entfernt, sind also theoretisch größer als der Augenabstand, ist gleichzeitig der Wert der Parallaxe so groß, dass die Bilder nicht mehr zu einem räumlichen Gesamtbild fusionieren können. Diesen Umstand nennt man divergente Parallaxe, wobei sich die Bezeichnung Divergenz auf die lateinische Übersetzung „auseinander streben“ bezieht. Um Objekte also räumlich und scharf betrachten zu können, müssen sie fokussiert werden (Akkomodation). Dabei kann logischerweise nur ein Objekt im Mittelpunkt der Betrachtung stehen.

Neben dem bereits zu Beginn dieses Kapitels erläuterten monekularen Sehen, bei dem Objekte in der Entfernung immer kleiner werden oder Linien sich verjüngen, gibt es weitere Tiefenwahrnehmungsmerkmale, die sich allerdings nur in der Bewegung erschließen. Dazu gehören die Bewegungsparallaxe und der sogenannte Pulfrich-Effekt.

Abbildung 18: Schematische Darstellung einer divergenten Parallaxe

Bewegungsparallaxe

Bisher ist in der Wissenschaft noch umstritten, ob durch das im Folgenden beschriebene Wahrnehmungsphänomen tatsächlich Tiefenhinweise gewonnen werden können. Theoretisch ist es zwar möglich, aber bisher konnte nicht nachgewiesen werden, dass unser Gehirn in der Lage ist, aus unterschiedlichen Bewegungsgeschwindigkeiten von Objekten substanzielle Rückschlüsse über deren Entfernung zu ziehen. Dennoch wird die Bewegungsparallaxe zur Tiefenwahrnehmung (durch Bewegung) hinzugezählt.

Jeder kennt dieses Phänomen: Man sitzt im Auto oder Zug und schaut in die Weite der Landschaft, die am Fenster vorüberzieht. Die Bäume am Straßenrand bewegen sich dabei scheinbar viel schneller als die Häuser oder Berge im Hintergrund. Die untergehende Sonne am Horizont scheint dagegen fast still zu stehen. Ab dem 19. Jahrhundert konnten die Menschen durch die Erfindung von Eisenbahn und Auto diesen Parallaxe-Effekt erstmalig „genießen“. Er ist auch als Panoramablick bekannt. In der Wahrnehmungspsychologie definiert man die Bewegungsparallaxe als einen optischen Effekt, der natürlich auch mit der Krümmung der Erdachse zu tun hat. Er begründet sich vielmehr darin, dass sich die Lichtmuster der näheren Objekte schneller über die Netzhaut bewegen. Je weiter weg die Objekte sich befinden (und damit näher am Horizont), geht ihre Bewegung approximativ gegen Null. Dabei hängt dieser Effekt der Bewegungsparallaxe selbstverständlich von der Eigengeschwindigkeit des Beobachters beziehungsweise der seines Fahrzeugs ab.

Abbildung 19: Bewegungsparallaxe in der Videoanimation

Die Effekte der Bewegungsparallaxe können im Umkehrschluss vor allem in der Videotechnik auch künstlich erzeugt werden. Selbst einfache Animationen können eine räumliche Tiefe simulieren, indem Objekte hintereinander in unterschiedlicher Größe und Geschwindigkeit animiert werden.

In obiger Abbildung wird in vereinfachter Weise die beschriebene Animation auf drei Ebenen durchgeführt. Dabei bewegen sich die größer dargestellten Objekte im Vordergrund um ein Vielfaches schneller als die Objekte in der mittleren oder aber hinteren Ebene, die darüber hinaus kleiner dargestellt werden. Die Bewegung nimmt also nach hinten ab, sodass eine räumliche Tiefe suggeriert wird.

3D-Sickness

Wie bereits beschrieben, hat sowohl das Licht als auch insbesondere die Tiefenwahrnehmung einige Schattenseiten. Einige Menschen empfinden vor allem die räumliche Animation als sehr anstrengend. Bisweilen sind Übelkeit, eingetrübte Sehfähigkeit und Kopfschmerzen typische Symptome nach einem Besuch im 3D-Kino. Auch wenn es sich als solches um keine Krankheit handelt, wird dieser Zustand dennoch im Allgemeinen als 3D-Sickness bezeichnet. Während der Betrachtung stereoskopischer Bilder fällt es bis zu 25 Prozent der Zuschauer besonders schwer, die Fokussierung ihrer Augen (Akkomodation) von der Konvergenz zu entkoppeln. Durch die Täuschung, dass ein Objekt scheinbar näher kommt, entsteht im Gehirn ein Konflikt, der sich auf die Augenmuskulatur auswirkt. Das Auge wartet quasi darauf, Objekte in unterschiedlicher Entfernung und Richtung auch unterschiedlich zu fokussieren. Doch eigentlich wird „nur“ die Projektionsfläche (Kinoleinwand) fixiert, und die bewegt sich real nicht auf den Zuschauer zu. Insofern stehen die Augen und damit das Gehirn unter Dauerstress, was zu den oben genannten Symptomen führen kann.

Wem also schon beim Autofahren übel wird oder wer generell Schwierigkeiten mit den Augen hat, der sollte auf 3D-Animationen verzichten. Auch ist der richtige Abstand zur Projektionsfläche zu beachten. Aus zahlreichen Befragungen wurde deutlich, dass die negativen Begleiterscheinungen sich verschlimmern, je näher man an die Kinoleinwand oder aber den Fernseher heranrückt.

Verschiedene Hersteller (u.a. Samsung) verweisen in einem Merkblatt auf die entsprechenden Nebenwirkungen und legen jedem heute verkauften 3D-Fernseher einen Beipackzettel mit Warnhinweisen bei. Darin ist beispielsweise von Desorientierung, hoher Augenbelastung, verminderter Haltungsstabilität die Rede. Es bestünde also die Gefahr, dass 3D-Nutzer vorübergehend das Gleichgewicht verlieren.

Empirische Studien liegen bisher nicht vor, allerdings wird unter anderem empfohlen, nach dem „Genuss“ einer 3D-Aufführung mindestens 15 Minuten Pause einzulegen. Außerdem sollten Kinder unter sechs Jahren keine 3D-Animationen schauen (z.B. Spielkonsolen), da von einer Beeinträchtigung der Entwicklung der Sehfähigkeit ausgegangen wird.

Pulfrich-Effekt

Die Grundlage zur räumlichen Darstellung (3D-Animation) bietet der sogenannte Pulfrich-Effekt. Hierbei handelt es sich um eine optische Täuschung, die auf Beobachtungen des Physikers Carl Pulfrich5 aus dem Jahre 1922 beruht. Demnach wird die Bewegung eines Objektes von einem abgedunkelten Auge langsamer wahrgenommen, wobei die bewegten Objekte von links nach rechts scheinbar näher kommen. Basis dieses Effektes ist die Reizverarbeitung in unserem Gehirn. Helle optische Reize werden von unserem Auge schneller wahrgenommen als dunkle. Wird nun ein Auge beispielsweise mit einem dunklen Glas oder einer farbigen Folie verdeckt, scheint sich das in Bewegung stehende Objekt an zwei räumlich auseinanderliegenden Orten zu befinden. Es wird somit aus einer zweidimensionalen Bewegung eine dreidimensionale. Die flächige Schwingung eines Pendels kann beispielsweise mit einem abgedunkelten Auge als Kreisbahn wahrgenommen werden. Unser Gehirn kreiert insofern ein räumliches Tiefenwahrnehmungsmerkmal, das real gar nicht existiert.

Während bei der klassischen 3D-Aufnahme zwei Bilder synchron zum Augenabstand aufgenommen werden müssen, genügt nach Pulfrich eine seitlich bewegte Filmkamera. Denn mithilfe der pseudostereoskopischen Betrachtung (ein abgedunkeltes Auge) kann ein ähnlicher Effekt erzielt werden, der bei der Erforschung und Entwicklung des 3D-Fernsehens genutzt wurde.

So fand der Pulfrich-Effekt zahlreiche Möglichkeiten in der kommerziellen Anwendung. Das sogenannte Nuoptix-Verfahren wurde beispielsweise durch die RTL-Fernsehshow „Tutti Frutti“ (Anfang der 1990er-Jahre) bekannt, aber auch in diversen Tiersendungen einiger Privatsender (ProSieben) genutzt. Dazu war eine Brille mit einem gelben und einem violetten Farbfilter notwendig, die seinerzeit üblicherweise den TV-Zeitschriften beilagen.

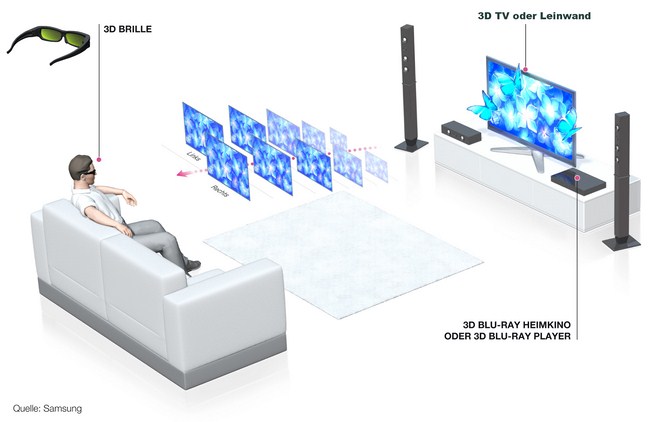

Shutterbrillen

Im 21. Jahrhundert kamen im Zuge der Entwicklung dreidimensionaler Heimkinos, Computer- und Spielkonsolen moderne Brillen auf den Markt. Die sogenannten Shutterbrillen sind technologisch auf einem weit höheren Niveau als ihre Papp-Vorfahren. Shutterbrillen verfügen über zwei steuerbare LCD-Gläser. Auf dem Monitor werden nacheinander Halbbilder im Links-Rechts-Wechsel dargestellt.

Abbildung 20: 3D-Animation mithilfe von Shutterbrillen (Samsung)

Synchron zur Abfolge dieser Halbbilder auf dem Monitor werden die Flüssigkeitskristalle in den Brillengläsern jeweils durchsichtig oder lichtundurchlässig. Auf Basis des oben erläuterten Pulfrich-Effekts wird durch die perspektivische Verschiebung der Einzelbilder so der 3D-Effekt erzielt. Die Steuerung funktioniert durch ein drahtloses Synchronsignal, welches dafür sorgt, dass jeweils das „richtige“ Auge im Wechsel sehen kann, während das andere Auge verdeckt ist. Auch hier gilt, dass es relativ schnell zu Ermüdungserscheinungen kommen kann, die in diesem Fall in unmittelbarem Zusammenhang mit der realisierten Bildwechselfrequenz stehen.

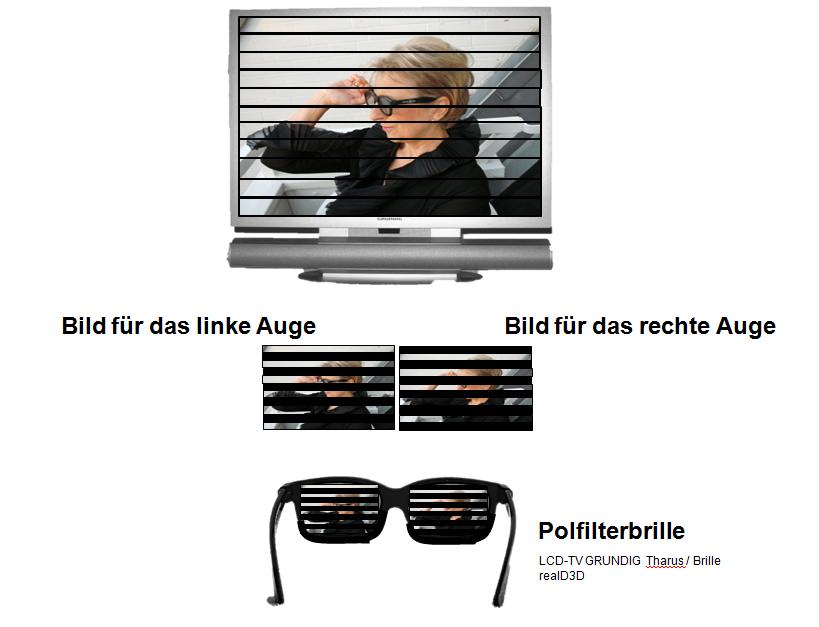

Polfilterbrille

Auch bei der Polfilterbrille erhält jedes Auge sein „eigenes“ Bild. Polfilterbrillen sind dem Namen nach mit Polarisationsfiltern versehen, die jeweils um 90 Grad gedreht sind, um nur das „passend“ polarisierte Licht durchzulassen. Mithilfe von zwei Projektoren werden für jedes Auge separat Bilder auf die Leinwand projiziert. Dabei wird jeder Projektor mit jeweils anderen Polarisationsfiltern versehen, die über unterschiedliche Polarisationsebenen verfügen.

Abbildung 21: Polfilterverfahren (Grundig)

Im Übrigen wissen auch Freunde des Angelsportes die Polarisationswirkung entsprechender Brillen sehr zu schätzen. Je nach Einfallswinkel reflektiert die Wasseroberfläche zu einem großen Teil das Sonnenlicht beziehungsweise wirft es zurück. Die Polarisationsfilter in der Polbrille blockieren bestimmte Lichtwellen mit horizontaler Ausrichtung und reduzieren so den Reflexionseinfluss. Der Angler hat mit einer solchen Brille also einen schärferen Blick durch die Wasseroberfläche, kann die Wassertiefe besser einschätzen und den exakten Standort der Köder und Fische bestimmen.

Auch war erst unter Bezugnahme von Polarisationsfiltern die farbige 3D-Film-Wiedergabe möglich. In der ersten Blütezeit des 3D-Films in den 1950er-Jahren wurden die meisten 3D-Kinofilme in Schwarz/Weiß produziert, da das Verfahren für Farbfilme in 3D damals mit sehr hohen Kosten verbunden war. Deshalb wurden viele Filme später im Rot/Grün-Verfahren produziert oder in ebenjenes kopiert.

Abbildung 22: Rot-Grün-Brille

Die Rot/Grün-Brillen sind allerdings bereits wieder aus der Mode gekommen, finden jedoch bei älteren IMAX-3D-Verfahren, bei 3D-Kuppelprojektionen oder bei Lichtbildvorträgen in 3D auch heute noch Verwendung.

Farbfilterbrillen (Anaglyphen-Verfahren)

Grundsätzlich werden bei dem sogenannten Anaglyphen-Verfahren die beiden Halbbilder über Farbfilter projiziert, die für das linke und rechte Auge jeweils die Komplementärfarben Rot/Blau oder Rot/Grün vorsehen. Dem Physiker Stephen Gibson gelang es Ende der 1970er-Jahre, das Prinzip der Farbanaglyphentechnik auf revolutionäre Weise zu verbessern. Mit seinem patentierten Deep-Vision-System verwendete er die Filterfarben Rot und Cyan.

In mehrerer Hinsicht bietet dieses Anaglyphen-Verfahren (vor allem die Rot/Cyan-Farbkombination) einige Vorteile. Die Augen ermüden beispielsweise nicht so schnell, da die Helligkeit gleichmäßiger empfunden wird. In jedem Fall aber ist das Farbanaglyphen-System eine preiswerte Alternative und lässt sich medienneutral im Film- oder Printbereich anwenden. Vielleicht ist das der Grund, warum diese Technologie bis heute noch präsent ist – auch wenn 3D an sich schon wieder aus der Mode ist. Die dänische Firma „Color Code“ entwickelte beispielsweise ein eigenes Farbanaglyphen-Verfahren mit der Farbkombination Blau (rechts) und Gelb (links). Im Jahre 2008 kam das neueste System auf den Markt, das Grün (rechts) und Magenta (links) verwendet.

Abbildung 23: Anaglyphenbrille von Oramics

Der augenscheinliche Nachteil dieser Form der räumlichen Darstellung ist natürlich, dass bei allen Farbfilterbrillen die Gesamtbilder generell nur in schwarz-weiß genossen werden können, da sich die jeweiligen Farben „auslöschen“. Wie es dazu kommt, wird im nächsten Kapitel umfassend analysiert.

Farbwahrnehmung

Der Mensch kann etwa 200 Farbtöne und ungefähr 20 Millionen Farben unterscheiden. Grundsätzlich ist festzustellen, dass die Farbe als solche eine Empfindungsgröße darstellt und somit generell subjektiven Charakter besitzt.

Wie bereits erläutert, wird das Licht im menschlichen Auge in Nervenimpulse umgewandelt. Während der Verarbeitung dieser Impulse in nachgeschalteten Hirnstrukturen entsteht eine Empfindung, die allgemeinhin als „Farbe“ bezeichnet wird. Die physikalischen Einheiten im Bereich der Wahrnehmung sind zwar generell messbar, dennoch ist das, was wir als Schärfe, Kontrast, Licht oder Farbe empfinden und einschätzen, vielmehr eine subjektive oder gar emotionale Größe, die parallel zur individuellen Beschaffenheit und Funktionalität des menschlichen Auges sowie Gehirns verläuft.

„Es ist nicht das Licht, das farbig ist.“ Isaac Newton

Der berühmte englische Naturforscher und Philosoph bringt auf den Punkt, was knapp 300 Jahre nach seinem Tod immer noch Gültigkeitscharakter besitzt. Die Farbe, die ein Mensch sieht, muss nicht zwangsläufig dieselbe sein, die von einem anderen Menschen als solche definiert wird.

Farbbegriffe

Farbe ist also nicht viel mehr als eine Sinneswahrnehmung, ausgelöst durch einen Farbreiz aus der Lichtstrahlung, der wiederum Ursache für die sogenannte Farbvalenz (den Farbwert) ist, deren Wirkung die Farbwahrnehmung darstellt. Der Zusammenhang dieser drei Aspekte wird in der folgenden Grafik (Abbildung 22) deutlich.

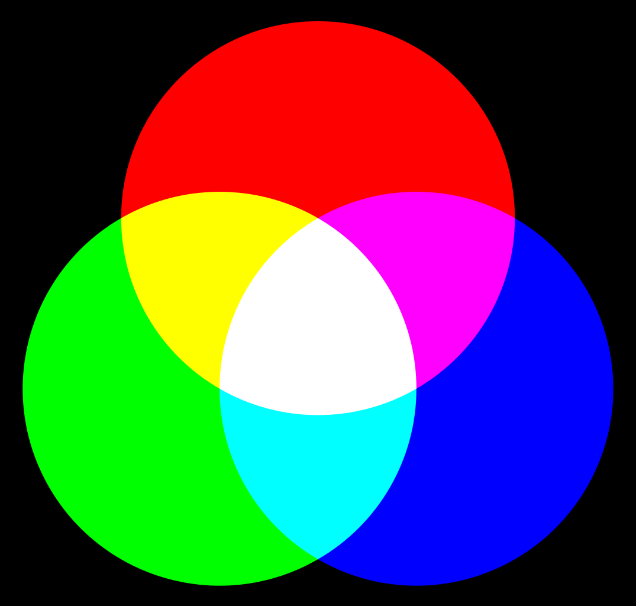

Die Graßmannschen Gesetze6 definieren die Farbvalenz als eine dreidimensionale Größe, die Grundfarbe (Spektralfarbe), die Farbintensität und die Weißintensität. Darauf aufbauend werden diese drei Grundgrößen heute im Zusammenhang mit dem HSV-Farbraum, den CIE-Primärvalenzen oder den Werten CMY und RGB verwendet. RGB ist die Abkürzung für Rot, Grün, Blau. Diese drei Farbwerte stellen die Primärvalenzen beziehungsweise Primärfarben dar, also jene drei spektral reinen Farben, die sich nicht aus den jeweils anderen herstellen (mischen) lassen.

Abbildung 24: Dreiklang der Farbbegriffe

Helmholtz7 erkannte, dass die Farbvalenz durch Farbton, Sättigung und Helligkeit gekennzeichnet ist. So lässt sich die „Farbe“ nach ihrem Helligkeitsanteil (engl. luminance) und der Farbart unterscheiden. Diese setzt sich aus dem durch die Wellenlänge des Lichtes bestimmten Farbton (engl. hue) und der Farbsättigung (engl. saturation) zusammen, die durch den zugemischten Weißanteil entsteht. Insofern ist der Begriff „Farbe“ nicht korrekt. Es müsste vielmehr „Buntheit“ heißen, da die sogenannten Farbnuancen in erster Linie etwas mit der Helligkeit zu tun haben. Im Umkehrschluss verwendet man bei Grauwerten in der Fachsprache die Bezeichnung „unbunte Farben“.

Farbfrequenzen und -wellenlängen

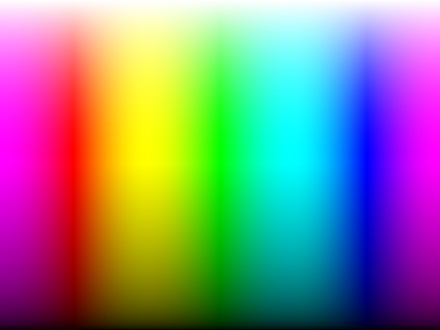

Farbe ist also abhängig vom Licht beziehungsweise dessen Wellenlänge sowie Frequenzbereich. Es ist nicht möglich, Farben als absolute Größen darzustellen, sondern lediglich als Vergleich. Hierzu werden die sogenannten Spektralfarben zugrunde gelegt, die gern mit dem atmosphärisch-optischen Phänomen des Regenbogens in Verbindung gebracht werden. Bei der Spektralfarbe handelt es sich um einen Farbeindruck, der aus einem Teilbereich des für den Menschen sichtbaren Lichtspektrums erzeugt wird, wobei die Wellenlängenbereiche lückenlos aneinanderstoßen. Deshalb gibt es theoretisch unendlich viele Spektralfarben, dennoch werden grundsätzlich nur die sieben „Regenbogenfarben“ Rot, Orange, Gelb, Grün, Blau, Indigo und Violett im Farbspektrum verwendet.

|

Wellenlängenbereich |

Frequenzbereich |

|

|

|

Rot |

≈ 700 - 630 nm |

≈ 430 - 480 THz |

|

|

Orange |

≈ 630 - 590 nm |

≈ 480 - 510 THz |

|

|

Gelb |

≈ 590 - 560 nm |

≈ 510 - 540 THz |

|

|

Grün |

≈ 560 - 490 nm |

≈ 540 - 610 THz |

|

|

Blau/Indigo |

≈ 490 - 450 nm |

≈ 610 - 670 THz |

|

|

Violett |

≈ 450 - 400 nm |

≈ 670 - 750 THz |

Abbildung 25: Spektralfarben und ihre Wellenlängen/Frequenzen

Wer schon einmal mit einem Grafikprogramm gearbeitet hat, kennt diese Farben aus der Praxis und weiß, dass sie sich beliebig mischen lassen. Wird der Farbwert eines Objektes auf eins gesetzt, färbt sich dieses schwarz. Werden alle drei Farbwerte (R = B = G) gleichmäßig um 50 Prozent erhöht, ergibt das die (unbunte) Farbe Grau. Setzt man zwei der drei Farbewerte auf 0 Prozent und die dritte auf 100 Prozent, ergibt sich daraus eine der drei Primärfarben.

Werden zwei Farbwerte auf 100 Prozent gesetzt und der dritte bleibt bei null, können so die Farben Cyan (Grün und Blau), Gelb (Rot und Grün) und Magenta (Blau und Rot) additiv gemischt werden. Aus diesen drei sogenannten Sekundärfarben (Cyan, Magenta und Yellow) resultiert der technisch-physikalische Wert CMY.

Abbildung 26: Primär- und Sekundärfarben/additive Farbmischung

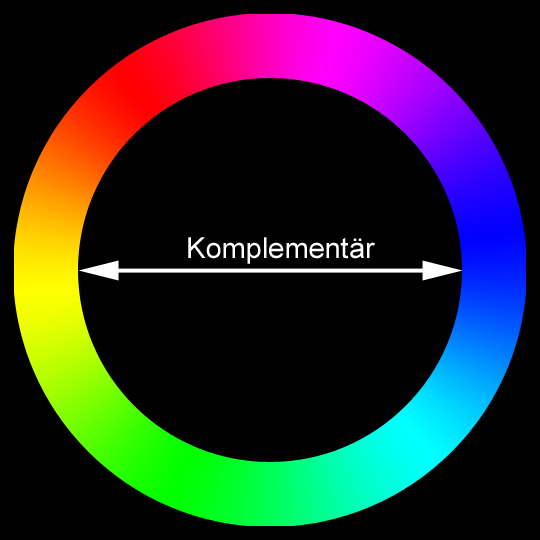

Werden sowohl bei der additiven als auch bei der subtraktiven Farbmischung zwei Farben gemischt, die einen neutralen Grauton oder Weiß ergeben, so werden diese als Komplementärfarben (lateinisch: complementum) bezeichnet. Sie heben sich bei der Mischung also gegenseitig auf (vgl. Kapitel über Farbfilterbrillen/Anaglyphen-Verfahren).

Verschiedene Farbpaare gelten als komplementär. Dazu zählen Blau ↔ Gelb, Rot ↔ Cyan und Grün ↔ Magenta. Da diese aus den Farben RGB resultieren, stellen sie die Basis dar für das CIE-System und andere technische Systeme (z.B. RGB und CMY). Die Komplementärfarben Blau ↔ Gelb und Rot ↔ Grün sind grundlegend für das NCS-System und Blau ↔ Orange sowie Rot ↔ Grün und Gelb ↔ Violett sind nach dem Modell von Goethe8 und Itten9 komplementär, die jeweils im künstlerischen Zusammenhang von Bedeutung sind. Diese Komplementärfarben werden auch synonym als Gegenfarben bezeichnet, da sie sich im sogenannten Farbkreis genau gegenüberstehen (vgl. Abbildung). Verändert man die Intensität eines Farbtons, ergeben sich pro Farbton etwa 500 unterscheidbare Helligkeiten.

Abbildung 27: RGB-Farbkreis/Komplementärfarben

Additive und subtraktive Farbmischung

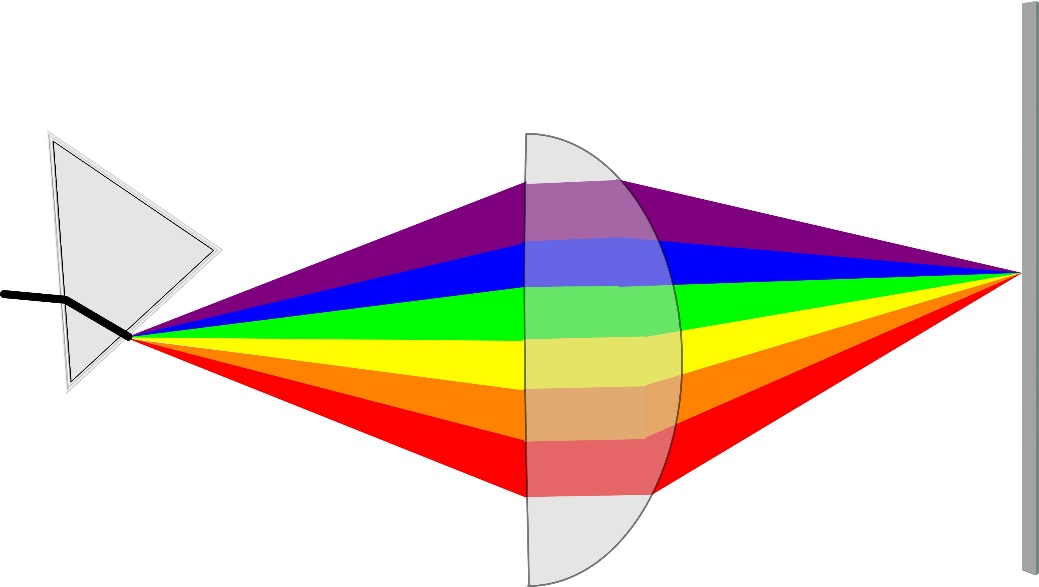

Setzt man hingegen im RGB-Farbmodell alle drei Werte auf 100 Prozent, ergibt sich daraus Weiß. Das heißt, dass durch die Überlagerung der Farben sich diese gegenseitig auflösen können. So kann im Umkehrschluss auch aus weißem Licht farbiges Licht entstehen. Dieser Vorgang ist reversibel - kann also in beide Richtungen erfolgen. Wenn man sich weg vom Computer in die Natur begibt, kann man mithilfe eines Prismas und einer Linse das Sonnenlicht in ein Farbspektrum aufspalten oder umgekehrt zusammenzuführen, um somit das ursprüngliche Sonnenlicht wiederherstellen.

Wenn „weißes Licht“ (Sonnenlicht) durch ein Glasprisma fällt, wird dieser Strahl zwei Mal gebrochen: Erstens beim Übergang vom optisch dünneren zum optisch dichteren Medium (Luft Glas) und zweitens beim Übergang vom optisch dichteren zum optisch dünneren Medium (Glas Luft). Dabei werden die verschiedenen Wellenlängen unterschiedlich stark gebrochen. So entsteht ein kontinuierliches Spektrum, das ungefähr 300 unterscheidbare Farbnuancen umfasst, die vom menschlichen Auge wahrgenommen werden können.

Abbildung 28: Lichtbrechung und Spektralfarben

Hingegen erhält man reines „weißes“ Licht, wenn man alle Farben des Spektrums mithilfe einer Linse wieder zusammenführt. Es werden also die einzelnen Wellenlängen „addiert“, die in der Summe wieder „weißes“ Licht ergeben. Dieses Verfahren wird auch als optisches Farbmischen bezeichnet und heute in verschiedenen Verfahren der modernen Bildschirmtechnik verwendet; beispielsweise bei der Quantum-Dot-Technologie diverser TV-Flachbildschirme seit 2015.

Das optische Farbmischen lässt sich unter anderem auf die Erkenntnisse von Isaac Newton zurückführen, der aufgrund von Beobachtungen und Praxistexts bereits Ende des 17. Jahrhunderts mit ebenjenem Hilfsmitteln (Prisma, Linse) die ersten Hinweise zur Erklärung der Farbwahrnehmung in seinen „Opticks“ lieferte. Im Rahmen der Zerlegung des „weißen“ Lichts wies Newton nach, dass das Licht in sieben Farben des Spektrums (vgl. Abbildung) zerlegt werden kann. Allerdings ging er davon aus, dass sich das Licht aus Partikeln zusammensetzt. Weitere Forschungen auf diesem Gebiet erwiesen aber, dass sich die Spektralfarben vor allem in ihrer Wellenlänge unterscheiden. Hierfür steht beispielsweise das sogenannte Wellenmodell nach Thomas Young10 oder Cristiaan Huygens11.

Insofern wird das Spektrum in der modernen Wissenschaft als die Gesamtheit aller Linien und Banden bestimmter Frequenz in einem energiegleichen Strahlungsereignis definiert. In der Physik besteht das sogenannte „weiße“ Licht aus Anteilen aller Wellenlängen des sichtbaren Spektralbereichs und ist somit ein energiegleich gemischtes Licht, das es in dieser perfekten Form allerdings nur in der Theorie gibt. In der Regel ist damit das Sonnenlicht oder Tageslicht gemeint beziehungsweise die Normlichtarten mit ihren unterschiedlichen Farbtemperaturen.

Farbtemperaturen

Denn Weiß entsteht auch durch Hitze oder vielmehr verschiebt sich das Maximum des Farbspektrums mit steigender Temperatur hin zu kürzeren Wellenlängen. So nehmen wir beispielsweise das Wellenlängengemisch der Sonne als weiß oder zumindest sehr hell wahr, weil die Außentemperatur dieser Gaskugel ca. 6000 °C beträgt, was einer Farbtemperatur von etwa 5800 Kelvin entspricht. Bei bedecktem Himmel verschiebt sich diese Farbtemperatur der Sonne zu höheren Werten (7000 Kelvin), sodass für das sogenannte Norm- oder Referenzlicht D65 namensgebende 6504 Kelvin zugrunde gelegt wurden. Die Werte aller sonstigen Kunstlichtquellen liegen weit unter diesem Bereich (vgl. Abbildung).

|

Himmel bedeckt |

7000 K |

Mondlicht |

4100 K |

|

Normlicht D65 |

6504 K |

Halogenlampe |

3200 K |

|

Himmel wolkenlos |

5800 K |

40W-Glühlampe |

2650 K |

|

HMI-Lampe |

5600 K |

25W-Glühlampe |

2500 K |

|

Sonne früh/spät |

4300 K |

Kerzenlicht |

1850 K |

Abbildung 29: Farbtemperaturen verschiedener Lichtquellen in Kelvin (K)

Absorptionsspektren

Wie verhält es sich nun aber mit all jenen Körpern, die nicht von selbst leuchten beziehungsweise Licht abstrahlen? Wie bereits erwähnt, emittieren, absorbieren oder reflektieren diese das Licht aus externen Quellen. Während beim Emittieren der transparente Körper das Licht verändert durchlässt (Beispiel Prisma), nehmen lichtundurchlässigere Körper das Licht auf und strahlen es verändert wieder ab. Vereinfacht ausgedrückt entstehen auf diesem Wege die sogenannten Körperfarben und damit die gesamte Farbvielfalt unserer Umwelt.

Allerdings verhalten sich Körper anders, je nachdem wie sie angestrahlt werden. Denn wie das Licht selbst hängt auch der Absorptions- oder Reflexionsgrad von der Wellenlänge des Lichtes ab. Körper erscheinen in „weißem Licht“ farbig, da eben nur bestimmte Frequenzen aufgenommen und wieder zurückgegeben werden (subtraktive Farbmischung). Werden Körper hingegen mit monochromatischem Licht – also mit nur einer Farbe beziehungsweise einer genau definierten Frequenz – angestrahlt, dann werden dieselben Körper ganz anders wahrgenommen. Wird rotes Papier etwa mit rotem Licht angestrahlt, erscheint es weiß. Hingegen nimmt ein Körper, der kein blaues Licht reflektiert, in blauem Licht die Farbe Schwarz an. Der Anteil der Strahlung, der nicht reflektiert wird, kann von den Körpern im Übrigen in Wärmeenergie umgewandelt werden. Deshalb erwärmen sich dunkle Körper (z.B. schwarze Kleidung) unter Lichteinfluss mehr, da sie weniger Licht reflektieren und damit eine höhere Menge Energie abgeben können.

Wie alles in der Natur hat auch die Farbwahrnehmung einen effektiven wenn nicht gar existenziellen Nutzen. Die Farbvielfalt, die jeder Mensch individuell empfindet, ist insofern nicht einfach nur „bunt“, sondern hilft uns, unsere Umwelt zu differenzieren. Ein berühmtes Sprichwort heißt: „Bei Nacht sind alle Katzen grau“. Unter sehr geringem Lichteinfluss sind tatsächlich alle Körper nur in Grautönen sichtbar. Bei Tageslicht hingegen ist die unregelmäßige Helligkeitsverteilung (Textur) der betrachteten Objekte in Verbindung mit den entsprechenden Farbinformationen dafür verantwortlich, dass wir die Texturen voneinander unterscheiden können.

In der folgenden Abbildung wird anhand derselben Photographie deutlich, dass erst die Farbwahrnehmung eine genaue Unterscheidung unserer Umwelt möglich macht.

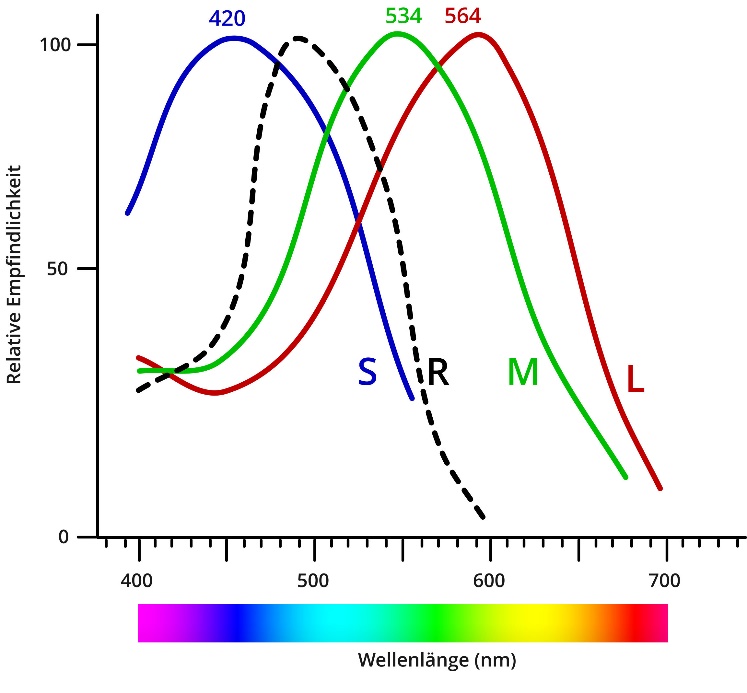

Abbildung 30: Unterschied zwischen bunt und unbunt: Farbe zur besseren Orientierung

Wie bereits eingangs beschrieben, sind die Photorezeptoren (Stäbchen und Zapfen) in unserem Auge zuständig für die Helligkeits- und Farbwahrnehmung. Die weniger lichtempfindlichen Zapfen können in drei Kategorien unterteilt werden: lang-, mittel-, und kurzwellenlängensensitiv oder einfacher ausgedrückt: Rot, Grün und Blau. Das heißt komplex betrachtet, dass diese drei Zapfenarten besonders gegenüber einer der Primärfarben empfindlich reagieren. Analog zur additiven Farbmischung kann das menschliche Auge also die unterschiedlichen Farbreize auf Basis dieser drei Farbwerte „mischen“. Wird beispielsweise die Farbe Gelb wahrgenommen, dann sind lediglich zwei Zapfenarten aktiv, nämlich die der rot- und grünempfindlichen Kategorie. Hierbei handelt es sich um den Schnittpunkt der beiden Maximalwerte (Rot und Grün), wie in der folgenden Abbildung dargestellt.

Diese sogenannten Absorptionsgipfel liegen nur eine Winzigkeit (ca. 30 Nanometer) auseinander, da sie ursprünglich zu nur einem Urzapfen gehörten, der sich erst im Laufe der Evolution zu zwei Zapfentypen entwickelte. Erst Anfang der 1990er Jahre ist es der Wissenschaft gelungen nachzuweisen, dass die Absorptionsfähigkeit der Zapfen von ihrem sogenannten Sehfarbstoff abhängt, dessen Proteine genetisch bestimmt sind. Dr. Jeremy Nathans12 und sein Team identifizierte die entsprechenden Gene, die die Ausbildung dieser Proteine kodieren. Auf dieser Basis stellte sich heraus, dass die Unterschiede der Aminosäuresequenzen der Rot- und Grünpigmente nur sehr gering sind (< 2 Prozent).

Abbildung 31: Empfindlichkeitsverteilung der drei Zapfenarten. Schwarz (R) = Stäbchen

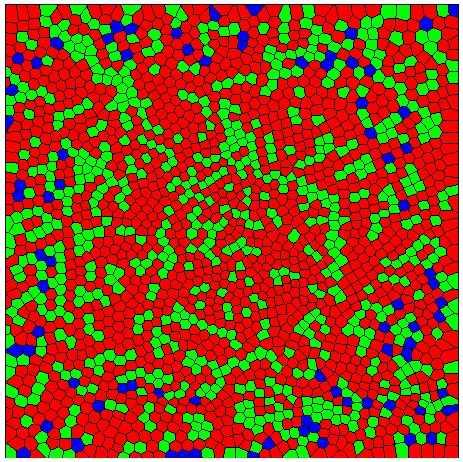

Auch die Anzahl und Dichte der Rot-/Grün-Zapfen auf der Netzhaut des menschlichen Auges sind gegenüber der für das Blausehen weitaus höher. Im zentralen Bereich der Fovea befinden sich ausschließlich Rot- und Grünzapfen. Die Blauzapfen machen nur einen Anteil von neun Prozent aus und sind ausschließlich in der peripheren Retina vorhanden. Im sogenannten Photorezeptormosaik nach Roorda & Williams (1999) wird das Verhältnis von Rot-, Grün- und Blauzapfen besonders deutlich (vgl. Abbildung).

Photorezeptormosaik

Während zahlreicher Studien innerhalb der Farbforschung wurde klar, dass die Farbwahrnehmung der Probanden und damit generell rein subjektiver Natur ist. Dies ist unter anderem der Grund dafür, warum die sogenannte Farbenblindheit bei vielen Menschen erst sehr spät und wenn meist nur zufällig entdeckt wird.

Abbildung 32: Photorezeptormosaik nach Roorda & Williams13

Im Mittelpunkt einiger Hypothesen in Bezug auf den evolutionären Vorteil der ausgeprägten Rot-Grün-Wahrnehmung steht die Annahme, dass diese Unterscheidungsfähigkeit der roten und grünen Farbe vor allem mit der Orientierung während der Nahrungssuche zusammenhängt. So ist es beispielsweise den Menschen aber auch vielen Tieren möglich, die roten Beeren zwischen den grünen Blättern zu identifizieren. Die Wissenschaft sieht zum Teil hier den Grund dafür, warum der dritte Zapfentyp für die Farbe Blau entsprechend weniger ausgeprägt ist. Allerdings steht dem entgegen, dass Menschen mit einer Rot-Grün-Blindheit sich ebenfalls in der Natur orientieren können und sich die wahrgenommene Struktur nur unwesentlich unterscheidet.

Rot-Grün-Blindheit (Anopia)

Gegenüber anderen Formen der genetisch bedingten Farbenblindheit tritt die Rot-Grün-Schwäche sehr häufig auf. Insbesondere Männer sind davon betroffen, da sich die Gene für die Rot- und Grünpigmente auf dem X-Chromosom befinden. Bekanntermaßen verfügen Männer nur über X-Chromosomen. Fehlt also eines dieser Gene, kann es nicht ausgeglichen werden, der entsprechende Zapfentyp (für Rot oder Grün) ist insofern nicht vorhanden.

So tritt die absolute Rot-Grün-Blindheit (Anopia) bei ca. 2,3 Prozent der männlichen Bevölkerung in Europa auf. Weniger ausgeprägte Anomalien, bei denen das Rot-Grün-Sehen lediglich gestört aber dennoch teilweise vorhanden ist, kommen bei weiteren 5,7 Prozent vor (vgl. Tabelle).

|

Geschlecht |

Anzahl |

Rot-Zapfen (Protan) |

Grün-Zapfen (Deutan) |

||

|

Anopia |

Anomalie |

Anopia |

Anomalie |

||

|

männlich |

45,989 |

1.01 % |

1.08 % |

1.27 % |

4.63 % |

|

weiblich |

30,711 |

0.02 % |

0.03 % |

0.01 % |

0.36 % |

Abbildung 33: Rot-Grün-Farbsehstörungen in Westeuropa (nach Sharpe14, 1999, Tabelle 1.4)

In diesem Zusammenhang muss darauf hingewiesen werden, dass die technischen Farbsysteme (RGB, CIE etc.) grundsätzlich nichts mit den hier beschriebenen anatomischen Begebenheiten im menschlichen Körper – also den Absorptionseigenschaften der Zapfen - zu tun haben. Dennoch sollte der Vollständigkeit halber nicht unerwähnt bleiben, dass vor allem die Dichte dieser Zapfen die Sehschärfe unserer Augen verantwortlich ist.

Insbesondere bei kurzwelligem Licht entsteht eine sogenannte retinale Unschärfe, die auf die geringe Dichte der Blauzapfen zurückzuführen ist. Da die Zapfendichte nur im Zentrum der Fovea am stärksten ist und in der Peripherie (Umgebung) abnimmt, können im äußeren Gesichtsfeld weitaus weniger Farben scharf wahrgenommen werden, was unter anderem einer Reizüberflutung entgegenwirken soll. Die unregelmäßige Anordnung der Zapfen, wie im Photorezeptormosaik (vgl. Abbildung) dargestellt, ist demnach der Grund dafür, warum im Farbbereich weniger Wahrnehmungsstörungen auftreten. Denn die räumliche Auflösung der Farbwahrnehmung ist wesentlich geringer als die des Helligkeitssystems, da die Photorezeptoren, die für das Hell-Dunkel-Sehen verantwortlich sind (Stäbchen) generell empfindlicher reagieren. Allerdings sei hier der Vollständigkeit halber ebenfalls angemerkt, dass die Stäbchen aufgrund ihrer hohen Lichtempfindlichkeit eben nicht für das Sehen im Hellen, sondern vielmehr für das Dämmungs- und Nachtsehen zuständig sind.

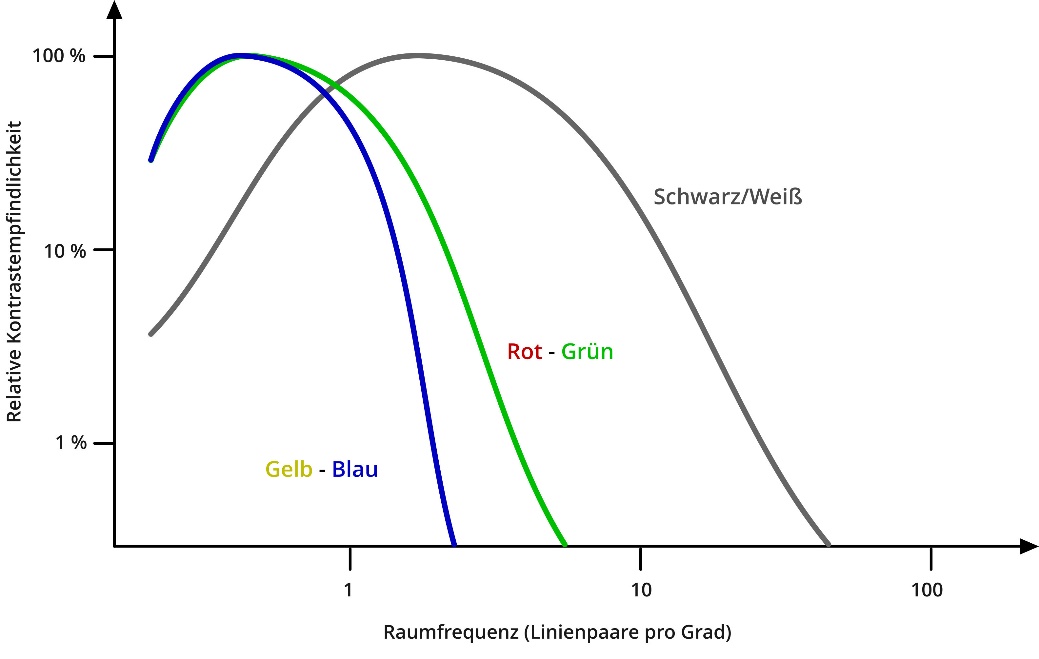

Abbildung 34: Kontrastempfindlichkeit in der räumlichen Auflösung

So können farbige Flächen schlechter differenziert werden als Schwarz-Weiß-Muster. Obige Abbildung veranschaulicht, dass das Kontrastempfinden für Farbmodulationen wesentlich geringer ist als für Helligkeitsmodulationen.

Im Kontext der Bildübertragungstechnologie ist dieses Wissen von Vorteil. Zeigt es doch, dass für eine qualitativ hohe Darstellung feiner Details lediglich die Helligkeitsinformationen übertragen werden müssen und auf Farbinformationen weitgehend verzichtet werden kann. Aber auch für viele andere Bereiche der Fernsehtechnik ist die Wahrnehmung essentiell. Deshalb dient sie auch in diesem Praxishandbuch als Grundlage für die nun folgenden technischen Erläuterungen.